说话人分割模型的训练方法、说话人分割方法及相关设备与流程

本申请涉及语音处理,尤其涉及一种说话人分割模型的训练方法、说话人分割方法及相关设备。

背景技术:

1、说话人分割又名说话人日志,它用于在一通语音中判断某个时间段是谁说话的问题。目前常用的说话人分割方案,主要利用端到端的模型训练方式训练一个具有说话人分割功能的模型,然后利用该模型对待分割音频进行说话人分割。但是,上述方案是利用一通音频中每个音频片段独立的相关特征进行模型训练,进而训练出的说话人分割模型在进行说话人分割时,是单独对待分割音频中的每个音频片段进行说话人分割,这就容易出现说话人混乱的问题,比如基于第一个候选音频片段识别出的说话人1是坐席、说话人2是客户,但是第二个候选音频片段被识别出说话人1是客户、说话人2是坐席,从而影响说话人分割结果的准确性。

技术实现思路

1、本申请实施例的目的是提供一种说话人分割模型的训练方法、说话人分割方法及相关设备,用于解决目标的说话人分割方案存在的说话人混乱的问题。

2、为了实现上述目的,本申请实施例采用下述技术方案:

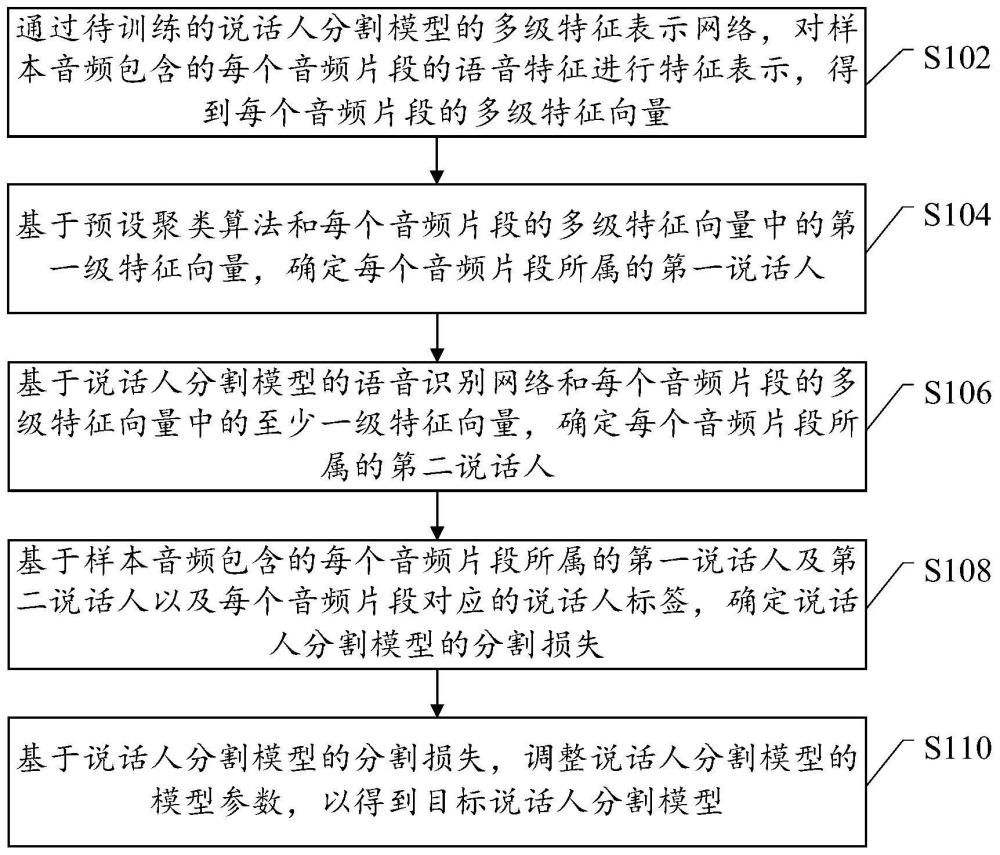

3、第一方面,本申请实施例提供一种说话人分割模型的训练方法,包括:

4、通过待训练的说话人分割模型的多级特征表示网络,对样本音频包含的每个音频片段的语音特征进行特征表示,得到所述每个音频片段的多级特征向量,其中,所述多级特征表示网络与所述多级特征向量一一对应;

5、基于预设聚类算法和所述每个音频片段的多级特征向量中的第一级特征向量,确定所述每个音频片段所属的第一说话人;

6、基于所述说话人分割模型的语音识别网络和所述每个音频片段的多级特征向量中的至少一级特征向量,确定所述每个音频片段所属的第二说话人;

7、基于所述样本音频包含的每个音频片段所属的第一说话人及第二说话人以及所述每个音频片段对应的说话人标签,确定说话人分割模型的分割损失;

8、基于所述说话人分割模型的分割损失,调整所述说话人分割模型的模型参数,以得到目标说话人分割模型。

9、本申请实施例中,采用具有语音识别网络和多级特征表示网络的说话人分割模型,利用多级特征表示网络分别对样本音频中每个音频片段的语音特征进行特征表示,得到每个音频片段的多级特征表示向量;由于每个音频片段的第一级特征表示向量更加切合说话人的基频信息特点,进而能够更准确地表达和描述音频片段的底层语音特征,以使该音频片段区别于其他音频片段,且属于同一说话人的音频片段的底层语音特征具有相似性,基于样本音频包含的各个音频片段的第一级特征表示向量对样本音频包含的音频片段进行聚类,并基于聚类结果确定每个音频片段所属的第一说话人,可使说话人分割模型充分学习每个音频片段的底层语音特征以及不同音频片段在时序上的关系;此外,还基于语音识别网络和每个音频片段的多级特征向量中的至少一级特征向量,识别每个音频片段所属的第二说话人,可使说话人分割模型单独学习每个音频片段的语音特征;进一步,基于样本音频包含的每个音频片段所属的第一说话人及第二说话人以及每个音频片段对应的说话人标签,确定说话人分割模型的分割损失,并基于该分割损失调整说话人分割模型的模型参数,使得说话人分割模型在进行说话人分割时,不仅能够单独利用每个音频片段的语音特征,还能够充分利用每个音频片段的底层语音特征以及不同音频片段在时序上的关系,进而有利于提高说话人分割模型的分割效果,从而得到具有较高分割准确性的目标说话人分割模型。

10、第二方面,本申请实施例提供一种说话人分割方法,包括:

11、将待分割音频划分为多个候选音频片段;

12、通过目标说话人分割模型的多级特征表示网络,对所述多个候选音频片段中每个候选音频片段的语音特征进行特征表示,得到所述每个候选音频片段的多级特征向量,其中,所述每个候选音频片段的多级特征表示网络与所述多级特征向量一一对应;

13、通过所述目标说话人分割模型的语音识别网络,对所述每个候选音频片段的语音特征进行识别,得到所述每个候选音频片段所属的说话人;

14、基于所述每个候选音频片段所属的说话人,确定所述待分割音频的说话人分割结果。

15、本申请实施例中,将待分割音频划分为多个候选音频,利用通过上述说话人分割模型的训练方法训练出的目标说话人分割模型对每个候选音频进行识别,由于目标说话人分割模型在进行识别时,不仅能够单独利用每个音频片段的语音特征,还能够充分利用每个音频片段的底层语音特征以及不同音频片段在时序上的关系,进而可以准确识别出每个候选音频片段所属的说话人;进一步,基于每个候选音频片段所属的说话人,确定待分割音频的说话人分割结果,有利于提高对待分割音频的说话人分割准确性。

16、第三方面,本申请实施例提供一种说话人分割模型的训练装置,包括:

17、第一特征表示单元,用于通过待训练的说话人分割模型的多级特征表示网络,对样本音频包含的每个音频片段的语音特征进行特征表示,得到所述每个音频片段的多级特征向量,其中,所述多级特征表示网络与所述多级特征向量一一对应;

18、第一确定单元,用于基于预设聚类算法和所述每个音频片段的多级特征向量中的第一级特征向量,确定所述每个音频片段所属的第一说话人;

19、第二确定单元,用于基于所述说话人分割模型的语音识别网络和所述每个音频片段的多级特征向量中的至少一级特征向量,确定所述每个音频片段所属的第二说话人;

20、第三确定单元,用于基于所述样本音频包含的每个音频片段所属的第一说话人及第二说话人以及所述每个音频片段对应的说话人标签,确定说话人分割模型的分割损失;

21、调整单元,用于基于所述说话人分割模型的分割损失,调整所述说话人分割模型的模型参数,以得到目标说话人分割模型。

22、第四方面,本申请实施例提供一种说话人分割装置,包括:

23、划分单元,用于将待分割音频划分为多个候选音频片段;

24、第二特征表示单元,用于通过目标说话人分割模型的多级特征表示网络,对所述多个候选音频片段中每个候选音频片段的语音特征进行特征表示,得到所述每个候选音频片段的多级特征向量,其中,所述每个候选音频片段的多级特征表示网络与所述多级特征向量一一对应;

25、识别单元,用于通过所述目标说话人分割模型的语音识别网络,对所述每个候选音频片段的语音特征进行识别,得到所述每个候选音频片段所属的说话人;

26、第四确定单元,用于基于所述每个候选音频片段所属的说话人,确定所述待分割音频片段的说话人分割结果。

27、第五方面,本申请实施例提供一种电子设备,包括:处理器;用于存储所述处理器可执行指令的存储器;其中,所述处理器被配置为执行所述指令,以实现如第一方面或第二方面所述的方法。

28、第六方面,申请实施例提供一种计算机可读存储介质,当所述存储介质中的指令由电子设备的处理器执行时,使得电子设备能够执行如第一方面或第二方面所述的方法。

技术特征:

1.一种说话人分割模型的训练方法,其特征在于,包括:

2.根据权利要求1所述的方法,其特征在于,所述基于所述样本音频包含的每个音频片段所属的第一说话人及第二说话人以及所述每个音频片段对应的说话人标签,确定所述说话人分割模型的分割损失,包括:

3.根据权利要求1所述的方法,其特征在于,所述基于预设聚类算法和所述每个音频片段的多级特征向量中的第一级特征向量,确定所述每个音频片段所属的第一说话人,包括:

4.根据权利要求1所述的方法,其特征在于,所述基于所述说话人分割模型的语音识别网络和所述每个音频片段的多级特征向量中的至少一级特征向量,确定所述每个音频片段所属的第二说话人,包括:

5.根据权利要求1至4中任一项所述的方法,其特征在于,所述多级特征表示网络中的每级特征表示网络包括特征映射层和双向编码层;

6.一种说话人分割方法,其特征在于,包括:

7.根据权利要求6所述的方法,其特征在于,所述基于所述每个候选音频片段所属的说话人,确定所述待分割音频片段的说话人分割结果,包括:

8.根据权利要求7所述的方法,其特征在于,所述基于所述多个候选音频片段中每个候选音频片段的最后一级特征向量,对所述多个候选音频片段进行聚类,得到多个第二聚类簇,包括:

9.根据权利要求8所述的方法,其特征在于,所述基于所述多个第二聚类簇中每个第二聚类簇的特征向量,确定所述第一目标聚类簇与第二目标聚类簇之间的距离,包括:

10.根据权利要求6所述的方法,其特征在于,所述基于所述每个候选音频片段所属的说话人,确定所述待分割音频片段的说话人分割结果,包括:

11.一种说话人分割模型的训练装置,其特征在于,包括:

12.一种说话人分割装置,其特征在于,包括:

13.一种电子设备,其特征在于,包括:

14.一种计算机可读存储介质,其特征在于,当所述存储介质中的指令由电子设备的处理器执行时,使得电子设备能够执行如权利要求1至10中任一项所述的方法。

技术总结

本申请公开了一种说话人分割模型的训练方法、说话人分割方法及相关设备。所述训练方法包括:通过待训练的说话人分割模型的多级特征表示网络,对样本音频包含的每个音频片段的语音特征进行特征表示,得到每个音频片段的多级特征向量;基于预设聚类算法和每个音频片段的第一级特征向量,确定每个音频片段所属的第一说话人;基于说话人分割模型的语音识别网络和每个音频片段的至少一级特征向量,确定每个音频片段所属的第二说话人;基于样本音频包含的每个音频片段所属的第一说话人及第二说话人以及每个音频片段对应的说话人标签,确定说话人分割模型的分割损失;基于分割损失调整说话人分割模型的模型参数,以得到目标说话人分割模型。

技术研发人员:孟庆林,蒋宁,吴海英,刘敏

受保护的技术使用者:马上消费金融股份有限公司

技术研发日:

技术公布日:2024/2/19

- 还没有人留言评论。精彩留言会获得点赞!