用于非朗伯体外观的自主多角度联合检测方法

本发明涉及自动检测,更具体地说,它涉及用于非朗伯体外观的自主多角度联合检测方法。

背景技术:

1、产品外观质量是产品质量的重要组成部分,它会直接影响消费者的感官,降低其商业价值和品牌口碑。具体而言,产品外观检测包括污点、划痕、浅坑、浅瘤、边缘缺陷、图案缺陷等。自动视觉检测(automated visual inspection,avi)系统具有检测精度高、检测速度快、成本低等优点,已取得较为广泛的应用。但待检查的产品复杂多变,设计通用视觉检测系统难。因此,如何确定图像采集视角、实现不同场景下的知识迁移是构造通用avi系统的关键。

技术实现思路

1、本发明的目的是提供用于非朗伯体外观的自主多角度联合检测方法,通过深度强化学习为产品规划采集视角序列,进而实现产品质量检测;通过迁移学习和抗噪学习来实现不同产品、不同场景间的知识迁移,有助于推进产品外观检测自动化进程。

2、本发明的上述技术目的是通过以下技术方案得以实现的:用于非朗伯体外观的自主多角度联合检测方法,包括以下步骤:

3、s1:在固定检测场景下对单一产品外观进行检测,通过数据驱动的人工智能方法获得多视角规划策略;

4、s2:通过已学得的视角规划策略和学习所用的样本集合,查询新产品图像的top-k个近似邻居样本,并获得对应的视角规划策略;

5、s3:通过新产品的样本来调整k个检索视角规划策略的权重,通过加权和的方式来估计任意新产品图像的多视角规划策略。

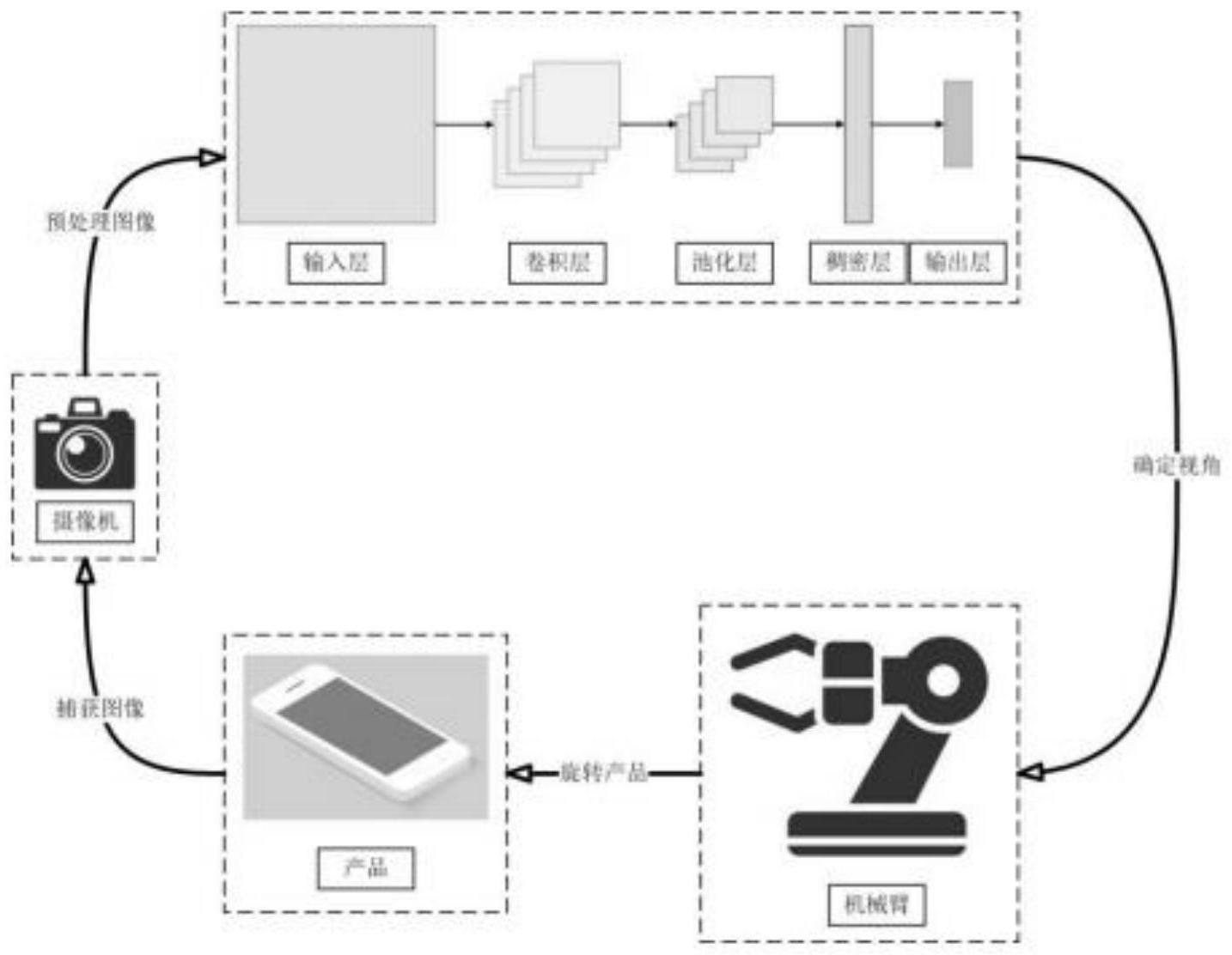

6、本发明进一步设置为:所述步骤s1中对单一产品外观进行检测是采用基于深度强化学习的非朗伯体表面轻微瑕疵检测方法;采用自动视觉检测建模,利用摄像头捕获任意角度下的待检产品图像;随后对捕获的待检产品图像进行预处理,并输入到具有卷积层的深度神经网络模型;输出机械手需旋转待检产品的偏移角度;进而控制机械手实现产品旋转并捕获新的图像,直至判定产品是否存在外观瑕疵。

7、本发明进一步设置为:将自动视觉检测强化为马尔可夫决策过程模型:

8、m=<δ,a,r,р,γ>

9、其中,δ是状态空间,即产品已捕获的图像序列;a是决策空间,即机械手旋转的角度;r是奖励函数,即当前动作的数值化好坏程度,r:δ×a→r;p是环境动态,即当前状态经动作改变后到新状态的映射,p:δ×a→δ;γ∈[0,1]是衰减系数,即当前动作对未来奖励影响随时间间隔而逐渐降低。

10、本发明进一步设置为:深度神经网络模型采用多卷积-池化层和稠密层的组合,输出层的节点数为|a|,输出的是每个动作的值;令网络模型为f,其输入是状态和动作,输出是动作值,将值函数的学习看作是回归问题。其目标函数为均方误差:

11、

12、st表示t时刻的状态,st+1表示t时刻下一时刻的状态,at表示t时刻的动作,rt表示奖励,θt表示当前网络参数。

13、本发明进一步设置为:所述步骤s2和步骤s3采用基于迁移学习的深度强化学习跨场景策略修正方法,当产品外观发生改变,捕获新产品的图像后,首先通过哈希组来实现相似产品检测,随后将检索获得的k个产品图像输入已有模型,从而获得响应的规划策略,再通过学习调整权重,用于估计待修正策略,从而完成知识迁移。

14、本发明进一步设置为:采用局部敏感哈希帮助进行检索,局部敏感哈希鼓励冲突,通过映射使得原空间中相近的两点具有相似的哈希值,反之亦然;局部敏感哈希的输入是将新产品图像x’输入原模型中经过卷积-池化层嵌入后的稠密向量;输出是离散的哈希值,再根据新产品图像的哈希值检索相近的k个原产品图像x;卷积层为cnn:rm→rn局部敏感哈希为lsh:rn→пd;通过局部敏感哈希检索top-k个相似度高的已有样本形式化描述为:

15、i(x',k)=topkx∈d(sim(lsh(cnn(x)),lsh(cnn(x')))),

16、其中,sim:πd×πd→[0,1]是相似度函数。

17、本发明进一步设置为:学习调整权重,权重由k个节点组成,经softmax归一化的神经网络层,采用三层神经网络,不使用激活函数来计算该权重,输入是k个相近的视角规划策略,由i(x’,k)∈r|a|×k表示,输出使权重y∈rk,权重学习网络为g,则目标函数为:

18、

19、本发明进一步设置为:机械手在旋转过程中为避免对产品在同一角度多次采样,将当前待检产品被采集的图像序列作为状态编码,其编码方式根据最大旋转次数来组合产品历史图像作为深度神经网络输入或通过长短期记忆网络等可用于时序问题的神经网络模型来实现对历史图像序列编码;

20、其动作编码采用离散编码,即以小偏移角度为间隔,均匀划分[0°,360°],外加“合格”、“残次”两个决策项;其奖励函数采用稀疏奖励,当产品被正确检测为“合格”或“残次”时候才会给予+1的奖励;当产品品质判别错误时,给予-1奖励;其他动作奖励为零。

21、本发明进一步设置为:状态编码采用循环神经网络(rnn))来编码状态的时序特征,其计算公式为:

22、ht=sigmoid(mtwh+bh)

23、mt=tanh(xtwm1+mt-1wm2+bm)

24、其中,xt和ht分别是循环神经网络结构中的输入和输出,m0由初始化随机赋值,wm1、wm2和wh是三个矩阵(稠密层),由反向传播更新,sigmoid和tanh是激活函数,用以规范输出空间。

25、本发明进一步设置为:对奖励稀疏的问题采用梯度补偿痕迹进行求解,其公式为:

26、

27、

28、其中,θt是每层网络在t时刻的权重,et是资格痕迹中的关键累积量,αt是学习率,γt是折扣因子;时间差分误差记作:

29、δt=rt+γmaxa f(st+1,a)-f(st,at)

30、

31、综上所述,本发明具有以下有益效果:1.基于多视角的工作中,视角规划针对特定产品外观及检测场景设计、捕获图像角度固定。本申请采用动态多视角规划,通过数据驱动的人工智能方法实现检测视角的自动规划。2.由于当检测场景中的待检产品外形、光源位置等影响视觉信息采集的关键因素发生变化后,其检测性能会明显降低,本申请根据已有知识,通过小样本修正,使其快速适应新的待检产品。3.对奖励稀疏的问题采用梯度补偿痕迹进行求解,结合状态的时序特征与梯度补偿痕迹加速学习过程改善学习效率。

技术特征:

1.用于非朗伯体外观的自主多角度联合检测方法,其特征是:包括以下步骤:

2.根据权利要求1所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:所述步骤s1中对单一产品外观进行检测是采用基于深度强化学习的非朗伯体表面轻微瑕疵检测方法;采用自动视觉检测建模,利用摄像头捕获任意角度下的待检产品图像;随后对捕获的待检产品图像进行预处理,并输入到具有卷积层的深度神经网络模型;输出机械手需旋转待检产品的偏移角度;进而控制机械手实现产品旋转并捕获新的图像,直至判定产品是否存在外观瑕疵。

3.根据权利要求2所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:将自动视觉检测强化为马尔可夫决策过程模型:

4.根据权利要求2所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:深度神经网络模型采用多卷积-池化层和稠密层的组合,输出层的节点数为|a|,输出的是每个动作的值;令网络模型为f,其输入是状态和动作,输出是动作值,将值函数的学习看作是回归问题。其目标函数为均方误差:

5.根据权利要求1所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:所述步骤s2和步骤s3采用基于迁移学习的深度强化学习跨场景策略修正方法,当产品外观发生改变,捕获新产品的图像后,首先通过哈希组来实现相似产品检测,随后将检索获得的k个产品图像输入已有模型,从而获得响应的规划策略,再通过学习调整权重,用于估计待修正策略,从而完成知识迁移。

6.根据权利要求5所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:采用局部敏感哈希帮助进行检索,局部敏感哈希鼓励冲突,通过映射使得原空间中相近的两点具有相似的哈希值,反之亦然;局部敏感哈希的输入是将新产品图像x’输入原模型中经过卷积-池化层嵌入后的稠密向量;输出是离散的哈希值,再根据新产品图像的哈希值检索相近的k个原产品图像x;卷积层为cnn:rm→rn局部敏感哈希为lsh:rn→пd;通过局部敏感哈希检索top-k个相似度高的已有样本形式化描述为:

7.根据权利要求5所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:学习调整权重,权重由k个节点组成,经softmax归一化的神经网络层,采用三层神经网络,不使用激活函数来计算该权重,输入是k个相近的视角规划策略,由i(x’,k)∈r|a|×k表示,输出使权重y∈rk,权重学习网络为g,则目标函数为:

8.根据权利要求2所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:机械手在旋转过程中为避免对产品在同一角度多次采样,将当前待检产品被采集的图像序列作为状态编码,其编码方式根据最大旋转次数来组合产品历史图像作为深度神经网络输入或通过长短期记忆网络等可用于时序问题的神经网络模型来实现对历史图像序列编码;

9.根据权利要求8所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:状态编码才用循环神经网络(rnn))来编码状态的时序特征,其计算公式为:

10.根据权利要求9所述的用于非朗伯体外观的自主多角度联合检测方法,其特征是:对奖励稀疏的问题采用梯度补偿痕迹进行求解,其公式为:

技术总结

本发明公开了用于非朗伯体外观的自主多角度联合检测方法,涉及自动检测技术领域。在固定检测场景下对单一产品外观进行检测,通过数据驱动的人工智能方法获得多视角规划策略。通过已学得的视角规划策略和学习所用的样本集合,查询新产品图像的Top‑k个近似邻居样本,并获得对应的视角规划策略。通过新产品的样本来调整k个检索视角规划策略的权重,通过加权和的方式来估计任意新产品图像的多视角规划策略。采用深度强化学习框架,不断试错获得视角规划策略。使用新的少样本学习方法来实现知识迁移:采用LSH来检索相似样本,通过重加权修正规划策略。使用梯度补偿痕迹应对奖励稀疏:结合状态的时序特征与梯度补偿痕迹加速学习过程。

技术研发人员:王碧,聂宇松,黄伟东,杨书新,吴剑青,曾博文

受保护的技术使用者:江西理工大学

技术研发日:

技术公布日:2024/1/12

- 还没有人留言评论。精彩留言会获得点赞!