基于元自步学习的视频/图片-文本跨模态匹配训练方法

基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法

技术领域

1.本发明属于视频/图片

‑

文本跨模态检索技术领域,更为具体地讲,涉及一种基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法。

背景技术:

2.现有跨模态检索的任务,比如视频

‑

文本检索、图片

‑

文本检索等都需要计算不同模态之间特征的相似度,这通常是由度量学习驱动的。当前主流的跨模态检索方法在特征提取网络中用预训练的卷积神经网络来提取视频/图片的特征向量,双向长短记忆(bi

‑

lstm)神经网络来提取文本的特征向量,并将视频/图片的特征向量和文本的特征向量映射到一个公共的空间内来消除异构鸿沟。视频/图片

‑

文本跨模态匹配训练就是训练特征提取网络,使其提取的视频/图片的特征向量、文本的特征向量在一个公共的空间上,为后面的视频/图片

‑

文本跨模态检索做准备。

3.现有视频/图片

‑

文本跨模态匹配训练采用无权重的三元组损失来训练特征提取网络,使得相互匹配的样本视频/图片

‑

文本对相互靠近,不匹配的样本视频/图片

‑

文本对相互远离。学习得到的共享空间不仅能消除模态间的异构鸿沟,同时能准确度量不同特征向量之间的相似度。

4.最近深度度量学习的突破表明,合适的加权策略能有效提升特征提取网络训练的收敛速度,并进一步提升其性能。现有的跨模态度量学习方法通过手工设计一个加权函数为单个的相似度分数进行加权或者为三元组进行加权。手工设计的权重函数能依据样本视频/图片

‑

文本对的难易程度为其分配合适的权重值,相似度分数较小的正对和相似度分数较大的负对能得到更大的权重值,反之相似度分数较大的正对和相似度分数较小的正对得到较小的权重值,从而在视频/图片

‑

文本跨模态检索模型训练时得到有效的更新。

5.现有跨模态加权策略首先从mini

‑

batch或者memory bank内选择信息对,然后通过手工设定一个加权函数来依据样本对的难易程度为其分配合适的权重值。当利用加权损失函数训练跨模态检索网络时,相似度分数较小的正对或者相似度分数较大的负对会产生较大的梯度因子,反之相似度分数较大的正对或者相似度分数较小的负对会产生较小的梯度因子。这种为不同视频/图片

‑

文本对分配动态梯度因子的策略,可以使得视频/图片

‑

文本得到高效的更新,从而使得跨模态检索模型收敛更快且精度更好。

6.尽管手工设计加权函数的方法能有效提升视频/图片

‑

文本跨模态检索模型的收敛速度,并进一步提升其检索性能。然而,其有两个不足,(1)、不同的视频/图片

‑

文本数据分布通常需要不同的加权方式,在对视频/图片

‑

文本数据集的分布知之甚少的情况下,很难确定加权函数的形式。(2)手工设计的加权函数不可避免的牵涉到超参数。超参数通常需要手工设定或在验证集上进行精调,需要花费大量的计算时间和资源来设定合适的超参数。以上问题的存在使得现有的基于手工设计权重函数的方法很难在实际中广泛使用。

技术实现要素:

7.本发明的目的在于克服现有技术的不足,提供一种基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法,以有效避免加权函数形式选择以及超参数设定难题。

8.为实现上述发明目的,本发明基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法,其特征在于,包括以下步骤:

9.(1)、构建训练的辅助网络

10.构建一个与用于视频/图片

‑

文本跨模态检索的主特征提取网络结构相同的辅助特征提取网络;

11.构建一个由一层全连接层组成的元自步网络;

12.(2)、更新辅助特征提取网络

13.在训练集中提取一批视频/图片

‑

文本对(k对)送入辅助特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度依据视频/图片的特征向量分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

1)个负对相似度中,选择最大的作为最难负对相似度

14.其中,vi表示视频/图像,t表示文本,表示第k个视频/图片

‑

文本对(正对),表示第k个视频/图片

‑

文本对对应的最难负对,f

θ

表示辅助特征提取网络;

15.将正对相似度最难负对相似度送入元自步网络,得到正对权重最难负对权重表示为:

[0016][0017]

其中,v(

·

)是表示元自步网络,w表示元自步网络的网络参数;

[0018]

采用梯度下降方法更新辅助特征提取网络的网络参数θ:

[0019][0020]

其中,α为学习率,为求关于网络参数θ的梯度;

[0021]

(3)、更新元自步网络

[0022]

将验证集一批视频/图片

‑

文本对(k对)送入辅助特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度依据视频/图片的特征向量分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的

相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

10个负对相似度中,选择最大的作为最难负对相似度

[0023]

其中,表示第k个视频/图片

‑

文本对(正对),表示第k个视频/图片

‑

文本对对应的最难负对;

[0024]

采用梯度下降方法更新元自步网络的网络参数w:

[0025][0026][0027]

其中,β为学习率,λ为常量,右下角加号表示元损失为正;

[0028]

(4)、更新主特征提取网络

[0029]

将训练集中提取的一批视频/图片

‑

文本对(k对)送入主特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度依据视频/图片的特征向量分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

1)个负对相似度中,选择最小的作为最难负对相似度

[0030]

将正对相似度最难负对相似度送入元自步网络,得到正对权重最难负对权重表示为:

[0031][0032]

采用梯度下降方法更新主特征提取网络的网络参数θ

′

:

[0033][0034]

其中,为求关于网络参数θ

′

的梯度;

[0035]

(5)、迭代更新主特征提取网络的网络参数

[0036]

将主特征提取网络的网络参数赋值给辅助特征提取网络,然后返回步骤(2),直到梯度下降值小于设定的阈值或迭代达到设定的次数,完成主特征提取网络训练,即完成视频/图片

‑

文本跨模态匹配训练。

[0037]

本发明的目的是这样实现的。

[0038]

为了解决现有技术存在的两个难题,本发明基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法,创新性提出了由一层全连接层组成的元自步网络,在训练主特征提取网络的同时,从验证集学习一个加权函数,从而有效避免函数形式选择以及超参数设定的难题。由于全连接层可以拟合任意的连续函数,包括已有的手工设计的加权函数,因此元自步网络为损失函数的可表达形式提供了极大的灵活性。元自步网络以正对和负对的相似度分数作为输入,并输出其对应的权重值。同时,采用元学习的方式来更新元自步网络,在主网络训练的同时,利用验证集的数据来更新元自步网络。本发明提出的元自步网络可以普遍应用于已有的跨模态匹配序列中,并进一步提升视频/图片

‑

文本跨模态检索模型的收敛速度和性能。

附图说明

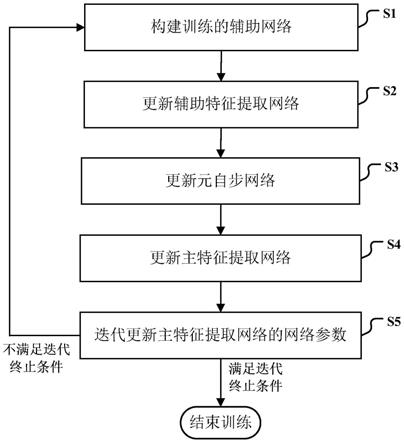

[0039]

图1是本发明基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法一种具体实施方式流程图;

[0040]

图2是基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法一种具体实施方式原理示意图。

具体实施方式

[0041]

下面结合附图对本发明的具体实施方式进行描述,以便本领域的技术人员更好地理解本发明。需要特别提醒注意的是,在以下的描述中,当已知功能和设计的详细描述也许会淡化本发明的主要内容时,这些描述在这里将被忽略。

[0042]

图1是本发明基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法一种具体实施方式流程图。

[0043]

在本实施例中,如图1所示,本发明基于元自步学习的视频/图片

‑

文本跨模态匹配训练方法包括以下步骤:

[0044]

步骤s1:构建训练的辅助网络

[0045]

如图2所示,在本发明中,构建的辅助网络包括:一个与用于视频/图片

‑

文本跨模态检索的主特征提取网络结构相同的辅助特征提取网络以及一个由一层全连接层组成的元自步网络。

[0046]

学习元自步网络的网络参数w是一个非平凡的任务。本发明采用元学习的方式在主特征提取网络训练的同时来更新元自步网络,在验证集上学习网络参数w然后将其应用于训练集,采用循环优化来交替更新元自步网络的网络参数w以及主特征提取网络的网络参数θ

′

,二者同时进行更新(训练),训练优化都采用梯度下降算法进行,具体步骤为s2~s4。

[0047]

步骤s2:更新辅助特征提取网络

[0048]

如图2所示,在训练集中提取一批视频/图片

‑

文本对(k对)送入辅助特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量

[0049]

然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度同时,依据视频/图片的特征向量

分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

1)个负对相似度中,选择最大的作为最难负对相似度

[0050]

其中,vi表示视频/图像,t表示文本,表示第k个视频/图片

‑

文本对(正对),表示第k个视频/图片

‑

文本对对应的最难负对,f

θ

表示辅助特征提取网络。

[0051]

将正对相似度最难负对相似度送入元自步网络,得到正对权重最难负对权重表示为:

[0052][0053]

其中,v(

·

)是表示元自步网络,w表示元自步网络的网络参数。

[0054]

值得注意的是,本发明中,元自步网络同时以正对和最难负对的相似度分数作为输入,使得学习到的权重函数在计算权重时,不仅能考虑到自相似度分数,同时能考虑到它们之间的交互,比如:正负对之间的相对相似度分数。

[0055]

采用梯度下降方法更新辅助特征提取网络的网络参数θ:

[0056][0057]

其中,α为学习率,为求关于网络参数θ的梯度。

[0058]

步骤s3:更新元自步网络

[0059]

将验证集一批视频/图片

‑

文本对(k对)送入辅助特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度依据视频/图片的特征向量分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

1)个负对相似度中,选择最大的作为最难负对相似度

[0060]

其中,表示第k个视频/图片

‑

文本对(正对),表示第k个视频/图片

‑

文本对对应的最难负对。

[0061]

定义一个元损失作为目标函数来获取元自步网络最优的超参数w*:

[0062]

[0063]

其中,是利用验证集的数据计算,它对于网络参数w是可微的,因此,可以采用梯度下降方法更新元自步网络的网络参数w:

[0064][0065][0066]

其中,β为学习率,λ为常量,右下角加号表示元损失为正。

[0067]

步骤s4:更新主特征提取网络

[0068]

将训练集中提取的一批视频/图片

‑

文本对(k对)送入主特征提取网络,得到视频/图片的特征向量以及对应的文本特征向量然后对于第k对视频/图片

‑

文本对,计算视频/图片的特征向量以及对应的文本特征向量的相似度,并作为正对相似度依据视频/图片的特征向量分别计算其与其他k

‑

1个文本特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,得到k

‑

1负对相似度,依据文本特征向量分别计算其与其他k

‑

1个视频/图片的特征向量j=1,2,...k,j≠k的相似度,并分别作为负对相似度,再得到k

‑

1负对相似度,在得到的2(k

‑

1)个负对相似度中,选择最大的作为最难负对相似度

[0069]

将正对相似度最难负对相似度送入元自步网络,得到正对权重最难负对权重表示为:

[0070][0071]

采用梯度下降方法更新主特征提取网络的网络参数θ

′

:

[0072][0073]

其中,为求关于网络参数θ

′

的梯度。

[0074]

步骤s5:迭代更新主特征提取网络的网络参数

[0075]

将主特征提取网络的网络参数赋值给辅助特征提取网络,然后返回步骤s2,直到梯度下降值小于设定的阈值或迭代达到设定的次数,完成主特征提取网络训练,即完成视频/图片

‑

文本跨模态匹配训练。

[0076]

匹配训练可表示为:。

[0077][0078]

实验评估

[0079]

本发明视频/图片

‑

文本跨模态匹配训练方法可以与已有的跨模特检索方法结合,进一步提升视频/图片

‑

文本跨模态检索模型的收敛速度和检索精度。为了评估本发明的性能,将本发明视频/图片

‑

文本跨模态匹配训练方法应用于三个典型的视频/图片

‑

文本跨模态检索方法上,并在图片

‑

文本检索任务和视频

‑

文本检索任务上对其进行评估。

[0080]

在评估中,采用recall@k(k=1,5,10)来作为评价指标。recall@k是跨模态检索领域最常用的评价指标,它表示在返回的前k个结果中有正确标签的查询样例所占的比例。

[0081]

对于图片

‑

文本检索任务,将本发明应用于bfan模型,并在最常用的两个数据集flickr30k和ms

‑

coco上验证其性能。实验结果分别列在表1和表2中。

[0082][0083][0084]

表1

[0085][0086]

表2

[0087]

从表1、表2的实验结果可以看出,本发明可以大幅提升bfan的检索性能,在flickr30k数据集上,对于图片

‑

检索文本任务,bfan(equal)能获得5.0(recall@1)的提升。在大规模数据集ms

‑

coco上,对于图片

‑

检索文本任务,bfan能获得0.7(recall@1)的提升。

[0088]

对于在视频

‑

文本检索任务,将本发明应用于dual encoding和其改进版本dual encoding(hybrid)上,分别在msr

‑

vtt数据集和vatex数据集上评估其性能。

[0089][0090]

表3

[0091][0092]

表4

[0093]

实验结果总结在表3和表4中,从结果可以看出,本发明可以进一步提升模型的性能。

[0094]

尽管上面对本发明说明性的具体实施方式进行了描述,以便于本技术领域的技术人员理解本发明,但应该清楚,本发明不限于具体实施方式的范围,对本技术领域的普通技术人员来讲,只要各种变化在所附的权利要求限定和确定的本发明的精神和范围内,这些变化是显而易见的,一切利用本发明构思的发明创造均在保护之列。

相关技术

网友询问留言

已有1条留言

-

0158022... 来自[中国] 2023年02月15日 19:47感谢,资源贡献

0158022... 来自[中国] 2023年02月15日 19:47感谢,资源贡献

1