一种双目立体匹配数据集视差真值获取方法

1.本发明涉及了一种双目数据集视差参数获取方法,尤其是涉及农业工程领域中的植物双目三维重建与表型测量的一种双目立体匹配数据集构建方法。

背景技术:

2.随着近些年人工智能、机器人视觉技术的发展,基于深度学习的立体匹配方法在公开双目榜单上的表现远超传统算法。但深度学习模型的训练需要大型数据集作为支撑,而双目立体匹配数据集中真值(视差图)的获取是学术界的一大难题。

3.针对该问题,有学者使用计算机视觉仿真软件获取视差图,但在虚拟数据集上训练的模型泛化能力存在一定问题;也有学者针对室外重建、自动驾驶等场景,使用激光雷达获取的深度值作为真值,并与双目左相机进行配准,从而生成视差图,但该方法获取的视差图误差大、稠密度低;也有学者针对室内重建场景,使用投影仪与双目相机搭建结构光测量系统,利用编解码获得的深度值作为真值,但该方法的系统复杂、费时费力,不利于自动化、快速构建大规模数据集。

技术实现要素:

4.针对上述问题,本发明的目的在于提供一种快速、半自动化获取双目立体匹配数据集视差真值的方法,旨在构建特定用途和场景下的大规模、高质量双目立体匹配数据集,用于有监督深度学习模型的迁移学习与微调,实现基于双目视觉的高精度深度信息感知。

5.本发明针对上述问题,使用结构光深度相机与双目相机,提出一种获取高精度、高稠密度视差真值的方法,用于快速、自动化构建大规模双目立体匹配数据集,并用于指定场景下的深度学习立体匹配模型的迁移学习与微调,实现双目重建。

6.为了达到上述目的,本发明采用的技术方案是如下,实施步骤包括相机联合标定、图像配准和视差计算与视差图生成。

7.方法是采用结构光深度相机与双目相机,分别采集指定场景的图像进而以双目相机中的左相机和结构光深度相机的参数和图像进行处理获得指定场景下的双目立体匹配数据集的视差真值的获取。

8.传统的双目图像数据的视差真值的参数难以准确获得,本发明的创新是在于巧妙利用结构光深度相机的高精度深度图,将其与左相机获取的图像进行配准,转换为视差图,从而实现了双目立体匹配数据集视差真值的准确获取。

9.步骤a、使用双目相机与结构光深度相机搭建成像平台,成像平台与数据集构建系统;调整两相机的相对位姿直至合适,在后续标定、图像配准以及数据集构建的过程中,保持两相机的相对位姿不变。

10.所述的双目相机采用zed双目相机;

11.所述的结构光深度相机采用mech-mind高精度结构光深度相机。

12.步骤b、使用棋盘格标定板与张正友标定法获得双目相机的左相机与结构光深度

相机的内参、外参作为标定结果,再计算左相机与结构光深度相机之间的相对外参,相对外参包括旋转矩阵与平移矩阵;

13.步骤c、使用双目相机的左相机和右相机拍摄指定场景获取指定场景的左、右视图,使用结构光深度相机拍摄指定场景获取场景的深度图;

14.步骤d、利用标定结果与相对外参结果,遍历深度图中的每个像素计算其在左视图中的像素坐标用于配准;即获得深度图上每个像素和左视图的对应关系,就实现了图像配准。

15.步骤e、利用双目相机的内参标定结果将深度图中的深度值转换计算视差值,从而生成视差图,对生成的视差图以及双目相机原始采集的左、右视图进行尺寸归一化处理,例如可以进行剪裁等后处理操作,将尺寸归一化后的左、右视图作为双目立体匹配数据集的双目视图,即输入信号;将尺寸归一化后的视差图作为双目立体匹配数据集的视差真值,即监督信号。

16.不断重复上述过程,即可构建大规模双目重建数据集。

17.所述步骤d包括如下步骤:

18.利用深度图中当前像素的深度值与深度相机的内参矩阵,将当前像素在深度图的像素坐标系下的坐标转换为深度相机的相机坐标系下的坐标;

19.然后利用步骤b中得到的相对外参结果,将当前像素在深度相机的相机坐标系下的坐标转换为双目相机中左相机的相机坐标系下的坐标;

20.利用当前像素的深度值与双目左相机的内参矩阵,将当前像素在双目左相机的相机坐标系下的坐标转换为在左视图的像素坐标系下的坐标。

21.所述步骤e中,双目相机的内参标定结果包括焦距与基线距离,按照以下公式转换计算视差值:

[0022][0023]

其中,b

zed

表示双目相机的基线距离,f

zed

表示双目相机的焦距,di表示深度图中第i个像素点的深度值所转换为的视差值。

[0024]

本发明具有的有益效果是:

[0025]

本发明通过所提出的相机联合标定与图像配准的方式,以半自动化的手段生成双目立体匹配数据集的视差真值。

[0026]

本发明方法获取视差真值构建数据集,能大幅度减少双目立体匹配数据集构建过程中的人力、物力成本,能够保证在真实场景下快速构建大规模立体匹配数据集。

[0027]

与使用其他方法构建的数据集相比,使用本发明方法构建的数据集的真实视差图具有精度高、稠密度高等优点,可以用于有监督的深度学习模型在特定任务与需求中的迁移学习与微调,实现特定场景下(如农业工程领域中的植物三维重建与表型测量或机器人领域中的机器人室内抓取操作)的高精度双目立体匹配、三维重建与机器人深度感知。

附图说明

[0028]

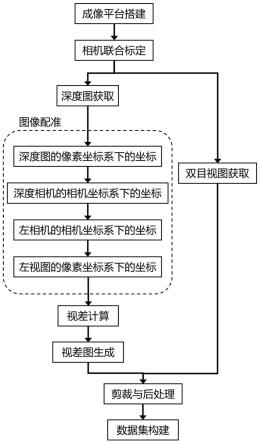

图1为本方法的总体流程图;

[0029]

图2为本发明的图像配准环节的示意图;

[0030]

图3为搭建的成像平台示意图;

[0031]

图4为以植物(包括菠菜、番茄、辣椒、南瓜植株的幼苗)为例,使用该方法构建的数据集(包括左视图、右视图、视差真值);

[0032]

图5为代表性立体匹配算法(包括传统匹配算法:bm、sgm,深度学习算法:psmnet、gwcnet)在测试数据集上的表现。

[0033]

图中:1.zed双目相机,2.mech-mind结构光高精度深度相机,3.相机连接件。

具体实施方式

[0034]

下面结合附图和实例对本发明作进一步说明。

[0035]

本发明的硬件装置包括:一台zed双目相机,一台mech-mind结构光深度相机及其连接件与成像平台。结构光深度相机与双目相机的分辨率、视场角等参数不相同,无法直接将深度图作为双目的真值,本发明计算其与双目左相机获取的图像之间的像素对应关系。

[0036]

在上述成像平台的基础上,首先利用棋盘格标定板与张正友标定法分别获取双目相机的左相机与结构光深度相机的内参与绝对外参,利用上述参数求取两相机之间相对外参(包括旋转与平移矩阵)。接下来,在结构光相机深度图的像素坐标系中遍历每一个像素点,求取其在双目相机的左相机的像素坐标系下的坐标,并将像素点对应的深度值利用双目与双目相机内参转换为对应的视差值,形成视差图。该视差图可与后续经过裁剪的双目相机获取的左、右视图共同构建双目立体匹配任务的数据集。

[0037]

如图1、图2所示,本发明描述的方法共包括三大步骤:相机联合标定、图像配准、视差计算与视差图生成,其中:

[0038]

1)相机联合标定:

[0039]

首先分别使用双目相机与结构光深度相机,获取包含棋盘格标定板的场景视图。利用张正友标定法,获得结构光深度相机与双目相机的左相机在世界坐标系下的外参矩阵(包括旋转矩阵r

mech

、r

zed

与平移矩阵t

mech

、t

zed

)与各自的内参矩阵(包括k

mech

、k

zed

)。接下来,利用上述外参矩阵,求取结构光深度相机的相机坐标系到双目相机左相机的相机坐标系的相对旋转矩阵r

mech

→

zed

与平移矩阵t

mech

→

zed

:

[0040]rmech

→

zed

=r

zed

(r

mech

)-1

[0041]

t

mech

→

zed

=t

zed-r

zed

(r

mech

)-1

t

mech

[0042]

其中,r

mech

、r

zed

分别表示zed双目相机、mech-mind结构光深度相机的旋转矩阵。

[0043]

2)图像配准:

[0044]

参见图2所示的步骤,获取真实视差图的关键在于计算深度图中每个像素点在双目相机左视图像素坐标系下的对应位置。对此,需要遍历深度图中每行与每列的所有像素进行计算。

[0045]

在此,以深度图中的第i个像素为例进行介绍。

[0046]

首先,利用第i个像素的深度值与结构光深度相机的内参与结构光深度相机的内参将结构光深度相机获取的深度图的第i个像素的像素坐标转换为在结构光深度相机的相机坐标系下的坐标

[0047][0048]

其中,分别表示第i个像素在结构光深度相机的相机坐标系x、y、z轴的坐标值,f

x,mech

、f

y,mech

分别表示结构光深度相机在x和y方向上的焦距,u

0,mech

、v

0,mech

分别表示结构光深度相机在u、v方向上的主点像素坐标值,分别表示第i个像素在结构光深度相机的像素坐标系u、v轴的坐标值。

[0049]

接下来,利用步骤1)中得到的两相机间的相对转换关系r

mech

→

zed

与t

mech

→

zed

,可以将深度相机的相机坐标系下的坐标转换为双目左相机的相机坐标下的坐标

[0050][0051]

其中,分别表示第i个像素在双目相机的左相机的相机坐标系x、y、z轴的坐标值。

[0052]

最后,利用步骤1)中标定得到的双目相机的左相机的内参最后,利用步骤1)中标定得到的双目相机的左相机的内参与对应像素的深度值计算出该像素点在双目左相机视场下的像素坐标

[0053][0054]

其中,f

x,zed

、f

y,zed

分别表示双目相机的左相机在x和y方向上的焦距,u

0,zed

、u

0,zed

分别表示双目相机的左相机在u、v方向上的主点像素坐标值,分别表示第i个像素在双目相机的左相机的像素坐标系u、v轴的坐标值。

[0055]

然后便可将第i个像素在深度相机的像素坐标系中的坐标转换为在双目左相机的像素坐标系中的坐标

[0056]

通过遍历深度图中的每个像素,便可得到深度图中每个像素在双目左视图中的像素坐标。

[0057]

3)视差计算与视差图生成:

[0058]

在进行该步骤的操作之前,还要再次利用棋盘格标定板与张正友标定法对zed双目相机进行额外的双目标定,并获得其内参(包括双目基线距离b

zed

与相机焦距f

zed

)。

[0059]

接着根据双目视觉的与双目相机的内参(包括基线距离与焦距),可将对应像素点的深度值转换为视差值di:

[0060][0061]

最后,由于结构光深度相机的视场角小于双目相机的视场角,因此需要将双目相机获取的左、右视图的边缘进行剪裁,保证与视差图的视场范围保持一致。剪裁后的左、右视图可作为双目立体匹配数据集的输入;配准后得到的视差图可作为数据集的真值,在深度学习模型训练时提供监督信息。

[0062]

采用本发明描述的方法构建的植物双目重建数据集如图4所示。采用该数据集进行训练后的深度学习模型的预测结果如图5所示。

[0063]

由此,本发明为双目立体匹配任务的高精度、高稠密度视差真值获取与数据集制

作巧妙提供了一种方法,制作的数据集可用于深度学习模型的迁移学习与微调,最终实现特定场景(如机器人抓取、植物表型测量等)的双目三维重建。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1