一种基于表情识别的用户体验度量方法与流程

1.本发明属于人脸表情识别技术领域,具体涉及一种基于表情识别的用户体验度量方法。

背景技术:

2.用户满意度作为一种重要的参考指标,广泛应用于网站、服务平台等系统的建设与优化过程。

3.现有技术中,主要采取意见反馈、问卷调查等方式获取用户使用体验,该方式存在时效性差、数据噪声大、成本高等缺点,难以及时捕捉用户的情绪波动,无法有效的反应用户满意度。此为现有技术的不足之处。

4.有鉴于此,本发明提供一种基于表情识别的用户体验度量方法;以解决现有技术中存在上述技术缺陷,是非常有必要的。

技术实现要素:

5.本发明的目的在于,针对上述现有技术存在的缺陷,提供设计一种基于表情识别的用户体验度量方法,以解决上述技术问题。

6.为实现上述目的,本发明给出以下技术方案:

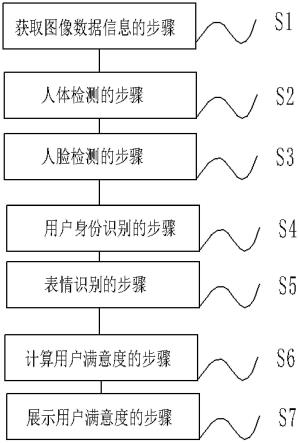

7.一种基于表情识别的用户体验度量方法,包括:

8.s1:获取图像数据信息的步骤,

9.通过视频监控设备获取视频数据流,对视频数据流进行解码处理;

10.s2:人体检测的步骤,

11.根据解码处理获得的图像数据,构建算法训练集以及测试集,通过目标检测网络模型进行训练,获得人体检测的模型输出置信度;

12.s3:人脸检测的步骤,

13.利用人脸检测算法从检测图像中检测人脸的位置;

14.s4:用户身份识别的步骤,

15.利用行人重识别算法识别用户身份,避免重复建立用户体验度量模型;

16.s5:表情识别的步骤,

17.获取人脸图像数据信息,并通过人脸表情分类模型对人脸图像数据信息分析处理,获得表情分类结果;

18.s6:计算用户满意度的步骤,

19.根据用户身份数据信息和表情分类结果,构建用户表情池模型,并通过用户满意度模型计算用户满意度;

20.s7:展示用户满意度的步骤,

21.以绘图的方式展示用户满意度的变化。如图3所示。

22.作为优选,所述的步骤s1中,对视频数据流进行解码处理后,通过opencv工具将解

码后的图像缩放至1280*720。

23.作为优选,所述的步骤s2中,采用ssd目标检测网络进行人体检测,通过步骤s1获取图像,构建算法训练集及测试集;本发明实施例中用于人体目标检测网络训练集数量为20000张,测试集为5000张。使用训练集及默认参数对ssd目标检测网络进行训练;将步骤s1中新获取的图像输入至ssd目标检测网络模型,输出预测结果[x

p-min

,y

p-min

,x

p-max

,y

p-max

,confidence-person];所述预测结果中[x

p-min

,y

p-min

,x

p-max

,y

p-max

]为人体目标最小外接矩形坐标,“confidence-person”为ssd目标检测网络模型输出的置信度。

[0024]

作为优选,所述的步骤s3中,使用人脸检测算法retinaface从检测图像中检测人脸的位置,使用公开数据集lfw作为训练集和测试集,采用默认参数训练retinaface;将步骤s1中图像输入至retinaface模型,输出人脸预测结果[x

f-min

,y

f-min

,x

f-max

,y

f-max

,confidence-face];所述预测结果中[x

f-min

,y

f-min

,x

f-max

,y

f-max

]为人脸目标最小外接矩形坐标,“confidence-face”为retinaface模型输出的置信度。

[0025]

作为优选,所述的步骤s4中,利用行人重识别算法(re-id)识别用户身份,避免重复建立用户体验度量模型;具体包括以下步骤:

[0026]

s41:识别用户身份的步骤,该步骤中采用多粒度网络(mgn)对步骤s2中人体图像进行行人重识别算法处理以获得用户身份信息;使用公开数据集cuhk03训练多粒度网络,获得re-id模型;实施过程中,将步骤s2中人体图像输入至多粒度网络获得人体特征,采用欧氏距离作为评价标准,将用户人体特征与已注册用户身份特征库进行比对,识别用户身份信息;若当前用户未注册,则自动注册该用户,并输出用户身份信息;若当前用户为注册用户,输出用户身份信息;

[0027]

注册数据示例为

[0028][0029]

所述用户身份注册数据格式中“feature”表示经多粒度网络提取到的人体特征向量;

[0030]

所述用户身份信息即该用户的注册数据;

[0031]

s42:匹配人脸对应身份的步骤,该步骤中,人体目标包括所有人体部位,例如头部、躯干、四肢等。通常情况下,在图像中某个个体的人脸最小外接矩形框应大部分位于人体目标最小外接矩形框内,如图2所示。使用步骤s2中人体目标最小外接矩形框与步骤s3中人脸最小外接矩形框进行匹配,获得人脸身份信息;匹配方法为将当前人脸最小外接矩形框与图像内所有检出的人体目标最小外接矩形框分别计算匹配度,选择最大的匹配度作为最终匹配度,当最终匹配度大于预设阈值m

th

时,则认为人脸目标与人体目标匹配;本发明实施例中预设阈值m

th

=0.85,可根据工程需要调整该值;人脸对应的身份即步骤s41中用户身份;匹配度计算方式为:

[0032]

[0033]

所述匹配度计算表达式中,i表示在图像中人体最小外接矩形框与人脸最小外接矩形框的交叠面积,s

face

为人脸最小外接矩形框的面积,如图2所示;所述面积的单位为像素。

[0034]

作为优选,所述的步骤s5具体包括以下步骤:

[0035]

s51:人脸图像获取的步骤,步骤s3人脸检测输出的最小外接矩形框表示为[x

f-min

,y

f-min

,x

f-max

,y

f-max

],使用矩形框坐标裁剪步骤s1中的原始图像,获取人脸图像;

[0036]

s52:表情分类的步骤,使用efficientface网络算法识别人脸表情;利用大规模人脸表情数据集raf-db训练efficientface网络,获得人脸表情分类模型;将步骤s51中的图像输入至所述人脸表情分类模型,输出分类结果c:

[0037][0038]

所述分类结果中,“class”表示表情类别,包括“happy”(高兴)、“normal”(平静)、“disgusted”(厌恶);“probability”表示置信度,其范围为[0,1]。

[0039]

作为优选,所述的步骤s6具体包括以下步骤:

[0040]

s61:建立用户表情池的步骤,针对实施过程中存在多名用户的情况,需根据步骤s4中re-id信息为每个用户建立表情池,达到提高系统效率的目的;所述表情池为某用户n个表情分类结果序列,其结构为:ci={c0,c1,

…

,c

n-1

,cn},其中ci表示第i个用户的表情池;cn表示当前时刻tn的表情分类结果;若所述身份存在于已建立的用户表情池则将表情分类结果更新至所属表情池,反之则为该用户新建表情池。

[0041]

s62:用户满意度计算的步骤:根据工程需要设定步骤s5中表情所代表的满意度分数;本发明中,各表情对应满意度分数设置为:高兴(+5分)、平静(0分)、厌恶(-5分);为提高用户满意度计算模型的稳定性并能够着重反应用户当前体验状态,本发明采用指数移动平均值(exponential moving average,简称ema)模型计算当前用户的满意度分数,所述用户满意度ema模型为:

[0042][0043]

其中,n为步骤s61中用户表情池长度;通过满意度ema模型可得出经指数加权后的用户满意度分数,提高用户体验度量的鲁棒性。

[0044]

本发明的有益效果在于,第一,采用基于深度学习的视频处理技术,对用户体验进行建模,能够实时提取用户表情变化并计算用户满意度分数,提高对用户体验度量的时效性和准确性。第二,通过建立表情池模型,提升体验度量的稳定性。结合re-id技术区分用户身份,避免重复建立表情池模型,提高系统运行效率。第三,使用指数移动平均值ema模型计算用户满意度分数,提高本发明所述系统的抗干扰能力。

[0045]

此外,本发明设计原理可靠,结构简单,具有非常广泛的应用前景。

[0046]

由此可见,本发明与现有技术相比,具有突出的实质性特点和显著地进步,其实施

的有益效果也是显而易见的。

附图说明

[0047]

图1是本发明提供的一种基于表情识别的用户体验度量方法的流程图。

[0048]

图2是人脸最小外接矩形框的面积的示意图。

[0049]

图3是用户满意度随时间变化示意图。

具体实施方式

[0050]

下面结合附图并通过具体实施例对本发明进行详细阐述,以下实施例是对本发明的解释,而本发明并不局限于以下实施方式。

[0051]

如图1-3所示,本实施例提供的一种基于表情识别的用户体验度量方法,包括:

[0052]

s1:获取图像数据信息的步骤,

[0053]

通过视频监控设备获取视频数据流,对视频数据流进行解码处理;对视频数据流进行解码处理后,通过opencv工具将解码后的图像缩放至1280*720。

[0054]

s2:人体检测的步骤,

[0055]

根据解码处理获得的图像数据,构建算法训练集以及测试集,通过目标检测网络模型进行训练,获得人体检测的模型输出置信度;

[0056]

所述的步骤s2中,采用ssd目标检测网络进行人体检测,通过步骤s1获取图像,构建算法训练集及测试集;本发明实施例中用于人体目标检测网络训练集数量为20000张,测试集为5000张。使用训练集及默认参数对ssd目标检测网络进行训练;将步骤s1中新获取的图像输入至ssd目标检测网络模型,输出预测结果[x

p-min

,y

p-min

,x

p-max

,y

p-max

,confidence-person];所述预测结果中[x

p-min

,y

p-min

,x

p-max

,y

p-max

]为人体目标最小外接矩形坐标,“confidence-person”为ssd目标检测网络模型输出的置信度。

[0057]

s3:人脸检测的步骤,

[0058]

利用人脸检测算法从检测图像中检测人脸的位置;

[0059]

所述的步骤s3中,使用人脸检测算法retinaface从检测图像中检测人脸的位置,使用公开数据集lfw作为训练集和测试集,采用默认参数训练retinaface;将步骤s1中图像输入至retinaface模型,输出人脸预测结果[x

f-min

,y

f-min

,x

f-max

,y

f-max

,confidence-face];所述预测结果中[x

f-min

,y

f-min

,x

f-max

,y

f-max

]为人脸目标最小外接矩形坐标,“confidence-face”为retinaface模型输出的置信度。

[0060]

s4:用户身份识别的步骤,

[0061]

利用行人重识别算法识别用户身份,避免重复建立用户体验度量模型;

[0062]

所述的步骤s4中,利用行人重识别算法(re-id)识别用户身份,避免重复建立用户体验度量模型;具体包括以下步骤:

[0063]

s41:识别用户身份的步骤,该步骤中采用多粒度网络(mgn)对步骤s2中人体图像进行行人重识别算法处理以获得用户身份信息;使用公开数据集cuhk03训练多粒度网络,获得re-id模型;实施过程中,将步骤s2中人体图像输入至多粒度网络获得人体特征,采用欧氏距离作为评价标准,将用户人体特征与已注册用户身份特征库进行比对,识别用户身份信息;若当前用户未注册,则自动注册该用户,并输出用户身份信息;若当前用户为注册

用户,输出用户身份信息;

[0064]

注册数据示例为

[0065][0066]

所述用户身份注册数据格式中“feature”表示经多粒度网络提取到的人体特征向量;

[0067]

所述用户身份信息即该用户的注册数据;

[0068]

s42:匹配人脸对应身份的步骤,该步骤中,人体目标包括所有人体部位,例如头部、躯干、四肢等。通常情况下,在图像中某个个体的人脸最小外接矩形框应大部分位于人体目标最小外接矩形框内,如图2所示。使用步骤s2中人体目标最小外接矩形框与步骤s3中人脸最小外接矩形框进行匹配,获得人脸身份信息;匹配方法为将当前人脸最小外接矩形框与图像内所有检出的人体目标最小外接矩形框分别计算匹配度,选择最大的匹配度作为最终匹配度,当最终匹配度大于预设阈值m

th

时,则认为人脸目标与人体目标匹配;本发明实施例中预设阈值m

th

=0.85,可根据工程需要调整该值;人脸对应的身份即步骤s41中用户身份;匹配度计算方式为:

[0069][0070]

所述匹配度计算表达式中,i表示在图像中人体最小外接矩形框与人脸最小外接矩形框的交叠面积,s

face

为人脸最小外接矩形框的面积,如图2所示;所述面积的单位为像素。

[0071]

s5:表情识别的步骤,

[0072]

获取人脸图像数据信息,并通过人脸表情分类模型对人脸图像数据信息分析处理,获得表情分类结果;

[0073]

所述的步骤s5具体包括以下步骤:

[0074]

s51:人脸图像获取的步骤,步骤s3人脸检测输出的最小外接矩形框表示为[x

f-min

,y

f-min

,x

f-max

,y

f-max

],使用矩形框坐标裁剪步骤s1中的原始图像,获取人脸图像;

[0075]

s52:表情分类的步骤,使用efficientface网络算法识别人脸表情;利用大规模人脸表情数据集raf-db训练efficientface网络,获得人脸表情分类模型;将步骤s51中的图像输入至所述人脸表情分类模型,输出分类结果c:

[0076][0077]

所述分类结果中,“class”表示表情类别,包括“happy”(高兴)、“normal”(平静)、“disgusted”(厌恶);“probability”表示置信度,其范围为[0,1]。

[0078]

s6:计算用户满意度的步骤,

[0079]

根据用户身份数据信息和表情分类结果,构建用户表情池模型,并通过用户满意度模型计算用户满意度;

[0080]

所述的步骤s6具体包括以下步骤:

[0081]

s61:建立用户表情池的步骤,针对实施过程中存在多名用户的情况,需根据步骤s4中re-id信息为每个用户建立表情池,达到提高系统效率的目的;所述表情池为某用户n个表情分类结果序列,其结构为:ci={c0,c1,

…

,c

n-1

,cn},其中ci表示第i个用户的表情池;cn表示当前时刻tn的表情分类结果;若所述身份存在于已建立的用户表情池则将表情分类结果更新至所属表情池,反之则为该用户新建表情池。

[0082]

s62:用户满意度计算的步骤:根据工程需要设定步骤s5中表情所代表的满意度分数;本发明中,各表情对应满意度分数设置为:高兴(+5分)、平静(0分)、厌恶(-5分);为提高用户满意度计算模型的稳定性并能够着重反应用户当前体验状态,本发明采用指数移动平均值(exponential moving average,简称ema)模型计算当前用户的满意度分数,所述用户满意度ema模型为:

[0083][0084]

其中,n为步骤s61中用户表情池长度;通过满意度ema模型可得出经指数加权后的用户满意度分数,提高用户体验度量的鲁棒性。

[0085]

s7:展示用户满意度的步骤,

[0086]

以绘图的方式展示用户满意度的变化。如图3所示。

[0087]

以上公开的仅为本发明的优选实施方式,但本发明并非局限于此,任何本领域的技术人员能思之的没有创造性的变化,以及在不脱离本发明原理前提下所作的若干改进和润饰,都应落在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1