基于视点追踪的智能人机交互方法

本发明属于基于视点追踪的人机交互,具体涉及一种基于视点追踪的智能人机交互方法。

背景技术:

1、人类对视点追踪的研究从早期的借助外部硬件设备判断眼动行为,发展到如今的利用摄像头或传感器估计用户视点位置的视点追踪技术。在视点追踪技术进步的同时,人类也开始追求更为高效的人机交互方式,于是诞生了基于视点追踪的人机交互技术。

2、视点追踪技术是一种利用专业设备,采集、分析用户眼部信息,从而确定用户视觉关注点的技术。视点追踪技术在众多领域都有着广泛的应用,例如在教育领域,可以根据学生的视线落点和关注区域来评估学生的上课质量;在心理学领域,可以根据视点变化检测人的精神状态,实现对心理疾病的治疗;在安全领域,可以根据用户预设的视点轨迹进行身份验证;在交通领域,可以根据用户视线判断盲区,辅助汽车驾驶等。在未来,视点追踪技术凭借兼容性,将与更多的领域相结合,有着广阔的应用前景。

3、人机交互技术是指人与计算机通过信息交换来实现期望的任务。人机交互研究首要关心的是能够改善人机互动的新型界面的设计、视线和评估,从而实现更具直观和稳健的人机交互方式。所以,人机交互自然而然地涉及到计算机科学和人文科学两个学科的内容,其中计算机科学包括图像处理、计算机视觉、编程语言等,人文科学包括人工工程学、认知心理学等。基于视点追踪的智能人机交互技术,将计算机科学和人文科学有机的联合在一起,形成了一种更为直观和稳健的人机交互方式。

4、基于视点追踪的智能人机交互技术以一种全新的人机交互方式,给用户带来了更为便捷、高效的操作体验。同时基于视点追踪的智能人机交互技术,可以摆脱对一些硬件设备如键盘、鼠标的需要,帮助残障、患病人士等操控计算机,具有广泛的研究和应用价值。

技术实现思路

1、本发明提供了一种基于视点追踪的智能人机交互方法,旨在实现一种仅通过计算机自带摄像头,不借助其他任何硬件设备,在没有任何约束的条件下利用深度学习算法实时对用户视点进行追踪,并监控用户面部姿态变化,利用视点和面部姿态变化实现基于视点追踪的人机交互。

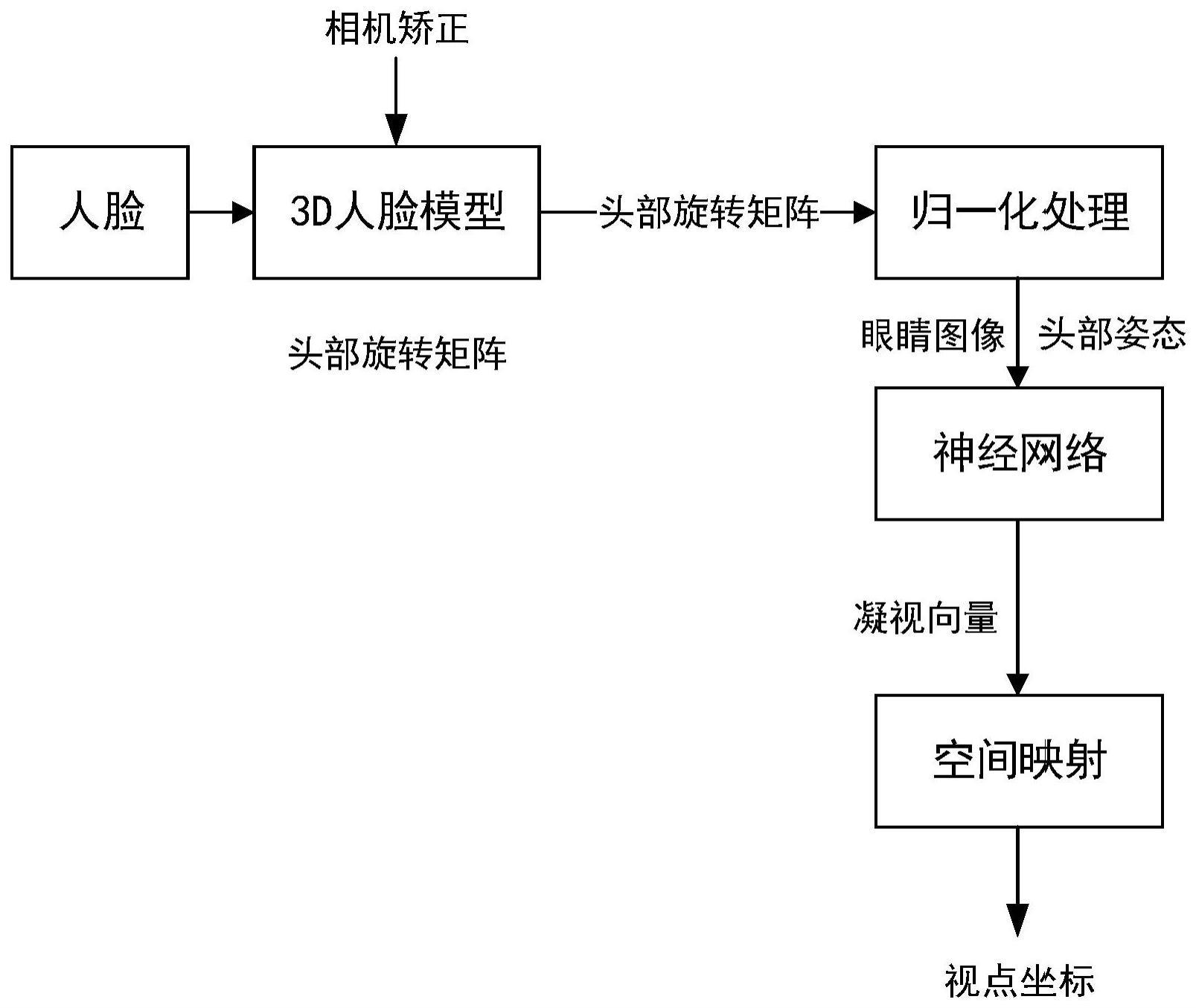

2、本发明采用的技术方案是:

3、一种基于视点追踪的智能人机交互方法,该方法包括下列步骤:

4、步骤1,通过计算机自带的摄像头采集图像,并对采集到的图像进行人脸检测,基于人脸检测框提取人脸图像;

5、对人脸图像进行人脸特征点检测,得到人脸图像的人脸特征点;

6、步骤2,头部姿态估计:

7、步骤201,定义一个包括6个关键点的3d人脸模型,其中,3d人脸模型的6个关键点为:每只眼睛分别包括左右眼角两个关键点,嘴巴包括左右嘴角两个关键点;

8、步骤202,在步骤1得到的人脸特征点中,查找与3d人脸模型的6个关键点位置对应的特征点,得到2d关键点;并基于2d关键点中的两只眼睛的关键点从人脸图像中提取出眼睛图像;

9、步骤203,基于3d人脸模型的6个关键点和对应的2d关键点,采用epnp算法获取头部旋转向量r,并基于头部旋转向量r计算旋转矩阵r′及对应的欧拉角,其中的欧拉角确定了头部的旋转角度,即2d头部角度;

10、步骤204,归一化处理:

11、定义头部坐标系,该坐标系包括x、y和z轴,其中,x轴为连接两个眼睛的中点,方向从右向左;y轴为从右眼睛中点向嘴巴方向出发,且垂直于x轴,z轴为从右眼睛中点指向人脸后方且垂直于x轴和y轴;

12、计算头部坐标系和相机坐标系之间的平移向量tr;

13、根据公式er=tr+eh分别计算左右眼在相机坐标系中的位置er,其中eh为两个眼角关键点的中点;

14、计算转换矩阵t=sr′,其中,缩放矩阵s=diag(1,1,dn/‖er‖),dn表示相机坐标系原点;

15、基于转换矩阵t对2d关键点中的眼睛的关键点位置进行转换,以及对2d头部角度进行转换,得到归一化后的2d眼睛关键点位置和2d头部角度;

16、步骤3,基于深度学习的视点追踪处理;

17、采用卷积神经网络vgg16架构作为视点追踪的网络模型,将眼睛图像作为模型的输入,并将归一化后的2d头部角度输入vgg16的第一个全连接层;并将vgg16的第一和第二池化层的池化步长修改为1;vgg16的第三个全连接层用于预测当前输入图像的眼睛的空间凝视向量;

18、对预测得到的空间凝视向量进行空间映射处理,以获取当前空间凝视向量所对应的屏幕坐标:

19、计算眼睛到屏幕的距离t:其中,ze表示头部坐标系中的眼睛中心的z轴坐标,zg表示头部坐标系中空间凝视向量的z轴坐标;

20、计算空间凝视向量在相机平面的坐标点(x,y):x=xe+t×xg,y=ye+t×yg;其中,xe,ye为头部坐标系中眼睛中心的x,y轴坐标,xg,yg为头部坐标系中空间凝视向量的x,y轴坐标;

21、将相机平面的坐标点(x,y)转换为屏幕像素点,得到空间凝视向量的屏幕映射点(px,py):

22、

23、

24、其中,wx,hx表示屏幕的像素,wm,hm表示屏幕的大小。

25、步骤4,基于视点追踪的人机交互处理:

26、基于预置的用户面部姿态变化信息与输入设备的操作方式的映射,提取当前用户面部姿态变化信息所对应的输入设备操作方式,该操作方式的在屏幕上的操作位置为空间凝视向量的屏幕映射点(px,py)。

27、进一步的,步骤1中,采用基于方向梯度直方图的人脸检测算法对采集到的图像进行人脸检测。

28、进一步的,步骤1中,采用基于级联回归树的人脸特征点检测算法对人脸图像进行人脸特征点检测。

29、进一步的,步骤4中,基于眼睛的姿态变化控制鼠标的操作。

30、进一步的,步骤4中,基于嘴巴的姿态变化和鼻子的位置控制鼠标和键盘的操作。

31、本发明提供的技术方案至少带来如下有益效果:

32、(1)可仅使用计算机自带的普通单目网络摄像头作为视点追踪的图像采集工具,其适用性强。

33、(2)使用基于vgg16的卷积神经网络作为深度学习算法对用户视点进行追踪,并针对vgg16框架做出了输入眼部图像较小的适应性调整,同时把头部姿态信息输入到全连接层,将vgg16框架扩展为多模态模型,提升了视点追踪的精度。

34、(3)借助用户面部变化的人机交互方式,实现了实时、便捷、高效的人机交互。

技术特征:

1.基于视点追踪的智能人机交互方法,其特征在于,包括下列步骤:

2.如权利要求1所述的方法,其特征在于,步骤1中,采用基于方向梯度直方图的人脸检测算法对采集到的图像进行人脸检测。

3.如权利要求1所述的方法,其特征在于,步骤1中,采用基于级联回归树的人脸特征点检测算法对人脸图像进行人脸特征点检测。

4.如权利要求1所述的方法,其特征在于,步骤4中,基于眼睛的姿态变化控制鼠标的操作。

5.如权利要求1所述的方法,其特征在于,步骤4中,基于嘴巴的姿态变化和鼻子的位置控制鼠标和键盘的操作。

技术总结

本发明公开了一种基于视点追踪的智能人机交互方法,属于基于视点追踪的人机交互技术领域。本发明包括:通过计算机自带的摄像头采集图像,并对采集到的图像进行人脸检测,基于人脸检测框提取人脸图像;对人脸图像进行人脸特征点检测,得到人脸图像的人脸特征点;对人脸特征点进行头部姿态估计获取眼睛图像,基于深度学习的视点追踪处理,基于视点追踪的人机交互处理。本发明实现一种仅通过计算机自带摄像头,不借助其他任何硬件设备,在没有任何约束的条件下利用深度学习算法实时对用户视点进行追踪,并监控用户面部姿态变化,利用视点和面部姿态变化实现基于视点追踪的人机交互。

技术研发人员:邢建川,刘梓然,曾凤,陈洋,周春文,付鱼,杨布雨

受保护的技术使用者:电子科技大学

技术研发日:

技术公布日:2024/1/12

- 还没有人留言评论。精彩留言会获得点赞!