结合注意力机制与强化学习应用于AI服务器散热的方法与流程

本发明涉及服务器散热,具体涉及一种结合注意力机制与强化学习应用于ai服务器散热的方法。

背景技术:

1、随着人工智能(ai)的发展,国内的服务器也渐渐往ai服务器发展,但是ai服务器的散热,一直也是按照传统服务器的方式进行散热,传统服务器的散热一般通过bmc(baseboard management controller,基板管理控制器)进行控制,bmc定期扫描服务器的主板信息并根据主板信息动态调整风扇的转速。

2、然而,ai服务器与传统服务器不同,除了cpu、内存、硬盘、raid卡等关键部件,ai服务器上的gpu和周围硬件(如交换芯片)运转频率密集会产生更大的热量。部件增多让软件的访问速度变慢,可能会造成散热上的不及时,造成服务器超温。

3、因此,传统服务器的散热方式对于硬件和功能上更为复杂的高算力ai服务器,显得捉襟见肘。部件越多,获取温度的速度越慢,对于复杂设备(如raid控制器)需要消耗更多的程序时间,调控的不及时可能会造成整机散热上的风险。

技术实现思路

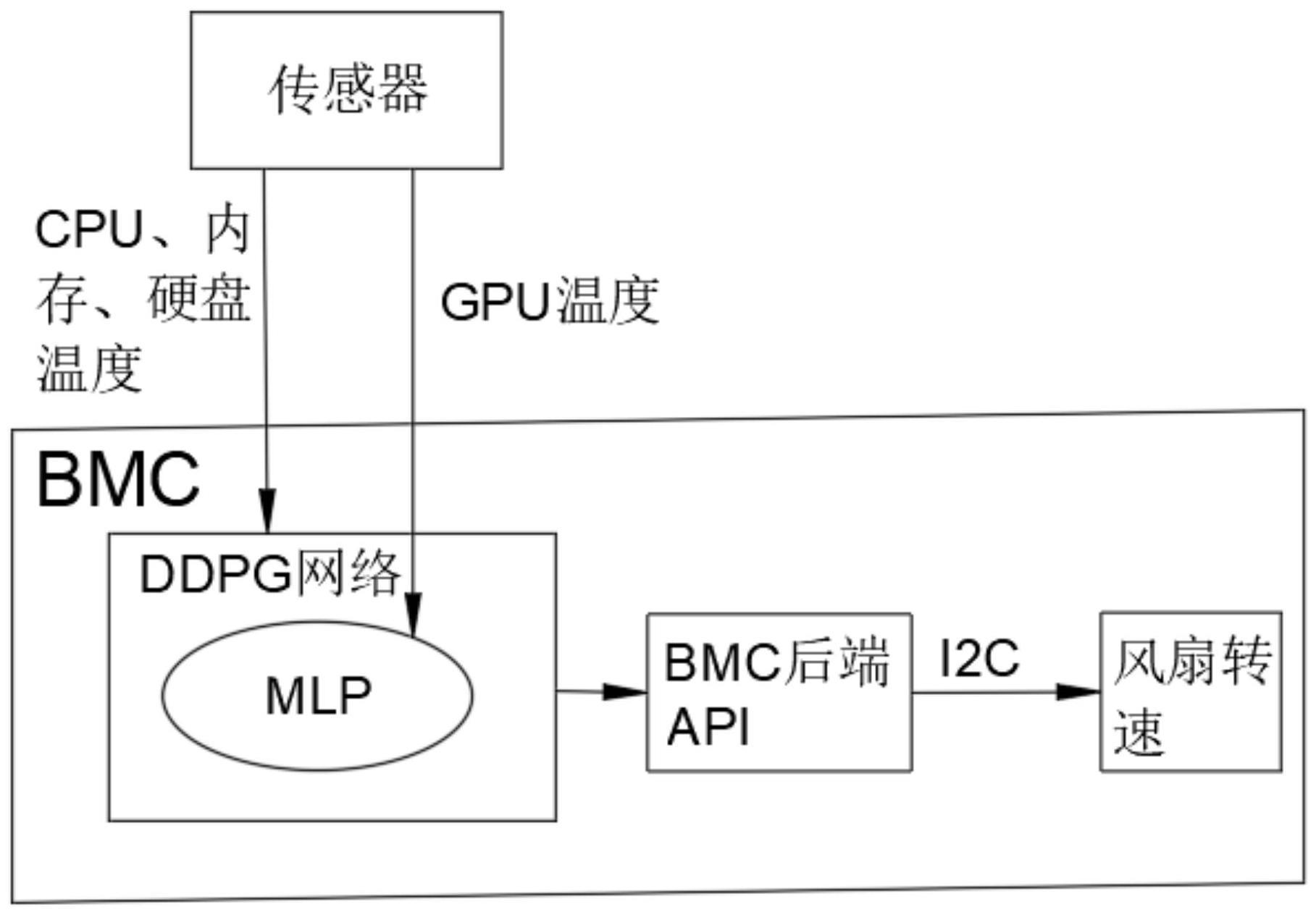

1、为了克服现有技术的不足,本发明提供一种结合注意力机制与强化学习应用于ai服务器散热的方法。

2、本发明解决其技术问题所采用的技术方案是:

3、结合注意力机制与强化学习应用于ai服务器散热的方法,包括以下步骤:

4、s1,将硬件的温度作为输入数据,所述硬件包括gpu、cpu、内存和硬盘,对输入数据做归一化处理;

5、s2,基于多层感知器mlp构建注意力网络,使用gpu温度作为输入,进行全连接mlp注意力网络的训练,输出注意力权重向量a,然后计算加权gpu温度,加权gpu温度=xgpu*a,式中,xgpu为gpu温度归一化处理后的数据;

6、s3,构建ddpg模型,ddpg网络由actor和critic组成,在actor-critic框架下执行以下步骤:s31,将加权gpu温度、cpu温度、内存温度及硬盘温度作为actor网络的输入特征,然后输出风扇转速的预测值;s32,将加权gpu温度、cpu温度、内存温度、硬盘温度及风扇转速作为critic网络的输入特征,然后输出状态-动作的q值估计;

7、s4,将ddpg模型嵌入bmc内部,把输入数据定期反馈给bmc中的ddpg模型,ddpg网络自适应地调整策略,bmc把需要控制的风扇转速输出通过i2c传输给风扇,以调节风扇转速。

8、作为上述技术方案的进一步改进,所述归一化处理将硬件温度及风扇转速的数据特征以最小-最大缩放到(0,1)的范围内。

9、作为上述技术方案的进一步改进,所述归一化处理的具体步骤如下:采集多个时间的硬件温度的数据,硬件温度的数据集x={x_1,x_2,...,x_n},找到每个数据特征的最小值min_val和最大值max_val,应用以下公式进行归一化处理:

10、x_i_normalized=(x_i-min_val)/(max_val-min_val);

11、其中,x_i是一个长度为m的向量,表示第i个时间步的硬件温度。

12、作为上述技术方案的进一步改进,将风扇转速也作为输入数据进行归一化处理,具体步骤如下:采集多个时间的风扇转速的数据,风扇转速的数据集y={y_1,y_2,...,y_n},找到每个数据特征的最小值min_val和最大值max_val,应用以下公式进行归一化处理:y_i_normalized=(y_i-min_val)/(max_val-min_val),其中,y_i是一个长度为m的向量,表示第i个时间步的风扇转速。

13、作为上述技术方案的进一步改进,所述注意力网络的训练采用前向传播算法进行训练。

14、作为上述技术方案的进一步改进,所述注意力网络的训练过程如下:

15、计算第一层的输出h1:h1=relu(w1*gpu温度+b1);

16、计算第二层的输出h2:h2=relu(w2*h1+b2);

17、计算注意力权重向量:注意力权重向量a=softmax(w3*h2+b3);

18、输出加权gpu温度;

19、其中,w1为第一层的权重矩阵;b1为第一层的偏置向量;w2为第二层的权重矩阵;b2为第二层的偏置向量;w3为注意力权重向量的权重矩阵;b3为注意力权重向量的偏置向量;relu为非线性激活函数,softmax函数用于将注意力权重向量的输出转化为概率分布。

20、作为上述技术方案的进一步改进,所述ddpg模型更新中actor网络的更新过程如下:

21、根据输入状态构建actor网络的输入向量:s=[加权gpu温度,cpu温度,内存温度,硬盘温度];

22、使用actor网络预测风扇转速的输出值:a1=π(s);

23、计算动作的梯度:

24、使用梯度上升方法更新actor网络的参数:其中,是梯度算子,α是学习率。

25、作为上述技术方案的进一步改进,所述ddpg模型更新中critic网络的更新过程如下:

26、根据输入状态和动作构建critic网络的输入向量:s=[加权gpu温度特征,cpu温度,内存温度,硬盘温度],a2=风扇转速;

27、使用critic网络估计状态-动作的q值:q(s,a2)=q(s,a2;θ_q);

28、计算critic网络预测q值与目标q值之间的损失:l=0.5*(q(s,a2)-(r+γ*q(s',π(s';θ_π);θ_q_target)))^2,其中r是奖励信号,γ是折扣因子,s'是下一个状态;

29、使用梯度下降方法更新critic网络的参数:其中β是学习率。

30、作为上述技术方案的进一步改进,采用传感器采集gpu、cpu、内存和硬盘的温度以及风扇转速。

31、本发明的有益效果是:将离线ddpg模型部署到bmc里,通过模型预测需要控制的风扇转速,又由于此模型为强化学习模型,有自我调节和反馈训练的功能,可以更精准的控制风扇转速,针对于ai服务器的注意力机制,有更强的实用性与通用性。

技术特征:

1.结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述归一化处理将硬件温度的数据特征以最小-最大缩放到(0,1)的范围内。

3.根据权利要求2所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述归一化处理的具体步骤如下:采集多个时间的硬件温度的数据,硬件温度的数据集x={x_1,x_2,...,x_n},找到每个数据特征的最小值min_val和最大值max_val,应用以下公式进行归一化处理:x_i_normalized=(x_i-min_val)/(max_val-min_val),其中,x_i是一个长度为m的向量,表示第i个时间步的硬件温度。

4.根据权利要求3所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,将风扇转速也作为输入数据进行归一化处理,具体步骤如下:采集多个时间的风扇转速的数据,风扇转速的数据集y={y_1,y_2,...,y_n},找到每个数据特征的最小值min_val和最大值max_val,应用以下公式进行归一化处理:y_i_normalized=(y_i-min_val)/(max_val-min_val),其中,y_i是一个长度为m的向量,表示第i个时间步的风扇转速。

5.根据权利要求4所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述注意力网络的训练采用前向传播算法进行训练。

6.根据权利要求5所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述注意力网络的训练过程如下:

7.根据权利要求6所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述ddpg模型更新中actor网络的更新过程如下:

8.根据权利要求7所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,所述ddpg模型更新中critic网络的更新过程如下:

9.根据权利要求1-8所述的结合注意力机制与强化学习应用于ai服务器散热的方法,其特征在于,采用传感器采集gpu、cpu、内存和硬盘的温度以及风扇转速。

技术总结

本发明公开了结合注意力机制与强化学习应用于AI服务器散热的方法,将硬件的温度作为输入数据,对输入数据做归一化处理;基于多层感知器构建注意力网络,使用GPU温度作为输入,进行注意力网络的训练,输出注意力权重向量a;将加权GPU温度、CPU温度、内存温度及硬盘温度作为Actor网络的输入特征,然后输出风扇转速的预测值;将加权GPU温度、CPU温度、内存温度、硬盘温度及风扇转速作为Critic网络的输入特征,然后输出状态‑动作的Q值估计;将DDPG模型嵌入BMC内部,把输入数据定期反馈给BMC中的DDPG模型,DDPG网络自适应地调整策略,BMC把需要控制的风扇转速输出通过I2C传输给风扇,以调节风扇转速。本发明的方法能够更精确控制服务器风扇散热,起到节能的效果。

技术研发人员:代舜,黄文杰

受保护的技术使用者:宝德计算机系统股份有限公司

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!