一种大语言模型训练方法、装置、设备及存储介质与流程

本发明涉及大语言模型领域,特别涉及一种大语言模型训练方法、装置、设备及存储介质。

背景技术:

1、近年,随着类chatgpt(chat generative pre-trained transformer)的大语言模型的涌现,衍生出了一些效果较好的以适配器形式进行模型微调的方式,典型的有lora(low-rank adaptation of large language models,大语言模型的低阶自适应)和p-tuning v2。

2、相较于底座大模型本身巨大的参数量,模型微调适配器参数量大大降低,从而降低了模型微调所需的资源要求和时间成本。但是,这类微调方法在训练完后,微调完后的大模型在微调中类似的问题上表现稳定,但在原有的大模型通用知识和语言理解表达能力上会发生遗忘,这个风险本质上是属于“过拟合”。adaptor是一种轻量级的模型,用于在预训练底座模型中添加任务特定的参数,adaptor的目的是在不改变预训练模型的情况下,将预训练模型适应于特定任务,因此,adaptor往往可包含信息量较低,微调训练时语料数量相对较少、类型相对匮乏。因此,如何改善大语言模型微调的效果,是本领域有待解决的问题。

技术实现思路

1、有鉴于此,本发明的目的在于提供一种大语言模型训练方法、装置、设备及存储介质,通过将p-tuning v2模块嵌入预训练语言大模型的适配器模块,和基于前置的门控模块改造预训练的底座模型,将训练流程变成二段式,实现模型动态控制激活适配器参数,达到输出结果更稳定、泛化的目的。其具体方案如下:

2、第一方面,本申请提供了一种大语言模型训练方法,包括:

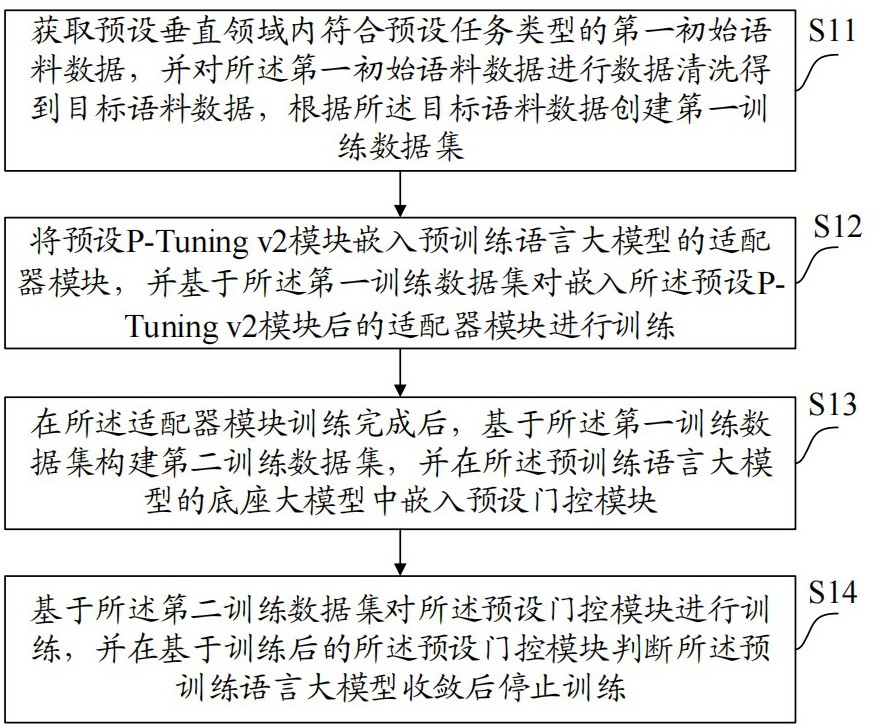

3、获取预设垂直领域内符合预设任务类型的第一初始语料数据,并对所述第一初始语料数据进行数据清洗得到目标语料数据,根据所述目标语料数据创建第一训练数据集;

4、将预设p-tuning v2模块嵌入预训练语言大模型的适配器模块,并基于所述第一训练数据集对嵌入所述预设p-tuning v2模块后的适配器模块进行训练;

5、在所述适配器模块训练完成后,基于所述第一训练数据集构建第二训练数据集,并在所述预训练语言大模型的底座大模型中嵌入预设门控模块;

6、基于所述第二训练数据集对所述预设门控模块进行训练,并在基于训练后的所述预设门控模块判断所述预训练语言大模型收敛后停止训练。

7、可选的,所述根据所述目标语料数据创建第一训练数据集,包括:

8、根据所述目标语料数据以json数据格式创建初始训练数据集,并基于预设样本生成规则对所述初始训练数据集中的序列进行处理后生成目标样本,以基于所述目标样本构建所述第一训练数据集。

9、可选的,所述基于预设样本生成规则对所述初始训练数据集中的序列进行处理后生成目标样本,包括:

10、若所述目标语料数据为qa对,则将所述qa对中的聊天历史作为所述序列的history值;

11、将所述history值拼接到所述序列的prompt之前,以生成所述目标样本。

12、可选的,所述基于所述第一训练数据集对嵌入所述预设p-tuning v2模块后的适配器模块进行训练之前,还包括:

13、冻结所述底座大模型的相关参数,以基于所述第一训练数据集对所述适配器模块中的所述预设p-tuning v2模块的embedding编码器参数进行训练。

14、可选的,所述基于所述第一训练数据集构建第二训练数据集,包括:

15、获取预设垂直领域外的第二初始语料数据,并利用未嵌入所述适配器模块的底座大模型基于所述第二初始语料数据生成第三训练数据集;

16、基于所述第一训练数据集和所述第三训练数据集根据预设比例构建所述第二训练数据集。

17、可选的,所述基于所述第二训练数据集对所述预设门控模块进行训练之前,还包括:

18、冻结所述底座大模型和所述适配器模块的相关参数,以基于所述第二训练数据集对所述预设门控模块的自身参数进行训练。

19、可选的,所述在所述预训练语言大模型的底座大模型中嵌入预设门控模块,包括:

20、在所述预训练语言大模型的所述底座大模型的embedding层与attention层之间嵌入所述预设门控模块。

21、第二方面,本申请提供了一种大语言模型训练装置,包括:

22、数据集创建模块,用于获取预设垂直领域内符合预设任务类型的第一初始语料数据,并对所述第一初始语料数据进行数据清洗得到目标语料数据,根据所述目标语料数据创建第一训练数据集;

23、适配器训练模块,用于将预设p-tuning v2模块嵌入预训练语言大模型的适配器模块,并基于所述第一训练数据集对嵌入所述预设p-tuning v2模块后的适配器模块进行训练;

24、门控嵌入模块,用于在所述适配器模块训练完成后,基于所述第一训练数据集构建第二训练数据集,并在所述预训练语言大模型的底座大模型中嵌入预设门控模块;

25、门控训练模块,用于基于所述第二训练数据集对所述预设门控模块进行训练,并在基于训练后的所述预设门控模块判断所述预训练语言大模型收敛后停止训练。

26、第三方面,本申请提供了一种电子设备,所述电子设备包括处理器和存储器;其中,所述存储器用于存储计算机程序,所述计算机程序由所述处理器加载并执行以实现前述的大语言模型训练方法。

27、第四方面,本申请提供了一种计算机可读存储介质,用于保存计算机程序,所述计算机程序被处理器执行时实现前述的大语言模型训练方法。

28、本申请中首先获取预设垂直领域内符合预设任务类型的第一初始语料数据,并对所述第一初始语料数据进行数据清洗得到目标语料数据,根据所述目标语料数据创建第一训练数据集;通过将预设p-tuning v2模块嵌入预训练语言大模型的适配器模块,基于所述第一训练数据集对嵌入所述预设p-tuning v2模块后的适配器模块进行训练,在所述适配器模块训练完成后,基于所述第一训练数据集构建第二训练数据集,并在所述预训练语言大模型的底座大模型中嵌入预设门控模块;然后基于所述第二训练数据集对所述预设门控模块进行训练,并在基于训练后的所述预设门控模块判断所述预训练语言大模型收敛后停止训练。通过上述技术方案,本申请通过改造预训练的底座模型,在进入生成环节前,前置一个门控模块,整个训练流程就变成了二段式,即先训练adaptor模块,再训练门控模块,保证了两个模块(适配器、门控)的参数训练互不影响,将它们对大模型最终输出的影响和训练流程解耦开来,方便对它们单独进行训练优化,并且避免发生灾难性遗忘,使输出结果更稳定、实现泛化的目的。

技术特征:

1.一种大语言模型训练方法,其特征在于,包括:

2.根据权利要求1所述的大语言模型训练方法,其特征在于,所述根据所述目标语料数据创建第一训练数据集,包括:

3.根据权利要求2所述的大语言模型训练方法,其特征在于,所述基于预设样本生成规则对所述初始训练数据集中的序列进行处理后生成目标样本,包括:

4.根据权利要求1所述的大语言模型训练方法,其特征在于,所述基于所述第一训练数据集对嵌入所述预设p-tuning v2模块后的适配器模块进行训练之前,还包括:

5.根据权利要求1所述的大语言模型训练方法,其特征在于,所述基于所述第一训练数据集构建第二训练数据集,包括:

6.根据权利要求1所述的大语言模型训练方法,其特征在于,所述基于所述第二训练数据集对所述预设门控模块进行训练之前,还包括:

7.根据权利要求1至6任一项所述的大语言模型训练方法,其特征在于,所述在所述预训练语言大模型的底座大模型中嵌入预设门控模块,包括:

8.一种大语言模型训练装置,其特征在于,包括:

9.一种电子设备,其特征在于,所述电子设备包括处理器和存储器;其中,所述存储器用于存储计算机程序,所述计算机程序由所述处理器加载并执行以实现如权利要求1至7任一项所述的大语言模型训练方法。

10.一种计算机可读存储介质,其特征在于,用于保存计算机程序,所述计算机程序被处理器执行时实现如权利要求1至7任一项所述的大语言模型训练方法。

技术总结

本申请公开了一种大语言模型训练方法、装置、设备及存储介质,涉及大语言模型领域,包括:获取初始语料数据并进行数据清洗得到目标语料数据,以创建第一训练数据集;将P‑Tuning v2模块嵌入预训练语言大模型的适配器模块,并基于第一训练数据集对适配器模块进行训练;基于第一训练数据集构建第二训练数据集,并在底座大模型中嵌入预设门控模块;基于第二训练数据集对预设门控模块进行训练,在预训练语言大模型收敛后停止训练。通过将P‑Tuning v2模块嵌入预训练语言大模型的适配器模块,和基于前置的门控模块改造预训练的底座模型,将训练流程变成二段式,实现模型动态控制激活适配器参数,达到输出结果更稳定、泛化的目的。

技术研发人员:丁乐,王伟,刘子星,徐煌,施建生

受保护的技术使用者:税友软件集团股份有限公司

技术研发日:

技术公布日:2024/1/5

- 还没有人留言评论。精彩留言会获得点赞!