一种基于车道线点集与注意力机制的匹配融合方法与流程

1.本发明涉及车辆控制技术领域,具体涉及一种基于车道线点集与注意力机制的匹配融合方法。

背景技术:

2.自动驾驶系统安全性依赖于各传感器的正确输出。示例性的,单传感器如前视摄像头或前视成像激光雷达会因为视场角范围,恶劣天气,遮挡等情况,难以持续稳定的检测车道线,前视摄像头还会受到光照条件,明暗交替等因素影响;而传感器系统(如多摄像头周视系统)可利用多个传感器(如摄像头)在不同方向上的检测结果构成的冗余信息,进行匹配和融合,从而提高持续稳定检测车道线的能力,以提高自动驾驶路径规划的安全性。而多传感器关键难点在于,每个传感器都只能获得局部信息,多传感器如何进行匹配和融合,降低多传感器的匹配搜索空间维度,据仿生学和心理学研究结果表明,人脑在处理信息时会利用注意力机制自动忽略低可能、低价值信息,选择遗忘和关联上下文来降低匹配搜索空间维度来融合信息,因此发明一种基于全局注意力机制的车道线匹配融合方法对于高等级自动驾驶是十分必要的。

3.如公开号为cn112154449a的发明专利公开了一种车道线融合方法、装置、车辆和存储介质,该车道线融合方法包括:获取可移动平台周围的环境图像,并根据环境图像得到可移动平台的初始车道线集合(s110);对初始车道线集合中的初始车道线数据进行拟合优化,得到目标车道线集合;其中,拟合优化包括:根据初始车道线数据和历史车道线集合中的历史车道线数据进行拟合优化得到目标车道线集合(s120);目标车道线集合包括相互不平行的车道线。但是该专利存在以下问题:

4.1、直接利用初始车道线和历史车道线进行融合,会在因为视野、光照突变的工况,当车道线信息突变时因历史车道线数据而产生识别延迟,而历史车道线数据的错误和噪声(误匹配),也会影响当前融合后的车道线的准确性。

5.2、当传感器的识别准确率和测量精度逐步提升后,历史车道线数据的作用降低,在传感器识别准确率接近100%和测量精度毫米级的情况下,历史车道线数据直接用于或通过预测用于车道线融合反而会引入延迟、不确定性和噪声。

技术实现要素:

6.针对上述现有技术的不足,本发明所要解决的技术问题是:如何提供一种基于车道线点集与注意力机制的匹配融合方法,解决如何在多种场景下对车道线有效、准确的匹配融合,有效降低匹配搜索空间,降低错误匹配和融合的风险,提高自动驾驶车辆路径规划的稳定性和安全性。

7.为了解决上述技术问题,本发明采用了如下的技术方案:

8.一种基于车道线点集与注意力机制的匹配融合方法,包括以下步骤:

9.s1、接收车辆位置和状态信息,若自动驾驶系统处于可用状态则执行步骤s2;

10.s2、接收传感器检测的道路数据和车道线点集,并对车道线点集进行处理;

11.s3、遍历各传感器检测到的车道线点集,判断车道线点集是否在注意力聚焦区域内;

12.s4、将车道线点集在注意力聚焦区域内的数据存入聚焦域待拟合点集存储区中,不在注意力聚焦区域内的数据存入非聚焦域待拟合点集存储区中,并分别进行拟合,且对拟合后的车道线进行编号以及置信度计算,对各点置信度加权平均值作为拟合后车道线的置信度;

13.s5、合并车道线,接收s4中所有拟合后的车道线并进行编号;

14.s6、根据预测规划控制请求,向预测规划控制系统输出全局融合车道线;

15.s7、记忆n帧融合车道线,并对记忆的n帧融合车道线统一预测到当前时刻,再进行帧间匹配;

16.s8、注意力分级,以聚焦域待拟合点集存储区中融合车道线作为主注意力车道线,以非聚焦域待拟合点集存储区中融合车道线作为次注意力车道线;

17.s9、计算注意力聚焦区域中心线,根据传感器测距误差确定注意力聚焦区域。

18.进一步地,在步骤s2中,所述道路数据包括可行驶区域、护栏和路沿数据;根据可行驶区域、护栏和路沿数据,在车道线点集中对护栏和路沿数据外侧异常点进行剔除处理。

19.进一步地,在步骤s4中,对存入聚焦域待拟合点集存储区中的车道线点集数据进行处理,遍历各聚焦域待拟合点集存储区,对各聚焦域在待拟合存储区中的车道线点集,采用ransac算法拟合多项式函数。

20.进一步地,采用ransac算法对存入聚焦域待拟合点集存储区中的车道线点集数据进行处理,包括剔除或稀疏化车头时距远的点、剔除置信度小于自适应阈值的点、剔除深灰轮胎印和旧车道线,以减少ransac算法的迭代次数。

21.进一步地,置信度的自适应阈值按长度分段,每段的车道线点的置信度的自适应阈值at

conf

为:

[0022][0023]

式中,conf

point

车道线点的置信度;λ∈(0,1]为拒绝域因子;m为按长度对车道线进行分段后,传感器在该段获得的车道线点的个数;conf

llimit

为置信度的自适应阈值的下限。

[0024]

进一步地,在步骤s4中,对存入非聚焦域待拟合点集存储区中的车道线点集数据进行处理的步骤包括:

[0025]

s41、对存入非聚焦域待匹配区中的车道线点集数据进行处理,将前半周中不在注意力聚焦区域内的车道线点集按长度排序,并将长度大于自适应阈值的车道线点集筛选出作为前半周长车道线line

long

fp(i)(i=1,...,m),反之作为前半周短车道线line

short

fp(i)(1,...,n);

[0026]

按从长到短的次序,依次将非聚焦域待拟合点集存储区中的前半周长车道线选为基准,遍历其余车道线和前半周短车道线进行匹配,当前半周的车道线都遍历匹配完则进入s42;

[0027]

s42、对存入非聚焦域待匹配区中的车道线点集数据进行处理,将后半周中不在注

意力聚焦区域内的车道线点集按长度排序,并将长度大于自适应阈值的车道线点集筛选出作为后半周长车道线line

long

rp(i)(i=1,...,m),反之作为后半周短车道线line

short

rp(i)(1,...,n);

[0028]

按从长到短的次序,依次将非聚焦域待拟合点集存储区中的后半周长车道线选为基准,遍历其余车道线和后半周短车道线进行匹配,当后半周的车道线都遍历匹配完则进入s43;

[0029]

s43、以前半周融合车道线为基准,遍历车辆后半周融合车道线并进行匹配,当前半周车道线点集能与后半周车道线点集匹配,则将所有匹配上的车道线点集合并,并剔除不匹配异常点拟合多项式函数。

[0030]

进一步地,对存入非聚焦域待拟合点集存储区中的车道线点集数据进行处理中的车道线长度自适应阈值的公式为:

[0031][0032]

式中,lth

line

为车道线计算长度;δ∈(0,1]拒绝域因子;n为非聚焦域待拟合点集存储区中车道线总数;lth

llimit

为置信度的自适应阈值的下限。

[0033]

进一步地,在步骤s7中,通过对车道线拟合n次多项式曲线进行帧间匹配,其公式为:

[0034][0035]

式中,a

ip1

表示后帧中n次多项式的系数,a

ip2

表示前帧中n次多项式的系数,tr

ifm

表示帧间匹配的容差阈值;δa

inon

表示多项式曲线的第i个系数的帧间匹配误差的归一化因子;

[0036]

在不等式成立时,记忆车道线曲线的帧间匹配成功,存入记忆车道线序列。

[0037]

进一步地,根据权利要求1所述的一种基于车道线点集与注意力机制的匹配融合方法,其特征在于,在步骤s9中,注意力聚焦区域中心线,根据预测行驶方向、主注意力车道系数和遗忘因子进行计算;其中,

[0038]

预测行驶方向,与预测本车行驶方向差别过大的主注意力车道线不计入注意力聚焦区域中心线计算,当下面判别函数不等式成立时,车道线作为注意力聚焦区域中心线计算:

[0039]

|a0+a1vht

pred

+(2a

2-yr)(vht

pred

)2|<tr

pred

[0040]

式中,vh为本车的车速,yr为本车的偏航率,t

pred

为设定预测时间,a0、a1、a2分别为拟合后的车道线方程系数,tr

pred

为预测的t

pred

时间后车道线距离本车的横向位置的判别阈值;

[0041]

计算当前帧的遗忘因子并进行存储,最多存储nm帧,其公式为:

[0042][0043]

式中,βb为遗忘因子基准值;vr

pi

为车道线在行车方向上的远端可视距离;v

hpi

为本

车的车速,conf

pi

为当前帧主注意力车道线置信度,dt

pi

为当前帧与上一帧之间的时间差,μ为安全阈值,i为帧数(i=1,...,nm);

[0044]

计算注意力聚集区域中心线,用三阶以及三阶以上的多项式表示,其系数的计算公式为:

[0045][0046]

式中,nm为记忆帧数上限,当m<n

m-1,(β

p1

+β

p1

β

p2

+...(β

p1

β

p2

...β

pm

))>tr

memo

∈(0,1)时,其中tr

memo

为记忆容限阈值;为nm个历史帧的匹配记忆序列中的第i帧的主注意力车道线的多项式系数向量;

[0047]

根据传感器测距误差确定注意力聚焦区域横向宽度的公式为:

[0048]

δd(l)=γσ

avg

(l)

[0049]

式中,δd(l)为聚焦区域横向宽度的一半,γ∈(0,1]为根据传感器性能特性设定的安全系数,σ

avg

(l)为l距离上的传感器测距误差平均值;

[0050]

采用n次多项式表示注意力聚集区域中心线,则在下面两条曲线之间的区域为注意力聚焦区域,

[0051]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x3+...+a

npf

xn+δd(x)

[0052]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x3+...+a

npf

x

n-δd(x)。

[0053]

与现有技术相比,本发明的有益效果在于:

[0054]

1、本明通过基于遗忘机制的注意力聚焦区域,将车道线点集在注意力聚焦区域的内数据存入聚焦域待拟合点集存储区中,利用ransac算法或其改进算法去除异常点进行拟合,以有效去除置信度低的点和误检测的点以及外点。将车道线点集不在注意力聚焦区域的内数据存入非聚焦域待拟合点集存储区中,先进行前半周、后半周局域的融合(前半周包含前向,侧前向传感器;后半周包含后向,侧后向的传感器),获得半局信息,进行全局的融合。注意力聚焦区域内的车道线点集融合可以和非聚焦域车道线点集融合可以并行异步计算,以降低注意力聚焦区域内的车道线点集匹配融合的延迟。车道线历史数据不直接参与

车道线的融合,因为融合车道线历史数据必然会引入延迟和噪声,不能很好的应对车道线在一定程度上的突变。而是用历史数据来生成基于遗忘机制的注意力聚焦区域,以降低匹配搜索空间维度。从而能够在多种场景下,有效降低匹配搜索空间,对多传感器检测到的车道线点集进行快速匹配和融合,降低错误匹配和融合的风险,降低融合延迟,提高自动驾驶车辆路径规划、控制的稳定性和安全性。

附图说明

[0055]

为了使发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明作进一步的详细描述,其中:

[0056]

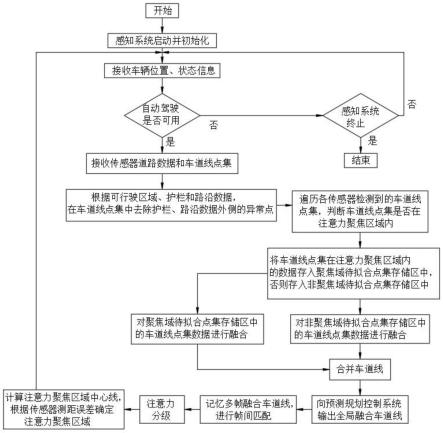

图1为本发明基于车道线点集与注意力机制的匹配融合方法的流程图;

[0057]

图2为本发明中传感器分布的示意图;

[0058]

图3为本发明中使用场景的示意图;

[0059]

图4为本发明中注意力聚焦区域的示意图。

具体实施方式

[0060]

下面结合附图对本发明作进一步的详细说明。

[0061]

由于多个传感器(如摄像头)在不同方向上的对车道线进行检测,得到用点集合及每个点置信度表示的检测结果,这些检测结果数据会构成的冗余信息,如果采用正确的方法对其进行匹配和融合,可以提高持续稳定检测车道线的能力,以提高自动驾驶路径规划的安全性。

[0062]

但是车道线为细长的结构,可能穿越车身并被各种目标遮挡,不同摄像头检测到的局部车道线(点集)及其特征参数,在实际复杂多变的场景中,难以正确匹配和融合起来,形成的全局的车道线信息输出。当传感器数量增加时,不同车道线的点集之间的匹配的遍历搜索空间维度也会大幅度增加,影响运算时间,不同摄像头检测车道线的错误匹配和融合会引起严重的曲率和航向角检测误差,而引起错误的路径规划结果,而产生严重的安全事故。

[0063]

本方法具体实施方式基于车辆坐标系进行推导和阐述,但改变坐标系不影响本方法的实际物理含义和效果。

[0064]

如图1、图2和图3所示,本实施例中提供一种基于车道线点集与注意力机制的匹配融合方法,包括以下步骤:

[0065]

s1、接收车辆位置和状态信息,若自动驾驶系统处于可用状态则执行步骤s2;

[0066]

s2、接收传感器检测的道路数据和车道线点集,并对车道线点集进行处理;当有k个传感器,第k个传感器检测到根线的情况下,车道线点集为:

[0067][0068]

上述车道线点集,可以通过传感器的检测结果直接获得,也可以通过对传感器语义/实例分割结果稀疏采样和距离计算后,间接获得。传感器输出的车道线点集已经包含各点在车辆坐标系中的位置信息,或者可以间接计算得到车道线点在车辆坐标系中的位置信息。

[0069]

s3、遍历各传感器检测到的车道线点集,判断车道线点集是否在注意力聚焦区域

内;

[0070]

s4、将车道线点集在注意力聚焦区域内的数据存入聚焦域待拟合点集存储区中,不在注意力聚焦区域内的数据存入非聚焦域待拟合点集存储区中,并分别进行拟合,且对拟合后的车道线进行编号以及置信度计算,对各点置信度加权平均值作为拟合后车道线的置信度;

[0071]

s5、合并车道线,接收s4中所有拟合后的车道线并进行编号;

[0072]

s6、根据预测规划控制请求,向预测规划控制系统输出全局融合车道线,以及车辆前、后半周车道线;

[0073]

s7、记忆n帧融合车道线,并对记忆的n帧融合车道线统一预测到当前时刻,再进行帧间匹配。

[0074]

s8、注意力分级,以聚焦域待拟合点集存储区中融合车道线作为主注意力车道线,以非聚焦域待拟合点集存储区中融合车道线作为次注意力车道线;

[0075]

当次注意力车道线在连续的n帧融合车道线中,能够帧间稳定匹配时转为主注意力车道线;

[0076]

当主注意力车道线在连续的n帧融合车道线中,只要出现1帧不能帧间匹配时,转为次注意力车道线。

[0077]

s9、计算注意力聚焦区域中心线,根据传感器测距误差确定注意力聚焦区域。

[0078]

本发明,通过基于遗忘机制的注意力聚焦区域,将车道线点集在注意力聚焦区域的内数据存入聚焦域待拟合点集存储区中,利用ransac算法或其改进算法去除外点进行拟合,以有效去除置信度低的点和误检测的外点。将车道线点集不在注意力聚焦区域的内数据存入非聚焦域待拟合点集存储区中,先进行前半周、后半周局域的融合(前半周包含前向,侧前向传感器;后半周包含后向,侧后向的传感器),获得半局信息,进行全局的融合。对车道线历史数据不直接参与车道线的融合,因为融合车道线历史数据必然会引入延迟和噪声,不能很好的应对车道线在一定程度上的突变。而是用历史数据来生成基于遗忘机制的注意力聚焦区域,以降低匹配搜索空间维度。从而能够在多种场景下,有效降低匹配搜索空间,提高多传感器检测到的车道线点集进行快速匹配和融合,降低错误匹配和融合的风险,提高自动驾驶车辆路径规划和方向盘控制的稳定性和安全性。

[0079]

参见图2,本发明中传感器可为周视摄像头系统,包含前视、左侧前视,左侧后视,右侧前视,右侧后视,后视6个摄像头构成的系统(摄像头可以被其他能够检测车道线(点集)的其他传感器如成像激光雷达替代,输出车道线点集,不影响本方法的使用。车道线点集,可以通过传感器的检测结果直接获得,也可以通过对传感器语义分割结果稀疏采样后,间接获得。

[0080]

本方法适用于多视觉传感器的车道线点检测结果的融合(检测结果包含车道线点集的坐标,和每个点的置信度及色彩灰度饱和度),也适用于成像激光雷达和高线数激光雷达等其它传感器及其组合传感器的车道线点检测结果(能够生成与摄像头的车道线点检测结果类似的车道线点集数据和每个点的置信度)的融合。

[0081]

本方法也适用路沿和广义道路边界点集的多传感器融合。

[0082]

本实施例中,所述道路数据包括可行驶区域、护栏和路沿数据;根据可行驶区域、护栏和路沿数据,在车道线点集中对护栏和路沿数据外侧异常点进行剔除处理。

[0083]

这样,车道线点集数据,经过了护栏,路沿,可行驶区域的多源信息校验,剔除了跨越护栏对向车道线的车道线,降低了错误匹配融合的风险。

[0084]

优选的,本实施例中,将超过四分之三的点在聚焦域内的车道线点集,存入聚焦域待拟合点集存储区。

[0085]

本实施例中,对存入聚焦域待拟合点集存储区中的车道线点集数据进行处理和存入非聚焦域待拟合点集存储区中的车道线点集数据进行处理,可并行异步处理,以降低注意力聚焦区域内的车道线点集匹配融合的延迟。

[0086]

为便于理解,现分别进行阐述。

[0087]

i、具体的,对存入聚焦域待拟合点集存储区中的车道线点集数据linefocusp(i,j)(i=1,...,r;j=1,...,s(r))(r个聚焦域,每个聚焦域s(r)个点)进行处理,遍历各聚焦域待拟合点集存储区,对各聚焦域在待拟合存储区中的车道线点集,采用ransac(随机采样一致)算法或者改进算法ransac拟合多项式函数。

[0088]

优选的,采用ransac算法或其改进算法的步骤:

[0089]

1)选择初始点集,执行步骤2)。

[0090]

2)在初始点集采用随机抽样选取出一组a个点,利用最小二乘方法拟合出多项式函数执行步骤3)。

[0091]

3)计算每点和多项式函数曲线的最近距离,剔除掉距离大于阈值的外点,并计算未被剔除掉的点的个数。执行步骤4)

[0092]

4)当未被剔除掉点个数大于总点数的一半时,再次拟合曲线,并计算曲线与点的距离之和,以及点的置信度均值并存储,执行步骤5),否则再次执行步骤2)、3)。

[0093]

5)当曲线与各点的距离之和小于阈值时,将此曲线选为备选最优曲线并存储。否则再次执行步骤2)、3)、4)。

[0094]

6)当步骤2)中随机抽样次数超过设定阈值c且至少有一条备选最优曲线,将备选最优曲线作为最优曲线输出。否则重复执行步骤2)、3)、4)和5),直到拟合出b条曲线。采用ransac算法中的加权评分机制,选取出b条曲线中评分最高的一条,作为当前的最优车道线输出。其中得分基于曲线与各点的距离之和,点集的置信度均值,车道线点的数量,车道线长度和颜色正常点比例计算。

[0095]

优选的,评分公式为:

[0096]

score=e1d

sum

+e2·

conf

mean

+e3·npoint

+e4·

l

lane

+e5·

p

color

[0097]

式中,e1,...,e5为加权系数,d

sum

为归一化的拟合曲线与各点的距离之和,conf

mean

为点集的置信度均值,n

point

为归一化的车道线点的数量,l

lane

为归一化的车道线计算长度,p

color

为车道线颜色正常点(非灰非黑)的比例。

[0098]

上述步骤中,a为预先设定的随机抽取点个数,b为备选最优曲线的上限(迭代终止),c为随机抽样次数上限(迭代终止)。

[0099]

优选的,原ransac算法的问题在于当点数量太多时,达到99%概率成功选出b条曲线需要的次数太多。对注意力机制聚焦域内的点,还可以采用基于车道线点集置信度,融合其他信息的特殊改进的ransac(随机抽样一致)算法拟合车道线。

[0100]

具体的,将步骤1)中选择初始点集的方法改进为:对各聚焦域在待拟合存储区中的车道线点集,先剔除置信度小于自适应阈值的点;然后剔除或稀疏化采样大于平均车头

时距大于5s/vehicle的点(平均车头时距=平均车头间距/平均车速);稀疏化采样大于平均车头时距大于2s/vehicle的点(平均车头时距=平均车头间距/平均车速),特别的,对能够检测到颜色的传感器,剔除掉深灰色的轮胎印和旧车道线,剔除与白色和黄色颜色差距过大的线。再使用ransac算法拟合多项式函数,可以有效的降低ransac随机取点次数。

[0101]

上述选择初始点集的中,置信度(confidence)的自适应阈值的计算方法,按长度分段,每d(示例性的,对8m摄像头,50米以内,d=5;50米至100米,d=10)米分为一段,每段的车道线点的置信度(confidence)的自适应阈值(adaptivethreshold)at

conf

为:

[0102][0103]

式中,conf

point

车道线点的置信度;λ∈(0,1]为拒绝域因子;m为按长度对车道线进行分段后,传感器在该段获得的车道线点的个数;conf

llimit

为置信度的自适应阈值的下限。

[0104]

上述改进的ransac算法拟合多项式时,根据场景确定曲线拟合的多项式次数:优选的,当传感器检测到当前场景为结构化道路,车道线3次多项式曲线表示,拟合得到的车道线3次多项式函数如下:

[0105]

a(x)=a0+a1x+a2x2+a3x3[0106]

当传感器检测到当前场景为非结构化道路,用5次多项式曲线表示,拟合得到的车道线5次多项式函数如下:

[0107]

a(x)=a0+a1x+a2x2+a3x3+a4x4+a5x5[0108]

将所有拟合之后的车道线linefocus(i)(i=1,...,h)进行编号,进行置信度计算,对各点置信度加权平均值作为拟合后车道线的置信度。

[0109]

ii、具体的,对存入非聚焦域待拟合点集存储区中的车道线点集数据进行处理的步骤包括:

[0110]

s41、对非聚焦域待匹配区中的车道线点集数据进行处理,将前半周中不在注意力聚焦区域内的车道线点集按长度排序,并将长度大于自适应阈值的车道线点集筛选出作为前半周长车道线line

long

fp(i)(i=1,...,m),反之作为前半周短车道线line

short

fp(i)(1,...,n);

[0111]

按从长到短的次序,依次将非聚焦域待拟合点集存储区中的前半周长车道线line

long

fp(i)(i=1,...,m)选为基准,遍历其余长车道线line

long

fp(j)(j≠i)和前半周短车道线line

short

fp(i)(1,...,n)进行匹配,具体包括:

[0112]

1)、如果车道线line

long

fp(i)(i=1,...,m)能与其他前半周长车道线line

long

fp(j)(j≠i)匹配上,则将所有匹配上的车道线合并,并剔除不匹配异常点拟合车道线,并将匹配上的车道线点集和前半周长车道线line

long

fp(j)(j≠i)合并为line

long

fp(i)作为新的基准车道线。并将前半周长车道线line

long

fp(j)(j≠i)剔除出基准车道线点集,不再对前半周长车道线line

long

fp(j)(j≠i),进行其余车道线匹配遍历。

[0113]

2)、如果前半周长车道线点集line

long

fp(i)(i=1,...,m)能与其他前半周短车道线点集line

short

fp(i)(i=1,...,n)匹配上,则将所有匹配上的车道线点集合并,并剔除不匹配异常点,再进行车道线拟合。

[0114]

3)、如果车道线不能与前半周短车道线匹配,且长度大于自适应阈值,直接将车道

线点集作为成独立车道线,进行拟合。

[0115]

将所有拟合之后的车道线linefp(i)(i=1,...,g)进行编号,进行置信度计算,各点置信度加权均值作为拟合后车道线置信度。

[0116]

当车辆前半周车道线都遍历匹配完则进入s42。

[0117]

s42、对非聚焦域待匹配区中的车道线点集数据进行处理,将后半周中不在注意力聚焦区域内的车道线点集按长度排序,并将长度大于自适应阈值的车道线点集筛选出作为后半周长车道线line

long

rp(i)(i=1,...,m),反之作为后半周短车道线line

short

rp(i)(1,...,n);

[0118]

按从长到短的次序,依次将非聚焦域待拟合点集存储区中的后半周长车道线选为基准,遍历其余车道线和后半周短车道线进行匹配,具体步骤包括:

[0119]

1)、如果车道线line

long

rp(i)(i=1,...,m)能与其他后半周长车道线line

long

rp(j)(j≠i)匹配上,则将所有匹配上的车道线点集合并,并剔除不匹配异常点拟合车道线,并将匹配上的车道线和后半周长车道线合并为line

long

rp(i)作为新的基准车道线。将后半周长车道线line

long

rp(j)(j≠i)剔除出基准车道线点集,不再对line

long

rp(j)(j≠i),进行其余车道线匹配遍历。

[0120]

2)、如果后半周长车道线能与其他后半周短车道线line

short

rp(i)(1,...,n)匹配上,则将所有匹配上的车道线点集合并,并剔除不匹配异常点,再进行车道线拟合。

[0121]

3)、如果车道线不能与后半周短车道线匹配,且长度大于自适应阈值,直接将车道线点集作为独立车道线,进行拟合。

[0122]

将所有拟合之后的车道线liner(i)(i=1,...,h)进行编号,进行置信度计算,各点置信度加权均值作为拟合后车道线置信度。

[0123]

当后半周的车道线都遍历匹配完则进入s43;

[0124]

s43、以前半周融合车道线为基准,遍历车辆后半周融合车道线并进行匹配,当前半周车道线点集能与后半周车道线点集匹配,则将所有匹配上的车道线点集合并,并剔除不匹配异常点拟合多项式函数。优选的,当传感器检测到当前场景为结构化道路,车道线3次多项式曲线表示,当传感器检测到当前场景为非结构化道路,用5次多项式曲线表示。

[0125]

具体的,对存入非聚焦域待拟合点集存储区中的车道线点集数据进行处理中的车道线长度自适应阈值的公式为:

[0126][0127]

式中,lth

line

为车道线计算长度;δ∈(0,1]拒绝域因子;n为非聚焦域待拟合点集存储区中车道线总数;lth

llimit

为置信度的自适应阈值的下限。

[0128]

用自适应阈值公式按长度筛选的目的在于:因为传感器检测到的特别短的车道线不容易匹配而且有一定概率是其他标识线,比如不清晰的箭头符号或者不清晰的导流线。因此从匹配融合策略上不将特别短,难以匹配的车道线选为匹配基准。

[0129]

具体实施时,在步骤s7中,通过对车道线拟合n次多项式曲线进行帧间匹配,其公式为:

[0130][0131]

式中,a

ip1

表示后帧中n次多项式的系数,a

ip2

表示前帧中n次多项式的系数,tr

ifm

表示帧间匹配的容差阈值;δa

inon

表示多项式曲线的第i个系数的帧间匹配误差的归一化因子;

[0132]

在不等式成立时,记忆车道线曲线的帧间匹配成功,已匹配成功的车道线曲线存入记忆车道线序列。

[0133]

当n次多项式n为3时,可对车道线拟合三次多项式曲线进行帧间匹配,其公式为:

[0134][0135]

式中,a

0p1

、a

1p1

、a

2p1

、a

3p1

表示后帧中拟合的车道线三次多项式的系数,a

0p2

、a

1p2

、a

2p2

、a

3p2

表示前帧中拟合的车道线三次多项式的系数,tr

ifm

为帧间匹配的容差阈值;

[0136]

在不等式成立时,记忆车道线曲线的帧间匹配成功,已匹配成功的车道线曲线存入记忆车道线序列。

[0137]

参见图4,在步骤s9中,注意力聚焦区域中心线,根据预测行驶方向、主注意力车道系数和遗忘因子进行计算;其中,

[0138]

预测行驶方向,与预测本车行驶方向差别过大的主注意力车道线不计入注意力聚焦区域中心线计算;当下面判别函数不等式成立时,车道线作为注意力聚焦区域中心线计算:

[0139]

|a0+a1vht

pred

+(2a

2-yr)(vht

pred

)2|<tr

pred

[0140]

式中,vh为本车的车速;yr为本车的偏航率;t

pred

为设定预测时间;a0,a1,a2分别为拟合后的车道线方程系数,tr

pred

为预测的t

pred

时间后车道线距离本车的横向位置的判别阈值;

[0141]

计算当前帧的遗忘因子并进行存储,最多存储nm帧,其公式为:

[0142][0143]

式中,βb为遗忘因子基准值;vr

pi

为车道线在行车方向上的远端可视距离;v

hpi

为本车的车速;conf

pi

为当前帧主注意力车道线置信度;dt

pi

为当前帧与上一帧之间的时间差;μ为安全阈值;i为帧数(i=1,...,nm)。即当历史帧中看到的车道线越长以及车速越慢时,遗忘因子越小,遗忘越慢,使用遗忘因子可以更有效的使用历史信息构建注意力聚焦区域。

[0144]

根据预测到的行驶方向,主注意力车道线系数,置信度和遗忘因子,计算注意力聚焦区的中心线。即与人脑视觉的仿生学试验结果相同,关注行驶方向,当置信度越低,遗忘的越快。

[0145]

计算注意力聚集区域中心线,用三阶以及三阶以上的多项式表示,其系数的计算公式为:

[0146][0147]

式中,nm为记忆帧数上限;当m<n

m-1,(β

p1

+β

p1

β

p2

+...(β

p1

β

p2

...β

pm

))>tr

memo

∈(0,1)时,其中tr

memo

为记忆容限阈值;为nm个历史帧的匹配记忆序列中的第i帧的主注意力车道线的多项式系数向量;

[0148]

根据传感器测距误差确定注意力聚焦区域横向宽度的公式为:

[0149]

δd(l)=γσ

avg

(l)

[0150]

式中,δd(l)为聚焦区域横向宽度的一半,γ∈(0,1]为根据传感器性能特性设定的安全系数,σ

avg

(l)为l距离上的传感器测距误差平均值;

[0151]

当采用三次多项式表示注意力聚集区域中心线时,则在下面两条曲线之间的区域为注意力聚焦区域,

[0152]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x3+δd(x)

[0153]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x

3-δd(x);

[0154]

当采用n次多项式表示注意力聚集区域中心线时,则在下面两条曲线之间的区域为注意力聚焦区域,

[0155]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x3+...+a

npf

xn+δd(x)

[0156]

a0(x)=a

0pf

+a

1pf

x+a

2pf

x2+a

3pf

x3+...+a

npf

x

n-δd(x)。

[0157]

最后说明的是,以上实施例仅用以说明本发明的技术方案而非限制,尽管通过参照本发明的优选实施例已经对本发明进行了描述,但本领域的普通技术人员应当理解,可以在形式上和细节上对其作出各种各样的改变。凡是属于本发明的技术方案所引申出的显而易见的改变仍处于本发明的保护范围之列。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1