边缘计算的算力预测方法、算力编排方法及系统与流程

1.本发明涉及物联网领域,具体地涉及一种边缘计算的算力预测方法、一种边缘计算的算力编排方法、一种边缘计算的算力编排系统以及一种存储介质。

背景技术:

2.随着物联网的迅猛发展,爆发式增长的数据量远远超过了网络带宽的承受能力,大量新型智能应用的涌现对系统时延性能提出了更高的需求。边缘计算作为一种新的计算模式,可以使数据在源头附近的边缘网络得到及时有效的处理。边缘计算模式下终端将任务卸载到附近的边缘服务器执行,有效缓解传统云计算中将所有数据传输到数据中心造成的网络拥塞与高延迟问题。边缘计算的瓶颈主要在于计算、通信、存储等资源有限。当终端数量和数据规模进一步增大时边缘节点趋于饱和,导致服务质量严重下降。

3.电力物联网新业务生态下的终端、数据和业务不断增加,海量电力数据需要在边缘计算设备上进行分析计算,进而实现高效灵活的业务处理和决策。由于新型电力系统业务的动态变化特性,边缘计算资源调度方式从按确定业务对象的固定配置模式转变为按动态业务对象的弹性配置模式。目前,日益增长的业务处理需求与有限算力资源之间的动态匹配是边缘计算的难题。

技术实现要素:

4.本发明的目的是提供一种边缘计算的算力预测方法及算力编排方法,以为边缘计算提供灵活高效的算力分配方案,提高算力资源利用率。

5.为了实现上述目的,本发明第一方面提供一种边缘计算的算力预测方法,所述方法包括:

6.统计不同类型业务流的到达率,根据不同类型业务流的到达率设定业务流到达的分布函数;

7.根据业务流到达的分布函数计算边缘计算的系统效率,以及计算各类业务流的系统效率占比;

8.在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值。

9.进一步地,所述业务流到达的分布函数为:

[0010][0011]

其中,λ1为周期性业务到达率,λ2为随机性业务到达率,δ为冲击函数,t为时间;

[0012]

所述周期性业务和所述随机性业务是根据边缘计算的业务类型特性划分的。

[0013]

进一步地,所述根据业务流到达的分布函数计算边缘计算的系统效率,包括:对业务流到达的分布函数进行拉普拉斯变换,得到系统效率因子;根据系统效率因子计算得到

边缘计算的系统效率。

[0014]

进一步地,所述计算各类业务流的系统效率占比,包括:

[0015]

统计不同类型业务流各自的占比,将各类业务流的占比分别乘以系统效率,得到各类业务流的系统效率占比。

[0016]

进一步地,所述在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值,包括:

[0017]

在业务丢失率约束条件和业务处理时延约束条件下,根据各类业务流的系统效率占比计算各类业务流所需的算力值的取值范围;

[0018]

在预先设定业务平均处理速率的条件下,计算所述算力值的取值范围内的最优算力值,将最优算力值作为业务流所需的算力值。

[0019]

本发明第二方面提供一种边缘计算的算力编排方法,所述方法包括:

[0020]

获取多种终端设备的多个业务流;

[0021]

采用权利要求1所述的边缘计算的算力预测方法,预测边缘计算的各类业务流所需的算力值;

[0022]

根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序。

[0023]

进一步地,所述根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序,包括:

[0024]

确定各类业务流所属的应用程序,将属于同一个应用程序的业务流形成集合;

[0025]

根据应用程序的优先级属性,对属于该应用程序的业务流形成的集合进行排序,对集合标注权重值;

[0026]

根据集合的权重值将各个集合内的业务流映射到对应容器的应用程序。

[0027]

进一步地,所述根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序,还包括:

[0028]

根据各类业务流的实时性要求,对相应的集合的权重值进行修正;

[0029]

根据修正后的集合的权重值将集合内的业务流映射到对应容器的应用程序。

[0030]

进一步地,所述方法还包括:

[0031]

统计相同类型业务流对应的应用程序的总算力值;

[0032]

将相同类型业务流对应的应用程序归并到同一个容器中,为该容器配置与所述应用程序的总算力值相匹配的算力资源。

[0033]

进一步地,所述方法还包括:

[0034]

在获取多种终端设备的多个业务流之后,对多个业务流进行缓存,形成业务流混合队列。

[0035]

本发明第三方面提供一种边缘计算的算力编排系统,所述系统包括:

[0036]

算力预测模块,用于根据边缘计算的不同业务流的特性,预测各类业务流所需的算力值;

[0037]

算力映射模块,用于根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序。

[0038]

进一步地,所述根据边缘计算的不同业务流的特性,预测各类业务流所需的算力值,包括:

[0039]

统计不同类型业务流的到达率,根据不同类型业务流的到达率设定业务流到达的分布函数;

[0040]

根据业务流到达的分布函数计算边缘计算的系统效率,以及计算各类业务流的系统效率占比;

[0041]

在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值。

[0042]

进一步地,所述业务流到达的分布函数为:

[0043][0044]

其中,λ1为周期性业务到达率,λ2为随机性业务到达率,δ为冲击函数,t为时间;

[0045]

所述周期性业务和所述随机性业务是根据边缘计算的业务类型特性划分的。

[0046]

进一步地,所述根据业务流到达的分布函数计算边缘计算的系统效率,包括:对业务流到达的分布函数进行拉普拉斯变换,得到系统效率因子;

[0047]

根据系统效率因子计算得到边缘计算的系统效率。

[0048]

进一步地,所述在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值,包括:

[0049]

在业务丢失率约束条件和业务处理时延约束条件下,根据各类业务流的系统效率占比计算各类业务流所需的算力值的取值范围;

[0050]

在预先设定业务平均处理速率的条件下,计算所述算力值的取值范围内的最优算力值,将最优算力值作为业务流所需的算力值。

[0051]

进一步地,所述根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序,包括:

[0052]

确定各类业务流所属的应用程序,将属于同一个应用程序的业务流形成集合;

[0053]

根据应用程序的优先级属性,对属于该应用程序的业务流形成的集合进行排序,对集合标注权重值;

[0054]

根据集合的权重值将各个集合内的业务流映射到对应容器的应用程序。

[0055]

进一步地,所述系统还包括:

[0056]

业务流缓存模块,用于在获取到多种终端设备的多个业务流之后,对多个业务流进行缓存,形成业务流混合队列。

[0057]

进一步地,所述系统还包括:

[0058]

业务接口模块,用于从多个通信端口接收来自多种终端设备的多个业务流。

[0059]

另一方面,本发明还提供一种存储介质,其上存储有计算机程序指令,所述计算机程序指令被执行时实现上述的边缘计算的算力预测方法,或者上述的边缘计算的算力编排方法。

[0060]

本发明的边缘计算的算力预测方法,根据不同类型业务流的到达率设定业务流到达的分布函数,通过分布函数计算边缘计算的各类业务流的系统效率占比,在约束条件下预测各类业务流所需的算力值。本方法可以精细化地估算边缘计算业务的算力资源需求,以便于动态地进行算力资源的编排。

[0061]

本发明的算力编排方法及系统,采用算力预测方法对边缘计算的各类业务流所需的算力值进行预测,根据预测的算力值将各类业务流映射到对应容器的应用程序,以便于配置与应用程序的总算力值相匹配的算力资源,为边缘计算提供灵活高效的算力分配方案,提高算力资源利用率。

[0062]

本发明实施方式的其它特征和优点将在随后的具体实施方式部分予以详细说明。

附图说明

[0063]

附图是用来提供对本发明实施方式的进一步理解,并且构成说明书的一部分,与下面的具体实施方式一起用于解释本发明实施方式,但并不构成对本发明实施方式的限制。在附图中:

[0064]

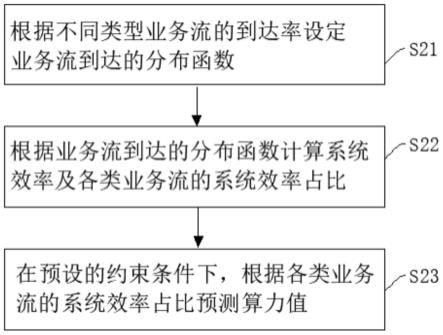

图1是本发明一种实施方式提供的边缘计算的算力预测方法的流程图;

[0065]

图2是本发明一种实施方式提供的边缘计算的算力编排方法的流程图;

[0066]

图3是本发明一种实施方式提供的边缘计算的算力编排系统的框图。

具体实施方式

[0067]

以下结合附图对本发明的具体实施方式进行详细说明。应当理解的是,此处所描述的具体实施方式仅用于说明和解释本发明,并不用于限制本发明。

[0068]

图1是本发明一种实施方式提供的边缘计算的算力预测方法的流程图。如图1所示,本发明实施方式提供一种边缘计算的算力预测方法,所述方法包括以下步骤:

[0069]

s21、统计不同类型业务流的到达率,根据不同类型业务流的到达率设定业务流到达的分布函数。

[0070]

根据边缘计算的业务类型的特性,将物联网边缘计算业务划分为不同的类型,并且各类业务的特性相互独立,例如划分为周期性业务和随机性业务。

[0071]

业务到达率是指平均每秒时间内业务到达的单位数量。假设周期性业务到达率为λ1,随机性业务到达率为λ2,设定业务流到达的分布函数为g(t)。

[0072][0073]

其中,λ1为周期性业务到达率,λ2为随机性业务到达率,δ为冲击函数,t为时间。

[0074]

s22、根据业务流到达的分布函数计算边缘计算的系统效率,以及计算各类业务流的系统效率占比。

[0075]

对业务流到达的分布函数g(t)进行拉普拉斯(laplace)变换,得到系统效率因子α:

[0076]

α=g

*

(μ-μα);

[0077]

其中,g*()函数表示分布函数g(t)的laplace变换,α为系统效率因子,μ为预测的算力值。

[0078]

将系统效率因子α代入以下公式:

[0079][0080]

计算得到边缘计算的系统效率η。

[0081]

统计不同类型业务流各自的占比,将各类业务流的占比分别乘以系统效率η,得到各类业务流的系统效率占比η'。

[0082]

s23、在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值。

[0083]

具体的,在业务丢失率约束条件和业务处理时延约束条件下,根据各类业务流的系统效率占比计算各类业务流所需的算力值的取值范围;在预先设定业务平均处理速率的条件下,计算所述算力值的取值范围内的最优算力值,将最优算力值作为业务流所需的算力值。

[0084]

边缘计算设备从多个通信端口接收来自多种终端设备的多个业务流,在获取到多种终端设备的多个业务流之后,对多个业务流进行缓存,形成业务流混合队列

[0085]

本实施方式中,通过构建边缘计算节点的算力预测模型来预测算力值,算力预测模型的公式如下:

[0086][0087]

其中,η'业务流的系统效率占比,ω为预先设定的业务平均处理速率,μ为预测的算力值,p

over

为缓存队列的溢出概率,p

loss

为业务丢失率约束条件,ws为业务流平均等待时延,ts为业务处理时延约束条件。

[0088]

算力预测模型的执行流程如下:

[0089]

步骤1:对算力预测模型的基础变量进行初始化,周期性业务到达率为λ1,随机性业务到达率为λ2;

[0090]

步骤2:提取业务流缓存队列中业务到达时间间隔等统计参数,计算综合业务到达率业务λc;

[0091]

步骤3:利用业务流到达的分布函数g(t)计算系统效率因子α;

[0092]

步骤4:设置缓存队列的溢出概率p

over

、业务丢失率约束条件p

loss

、业务处理时延约束条件ts等约束条件;

[0093]

步骤5:采用枚举法,计算在预先设定的业务平均处理速率ω的条件下,得到业务丢失率约束条件p

loss

、业务处理时延约束条件ts下算力值μ的取值范围;

[0094]

步骤6:计算maxη’=ω/μ的最优解,此时得到的μ为最终的预测算力值。

[0095]

本实施方式的边缘计算的算力预测方法,根据不同类型业务流的到达率设定业务流到达的分布函数,通过分布函数计算边缘计算的各类业务流的系统效率占比,在约束条件下预测各类业务流所需的算力值。本方法可以精细化地估算边缘计算业务的算力资源需求,以便于动态地进行算力资源的编排。

[0096]

本发明实施方式还提供一种边缘计算的算力编排方法,基于上述算力预测方法进行算力资源的映射,将各类业务流映射到不同业务容器及对应的应用程序app中。

[0097]

图2是本发明一种实施方式提供的边缘计算的算力编排方法的流程图。如图2所示,本实施方式提供一种边缘计算的算力编排方法,所述方法包括以下步骤:

[0098]

s10、获取多种终端设备的多个业务流。

[0099]

边缘计算设备从多个通信端口接收来自多种终端设备的多个业务流,在获取到多种终端设备的多个业务流之后,对多个业务流进行缓存,形成业务流混合队列。

[0100]

s20、采用上述的边缘计算的算力预测方法,预测边缘计算的各类业务流所需的算力值。

[0101]

将多个业务流形成的业务流混合队列输入算力预测模块,算力预测模块执行上述的算力预测方法步骤,计算得到边缘计算的各类业务流所需的算力值。

[0102]

s30、根据各类业务流所需的算力值,将各类业务流映射到对应容器的应用程序。

[0103]

在一实施例中,确定各类业务流所属的应用程序,将属于同一个应用程序的业务流形成集合;根据应用程序的优先级属性,对属于该应用程序的业务流形成的集合进行排序,对集合标注权重值。根据集合的权重值将各个集合内的业务流映射到对应容器的应用程序。

[0104]

在另一实施例中,将各类业务流映射到对应容器的应用程序,还包括:根据各类业务流的实时性要求,对相应的集合的权重值进行修正;根据修正后的集合权重值将集合内的业务流映射到对应容器的应用程序。

[0105]

此外,本实施方式的算力编排方法还包括:统计相同类型业务流对应的应用程序的总算力值;将相同类型业务流对应的应用程序归并到同一个容器中,为该容器配置与所述应用程序的总算力值相匹配的算力资源。

[0106]

在更为具体的实施例中,将各类业务流映射到对应容器的应用程序app包括以下流程:

[0107]

1)、确定各业务流所属的app,属于同一个app的业务流形成一个集合;

[0108]

2)、对各app的优先级属性进行排序,分别对其中的业务流集合标注权重值;

[0109]

3)、统计各业务流的实时性要求,按照业务流到达的剩余时间排序,将剩余时间接近阈值的业务流的优先级权重提高,对其权重值进行修正;

[0110]

4)、根据修正后的权重值,将业务流按序映射到对应业务的app;

[0111]

5)、统计同类业务app的预测算力值的总和,将该类业务归并入同一个容器,并为该容器配置相匹配的算力资源。

[0112]

本实施方式的算力编排方法,采用算力预测方法对边缘计算的各类业务流所需的算力值进行预测,根据预测的算力值将各类业务流映射到对应容器的应用程序,以便于配置与应用程序的总算力值相匹配的算力资源,为边缘计算提供灵活高效的算力分配方案,提高算力资源利用率。

[0113]

图3是本发明一种实施方式提供的边缘计算的算力编排系统的框图。如图3所示,本实施方式提供一种边缘计算的算力编排系统,所述系统包括:算力预测模块、算力映射模块、业务缓存模块以及业务接口模块。所述算力预测模块用于根据边缘计算的不同业务流的特性,预测各类业务流所需的算力值。所述算力映射模块用于根据各类业务流所需的算

力值,将各类业务流映射到对应容器的应用程序。所述业务缓存模块用于在获取到多种终端设备的多个业务流之后,对多个业务流进行缓存,形成业务流混合队列。所述业务接口模块用于从多个通信端口接收来自多种终端设备的多个业务流。

[0114]

所述算力预测模块统计不同类型业务流的到达率,根据不同类型业务流的到达率设定业务流到达的分布函数;根据业务流到达的分布函数计算边缘计算的系统效率,以及计算各类业务流的系统效率占比;在预设的约束条件下,根据各类业务流的系统效率占比预测各类业务流所需的算力值。

[0115]

具体而言,算力预测模块根据边缘计算的业务类型的特性,将物联网边缘计算业务划分为不同的类型,并且各类业务的特性相互独立,例如划分为周期性业务和随机性业务。假设周期性业务到达率为λ1,随机性业务到达率为λ2,设定业务流到达的分布函数为g(t)。

[0116][0117]

其中,λ1为周期性业务到达率,λ2为随机性业务到达率,δ为冲击函数,t为时间。

[0118]

对业务流到达的分布函数g(t)进行拉普拉斯(laplace)变换,得到系统效率因子α:

[0119]

α=g

*

(μ-μα);

[0120]

其中,g*()函数表示分布函数g(t)的laplace变换,α为系统效率因子,μ为预测的算力值。

[0121]

将系统效率因子α代入以下公式:

[0122][0123]

计算得到边缘计算的系统效率η。

[0124]

统计不同类型业务流各自的占比,将各类业务流的占比分别乘以系统效率η,得到各类业务流的系统效率占比η'。

[0125]

在业务丢失率约束条件和业务处理时延约束条件下,根据各类业务流的系统效率占比计算各类业务流所需的算力值的取值范围;在预先设定业务平均处理速率的条件下,计算所述算力值的取值范围内的最优算力值,将最优算力值作为业务流所需的算力值。

[0126]

所述算力映射模块确定各类业务流所属的应用程序,将属于同一个应用程序的业务流形成集合;根据应用程序的优先级属性,对属于该应用程序的业务流形成的集合进行排序,对集合标注权重值;根据集合的权重值将各个集合内的业务流映射到对应容器的应用程序。

[0127]

具体而言,算力映射模块对业务流进行映射的流程为:

[0128]

1)、确定各业务流所属的app,属于同一个app的业务流形成一个集合;

[0129]

2)、对各app的优先级属性进行排序,分别对其中的业务流集合标注权重值;

[0130]

3)、统计各业务流的实时性要求,按照业务流到达的剩余时间排序,将剩余时间接近阈值的业务流的优先级权重提高,对其权重值进行修正;

[0131]

4)、根据修正后的权重值,将业务流按序映射到对应业务的app;

[0132]

5)、统计同类业务app的预测算力值的总和,将该类业务归并入同一个容器,并为该容器配置相匹配的算力资源。

[0133]

本实施方式的算力编排系统,构建了面向多业务的算力预测模型,通过算力预测模块对边缘计算的各类业务流所需的算力值进行预测,算力映射模块根据预测的算力值将各类业务流映射到对应容器的应用程序,以便于配置与应用程序的总算力值相匹配的算力资源,为边缘计算提供灵活高效的算力分配方案,提高算力资源利用率。

[0134]

本发明实施方式还提供一种存储介质,其上存储有计算机程序指令,所述计算机程序指令被执行时实现上述的边缘计算的算力预测方法,或者上述的边缘计算的算力编排方法。

[0135]

本领域内的技术人员应明白,本技术的实施例可提供为方法、系统或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。

[0136]

本技术是参照根据本技术实施例的方法、系统和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0137]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0138]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0139]

最后应当说明的是:以上实施例仅用以说明本发明的技术方案而非对其限制,尽管参照上述实施例对本发明进行了详细的说明,所属领域的普通技术人员应当理解:依然可以对本发明的具体实施方式进行修改或者等同替换,而未脱离本发明精神和范围的任何修改或者等同替换,其均应涵盖在本发明的权利要求保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1