一种船舶智能避碰预警系统及多传感器融合算法的制作方法

1.本发明涉及一种船舶智能避碰预警系统及多传感器融合算法。

背景技术:

2.上海轮渡、浦江游览船只作为浦江两岸公共交通工具,运营于繁忙的黄浦江水域,且实际运行航线均为穿越线路,给船舶自身安全和航线周边船舶的航行安全增加了管控风险;上海轮渡、浦江游览当前防碰撞行为主要依托船载电子海图和视距摄像头作为辅助监测手段,结合船长的驾驶经验,进行航行过程中的防避碰和靠离泊过程中的防避碰操作。

3.由于轮渡在江面运动姿态相对较为简单,毫米波雷达与激光雷达等船基式传感设备在此应用场景下也可扬长避短获得较好的应用效果。

4.下表1列出了现有船舶上一些常见的环境感知传感器在不同性能指标下的对比。

5.表1船载环境感知传感器对比

[0006][0007][0008]

备注:+优势,-劣势

[0009]

可见光摄像头与红外摄像头尽管更适合做目标的分类与识别,所需训练样本数量大,而对于无人船来说,获取江面目标的距离与速度是首要任务,因此不适合作为近距离目标态势感知的主要传感器。毫米波雷达与激光雷达的极高的测距精度和点云成像能力显然

能够提供更强的近距离目标感知能力。另一方面,激光雷达在恶劣天气条件下运行效果不佳的缺陷导致其必须与可靠性较高的毫米波雷达互相协作。

[0010]

毫米波雷达测距精度仅次于激光雷达,距离测量精度在0.05m-0.4m之间,角度分辨率在0.1

°

至5

°

之间,但与激光、红外、可见光相比,毫米波雷达透雾、烟、尘的能力强,且具有体积小、重量轻、抗干扰、空间分辨率高等特点,可在较为恶劣的天气环境下全天候工作,这对江面船舶能否自主航行至关重要。

技术实现要素:

[0011]

本发明所要解决的技术问题是提供一种船舶智能避碰预警系统及多传感器融合算法,以解决背景技术中所存在的问题。

[0012]

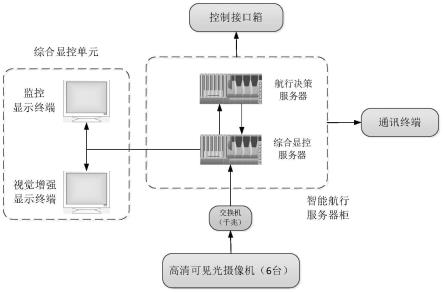

本发明船舶智能避碰预警系统及多传感器融合算法是通过以下技术方案来实现的:包括高清可见光摄像机、智能航行服务器柜、综合显控单元和通讯终端;

[0013]

高清可见光摄像机采集船身周围的视频信息,视频信息数据传输至交换机,并通过交换机将视频信息数据发送至智能航行服务器柜进行处理,在综合显控单元上进行实时显示;同时,感知数据通过通讯终端发送向岸基数据中心,决策数据通过控制接口箱发送向动力系统控制单元。

[0014]

作为优选的技术方案,综合显控单元由监控显示终端和视觉增强显示终端组成,监控显示终端和视觉增强显示终端相互连接;所述智能航行服务器柜由航行决策服务器和综合显控服务器组成,且综合显控服务器连接综合显控单元,交换机连接综合显控服务器,航行决策服务器连接控制箱接口;所述航行决策服务器与综合显控服务器相互连接。

[0015]

一种多传感器融合算法,其特征在于,具体步骤如下:

[0016]

s1、畸变矫正;相机镜头畸变矫正

‑‑

》得到相机的内外参数、畸变参数矩阵;

[0017]

s2、测距;

[0018]

s3、根据相似三角比例计算出对应像素点的实际坐标。

[0019]

作为优选的技术方案,畸变矫正具体包括以下步骤:

[0020]

s11、外参数矩阵,世界坐标经过旋转和平移,然后落到另一个现实世界点上;

[0021]

s12、内参数矩阵,现实世界点在1的基础上,继续经过摄像机的镜头、并通过针孔成像和电子转化而成为像素点。

[0022]

s13、畸变矩阵,像素点并没有落在理论计算该落在的位置上,产生一定的偏移和变形。

[0023]

5.根据权利要求3所述的多传感器融合算法,其特征在于,测距具体包括以下步骤:

[0024]

s21、使用摄像机采集道路前方的图像;

[0025]

s22、在道路区域对物体进行检测,通过矩形框将物体形状框出来;

[0026]

s23、结合矩形框信息,找到该矩形框底边的两个像平面坐标,分别记为(u1,v1)和(u2,v2);

[0027]

s24、使用几何关系推导法,由像平面坐标点(u1,v1)、(u2,v2)推导出道路平面坐标(x1,y1)、(x2,y2);

[0028]

s25、通过欧氏距离公式计算出d。

[0029]

作为优选的技术方案,根据相似三角比例计算出对应像素点的实际坐标,其对摄像机标定要求较高,同时要求镜头本身造成的畸变就比较小,其主要原理为小孔成像;其推导步骤如下:

[0030]

已知量:

[0031]

摄像机高度h

[0032]

图像坐标中心对应的世界坐标点与摄像头在y轴上的距离o3mo3m

[0033]

镜头中心点的图像坐标o1(ucenter,vcenter)o1(ucenter,vcenter)

[0034]

测量像素点的图像坐标p1(u,0)、q1(u,v)p1(u,0)、q1(u,v)

[0035]

实际像素的长度xpix

[0036]

实际像素的宽度ypix

[0037]

摄像头焦距f

[0038][0039][0040]

β=α-γ

[0041][0042]

这样就可以得到垂直方向的坐标。

[0043]

y=o3p

[0044][0045][0046]

由

[0047]

得到pq=(o2*p1q1)/o2p1

[0048]

这样就可以得到垂直方向的坐标;

[0049]

x=pq。

[0050]

本发明的有益效果是:本发明将激光雷达的高精度与毫米波雷达的高可靠性特征相结合,将激光雷达的目标三维形状感知与毫米波雷达的多目标实时探测与跟踪相结合,共同实现船舶近距离目标的精确感知,方案兼具了可行性及可靠性,为无人船自动靠离泊与近距离避障提供技术支撑,同时赋予无人船全方位、高精度的江面感知能力。

附图说明

[0051]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以

根据这些附图获得其他的附图。

[0052]

图1为本发明的系统方框图图;

[0053]

图2为本发明的轮渡感知系统能力图;

[0054]

图3为本发明的小孔成像原理图;

[0055]

图4为本发明的yolov5目标检测算法整体框图。

具体实施方式

[0056]

本说明书中公开的所有特征,或公开的所有方法或过程中的步骤,除了互相排斥的特征和/或步骤以外,均可以以任何方式组合。

[0057]

如图1所示,本发明的一种船舶智能避碰预警系统,包括高清可见光摄像机、智能航行服务器柜、综合显控单元和通讯终端;

[0058]

所述高清可见光摄像机采集船身周围的视频信息,视频信息数据传输至交换机,并通过交换机将视频信息数据发送至智能航行服务器柜进行处理,在综合显控单元上进行实时显示;同时,感知数据通过通讯终端发送向岸基数据中心,决策数据通过控制接口箱发送向动力系统控制单元。

[0059]

如图2所示,高清可见光摄像机将激光雷达的高精度与毫米波雷达的高可靠性特征相结合,将激光雷达的目标三维形状感知与毫米波雷达的多目标实时探测与跟踪相结合,共同实现船舶近距离目标的精确感知,方案兼具了可行性及可靠性,为无人船自动靠离泊与近距离避障提供技术支撑,同时赋予无人船全方位、高精度的江面感知能力。

[0060]

本实施例中,综合显控服务器实现对视频监控数据的实时处理、显示和存储,并与航行决策服务器进行交互,提供航行建议轨迹;感知数据以4g/5g的通讯方式与岸基进行无线通讯;监控显示终端实现全摄像机视角同步实时显示监控状态,视觉增强显示终端实现对监控距离50m范围内威胁目标的识别和预警,并针对5m、20m和50m范围设定不同的报警级别。

[0061]

本实施例中,综合显控单元由监控显示终端和视觉增强显示终端组成,监控显示终端和视觉增强显示终端相互连接;所述智能航行服务器柜由航行决策服务器和综合显控服务器组成,且综合显控服务器连接综合显控单元,交换机连接综合显控服务器,航行决策服务器连接控制箱接口;所述航行决策服务器与综合显控服务器相互连接。

[0062]

一种多传感器融合算法,具体步骤如下:

[0063]

s1、畸变矫正;相机镜头畸变矫正

‑‑

》得到相机的内外参数、畸变参数矩阵;

[0064]

s2、测距;

[0065]

s3、根据相似三角比例计算出对应像素点的实际坐标。

[0066]

本实施例中,畸变矫正具体包括以下步骤:

[0067]

s11、外参数矩阵,世界坐标经过旋转和平移,然后落到另一个现实世界点上;

[0068]

s12、内参数矩阵,现实世界点在1的基础上,继续经过摄像机的镜头、并通过针孔成像和电子转化而成为像素点。

[0069]

s13、畸变矩阵,像素点并没有落在理论计算该落在的位置上,产生一定的偏移和变形。

[0070]

本实施例中,测距具体包括以下步骤:

[0071]

s21、使用摄像机采集道路前方的图像;

[0072]

s22、在道路区域对物体进行检测,通过矩形框将物体形状框出来;

[0073]

s23、结合矩形框信息,找到该矩形框底边的两个像平面坐标,分别记为(u1,v1)和(u2,v2);

[0074]

s24、使用几何关系推导法,由像平面坐标点(u1,v1)、(u2,v2)推导出道路平面坐标(x1,y1)、(x2,y2);

[0075]

s25、通过欧氏距离公式计算出d。

[0076]

如图3所示,根据相似三角比例计算出对应像素点的实际坐标,其对摄像机标定要求较高,同时要求镜头本身造成的畸变就比较小,其主要原理为小孔成像;其推导步骤如下:

[0077]

已知量:

[0078]

摄像机高度h

[0079]

图像坐标中心对应的世界坐标点与摄像头在y轴上的距离o3mo3m

[0080]

镜头中心点的图像坐标o1(ucenter,vcenter)o1(ucenter,vcenter)

[0081]

测量像素点的图像坐标p1(u,0)、q1(u,v)p1(u,0)、q1(u,v)

[0082]

实际像素的长度xpix

[0083]

实际像素的宽度ypix

[0084]

摄像头焦距f

[0085][0086][0087]

β=α-γ

[0088][0089]

这样就可以得到垂直方向的坐标。

[0090][0091][0092]

y=o3p由得到

[0093]

这样就可以得到垂直方向的坐标;

[0094]

x=pq。

[0095]

本实施例中,还包括yolov5目标识别算法;所述yolov5是一种单阶段目标检测算法,该算法在yolov4的基础上些改进:输入端,主要包括mosaic数据增强、自适应锚框计算、自适应图片缩放;基准网络主要包括focus结构与csp结构;neck网络,在目标检测网络在backbone与最后的head输出层之间添加fpn+pan结构;head输出层:输出层的锚框机制与

yolov4相同,改进的是训练时的损失函数giou_loss,以及预测框筛选的diou_nms。

[0096]

如图4所示,目标检测算法将其划分为4个通用的模块,具体包括:输入端、基准网络、neck网络与head输出,对应于上图中的4个红色模块。yolov5算法具有4个版本,具体包括:yolov5s、yolov5m、yolov5l、yolov5x四种,本文重点讲解yolov5s,其它的版本都在该版本的基础上对网络进行加深与加宽。

[0097]

本实施例中,输入端-输入端表示输入的图片,该网络的输入图像大小为608*608,该阶段通常包含一个图像预处理阶段,即将输入图像缩放到网络的输入大小,并进行归一化等操作。在网络训练阶段,yolov5使用mosaic数据增强操作提升模型的训练速度和网络的精度;并提出了一种自适应锚框计算与自适应图片缩放方法;基准网络-基准网络通常是一些性能优异的分类器种的网络,该模块用来提取一些通用的特征表示。yolov5中不仅使用了cspdarknet53结构,而且使用了focus结构作为基准网络。

[0098]

本实施例中,neck网络-neck网络通常位于基准网络和头网络的中间位置,利用它可以进一步提升特征的多样性及鲁棒性。虽然yolov5同样用到了spp模块、fpn+pan模块,但是实现的细节有些不同。

[0099]

本实施例中,head输出端-head用来完成目标检测结果的输出。针对不同的检测算法,输出端的分支个数不尽相同,通常包含一个分类分支和一个回归分支。yolov4利用giou_loss来代替smooth l1 loss函数,从而进一步提升算法的检测精度。

[0100]

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何不经过创造性劳动想到的变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应该以权利要求书所限定的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1