一种基于平均距离权重和价值计算的多标签分类方法与流程

1.本发明属于多标签分类方法领域,具体涉及一种基于平均距离权重和价值计算的多标签k最近邻分类方法。

背景技术:

2.随着互联网技术的发展,数据的数量和复杂程度越来越大,多标签分类方法在面对这些数据时会出现分类性能下降的情况。多标签k最近邻分类方法 (ml

‑

knn)的出现使得多标签学习的研究领域得到了极大的进展,但是 ml

‑

knn也存在一定的局限性。在基于概率统计的ml

‑

knn多标签分类方法里,待分类样本的k个近邻被隐含地认为对分类结果具有相同的影响而忽略了该k 个近邻与待分类样本距离的远近。

3.鉴于此,zeng等人在2016年提出了iml

‑

knn方法,在ml

‑

knn基础上通过融合样本的最近邻和k个邻居的信息以达到正确分类的目的。该算法仅仅考虑了最近邻的影响,并不能全面地考虑到整体近邻样本对分类结果的影响,并且待测样本的k近邻中样本与待测样本的距离远近对于待测样本的标签也具有很大影响。对于大多数多标签数据集的某一类,正例的样本数远远小于负例的样本数,而在分类中应该更多关注的是正例的正确分类程度。

4.为了解决传统ml

‑

knn方法中距离信息丢失的问题,2018年乔亚琴等人提出了构造k近邻数据的多标签分类方法(linrml

‑

knn和logrml

‑

knn),通过对近邻样本与测试样本之间的距离关系,重新构造了新的数据集。在所构造的新数据集中,新数据的特征定义为近邻样本的距离与相关标签的加权和。通过这种方式,样本中可以包含近邻样本的距离,并且将近邻样本的个数也加入到数据的特征中,特征中包含了更多的信息。通过构造新数据集进行分类的方法虽然在一定程度上弥补了ml

‑

knn的缺陷,但其完全依靠近邻之间的信息进行预测,不能结合近邻的概率特征进行预测。

技术实现要素:

5.本发明主要针对上述问题,提出了基于平均距离权重和价值计算的多标签分类方法(average distance weight and value ml

‑

knn,dvml

‑

knn),将包含标签的近邻和不包含标签的近邻信息加入到分类中,全面地将近邻样本对待测样本的影响进行考量。具体地,通过计算近邻样本的距离,并将距离进行量化后选取适当的权重,得到一个新的分类函数,并且在计算后验概率时加入价值概念,使得最终的分类结果更偏向弱势类。

6.本发明的上述技术问题是通过以下技术方案得以实施的:一种基于平均距离权重和价值计算的多标签分类方法,其特征在于,方法流程如下:

7.输入:训练集,测试集;

8.输出:分类结果。

9.步骤一,计算标签y

j

的先验概率,计算公式为:

10.p(y

j

=0)=1

‑

p(y

j

=0);

11.s为拉普拉斯平滑系数,一般取1,m为数据集中训练集的样本个数。

12.步骤二,计算训练集样本xz的k个邻居n(x

i

)。

13.步骤三,计算近邻样本选中标签y

j

的个数;

[0014][0015]

步骤四,h[a]=0,h'[a]=0,对于样本x

i

,如果含有标签y

j

,则对于h[a] 和h'[a]需要满足的条件为h[a]=h[a]+1&&h'[a]=h'[a]

‑

1,如果不包含标签y

j

,则需要满足的条件为h'[a]=h'[a]+1&&h[a]=h[a]

‑

1。

[0016]

步骤五,对于测试集样本x

i

中的近邻,若最终h[c

j

(x

i

)]<0

[0017]

或者h'[c

j

(x

i

)]<0,则需将h[c

j

(x

i

)]或者h'[c

j

(x

i

)]的值置为0。

[0018]

步骤六,计算后验条件概率。

[0019]

步骤七,对于x

i

包含标签的样本和不包含标签的样本对其分别计算平均距离d和d',采用欧式距离;

[0020]

距离转化公式为:

[0021]

(d,d')表示;两个样本之间的距离,a为一个常数,

[0022]

将w的公式代入决策函数中,决策函数的最终形式为:

[0023][0024]

步骤八,根据决策公式计算最终结果,判断x

i

的分类结果。

[0025]

作为优选,所述步骤四即为价值计算,训练集样本在完成价值计算之后,如果h[a]或者h'[a]的值小于0时,则将h[a]或者h'[a]的值置为0。

[0026]

作为优选,所述价值计算的过程主要为:计算后验条件概率p(c

j(xi)

|y

j

) 时,当数据集中的某一样本x的近邻中有a个近邻选择标签y

j

,且样本x 选择了标签y

j

,则h[a]的值增加1,将h'[a]的值减少1;若样本x未选择标签y

j

,并且有a个近邻选择标签y

j

,则对h'[a]的值增加1,h[a]的值减少1,初始值为0,h'[a]的最大值为k;当计算后的h[a]或者h'[a]的值小于0时,将h[a]或者h'[a]的值均置为0;最后通过最终得到的h[a]和h'[a] 计算后验条件概率。

[0027]

作为优选,所述后验条件概率计算公式为:

[0028]

[0029][0030]

其中s为拉普拉斯平滑系数,一般取1。

[0031]

作为优选,所述决策函数的过程:

[0032]

步骤1,首先确定ml

‑

knn中标签的先验概率:

[0033][0034]

其中s为拉普拉斯平滑系数,一般取1,m数据集中训练集的样本个数;

[0035]

步骤2,在ml

‑

knn基础上得到一个新的分类函数:

[0036][0037]

其中含有标签j时,j=1,否则j=0;当j=1时,t表示含有标签j的近邻样本的个数,w表示含有标签j的近邻样本的平均距离转化的权重;

[0038]

样本当j=0时,表示不含有标签j的近邻样本个数,w表示不含有标签j的近邻样本的平均距离转化的权重,t/k和(k

‑

t)/k分别表示不同的加权系数;

[0039]

距离转化成权重w要求距离越小则权重越大;

[0040]

步骤3,高斯转换

[0041][0042]

其中a和b为常数项;

[0043]

步骤4,将w的公式代入决策函数中,决策函数的最终形式为:

[0044][0045]

在实际的应用中,对于样本选择了标签y

j

,但其近邻选择标签y

j

的个数较少的样本需要更加有偏重,在上述对后验条件概率的计算中传统的ml

‑

knn方法并不能对这一类样本有所偏重。因此本发明提出了价值计算的概念,使用价值代替传统ml

‑

knn对于样本数量的计算,即在ml

‑

knn的计算后验条件概率 p(c

j(xi)

|y

j

)时在其中加入价值的计算,使得分类算法对弱势类的样本有所偏重,能更好的对弱势类进行分类,提高分类性能。

[0046]

综上所述,本发明与现有技术相比具有如下优点:

[0047]

本发明提出了基于平均距离权重和价值计算的多标签分类方法(averagedistance weight and valueml

‑

knn,dvml

‑

knn),将包含标签的近邻和不包含标签的近邻信息加入到分类中,全面地将近邻样本对待测样本的影响进行考量。具体地,通过计算近邻样本的距离,并将距离进行量化后选取适当的权重,得到一个新的分类函数,并且在计算后验概率时加入价值概念,使得最终的分类结果更偏向弱势类。

[0048]

本发明在ml

‑

knn算法的基础上进行了改进,在传统ml

‑

knn算法的后验条件概率计

算中,引入价值计算,并且对样本的近邻标签的距离进行衡量,将距离通过高斯函数转化为权值,最后通过对决策函数的改进实现最终的分类,所提出的dvml

‑

knn算法在多项性能上有了较大的提高。

具体实施方式

[0049]

下面结合实施例对本发明进一步说明。

[0050]

实施例1:

[0051]

决策函数:

[0052]

对于待测样本的每一个近邻样本,通常认为距离越近相似度越大,对于包含标签的样本和不包含标签的样本需要综合考虑对待测样本的影响,并且需要衡量包含或者不包含标签的样本数量对待测样本的影响。

[0053]

首先确定ml

‑

knn中标签的先验概率:

[0054][0055]

其中s为拉普拉斯平滑系数,一般取1,m数据集中训练集的样本个数。基于以上考虑,在ml

‑

knn基础上可以得到一个新的分类函数:

[0056][0057]

其中含有标签j时,j=1,否则j=0。当j=1时,t表示含有标签j的近邻样本的个数,w表示含有标签j的近邻样本的平均距离转化的权重。样本当j=0时,表示不含有标签j的近邻样本个数,w表示不含有标签j的近邻样本的平均距离转化的权重,t/k和(k

‑

t)/k分别表示不同的加权系数。

[0058]

距离转化成权重w要求距离越小则权重越大。距离可以通过采取反函数、减操作以及高斯转化三种方法转换为权重的形式。在距离转化当中将距离的倒数作为权值即为反函数形式,一般的公式如公式3所示,其中(d,d')表示;两个样本之间的距离,a为一个常数,防止当样本之间的距离过小导致w值过大。为了确定反函数是否适用于本文的权值计算,对反函数进行求导可得公式4。我们发现当距离较近时不仅权值较大,并且权值的变化也较大,所以反函数并不适合距离与权值的转换。减操作的一般形式为w=a

‑

(d,d'),a为常数项,若(d,d')大于a,则w=0。但是减操作的缺陷是常数项a的取值难以衡量,在距离达到一定的程度时权重会减为0,不能有效的对距离进行衡量。高斯转换一般形式如公式 5所示,其中a和b为常数项,通过高斯函数进行转换,权值的变化率较为平缓,对于距离较小或者较大的函数不会出现权值过大或者为0的情况。因而高斯转换的方式适合作为距离转换为权值的方法。

[0059][0060]

[0061][0062]

将w的公式代入决策函数中,决策函数的最终形式为:

[0063][0064]

价值计算:

[0065]

在ml

‑

knn中,后验条件概率计算公式如公式7和公式8所示。其中c

j(xi)

表示样本x

i

的k个近邻含有标签j的或者不含有标签j的个数,y

j

表示样本中x

i

选中或者不选中标签j。ml

‑

knn的核心思想是计算不同近邻样本在某一标签上的频率。具体的流程是,当数据集中的某一样本x的近邻中有a个近邻选择标签y

j

,且样本x选择了标签y

j

,则h[a]的值增加1,h[a]的初始值为0,h[a]的最大值为k。若样本x未选择标签y

j

且有a个近邻选择标签y

j

,则h'[a]的值增加1,h'[a]的初始值为0,h'[a]的最大值为k。

[0066][0067][0068]

其中s为拉普拉斯平滑系数,一般取1。

[0069]

在实际的应用中,对于样本选择了标签y

j

,但其近邻选择标签y

j

的个数较少的样本需要更加有偏重,在上述对后验条件概率的计算中传统的ml

‑

knn方法并不能对这一类样本有所偏重。因此本发明提出了价值计算的概念,使用价值代替传统ml

‑

knn对于样本数量的计算,即在ml

‑

knn的计算后验条件概率 p(c

j(xi)

|y

j

)时在其中加入价值的计算,使得分类算法对弱势类的样本有所偏重,能更好的对弱势类进行分类,提高分类性能。

[0070]

价值计算的过程主要为:计算后验条件概率p(c

j(xi)

|y

j

)时,当数据集中的某一样本x的近邻中有a个近邻选择标签y

j

,且样本x选择了标签y

j

,则h[a]的值增加1,将h'[a]的值减少1。若样本x未选择标签y

j

,并且有a个近邻选择标签y

j

,则对h'[a]的值增加1,h[a]的值减少1,初始值为0,h'[a]的最大值为k。当计算后的h[a]或者h'[a]的值小于0时,将h[a]或者h'[a]的值均置为0。最后通过最终得到的h[a]和h'[a]计算后验条件概率。

[0071]

算法描述:

[0072]

通过在多标签分类方法中改进决策函数和加入价值计算,基于平均距离权重和价值的多标签分类方法流程如下:

[0073]

输入:训练集,测试集

[0074]

输出:分类结果

[0075]

步骤一,通过以下公式计算标签y

j

的先验概率;

[0076]

p(y

j

=0)=1

‑

p(y

j

=0);

[0077]

步骤二,计算训练集样本x

z

的k个邻居n(x

i

);

[0078]

步骤三,计算近邻样本选中标签y

j

的个数;

[0079][0080]

步骤四,h[a]=0,h'[a]=0,对于样本x

i

,如果含有标签y

j

,则对于h[a]和h'[a] 需要满足的条件为h[a]=h[a]+1&&h'[a]=h'[a]

‑

1,如果不包含标签y

j

,则需要满足的条件为h'[a]=h'[a]+1&&h[a]=h[a]

‑

1;

[0081]

步骤五,对于测试集样本x

i

中的近邻,若最终h[c

j

(x

i

)]<0或者h'[c

j

(x

i

)]<0,则需将h[c

j

(x

i

)]或者h'[c

j

(x

i

)]的值置为0;

[0082]

步骤六,计算后验条件概率;

[0083]

步骤七,对于x

i

包含标签的样本和不包含标签的样本对其分别计算平均距离 d和d',采用欧式距离;

[0084]

步骤八,根据决策公式计算最终结果,判断x

i

的分类结果;

[0085]

算法的步骤四即为价值计算,训练集样本在完成价值计算之后,如果h[a]或者h'[a]的值小于0时,则将h[a]或者h'[a]的值置为0。

[0086]

实验结果与分析:

[0087]

在实验中对本发明提出方法与不同的多标签分类方法进行了对比。

[0088]

评价指标和数据集:

[0089]

在分类结果的评价指标中选用汉明损失(hammingloss)。

[0090]

汉明损失表示所有数据集中所有样本的分类结果与真实标签差异程度,值越小则说明分类效果越好,预测结果与真实标签的差异程度越小,当损失值为0 时,表明分类效果好。

[0091][0092]

其中m为样本数,y

i

为样本x

i

的标签集,z

i

为样本x

i

预测的标签集合,δ为y

i

与z

i

两个标签集合的对称差即异或操作。

[0093]

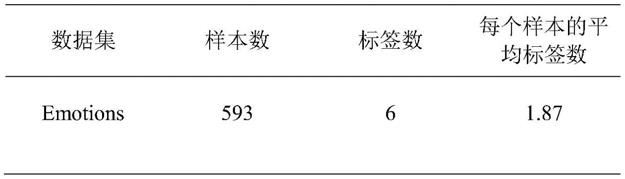

在申请中,使用emotions多标签数据集进行实验,emotions是音乐领域数据集,数据集的详细信息如下表所示。

[0094]

表1 emotions多标签实验数据集的详细信息

[0095][0096]

对比实验:

[0097]

为了验证dvml

‑

knn在多标签分类学习当中的有效性,将该方法与3种多标签分类方法linrml

‑

knn,logrml

‑

knn和iml

‑

knn进行对比实验,在 emotions数据集上进行,均采用十折交叉验证,dvml

‑

knn的a值设置为1/2, b设置为10,其他均为默认参数,每个数据集进行10次实验,以各项指标的10 次实验的平均值作为评价指标。

[0098]

实验结果如表2所示,在emotions数据集中,dvml

‑

knn在汉明损失远远领先于其他

方法。

[0099]

实验结果表明,dvml

‑

knn方法在多标签分类中相较于其他多标签分类方法具有一定的优势。dvml

‑

knn方法的提出的平均距离和价值计算取得了良好的效果,提高了分类性能。

[0100]

表2不同多标签分类方法在emotions数据集上的实验结果

[0101][0102]

本发明在ml

‑

knn方法的基础上进行了改进,提出了一种基于平均距离权重和价值的多标签分类方法。在传统ml

‑

knn方法的后验条件概率计算中,引入价值计算,并且对样本的近邻标签的距离进行衡量,将距离通过高斯函数转化为权值,最后通过对决策函数的改进实现最终的分类。本发明所提出的 dvml

‑

knn方法在性能上有了较大的提高。

[0103]

本方法的应用:

[0104]

在传统的分类学习中,假定每个样本只属于一个类别标签,该问题属于单标签分类问题。单标签分类问题中,二分类最为常见,主要是指标签的取值只有两种,而单标签的多分类问题主要是指标签的取值可能有多种。随着大数据时代的到来,机器学习和数据挖掘得到长足的发展,多标签分类越来越受到重视。多标签分类问题中,每个样本则是可以和多个类别标签相关联。比如,一则新闻可以同时属于政治和法律类别,一种药物可能治疗多种疾病。

[0105]

多标签分类在生物信息学,药物研发,文本分类,蛋白质分类,音乐分类,和语义场景分类等领域得到广泛的应用。例如:在传统药物研究中药物与疾病关系是一对一的关系,一种药物往往只能治疗一种疾病。但是随着进一步的研究发现药物与靶标对应的关系是多标签关系也就是每个靶标对应多个药物,同样药物分子也对应多个靶标。因此,通过基于多标签学习的机器学习方法可以极大地提高筛选效率,可以运用药物的多种信息以及不同特征进行分类处理,方式多变灵活,不再需要复杂昂贵的各种研发仪器,只需具有强大计算能力的电脑就能实现药物的筛选,其廉价的成本获得了研发人员的青睐。除此之外,药物分子往往只针对一个特定靶标的进行研发,而在多标签学习可分类出多个药物靶标,极大地提高靶标发掘的效率。

[0106]

本发明的上述具体实施方式仅仅用于示例性说明或解释本申请的原理,而不构成对本申请的限制。因此,在不偏离本申请的精神和范围的情况下所做的任何修改、等同替换、改进等,均应包含在本申请的保护范围之内。此外,本发明所附权利要求旨在涵盖落入所附权利要求范围和边界、或者这种范围和边界的等同形式内的全部变化和修改例。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1