一种基于SDL模型的仿真深度学习的构建方法与流程

一种基于sdl模型的仿真深度学习的构建方法

【技术领域】

1.本发明属于人工智能领域中的一种基于sdl模型的仿真深度学习的构建方法。

背景技术:

2.加拿大多伦多大学教授hinton团队提出的“深度学习”(非专利文献1)在 imagenet的图像分类的测试数据集中获得了优异的成绩,引起世界的关注,因此掀起了本次人工智能的高潮。很多的研究人员力图用“深度学习”模型进行自动驾驶汽车的控制。代表的手法有“一天学会开车”(非专利文献2)。

3.作为“深度学习”的发明人hinton在2017年9月在接受axios网站采访时宣告:“我的观点是把它(反向传播)全部丢下,重起炉灶”,这是hinton的玻尔兹曼机的梦想破灭,“深度学习”的黑箱问题不可解决,因此不适于广泛的普及最终要终结。

4.因此人们迫切的需要寻找替代”深度学习“的新一代人工智能模型,希望得到一个没有黑箱问题的,小数据的,概率的,迭代的机器学习模型。然而, hinton预言的capsule理论(非专利文献3)并没有得到预期的效果。

5.在深度学习被发明人否定之后,算法学派大崛起,一个题为:“一种人工智能新型神经网络的构建方法”(cn108510052a)的新一代人工智能自律学习sdl 模型被发表了。【非专利文献1】

6.a.krizhevsky,i.sutskever,geoffrey e.hinton:“imagenet classification with deep convolutional neural networks”,advances in neural information processing systems 25:pp1097-1105(2012).【非专利文献2】

7.a.kendall,j.hawke:

″

learning to drive in day

″

, arxiv:1807.00412v2.[cs.lg]11sep.(2018).【非专利文献3】

[0008]

s.sabour,n.frosst,geoffrey e.hinton:

″

dynamic routing between capsules

″

,arxiv:1710.09829v2.[cs.cv]7nov.(2017).【专利文献1】

[0009]

(cn108510052a)

[0010]

上述(非专利文献1)的深度学习模型,在求解数据集时,需要穷举才能得到全局最佳,在这样大的组合空间里这是一个npc问题。再有,通过概率梯度下降法sgd只能获得局域最佳解,很难达到全局最佳解。而且,sgd所获得局域最佳解,对深度学习的应用效果是随机性的,不能保证每一个sgd的解都是应用效果最好的解。由于全局最佳解不可能得到,sgd的局域最佳解是很不稳定的,只要数据有一点波动就会得到截然不同的解,这就是黑箱问题出现的原因。

[0011]

再有,在穷举的计算上消耗了庞大的硬件开销,处理效率极低,硬件成本非常高,是大模型解决小任务的原因。深度学习由于是函数映射模型,在实际应用中,一位深度学习

算法人员要配100位标注人员,这完全是“人工的智能”,致使应用成本很高。再有就是深度学习受应用场景的限制,仅可以在图像识别,声音识别上发挥作用,不能应用于工业控制,自动驾驶汽车的控制等。

[0012]

上述(非专利文献2)的采用无模型深度强化学习算法方法,用深度确定性策略梯度(deep deterministic policy gradients,ddpg)来解决车道跟踪任务。面对复杂的自动驾驶汽车的控制,该方法容易陷入控制的npc问题,在实际工程应用上很困难。

[0013]

上述(非专利文献3)的capsule理论,用效果好的节点信息,增加权重值,效果不好的节点信息就降低权重值,作为迭代的方法,并通过公式化的方法计算结果等,其结果目前还没有展示出令人信服的,且hinton本人所希望得到的真正的概率模型,以及强大的迭代效果。

[0014]

上述(专利文献1)导入了在数学上最强大的高斯过程的理论,是概率的模型,是小数据的模型,也是高度迭代的模型。仅用很少的数据,就可以获得相当于函数映射的无穷个数据集的应用效果。系统规模可以无穷的扩展,计算复杂度接近线性。可以应用于任何领域。但是不具有深度学习函数映射模型那种可以扩大特征向量之间的间隔的特点。

技术实现要素:

[0015]

本发明的第一个目的是:提出一个通过算法既数理计算,仿真函数映射模型的深度学习,从而不需要通过组合获得数据训练最佳的解,提高系统的处理效率,降低了硬件的开销,解决了黑箱问题。

[0016]

本发明的第二个目的是:提出一个将数理计算所仿真的深度学习,与sdl 高斯分布模型融合,函数的概率分布与函数的映射两种模型相结合,两种特点都能发挥,构建目前最强大的人工智能模型,推动人工智能的深入普及。

[0017]

为实现上述至少一种目的,本发明提出如下技术方案。一种基于sdl模型的仿真深度学习的构建方法,至少具备如下一个特征:((1)将所有的包括特征向量值,或者特征向量值的高斯分布在内的至少一种形式的信息,通过映射函数映射到数据集层;(2)将各个特征向量的高斯分布的结果,即最大概率值,最大概率尺度值通过映射函数,映射到数据集层作为输出结果;(3)将所有的特征向量通过映射函数映射到数据集层,再在数据集层中,将高斯分布的结果,即最表示最大概率空间的大概率值,最大概率尺度值作为输出结果的一种方法。

[0018]

而且,所述映射函数是指:包括线性函数,也可以是非线性的函数,还可以是随机函数中至少一种,或多种混合映射函数。

[0019]

而且,所述映射函数是指:不只是经典的线性函数,经典的非线性的函数,经典的随机函数,特别是按照深度学习的sdg求解出的解的特点,考虑了深度学习对模式识别的精度的提高的作用,结合人为介入的手法,综合的构造出来的映射函数;映射函数中有包括数理运算形式的成分,有隶属函数的成分,有规则构建成分在内的至少一种或多种混合成分。

[0020]

而且,所述最大几率的概率空间,是直接计算高斯分布,或是通过自律机器学习sdl聚类得到的。

[0021]

一种基于sdl模型的仿真深度学习的构建方法,其特征在于是通过如下步骤实现

的:(1)特征值通过sdl模型以最大几率特征值,或者卷积的输出信息输入到输入层的各个节点上;(2)输入到输入层的各个节点上特征值,或者卷积的输出信息通过映射函数,映射到数据集层;或者将高斯分布的结果映射到数据集层中;或将映射到数据集层的复数个同一种类的特征值的训练数据,再通过数据集层与高斯层之间搭载着的sdl模型的模组训练出,可以表示最大几率空间的高斯分布的最大几率训练值,或最大几率尺度值。

[0022]

而且,所述映射函数是指:包括线性函数,也可以是非线性的函数,还可以是随机函数中至少一种或多种映射函数。而且,所述映射函数是指:不只是经典的线性函数,经典的非线性的函数,经典的随机函数,特别是按照深度学习的sdg求解出的解的特点,考虑了深度学习对模式识别的精度的提高的作用,结合人为介入的手法,综合的构造出来的映射函数;映射函数中有包括数里运算形式的成分,有隶属函数的成分,有规则构建成分在内的至少一种或多种混合的成分。而且,所述最大几率的概率空间,是通过自律机器学习sdl聚类得到的。本发明提出的一种基于sdl模型的仿真深度学习的构建方法,本方法的实施效果是:针对识别对象的数据训练,不需要像传统的深度学习那样通过组合的方法,本发明仅仅通过映射函数就可以达到对识别对象的训练效果,没有黑箱问题,不需要大的硬件支持,不需要大数据的标注,仅仅通过小数据的训练就可以得到大数据集的效果。因此具有性能高,导入成本低,便于大量普及。

附图说明

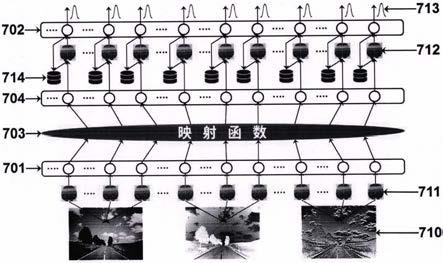

图1是最小规模神经网络构成示意图图2是某输入信息所获的的所有sgd的解与应用效果的关系实例图3是灰度变换图像处理方法图4是强调边框信息的图像处理方法图5是另一种强调边框信息的图像处理方法图6是一种基于sdl模型仿真深度学习的构成示意图图7是另一种基于sdl模型仿真深度学习的构成示意图图8是映射函数的各种形式的示意图图9是两个重叠的高斯分布的示意图图10是image_net一个图像类的训练数据图11是自律机器学习sdl聚类方法的流程图图12是深度可分离卷积示意图图13是在需要提取更多的特征时的深度可分离卷积示意图符号说明i1,i2,i3,i4是输入信息t1,t2,t3,...,t

16

是权值o1,o2,o3,o4是输出信息

(601)是输入层(602)是高斯层(603)是函数映射层(604)数据集层(610)图像信息(611)sdl模型构成的机器学习(612)用sdl模型构成的机器学习(613)高斯分布的输出数据(701)是输入层(702)是高斯层(703)是函数映射层(704)数据集层(710)图像信息(711)用sdl模型构成的机器学习(712)用sdl模型构成的机器学习(713)高斯分布的输出数据g

ζ

一个高斯分布g

ξ

另一个高斯分布ω两个高斯分布的重叠部分φ

maxζ

高斯分布g

ζ

的最大几率值φ

maxξ

高斯分布g

ξ

的最大几率值m

maxζ

高斯分布g

ζ

的最大几率尺度m

maxξ

高斯分布g

ξ

的最大几率尺度σ

ζ

高斯分布g

ζ

的最大几率尺度的压缩值σ

ξ

高斯分布g

ξ

的最大几率尺度的压缩值初始化步骤二分割步骤数据交换步骤分类结束判断步骤概率空间获得步骤

具体实施方式

以下结合附图对本发明实施例做进一步详述,但本发明所述的实施例是说明性的,而不是限定性的。首先对本发明所需一些新的定义,以及新的概念,新的公式进行介绍自律学习sdl(self-discepline learning)模型设概率空间:【公式1】

存在一个初始的区域,这个区域的中心值以及以这个中心值所计算出的高斯分布的方差,作为初始的最大几率的尺度以为中心值,以概率尺度为基准进行如下的迭代:【公式2】【公式2】【公式2】其n次的迭代的结果,一定可以得到上述概率空间的一个接近母体的最大几率值最大几率尺度以及最大几率空间g

(n)

。由此构成自律学习 self-discepline learning(sdl)模型。sdl模型的迁移性与必然性:上述sdk模型不管初始区域在哪里,通过若干次迭代,必然可以迁移到最大几率的区域内收敛。概率空间:这里所述的概率空间(probability space):是基于苏联数学家andreykolmogorov的“概率论是以测度论为基础的”理论,所谓的概率空间就是一个总的测度为“1”的可测空间。按照这样的理论可以产生引理1:“概率空间中只存在一个高斯分布,因此欧几里德空间存在着无穷个概率空间。概率空间距离:衡量欧几里得空间的一点,到一个概率空间,或某一个概率空间到另一个概率空间之间的尺度。概率空间距离的计算方法:设特征向量v的特征值的概率空间的最大几率值及最大几率尺度与另一个特征向量w特征值的概率空间的最大几率值最大几率尺度以及在欧几里德空间里的特征向量的特征值则可以统一欧几里德空间与概率空间的距离g (v,w)可由下式算出。【公式3】【公式3】

下面提供一个打开深度学习的黑箱的方法。根据组合理论的公知超过40个要素的组合就是图灵机不可解的npc问题。根据这一公知,我们构建一个可以通过穷举得到全局最佳解的最小规模的神经网络。图1是最小规模神经网络构成示意图。如图1所示;i1,i2,i3,i4是输入信息,t1,t2,t3,...,t

16

是权值,既组合结果的数据集,o1,o2,o3,o4是输出信息。根据神经网络原理,则【公式4】【公式4】【公式4】【公式4】令则:则:则:则:如公式4所示;这是一个线性方程组,在输入信息等于输出信息时应该具有一个全局的最佳解。因此,系统在全局最佳解时是一个稳定系统,不存在黑箱问题。我们通过穷举的方法找到了唯一的一个全局最佳解,证明了公式1的正确性,同时根据概率梯度下降法sgd的原理,同样用穷举的方法求解sgd的解。发现这么简单的一个神经网络,sgd的局域最佳解的个数,是随着输入信息的不同呈现随机性。少的时候是几百个,多的时候就有可能达到两万多个。虽然偶尔遇到的输入信息,可以使sgd的解一直朝着全局最佳解挺进,直到获得全局最佳解。但是这种情况是及其偶然的。绝大多数由于sgd的解过于多,用sgd 的方法越过如此多的局域最佳解的山坡是极其困难的。因此,sgd方法的倡导者企图通过sgd获得全局最佳解是没有科学依据的,是一个非常错误的理论。我们打开深度学习的黑箱的目的是力图揭穿深度学习在图像识别,图像分类等领域中应用效果好的奥秘。我们又对各种不同的输入信息,并针对每一个输入信息,求出所有的sgd局部最佳解与深度学习的应用效果的对应值,进行 sgd的解与应用效果的关系的考察。图2是某输入信息所获的的所有sgd的解与应用效果的关系实例。如图2所示;从获得的第一个sgd的解,到最后5,187个sgd的解,与应用效果呈现随机性,而且有几倍的差别。由此可见,sgd的方法既不能保证一定可以获得全局的最佳解,也

不能保证sgd的解是深度学习的应用效果最好的解,因此,sgd方法是一个伪命题。神经网络的黑箱被打开后,通过大量的数据使我们彻底的认清了深度学习的机理:神经网络针对输入数据通过神经网络的组合所实现的函数映射可以把不同的特征向量的间隔放大到几百倍甚至几千倍,或者更高的程度。而且这种函数映射是随机函数的映射,微小的输入信息的差别会通过随机函数映射被映射到截然不同的数据集的结果,因此根据高斯分布的理论可以极大的降低不同类的数据集的数据出现误识别的几率。这对于图像分类,图像识别的精度的提高是很有利的。深度学习在应用效果上的突出成绩并不是由神经网络的结构或者权重的产生的形式决定的。而是由函数映射的形式决定的。函数映射是在独立的单一数据下映射的,因此特征向量间微小的差距就可以获得正确映射的结果,以及数据匹配的结果,这是深度学习获得超越传统识别精度的根源。为提高图像识别的精度,模仿深度学习,为了突出图像的个性化特征,可以通过各种模版对图像进行滤波,或直接用图像处理算法对被识别图像进行处理。以下以灰度值调整图像处理方法为例,介绍突出图像的个性化特征的处理方法,根据以往公开的各种方法,在本发明提供的基于sdl模型模拟深度学习的方法中的应用,都具有新颖性,都属于本发明的范围之内。图3是灰度变换图像处理方法。如图3的(a)是原图像中的任意3*3像素的原灰度值。如图3的(b)将 3*3像素的原灰度值中的最大灰度值与中心灰度值交换。如图3的(c)将3*3 像素的原灰度值中的最小灰度值与中心灰度值交换。如图3的(d)将3*3像素的原灰度值中的各个灰度值用sdl模型计算出最大概率值,将最大概率值与中心灰度值交换。仿照上述方法还可以将图3(a)的3*3像素的原灰度值的对角线,中心十字线的像素值用3*3像素的原灰度值中的最大灰度值,最小灰度值,用概率尺度自组织求出对大概率值代替。图4是强调边框信息的图像处理方法。如图4的(a)所示;将图像分别进行x方向和y方向的求导,然后再用图 4(a)的左右两个3*3格子中的常数,按照各个像素的对应,进行相乘的结果替换原像素的灰度值。同样,如图4的(b)所示;将图像分别进行x方向和y 方向的求导,然后再用图4(b)的左右两个3*3格子中的常数相乘的结果替换原像素的灰度值。图5是另一种强调边框信息的图像处理方法。同图4相同,如图5的(a)所示,把x方向求导结果用这个模版进行相乘,就可得到垂直边框滤波器的处理效果。如图5的(b)所示,把y方向求导结果用这个模版进行相乘,就可得到水平边框滤波器的处理效果。在图像识别时可以将一个图像变换成多张图像,可以构成各个特征向量的高斯分布,从而提高识别率,同时还可以提高图像的质量。这里特别是在图像识别时可以增加特征向量的数量,提高图像识别率。特别是可以将深度学习中经常使用的卷积神经网络的输出直接输入到sdl模型的输入层的节点上,作为一组新的特征值,它可提高特征向量的数量,增加不同类别图像的特征向量之间的间隔,增加数据集的规模,最终可以提高图像的分类精度,提高图像识别的精度。深度学习的主要卷积算法如下:

1.高斯卷积核【公式5】同每一个rgb颜色的图像的小区的像素对应,把处理结果累加再平均,可以滑动一个像素,也可以滑动两的,或三个等。2.roberts边缘检测【公式6】或3.prewitt边缘检测【公式7】或4.sobel边缘检测【公式8】或5.scharr边缘检测【公式9】

或6.laplacian算子【公式10】7.kirsch方向算子【公式11】计算8个方向的差分值,取其最大值作为最终输出的边缘强度,其对应的方向为边缘的方向。8.浮雕滤波器【公式12】滤除图像中的小区域噪声。9.边缘强化【公式13】10.平均滤波【公式14】

11.深度可分离卷积图12是深度可分离卷积示意图。如图12所示;同神经网络一样,在sdl模型中也可使用深度可分离卷积,将执行空间卷积,同时保持通道分离,然后进行深度卷积。以输入图像为 12x12x3的rgb图像为例,正常卷积是卷积核对3个通道同时做卷积。也就是说,3个通道,在一次卷积后,输出一个数。而深度可分离卷积分为两步:用三个卷积对三个通道分别做卷积,这样在一次卷积后,输出3个数。这输出的三个数,再通过一个1x1x3的卷积核(pointwise核),得到一个数据。所以深度可分离卷积其实是通过两次卷积实现的。第一步,对三个通道分别做卷积,输出三个通道的属性。第二步,用卷积核1x1x3对三个通道再次做卷积,得到一个特征值数据,这个时候的要对应64个特征值,即8x8x1。图13是在需要提取更多的特征时的深度可分离卷积示意图。如图13所示;在需要提取更多的特征时,就要设计更多的1x1x3卷积核(例如,将8x8x256那个立方体绘制成256个8x8x1,因为他们不是一体的,代表了256个属性)。在sdl模型里,在需要提取更多的特征时,对于深度可分离卷积的处理方法就是用卷积神经网络输出的结果,直接输入到sdl模型的输入层所对应的各个节点上就可。深度学习在2012年的image_net的图像分类中,以优异的成绩被世界关注。为了证明本发明提出的基于算法仿真深度学习,可以达到普通深度学习相同的能力,我们以image_net的图像分类为例,介绍用sdl函数高斯分布模型,再加上用算法模拟深度学习的函数映射模型,所构成的更加强大的一种新一代人工智能模型。图6是一种基于sdl模型仿真深度学习的构成示意图。如图6所示;(601)是输入层,主要担负着在输入层的各个节点上通过sdl 模型(611)接受图像信息(610),(602)是高斯层,主要担负将多次输入的同一类图像,通过机器学习(612)的训练,获得图像的特征值的高斯分布(613)。 (603)是函数映射层,主要担负通过sdl模型仿真深度学习,将高斯层得到的高斯分布的结果(613)映射到数据集(604)上。这里,图像信息(610)可以将图像分割成η个∈*δ像素小区域,每个小区域通过sdl模型求出该区域的最大几率值,输入到输入层的相应节点上。每个小区域的最大几率值构成了各自的特征值,这个图像的所有的小区域的最大几率值的特征值构成了这个图像的特征向量。在sdl模型里,在需要提取更多的特征时,同深度学习完全一样,用卷积的算法对图像的各个小区域进行处理,将处理结果输入到输入层的相应的节点上,对于深度分离卷积可以将卷积神经网络的输出直接作为sdl模型的输入,直接输入到输入层的相应节点上。下面我们用数学公式表述基于算法仿真深度学习的图像分类与图像识别的原理。设输入到输入层(601)的各节点的β个特征值所构成的α个图像的训练数据,这是在不同情况下获得的同一类训练集图像,或不同训练集中数据混在一起的不同类图像,例如image_net上的同类训练图像,或者是把不同类的图像混在一起,通过概率距离以及最大

概率尺度的特征向量分类的训练,将不同类特征向量的间隔拉开,以下简称训练图像,其表达式如下:【公式15】通过对公式(15)的训练,在每一组特征值可以由(公式1~2)得到γ个由β个最大几率特征值所构成的特征向量群:【公式16】这里:γ≤α,以及由(公式1~2)可以得到最大几率尺度的向量:【公式17】根据上述概率空间的定义,将每一个要素与m

maxi

(i=1,2,..,β),可构成特征向量的一组最大几率空间:【公式18】由(公式1~2)与m

maxi

就是计算概率空间 s

maxij

(i=1,2,..,γ,j=1,2,...,β)的常数。在γ个概率空间中有同类图像,也有不同类图像,但是,不同类图像的特征向量之间的的高斯分布间隔一定是被分离开了。深度学习与本发明提出的用算法仿真深度学习的新型sdl模型的区别是,深度学习只是把数据映射到数据集中,新型sdl模型是可以把不同类的图像的高斯分布的间隔分离开,并可以把高斯分布映射到数据集中,具有小数据训练大数据的效果的特点。为了提高识别精度,总是希望不同类的图像的最大几率特征值与的概率空间距离越远越好,通过函数映射可以解决这个问题。设映射函数可以满足如下的不等式:【公式19】

图7是另一种基于sdl模型仿真深度学习的构成示意图。如图7所示;(701)是输入层,主要担负着在输入层的各个节点上通过sdl 模型(711)接受图像特征信息(710),(703)是映射函数,主要担负把输入层输出的图像的特征信息映射到数据集层(704),(702)是高斯层,主要担负将数据集层(704)所得到的同一类训练图像(公式5)的数据集,通过概率尺度自组织(712)的训练,获得图像的特征值的最大几率的高斯分布。在输入不同类的图像时,通过概率尺度自组织(712)的训练,获得不同类的图像的特征值的最大几率高斯分布(公式18),在这种强况下,如果这两个不同类的图像的高斯分布有重合部分,要进行两个高斯分布的最大几率尺度值的压缩,最后得到可以表示压缩后的高斯分布(713)的最大几率值,以及最大几率尺度值,并送到高斯层(702)的各个节点上作为输出值。这里,图像信息(710)可以将图像分割成η个∈*δ像素小区域,每个小区域通过sdl模型求出该区域的最大几率值,输入到输入层的相应节点上。每个小区域的最大几率值构成了各自的特征值,这个图像的所有的小区域的最大几率值的特征值构成了这个图像的特征向量。还可以对图像整体直接进行特征抽出,把特征抽出的结果送到输入层的节点上。也可以通过深度学习常用的卷积算法(公式5~14)在图像的各个小区域里进行特征抽出,并把每一个小区域所抽出的特征作为一组特征值,与前面介绍的特征值一起构成新的特征向量。图8是映射函数的各种形式的示意图。可以是线性函数,如图8的(a)所示;(801)为由各个特征值构成的特征向量,(802)为被映射的结果,通过映射函数可以随意的把特征向量(801)的距离间隔加大,这就是通过模仿深度学习的映射函数,把信息输入后被映射到数据集层后特征向量的间隔被放大了效果。也可以是非线性的函数,如图8的(b)所示;(803)是由各个特征值构成的特征向量,(804)为被映射的结果,通过映射函数可以随意的把特征向量(803)映射成复杂的非线性的结果。通过模仿深度学习的激励函数,让被映射到数据集层后的特征向量产生非线性效果,已用于对应非线性的数据分类。还可以是随机函数,如图8的(c)所示;(805)为由各个特征值构成的特征向量,(806)为被映射的结果,通过映射函数可以随意的把特征向量(805)映射成复杂的随机函数的结果,这是特征向量中的各个特征值所构成的随机性的排列,可以模仿sgd与输入信息之间的随机关系。还可以是这三种函数中至少有两种函数构成的复合函数。如图8 的(d)所示;(807)为由各个特征值构成的特征向量,(808)为被映射的结果,通过映射函数可以随意的把特征向量(807)映射成复杂的既有随机的结果的效果,又有非线性的效果,这也是深度学习的函数映射结果的特点。不只是经典的线性函数,经典的非线性的函数,经典的随机函数,特别是按照深度学习的sdg求出的解的特点,考虑了深度学习对模式识别的精度的提高的作用,

结合人为介入的手法,综合的构造出来的映射函数。映射函数中有数理运算形式的成分,有隶属函数的成分,有规则构建成分等等,可满足综合性的函数映射模型。结合高斯分布的机理,从高斯层(602)或(702)的各个节点输出的由sdl 模型(612)或(712)被识别对象的训练数据求出的特征值的最大几率的高斯分布,在这个最大几率的高斯分布中的最大几率值的最大几率尺度范围内的所有数据,根据概率空间距离的公式(3)都应映射到同一个数据空间的同一个数据。也可以把高斯层(602)或(702)的各个节点输出的由sdl模型(612)或 (712)被识别对象的训练数据求出的特征值高斯分布的结果,看成是无穷的函数映射数据,直接通过映射函数映射到数据集层上,在判断识别结果上,再依据被放大的特征值高斯分布的结果,通过求概率空间的距离,以距离最近的数据集所对应的图像作为识别结果。图9是两个重叠的高斯分布的示意图。如图9所示;是两个不同类的图像所得到的两个高斯分布g

ζ

和g

ξ

,其重叠部分为ω,表示高斯分布分g

ζ

的最大几率值φ

maxζ

,和最大几率尺度值m

maxζ

,以及可以表示高斯分布分g

ξ

的最大几率值φ

maxξ

,最大几率尺度值m

maxξ

。传统的方法通过概率尺度自组织求出高斯分布分g

ζ

的最大几率值φ

maxζ

,最大几率尺度值 m

maxζ

后,通过计算样本数据的特征向量(公式18)与训练数据(公式15)的高斯分布g

ζ

的最小概率空间距离就可确定图像的识别结果。在这种情况下,要求不同的种类之间的图像的特征向量之间的距离尽可能大,这就需要在特征抽取的质量上,或者特征值的数量上下功夫,而现实中会受到一定的限制。函数映射模型不需要考虑不同类型图像的特征向量之间的距离的最大化问题,只要每一个被映射的不同类型的图像的特征向量数据必须要独立存在的。为此需要对不同种类的图像的特征向量的间隔做一些处理。如图9所示;两个不同类的图像的高斯分布的结果,出现有重合区域ω,这就意味着会有识别错误的可能,如果将最大几率尺度的范围的数据映射到数据集上,就有可能出现把不同类的图像分到一个类里面的错误结果。本发明提出将不同类的图像放在一起进行训练,针对出现图9的不同类的图像的高斯分布重合时,针对两个高斯分布的最大几率尺度值m

maxζ

和m

maxξ

要压缩σ

ζ

和σ

ξ

范围的值,可以得到压缩两个高斯分布最大几率尺度值的结果m’maxζ

和 m’maxξ

。用算法仿真深度学习时,是将高斯分布作为映射数据,具体就是将高斯分布的最大几率值,以及压缩后的最大几率尺度m

‘

maxζ

和m

‘

maxξ

作为映射数据的输出,在高斯分布的压缩后的最大几率尺度m’maxζ

和m’maxξ

的范围内的所有数据,是看做同一个数值的数据。也就是在高斯分布g

ζ

的最大几率区间φ

maxζ-m’maxζ

≤ sp

ζ

≤φ

maxζ

+m’maxζ

由于是最大几率区域,因此由公式(3)可以视为同一数值,因此在这个区间,无论高斯分布是什么值,都可作为同一个被映射的数值。同样在高斯分布g

ξ

的最大几率区间φ

maxξ-m’maxξ

≤sp

ξ

≤φ

maxξ

+m’maxξ

的处理方法同上述相同。如果完全仿真深度学习,利用大数据的标注数据进行训练,可以不通过高斯分布进行函数映射,直接从输入层601的各个节点输出的数据直接通过公式( 10)的映射函数将特征向量映射到大数据空间(604)。为了提升机器学习的泛化能力,可以把各种有利于在不同类的图像的特征向量之间扩大其距离,以便于区别不同类的图像。可以通过图3~5的模版,或利用卷积核(公式5~14,以及图12,图13)对图像进行特征向量的抽出的处理,或复数个特征抽出方法的组合一

起,进行图像的特征抽出。最后把处理结果作为新的特征值,输入到输入层(601,701)的节点上。下面针对image_net的图像分类问题,具体介绍本发明所提出的用算法仿真深度学习的方法。图10是image_net一个图像类的训练数据。如图10所示;这是一个金鱼类图像的训练数据,为了达到更加高的精度的图像分类效果,首先要通过人工的方法,把对象图像从背景中挖出来,比如图9 的对象图像是金鱼,所以就要通过人工的方法把金鱼图像挖出来。这也是由人为介入把什么是对象图像告诉给机器的过程。下面,是求被挖出图像的特征向量,可以把被挖出的对象图像的r,g,b ,或者lab中的a,b,或者其他颜色空间的颜色的各个灰度值,最大几率值,最大几率尺度,最大灰度值,最小灰度值等等的灰度信息,或通过对各个颜色求导得到的纹理信息等等,生成各种可以反应对象图像特征,并可以区分其他图像的特征向量的生成方法。如图10所示,针对对象图像即使都是金鱼,但是有不同的金鱼,因此还需要通过自律机器学习sdl聚类,将不同的金鱼按最大几率的概率空间进行分类,再有,把其他的类的数据集也都混合在一起,处理不同类的特征向量的间隔的分开,以便直接把每个特征值的高斯分布映射到数据集上或者直接输出。自律机器学习sdl聚类的算法如下:

传统的k-means聚类是以欧几里德距离为尺度进行聚类的,因此不能针对概率空间进行分类,而且要分多少类需要人为事先指定,不能求出最佳的最大几率的自律机器学习sdl聚类结果,不能实现在考虑目标函数映射的同时,还可以考虑目标函数的最大几率的高斯分布。图11是自律机器学习sdl模型聚类算法流程图。如图11所示;这是一个用算法仿真深度学习的聚类方法,其特点是数据训练不需要组合,没有黑箱问题,在函数映射与高斯分布的效果上自律的获得最佳的聚类结果,对于小间隔的不同类的特征向量也可以发挥目标函数的函数映射的特点,可以准确的获得识别结果,同时针对图10这类的image_net图像数据,在颜色以及纹理上都是差别很大的单一图像,如何发挥高斯分布模型的泛化能力,这个聚类算法就可以针对给定的训练数据,给定的特征向量的抽出结果,获得函数映射模型与高斯分布模型最佳的融合结果。如图11所示;具体自律机器学习sdl聚类步骤如下:step1初始化步骤:分别设立尚没聚类的数据库以及已经聚类的数据库最初把所有的参与聚类的训练数据的特征向量数据放入step2概率尺度自组织步骤:针对数据库中的所有数据按照特征向量之间的欧几里德距离进行概率尺度自组织迭代,得到一个可以表示最大概率高斯分布(最大概率空间)的常数,即最大的概率值φ

maxζ

(期望值),和最大概率尺度m

max

(方差)。把迭代中剔

除的数据放回数据库中再一次针对数据库中的所有数据,用运用概率尺度自组织迭代,得到另一个最大的概率值和最大概率尺度(方差)。也把迭代中剔除的数据放回数据库中step3产生两个类步骤:因为特征向量是高维数据,只根据欧几里德空间距离的聚类会陷入局域最佳解,所以要进行如下的处理。以最大概率值φ

max

为中心,以及最大概率尺度m

max

所表示的两个新得到的概率空间,与数据库中的所有数据用概率空间距离进行计算,在这两个概率空间中进行对抗,分别把两个最大概率尺度m

max

以内的数据作为最终的两个聚类结果存入数据库中。step4概率尺度修正步骤:针对新产生的两个高斯概率空间,还要同数据库中的不同训练集的数据的概率空间进行图9的压缩最大概率尺度的处理,把压缩后的一对概率分布数据作为函数映射数据集的结果存入数据库中,这样可以最大限度的发挥函数映射的高识别精度的作用,同时也可以最大限度的保留高斯分布的最大泛化能力的作用。step5聚类完成判断步骤:判断所有的向量数据是否全部获得聚类结果,“y”转下一个聚类结束步骤,“n”跳转step2概率尺度自组织步骤。step6聚类完成步骤。不管是图6所示的先进行针对输入到输入层各个节点上的特征值,通过sdl 模型计算出高斯分布值,然后再把不同类有重合的高斯分布的概率空间的最大概率尺度压缩映射到数据集上;还是如图7所示的先进行针对输入到输入层各个节点上的特征值,直接映射到数据集层上,再通过sdl模型计算出,数据集层各个节点上的高斯分布值,然后再把不同类有重合的高斯分布的概率空间的最大概率尺度压缩,最后再把最大几率值,最大几率尺度值作为sdl模型的输出值。深度学习的目标函数的映射机理是;专注于把映射数据的空间扩大,即通过复杂的神经网络的组合,得出的大数据的训练值,在不同分类的图像的特征向量之间,即使很小的距离,也可以正确的识别。由于每一个识别对象都要映射到数据集中,因此泛化能力很差,需要把对象图像的所有的状态通过大数据的标注才可以实际应用。高斯分布的机理是尽可能的扩大不同类的图像的特征向量之间的距离,用以提高图像的识别精度,可以通过小数据的训练,具有非常强的的泛化能力,但是通过提高特征值的抽出质量,尽可能的扩大图像的特征向量之间的距离是会遇到极限的问题。高斯分布具有可以举一反三的特点的同时,由于特征向量的质量不能保证不同类的图像的特征向量之间的距离足够大,会导致把不同的类的图像或出现在同一个概率空间中,通过细致的将高斯分布的最大几率尺度值进行压缩,将不同图像的特征向量之间的间隔拉开,把压缩后的最大几率的高斯分布结果映射到大数据空间层,即输出层。这样既可以得到目标函数映射的效果,同时又具有小数据的目标函数概率分布的特点。上述分类结果所产生的各个最大几率的概率空间,在函数映射层(603)通过映射函数把数据映射到数据集(604)中。为了更高精度的进行图像分类,针对imagenet的训练数据集,以及测试数据集,还要考虑对象图像的轮廓信息的利用,可以对图像轮廓进行抽出,并用从8个方向进行求导,并按照抽出的轮廓,将不同方向的最大密度的导数值的位置进行连接,把链接的方向,长度

的高斯分布结果作为结构化的特征向量,以求得更加精准的对于图像的分类,以防止由于背景的噪声图像影响图像分类的的精度。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1