一种用于智能面试的行为礼仪维度评价方法及装置与流程

1.本发明属于数据分析技术领域,涉及对图像、音频的特征提取和分析,用于对人物进行特征画像提取和建模分析,为一种用于智能面试的行为礼仪维度评价方法及装置。

背景技术:

2.传统主流的面试方式是面试官和面试者在同一时空内面对面交流的现场面试。但是由于时间和距离的限制颇多,出现了通过电话去进行远程面试,但面试官和面试者无法看到对方的脸,这不仅影响双方的面试体验,还存在着难以进行信息记录和快速有效传递内容等困扰。在互联网的飞速发展下,慢慢衍生出了数字化面试,这很好地解决了以上问题,但是在极具多样性和复杂性的市场需求中,大量依赖人力的人工面试效率低下,且易受到面试官主观因素的干扰。

3.一般的视频面试由企业根据自身招人需求定制化自己的面试问题,面试者通过远程面试软件等方式回答问题。代表产品有视频面试软件hirevue,面试软件系统会对答案进行粗略分析,同时企业也会对面试信息进行人工审核,从而综合判断面试者是否通过面试。虽然这样的视频面试打破了时空的限制,提高了面试效率,但是这种面试过程中不仅仍然需要大量的人工参与,只是部分工作的自动化,且人工审核时带有极大的主观性,不能保证对面试者给出客观评价,尤其是在对面试者的行为礼仪这类人物行为特征的识别上,往往由于面试官的经验、观察不足,或者面试者采取的一些技巧等因素,导致面试官对面试者的行为特征评估带有随机性,难以客观准确地全面评估面试者的行为礼仪能力。

技术实现要素:

4.本发明要解决的问题是:现有的线上视频面试中需要大量人力对面试者评估筛选,效率不高,同时对于面试中的任务行为特征的判断,易受到面试官主观因素的影响,难以准确评估面试者行为礼仪能力;需要一种能够快速自动全面观察面试者行为特征并对行为进行客观评估的方案。

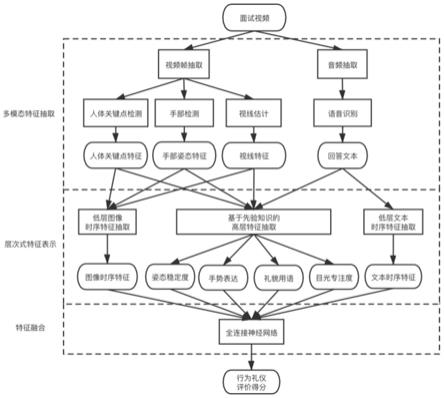

5.本发明的技术方案为:一种用于智能面试的行为礼仪维度评价方法,获得面试视频的视频帧及音频数据,

6.首先进行多模态低层特征抽取:基于函数计算部署配置多个深度学习模块,并行地对视频帧基于深度学习进行视频图像特征提取,获取面试者的身体姿态特征、手部姿态特征和目光视线特征,同时对音频数据获取语言表达信息,包括回答文本、用词、语速、语调和音量;

7.利用先验知识从多模态低层特征中抽取高层语义特征,高层语义特征包括面试者的姿态稳定度、手势表达、目光专注度和礼貌用语;同时对视频图像特征和回答文本进行时序分析,获得面试者的视频时序特征和回答时序特征,高层语义特征和时序特征组成面试视频的多模态层次式特征;

8.利用多模态层次式特征训练神经网络拟合模型,得到行为礼仪等级分类器,训练

好的神经网络拟合模型用于对新的面试视频进行行为礼仪维度评价。

9.本发明还提供一种用于智能面试的行为礼仪维度评价装置,配置有数据处理模块,数据处理模块的输入为面试者面试视频,输出为行为礼仪维度评价信息,输出为行为礼仪维度评价信息,数据处理模块中配置有神经网络拟合模型,神经网络拟合模型由上述方法训练得到,并执行所述评价方法。

10.本发明针对在线ai面试的实际应用场景,研究了对面试者行为礼仪的智能化自动化检测和计算的技术。本发明灵活的组合使用了多种深度学习算法技术,成功解决了在线面试中对面试者行为礼仪自动评测的实际问题,一方面结合了视觉信息和音频信息,提供了多模态的准确高效的评价能力,能够以相对实时的速度准确检测和计算面试者在面试视频中的表现;另一方面又充分发挥了面试领域的先验知识,相比纯粹的机器学习特征提取,我们添加了由面试领域的经验知识得到的高层语义特征加权计算方案,提高了算法模型的可解释性,更能适应实际面试中的打分场景,且拥有优异的表现。由于采用了轻量级的深度学习算法模型,并且使用了函数计算方式部署模型,使整个系统能够快速并行计算大量数据,实现了快速并准确的行为礼仪评价功能。

11.本发明的有益效果是:提出了一种用于智能面试的行为礼仪维度评价方法及装置,通过自动化流程和深度学习技术,对面试视频提取多模态、层次式特征来产生对面试者行为礼仪的综合评价。第一,现有的智能评价方法大多仅依赖底层感知特征,本发明所提出的层次式特征综合了底层感知特征和高层认知特征,能够为面试者行为礼仪形成更加完整的表征;第二,现有智能评价方法大多仅依赖与对静态视频帧的分析,本发明利用lstm网络进一步抽取时序特征,以此捕捉面试者在面试过程中的动态行为信息;第三,现有智能评价方法大多仅利用图像或语音一种模态的信息进行分析,本发明通过对图像、音频双通道特征提取,产生多模态特征表示,使其能够具备理解多源信息的能力;第四,现有智能评价方法大多仅使用单个深度学习模型进行特征提取,本发明使用分布式函数计算服务搭建系统,使本发明能够使用多个深度学习模型进行多种特征提取,使系统具备良好的性能和可扩展性。本发明实现的基于层次式特征提取、多模态特征融合的行为礼仪评价方法能够捕捉到面试者更全面的信息,有助于产生更加客观的评价供面试官进行进一步判断,有效降低面试的时间成本,减少主观因素对面试的影响,同时提升了评估效率和质量,具有良好的实用性。

附图说明

12.图1为本发明的实施流程图。

13.图2为本发明的视频时序特征训练的结构图。

14.图3为本发明的回答文本时序特征训练的结构图。

15.图4为本发明的最终评分分类神经网络结构图。

具体实施方式

16.本发明提出了一种用于智能面试的行为礼仪维度评价方法,如图1所示。通过线上面试收集面试者的面试视频,从中抽取数帧获取图像数据组,同时抽取音频数据,一般面试视频要求正对摄像头,不要求全身,部分面试视频,例如要求表演舞蹈等可不正向面对摄像

头,由面试需求而定。首先进行多模态低层特征抽取,将图像输入分布式部署在函数计算上的各个基于深度学习的图像特征抽取模块,获取面试者的低层视觉相关特征;同时将音频数据输入基于自然语言处理技术的音频处理模块,获取面试者在面试过程中的语言表达方面的低层信息。在得到低层特征后,进行多模态层次式特征提取,通过先验知识计算出面试者的高层语义特征,同时对视频特征和回答文本进行时序分析,获得面试者的视频时序特征和回答文本时序特征。最后训练神经网络模型对多模态时序特征、高层语义特征进行拟合,自动分析获得该面试者的行为礼仪总体评价。

17.下面结合本发明实施例及附图,对本发明实例中的技术方案进行清楚、完整地描述,所描述的实例仅仅是本发明的一部分实例,而不是全部的实例。基于本发明的实例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实例,都属于本发明的保护范围。

18.本发明的具体实施包括以下步骤:

19.1.将视频预处理得到图像和音频数据。对输入的视频进行抽帧,每k帧抽取一帧得到视频帧的图像数据组,本实施例从视频里每10帧中取最后一帧,直到抽完视频所有帧;音频数据的处理方法为使用ffmpeg从面试视频提取音频。

20.2.基于事件驱动的全托管式函数计算服务,部署配置多个深度学习模块,将图像数据输入所有特征检测模型,并行地将视频帧输入深度学习模块进行感知特征抽取得到低层特征,包括面试者的身体姿态特征、手部姿态特征和目光视线特征。在图像特征检测中涉及到使用人脸检测的部分,都先用ultra

‑

ligh

‑

fast

‑

generic

‑

face

‑

detector轻量级人脸检测模型检测面试者人脸框。各个特征检测模型都部署在函数计算服务上并行计算。各低层特征检测方式为:

21.1)通过人体关键点检测技术检测人体关键点,得到身体姿态特征。

22.对于输入的每一帧图像,输入posenet模型,得到鼻子、左右眼、左右耳、左右肩、左右手肘、左右手腕、左右膝盖、左右臀、左右脚踝,共17个关键点的位置和置信度,每一个点的格式为(x,y,p),其中x、y是该点坐标,为不超过图像边界的正整数,p是该点的置信度,范围为[0,1],人体关键点只有帧级特征。

[0023]

2)通过手部检测技术获得面试者手部位置框和手腕位置信息,得到手部姿态特征。

[0024]

手部位置检测:对于输入的每一帧图像,输入手部检测模型中,得到双手的位置和手腕的位置,每一只手的输出格式为(x1,y1,x2,y2,xw,yw),其中x1,y1是手部左上角坐标,x2,y2是右下角坐标,xw,yw是手腕的坐标,当无法检测到手部时,输出6个空值。

[0025]

3)通过视线检测技术检测面试者的双眼视线俯仰角和偏航角,得到目光视线特征。

[0026]

对于输入的每一帧图像,将人脸输入到mippigaze模型中,得到双眼各自的俯仰角和偏航角,范围均为[

‑

90

°

,90

°

]。

[0027]

4)音频特征:通过语音识别技术,如vosk模型、pydub模型或snownlp模型,获得面试者的回答信息,包括停顿时间、停顿次数、思考时间、回答时间、停顿比值、回答文本长度、语速、各类词语各自的频次、总词汇量、音量等信息,各类词语包括关联词、语气词、停顿词、问候语、感谢语。得到各个词汇的格式为[内容,开始时间,结束时间,置信度]组成的列表。

回答文本由抽取的音频词汇列表按照开始和结束时间顺序拼接而得。

[0028]

3.将上视频帧和音频抽取的低层特征通过先验知识处理并加权计算得到高层语义特征,其处理过程为:

[0029]

1)姿态稳定度:由面试者图像特征中的身体的姿态和动作的特征进行统计分析而得,为一个浮点数。根据所抽取的视频帧中相邻两帧的左肩和右肩移动距离是否出现晃动现象,对晃动次数做非线性归一化计算姿态稳定性得分。

[0030]

晃动判定:左右肩分别计算晃动情况,计算公式为:

[0031]

dist

h

=sqrt[(x

i

‑

x

i

‑

1)^2+(y

i

‑

y

i

‑

1)^2]

[0032]

若某一帧至少其中一肩的晃动dist

h

大于阈值,则判定为出现晃动现象,统计所有抽取的帧中的晃动次数,非线性归一化公式如下:

[0033][0034]

其中x

i

,y

i

是抽取的第i帧的肩部坐标,sqrt是对数据开根号,mean是计算均值,std是计算方差,atan是计算反三角函数arctan的值,f是每一帧特征数据构成的列表,在姿态稳定度中,为视频帧身体姿态特征的列表,例如左肩特征列表f=[帧1左肩位置,帧2左肩位置......]。

[0035]

2)手势表达:由面试者图像特征中的手部位置检测进行统计分析而得,为一个浮点数。先排除无法检测到手部的帧,在剩下的帧内根据手腕位置相对于手部区域范围的位置,若手腕在相对手部中心位置的下部则判断为有手势,对手势次数做非线性归一化计算手势频率,非线性归一化公式同姿态稳定度,此时f为各视频帧手势特征的列表。

[0036]

3)目光专注度:由面试者图像特征中的双眼视线俯仰角和偏航角特征进行统计分析而得,为一个浮点数。根据相邻两帧的目光角度偏转角度计算是否出现乱瞟现象,对乱瞟次数做非线性归一化计算视线稳定性得分。

[0037]

乱瞟判定:对左右眼分别计算每一帧视线偏离角度,公式计算如下

[0038]

dist

p

=sqrt[(pitch

i

‑

pitch

i

‑1)^2+(yaw

i

‑

yaw

i

‑1)^2]

[0039]

其中pitch

i

和yaw

i

分别是抽取的第i帧的视线俯仰角和偏航角,sqrt是对数据开根号。若某一帧中至少一只眼视线的偏移dist

p

大于阈值,则计算出现乱瞟现象一次,统计所有帧的乱瞟总次数,非线性归一化公式同姿态稳定度。

[0040]

4)礼貌用语:由面试者音频特征中的问候语和感谢词的次数数据加权计算而得,加权公式为:

[0041]

score=w1

×

greetings+w2

×

thanks

[0042]

其中w

i

是权重,greetings表示问候语的次数,thanks表示感谢语的次数

[0043]

4.将视频低层特征输入到lstm时序分析模块,其结构见附图2,说明如下:

[0044]

1)网络输入:输入层为前述帧级原始特征,包括手部的6个坐标位置,双眼视线的4个角度,人体关键点的17个关键点的位置(x和y)和置信度,共61维相连接而得。所有特征列都要进行标准化,公式为:

[0045]

norm(x)=(x

‑

mean(x))/std(x)

[0046]

其中x为一类特征的具体实例值,mean(x)表示该类特征在所有训练样本上的均值,std(x)表示该类特征在所有训练样本上的方差

[0047]

2)网络设置:lstm隐藏层设置64个长期状态单元64个输出单元,最长限制为256个时序数据。

[0048]

3)训练方案:将最后一个时序输出单元的64维向量并入第6步中的神经网络进行端对端的训练。

[0049]

5.将音频回答文本输入到lstm时序分析模块,其结构见附图3,训练过程为:

[0050]

1)网络输入:输入层为回答文本进行词嵌入后的张量,使用bert模型对文本的每个字进行词嵌入,得到bert模型最后一层的768维张量作为词向量。

[0051]

2)网络设置:lstm隐藏层设置256个长期状态单元和64个输出单元,最长限制为512个时序数据

[0052]

3)训练方案:将最后一个时序输出单元的64维向量并入第6步中的神经网络进行端对端的训练。

[0053]

6.将计算的到的视频和回答文本时序特征和高层抽象特征输入神经网络学习得到行为礼仪分类器,其网络结构见附图4,训练过程为:

[0054]

1)标签处理:根据历史数据中各个面试者的行为礼仪得分高低,将行为礼仪分为5类等级(下、中下、中、中上、上)。

[0055]

2)网络输入:输入层为前述视频时序特征(64维向量)、回答文本时序特征(64维向量)和高层语义特征(4个)相连接而得,所有特征列都要进行标准化,公式同视频时序特征里的标准化方法;

[0056]

3)网络隐藏层:使用3层全连接神经网络模型进行拟合训练,两层隐藏层各有1024个单元,激活函数为relu,输出层有5个输出值,使用softmax激活,分别代表5类行为礼仪的置信度。

[0057]

4)全连接神经网络模型训练过程及参数:

[0058]

[1]训练采用小批量训练法,batchsize=64;

[0059]

[2]迭代次数epoch=300;

[0060]

[3]多阶段学习率调整,初始学习率lr=0.001,milestones=[120,180,240],调整率为每次调整为当前学习率的2/10,即乘以gamma=0.2;

[0061]

[4]采用动量优化法,momentum=0.9;

[0062]

[5]采用权重衰减缓解过拟合,weight decay=2e

‑

3;

[0063]

[6]损失函数使用cross entropy loss交叉熵误差;

[0064]

[7]梯度反向传播方法为:sgd随机梯度下降。

[0065]

7.在对新面试视频计算行为礼仪评价时,将面试视频计算得到的高层抽象特征、视频和音频时序特征按照训练网络时的标准化方式进行标准化后,连接并输入神经网络,计算得到该面试者的最终行为礼仪得分。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1