一种基于内容分类的营销文本短句生成方法与流程

1.本发明属于文本处理技术领域,具体来说是一种基于内容分类的营销文本短句生成方法。

背景技术:

2.目前传统人工方式撰写营销文本,耗时耗力、效率低下;同时营销文本还需要针对不同客群和产品进行扩写、风格迁移,人工撰写方式存在创作瓶颈。因此,亟需一种可以快速自动根据营销对象生成相匹配的营销文本和营销短句的方法。

技术实现要素:

3.1.发明要解决的技术问题

4.本发明的目的在于解决现有的营销文本和营销短句需要人为撰写,效率低下的问题。

5.2.技术方案

6.为达到上述目的,本发明提供的技术方案为:

7.本发明的一种基于内容分类的营销文本短句生成方法,具体包括如下步骤:

8.s100、获取关键字,基于给定的句子内容使用ner技术,提取客群、产品名、产品特性及其它实体关键字;

9.s200、预处理,对步骤s100获取的实体关键字进行拼接处理;

10.s300、初始化,使用berttokenizer对拼接后内容进行tokenizer初始化;

11.s400、建模,建立自回归生成式预训练语言模型;

12.s500、模型训练,将步骤s300中的tokenizer初始化后的embedding输送到自回归生成式预训练语言模型;

13.s600、文本短句生成,通过自回归生成式预训练语言模型进行对应客群产品的营销文本短句生成。

14.优选的,所述步骤s100还包括采用bert+crf模型结构,对给定句子内容进行命名实体识别,提取出客群、产品名、产品特性及其它相关实体关键字。

15.优选的,所述步骤s200对关键字进行拼接处理具体为将客群、产品名、产品特性及其它相关实体关键字全部拼接成一段文本。

16.优选的,所述步骤s300拼接后内容进行tokenizer初始化具体为对拼接后内容进行中文分词和词语向量化处理。

17.优选的,所述步骤s500中的模型训练包括如下步骤:

18.s510、大规模营销文本清洗转换处理;

19.s520、基于清洗转换处理后大规模营销文本,进行营销领域的自回归生成式预训练语言模型;

20.s530、营销文本短句生成任务语料预处理;

21.s540、基于营销领域的自回归生成式预训练语言模型,进行营销文本短句生成任务微调训练。

22.优选的,所述步骤s510的清洗具体为删除无意义的标点符号并对长文本进行段落切分。

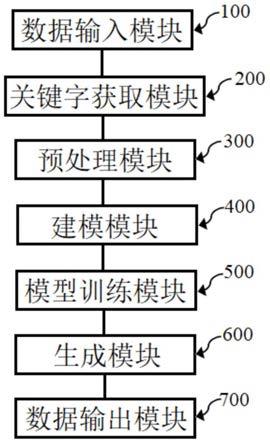

23.一种基于内容分类的营销文本短句生成系统,用于实现上述所述的方法,包括

24.数据输入模块,所述数据输入模块用于向系统输入相关的句子内容;

25.关键字获取模块,所述关键字获取模块用于从输入相关的句子内容中提取客群、产品名、产品特性及其它实体关键字;

26.预处理模块,所述预处理模块用于对关键字获取模块获取的实体关键字进行拼接处理;

27.建模模块,所述建模模块用于建立自回归生成式预训练语言模型;

28.模型训练模块,所述模型训练模块用于获取预处理模块处理后的数据并进行初始化后输送到自回归生成式预训练语言模型进行训练;

29.生成模块,所述生成模块用于根据训练好的模型进行对应客群产品的营销文本短句生成;

30.数据输出模块,所述数据输出模块用于将生成模块生成的营销文本短句输出。

31.优选的,所述模型训练模块还包括大规模营销文本清洗转换处理;基于清洗转换处理后大规模营销文本,进行营销领域的自回归生成式预训练语言模型;营销文本短句生成任务语料预处理;基于营销领域的自回归生成式预训练语言模型,进行营销文本短句生成任务微调训练。

32.3.有益效果

33.采用本发明提供的技术方案,与现有技术相比,具有如下有益效果:

34.本发明的一种基于内容分类的营销文本短句生成方法,具体包括如下步骤:s100、获取关键字,基于给定的句子内容使用ner技术,提取客群、产品名、产品特性及其它实体关键字;s200、预处理,对步骤s100获取的实体关键字进行拼接处理;s300、初始化,使用berttokenizer对拼接后内容进行tokenizer初始化;s400、建模,建立自回归生成式预训练语言模型;s500、模型训练,将步骤s300中的tokenizer初始化后的embedding输送到自回归生成式预训练语言模型;s600、文本短句生成,通过自回归生成式预训练语言模型进行对应客群产品的营销文本短句生成,通过对给定营销句子内容进行提取,获取实体关键字,建立自回归生成式预训练语言模型并对模型训练,使得训练好的模型可以根据实体关键字进行对应客群产品的营销文本短句生成,相对于传统的人工去进行营销文本短句的撰写,更加方便迅速。

附图说明

35.图1为本发明的一种基于内容分类的营销文本短句生成系统的结构示意图;

36.图2为本发明的一种基于内容分类的营销文本短句生成方法的流程图。

37.示意图中的标号说明:

38.100、数据输入模块;200、关键字获取模块;300、预处理模块;400、建模模块;500、模型训练模块;600、生成模块;700、数据输出模块。

具体实施方式

39.为了便于理解本发明,下面将参照相关附图对本发明进行更全面的描述,附图中给出了本发明的若干实施例,但是,本发明可以以许多不同的形式来实现,并不限于本文所描述的实施例,相反地,提供这些实施例的目的是使对本发明的公开内容更加透彻全面。

40.需要说明的是,当元件被称为“固设于”另一个元件,它可以直接在另一个元件上或者也可以存在居中的元件;当一个元件被认为是“连接”另一个元件,它可以是直接连接到另一个元件或者可能同时存在居中元件;本文所使用的术语“垂直的”、“水平的”、“左”、“右”以及类似的表述只是为了说明的目的。

41.除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的技术人员通常理解的含义相同;本文中在本发明的说明书中所使用的术语只是为了描述具体的实施例的目的,不是旨在于限制本发明;本文所使用的术语“及/或”包括一个或多个相关的所列项目的任意的和所有的组合。

42.实施例1

43.参照图1、图2,本实施例的一种基于内容分类的营销文本短句生成方法,具体包括如下步骤:

44.s100、获取关键字,基于给定的句子内容使用ner技术,提取客群、产品名、产品特性及其它实体关键字;

45.s200、预处理,对步骤s100获取的实体关键字进行拼接处理;

46.s300、初始化,使用berttokenizer对拼接后内容进行tokenizer初始化;

47.s400、建模,建立自回归生成式预训练语言模型;

48.s500、模型训练,将步骤s300中的tokenizer初始化后的embedding输送到自回归生成式预训练语言模型;

49.s600、文本短句生成,通过自回归生成式预训练语言模型进行对应客群产品的营销文本短句生成。

50.具体的,所述步骤s100还包括采用bert+crf模型结构,对给定句子内容进行命名实体识别,提取出客群、产品名、产品特性及其它相关实体关键字。

51.步骤s200对关键字进行拼接处理具体为将客群、产品名、产品特性及其它相关实体关键字全部拼接成一段文本。

52.所述步骤s300拼接后内容进行tokenizer初始化具体为对拼接后内容进行中文分词和词语向量化处理。

53.所述步骤s500中的模型训练包括如下步骤:

54.s510、大规模营销文本清洗转换处理;

55.s520、基于清洗转换处理后大规模营销文本,进行营销领域的自回归生成式预训练语言模型;

56.s530、营销文本短句生成任务语料预处理;

57.s540、基于营销领域的自回归生成式预训练语言模型,进行营销文本短句生成任务微调训练。

58.所述步骤s510的清洗具体为删除无意义的标点符号并对长文本进行段落切分。

59.本实施例的营销文本短句生成方法,通过对给定营销句子内容进行提取,获取实

体关键字,建立自回归生成式预训练语言模型并对模型训练,使得训练好的模型可以根据实体关键字进行对应客群产品的营销文本短句生成,相对于传统的人工去进行营销文本短句的撰写,更加方便迅速。

60.一种基于内容分类的营销文本短句生成系统,包括

61.数据输入模块100,所述数据输入模块100用于向系统输入相关的句子内容;

62.关键字获取模块200,所述关键字获取模块200用于从输入相关的句子内容中提取客群、产品名、产品特性及其它实体关键字;

63.预处理模块300,所述预处理模块300用于对关键字获取模块200获取的实体关键字进行拼接处理;

64.建模模块400,所述建模模块400用于建立自回归生成式预训练语言模型;

65.模型训练模块500,所述模型训练模块500用于获取预处理模块300处理后的数据并进行初始化后输送到自回归生成式预训练语言模型进行训练;

66.生成模块600,所述生成模块600用于根据训练好的模型进行对应客群产品的营销文本短句生成;

67.数据输出模块700,所述数据输出模块700用于将生成模块600生成的营销文本短句输出。

68.具体的,所述模型训练模块500还包括大规模营销文本清洗转换处理;基于清洗转换处理后大规模营销文本,进行营销领域的自回归生成式预训练语言模型;营销文本短句生成任务语料预处理;基于营销领域的自回归生成式预训练语言模型,进行营销文本短句生成任务微调训练。

69.以上所述实施例仅表达了本发明的某种实施方式,其描述较为具体和详细,但并不能因此而理解为对本发明专利范围的限制;应当指出的是,对于本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变形和改进,这些都属于本发明的保护范围;因此,本发明专利的保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1