红外图像的超分辨率的处理方法及系统

1.本发明总体上涉及图像处理,且尤其涉及从低分辨率(lr)图像生成高分辨率(hr)图像。

背景技术:

2.红外(ir)图像是感测从给定目标表面发射或反射的处于电磁谱的红外带宽(约0.72至12微米)的电磁辐射的结果。经由当前ir未制冷技术生成的图像有低分辨率的问题,因此降低了这些lr图像的有用性。

3.超分辨率(super-resolution)(sr)成像是增强(增加)成像系统的分辨率的一类技术,例如,从一个或更多个低分辨率输入图像恢复或生成高分辨率图像。

4.彩色数字图像由像素(通常由4个红色像素、绿色类型1像素和绿色类型2像素以及蓝色像素的簇组成彩色像素),使得像素由一系列代码(数值)表示的原色的组合制成。每种颜色被称为通道。例如,来自标准数码相机的图像将具有红色通道、绿色通道和蓝色通道(rgb)。灰度图像仅具有一个通道。yuv图像是源自广播的rgb颜色空间的仿射变换。y通道大致与感知强度相关,而u通道和v通道提供颜色信息。

技术实现要素:

5.根据本实施例的教导,提供了一种用于使用用于低功率设备的深度神经网络方法从低分辨率图像生成高分辨率图像的方法。本实施例通常可以用人工神经网络(ann)来实现,更具体地,可以用卷积神经网络(cnn)来实现。实施例包括使用低功率设备生成超分辨率(sr)图像以增强早期检测的能力(例如在农业中用于表型识别、灌溉监测和植物中疾病的早期检测)。

6.分辨率可以取决于应用,例如,lr可以小于160

×

120像素(19600像素),并且高分辨率(hr)和超分辨率(sr)可以是640

×

480(307200像素)或更多。

7.一些方法基于深度学习,其中许多计算在低分辨率(lr)域中完成。每个层的结果聚集在一起,以允许信息通过网络更好的流动。

8.实施例使用具有大约200k乘加计算(mac)的深度可分离卷积来实现结果,而基于现在的卷积神经网络(cnn)的sr算法需要大约1500k mac(1500kmac)。因此,实施例例如通过增加功率效率(减少功率使用、成本)和增加计算速度(减少运行时间)来改善计算设备的功能。例如,实施例还改善了估计的度量(例如,峰值信噪比psnr、结构相似性指数测量ssim)。与传统实施方式相比,实施例结合了提高的质量和较低的复杂性,因此实施例可以在低功率设备上实现。结果,展示了用于图像的新的深度学习sr方案。

9.该方法是可操作的,例如,实施例已经成功地用于真实的农业图像。为了在本描述中清楚起见,使用处理红外(ir)图像的非限制性示例。

10.实施例提供了仅使用单个ir图像来执行sr的方法,同时平衡超分辨率图像(指定的i

sr

)的度量质量与由ir相机的硬件提出的低功率要求。本发明的计算复杂度明显低于类

似的网络。

11.在一些实施例中,网络(神经网络)使用来自kim等人(2016)[12]的瓶颈层与tong等人(2017)[19]的密集残差连接以保持深度网络的高质量性能,仅具有一小部分递归计算能力。可以对lr空间执行本发明的计算以节省计算成本,并且可以例如使用来自shi等人2016)[17]的技术来完成对hr的放大(upscale,也被称为升级,升尺寸)。结果表明,只有少数残差连接就足够了。为了进一步降低计算复杂度,可以使用例如来自chollet(2017)[6]的深度可分离卷积。

[0012]

根据本实施例的教导,提供了一种用于图像处理的系统,所述系统包括:处理系统,所述处理系统包括一个或更多个处理器,以及人工神经网络,所述人工神经网络包括:输入层,所述输入层包括用于存储输入图像的存储位置,一个或更多个卷积层,其中,所述输入层连接到所述卷积层的第一卷积层,以及输出层,所述输出层连接到所述卷积层的最后卷积层并且包括用于存储输出图像的存储位置,其中,所述层包括用于在所述处理系统上执行的指令,所述输入图像输入到所述输入层以及所述卷积层中的至少一个卷积层,所述输入层的初始输出输入到所述卷积层中的至少一个卷积层,并且所述卷积层中的至少一个卷积层的层输出输入到至少一个后续的卷积层。

[0013]

在可选实施例中,所述处理器被配置为执行使用预定的一组机器代码编程的指令,并且所述层包括在所述处理器的所述机器代码中实现的计算指令。

[0014]

在另一可选实施例中,所述输入图像是低分辨率图像,并且所述输出图像是超分辨率图像。

[0015]

在另一可选实施例中,所述卷积层中的至少一个卷积层中的每个卷积层包括:相应的卷积模块,所述相应的卷积模块接收至相应的卷积层的数据,相应的激活函数,所述相应的激活函数处理来自所述相应的卷积模块的输出数据,相应的瓶颈层,所述相应的瓶颈层处理来自所述相应激活函数的输出数据。

[0016]

在另一可选实施例中,所述输入图像和所述初始输出输入到所述瓶颈层,并且所述瓶颈层生成所述层输出。

[0017]

在另一可选实施例中,所述输入图像输入到所述卷积层中的每个卷积层。在另一可选实施例中,所述初始输出输入到所述卷积层中的每个卷积层。在另一可选实施例中,层输出输入到每个后续的卷积层。

[0018]

在另一可选实施例中,输出层包括:混洗块,所述混洗块接收所述最后卷积层的所述层输出和所述输入图像,并生成比所述输入图像和所述层输出的分辨率高的分辨率的混洗块输出,插值模块,所述插值模块接收所述输入图像并生成比所述输入图像的分辨率高的分辨率的插值图像,以及最终卷积,所述最终卷积接收所述混洗块输出和所述插值图像并生成所述输出图像。

[0019]

在另一可选实施例中,所述网络用基于高分辨率图像和对应的低分辨率图像的训练集来训练。

[0020]

根据本实施例的教导,提供了一种训练根据权利要求1所述的网络的方法,所述方法包括以下步骤:接收一组或更多组高分辨率图像,将一个或更多个变换应用于所述一组或更多组高分辨率图像中的至少一个子组以生成关联的至少一组的低分辨率图像,创建包括所述一组或更多组高分辨率图像和所述关联的至少一组的低分辨率图像的训练集,以及

使用所述训练集训练所述网络。

[0021]

根据本实施例的教导,提供了一种用于图像处理的方法,所述方法包括以下步骤:基于高分辨率图像和对应的低分辨率图像的训练集来配置人工神经网络;将输入图像输入到输入层和至少一个卷积层;基于所述输入图像从所述输入层生成初始输出,并且将所述初始输出至少发送到所述卷积层中的第一卷积层;基于所述输入图像、所述初始输出和任何先前层输出生成所述卷积层中的至少一个卷积层的当前层输出,并且将所述当前层输出发送到至少一个后续的卷积层;以及基于所述卷积层的最后卷积层的所述层输出与所述输入图像,由输出层生成输出图像。

[0022]

根据本实施例的教导,提供了一种计算机可用的非暂时性存储介质,所述非暂时性存储介质具有在其上实现的计算机程序,以用于当在系统上执行该程序时,通过执行根据权利要求12所述的步骤来使适当编程的所述系统处理图像。

附图说明

[0023]

在此参照附图仅以示例的方式描述了本发明的一些实施例。具体地详细参照附图,强调的是,所示的细节是作为示例的,并且出于对本发明的实施例的说明性讨论的目的。在这点上,结合附图所作的描述使得本领域技术人员清楚了可以如何实施本发明的实施例。

[0024]

现在注意附图,其中同样的附图标号或字符指示相应的或同样的组件。在附图中:

[0025]

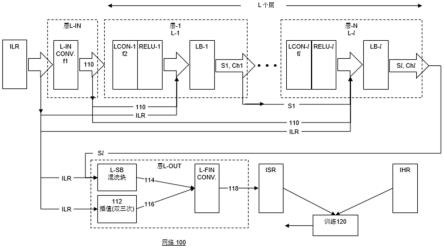

图1是可以用于实现本发明的实施例的卷积神经网络的示意图。

[0026]

图2是混洗块的示意图。

[0027]

图3a至图3d是示出最终层输出过程的照片。

[0028]

图4和图5是sr结果的图像。

[0029]

图6是放大的示例。

[0030]

图7是被配置为实现网络的示例性系统的高级部分框图。

[0031]

图8a至图8d是不同数据集的实验结果的表格。

[0032]

图9是实施例的调制传递函数(mtf)的结果。

[0033]

缩略语和定义

[0034]

为了便于参考,本部分包括本文档中使用的缩写、首字母缩略词和简短定义的简要列表。本部分不应被认为是限制性的。更详细的描述可以在下面和适用的标准中找到。

[0035]

α超分辨率的放大倍数。

[0036]

bottleneck与先前层相比,包括较少节点的层。可以用于获得具有降低的维数的表示。用作给出处理的数据的重要系数的学习层。可以用于表示不同子空间中的数据。

[0037]

ch针对网络的每层的通道的数目。也称为特征。

[0038]fl

第l卷积模块的输出。

[0039]

对于所有l,输入和输出两者中的滤波器的数目是ch。

[0040]

i图像。

[0041]

ir红外。

[0042]

ilr、i

lr

、i

lr

低分辨率输入图像。尺寸为h

×

w。

[0043]

ihr、i

hr

、i

hr

高分辨率标注图像。用于教导网络如何创建isr。尺寸为αh

×

αw。

[0044]

isr、i

sr

、i

sr

l的超分辨版本。其尺寸为αh

×

αw。

[0045]

hr高分辨率。

[0046]

l网络中的层的总数。

[0047]

l、ln、l-n网络中的一层,网络中的第n层

[0048]

lcon卷积模块。

[0049]

lcon-l第l卷积模块。

[0050]

lr低分辨率。

[0051]

mac乘积累加运算。

[0052]

prelu参数整流线性激活单元实现整流线性激活函数,如果它是正的,则分段线性函数将把输入直接输出,否则,分段线性函数将输出与学习参数对应的值。用作激活功能的示例性典型实施方式。

[0053]

s瓶颈层的输出。“层输出”。

[0054]

sl第l瓶颈层的输出。

[0055]

输入中的滤波器的数目为l

·

ch。

[0056]

对于所有l,输出中滤波器的数目是ch。

[0057]

sr超分辨率。

[0058]

瓶颈层的学习权重。每个滤波器具有l

×

l空间尺寸。

[0059]

θ卷积层(模块)的学习权重。每个滤波器具有3

×

3的空间尺寸。

[0060]

φ非线性激活函数

具体实施方式

[0061]

参照附图和所附描述,可以更好地理解根据本实施例的系统和方法的原理和操作。本实施例是用于从低分辨率图像生成高分辨率图像的系统和方法。

[0062]

以下段落描述本发明的不同实施例。以下实施例仅是示例性的,通常使用ir图像。本发明不应限于这里描述的特定实施例。例如,低分辨率图像(例如,输入的低分辨率图像ilr)可以是ir图像,或者其他图像(诸如以下列出的图像)。还预期了其它实施例。例如,已经在7.5-14微米范围内完成了工作。可以预见,基于当前描述,可以处理电磁谱的其它范围(例如,包括但不限于可见光谱、ir谱、兆赫兹(thz)谱和x射线(x-ray)谱)以及其它图像系统(例如,电子束图像、mri、超声波、卫星图像、显微镜、移动电话应用和雷达)。

[0063]

已经演示了实施例,并且实施例可以解决现实世界中的问题(例如,使用低功率ir相机改善作物中疾病的检测和灌溉失败者)。实施例可以在适合农业和环境使用的现场条件下与低功率设备一起实时使用。

[0064]

除非另有定义,否则在此使用的所有技术和/或科学术语具有与本发明所属领域的普通技术人员通常理解的含义相同的含义。尽管可以在本发明的实施例的实践或测试中使用与在此描述的方法和材料类似或等同的方法和材料,但是下面描述示例性方法和/或材料。在冲突的情况下,包括定义的专利说明书将控制。此外,材料、方法和示例仅是说明性的,并且不旨在必然地限制。

[0065]

在详细解释本发明的至少一个实施例之前,应当理解,本发明在其应用中不一定限于以下描述中阐述的以及/或者附图和/或示例中所示出的组件和/或方法的构造和布置

的细节。本发明能够以各种方式实施或执行其它实施例。

[0066]

用于处理低分辨率图像以生成超分辨率图像的人工神经网络包括层之间的前馈连接。所述网络包括输入层、一个或更多个卷积层和输出层,其中,输入层连接到卷积层中的第一卷积层,输出层连接到卷积层中的最后一个卷积层。输入图像输入到输入层以及卷积层中的至少一个,输入层的初始输出输入到卷积层中的至少一个,卷积层中的至少一个的层输出输入到至少一个后续的卷积层。

[0067]

材料和方法

[0068]

数据

[0069]

该训练是基于agustsson等人[1]的div2k数据集和timofte等人[18]中公开的flicker2k完成的。这些数据集中的图像具有2k的分辨率,因此每个图像包含精细的细节。为了获得低分辨率图像,处理训练集并且优选地将每个图像变换为低分辨率图像,例如使用双三次插值对每个图像进行下采样。由于下面所示的温度和像素强度之间的比例关系,在y通道上完成训练。

[0070]

基于bevilacqua等人[3]的set5、zeyde等人[21]的set14和来自huang等人[11]的urban100来评估训练结果。所使用的度量是峰值信噪比(psnr)和结构相似性指数(ssim)。使用来自python中的skimage库的比较psnr()和比较ssim()来在所生成的超分辨率图像isr和高分辨率图像ihr之间计算两种度量。对于每个边界,图像的边界裁剪了10个像素,以忽略边界效果。

[0071]

除了这些训练测试集之外,在正午使用therm-app th红外照相机[23]收集不同植物的几个测试集。参见下面的图8a至图8d,关于基于黄瓜测试集的信息和结果。

[0072]

热图像往往是有噪声的。对ir图像中的特征噪声进行分析,发现ir图像中的特征噪声是具有变化的均值和方差的高斯分布。为了提供更好的超分辨率估计,在两个阶段中完成训练:第一阶段使用下采样图像而不是它们的高分辨率源,第二阶段通过将特征噪声注入到下采样图像而不是它们的高分辨率源。

[0073]

实施例的特征是训练网络以忽略输入图像中的噪声。在训练过程中,调整滤波器以(仅)注意图像中的显著特征。

[0074]

网络

[0075]

参照图1,图1是可用于实施本发明的实施例的卷积神经网络100的示意图。表示为i

lr

的低分辨率ir图像在网络100中传播通过l层,网络100的最终输出是高分辨率图像i

hr

的超分辨率(sr)图像i

sr

近似。卷积神经网络100将i

lr

分解为ch滤波器。网络100的每层具有ch通道(也称为特征)。超分辨率标度表示为α。在当前描述中,对网络100进行训练以实现超分辨率的放大倍数(upscale factor)α∈2,4。

[0076]

网络具有用于输入的一个初始卷积层l-in、串联在一起的l个卷积层以及用于输出的另一个最终卷积层l-out。全部(2+l)个卷积和l个瓶颈层。虽然中间层或隐藏层l被称为“卷积层”(数量为l),但是卷积不限于仅在中间层中实现,并且卷积也可以在其它位置中(例如,在输入l-in和输出l-out层中)进行。

[0077]

初始卷积层l-in用于将低分辨率输入图像ilr投射到初始特征空间中。

[0078]

层l的每个卷积lcon模块的输出被馈送到非线性激活函数,按单元施加到结果。在当前描述中,激活函数的非限制性实施方式使用prelu。激活函数prelu的结果通过将先前

层l的输出的级联与输入图像ilr集合。级联的矩阵经过输出ch滤波器的瓶颈层lb。对于每个瓶颈层或“瓶颈块”lb-n(其中“n”是表示层数的整数),网络的所有先前层l被级联在一起并与瓶颈层lb卷积。将两个矩阵a和b之间的卷积表示为a*b,并且将这些矩阵之间的级联表示为{a,b}。瓶颈层的数学公式如下:

[0079][0080]

其中,s1是第1瓶颈层的输出,表示瓶颈层(l

·

ch为输入,ch滤波器为输出)的学习权重。φ为非线性激活函数,f

l

为第l卷积模块的输出。为了简洁,省略了偏置项。

[0081]

瓶颈层lb与池化层的不同之处在于给出了基于图像本身固有的数据的显著的特征。部分地,瓶颈层lb的此特征在系统(网络)中节省能量,因为瓶颈层lb的输出将仅具有相应层的最显著特征(该层的处理,其可以包括来自先前层的输入)。瓶颈层lb通常是被训练为仅给出关于特征空间的最重要的系数的学习层。瓶颈层lb可以处理输入信息并在不同的子空间中生成表示。部分地,瓶颈层lb通过选择哪些特征是最重要的来帮助保持特征(的数量)低。

[0082]

该网络由l个卷积模块组成,每个卷积模块在对应的卷积层中,可以被描述如下:

[0083][0084]

其中,对于ch滤波器,θ具有3

×

3的空间尺寸的学习权重。虽然可以使用各种非线性激活函数,但是为了简单起见,在本描述中,将使用由he等人(2015)[9]提出的prelu作为非线性激活函数的非限制性示例。

[0085]

可以使用由chollet(2017)[6]提出的深度可分离卷积模块来降低计算成本。下面描述深度可分离卷积的示例性使用。

[0086]

现在也参照图2,图2是混洗块l-sb的示意图。混洗块l-sb包括卷积层202和像素混洗器204。在混洗块l-sb中执行从i

lr

到i

sr

的放大,生成比输入图像ilr和层输出(sl)高的分辨率的混洗块输出114。在shi等人(2016)[17]中描述了该方法。

[0087]

在当前实施例中,网络100的最终层l-out包括具有ch+l个滤波器作为输入的最终卷积l-fin。额外通道是从低分辨率输入图像ilr生成的高分辨率图像。用于生成额外通道的一个示例性实施方式是使用输入低分辨率图像的双三次插值112来生成额外通道高分辨率插值116。如本领域已知的,双三次插值112输入低分辨率数据(低分辨率图像ilr),并将低分辨率信息扩展到空间域,以生成高分辨率数据(高分辨率图像,插值116)。该高分辨率插值116仅包括低分辨率信息。在经过最终级联l-fin之前,高分辨率插值116(高分辨率图像)被级联到混洗块输出114。混洗块114的输出包括高分辨率信息。这种级联和卷积使得网络100能够仅学习i

lr

和i

hr

之间的高分辨率差异。最终层l-out输出超分辨率图像isr的单通道118,并且没有激活功能。

[0088]

网络100学习高频、重要特征,然后将该学习与低分辨率图像的处理相结合。可以训练每层以找到图像中的不同方面。例如,可以训练第一层(层-l(l-1))(卷积矩阵加权的权重)以找到边缘,并且可以训练第二层(层-l(l-2))以找到lr图像中的圆。

[0089]

也参照图3a至图3d,图3a至图3d示出最终层输出过程的照片。图3a是低分辨率图

像。图3b示出了低分辨率图像ilr的双三次插值116。图3c示出了由主网络管道(l)学习的“高分辨率”信息114。这些插值数据116和“高分辨率”数据114在最终层卷积l-fin中进行加和。在训练过程中,该加和的结果被最小化,以类似于高分辨率ihr基表实况(ground truth)图像(图3d)。

[0090]

输入低分辨率图像i

lr

具有拥有l通道的尺寸h

×

w。通道将低分辨率图像i

lr

的对象的温度表示为16比特。在进入网络之前,i

lr

可以被标准化到范围(0,1),使得

[0091][0092]

网络训练120可以通过使基表实况图像ihr和工作输出(sr图像)isr之间的误差最小化来完成。作为成本函数,对离群值鲁棒的被称为l1规范化的绝对平均误差应用在像素域中的i

sr

和i

hr

之间。形式上:

[0093][0094]

其中,h、w分别是高度和宽度。θ是网络的学习权重。参数列表见上面在部分“缩略语和定义”中提供。

[0095]

瓶颈层

[0096]

瓶颈层lb是l

×

l卷积,其中,输出滤波器的数目是ch。这个处理在bishop(2006)[4]中描述并被shelhamer(2017)[16]等人使用。瓶颈层lb具有若干效果。例如,瓶颈层lb有助于减轻消失的梯度(vanishing gradient)。在另一示例中,使用计算效率和参数保守的瓶颈层来选择最重要的特征,因此在其它卷积层中的操作总是仅应用于ch通道。

[0097]

温度与像素强度的关系

[0098]

stefan-boltzmann等式描述了表面的温度与表面的辐照度之间的关系。在典型的室外温度(例如,280k至320k)中,目标温度和环境温度是类似的,使得在该范围内的辐射功率的变化可以近似地线性依赖于体温相对于环境温度的变化。

[0099][0100]

其中,p是辐射功率,t0、p0分别是参考环境温度和相关辐射率,σ是stefan-boltzmann系数,α是比例因子。等式(4)展示了围绕环境温度的泰勒膨胀。实际上,在较窄的温度范围内,辐射的变化线性依赖于物体温度δt相对于环境温度t0的变化。

[0101]

与物体温度相关的ir辐射通过相机的镜头集中在相机的检测器上。通过加热像素,集中的ir辐射改变微测辐射热器的电阻,这反过来线性地改变像素读数。这里,假设所得到的场景的灰度呈现与图像灰度线性连接。

[0102]

这种关系允许针对规则可见图像训练模型,并且即使没有对ir图像进行微调的情况下仍能获得满意的结果。由于ir图像和可见图像之间的统计差异,微调可以进一步增强性能。

[0103]

计算成本

[0104]

在网络100的每层中进行的操作主要是点积:

[0105]

y=w0

·

x0+

…

+wn

·

xn等式(6)

[0106]

其中,x和w是向量,y是标量。乘积累加运算(mac)被定义为单个乘法和单个加法运算。在等式6中,存在n个mac操作。注意,在浮点运算(flop)方面,对于点积存在2n-1个运算。

[0107]

设f

l

是具有尺寸ch

×h×

w的第l层的特征图,其中,h

×

w是特征图的空间尺寸,而ch是通道的数目。对于分别以k、cin、cout作为核大小、输入通道的数目和输出通道的数目的一系列卷积层,对于特征图中的每个像素,遍及所有c

in

对k2窗口取点积,并且对c

out

通道重复该过程:

[0108]h×w×

k2

×

cin

×

cout

[0109]

表示其中k=l的瓶颈层具有:

[0110]h×w×

cin

×

cout

[0111]

对于深度可分离的卷积,针对每个像素的计算分别针对每个通道进行,因此仅c

in

次。所得mac的数目是比卷积层小的c

out

因数:

[0112]h×w×

k2×cin

[0113]

在网络100中,第一(l-1)层和最后(l-l)层通常是卷积层,而其它层可以是深度可分离的卷积。从此以后,为了简洁,c

in

≡c

out

≡ch。初始卷积l-in、最终卷积l-fin和混洗块l-sb中的mac分别为:

[0114]

#convin=h

×w×

k2×

l

×

ch

[0115]

#convout=α2×h×w×

k2×

ch

×

l

[0116]

#shuffleblock=α2×h×w×

k2×

ch2[0117]

其中,α是输出的放大倍数。针对具有瓶颈的l个卷积层的mac的数目:

[0118][0119]

具有瓶颈的l个深度可分离卷积层的mac的数目:

[0120][0121]

这意味着在深度可分离卷积实施方式和卷积实施方式之间执行的mac的数量之间的因子是:

[0122][0123]

以ξ作为折减因子(reduction factor)。不同网络之间的比较可以在图8a至图8d中示出。为了简洁起见,忽略了偏置项和prelu,因为每个都添加可忽略的c

out mac。

[0124]

训练

[0125]

再次参照图1,训练模块120包括用于输入训练数据、处理和准备训练数据、配置初始系统、运行训练等的各种处理和功能。低分辨率(lr)图像和具有噪声的图像展示了确定成像位置中的高分辨率特征的重大问题。虽然lr图像可以容易地从各种来源获得,或者(与用于收集高分辨率图像的设备相比,经由低成本的设备)低成本地获取或者需要使用低功

率设备(通常固有的lr)来捕获,但是问题是如何从这些lr图像中提取显著的特征。此外,与处理较低分辨率的图像相比,用于生成高分辨率(hr)图像的lr图像的传统处理通常是高成本、长时间和高功率的。如在整个描述中所描述的,实施例的各种元件被训练以处理和提取来自lr图像的显著特征,因此与用于处理hr图像的传统技术和用于处理lr图像的现有技术相比,改善了实施例运行所在的计算系统的操作,降低了成本、时间和功耗。

[0126]

使用paszke等人[15]实现了示例性网络100。小批量尺寸设定为16。将每个图像随机裁剪成192

×

192以创建高分辨率图像i

hr

,然后将高分辨率图像i

hr

用双三次核缩小2倍或4倍以创建低分辨率图像i

lr

以训练网络100。通过水平翻转和90度旋转来增强训练数据集。使用python pil图像库完成所有图像处理。

[0127]

经由由he等人(2015)[9]提出的方法使所有网络可训练权重初始化,并且比例因子为0.1,如由wang等人(2018)[20]提出。使用kingma等人[13]的梯度下降来优化网络。其中β1=0.9,β2=0.999并且初始学习速率设定为5

·

10-4

。在104和105次迭代时,学习速率减半。训练运行了3

·

105次迭代。

[0128]

使用nvidia2080tigpu完成训练。对网络的每个置换(permutation,或被称为排列)进行训练300k次迭代。

[0129]

示例

[0130]

参照图8a至图8d,图8a至图8d是针对放大倍数α=4的不同数据集的实验结果的表格。基于由野外中和温室中的四种作物(黄瓜和香蕉叶)的9630室外ir图像组成的数据库来评价本发明的方法。其中在恢复温度psnr和mac方面的性能与其它先前建议的现有技术sr网络相比。在当前的图中,展示了四种作物(a)温室中的黄瓜,b)野外中的黄瓜,c)温室中的香蕉叶,和d)野外中的香蕉叶)的平均结果。

[0131]

为了方便起见,将当前图的表分成四个子表。每个子表由七行组成。行1至行3展示了网络的不同实施方式。行4至行7展示了三个先前建议的sr网络(srcnn freeman等人[8]、srdensenet wang等人[20]、vdsr kingma等人[13]和双三次(bi-cubic)插值)的性能。为了方便起见,在所有子表中重复行的该顺序。观察结果,在恢复质量和具有较低mac两方面,网络优于srcnn freeman等人[8]、srdensenet wang等人[20]和双三次插值。而vdsr kingma等人[13]实现了最好的恢复结果——在psnr方面以大约1db而是更优的,在绝对性能方面仅以3%而是更优的,在平均温度误差方面以0.022c而是更优的,但是执行28次或更多次额外的mac。比较计算成本的相对改善,该方法建议成本有效的实施方式。

[0132]

参照图4和图5,图4和图5是sr结果的图像。下面依次展示五个不同数据集的典型示例。从左到右的列内容是:低分辨率输入、双三次插值结果、vdsr恢复结果和所述方法的结果。当前的图分别示出了2倍sr和4倍sr的sr结果。这些示出了由kim等人(2016)[12]提出的i

lr

、bi-cubic、i

sr

和vdsr之间的比较。观察这些图,所述方法看起来处于与vdsr相同的水平,这是以明显较低的计算努力来完成的。两种方法在外观和度量两方面都优于双三次插值。在图6中,展示了图5中的e(温室中的黄瓜)的放大副本。观察结果,该方法比vdsr kingma等人[13]看起来更好,下面进一步讨论。

[0133]

所有结果都是在配备有i7处理器的台式计算机上运行时获得的。

[0134]

现在参照图6,图6是放大的示例。在当前图中,4

×

sr的放大示例是a)低分辨率图像,b)是双三次插值结果,c)是vdsr的sr结果,以及d)是所述方法的4

×

sr结果。

convolutions(具有深度可分离卷积的深度学习).2017ieee conference on computer vision and pattern recognition(cvpr),pages 1800

–

1807,2017.2,4

[0147]

[7]c.dong,c.c.loy,k.he,and x.tang.image super-resolution using deep convolutional networks(使用深卷积网络的图像超分辨率).ieee transactions on pattern analysis and machine intelligence,38(2):295

–

307,feb 2016.issn 0162-8828.doi:10.1109/tpami.2015.2439281.2,10

[0148]

[8]w.t.freeman,t.r.jones,and e.c.pasztor.example-based superresolution(基于示例的超分辨率).ieee computer graphics and applications,22(2):56

–

65,march 2002.issn 0272-1716.doi:10.1109/38.988747.2

[0149]

[9]k.he,x.zhang,s.ren,and j.sun.delving deep into rectifiers:surpassing human-level performance on imagenet classification(深入研究整流器:在imagenet分类上超越人本级性能).ieee international conference on computer vision(iccv 2015),1502,02 2015.doi:10.1109/iccv.2015.123.4,8

[0150]

[10]z.he,s.tang,j.yang,y.cao,m.y.yang,and y.cao.cascaded deep networks with multiple receptive fields for infrared image super-resolution(用于红外图像超分辨率的具有多个接收场的级联深度网络).ieee transactions on circuits and systems for video technology,pp:1

–

1,08 2018.doi:10.1109/tcsvt.2018.2864777.2,10

[0151]

[11]j.huang,a.singh,and n.ahuja.single image super-resolution from transformed self-exemplars(来自变换的自我示例的单个图像超分辨率).in 2015 ieee conference on computer vision and pattern recognition(cvpr),pages 5197

ꢀ–

5206,june 2015.doi:10.1109/cvpr.2015.7299156.8

[0152]

[12]j.kim,j.k.lee,and k.m.lee.accurate image super-resolution using very deep convolutional networks(使用非常深的卷积网络的精确图像超分辨率).in the ieee conference on computer vision and pattern recognition(cvpr oral),june 2016.2,10

[0153]

[13]kingma,p.diederik,and j.ba.adam:amethod for stochastic optimization(用于随机优化的方法),2014.网址http://arxiv.org/abs/1412.6980.cite arxiv:1412.6980comment:published as a conference paper at the 3rd international conference for learning representations(在第三届国际学习代表大会上作为会议论文发表),san diego,2015.8

[0154]

[14]m.mller,v.alchanatis,y.cohen,m.meron,j.tsipris,a.naor,v.ostrovsky,m.sprintsin,and s.cohen.use of thermal and visible imagery for estimating crop water status of irrigated grapevine*(使用热图像和可见图像来估计灌溉葡萄藤的作物水分状况).journal of experimental botany,58(4):827

–

838,09 2006.issn 0022-0957.doi:10.1093/jxb/erl115.网址https://doi.org/10.1093/jxb/erl115.1

[0155]

[15]a.paszke,s.gross,s.chintala,g.chanan,e.yang,z.devito,z.lin,a.desmaison,l.antiga,and a.lerer.automatic differentiation in pytorch(pytorch

中的自动分化).in nips autodiff workshop,2017.8

[0156]

[16]e.shelhamer,j.long,and t.darrell.fully convolutional networks for semantic segmentation(用于语义分割的全卷积网络).ieee trans.pattern anal.mach.intell.,39(4):640

–

651,apr.2017.issn 0162-8828.doi:10.1109/tpami.2016.2572683.

[0157]

网址https://doi.org/10.1109/tpami.2016.2572683.4

[0158]

[17]w.shi,j.caballero,f.husz

′

ar,j.totz,a.p.aitken,r.bishop,d.rueckert,and z.wang.real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network(使用有效子像素卷积神经网络的实时单图像和视频超分辨率).2016ieee conference on computer vision and pattern recognition(cvpr),pages 1874

–

1883,2016.5

[0159]

[18]r.timofte,e.agustsson,l.van gool,m.-h.yang,l.zhang,b.lim,et al.ntire 2017challenge on single image super-resolution:methods and results(对单个图像超分辨率的挑战:方法和结果).in the ieee conference on computer vision and pattern recognition(cvpr)workshops,july 2017.8

[0160]

[19]t.tong,g.li,x.liu,and q.gao.image super-resolution using dense skip connections(使用密集残差连接的图像超分辨率).in 2017ieee international conference on computer vision(iccv),pages 4809

–

4817,oct 2017.doi:10.1109/iccv.2017.514.2,10

[0161]

[20]x.wang,k.yu,s.wu,j.gu,y.liu,c.dong,y.qiao,and c.c.loy.esrgan:enhanced super-resolution generative adversarial networks(增强的超分辨率生成对抗网络).in the european conference on computer vision workshops(eccvw),september 2018.8

[0162]

[21]r.zeyde,m.elad,and m.protter.on single image scale-up using sparse representations(关于使用稀疏表示的单个图像放大).in j.-d.boissonnat,p.chenin,a.cohen,c.gout,t.lyche,m.-l.mazure,and l.schumaker,editors,curves and surfaces,pages 711

–

730,berlin,heidelberg,2012.springer berlin heidelberg.isbn 9783-642-27413-8.8

[0163]

[22]a.zomet and s.peleg.multi-sensor super-resolution(多传感器超分辨率).in proceedings of the sixth ieee workshop on applications of computer vision,wacv’02,pages 27

–

,washington,dc,usa,2002.ieee computer society.isbn 0-7695-1858-3.网址http://dl.acm.org/citation.cfm?id=832302.836830.2

[0164]

[23]https://therm-app.com/therm-app-thermography/

[0165]

虽然已经关于有限数量的实施例描述了本发明,但是将理解的是,可以进行本发明的许多变化、修改和其它应用。因此,所附权利要求书中记载的要求保护的发明不限于这里描述的实施例。

[0166]

在本领域中众所周知的是,人类通常不可能执行诸如当前实施例的人工智能(ai)和机器学习(ml)系统的计算。例如,网络100对给定数据集执行的处理通常不是预编程的,并且可以根据动态因素(诸如处理输入数据集的时间和先前处理的其他输入数据集的时

间)而变化。

[0167]

当前网络100是部分地使用算法的精心设计的架构。也就是说,一些算法可以用作网络100架构的构建块,在网络100架构中,系统将自身学习他自己的运行参数。

[0168]

图7是被配置为实现本发明的网络100的示例性系统600的高级部分框图。系统(处理系统)600包括(一个或更多个)处理器602和四个示例性存储器件:随机存取存储器(ram)604、引导只读存储器(rom)606、大容量存储设备(硬盘)608和闪存610,它们都经由公共总线612通信。如本领域已知的,处理和存储器可以包括存储软件和/或固件和/或任何硬件元件的任何计算机可读介质,任何硬件元件包括但不限于现场可编程逻辑阵列(fpla)元件、硬接线逻辑元件、现场可编程门阵列(fpga)元件、图形处理单元(gpu)和专用集成电路(asic)元件。处理器602由一个或更多个处理器(例如,用于执行在此详述的功能和操作的包括微处理器的硬件处理器)形成。处理器例如是常规的处理器(诸如在服务器、计算机和其它计算机化设备中使用的处理器)。例如,处理器可以包括来自amd和英特尔公司的x86处理器、来自英特尔公司的xenon和pentium处理器以及它们的任何组合。可以在处理器602中使用任何指令集架构,包括但不限于精简指令集计算机(risc)架构和/或复杂指令集计算机(cisc)架构。模块(处理模块、神经网络节点或层)614示出在大容量存储器608上,但是如对于本领域技术人员而言明显的,模块(处理模块、神经网络节点或层)614可以位于任何存储器件上。

[0169]

大容量存储设备608是带有用于实现在此描述的图像处理方法的计算机可读代码的非瞬时性计算机可读存储介质的非限制性示例。这种非瞬时性计算机可读存储介质的其它示例包括诸如承载这种代码的cd的只读存储器。

[0170]

系统600可以具有存储在存储器件上的操作系统,rom可以包括用于所述系统的引导代码,处理器可以被配置为执行引导代码以将操作系统加载到ram604,执行操作系统以将计算机可读代码复制到ram604且执行所述代码。

[0171]

网络连接器620提供与系统600之间的通信。通常,单个网络连接器向本地和/或远程网络上的其它设备提供一个或更多个链路(包括虚拟连接)。可选地,系统600可以包括多于一个的网络连接器(未示出),每个网络连接器向其他设备和/或网络提供一个或更多个链路。

[0172]

系统600可以实现为分别通过网络连接到客户端或服务器的服务器或客户端。

[0173]

注意,根据应用,用于模块、处理和层的各种实施方式是可能的。模块在一个或更多个位置处在单个处理器或分布式处理器上优选地以软件实现,但也可以以硬件和固件实现。上述模块功能可以被组合并实现为较少的模块,或者被分成子功能并实现为较多的模块。基于以上描述,本领域技术人员将能够设计用于特定应用的实施方式。

[0174]

注意,上述示例、所使用的数字和示例性计算有助于本实施例的描述。非故意的打字错误、数学错误和/或简化计算的使用不会损害本发明的效用和基本优点。

[0175]

在没有多项引用的情况下起草所附权利要求的程度上,这仅仅是为了适应不允许这种多项引用的司法管辖范围中的形式要求。注意,通过使权利要求书多项引用而隐含的特征的所有可能的组合是明确设想了的,并且应当被认为是本发明的一部分。

[0176]

已经为了说明的目的而给出本公开的各种实施例的描述,但本公开的各种实施例的描述并不旨在穷举或局限于所公开的实施例。在不脱离所描述的实施例的范围和精神的

情况下,许多修改和改变对于本领域的普通技术人员是明显的。选择这里使用的术语是为了最佳地解释实施例的原理、实际应用或相对于市场中发现的技术的技术改善,或者使本领域普通技术人员能够理解在此公开的实施例。

[0177]

如在此所使用的,单数形式“一(一个/一者/一种)”和“所述(该)”包括复数指称,除非上下文另有明确的指示。

[0178]

在此使用词语“示例性”来表示“用作示例、实例或说明”。被描述为“示例性”的任何实施例不必被解释为比其它实施例更优选或更有利以及/或者从其它实施例中排除特征的结合。

[0179]

应当理解,为了清楚起见,在单独实施例的上下文中描述的本发明的某些特征也可以在单个实施例中被组合地提供。相反,为了简明起见,在单个实施例的上下文中描述的本发明的各种特征也可以单独提供,或者以任何合适的子组合提供,或者以本发明的任何其它描述的实施例中的合适的方式提供。在各种实施例的上下文中描述的某些特征不应被认为是这些实施例的必要特征,除非该实施例在没有这些元件的情况下不可操作。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1