一种利用跨任务信息的数字图像自动标注方法

1.本发明属于数字图像标注技术领域,具体涉及一种利用跨任务信息的数字图像自动标注方法。

背景技术:

2.数字图像标注是人工智能应用中的常见任务。现有图像标注模型的训练往往需要大量标注样本,代价高昂。然而,由于现实世界中物体对象的出现概率分布为长尾分布,存在大量对象类别仅能收集到少量标注样本。同时,有些任务领域本身就带有难以获取目标任务对应标注数据的属性。例如在医疗健康和生物信息领域,数据的标注需要专家给出,标注代价极高。除此之外,也有些任务存在训练数据和预测分布存在差异而无法进行泛化的情况。例如在计算机视觉领域中的手机照片分类任务,由于不可控的任务场景中的光照、朝向、清晰度等问题,从公共数据集上学得的模型通常无法在目标任务上获取良好泛化效果,无法满足用户需求。一个解决方案是使用模型迁移算法,利用相关任务的模型辅助目标任务上的模型训练,通过跨领域的知识迁移实现目标模型的效果提升。通常利用在超大数据集上训练得到的深度模型(vgg,resnet等)抽取图像的一般特征。在此特征基础上进行目标任务线性分类模型的训练。现有模型迁移算法往往直接将相关任务的分类模型作用到目标任务样本或模型上,利用辅助模型的加权组合表示或约束目标模型。然而,在辅助领域与目标任务相关性较低时,通常方法包含大量无用的知识迁移,无法稳定有效地提升目标模型效果。

技术实现要素:

3.发明目的:为了克服在领域相关性较低时,难以利用辅助领域模型提升目标模型性能的问题,本发明提供了一种利用跨任务信息的数字图像自动标注方法,

4.技术方案:为实现上述目的,本发明采用的技术方案为:

5.一种利用跨任务信息的数字图像自动标注方法,包括以下步骤:

6.步骤1:收集相关图像标注任务上的预训练模型,并由用户判断模型的丰富程度,若足够丰富则转到步骤2,否则转到步骤4;

7.步骤2:利用丰富的辅助模型进行领域共享知识的抽取,即获取共享基模型集合d;

8.步骤3:利用共享基模型集合d对目标模型w

t

进行有偏正则化约束,同时最小化模型w

t

的经验损失,输出目标模型w

t

;

9.步骤4:利用步骤1收集到的辅助模型以及当前任务少量标注样本上学得的较差模型,同时进行领域共享知识d抽取,模型w

t

的经验误差最小化与有偏正则化,输出目标模型w

t

;

10.步骤5:利用步骤3或4学得的标注模型,对经过与辅助模型相同预处理方式得到的数字图像样本进行标注预测,选择预测概率最大的类别作为图像标记。

11.进一步的:步骤2中抽取领域共享基模型集合d的具体方法为:

12.我们假设在来自多个相关的图像领域的模型间,存在一组通用基础模型d可用于表示每个领域上的模型中的共有知识部分,比如多领域任务共有的形状或纹理知识。假设共搜集到m个辅助模型其中d为图像抽取到的特征维度;设d∈r

d

×

k

,v

s

∈r

k

×

m

。假设收集到较多的辅助模型来自与目标任务具有相似的形状、纹理、颜色或场景等特征的标注任务,则认为收集到了丰富的辅助模型,这种情况下我们认为从辅助模型中可以直接获得对目标任务较为有效的共有知识。因此我们基于上述想法采用矩阵分解的方式抽取共享基模型集合d,得到了下列优化目标:

[0013][0014]

其中λ为控制权重矩阵v

s

每列光滑程度的超参数,需根据问题搜索最优值;k为基模型的数量,在(3,min(d,2m/3))中搜索最优值。由于我们希望抽取到对每个领域都有用的基模型,我们对模型权重v

s

采用2,1范数作为约束,使每一个辅助模型对应的基模型权重分布尽量光滑。

[0015]

进一步的:可通过梯度下降求解式(1)。不同于直接对所有变量求导的常用梯度下降法,我们为本发明提出的式(1)专门设计了一种分块最速梯度下降法,在固定某些变量的情况下找到其它变量的最优值,依次更新变量迭代收敛到局部最优。具体如下:首先将变量d,v

s

以标准正态分布初始化,d在v

s

固定的情况下,对优化目标求导并使梯度为零,得到d的更新式:接着固定d使目标函数关于v

s

的梯度为零,由于我们设计的目标函数式(1)的特殊性,我们仅能获得v

s

的隐式更新式:(d

t

d)v

s

+v

s

m=d

t

w

s

。其中m=diag(1/||v

i

||,i=1,...),v

i

为v

s

中的第i列;v

s

的隐式更新式为sylvester方程,形如ax+xb=q,通过python包scipy中的scipy.linalg._solvers.solve_sylvester(a,b,q)求解;由于m为关于v

s

的变量,需重复求解此式直到收敛获取固定d情况下v

s

的最优值。依次重复d与v

s

的更新直到收敛,由目标函数的块凸性可保证收敛到局部最优,得到共享基模型集合d。接着即可利用d对通过有偏最小化目标模型的经验损失学习目标模型。

[0016]

进一步的:所述步骤3对目标模型w

t

经验损失的有偏最小化的具体方法为:

[0017]

在抽取到对目标任务较为有效的基模型集合d之后。假设目标任务图像有c个类别,将线性模型推广到多分类设v

t

∈r

k

×

c

。为了使学得的模型能良好的应用于目标图像标注任务,我们结合目标任务的少两样本标注与领域共用知识设计了模型学习方法,通过优化下式可学得目标模型w

t

:

[0018][0019]

其中分别为目标任务的样本与标记,l(

·

)为任意可求梯度的损失函数,λ,μ为需要搜索的超参数。通过同时最小化模型分类的损失函数以及基模型对目标模型的表达损失,我们利用领域间共有的模型先验知识表达目标模型的共有知识部分,同时也利用目标任务的标注信息尽可能地学习目标任务的特有知识。式(2)可通过分块最速梯度下降求解,类似地分别固定v

t

与w

t

,依次更新直到目标函数收敛可得目标分类模型w

t

。

[0020]

进一步的:所述步骤4同时抽取领域共享基模型集合d与训练有偏目标模型的具体方法为:

[0021]

假设目标任务图像有c个类别,将线性模型推广到多分类设假设目标任务图像有c个类别,将线性模型推广到多分类设假设收集到的辅助模型来自与目标任务具有较少相似特征的标注任务,则认为没有收集到丰富的辅助模型,这种情况下我们认为仅从低质量辅助模型中抽取的多领域间共有知识难以保证能学得高效的目标模型。为了提高领域间抽取知识对目标任务的有效性以及更准确地刻画领域共有知识,我们设计了以下优化目标以学习目标模型w

t

:

[0022][0023]

其中分别为目标任务的图像与其标记,分别为目标任务的图像与其标记,d∈r

d

×

k

,v

s

∈r

k

×

m

,v

t

∈r

k

×

c

,l(

·

)为任意可求梯度的损失函数,λ,μ,η为需要搜索的超参数。通过同时利用辅助模型与更新过程中初步学得的目标模型进行知识抽取,更好地刻画了领域共有知识。通过同时进行知识抽取与目标标注任务的学习,进一步提高了抽取所得知识对目标任务的有效性。式(3)可通过分块最速梯度下降求解,通过结合权利要求3、4中的分块最速梯度下降法,依次更新所有变量直至目标函数收敛到局部最优可得目标分类模型w

t

。

[0024]

有益效果:本发明通过利用容易获得的相关任务领域充分训练的线性模型,抽取领域间共享的基模型集合,对目标任务模型权重进行有偏正则化提高目标模型性能,在辅助领域与目标任务相关性较弱的情况下实现了领域模型间有效的知识迁移,在目标任务标注数据不足的情况下学得了高效的预测模型。具体的,本发明根据搜集到的相关任务领域模型的丰富程度选择不同的方式抽取领域共享基模型集合。在辅助模型较多时,先通过矩阵分解获取领域共享的基模型,抽取领域间的共享知识,然后利用其对目标预测模型权重进行有偏正则化实现知识迁移;在辅助模型较少或相关性普遍较低时,同时利用辅助模型与目标域少量标注数据联合进行领域共享知识抽取与目标任务模型预测误差最小化,利用目标域的信息帮助选择共享知识的抽取。常见模型迁移方法通常直接将辅助模型作用到目标任务数据上进行模型加权组合或是利用其进行目标模型的有偏正则化,而当辅助模型与目标任务相关性较差时,辅助模型对目标数据的预测效果较差且模型中含有大量对目标任务无用的知识,直接将其作用到目标数据模型无法获取理想的结果。在各种辅助模型相关性大小、数量多少的情况下,本发明设计了有效的领域模型知识迁移方法,稳定提升了模型预测性能,而无需用户对相关领域模型进行手动挑选,避免了人为判断领域模型相关程度与设置相关性阈值挑选模型的困难性,解决了在标注数据不足的情况下有效利用相关领域模型提升目标模型性能的问题。

附图说明

[0025]

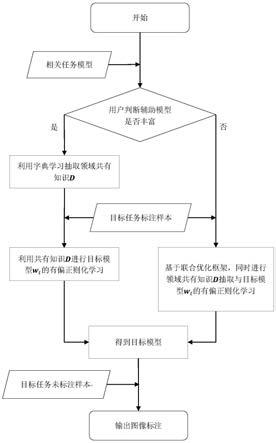

图1是本发明机制的流程图;

[0026]

图2是基模型权重学习的流程图;

[0027]

图3是知识抽取与迁移的流程图;

[0028]

图4是联合知识抽取与模型迁移的流程图。

具体实施方式

[0029]

下面结合附图对本发明作更进一步的说明。

[0030]

实施例

[0031]

如图1所示为本发明机制的流程图。首先搜集相关任务辅助模型并判断其丰富程度(辅助模型的数量及与目标任务的相关性)。在辅助模型较丰富的情况下,首先利用辅助模型的分解进行领域共享基模型集合d的抽取,然后将d对目标模型的加权表出作为模型训练目标的有偏正则化项,通过优化目标函数得到模型w

t

。而在辅助模型不丰富的情况下,同时进行领域共享基模型集合d的抽取与目标模型w

t

的有偏正则化学习,优化目标函数直到收敛可获得高效目标模型w

t

。

[0032]

图2所示为基模型权重学习的流程图。本发明采用交替更新的方式抽取共享基模型集合,需多次在固定模型与基模型集合的情况下,求解模型基于基模型集合的规则化权重即v。首先根据是否为第一轮更新选择是否随机初始化基模型权重v,我们采用标准正态分布。然后计算v每列2范数倒数的对角阵m=diag(1/||v

i

||,i=1,...)。接着根据现有的d,w,m解sylvester方程(d

t

d)v+vm=d

t

w,并根据对应目标函数(1)的收敛与否决定是否结束更新,或进行下一次迭代。收敛结束条件可设置为v的变化幅度或速度。

[0033]

图3所示为知识抽取与迁移的流程图,代表了在丰富辅助模型情况下目标模型的训练过程。首先按标准正态分布初始化目标模型w

t

与基模型集合d。根据输入的相关任务模型w

s

按更新基模型集合d。然后利用图2流程更新基模型权重v

s

。重复更新d,v

s

直到式(1)收敛,获得良好抽取的基模型集合d。然后根据d与目标任务样本x,y更新目标模型权重。利用图2流程更新基模型权重v

t

。重复更新w

t

,v

t

直到式(2)收敛,输出目标模型通常收敛结束条件可根据函数值的变化幅度或速度设置。

[0034]

图4所示为联合知识抽取与模型迁移的流程图,代表了在辅助模型较少或较差情况下目标模型的训练过程。首先按标准正态分布初始化目标模型w

t

与基模型集合d。假设我们这里采用均方误差作为损失函数。根据输入的相关任务模型w

s

与目标任务样本x,y,按更新目标模型w

t

。然后按更新基模型集合d。接着分别利用图2流程更新基模型权重v

s

,v

t

。重复上述更新过程直到式(3)收敛,输出目标模型通常收敛结束条件可根据函数值的变化幅度或速度设置。

[0035]

以上所述仅是本发明的优选实施方式,应当指出:对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1