一种基于知识库问答的实体抽取方法及装置与流程

1.本申请涉及自然语言处理技术领域,特别涉及一种基于知识库问答的实体抽取方法及装置、计算设备及计算机可读存储介质。

背景技术:

2.知识库问答目前主要方法分为两大类。第一类是基于语义解析的方法,该类方法使用字典、规则和机器学习,直接从问题中解析出实体、关系和逻辑组合。基于语义解析的方法通常使用分类模型进行关系的预测,会面临着未登录关系的问题,即训练集中未出现的关系难以被预测出来。而且中文知识库中包含数十万种关系,导致训练集难以覆盖如此庞大规模的数量,从而使得基于语义解析的方法在中文知识知识库问答上受到限制。

3.第二类是基于信息检索的方法,该类方法需要根据问题得到若干个候选实体,在进行候选实体抽取的过程中,一般都是利用命名实体识别模型预测问题中出现的实体,但是使用命名实体识别模型识别出的实体可能并不是知识库中的实体,导致无法获取答案;或者是实体识别模型识别出的实体少了,导致不能找到正确的答案。并且在实体链接部分对所有的候选实体排序时,仅仅采用机器学习算法利用人工构造的特征对候选实体排序准确率较低,导致整个知识库问答系统准确率降低。

技术实现要素:

4.有鉴于此,本申请实施例提供了一种基于知识库问答的实体抽取方法及装置、计算设备及计算机可读存储介质,以解决现有技术中存在的技术缺陷。

5.根据本说明书实施例的第一方面,提供了一种基于知识库问答的实体抽取方法,包括:

6.获取目标问题语句并对所述目标问题语句进行实体识别,分别确定所述目标问题语句中的至少一个第一预测实体和至少一个第二预测实体;

7.根据所述至少一个第一预测实体和至少一个第二预测实体,确定所述目标问题语句对应的至少一个目标预测实体;

8.将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

9.根据本说明书实施例的第二方面,提供了一种基于知识库问答的实体抽取装置,包括:

10.实体识别模块,被配置为获取目标问题语句并对所述目标问题语句进行实体识别,分别确定所述目标问题语句中的至少一个第一预测实体和至少一个第二预测实体;

11.实体处理模块,被配置为根据所述至少一个第一预测实体和至少一个第二预测实体,确定所述目标问题语句对应的至少一个目标预测实体;

12.实体链接模块,被配置为将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

13.根据本说明书实施例的第三方面,提供了一种计算设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机指令,所述处理器执行所述指令时实现所述基于知识库问答的实体抽取方法的步骤。

14.根据本说明书实施例的第四方面,提供了一种计算机可读存储介质,其存储有计算机指令,该指令被处理器执行时实现所述基于知识库问答的实体抽取方法的步骤。

15.本申请在实体抽取部分,通过将实体识别模型与规则匹配方法结合,解决仅仅使用实体识别模型抽取不全或不准的情况。同时,通过在实体抽取部分将实体识别模型结果与规则匹配出的实体融合并过滤,一定程度上修正了实体识别模型的结果,并补充了实体识别模型没有识别出的实体。

16.本申请在实体链接部分,通过将机器学习算法lightgbm和深度学习算法bert模型结合提高实体链接准确率,提升了候选实体排序效果,从而帮助提升了中文知识库问答总体的效果。

附图说明

17.图1是本申请实施例提供的计算设备的结构框图;

18.图2是本申请实施例提供的基于知识库问答的实体抽取方法的流程图;

19.图3是本申请实施例提供的基于知识库问答的实体抽取方法的流程图;

20.图4是本申请实施例提供的基于知识库问答的命名实体识别模型的示意图;

21.图5是本申请实施例提供的基于知识库问答的实体抽取方法的另一流程图;

22.图6是本申请实施例提供的基于知识库问答的实体抽取方法的另一流程图;

23.图7是本申请实施例提供的基于知识库问答的实体抽取方法的另一流程图;

24.图8是本申请实施例提供的基于知识库问答的实体抽取方法的另一流程图;

25.图9是本申请实施例提供的基于知识库问答的实体抽取方法的另一流程图;

26.图10是本申请实施例提供的基于知识库问答的实体抽取装置的结构示意图。

具体实施方式

27.在下面的描述中阐述了很多具体细节以便于充分理解本申请。但是本申请能够以很多不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本申请内涵的情况下做类似推广,因此本申请不受下面公开的具体实施的限制。

28.在本说明书一个或多个实施例中使用的术语是仅仅出于描述特定实施例的目的,而非旨在限制本说明书一个或多个实施例。在本说明书一个或多个实施例和所附权利要求书中所使用的单数形式的“一种”、“所述”和“该”也旨在包括多数形式,除非上下文清楚地表示其他含义。还应当理解,本说明书一个或多个实施例中使用的术语“和/或”是指并包含一个或多个相关联的列出项目的任何或所有可能组合。

29.应当理解,尽管在本说明书一个或多个实施例中可能采用术语第一、第二等来描述各种信息,但这些信息不应限于这些术语。这些术语仅用来将同一类型的信息彼此区分开。例如,在不脱离本说明书一个或多个实施例范围的情况下,第一也可以被称为第二,类似地,第二也可以被称为第一。

30.首先,对本发明一个或多个实施例涉及的名词术语进行解释。

31.知识库问答:知识库问答(knowledge base question answering,kbqa)即给定自然语言问题,通过对问题进行语义理解和解析,进而利用知识库进行查询、推理得出答案。一般主要包括候选实体抽取、实体链接、关系抽取、答案生成几个步骤。举例如,问:张三的身高是多少?,知识库中有三元组(张三,身高,175cm),则目标答案为:175cm。

32.实体链接:问题中提到的实体与其知识库中相应的实体链接起来的任务,即找出知识库中与问题最匹配的实体。

33.bert(bidirectional encoder representations from transformers)模型:一种双向注意力神经网络模型。bert模型的目标是利用大规模无标注语料训练以获得文本的包含丰富语义信息的语义表示(representation),然后将文本的语义表示在特定自然语言处理任务中作微调(fine

‑

tuning),最终应用于该自然语言处理任务。

34.条件随机场(conditional random fields,crf):是给定一组输入序列条件下另一组输出序列的条件概率分布模型。

35.lightgbm(light gradient boosting machine)算法:是一个实现gbdt(gradient boosting decision tree)算法的分布式梯度提升框架,支持高效率的并行训练,并且具有更快的训练速度、更低的内存消耗、更好的准确率和支持分布式可以快速处理海量数据等优点。

36.命名实体识别(named entity recognition,ner):又称作“专名识别”,是指识别文本中具有特定意义的实体,主要包括人名、地名、机构名或专有名词等。

37.在本申请中,提供了一种基于知识库问答的实体抽取方法及装置、计算设备及计算机可读存储介质,在下面的实施例中逐一进行详细说明。

38.图1示出了根据本说明书一实施例的计算设备100的结构框图。该计算设备100的部件包括但不限于存储器110和处理器120。处理器120与存储器110通过总线130相连接,数据库150用于保存数据。

39.计算设备100还包括接入设备140,接入设备140使得计算设备100能够经由一个或多个网络160通信。这些网络的示例包括公用交换电话网(pstn)、局域网(lan)、广域网(wan)、个域网(pan)或诸如因特网的通信网络的组合。接入设备140可以包括有线或无线的任何类型的网络接口(例如,网络接口卡(nic))中的一个或多个,诸如ieee802.11无线局域网(wlan)无线接口、全球微波互联接入(wi

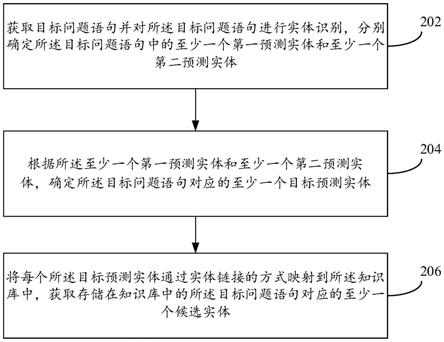

‑

max)接口、以太网接口、通用串行总线(usb)接口、蜂窝网络接口、蓝牙接口、近场通信(nfc)接口,等等。

40.在本说明书的一个实施例中,计算设备100的上述部件以及图1中未示出的其他部件也可以彼此相连接,例如通过总线。应当理解,图1所示的计算设备结构框图仅仅是出于示例的目的,而不是对本说明书范围的限制。本领域技术人员可以根据需要,增添或替换其他部件。

41.计算设备100可以是任何类型的静止或移动计算设备,包括移动计算机或移动计算设备(例如,平板计算机、个人数字助理、膝上型计算机、笔记本计算机、上网本等)、移动电话(例如,智能手机)、可佩戴的计算设备(例如,智能手表、智能眼镜等)或其他类型的移动设备,或者诸如台式计算机或pc的静止计算设备。计算设备100还可以是移动式或静止式的服务器。

42.常规的基于信息检索的方法是指根据预定义的逻辑形式,从知识库中抽取与候选

实体相连的关系作为候选查询路径,再使用文本匹配模型,选择出与问题相似度最高的候选查询路径,最终到知识库中检索答案。这类方法侧重于计算问题和候选关系的相似度,在关系选择上具有更好的泛化能力,因此更适合解决中文知识库问答。

43.如前文所述,在基于信息检索的知识库问答方法可以概括为候选实体抽取、实体链接、关系抽取、关系排序和答案生成几个主要步骤,本申请只涉及实体抽取和实体链接的两个步骤,即对于给出的问题经过实体抽取和实体链接后,输出知识库中所有可能与问题匹配的候选实体并排序,以便后续关系抽取等工作进行。在候选实体抽取部分,一般都是利用命名实体识别模型预测问题中出现的实体,但是使用命名实体识别模型识别出的实体可能并不是知识库中的实体,导致无法获取答案,如问题“第五套人民币纸币的最小面额?”,命名实体识别模型识别出的实体为<第五套人民币>,但是知识库中存在的三元组为(第五套人民币纸币,最小面额,1元),即准确的实体应为<第五套人民币纸币>。

44.还有一种情况是实体识别模型识别出的实体少了,导致不能找到正确的答案,如问题“信仰佛教的日本教育家是谁?”,实体识别模型识别出的实体为<佛教>、<日本>,但是还应该把<教育家>这个实体识别出来,才能找到准确的答案。

45.在实体链接部分对所有的候选实体排序时,仅仅采用机器学习算法利用人工构造的特征对候选实体排序准确率较低,导致整个知识库问答系统准确率降低。本申请的技术方案主要解决以上三个问题。

46.其中,处理器120可以执行图2所示方法中的步骤。图2是示出了根据本申请一实施例的基于知识库问答的实体抽取方法的示意性流程图,包括步骤202至步骤206。

47.步骤202:获取目标问题语句并对所述目标问题语句进行实体识别,分别确定所述目标问题语句中的至少一个第一预测实体和至少一个第二预测实体。

48.在本申请的实施例中,本申请首先通过至少两种方式对获取到目标问题语句进行实体识别,例如基于百科网站或垂直站点提取、基于规则与词典的实体提取方法和基于统计机器学习的实体抽取方法等,从而从目标问题语句中自动识别出命名实体。由于实体是知识图谱中的最基本元素,其抽取的完整性、准确率、召回率等将直接影响到知识库问答的质量。因此,实体抽取是知识库问答中基础与关键的一步。

49.步骤204:根据所述至少一个第一预测实体和至少一个第二预测实体,确定所述目标问题语句对应的至少一个目标预测实体。

50.在本申请的实施例中,本申请对所述至少一个第一预测实体和至少一个第二预测进行实体融合操作,从而相互弥补不同实体命名识别方式之间的漏洞和不足,尤其是在通过不同实体命名识别方式识别出的预测实体之间存在包含或被包含的关系情况下,通过实体融合的方式确定出所述目标问题语句对应的至少一个目标预测实体。

51.步骤206:将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

52.本申请通过实体链接的方式将每个所述目标预测实体映射到所述知识库中所有可能的实体,具体而言,通过预设的实体链接表查询每个目标预测实体在所述知识库中对应的全部实体,所述实体链接表为一个txt格式的文本文件,查表的基本过程为:对于所述目标预测实体“a”,在实体链接表中从第一行开始,查询第一个词为“a”的实体,然后将包含该实体“a”及其属性信息的文本信息<a1_(xxxxxx)>返回作为候选实体,然后继续查询<a2_

(xxxxxx)>、<a3_(xxxxxx)>...<a

n

_(xxxxxx)>直到将所述实体链接表中所有有关目标预测实体“a”对应的实体链接后的实体全部找出,例如,所述目标问题语句为“诗人李白的祖籍是什么地方?”,经过步骤202和步骤204能够得到目标预测实体<李白>,经过实体链接表查询后会得到<李白_(唐朝著名诗人)>、<李白_(中国2010年邵警辉执导电视剧)>、<李白_(革命烈士)>

……

等在知识库中可能的全部实体。

53.在本申请的一个实施例中,如图3所示,所述步骤202具体包括步骤302至步骤304。

54.步骤302:获取目标问题语句,通过预训练的命名实体识别模型确定所述目标问题语句中的至少一个第一预测实体。

55.在上述实施例中,如图4所示,本申请通过预训练的命名实体识别模型预测所述目标问题语句中的至少一个第一预测实体,所述命名实体识别模型采用bert模型叠加条件随机场(crf)层的模型结构,通过bert模型对所述目标问题语句的进行特征表示,然后所述命名实体识别模型通过crf层输出所述目标问题语句中的每个字符对应为第一预测实体的概率,具体而言,每个字符可以对应三种标签b、标签i和标签o,其中,标签b表示一个实体的开始,标签i表示属于一个实体但不是开头,标签o表示非实体中的字符,crf层的输入是每个字符预测出的各个标签的概率,如“a”字符对应的输入可能为标签b:0.8,标签i:0.15,标签o:0.05,则crf层的输出的是每个字符预测的标签,即“a”字符对应的输出为标签b。

56.例如,所述目标问题语句为“信仰佛教的日本教育家是谁?”,经过crf层输出会输出每个字符对应的标签,“信(o)仰(o)佛(b)教(i)的(o)日(b)本(i)教(o)育(o)家(o)是(o)谁(o)?(o)”,最终通过实体命名识别模型得到<日本>和<佛教>两个第一预测实体;又例如,所述目标问题语句为“张三的身高是多少?”,经过crf层输出会输出每个字符对应的标签,“张(b)三(i)的(o)身(o)高(o)是(o)多(o)少(o)?(o)”,最终通过实体命名识别模型得到<张三>一个第一预测实体。

57.步骤304:将所述目标问题语句与存储在知识库中所有的实体进行规则匹配,确定所述目标问题语句中的对应在所述知识库中的至少一个第二预测实体。

58.本申请通过将所述目标问题语句与预设的知识库中所有实体进行匹配,找出所述目标问题语句中出现的所有知识库中存在的第二预测实体,例如,对于中文知识库,所述目标问题语句为“信仰佛教的日本教育家是谁?”,经过规则匹配后会得到<日本>、<佛教>、<教育家>三个第二预测实体。

59.本申请通过将实体识别模型与规则匹配方法结合,解决仅仅使用实体识别模型抽取不全或不准的情况

60.在本申请的一个实施例中,如图5所示,所述步骤204具体包括步骤502至步骤504。

61.步骤502:将所述至少一个第一预测实体与所述至少一个第二预测实体进行实体融合,生成至少一个第三预测实体。

62.在上述实施例中,如图6所示,所述步骤502具体包括步骤602至步骤610。

63.步骤602:在所述至少一个第二预测实体中存在与至少一个第一预测实体不相同的至少一个未预测实体的情况下,将所述未预测实体和第一预测实体共同作为第三预测实体。

64.具体而言,在目标问题语句为“信仰佛教的日本教育家是谁?”的情况下,经过命名实体识别模型预测后会输出<日本>和<佛教>两个第一预测实体,经过规则匹配后会得到<

日本>、<佛教>、<教育家>三个第二预测实体,可见,<教育家>没有出现在第一预测实体中,因此,需要将<日本>、<佛教>、<教育家>共同作为第三预测实体。

65.步骤604:在任一所述第二预测实体的文本语料与任一所述第一预测实体的文本语料存在包容关系的情况下,将所述第二预测实体与第一预测实体进行融合从而作为第三预测实体。

66.具体而言,如果任一所述第二预测实体的文本语料与任一所述第一预测实体的文本语料相比,其区别仅在于所述第二预测实体的文本语料的字符串长度大于第一预测实体的文本语料的字符串长度,则需要将所述第二预测实体与第一预测实体进行融合从而作为第三预测实体。例如,所述目标问题语句为“第五套人民币纸币的最小面额?”,通过命名实体识别模型识别出的第一预测实体为<第五套人民币>,通过规则匹配方法找出的第二预测实体为<第五套人民币纸币>,可见,<第五套人民币纸币>的字符串长度大于<第五套人民币>,也即是“第五套人民币纸币”包含了“第五套人民币”,因此要将实体识别结果更新为<第五套人民币纸币>。

67.步骤606:在任一所述第一预测实体的文本语料与任一所述第二预测实体的文本语料存在包容关系的情况下,判断所述第一预测实体是否为所述知识库中的实体;若是,则执行步骤608;若否,则执行步骤610。

68.步骤608:保留所述第一预测实体作为第三预测实体。

69.步骤610:保留所述第二预测实体作为第三预测实体。

70.具体而言,如果任一所述第一预测实体的文本语料与任一所述第二预测实体的文本语料存在包容关系,则需要判断所述第一预测实体是否为所述知识库中的实体,例如,所述目标问题语句为“万达董事长是谁?”,通过命名实体识别模型识别出的实体为<万达董事长>,规则匹配方法找出的实体为为<万达>,并且知识库中三元组为(万达,董事长,王健林),即<万达董事长>并不是所述知识库中的实体,其正确的实体为<万达>,因此将实体识别结果更新为<万达>。

71.步骤504:对所述至少一个第三预测实体进行过滤,从所述至少一个第三预测实体中筛选出至少一个目标预测实体。

72.具体而言,本申请会根据每个第三预测实体在所述知识库中对应的知识类别,将作为实体类别之外的其他数据类别对应的第三预测实体进行过滤。例如,所述目标问题语句为“功夫的主演是谁?”,通过命名实体识别模型得到的第一预测实体为<功夫>,通过知识库规则匹配得到的第二预测实体为<功夫>和<主演>,经过步骤502可能将<主演>加入到最终结果中,但是在此问题中<主演>在所述知识库中并不是一个实体而是关系,因此需要过滤掉多余的<主演>实体。

73.本申请通过在实体抽取部分将实体识别模型结果与规则匹配出的实体融合并过滤,一定程度上修正了实体识别模型的结果,并补充了实体识别模型没有识别出的实体。

74.在本申请的一个实施例中,如图7所示,在获取存储在知识库中的所述目标问题语句对应的至少一个候选实体之后,还包括步骤702至步骤704。

75.步骤702:获取每个所述候选实体对应的实体特征得分和相似度得分。

76.在上述实施例中,如图8所示,所述步骤702具体包括步骤802至步骤804。

77.步骤802:根据每个所述候选实体对应的实体特征,通过lightgbm算法确定每个所

述候选实体对应的实体特征得分。

78.本申请根据每个所述候选实体对应的实体特征,所述实体特征包括实体长度、实体是否在原文中出现或实体在知识库中出现频次等,然后使用调参算法(lightgbm算法),将实体特征作为输入,计算得到每个所述候选实体对应的实体特征得分,得分越高表示该实体越有可能是准确的且可以找到答案的实体。

79.步骤804:根据预训练的相似度计算模型获取每个候选实体与所述目标问题语句对应的相似度得分。

80.本申请再使用由bert模型与训练得到的相似度计算模型计算每个候选实体与所述目标问题语句对应的相似度得分,同样得分越高表示该候选实体越有可能是准确的且可以找到答案的实体。

81.步骤704:根据每个所述候选实体对应的实体特征得分和相似度得分,对至少一个候选实体进行排序。

82.本申请将每个所述候选实体对应的实体特征得分和相似度得分相加,然后使用最终得分将候选实体排序,即排在最高分的实体是最有可能是目标实体。

83.本申请在实体链接部分,通过将机器学习算法lightgbm和深度学习算法bert模型结合提高实体链接准确率,提升了候选实体排序效果,从而帮助提升了中文知识库问答总体的效果。

84.图9示出了本说明书一实施例的基于知识库问答的实体抽取方法,该基于知识库问答的实体抽取方法为例进行描述,包括步骤902至步骤916。

85.步骤902:获取目标问题语句,通过预训练的命名实体识别模型确定所述目标问题语句中的至少一个第一预测实体。

86.步骤904:将所述目标问题语句与存储在知识库中所有的实体进行规则匹配,确定所述目标问题语句中的对应在所述知识库中的至少一个第二预测实体。

87.步骤906:将所述至少一个第一预测实体与所述至少一个第二预测实体进行实体融合,生成至少一个第三预测实体。

88.步骤908:对所述至少一个第三预测实体进行过滤,从所述至少一个第三预测实体中筛选出至少一个目标预测实体。

89.步骤910:将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

90.步骤912:每个所述候选实体对应的实体特征,通过lightgbm算法确定每个所述候选实体对应的实体特征得分。

91.步骤914:根据预训练的相似度计算模型获取每个候选实体与所述目标问题语句对应的相似度得分。

92.步骤916:根据每个所述候选实体对应的实体特征得分和相似度得分,对至少一个候选实体进行排序。

93.与上述方法实施例相对应,本说明书还提供了基于知识库问答的实体抽取装置实施例,图10示出了本说明书一个实施例的基于知识库问答的实体抽取装置的结构示意图。如图10所示,该装置包括:

94.实体识别模块1001,被配置为获取目标问题语句并对所述目标问题语句进行实体

识别,分别确定所述目标问题语句中的至少一个第一预测实体和至少一个第二预测实体;

95.实体处理模块1002,被配置为根据所述至少一个第一预测实体和至少一个第二预测实体,确定所述目标问题语句对应的至少一个目标预测实体;

96.实体链接模块1003,被配置为将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

97.可选的,所述装置还包括:

98.得分计算模块,被配置为获取每个所述候选实体对应的实体特征得分和相似度得分;

99.实体排序模块,被配置为根据每个所述候选实体对应的实体特征得分和相似度得分,对至少一个候选实体进行排序。

100.可选的,所述实体识别模块1001包括:

101.命名实体识别单元,被配置为获取目标问题语句,通过预训练的命名实体识别模型确定所述目标问题语句中的至少一个第一预测实体;

102.规则匹配单元,被配置为将所述目标问题语句与存储在知识库中所有的实体进行规则匹配,确定所述目标问题语句中的对应在所述知识库中的至少一个第二预测实体。

103.可选的,所述实体处理模块1002包括:

104.实体融合单元,被配置为将所述至少一个第一预测实体与所述至少一个第二预测实体进行实体融合,生成至少一个第三预测实体;

105.实体过滤单元,被配置为对所述至少一个第三预测实体进行过滤,从所述至少一个第三预测实体中筛选出至少一个目标预测实体。

106.可选的,所述实体融合单元还被配置为:

107.在所述至少一个第二预测实体中存在与至少一个第一预测实体不相同的至少一个未预测实体的情况下,将所述未预测实体和第一预测实体共同作为第三预测实体;

108.在任一所述第二预测实体的文本语料与任一所述第一预测实体的文本语料存在包容关系的情况下,将所述第二预测实体与第一预测实体进行融合从而作为第三预测实体;

109.在任一所述第一预测实体的文本语料与任一所述第二预测实体的文本语料存在包容关系的情况下,判断所述第一预测实体是否为所述知识库中的实体;

110.若是,则保留所述第一预测实体作为第三预测实体;

111.若否,则保留所述第二预测实体作为第三预测实体。

112.可选的,所述实体过滤单元还被配置为:

113.根据每个第三预测实体在所述知识库中对应的知识类别,将作为实体类别之外的其他数据类别对应的第三预测实体进行过滤。

114.可选的,所述得分计算模块包括:

115.梯度计算单元,被配置为根据每个所述候选实体对应的实体特征,通过lightgbm算法确定每个所述候选实体对应的实体特征得分;

116.相似度计算单元,被配置为根据预训练的相似度计算模型获取每个候选实体与所述目标问题语句对应的相似度得分。

117.本申请在实体抽取部分,通过将实体识别模型与规则匹配方法结合,解决仅仅使

用实体识别模型抽取不全或不准的情况。同时,通过在实体抽取部分将实体识别模型结果与规则匹配出的实体融合并过滤,一定程度上修正了实体识别模型的结果,并补充了实体识别模型没有识别出的实体。

118.本申请在实体链接部分,通过将机器学习算法lightgbm和深度学习算法bert模型结合提高实体链接准确率,提升了候选实体排序效果,从而帮助提升了中文知识库问答总体的效果。

119.需要说明的是,装置权利要求中的各组成部分应当理解为实现该程序流程各步骤或该方法各步骤所必须建立的功能模块,各个功能模块并非实际的功能分割或者分离限定。由这样一组功能模块限定的装置权利要求应当理解为主要通过说明书记载的计算机程序实现该解决方案的功能模块构架,而不应当理解为主要通过硬件方式实现该解决方案的实体装置。

120.本申请一实施例还提供一种计算设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机指令,所述处理器执行所述指令时实现以下步骤:

121.获取目标问题语句并对所述目标问题语句进行实体识别,分别确定所述目标问题语句中的至少一个第一预测实体和至少一个第二预测实体;

122.根据所述至少一个第一预测实体和至少一个第二预测实体,确定所述目标问题语句对应的至少一个目标预测实体;

123.将每个所述目标预测实体通过实体链接的方式映射到所述知识库中,获取存储在知识库中的所述目标问题语句对应的至少一个候选实体。

124.本申请一实施例还提供一种计算机可读存储介质,其存储有计算机指令,该指令被处理器执行时实现如前所述基于知识库问答的实体抽取方法的步骤。

125.上述为本实施例的一种计算机可读存储介质的示意性方案。需要说明的是,该计算机可读存储介质的技术方案与上述的基于知识库问答的实体抽取方法的技术方案属于同一构思,计算机可读存储介质的技术方案未详细描述的细节内容,均可以参见上述基于知识库问答的实体抽取方法的技术方案的描述。

126.上述对本说明书特定实施例进行了描述。其它实施例在所附权利要求书的范围内。在一些情况下,在权利要求书中记载的动作或步骤可以按照不同于实施例中的顺序来执行并且仍然可以实现期望的结果。另外,在附图中描绘的过程不一定要求示出的特定顺序或者连续顺序才能实现期望的结果。在某些实施方式中,多任务处理和并行处理也是可以的或者可能是有利的。

127.所述计算机指令包括计算机程序代码,所述计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。所述计算机可读介质可以包括:能够携带所述计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(rom,read

‑

only memory)、随机存取存储器(ram,random access memory)、电载波信号、电信信号以及软件分发介质等。需要说明的是,所述计算机可读介质包含的内容可以根据司法管辖区内立法和专利实践的要求进行适当的增减,例如在某些司法管辖区,根据立法和专利实践,计算机可读介质不包括电载波信号和电信信号。

128.需要说明的是,对于前述的各方法实施例,为了简便描述,故将其都表述为一系列的动作组合,但是本领域技术人员应该知悉,本申请并不受所描述的动作顺序的限制,因为

依据本申请,某些步骤可以采用其它顺序或者同时进行。其次,本领域技术人员也应该知悉,说明书中所描述的实施例均属于优选实施例,所涉及的动作和模块并不一定都是本申请所必须的。

129.在上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详述的部分,可以参见其它实施例的相关描述。

130.以上公开的本申请优选实施例只是用于帮助阐述本申请。可选实施例并没有详尽叙述所有的细节,也不限制该发明仅为所述的具体实施方式。显然,根据本说明书的内容,可作很多的修改和变化。本说明书选取并具体描述这些实施例,是为了更好地解释本申请的原理和实际应用,从而使所属技术领域技术人员能很好地理解和利用本申请。本申请仅受权利要求书及其全部范围和等效物的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1