基于知识蒸馏的鱼眼图像实时语义分割方法

1.本发明涉及的是一种计算机视觉与模式识别领域的技术,具体是一种基于知识蒸馏的鱼眼图像实时语义分割方法。

背景技术:

2.现有的语义分割方法大多基于深度神经网络,近年来一些针对复杂语义分割网络加速改进的方法包括:限制网络输入图像的尺寸,复杂网络能够在维持结构不变的情况下获得实时性的提升;降低网络的规模,通过修剪网络早期的通道或者丢弃某些阶段从而提升实时性。然而这些方法对网络实时性的提升均是以牺牲精度和降低泛化能力为代价,并没有使模型在实时性与准确性间达到一个很好的平衡。

技术实现要素:

3.本发明针对现有技术存在的上述不足,提出一种基于知识蒸馏的鱼眼图像实时语义分割方法,能够有效地在鱼眼图像语义分割过程中抑制环境中遮挡和光照强度等干扰的影响,对于输入的高分辨率图像可以在保证实时性的前提下大幅提升模型的精度。

4.本发明是通过以下技术方案实现的:

5.本发明涉及一种基于知识蒸馏的鱼眼图像实时语义分割方法,通过鱼眼图像构建数据集,训练教师语义分割模型,然后将教师语义分割模型中的复杂特征提取骨架替换为轻量级骨架后得到轻量级学生模型,通过数据集上训练轻量级学生模型;再构建基于知识蒸馏的输出迁移和特征迁移,在保持轻量级学生模型实时性情况下提升精度,在测试阶段,单独使用轻量级学生模型对测试图像进行基于知识蒸馏的鱼眼图像实时语义分割。

6.所述的提升精度,具体包括:输出迁移采用损失函数对教师语义分割模型与轻量级学生模型的输出的概率分别差异进行衡量,使得两者输出尽可能保持一致,特征迁移对教师语义分割模型与轻量级学生模型输出中间层特征图进行处理形成相似度注意力图,提取结构化信息,通过损失函数对齐教师语义分割模型与轻量级学生模型间的相似度注意力图完成结构化知识迁移。技术效果

7.本发明整体解决了现有语义分割技术在实时性与准确性直接难以平衡的问题;本发明利用参数规模更大的教师语义分割模型来辅助轻量级学生模型的训练,采用更换特征提取骨架的方式获得学生模型,由于具有相似的结构,学生模型可以更好地理解教师模型从数据集中获取的知识,更便于知识的迁移,能够在不降低输入图像分辨率的情况下兼具实时与准确的语义分割;通过输出迁移与特征迁移有效的提取教师语义分割模型的知识并迁移至轻量级学生模型,能够在不增加轻量级学生模型计算量的前提下提升其精度,使轻量级学生模型的实时性与准确性达到平衡。

8.相较于传统的知识蒸馏技术,本发明的特征迁移模块能够有效地将教师语义分割模型理解图像的结构化知识迁移至轻量级学生模型,获得比传统的输出蒸馏更大幅度的提

升。

附图说明

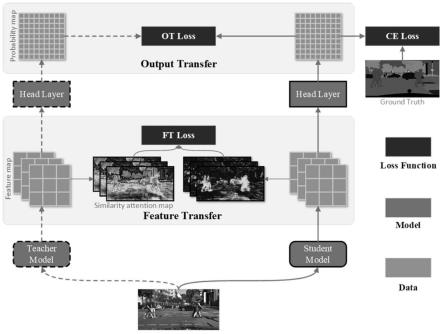

9.图1为本发明知识蒸馏的整体框架图;

10.图2为鱼眼摄像头采集的图像及语义分割示意图;

11.图3为采集数据集的类别分布示意图;

12.图4为实时语义分割软件设计流程图;

具体实施方式

13.如图1所示,为本实施例涉及一种基于知识蒸馏的鱼眼图像实时语义分割系统,包括:依次相连的教师语义分割模块、输出迁移模块、特征迁移模块和轻量级学生模块,其中:轻量级学生模块训练的过程中,输出迁移模块提取教师语义分割模块输出概率分布中的知识至轻量级学生模块,特征迁移模块通过提取教师语义分割模块中间层输出特征图中的结构化知识至轻量级学生模块。

14.本实施例涉及上述系统的基于知识蒸馏的鱼眼图像实时语义分割方法,通过对齐教师模型与学生模型间输出的差异,再生成相似度注意力图并将结构化的语义知识从教师模型迁移至学生模型,具体为:首先利用车载鱼眼摄像机采集街景图像并标注以构建数据集,在该数据集上训练参数规模庞大的教师模型,学生模型将教师模型中的复杂特征提取骨架替换为更轻量的骨架,利用本发明多的知识蒸馏框架将教师模型中的知识迁移至学生模型,实现学生模型在实时性不变的情况下提升精度。

15.本实施例具体包括以下步骤:

16.第一步、利用车载鱼眼摄像头采集图像构建数据集,训练实时性不佳但精度高的教师语义分割模型:

17.所述的数据集中的图片由安装在无人驾驶车辆上的摄像头在真实街景环境下采集,在无人驾驶车辆的前后左右四个方向设置四个摄像头分别用来采集各个方向上的街景图片。采集图像分辨率大小为1920*1080,根据图像内的物体类别将像素标注为18类,构建有600张像素级标注图片的数据集,其中350张图片作为训练集;150张作为验证集,100张图片作为测试集。数据集中各类别的分布情况如图2所示。

18.所述的教师语义分割模型采用bisenet为基本网络框架,其特征提取骨架采用在imgnet上经过预训练的resnet18深度网络,并采用辅助损失函数来监督网络训练的过程,具体为:其中:lm为用于监督最终分类结果的主损失函数,x为最终预测结果,w为网络参数,li为用于监督第i阶段的辅助损失函数,xi为模型第i阶段输出的特征,α为用于结合二者的超参数,以上损失均为softmax损失。

19.所述的训练,将数据集中的图片在训练时采用数据增强操作,在输入教师语义分割模型前进行均值归一化、随机水平翻转和随机尺度变换等增强处理。

20.所述的随机尺度变换大小包括0.75、1.0、1.5、1.75、2.0。最终对增强后的图片进行随机裁剪为固定尺寸后进行训练。

21.所述的训练,采用批次梯度下降算法(sgd),在训练中引入动量方法(momentum)与

权重衰减(weightdecay)对于批次梯度下降算法进行优化。训练中的学习率采用poly变化策略,具体为:其中:lr0是初始学习率,iter为当前迭代次数,max_iter为最大迭代次数,power为衰减指数;训练完成后采用平均交并比对教师模型的精度进行衡量,具体为:其中:p

ij

代表标签属于第i类被预测为j类的像素数,p

ii

为预测正确的像素数,p

ij

为假正数(falsepositives)即将第i类错误预测为其他类别的像素数,p

ji

为假负数(falsenegatives)即将其他类别错误预测为第i类的像素数。

22.第二步、将教师语义分割模型中的复杂特征提取骨架替换为轻量级骨架,在第一步的数据集上训练改进后的轻量级网络,具体为:将教师语义分割模型中的复杂特征提取骨架resnet18替换为经过imgnet预训练的resnet系列或者xception系列网络并作为轻量级学生模型,然后由第一步的数据集进行训练。

23.所述的轻量级学生模型的训练与第一步中教师语义分割模型的训练方式相同。

24.第三步、通过基于知识蒸馏的输出迁移处理,采用损失函数对教师语义分割模型与轻量级学生模型的输出概率分布差异进行衡量,使得两者输出尽可能保持一致,再通过基于知识蒸馏的特征迁移处理,对教师语义分割模型与轻量级学生模型输出中间层特征图进行处理形成相似度注意力图,提取结构化信息,通过损失函数对齐教师语义分割模型与轻量级学生模型间的相似度注意力图完成结构化知识迁移。

25.所述的输出迁移处理,通过l2损失函数实现,具体为:其中:i为教师语义分割模型与轻量级学生模型中对应图片位置的索引集合,分别为轻量级学生模型和教师语义分割模型在softmax层前输出的logits,本发明以logits此来提取输出概率分布中的知识。

26.所述的特征迁移处理,具体为:其中:as(φ)、a

t

(φ)分别为轻量级学生模型和教师语义分割模型输出的相似度注意力图,模型中间层特征图生成相似度注意力图的过程为:其中:a(φ)

ij

为特征图中第i个特征与第j个特性间的相似度,φi为特征图中的第i个向量。

27.所述的结构化知识迁移是指:教师语义分割模型通过输出迁移与特征迁移对轻量级学生模型进行模型指导,在训练过程中教师语义分割模型参数保持不变,轻量级学生模型在原始softmax损失、输出迁移损失和特征迁移损失三者的监督下进行参数的更新,超参数α和β的设置应使三个损失函数保持在同一数量级;在轻量级学生模型的训练过程中原有的softmax损失函数基础上,增加输出迁移损失函数与特征迁移损失函数,具体为:l

total

(s)=l

ce

(s)+αl

ot

(s)+βl

ft

(s),其中:l

ce

为轻量级学生模型的单独训练的损失函数,l

ot

为输出迁移损失函数,l

ft

为特征迁移损失函数,α和β为用来调节损失对网络训

练贡献大小的超参数。

28.第四步、在测试阶段,单独使用经第三步优化的轻量级学生模型对测试图像进行分割,获得尺寸为原图大小1/8的分割结果,通过双线性差值将最终结果上采样至输入图像尺寸。

29.本实施例通过实验对方法的有效性进行说明。训练的数据集有车载环视摄像头采集并被标注为18个类别,如图2所示。利用基于resnet18的bisenet指导基于xception39的bisenet训练,在训练的过程中,超参数的设置为,α=10,β=1000,lr0=0.1,power=0.9,batch size=16。不同模块对分割效果的提升如图2所示,实验结果如表1所示。

30.表1bisenet系列模型蒸馏实验表1bisenet系列模型蒸馏实验

31.表1是bisenet在采集的鱼眼图像数据集下的实验结果,基于xception39的bisenet1在基于resnet18的bisenet2输出分布的指导下进行训练,采用了l2输出迁移损失函数对齐二者的输出分布。基于xception39的bisenet1在基于resnet18的bisenet2的输出迁移指导下的平均交并比为73.7%,比单独训练的bisenet1提高了0.8%。在此基础上进一步增加本发明设计的特征迁移蒸馏方案进行训练后,bisenet1的平均交并比提升至74.6%,两部分的蒸馏一共使学生模型的平均交并比提高了1.7%。

32.本实施例中将蒸馏的模型部署至nvidiajetsonxavier嵌入式平台,利用嵌入式平台实现了真实环境下的实时语义分割,速度达到了14fps,证实本发明的语义分割方法兼具准确性与实时性。模型实时性的测试如表2所示。

33.表2模型在nvidiajetsonxavier嵌入式平台上实时性比较模型骨架测试平台输入大小fpsbisenet1xception39xavier1920*108014.0bisenet2resnet18xavier1920*10806.6

34.为了提高现有实时语义分割网络的分割性能,本发明基于知识蒸馏技术设计了一套针对语义分割网络的训练方案,在实现实时语义分割的基础上,借助复杂精确的教师语义分割模型通过输出迁移与特征迁移两个方面的蒸馏训练得到更高性能的实时轻量级学生模型。本发明能够有效地提取复杂教师语义分割模型中的知识并迁移至轻量级学生模型,在大幅提升轻量级语义分割模型精度的同时没有任何计算量的增加,具有应用灵活,精度提升明显等优点。

35.与现有技术相比,本发明通过设计的知识蒸馏框架在不改变实时性的前提下提升了现有语义分割模型的准确性。从实施例可以看出,表1是bisenet在采集的鱼眼图像数据集下的实验结果,基于xception39的bisenet1在基于resnet18的bisenet2输出分布的指导下进行训练,采用了l2输出迁移损失函数对齐二者的输出分布。基于xception39的

bisenet1在基于resnet18的bisenet2的输出迁移指导下的平均交并比为73.7%,比单独训练的bisenet1提高了0.8%。在此基础上进一步增加本发明设计的特征迁移蒸馏方案进行训练后,bisenet1的平均交并比提升至74.6%,两部分的蒸馏一共使学生模型的平均交并比提高了1.7%,在精度提升的同时学生模型的计算量没有任何增加。

36.上述具体实施可由本领域技术人员在不背离本发明原理和宗旨的前提下以不同的方式对其进行局部调整,本发明的保护范围以权利要求书为准且不由上述具体实施所限,在其范围内的各个实现方案均受本发明之约束。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1