交互方法、设备及存储介质与流程

1.本技术涉及人工智能技术领域,尤其涉及一种交互方法、设备及存储介质。

背景技术:

2.随着人工智能技术的不断发展,机器人等自主移动设备被广泛应用于工业、农业及人们的日常生活中。例如,扫地机器人等智能清洁设备被应用于人们日常清洁中。

3.为了提高用户体验,智能清洁设备一般在家中无人时进行清扫;家中有人时则处于充电模式,使用户尽可能看不到其庞大体积。但是,这种工作模式失去了与用户的交互性。

技术实现要素:

4.本技术的多个方面提供一种交互方法、设备及存储介质,用以提高智能设备的交互性。

5.本技术实施例提供一种交互方法,适用于设置于目标场所的智能设备,包括:

6.获取用户与目标场所之间的位置状态关系;

7.当所述位置状态关系示意用户位于所述目标场所,执行指定动作。

8.本技术实施例还提供一种交互方法,适用于物联网设备,包括:

9.获取用户与目标场所的位置状态关系;

10.将所述位置状态关系提供给智能设备,以供所述智能设备当所述位置状态关系示意用户位于所述目标场所,执行指定动作。

11.本技术实施例还提供一种智能设备,包括:机械本体;所述机械本体上存储器和处理器;其中,所述存储器,用于存储计算机程序;

12.所述处理器耦合至所述存储器,用于执行所述计算机程序以用于执行上述智能设备执行的交互方法中的步骤。

13.本技术实施例还提供一种物联网设备,包括:存储器、处理器和通信组件;其中,所述存储器,用于存储计算机程序;

14.所述处理器耦合至所述存储器和所述通信组件,用于执行所述计算机程序以用于执行权上述物联网设备执行的交互方法中的步骤。

15.本技术实施例还提供一种存储有计算机指令的计算机可读存储介质,当所述计算机指令被一个或多个处理器执行时,致使所述一个或多个处理器执行上述各交互方法中的步骤。

16.在本技术实施例中,智能设备可获取用户与智能设备所在的物理场所之间的位置状态关系;并可在用户位于智能设备所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性。

附图说明

17.此处所说明的附图用来提供对本技术的进一步理解,构成本技术的一部分,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:

18.图1-图3为本技术实施例提供的交互方法的流程示意图;

19.图4a和图4b为本技术实施例提供的交互系统的结构示意图;

20.图5-图7为本技术实施例提供的另一些交互方法的流程示意图;

21.图8a为本技术实施例提供的扫地机的结构示意图;

22.图8b为本技术实施例提供的智能设备的结构示意图;

23.图9为本技术实施例提供的物联网设备的结构示意图。

具体实施方式

24.为使本技术的目的、技术方案和优点更加清楚,下面将结合本技术具体实施例及相应的附图对本技术技术方案进行清楚、完整地描述。显然,所描述的实施例仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

25.针对智能扫地机等智能设备与用户之间交互性较差的技术问题,在本技术一些实施例中,智能设备可获取用户与智能设备所在的物理场所之间的位置状态关系;并可在用户位于智能设备所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性。

26.以下结合附图,详细说明本技术各实施例提供的技术方案。

27.应注意到:相同的标号在下面的附图以及实施例中表示同一物体,因此,一旦某一物体在一个附图或实施例中被定义,则在随后的附图和实施例中不需要对其进行进一步讨论。

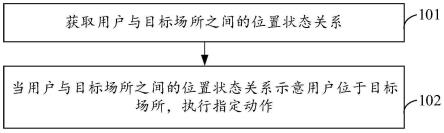

28.图1为本技术实施例提供的交互方法的流程示意图。如图1所示,交互方法包括:

29.101、获取用户与目标场所之间的位置状态关系。

30.102、当用户与目标场所之间的位置状态关系示意用户位于目标场所,执行指定动作。

31.本实施例提供的交互方法可适用于设置于目标场所的智能设备。在本技术实施例中,不限定智能设备的具体实现形式。在一些实施例中,智能设备可为自主移动设备,如智能机器人、智能玩具等。其中,智能机器人可为智能扫地机器人(可简称扫地机)、智能玩具车或智能宠物等。在另一些实施例中,智能设备可为智能家居设备,如智能音箱、智能电视、智能灯、智能锁或智能摄像头等。在本实施例中,目标场所是指智能设备所在的物理场所。例如,对于家用扫地机来说,目标场所是指用户的家;对于商超用扫地机来说,目标场所为商超;对于餐厅用扫地机来说,目标场所为餐厅;等等。

32.对于一些智能设备,一般在目标场所无人时进行作业,有人时则处于待机模式,尽可能不打扰目标场所中的用户。但是,这种工作模式失去了与用户的交互性。例如,在实际应用中,扫地机一般在目标场所无人时进行清扫;有人时则处于充电模式,使用户尽可能看不到其庞大体积。但是,这种工作模式失去了与用户的交互性。

33.在本实施例中,为了提高智能设备的交互性,在步骤101中,可获取用户与目标场

所之间的位置状态关系。其中,用户与目标场所之间的位置状态关系是指可反映用户与目标场所之间的位置关系的信息,例如,可以包括:用户是否位于目标场所,和/或,用户是否到达目标场所,和/或,用户与目标场所之间的距离等等。对于智能设备来说,为了增强交互性,在确定用户与目标场所之间的位置状态关系示意用户位于目标场所的情况下,可在步骤102中执行指定动作。

34.在本技术实施例中,不限定指定动作的实现形态。例如,智能设备为自主移动设备来说,则可在用户位于目标场所的情况下,移动至指定区域。可选地,自主移动设备可切换至低噪声模式移动至指定区域。低噪声是指运行噪声小于或等于预设的噪声阈值。例如,扫地机在确定用户到家的情况下,从当前位置移动至门口或客厅,迎接用户回家等。

35.可选地,自主移动设备可沿规划的导航路线,移动至指定区域。其中,导航路线可为自主移动设备在移动之前已规划好的,也可为在向指定区域移动过程中,边移动边规划的。可选地,自主移动设备可获取目标场所的环境信息,并根据目标场所的环境信息,规划到指定区域的导航路径。具体地,其中,所采用的路径规划算法包括但不局限于:启发式搜索、反向增量式搜索算法等。

36.启发式搜索算法可在搜索过程中建立启发式搜索规则,来衡量搜索位置和目标位置之间的距离关系,使搜索方式优先查询目标点所处位置的方向,可提高搜索效果。在本技术实施例中,目标位置是指指定区域位置;搜索位置是指自主移动设备的当前位置。启发式搜索算法的思想主要是引入当前搜索节点x的估计函数f(x),其中,估计函数f(x)可表示为:

37.f(x)=g(x)+h(x)

ꢀꢀꢀ

(1)。

38.在上述式(1)中,g(x)是指从起始点到当前搜索节点x的实际距离;h(x)是指从当前搜索节点x到目标位置的最小距离估计。在本实施例中,起始点可为自主移动设备的出发点。其中,h(x)可采用欧式距离、余弦距离或曼哈顿距离等进行度量。

39.基于上述式(1),自主移动设备在利用启发式搜索算法进行路线规划时,可从出发位置开始计算出发位置的每一个子节点的f值,即上述式(1)的值,从出发位置的子节点中,选择f值最小的子节点作为出发位置的下一点;再按照相同的方式,确定出发位置的下一点的子节点,往复迭代,直至下一子节点为目标位置,即指定区域位置。其中,确定出的每一个子节点连同出发位置和指定区域位置形成的路线,即为规划的导航路线。

40.反向增量式搜索算法是在启发式搜索算法的基础上提出改良。反向是指从目标位置开始向起始位置逐步搜索;增量式搜索是指在搜索过程中计算每个节点x的距离度量信息d(x)。其中,其中,距离度量信息d(x)可表示为:

41.d(x)=d(y)+d(y,x)

ꢀꢀꢀ

(2)。

42.在式(2)中,d(y)表示节点y到目标位置的实际距离;d(y,x)表示节点x到节点y的实际距离。

43.对于反向增量式搜索算法可从指定区域开始计算指定区域位置的每一个子节点的f值,即上述式(1)的值,从指定区域位置的子节点中,选择f值最小的子节点作为指定区域位置的下一点;再按照相同的方式,确定指定区域位置的下一点的子节点,往复迭代,直至下一子节点为起始位置,即自主移动设备出发位置。其中,确定出的每一个子节点连同出发位置和指定区域位置形成的路线,即为规划的初始导航路线。

44.自主移动设备可沿着初始导航路线移动,在移动过程中,若出现障碍物导致自主移动设备无法继续沿初始导航路线移动,自主移动设备可利用反向增量式搜索算法根据初始导航路径未经过的每个点的距离度量信息,重新进行路线规划。具体实现为:假设自主移动设备在位置x探索到节点x在初始导航路线的下一节点存在障碍物,则自主移动设备首先计算当前位置x到指定区域位置的实际距离,并计算节点x的新的子节点y与节点x之间的距离,从节点x的新的子节点y中,选择f值最小的子节点作为节点x的新的下一点,反复迭代,直至下一子节点为指定区域位置,得到新的导航路线。

45.又例如,在另一些实施例中,自主移动设备可在用户到达目标场所的情况下,沿规划的导航路线向指定区域移动,并在向指定区域移动过程中完成设定的动作。例如,自主移动设备可沿导航路线向指定区域移动,并在向指定区域移动过程中播放设定的音频(如音乐、语音等);又例如,自主移动设备可沿规划的导航路线向指定区域移动,并在向指定区域移动过程中完成设定的机械动作(如舞蹈动作、俯仰动作等);又例如,对于扫地机可沿规划的导航路线向指定区域移动,并在向指定区域移动过程中报告当天的清洁状态等等。

46.又例如,自主移动设备可在用户位于目标场所的情况下,沿规划的导航路线到达指定区域,并在指定区域完成设定的动作。例如,在到达指定区域时,播放设定的音频(如音乐、语音等)、完成设定的机械动作(如舞蹈动作、俯仰动作等);或者针对扫地机,还可在指定区域报告当天的清洁状态等等。

47.其中,上述指定区域为智能设备在确定用户位于目标场所时,与用户进行交互的区域。该指定区域可为预先设置的区域。如门口、客厅等。在一些实施例中,指定区域可为预设的指定区域,如智能设备系统默认的区域,或者为用户自主设置的指定区域,或者为从云端获取的指定区域。对于由用户自主设置的指定区域,智能设备或智能设备对应的助手app可提供交互区域设置控件,用户可通过该控件设置指定区域。相应地,智能设备可响应于针对交互区域的设置操作,将该设置操作设置的区域作为指定区域。或者装载有智能设备对应的助手app的用户终端设备响应于针对交互区域的设置操作,将该设置操作设置的区域作为指定区域,并将指定区域发送给智能设备。

48.进一步,智能设备在完成指定动作之后,还可沿规划的导航路线返回出发位置。其中,智能设备的出发位置可为充电座处,或者,或者为放置智能设备的位置等等。对于扫地机,出发位置还可为扫地机原先执行清洁任务的区域等,但不限于此。

49.在另一些实施例中,自主移动设备可实现为迎宾机器人。该迎宾机器人可为商铺使用的机器人,也可为公司使用的机器人。对于商铺使用的机器人的场景,目标场所为迎宾机器人所服务商铺,可在顾客与目标场所之间的位置状态关系示意顾客位于目标场所时,执行指定动作。如发出“欢迎光临”的语音等。对于公司使用的机器人的场景,目标场所为迎宾机器人所服务的办公室,可在公司员工与办公室之间的位置状态关系示意公司员工位于目标场所时,执行指定动作,如移动至指定区域,欢迎员工等。

50.在本实施例中,智能设备可获取用户与智能设备所在的物理场所之间的位置状态关系;并可在用户位于智能设备所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性,有助于提高用户体验。

51.在本技术实施例中,智能设备可自动感测用户与目标场所之间的位置状态关系,也可与其它设备进行通信,从其它智能设备处获取用户与目标场所之间的位置状态关系。

其中,其它设备可为与智能设备处于同一物理场所的其它智能设备,如物联网(internet of things,iot)设备,或者云端设备,如智能设备或iot设备中运行的应用程序对应的服务端设备等。下面对智能设备获取用户与目标场所之间的位置状态关系的实施方式进行示例性说明。

52.实施方式1:智能设备上安装有感测器。如图2所示,步骤101的一种实施方式为:步骤201,利用感测器确认用户与目标场所之间的位置状态关系。其中,感测器的实现形式不同,确认用户与目标场所之间的位置状态关系的实施方式不同。下面以几种感测器为例,对利用感测器确认用户与目标场所之间的位置状态关系的实时方式进行示例性说明。

53.实施方式a1:在一些实施例中,智能设备具有语言识别功能。用户在到达目标场所时,可发出“我回来了”等语音。在该实施方式a1中,智能设备设置有麦克风。相应地,可利用麦克风拾取语音信号;并根据语音信号确定用户与目标场所之间的位置状态关系。

54.在一些实施例中,智能设备可针对到达目标场所,并发出“我回来了”等语音的用户进行交互。相应地,在根据语音信号确定用户与目标场所之间的位置状态关系时,可对麦克风拾取的语音信号进行语音识别,得到语音识别结果;当语音识别结果反映用户到达目标场所,确定用户与目标场所之间的位置状态关系为用户到达目标场所。

55.在另一些实施例中,智能设备可针对特定用户进行交互。在该实施例中,智能设备可预先获取指定用户的语音;并对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储。相应地,在对语音信号进行语音识别之前,还可对语音信号进行声纹识别,以得到语音信号的声纹特征。进一步,判断语音信号的声纹特征是否与指定用户的声纹特征相匹配。当判断结果为是,则对语音信号进行语音识别,得到语音识别结果;当语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系示意指定用户位于目标场所。进一步,可在确定指定用户位于目标场所的情况下,完成指定动作。其中,关于完成指定动作的具体实施方式,可参见上述实施例的相关内容,在此不再赘述。

56.实施方式a2:针对一些物理场所来说,用户白天离开该场所,晚上回来。例如,用户早上离家上班,晚上下班回家等。晚上回家会开灯。灯光与自然光的光学特征不同。因此,可在智能设备上设置光线感测器,该光线感测器可感测目标场所的光线的光学特征。其中,光线的光学特征可包括:光线的光谱、光强分布、波长、色温以及紫外线含量等中的一种或多种。多种是指2种或2种以上。相应地,可获取光线感测器感测到的目标场所的光线的光学特征;并根据光线的光学特征,确定用户与目标场所之间的位置状态关系。

57.可选地,当感测到的光线的光学特征符合灯光的光学特征,确定用户与目标场所的位置状态关系示意用户位于目标场所。例如,感测到的光线的波长属于灯光的波长范围;又例如,感测到的光线的光谱符合灯光的光谱特征等等,则确定用户与目标场所的位置状态关系示意用户位于目标场所。

58.实施方式a3:针对一些物理场所来说,用户在一定时间段离开,该场所无人;在另外时间段回来,该场所有人。例如,用户早上离家上班,家中无人;晚上下班回家,家中人回来。又例如,某超市、商店或餐厅,员工下班时间离开,这些场所中无人;员工上班时间到店,店中有人等。基于此,智能设备上可设置视觉传感器,视觉传感器可采集目标场所的图像。其中,视觉传感器可为摄像头、激光传感器等。相应地,在利用感测器感测用户与目标场所的位置状态关系时,可利用视觉传感器采集目标场所的图像;对目标场所的图像进行主体

识别,以得到主体识别结果;并根据主体识别结果,确定用户与目标场所之间的位置状态关系。

59.在一些实施例中,智能设备可针对到达目标场所的用户进行交互。相应地,当主体识别结果为目标场所的图像中的主体包括人,确定用户与目标场所之间的位置状态关系示意用户到达目标场所。

60.在另一些实施例中,智能设备可针对特定用户进行交互。在该实施例中,智能设备可预先采集指定用户的面部图像;并对指定用户的面部图像进行特征提取,得到指定用户的面部特征并存储。相应地,当主体识别结果为目标场所的图像中的主体包括人,从目标场所的图像中获取面部图像;并对面部图像进行人脸识别,以得到面部特征。当面部特征为指定用户的面部特征,确定用户与目标场所之间的位置状态关系示意指定用户到达目标场所。进一步,可在确定指定用户到达目标场所的情况下,完成指定动作。其中,关于完成指定动作的具体实施方式,可参见上述实施例的相关内容,在此不再赘述。

61.基于上述实施方式a1-a3,在利用感测器确认用户与目标场所之间的位置状态关系为用户或指定用户位于目标场所,可在步骤202中,执行指定动作。其中,关于执行指定动作的描述,可参见上述步骤102的相关内容,在此不再赘述。

62.实施方式2:用户的终端设备可安装智能设备对应的应用程序,如助手app等。其中,终端设备可为智能手机、平板电脑或智能可穿戴设备(如智能手表、手环、智能眼镜或智能耳机等)等。用户可通过终端设备上的应用程序告知智能设备用户要去目标场所。如用户要回家等。

63.在实施方式2中,用户的终端设备可获取用户移动至目标场所的关联信息。其中,用户移动至目标场所的关联信息是指可反映用户与目标场所之间的位置状态关系的信息。例如用户移动至目标场所的关联信息可包括:用户预计到达目标场所的时间、用户的实时定位信息等,但不限于于此。

64.进一步,用户的终端设备可将用户移动至目标场所的关联信息提供给智能设备。确切地说是,终端设备将用户移动至目标场所的关联信息提供给云端,云端将用户移动至目标场所的关联信息发送给智能设备。相应地,如图3所示,步骤101的另一种实施方式为步骤301,即获取用户移动至目标场所的关联信息,并在步骤302中,根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系。

65.在实施方式2中,用户的终端设备可自主定位,并将其实时定位信息提供给智能设备。确切地说是,终端设备将实时定位信息提供给云端;云端将用户终端的实时定位信息发送给智能设备。用户移动至目标场所的关联信息可为用户终端的实时定位信息。相应地,步骤101的另一种实施方式为:获取用户的终端设备的实时定位信息;并根据终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系。可选地,可根据用户终端的实时定位信息和目标场所的地理位置信息,计算用户终端与目标场所之间的距离。当用户终端与目标场所之间的距离小于或等于设定的距离阈值,则确定终端设备对应的用户与目标场所之间的位置状态关系示意用户到达目标场所。或者,可将终端设备的实时定位信息在目标场所的地理位置信息中进行匹配,当终端设备的实时定位信息落入目标场所的地理位置信息限定的区域,则确定终端设备对应的用户与目标场所之间的位置状态关系为用户位于目标场所。

66.或者,在实施方式2中,也可由云端确定用户与目标场所之间的位置状态关系。用户的终端设备将实时定位信息提供给云端,云端根据终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系,并将用户与目标场所之间的位置状态关系提供给智能设备。云端确定用户与目标场所之间的位置状态关系的具体实施方式,可参见智能设备确定用户与目标场所之间的位置状态关系的相关内容,在此不再赘述。相应地,步骤101的另一种实施方式为:接收云端根据用户的终端设备的实时定位信息确定出的用户与目标场所之间的位置状态关系。

67.进一步,当用户与目标场所之间的位置状态关系示意用户位于目标场所,可在步骤303中,执行指定动作。其中,关于执行指定动作的描述,可参见上述步骤102的相关内容,在此不再赘述。

68.基于上述实施方式2,对于智能设备来说,为了在用户到达目标场所之前完成一些预设操作。例如,对于智能设备实现为扫地机的实施例来说,扫地机可在用户到达目标场所之前打扫干净目标场所,为用户提供干净的环境等。基于此,智能设备还可根据用户的终端设备的实时定位信息及目标场所的地理位置信息,计算用户与目标场所之间的距离。当用户与目标场所之间的距离小于或等于设定距离阈值,执行预设操作。例如,扫地机可根据用户的终端设备的实时定位信息及目标场所的地理位置信息,计算用户与目标场所之间的距离。当用户与目标场所之间的距离小于或等于设定距离阈值,提高清洁速度,以在用户到达目标场所前完成清洁任务。

69.实施方式3:如图4a所示,在一些实施例中,目标场所除了智能设备11之外,还可部署其它智能设备12,如iot设备。其中,智能设备11可为扫地机,其它智能设备12可为智能电器或智能家居,如智能锁、智能灯、智能冰箱、智能音箱、智能窗帘或智能空调等,但不限于此。图4a和图4b仅以其它智能设备12为智能音箱和智能锁为例进行图示,但不构成限定。

70.在实施方式3中,如图4a和图4b所示,其它智能设备12可感测用户与目标场所之间的位置状态关系,并在用户到达目标场所的情况下,向智能设备11发送用户到达信息。在一些实施例中,智能设备11与其它智能设备12通过点对点(p2p)通讯方式连接。其中,点对点通讯方式可为蓝牙连接、红外线连接或者wifi直连等。相应地,如图4a所示,其它智能设备12可通过点对点通讯机制将用户到达信息直接发送给智能设备11。

71.在另一些实施例中,如图4b所示,智能设备11与其它智能设备12采用wifi或移动网络等方式通信连接,相应地,移动网络的网络制式可以为2g(gsm)、2.5g(gprs)、3g(wcdma、td-scdma、cdma2000、utms)、4g(lte)、4g+(lte+)、5g、wimax等中的任意一种。相应地,其它智能设备12可将用户到达信息发送给云端13,云端13接收用户到达信息,并将用户到达信息发送给智能设备11。

72.基于上述实施方式3,步骤101的一种可选实施方式为:监测是否接收到目标场所内的其它智能设备发送的用户到达信息;当接收到其它智能设备发送的用户到达信息,则确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

73.进一步,在确定用户位于目标场所的情况下,即监测到其它智能设备发送的用户到达信息的情况下,可执行指定动作。关于执行指定动作的描述,可参见上述步骤102的相关描述内容,在此不再赘述。

74.基于上述实施方式3,本技术实施例还提供一种交互方法,适用于设置于目标场所

的iot设备。如图5所示,该方法包括:

75.501、获取用户与目标场所之间的位置状态关系。

76.502、将位置状态关系提供给目标场所的智能设备,以供该智能设备当在位置状态关系示意用户位于目标场所,执行指定动作。

77.在本实施例中,iot设备设置于目标场所,可获取用户与目标场所之间的位置状态关系;并将用户与目标场所之间的位置状态关系提供给设置于该目标场所的智能设备,如扫地机等。这样,智能设备可在确定用户与目标场所之间的位置状态关系示意用户位于目标场所的情况下,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性。

78.在本实施例中,不限定iot设备向智能设备提供的用户与目标场所之间的位置状态关系的实现形式。在一些实施例中,如上图4a和图4b所示,iot设备可发送反映用户与目标场所之间的位置状态关系的信息,如指令等,来实现将用户与目标场所之间的位置状态关系发送给智能设备。例如,iot设备可在用户与目标场所之间的位置状态关系示意用户位于目标场所的情况下,向智能设备提供用户到达信息。相应地,智能设备在接收到用户到达信息的情况下,可确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

79.在另一些实施例中,iot设备也可将描述用户与目标场所之间的位置状态关系的信息发送给智能设备。这样,智能设备可从这些信息中获取用户与目标场所之间的位置状态关系。

80.在本技术实施例中,iot设备安装有感测器。如图6所示,在步骤601中,可利用感测器确认用户与目标场所之间的位置状态关系;并将感测到的用户与目标场所之间的位置状态关系提供给智能设备。可选地,iot设备与智能设备可通过p2p通讯机制通信。相应地,步骤602可实现为通过p2p通讯机制将用户与目标场所之间的位置状态关系提供给智能设备。或者,也可将用户与目标场所之间的位置状态关系提供给云端,由云端将用户与目标场所之间的位置状态关系发送给智能设备。

81.其中,iot设备的实现形态不同,部署的感测器不同,感测用户与目标场所之间的位置状态关系的实施方式不同。下面结合几种iot设备及iot设备对利用感测器确认用户与目标场所之间的位置状态关系的具体实施方式进行示例性说明。

82.实施方式b1:iot设备可设置有麦克风和语音识别模块。iot设备可实现为智能电器。如智能音箱、智能空调、智能冰箱、智能电视或智能灯等,但不限于此。相应地,对于设置有麦克风和语音识别模块的iot设备,用户在到达目标场所时,可发出“我回来了”等语音。在该实施方式a1中,智能设备设置有麦克风。相应地,可利用麦克风拾取语音信号,并根据语音信号确定用户与目标场所之间的位置状态关系。

83.在一些实施例中,智能设备可针对到达目标场所,并发出“我回来了”等语音的用户进行交互。相应地,在根据语音信号确定用户与目标场所之间的位置状态关系时,可对麦克风拾取的语音信号进行语音识别,得到语音识别结果。当语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系示意用户位于目标场所,并将用户到达信息发送给智能设备。

84.在另一些实施例中,智能设备可针对特定用户进行交互。在该实施例中,iot设备可预先获取指定用户的语音;并对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储。相应地,在对语音信号进行语音识别之前,iot设备还可对语音信号进行声纹识

别,以得到语音信号的声纹特征。进一步,判断语音信号的声纹特征是否与指定用户的声纹特征相匹配,若判断结果为是,则对语音信号进行语音识别,得到语音识别结果;若语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系为指定用户位于目标场所。进一步,可在指定用户位于目标场所的情况下,向智能设备发送用户到达信息。

85.实施方式b2:基于上述实施方式a3的相关描述。iot设备可设置视觉传感器。iot设备可摄像头或智能电器。如智能音箱、智能空调、智能冰箱、智能电视或智能灯等,但不限于此。在利用感测器感测用户与目标场所的位置状态关系时,可利用视觉传感器采集目标场所的图像;对目标场所的图像进行主体识别,以得到主体识别结果;并根据主体识别结果,确定用户与目标场所之间的位置状态关系。

86.在一些实施例中,智能设备可针对到达目标场所的用户进行交互。相应地,当主体识别结果为目标场所的图像中的主体包括人,确定用户与目标场所之间的位置状态关系为用户位于目标场所,并将用户到达信息提供给智能设备。

87.在另一些实施例中,智能设备可针对特定用户进行交互。在该实施例中,智能设备可预先采集指定用户的面部图像,并对指定用户的面部图像进行特征提取,得到指定用户的面部特征并存储。相应地,当主体识别结果为目标场所的图像中的主体包括人,从目标场所的图像中获取面部图像,并对面部图像进行人脸识别,以得到面部特征。当面部特征为指定用户的面部特征,则确定用户与目标场所之间的位置状态关系示意指定用户位于目标场所。进一步,iot设备可在确定指定用户位于目标场所的情况下,将用户到达信息提供给智能设备。

88.实施方式b3:在一些实施例中,用户离开目标场所时需要对目标场所的房门进行锁门,相应地,在到达目标场所时需要开锁。例如,用户离家上班时需要锁门,下班回到家时需要开锁。在该实施方式中,iot设备可实现为智能锁。其中智能锁可为磁卡锁、密码锁、指纹锁或人脸识别锁等。

89.在一些实施例中,智能设备针对到达目标场所的所有用户进行交互。相应地,iot设备(智能锁)可监测是否接收到开锁指令。当接收到开锁指令,确定用户与目标场所的位置状态关系为用户到达目标场所,并将用户到达目标场所的相关信息(如用户到达信息等)提供给智能设备。

90.其中,智能锁的实现形式不同,监测开锁指令的实施方式不同。下面结合几种智能锁进行示例性说明。

91.针对密码锁,可获取用户输入的待检验密码,并将待检测密码在预存的密码中进行匹配,若匹配中,则确定接收到开锁指令。

92.针对指纹锁,可获取待测指纹图像,并将待测指纹图像在预存的指纹图像中进行匹配。若匹配中,则确定接收到开锁指令。可选地,可计算待测指纹图像与预存的指纹图像之间的相似度,当预存的指纹图像中存在与待测指纹图像之间的相似度大于或等于设定的相似度阈值的指纹图像,则确定接收到开锁指令。在一些实施例中,智能设备可针对到达目标场所的所有用户进行交互。相应地,智能锁可在接收到开锁指令的情况下,将用户到达目标场所的相关信息(如用户到达信息)提供给智能设备。

93.在另一些实施例中,智能设备可针对特定用户进行交互。对于指纹锁来说,还可存

储指纹图像与用户标识之间的对应关系,并预先设置指定用户。相应地,还可将待测指纹图像在预存的指纹图像中进行匹配,以确定提供待测指纹图像的用户的身份(即确定提供待测指纹图像的用户标识);当提供待测指纹图像的用户为指定用户,则将用户与目标场所的位置状态关系提供给智能设备。可选地,智能锁可将上述预存的指纹图像中,与待测指纹图像之间的相似度大于或等于设定的相似度阈值的指纹图像对应的用户标识,作为提供待测指纹图像的用户标识。进一步,智能锁可判断提供待测指纹图像的用户标识是否为指定用户的标识;若判断结果为是,则确定指定用户到达目标场所;并将指定用户与目标场所的位置状态关系提供给智能设备。

94.针对人脸识别锁,可获取待测面部图像;并将待测面部图像在预存的指纹图像中进行匹配;若匹配中,则确定接收到开锁指令。可选地,可计算待测面部图像与预存的面部图像之间的相似度;当预存的面部图像中存在与待测面部图像之间的相似度大于或等于设定的相似度阈值的面部图像,确定接收到开锁指令。在一些实施例中,智能设备可针对到达目标场所的所有用户进行交互。相应地,智能锁可在接收到开锁指令的情况下,将用户到达目标场所的相关信息(如用户到达指令)提供给智能设备。

95.在另一些实施例中,智能设备可针对特定用户进行交互。对于人脸识别锁来说,还可存储面部图像与用户标识之间的对应关系,并预先设置指定用户。相应地,还可将待测面部图像在预存的面部图像中进行匹配,以确定提供待测面部图像的用户的身份(即确定提供待测面部图像的用户标识)。当提供待测面部图像的用户为指定用户,则将用户与目标场所的位置状态关系提供给智能设备。可选地,智能锁可将上述预存的面部图像中,与待测面部图像之间的相似度大于或等于设定的相似度阈值的面部图像对应的用户标识,作为提供待测面部图像的用户标识。进一步,智能锁可判断提供待测面部图像的用户标识是否为指定用户的标识。若判断结果为是,则确定指定用户到达目标场所,并将指定用户与目标场所的位置状态关系提供给智能设备。

96.实施方式b4:针对一些物理场所来说,用户白天离开该场所,晚上回来。例如,用户早上离家上班,晚上下班回家等。晚上回家会开灯。基于此,感测器可实现为智能灯。对于智能灯来说,可监测是否接收到开灯指令。当接收到开灯指令,确定用户与目标场所的位置状态关系为用户到达目标场所。

97.其中,控制智能灯的开关的实现形式不同,智能灯监测是否接收到开灯指令的方式不同。下面结合几种控制智能灯开关的实现形式进行示例性说明。

98.在一些实施例中,智能灯的开关为按键开关。相应地,智能灯可包括按键检测电路。进一步,可利用智能灯中的按键检测电路,检测智能灯的开关是否闭合;当检测结果到开关闭合,确定接收到开灯指令。

99.在另一些实施例中,智能灯为声控灯。用户可发出“请开灯”等语音来开灯。相应地,智能灯可设置麦克风,并利用麦克风拾取语音信号,对语音信号进行语音识别,得到语音识别结果。当语音识别结果反映开灯,则确定接收到开灯指令。

100.在一些实施例中,智能灯可在确定接收到开灯指令时,确定用户到达目标场所,并将用户到达目标场所的相关信息提供给智能设备。

101.在另一些实施例中,智能设备可针对特定用户进行交互。智能灯还可对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储。相应地,智能灯还可对语音信号进

行声纹识别,以得到语音信号的声纹特征。进一步,判断语音信号的声纹特征是否与指定用户的声纹特征相匹配,若判断结果为是,则确定用户与目标场所之间的位置状态关系为指定用户到达目标场所,并将用户与目标场所的位置状态关系提供给智能设备。

102.在又一些实施例中,用户的终端设备(如智能手机、可穿戴设备等)可安装有智能灯对应的应用程序,通过终端设备控制智能灯。或者,通过智能灯对应的遥控控制智能灯。相应地,智能灯可监测是否接收到终端设备发出的开灯信号;当接收到,则确定接收到开灯指令,并在接收到开灯指令的情况下,确定用户到达目标场所。其中,终端设备可为用户终端,如智能手机、可穿戴设备等,也可为智能灯对应的遥控等。

103.在本技术实施例中,iot设备除了可利用感测器感测用户与目标场所之间的位置状态关系之外,还可通过iot设备对应的应用程序获取用户移动至目标场所的关联信息,并根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系提供给智能设备。在该实施例中,iot设备对应的应用程序可安装于用户的终端设备。其中,关于终端设备的描述可参见上述实施例。用户可通过终端设备上的应用程序告知智能设备用户要去目标场所。如用户要回家等。

104.在该实施方式中,用户终端可获取用户移动至目标场所的关联信息。其中,用户移动至目标场所的关联信息是指可反映用户与目标场所之间的位置状态关系的信息。例如用户移动至目标场所的关联信息可包括:用户预计到达目标场所的时间、用户的实时定位信息等,但不限于于此。

105.进一步,终端设备可将用户移动至目标场所的关联信息提供给设置于目标场所的iot设备。确切地说是,终端设备将用户移动至目标场所的关联信息提供给云端;云端将用户移动至目标场所的关联信息发送给设置于目标场所的iot设备。相应地,如图7所示,步骤501的另一种实施方式为:步骤701获取用户移动至目标场所的关联信息,并在步骤702中,根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系。

106.可选地,用户的终端设备可自主定位,并将其实时定位信息提供给设置于目标场所的iot设备。确切地说是,终端设备将实时定位信息提供给云端;云端将终端设备的实时定位信息发送给iot设备。用户移动至目标场所的关联信息可为终端设备的实时定位信息。相应地,步骤702可实现为:获取用户的终端设备的实时定位信息;并根据终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系。其中,关于根据用户终端的实时定位信息,确定用户与目标场所之间的位置状态关系的具体实施方式可参见上述实施例的相关内容。

107.或者,也可由云端确定用户与目标场所之间的位置状态关系。用户的终端设备将实时定位信息提供给云端;云端根据终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系;并将用户与目标场所之间的位置状态关系提供给iot设备。云端确定用户与目标场所之间的位置状态关系的具体实施方式,可参见上述智能设备确定用户与目标场所之间的位置状态关系的相关内容,在此不再赘述。相应地,步骤702可实现为:接收云端根据用户的终端设备的实时定位信息确定出的用户与目标场所之间的位置状态关系。

108.进一步,对于iot设备来说,可将感测到的用户与目标场所之间的位置状态关系提供给与用户进行交互的智能设备。可选地,iot设备与智能设备可通过p2p通讯机制通信。相应地,iot设备可通过p2p通讯机制将用户与目标场所之间的位置状态关系提供给智能设

备。或者,也可如图7中步骤703所示,将用户与目标场所之间的位置状态关系提供给云端,由云端将用户与目标场所之间的位置状态关系发送给智能设备。智能设备可在用户位于目标场所的情况下,执行指定动作,实现与用户的交互。

109.需要说明的是,上述实施例所提供方法的各步骤的执行主体均可以是同一设备,或者,该方法也由不同设备作为执行主体。比如,步骤101和102的执行主体可以为设备a;又比如,步骤101的执行主体可以为设备a,步骤102的执行主体可以为设备b;等等。

110.另外,在上述实施例及附图中的描述的一些流程中,包含了按照特定顺序出现的多个操作,但是应该清楚了解,这些操作可以不按照其在本文中出现的顺序来执行或并行执行,操作的序号如101、102等,仅仅是用于区分开各个不同的操作,序号本身不代表任何的执行顺序。另外,这些流程可以包括更多或更少的操作,并且这些操作可以按顺序执行或并行执行。

111.相应地,本技术实施例还提供一种存储有计算机指令的计算机可读存储介质,当计算机指令被一个或多个处理器执行时,致使一个或多个处理器执行上述各交互方法中的步骤。

112.相应地,本技术实施例还提供一种计算机程序产品,包括:计算机程序;当计算机程序被处理器执行时,可实现上述各交互方法。

113.图8a为本技术实施例提供的扫地机的结构示意图。如图8a所示,扫地机包括:机械本体81;机械本体81上设置有动力组件82、清洁组件83、存储器84和处理器85。

114.值得说明的是,动力组件82、清洁组件83、存储器84和处理器85可设置于机械本体81内部,也可以设置于机械本体81的表面。

115.机械本体81是指扫地机800的机身,可作为扫地机800的执行机构,可以在确定的环境中执行处理器85指定的操作。其中,机械本体81一定程度上体现了扫地机800的外观形态。在本实施例中,并不限定扫地机800的外观形态。例如,扫地机800可以是图4a和图4b所示的圆形扫地机;或者为方形、椭圆形、梯形等等。

116.在本实施例中,动力组件82用于驱动清洁组件83执行清洁任务。动力组件82可以包括驱动轮、驱动电机等。

117.存储器84,用于存储计算机程序。计算机程序可被一个或多个处理器85执行,致使一个或多个处理器85控制扫地机800实现相应功能、完成相应动作或任务。除了存储计算机指令之外,一个或多个存储器84还可被配置为存储其它各种数据以支持在扫地机800上的操作等。

118.处理器85,可以看作是扫地机800的控制系统,可用于执行一个或多个存储器84中存储的计算机指令,以控制扫地机800实现相应功能、完成相应动作或任务。值得说明的是,扫地机800处于不同场景时,其所需实现的功能、完成的动作或任务会有所不同;相应地,一个或多个存储器84中存储的计算机指令也会有所不同,而一个或多个处理器85执行不同计算机指令可控制扫地机800实现不同的功能、完成不同的动作或任务。

119.在本实施例中,处理器85耦合至存储器84,用于执行计算机程序以用于:获取用户与目标场所之间的位置状态关系;当用户与目标场所之间的位置状态关系示意用户位于目标场所,执行指定动作。

120.在一些实施例中,扫地机800包括:感测器86。相应地,处理器85在获取用户与目标

场所之间的位置状态关系时,具体用于:利用感测器86确认用户与目标场所之间的位置状态关系。

121.在一些实施例中,扫地机设置有麦克风86a。相应地,处理器85在利用感测器确认用户与目标场所的位置状态关系时,具体用于:利用麦克风86a拾取语音信号;根据语音信号确定用户与目标场所之间的位置状态关系。

122.进一步,处理器85在根据语音信号确定用户与目标场所之间的位置状态关系时,具体用于:对语音信号进行语音识别,得到语音识别结果;当语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系为用户位于目标场所。

123.可选地,处理器85还用于:对语音信号进行语音识别之前,对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储;以及,对语音信号进行声纹识别,以得到语音信号的声纹特征;判断语音信号的声纹特征是否与指定用户的声纹特征相匹配;若判断结果为是,则对语音信号进行语音识别。

124.在另一些实施例中,扫地机800设置有光线感测器86b。相应地,处理器85在利用感测器感测用户与目标场所的位置状态关系时,具体用于:利用光线感测器86b感测目标场所的光线的光学特征;并根据光线的光学特征,确定用户与目标场所的位置状态关系。

125.可选地,处理器85在确定用户与目标场所的位置状态关系时,具体用于:当感测到的光线的光学特征符合灯光的光学特征,确定用户与目标场所的位置状态关系示意用户位于目标场所。

126.在另一些实施例中,扫地机800设置有视觉传感器86c。相应地,处理器85在利用感测器确认用户与目标场所的位置状态关系时,具体用于:利用视觉传感器86c采集目标场所的图像;对目标场所的图像进行主体识别,以得到主体识别结果;根据主体识别结果,确定用户与目标场所之间的位置状态关系。

127.进一步,处理器85在确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

128.可选地,处理器85还用于:利用视觉传感器86c采集指定用户的面部图像;并对指定用户的面部图像进行特征提取,得到所述指定用户的面部特征并存储。相应地,处理器85在确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,则从目标场所的图像中获取面部图像;对目标场所的图像中的面部图像进行人脸识别,以得到面部特征;当面部特征为指定用户的面部特征,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

129.在一些实施例中,处理器85在获取用户与目标场所之间的位置状态关系时,具体用于:获取用户移动至目标场所的关联信息;根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系。

130.可选地,处理器85在获取用户移动至目标场所的关联信息时,具体用于:获取用户的终端设备的实时定位信息,作为用户移动至目标场所的关联信息。相应地,处理器85在确定用户与目标场所之间的位置状态关系时,具体用于:根据用终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系。

131.可选地,处理器85还用于:根据用户的终端设备的实时定位信息及目标场所的地

理位置信息,计算用户与目标场所之间的距离;当用户与目标场所之间的距离小于或等于设定距离阈值,执行预设操作。

132.在另一些实施例中,扫地机包括:通信组件87。处理器85在获取用户与目标场所之间的位置状态关系时,具体用于:

133.监测通信组件87是否接收到目标场所内的其它智能设备发送的用户到达信息;当监测到通信组件87接收到用户到达信息,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

134.在本技术实施例中,处理器85在执行指定动作时,具体用于:当用户与目标场所之间的位置状态关系示意用户位于目标场所,控制扫地机800移动至目标场所内的指定区域。

135.可选地,指定区域为预设指定区域、用户设置的指定区域或从云端获取的指定区域。

136.可选地,处理器85在控制扫地机800执行指定动作时,还用于:控制扫地机800在指定区域完成设定的动作。

137.可选地,处理器85在控制扫地机800从当前位置移动至指定区域时,具体用于:控制扫地机800沿着规划的导航路线,从当前位置向指定区域移动;并控制扫地机800在向指定区域移动过程中,完成设定的动作。

138.可选地,处理器85还用于:获取目标场所的环境信息。根据环境信息,规划到指定区域的导航路线。

139.可选地,处理器85还用于:响应于针对交互区域的设置操作,将设置操作设置的区域作为指定区域。

140.在一些实施例中,处理器85还用于:在完成指定动作之后,控制扫地机800沿规划路线返回出发位置。

141.在一些可选实施方式中,如图8a所示,该扫地机800还可以包括:电源组件88、音频组件89、显示组件810、万向轮(图8a中未示出)等组件,还可包括:光传感器、接触传感器、反射光耦合器以及惯性传感器等传感器(图8a中未示出),但不限于此。值得说明的是,不同扫地机800所包含的这些基本组件以及基本组件的构成均会有所不同,本技术实施例列举的仅是部分示例。图8a中仅示意性给出部分组件,并不意味着扫地机800必须包含图8a所示全部组件,也不意味着扫地机800只能包括图8a所示组件。

142.本实施例提供的扫地机,可获取用户与扫地机所在的物理场所之间的位置状态关系;并可在用户位于扫地机所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了扫地机的交互性。

143.图8b为本技术实施例提供的智能设备的结构示意图。如图8b所示,该智能设备包括:存储器80a和处理器80b。处理器80b耦合至存储器80a,用于执行计算机程序以用于:获取用户与目标场所之间的位置状态关系;当用户与目标场所之间的位置状态关系示意用户位于目标场所,执行指定动作。

144.在一些实施例中,智能设备包括:感测器80c。相应地,处理器80b在获取用户与目标场所之间的位置状态关系时,具体用于:利用感测器80c确认用户与目标场所之间的位置状态关系。

145.在一些实施例中,智能设备设置有麦克风。相应地,处理器80b在利用感测器确认

用户与目标场所的位置状态关系时,具体用于:利用麦克风拾取语音信号;根据语音信号确定用户与目标场所之间的位置状态关系。

146.进一步,处理器80b在根据语音信号确定用户与目标场所之间的位置状态关系时,具体用于:对语音信号进行语音识别,得到语音识别结果;当语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系为用户位于目标场所。

147.可选地,处理器80b还用于:对语音信号进行语音识别之前,对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储;以及,对语音信号进行声纹识别,以得到语音信号的声纹特征;判断语音信号的声纹特征是否与指定用户的声纹特征相匹配;若判断结果为是,则对语音信号进行语音识别。

148.在另一些实施例中,智能设备设置有光线感测器。相应地,处理器80b在利用感测器感测用户与目标场所的位置状态关系时,具体用于:利用光线感测器感测目标场所的光线的光学特征;并根据光线的光学特征,确定用户与目标场所的位置状态关系。

149.可选地,处理器80b在确定用户与目标场所的位置状态关系时,具体用于:当感测到的光线的光学特征符合灯光的光学特征,确定用户与目标场所的位置状态关系示意用户位于目标场所。

150.在另一些实施例中,智能设备设置有视觉传感器。相应地,处理器80b在利用感测器确认用户与目标场所的位置状态关系时,具体用于:利用视觉传感器采集目标场所的图像;对目标场所的图像进行主体识别,以得到主体识别结果;根据主体识别结果,确定用户与目标场所之间的位置状态关系。

151.进一步,处理器80b在确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

152.可选地,处理器80b还用于:利用视觉传感器采集指定用户的面部图像;并对指定用户的面部图像进行特征提取,得到所述指定用户的面部特征并存储。相应地,处理器80b在确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,则从目标场所的图像中获取面部图像;对目标场所的图像中的面部图像进行人脸识别,以得到面部特征;当面部特征为指定用户的面部特征,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

153.在一些实施例中,处理器80b在获取用户与目标场所之间的位置状态关系时,具体用于:获取用户移动至目标场所的关联信息;根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系。

154.可选地,处理器80b在获取用户移动至目标场所的关联信息时,具体用于:获取用户的终端设备的实时定位信息,作为用户移动至目标场所的关联信息。相应地,处理器80b在确定用户与目标场所之间的位置状态关系时,具体用于:根据用终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系。

155.在本技术实施例中不限定智能设备的具体实现形态,智能设备的实现形态不同,包含的基本组件不同。在一些实施例中,智能设备可实现为自主移动设备。相应地,智能设备还可包括:动力组件80e和移动组件80f。其中,动力组件80e用于驱动移动组件80f运动。移动组件80f与智能设备的行进方式有关。智能设备为轮式行进,移动组件80f可包括轮子

等。智能设备为履带式行进,移动组件80f可包括履带等。

156.在该实施例中,处理器80b在执行指定动作时,具体用于:当用户与目标场所之间的位置状态关系示意用户位于目标场所,控制动力组件80e驱动移动组件80f移动至目标场所内的指定区域。

157.可选地,指定区域为预设指定区域、用户设置的指定区域或从云端获取的指定区域。

158.可选地,处理器80b在控制智能设备执行指定动作时,还用于:控制智能设备在指定区域完成设定的动作。

159.可选地,处理器80b在控制智能设备从当前位置移动至指定区域时,具体用于:控制智能设备沿着规划的导航路线,从当前位置向指定区域移动;并控制智能设备在向指定区域移动过程中,完成设定的动作。

160.可选地,处理器80b还用于:获取目标场所的环境信息。根据环境信息,规划到指定区域的导航路线。

161.可选地,处理器80b还用于:响应于针对交互区域的设置操作,将设置操作设置的区域作为指定区域。

162.在一些实施例中,处理器80b还用于:在完成指定动作之后,控制智能设备沿规划路线返回出发位置。

163.在一些实施例中,智能设备还可实现为扫地机器人,即上述扫地机。相应地,还可包括:清洁组件80g。相应地,动力组件80f可驱动清洁组件80f执行清洁任务。

164.可选地,处理器80b还用于:根据用户的终端设备的实时定位信息及目标场所的地理位置信息,计算用户与目标场所之间的距离;当用户与目标场所之间的距离小于或等于设定距离阈值,执行预设操作。

165.在另一些实施例中,智能设备包括:通信组件80d。处理器80b在获取用户与目标场所之间的位置状态关系时,具体用于:监测通信组件80d是否接收到目标场所内的其它智能设备发送的用户到达信息;当监测到通信组件80d接收到用户到达信息,确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

166.在一些可选实施方式中,如图8b所示,该智能设备还可以包括:电源组件、音频组件、显示组件(图8b中未示出)等组件,还可包括:光传感器、接触传感器、反射光耦合器以及惯性传感器等传感器(图8b中未示出),但不限于此。值得说明的是,不同智能设备所包含的这些基本组件以及基本组件的构成均会有所不同,本技术实施例列举的仅是部分示例。图8b中仅示意性给出部分组件,并不意味着智能设备必须包含图8b所示全部组件,也不意味着智能设备只能包括图8b所示组件。

167.本实施例提供的智能设备,可获取用户与智能设备所在的物理场所之间的位置状态关系;并可在用户位于智能设备所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性。

168.图9为本技术实施例提供的物联网设备的结构示意图。如图9所示,物联网设备包括:存储器90a、处理器90b和通信组件90c;其中,存储器90a,用于存储计算机程序。该物联网设备可设置于目标场所。

169.处理器90a耦合至存储器90a和通信组件90c,用于执行计算机程序以用于:获取用

户与目标场所之间的位置状态关系;通过通信组件90c将用户与目标场所的位置状态关系提供给目标场所内的智能设备,以供智能设备当位置状态关系示意用户位于目标场所,执行指定动作。

170.在一些实施例中,物联网设备包括:感测器90d。处理器90b在获取用户与目标场所的位置状态关系时,具体用于:利用感测器90d确认用户与目标场所之间的位置状态关系。

171.可选地,物联网设备包括:麦克风。处理器90b在利用感测器感测用户与目标场所之间的位置状态关系时,具体用于:利用麦克风拾取语音信号;根据语音信号确定用户与目标场所之间的位置状态关系。

172.可选地,处理器90b在根据语音信号确定用户与目标场所之间的位置状态关系时,具体用于:对语音信号进行语音识别,得到语音识别结果;当语音识别结果反映用户到达目标场所,则确定用户与目标场所之间的位置状态关系示意用户位于目标场所。

173.可选地,处理器90b还用于:对指定用户的语音进行声纹识别,得到指定用户的声纹特征并存储;以及,在对语音信号进行语音识别之前,对语音信号进行声纹识别,以得到语音信号的声纹特征;判断语音信号的声纹特征是否与指定用户的声纹特征相匹配;若判断结果为是,则对语音信号进行语音识别。

174.在另一些实施例中,物联网设备包括:视觉传感器(图9中未示出)。处理器90b在利用感测器确认用户与目标场所的位置状态关系时,具体用于:利用视觉传感器采集目标场所的图像;对目标场所的图像进行主体识别,以得到主体识别结果;根据主体识别结果,确定用户与目标场所之间的位置状态关系。

175.可选地,处理器90b在根据主体识别结果确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,确定用户与目标场所之间的位置状态关系为用户到达目标场所。

176.可选地,处理器90b还用于:利用视觉传感器采集指定用户的面部图像;并对指定用户的面部图像进行特征提取,得到所述指定用户的面部特征并存储。相应地,处理器90b在根据主体识别结果,确定用户与目标场所之间的位置状态关系时,具体用于:当主体识别结果为目标场所的图像中的主体包括人,则从目标场所的图像中获取面部图像;对面部图像进行人脸识别,以得到面部特征;当面部特征为指定用户的面部特征,则确定用户与目标场所之间的位置状态关系为指定用户到达目标场所。

177.在一些实施例中,感测器可实现为智能锁。相应地,处理器90d在利用感测器感测用户与目标场所的位置状态关系时,具体用于:监测是否接收到开锁指令;当接收到,确定用户与目标场所的位置状态关系示意用户位于目标场所。

178.可选地,在一些实施例中,智能锁可为指纹锁。物联网设备(智能锁)还包括:指纹采集传感器(图中未示出)。处理器90d在监测是否接收到开锁指令时,具体用于:利用指纹采集传感器获取待测指纹图像;将待测指纹图像在预存的指纹图像中进行匹配;若匹配中,则确定接收到开锁指令。

179.相应地,处理器90d在将用户与目标场所的位置状态关系提供给智能设备时,具体用于:将待测指纹图像在预存的指纹图像中进行匹配,以确定提供待测指纹图像的用户的身份;当提供待测指纹图像的用户为指定用户,则通过通信组件90c将指定用户与目标场所之间的位置状态关系提供给智能设备。

180.可选地,智能锁为人脸识别锁。物联网设备(智能锁)还包括:摄像头。相应地,处理器90d在监测是否接收到开锁指令时,具体用于:利用摄像头采集待测面部图像;将待测面部图像在预存的面部图像中进行匹配;当匹配中,则确定接收到开锁指令。

181.相应地,处理器90d在将用户与目标场所的位置状态关系提供给智能设备时,具体用于:将待测面部图像在预存的面部图像中进行匹配,以确定提供待测面部图像的用户的身份;当提供待测面部图像的用户为指定用户,通过通信组件90c将用户与目标场所的位置状态关系提供给智能设备。

182.在一些实施例中,物联网设备实现为智能灯。相应地,感测器可实现为智能灯。相应地,处理器90b在利用感测器确认用户与目标场所的位置状态关系时,具体用于:监测是否接收到开灯指令;当接收到开灯指令,确定用户与目标场所的位置状态关系示意用户位于目标场所。

183.可选地,在一些实施例中,智能灯包括:开关和按键检测电路。相应地,处理器90b在监测是否接收到开灯指令时,具体用于:利用智能灯中的按键检测电路,检测智能灯的开关是否闭合;当检测结果为是,确定接收到开灯指令。

184.在另一些实施例中,智能灯包括:麦克风。相应地,处理器90b在监测是否接收到开灯指令时,具体用于:利用麦克风拾取语音信号;对语音信号进行语音识别,得到语音识别结果;当语音识别结果反映开灯,确定接收到开灯指令。

185.相应地,处理器90b在将用户与目标场所的位置状态关系提供给智能设备时,具体用于:对语音信号进行声纹识别,以得到语音信号的声纹特征;判断语音信号的声纹特征是否与指定用户的声纹特征相匹配;当判断结果为是,通过通信组件90c将用户与目标场所的位置状态关系提供给智能设备。当判断结果为否,则不通知智能设备。

186.在一些实施例中,智能灯可由遥控或用户终端等终端设备控制。相应地,处理器90b在监测是否接收到开灯指令时,具体用于:监测是否接收到终端设备发出的开灯信号;当接收到,确定接收到开灯指令。

187.在本技术另一些实施例中,处理器90b在获取用户与目标场所之间的位置状态关系时,具体用于:获取用户移动至目标场所的关联信息;根据用户移动至目标场所的关联信息,确定用户与目标场所之间的位置状态关系。

188.可选地,处理器90b在获取用户移动至目标场所的关联信息时,具体用于:获取用户的终端设备的实时定位信息,作为用户移动至目标场所的关联信息。相应地,处理器90b在确定用户与目标场所之间的位置状态关系时,具体用于:根据终端设备的实时定位信息,确定用户与目标场所之间的位置状态关系;和/或,接收云端根据终端设备的实时定位信息确定出的用户与目标场所之间的位置状态关系。

189.在本技术实施例中,处理器90b在将用户与目标场所的位置状态关系提供给智能设备时,具体用于:通过通信组件90c将用户与目标场所的位置状态关系提供给云端,以供云端将用户与目标场所的位置状态关系提供给智能设备;和/或,通过点对点通讯机制将用户与目标场所的位置状态关系提供给智能设备。

190.在一些可选实施方式中,如图9所示,该物联网设备还可以包括:电源组件90e、音频组件90f、显示组件90g等组件,但不限于此。值得说明的是,不同物联网所包含的这些基本组件以及基本组件的构成均会有所不同,本技术实施例列举的仅是部分示例。例如,对于

智能锁来说,还可包括:把手、锁体及锁头等;对于智能冰箱来说,还可包括:冷藏室、冷冻室及制冷装置等;对于智能灯来说,还可包括:发光管、灯座或支架等等。图9仅示意性给出部分组件,并不意味着物联网设备必须包含图9所示全部组件,也不意味着物联网设备只能包括图9示组件。

191.本实施例提供的物联网设备,可获取用户与智能设备所在的物理场所之间的位置状态关系;并将用户与物理场所之间的位置状态关系提供给智能设备。这样智能设备可在用户位于智能设备所在的物理场所时,执行指定动作,实现与用户之间的交互,增加了智能设备的交互性。

192.在本技术实施例中,存储器用于存储计算机程序,并可被配置为存储其它各种数据以支持在其所在设备上的操作。其中,处理器可执行存储器中存储的计算机程序,以实现相应控制逻辑。存储器可以由任何类型的易失性或非易失性存储设备或者它们的组合实现,如静态随机存取存储器(sram),电可擦除可编程只读存储器(eeprom),可擦除可编程只读存储器(eprom),可编程只读存储器(prom),只读存储器(rom),磁存储器,快闪存储器,磁盘或光盘。

193.在本技术实施例中,处理器可以为任意可执行上述方法逻辑的硬件处理设备。可选地,处理器可以为中央处理器(central processing unit,cpu)、图形处理器(graphics processing unit,gpu)或微控制单元(microcontroller unit,mcu);也可以为现场可编程门阵列(field-programmable gate array,fpga)、可编程阵列逻辑器件(programmable array logic,pal)、通用阵列逻辑器件(general array logic,gal)、复杂可编程逻辑器件(complex programmable logic device,cpld)等可编程器件;或者为先进精简指令集(risc)处理器(advanced risc machines,arm)或系统芯片(system on chip,soc)等等,但不限于此。

194.在本技术实施例中,通信组件被配置为便于其所在设备和其他设备之间有线或无线方式的通信。通信组件所在设备可以接入基于通信标准的无线网络,如wifi,2g或3g,4g,5g或它们的组合。在一个示例性实施例中,通信组件经由广播信道接收来自外部广播管理系统的广播信号或广播相关信息。在一个示例性实施例中,所述通信组件还可基于近场通信(nfc)技术、射频识别(rfid)技术、红外数据协会(irda)技术、超宽带(uwb)技术、蓝牙(bt)技术或其他技术来实现。

195.在本技术实施例中,显示组件可以包括液晶显示器(lcd)和触摸面板(tp)。如果显示组件包括触摸面板,显示组件可以被实现为触摸屏,以接收来自用户的输入信号。触摸面板包括一个或多个触摸传感器以感测触摸、滑动和触摸面板上的手势。所述触摸传感器可以不仅感测触摸或滑动动作的边界,而且还检测与所述触摸或滑动操作相关的持续时间和压力。

196.在本技术实施例中,电源组件被配置为其所在设备的各种组件提供电力。电源组件可以包括电源管理系统,一个或多个电源,及其他与为电源组件所在设备生成、管理和分配电力相关联的组件。

197.在本技术实施例中,音频组件可被配置为输出和/或输入音频信号。例如,音频组件包括一个麦克风(mic),当音频组件所在设备处于操作模式,如呼叫模式、记录模式和语音识别模式时,麦克风被配置为接收外部音频信号。所接收的音频信号可以被进一步存储

在存储器或经由通信组件发送。在一些实施例中,音频组件还包括一个扬声器,用于输出音频信号。例如,对于具有语言交互功能的设备,可通过音频组件实现与用户的语音交互等。

198.需要说明的是,本文中的“第一”、“第二”等描述,是用于区分不同的消息、设备、模块等,不代表先后顺序,也不限定“第一”和“第二”是不同的类型。

199.本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。

200.本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

201.这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

202.这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

203.在一个典型的配置中,计算设备包括一个或多个处理器(cpu)、输入/输出接口、网络接口和内存。

204.内存可能包括计算机可读介质中的非永久性存储器,随机存取存储器(ram)和/或非易失性内存等形式,如只读存储器(rom)或闪存(flash ram)。内存是计算机可读介质的示例。

205.计算机可读介质包括永久性和非永久性、可移动和非可移动媒体可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括,但不限于相变内存(pram)、静态随机存取存储器(sram)、动态随机存取存储器(dram)、其他类型的随机存取存储器(ram)、只读存储器(rom)、电可擦除可编程只读存储器(eeprom)、快闪记忆体或其他内存技术、只读光盘只读存储器(cd-rom)、数字多功能光盘(dvd)或其他光学存储、磁盒式磁带,磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。按照本文中的界定,计算机可读介质不包括暂存电脑可读媒体(transitory media),如调制的数据信号和载波。

206.还需要说明的是,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、商品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、商品或者设备所固有的要

素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、商品或者设备中还存在另外的相同要素。

207.以上所述仅为本技术的实施例而已,并不用于限制本技术。对于本领域技术人员来说,本技术可以有各种更改和变化。凡在本技术的精神和原理之内所作的任何修改、等同替换、改进等,均应包含在本技术的权利要求范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1