一种基于Wasserstein距离的表征相似对抗网络

一种基于wasserstein距离的表征相似对抗网络

技术领域

1.本发明涉及脑电情绪分类和深度迁移学习的技术领域,尤其涉及一种基于 wasserstein距离的表征相似对抗网络模型。

背景技术:

2.与传统迁移学习相比,深度迁移学习因为可以直接对原始数据进行处理,能更好的提取特征,进而提高结果的准确率,目前已经成功的应用在脑机接口领域,因为不同被试者的个体差异很大,同一个体在不同时间段的差异也不同,所以需要通过拉近不同被试者数据的边缘概率分布和条件概率分布来拉近两个领域之间的差异。

3.传统的域适应方法通常先提取源域与目标域的特征,然后对两域特征进行域适应,最终采用传统分类器进行分类,上述传统算法运算效率较高,但是准确率比较有限,而且在整个过程中需要人为干预,以往的基于度量的深度域适应方法在准确率上通常优于传统算法,但是在性能上仍存在许多缺点,比如采用 mmd距离的域适应方法,准确率波动较大,采用二阶统计特征对齐的方法针对差异较大的两域作用有限等。

4.例如,一种在国外论文文献上公开的“[jinpeng li,shuang qiu,changdedu,yixin wang,and huiguang he.domain adaptation for eeg emotionrecognition based on latent representation similarity[j].ieeetransactions on cognitive and developmental systems,2019.]”,提出了一种基于潜在表征相似性的脑电情感模型,这个模型采用减小交叉熵(衡量数据真实分布和模型预测分布相似性的一种方法)损失的方法来减小不同被试者的边缘概率分布的差异,采用关联强化的方法减小条件概率分布的差异。然而当数据点的分布与另一个分布没有重叠区域或者重叠区域可以忽略时,会出现梯度消失的情况,所以交叉熵反应不了两个分布的真实距离,采用wasserstein 距离作为距离度量,可以在任何地方提供稳定的梯度,即反应两个分布的真实距离。

技术实现要素:

[0005]

为此,本发明实施例提供一种基于wasserstein距离的表征相似对抗网络模型,能够反应两个分布的真实距离,为脑电情绪识别的深度迁移方法提供了一种准确率更高的方法。

[0006]

为了实现上述目的,本发明的实施方式提供如下技术方案:

[0007]

一种基于wasserstein距离的表征相似对抗网络,其特征在于,包括如下步骤:

[0008]

s1、脑电信号首先以200hz的采样率下采样,在0.5hz

‑

70hz之间用带通滤波器对脑电信号进行处理来滤除噪声和伪影,随机选择一名被试者的脑电信号作为目的域,其他被试者脑电信号作为源域;

[0009]

s2、通过特征提取器将数据映射到一个特征空间并设置域混淆器的 wasserstein距离;

[0010]

s3、设置域混淆器的梯度惩罚并更新w参数;

[0011]

s4、采用关联强化的分类器并求源域到目的域特征表征的相似度以及目的域到源域特征表征的相似度;

[0012]

s5、计算源域目的域的往返概率和计算源域标签概率并用交叉熵损失计算损失;

[0013]

s6、设定访问概率与目的域标签概率并用交叉熵损失计算损失;

[0014]

s7、设置分类器损失与源域预测分类损失并计算模型损失,设置迭代次数 n,当训练次数达到迭代次数后停止。

[0015]

作为优选,所述s1中:滤除噪声和伪影包括使用1s长非重叠汉宁窗的短时傅里叶变换计算5个频带(δ:1

‑

3hz,θ:4

‑

7hz,α:8

‑

13hz,β:14

‑

30hz,γ:31

‑

50hz)中的传统de特征,引入线性动态系统来过滤无关信息。提高信息处理效果。

[0016]

作为优选,所述s2中:特征提取器是由310

‑

128的全连接层构成,特征通过特征提取器后,由310维降至128维,再经过relu激活,映射关系如下:

[0017]

x

′

s

=f(x

s

) x

′

t

=f(x

t

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0018]

其中,x

s

为原始源域特征,x

t

为原始目的域特征,f(x)为特征提取器,x

′

s

和 x

′

t

表示源域和目的域在相同特征空间中的128维特征表示;wasserstein距离可以减小源域和目的域边缘概率分布,wasserstein距离的表达式如下:

[0019][0020]

式子中,p

a

表示特征空间中的随机位置a的边缘概率分布,p

b

表示特征空间中的另一个位置b的边缘概率分布,inf表示结果的下确界,μ(p

a

,p

b

)是p

a

和p

b

组合的所有联合概率分布的集合,ε为可能组合的联合概率分布,‖x

‑

y‖为随机样本x和y的距离,e为随机样本距离的期望值,w(p

a

,p

b

)是最优路径的最小消耗;在式子中,由于不能直接求出结果,所以根据坎托罗维奇

‑

鲁宾斯坦对偶定理,将式子(2)变成如下形式:

[0021][0022]

式子中,sup表示上确界,表示在边缘概率分布p

a

下样本x对函数f(x) 的期望值,表示在边缘概率分布p

b

下样本x对函数f(x)的期望值,‖f‖

l

表示lipschitz常数,它的定义为:

[0023]

‖f‖

l

=sup|f(x1)

‑

f(x2)|/|x1‑

x2|

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0024]

由于经过特征提取器后,源域目的域特征映射为x

′

s

和x

′

t

,所以公式(3) 改为:

[0025][0026]

可以通过调整参数w来最大化域混淆器的损失,以近似的表示wasserstein 距离,所以把公式(5)改为:

[0027][0028]

式子中,d表示域混淆器,等价于公式(5)中的f

w

(),表示域混淆器的损失, x

′

s

表示源域特征经过特征提取器后的特征表示,x

′

t

表示目的域特征经过特征提取器后的特

征表示,σ表示求和,m表示源域特征数目,n表示目的域特征数目。有效降低混淆器损失。

[0029]

作为优选,所述s3中:设置域混淆器的梯度惩罚包括由于公式(3)中有‖f‖

l

≤1的约束,所以在域混淆器中针对w增加梯度惩罚式子如下:

[0030][0031]

式子中为特征表示,x

′

表示特征经过特征提取器后的特征表示,表示对x

′

求导,‖

…

‖2表示对其中的数先求平方和,再开根号;将w参数更新包括将 wasserstein距离的损失与梯度惩罚项相减,再针对w参数进行梯度更新,式子如下:

[0032][0033]

式子中,γ为混淆参数,α1为学习率,w表示域混淆器的权重;当迭代次数小于设定的域混淆器的迭代次数时,返回s2;否则,进入s4。能够得到接近的数据。

[0034]

作为优选,所述s4中:采用关联强化的分类器包括将经过特征提取器后的源域和目的域特征表示进行点积运算,如下公式:

[0035]

m

st

=<x

′

s

,x

′

t

>

[0036]

式子中,x

′

s

表示经过特征提取器的源域特征表示,x

′

t

表示经过特征提取器的目的域表示,m

st

表示源域和目的域的特征表示的点积;求源域到目的域特征表征的相似度包括对m

st

采用softmax的方法,将x

′

s

和x

′

t

相似的概率采用下面的公式表示:

[0037][0038]

式子中,p

st

表示源域特征与目的域特征相似度的概率,m

st

表示源域和目的域的特征表示的点积,σ

t

表示特征的总数;求目的域到源域特征表征的相似度包括对m

st

进行转置得到m

ts

,m

ts

表示目标域和源域的特征表示的点积,再重复步骤八的步骤得到p

ts

,p

ts

表示源域特征与目的域特征相似度的概率。提高数据关联度。

[0039]

作为优选,所述s5中:获得源域目的域的往返概率包括相乘得到的p

st

、p

ts

,公式如下:

[0040]

p

sts

=p

st

p

ts

;

[0041]

式子中,p

sts

表示p

st

和p

ts

的乘积;计算源域标签概率l

zw

包括把源域一个特征记为s

a

,特征经过目的域映射后又返回源域的特征记为s

b

,如果s

a

的类别和s

b

的类别相等,记为式子如下:

[0042][0043]

通过交叉熵损失计算损失包括式子如下:

[0044]

wloss=h(l

zw

,p

sts

)

[0045]

式子中,h表示交叉熵损失,l

zw

表示源域标签概率,p

sts

表示特征在源域目的域的往返概率,wloss表示l

zw

和p

sts

经过交叉熵损失后的值。获得更接近数据。

[0046]

作为优选,所述s6中:设定访问概率p

v

包括,确保每个目的域的样本都能被关联,式子如下:

[0047][0048]

表示经过特征提取器后的每个源域特征相似度概率的总和;设置目的域标签概率l

op

包括公式如下:

[0049][0050]

式子中t

a

表示目的域的特征;采用交叉熵损失计算l

op

和p

v

的损失包括式子如下:

[0051]

vloss=h(l

op

,p

v

)

[0052]

式子中,vloss表示l

op

和p

v

经过交叉熵损失后的值。获得更接近数据。

[0053]

作为优选,所述s7中:设置分类器损失包括公式如下:

[0054][0055]

设置源域预测分类损失包括公式如下:

[0056][0057]

式子中,y表示目的域特征真实标签,表示目的域特征预测标签,模型的损失表达式包括如下公式:

[0058]

有效获取更有效数据。

[0059]

作为优选,所述s3中,更新w参数包括混淆参数γ可以设置为10,学习率α1可以设置为0.01。提高数据处理效果。

[0060]

作为优选,反向传播说明为:

[0061][0062][0063]

式子中,ω1表示特征提取器权重。ω2表示分类器权重。α2表示分类器的学习率,α1表示域混淆器的学习率,γ表示系数,表示源域预测分类损失,表示分类器损失表示域混淆器的损失,表示梯度惩罚,分类器的学习率α2可以设置为0.001,域混淆器权重ω3可以设置为0.01,系数γ可以设置为10。提高数据处理效果。

[0064]

本发明的实施方式具有如下优点:

[0065]

通过减小wasserstein距离的方法最大程度的减小源域受试者和目的域受试者的边缘概率分布,再通过关联强化的方法减小条件概率分布,加强了类别的内在联系,为脑电

情绪识别的深度迁移方法提供了一种准确率更高的方法。

附图说明

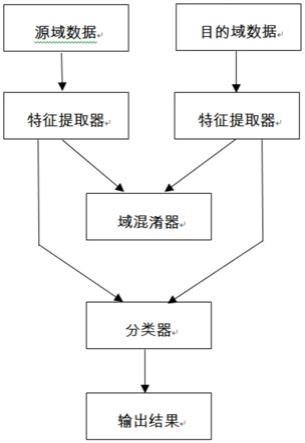

[0066]

为了更清楚地说明发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍。显而易见地,下面描述中的附图仅仅是示例性的,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图引伸获得其它的实施附图。

[0067]

本说明书所绘示的结构、比例、大小等,均仅用以配合说明书所揭示的内容,以供熟悉此技术的人士了解与阅读,并非用以限定本发明可实施的限定条件,故不具技术上的实质意义,任何结构的修饰、比例关系的改变或大小的调整,在不影响本发明所能产生的功效及所能达到的目的下,均应仍落在本发明所揭示的技术内容能涵盖的范围内。

[0068]

图1是本发明的逻辑流程示意图。

具体实施方式

[0069]

以下由特定的具体实施例说明本发明的实施方式,熟悉此技术的认识可由本说明书所揭露的内容轻易地了解本发明的其他优点及功效,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0070]

如图1所示,本发明提供了一种基于wasserstein距离的表征相似对抗网络,其特征在于,包括如下步骤:

[0071]

s1、脑电信号首先以200hz的采样率下采样,在0.5hz

‑

70hz之间用带通滤波器对脑电信号进行处理来滤除噪声和伪影,随机选择一名被试者的脑电信号作为目的域,其他被试者脑电信号作为源域;

[0072]

s2、通过特征提取器将数据映射到一个特征空间并设置域混淆器的 wasserstein距离;

[0073]

s3、设置域混淆器的梯度惩罚并更新w参数;

[0074]

s4、采用关联强化的分类器并求源域到目的域特征表征的相似度以及目的域到源域特征表征的相似度;

[0075]

s5、计算源域目的域的往返概率和计算源域标签概率并用交叉熵损失计算损失;

[0076]

s6、设定访问概率与目的域标签概率并用交叉熵损失计算损失;

[0077]

s7、设置分类器损失与源域预测分类损失并计算模型损失,设置迭代次数 n,当训练次数达到迭代次数后停止。

[0078]

所述s1中:滤除噪声和伪影包括使用1s长非重叠汉宁窗的短时傅里叶变换计算5个频带(δ:1

‑

3hz,θ:4

‑

7hz,α:8

‑

13hz,β:14

‑

30hz,γ:31

‑

50hz) 中的传统de特征,引入线性动态系统来过滤无关信息。

[0079]

所述s2中:特征提取器是由310

‑

128的全连接层构成,特征通过特征提取器后,由310维降至128维,再经过relu激活,映射关系如下:

[0080]

x

′

s

=f(x

s

) x

′

t

=f(x

t

)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0081]

其中,x

s

为原始源域特征,x

t

为原始目的域特征,f(x)为特征提取器,x

′

s

和 x

′

t

表

示源域和目的域在相同特征空间中的128维特征表示;wasserstein距离可以减小源域和目的域边缘概率分布,wasserstein距离的表达式如下:

[0082][0083]

式子中,p

a

表示特征空间中的随机位置a的边缘概率分布,p

b

表示特征空间中的另一个位置b的边缘概率分布,inf表示结果的下确界,μ(p

a

,p

b

)是p

a

和p

b

组合的所有联合概率分布的集合,ε为可能组合的联合概率分布,‖x

‑

y‖为随机样本x和y的距离,e为随机样本距离的期望值,w(p

a

,p

b

)是最优路径的最小消耗;在式子中,由于不能直接求出结果,所以根据坎托罗维奇

‑

鲁宾斯坦对偶定理,将式子(2)变成如下形式:

[0084][0085]

式子中,sup表示上确界,表示在边缘概率分布p

a

下样本x对函数f(x) 的期望值,表示在边缘概率分布p

b

下样本x对函数f(x)的期望值,‖f‖

l

表示lipschitz常数,它的定义为:

[0086]

‖f‖

l

=sup|f(x1)

‑

f(x2)|/|x1‑

x2|

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0087]

由于经过特征提取器后,源域目的域特征映射为x

′

s

和x

′

t

,所以公式(3) 改为:

[0088][0089]

可以通过调整参数w来最大化域混淆器的损失,以近似的表示wasserstein 距离,所以把公式(5)改为:

[0090][0091]

式子中,d表示域混淆器,等价于公式(5)中的f

w

(),表示域混淆器的损失, x

′

s

表示源域特征经过特征提取器后的特征表示,x

′

t

表示目的域特征经过特征提取器后的特征表示,σ表示求和,m表示源域特征数目,n表示目的域特征数目。

[0092]

所述s3中:设置域混淆器的梯度惩罚包括由于公式(3)中有‖f‖

l

≤1的约束,所以在域混淆器中针对w增加梯度惩罚式子如下:

[0093][0094]

式子中为特征表示,x

′

表示特征经过特征提取器后的特征表示,表示对x

′

求导,‖

…

‖2表示对其中的数先求平方和,再开根号;将w参数更新包括将 wasserstein距离的损失与梯度惩罚项相减,再针对w参数进行梯度更新,式子如下:

[0095][0096]

式子中,γ为混淆参数,α1为学习率,w表示域混淆器的权重;当迭代次数小于设定的域混淆器的迭代次数时,返回s2;否则,进入s4。

[0097]

所述s4中:采用关联强化的分类器包括将经过特征提取器后的源域和目的域特征

表示进行点积运算,如下公式:

[0098]

m

st

=<x

′

s

,x

′

t

>

[0099]

式子中,x

′

s

表示经过特征提取器的源域特征表示,x

′

t

表示经过特征提取器的目的域表示,m

st

表示源域和目的域的特征表示的点积;求源域到目的域特征表征的相似度包括对m

st

采用softmax的方法,将x

′

s

和x

′

t

相似的概率采用下面的公式表示:

[0100][0101]

式子中,p

st

表示源域特征与目的域特征相似度的概率,m

st

表示源域和目的域的特征表示的点积,σ

t

表示特征的总数;求目的域到源域特征表征的相似度包括对m

st

进行转置得到m

ts

,m

ts

表示目标域和源域的特征表示的点积,再重复步骤八的步骤得到p

ts

,p

ts

表示源域特征与目的域特征相似度的概率。

[0102]

所述s5中:获得源域目的域的往返概率包括相乘得到的p

st

、p

ts

,公式如下:

[0103]

p

sts

=p

st

p

ts

;

[0104]

式子中,p

sts

表示p

st

和p

ts

的乘积;计算源域标签概率l

zw

包括把源域一个特征记为s

a

,特征经过目的域映射后又返回源域的特征记为s

b

,如果s

a

的类别和s

b

的类别相等,记为式子如下:

[0105][0106]

通过交叉熵损失计算损失包括式子如下:

[0107]

wloss=h(l

zw

,p

sts

)

[0108]

式子中,h表示交叉熵损失,l

zw

表示源域标签概率,p

sts

表示特征在源域目的域的往返概率,wloss表示l

zw

和p

sts

经过交叉熵损失后的值;

[0109]

所述s6中:设定访问概率p

v

包括,确保每个目的域的样本都能被关联,式子如下:

[0110][0111]

表示经过特征提取器后的每个源域特征相似度概率的总和;设置目的域标签概率l

op

包括公式如下:

[0112][0113]

式子中t

a

表示目的域的特征;采用交叉熵损失计算l

op

和p

v

的损失包括式子如下:

[0114]

vloss=h(l

op

,p

v

)

[0115]

式子中,vloss表示l

op

和p

v

经过交叉熵损失后的值;

[0116]

所述s7中:设置分类器损失包括公式如下:

[0117][0118]

设置源域预测分类损失包括公式如下:

[0119][0120]

式子中,y表示目的域特征真实标签,表示目的域特征预测标签,模型的损失表达式包括如下公式:

[0121][0122]

所述s3中,更新w参数包括混淆参数γ可以设置为10,学习率α1可以设置为0.01。

[0123]

反向传播说明为:

[0124][0125][0126]

式子中,ω1表示特征提取器权重。ω2表示分类器权重。α2表示分类器的学习率,α1表示域混淆器的学习率,γ表示系数,表示源域预测分类损失,表示分类器损失表示域混淆器的损失,表示梯度惩罚,分类器的学习率α2可以设置为0.001,域混淆器权重ω3可以设置为0.01,系数γ可以设置为10。

[0127]

本发明在使用时,选取一组实验中的一个被试者作为目的域,取剩下两组实验中除作为目的域被试者以外的14个被试者作为源域。即把三组实验分别记为a,b,c。a组实验中的15个被试者记为a1、a2

…

a15;b组实验中的15个被试者记为b1、b2

…

b15;c组实验中的15个被试者记为c1、c2

…

c15。假设取a1作为目的域,那么就把b2、b3

…

b15,c2、c3

…

c15作为源域,最后把数据作为输入放进网络中运行即可得出每一个被试者的准确率。以此类推,对每一组的15个被试者进行实验,最后对每一组的15个被试者取平均值,得到每一组的平均准确率。

[0128]

为证明上述方法的可行性,下面使用seed数据集对该算法进行检验;

[0129]

数据提取的方法如下:首先选择15个电影片段作为刺激源,其中5个电影片段正面情绪,5个电影片段中性情绪,5个电影片段负面情绪。共有15名中国受试者,每个受试者需要把15个电影片段都观看完,因此在一组实验中每个受试者需要做15次实验。相同的实验重复做三组,每一组间隔一周。

[0130]

数据集先下采样到200hz。应用了0

‑

75hz的带通频率滤波器,提取了与每部电影的时长相对应的脑电图片段,再提取eeg信号的de特征,使用传统的移动平均和线性动态系统(lds)方法进行平滑处理。

[0131]

下面选取了脑电情绪识别中常用的几种深度迁移学习方法进行对比。

[0132]

tca:一种边缘分布自适应方法,是迁移学习中数据分布自适应的经典方法。也可被应用于脑电型号的迁移学习中。

[0133]

svm:机器学习中经典的分类器,具有较好的数学理论支撑。

[0134]

dan:又叫深度适配网络。在深度迁移学习中具有较好的分类效果。

[0135]

jdan:又叫联合概率分布网络。他结合了边缘概率分布和条件概率分布进行迁移学习。

[0136][0137]

从以上结果可以看出,本发明为脑电情绪识别的深度迁移方法提供了一种准确率更高的方法。

[0138]

虽然,上文中已经用一般性说明及具体实施例对本发明作了详尽的描述,但在本发明基础上,可以对之作一些修改或改进,这对本领域技术人员而言是显而易见的。因此,在不偏离本发明精神的基础上所做的这些修改或改进,均属于本发明要求保护的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1