一种数字化信息风险监控方法及装置与流程

1.本发明涉及大数据领域,尤其涉及一种数字化信息风险监控方法及装置。

背景技术:

2.近年来,数字经济蓬勃发展,企业在推动生产力发展和生产关系变革的同时带来了企业快速发展和新机遇,但同时企业在数字化转型升级过程中也遇到一些信息化、数字化安全风险,如企业数据泄露事件。随着民众对自身隐私和数据安全保护意识逐步提高,数据安全也越来越受到国家以及各界关注,企业一旦发生数据泄露会面临风险:客户资损风险:用户数据泄露其信息会被不法分子利用进行诈骗或盗刷(金融数据),对用户造成资损;舆情危机风险:降低用户信任感,影响公司市场口碑和声誉,促使用户放弃使用产品、增加用户流失率;监管合规风险:带来法律法规风险,甚至是行政或刑事处罚。目前全球各国相继制定和完善数据安全相关法律法规,如欧盟gdpr规定“企业发生数据泄露最高受到当年全球营业额的4%或最高2000万欧元处罚”,而我国在数据安全法规制定方面也日趋和国际接轨。

技术实现要素:

3.本发明提供的一种数字化信息风险监控方法,旨在解决现有技术中对企业数字化信息中的敏感数据处理不够彻底,对于其中报文数据存在重复处理导致效率低,并且数据落库后进行风险监控不及时,不能及时告警而形成闭环的风险处理的问题。

4.为实现上述目的,本发明采用以下技术方案:获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;从所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处理,得到第二报文数据;利用多模式匹配算法对所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;将完成所述识别处理后的第二报文数据落库,并进行风险监控。

5.作为优选,所述获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据,包括以下步骤:通过配置脚本和应用接口,采集原始流量数据,所述脚本用于控制采集频率和限制采集的数据内容;将所述原始流量数据按照网络报文格式进行解码获取第一报文数据;根据预设的过滤规则对所述第一报文数据进行筛选过滤并格式化后,通过所述脚本推送到消息队列。

6.作为优选,所述从所述消息队列中获取所述筛选处理后的第一报文数据并进行去

重合并处理,得到第二报文数据,包括:从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,利用信息摘要算法将所述关键参数顺序拼接加密后生成唯一哈希值;根据所述哈希值进行去重合并处理;作为优选,所述利用多模式匹配算法对所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签,包括:根据预设关键字和预设正则表达式对所述第二报文数据的正文内容进行匹配,当匹配相符时,对所述匹配相符的正文内容添加敏感标签;所述预设关键字表示个人隐私身份数据,所述预设正则表达式表示被用来检索、替换那些符合某个模式的文本。

7.作为优选,所述将完成所述识别处理后的第二报文数据落库,并进行风险监控,包括:通过所述哈希值判断第三报文数据是否是新落库的,若数据库中不存在相同的所述哈希值,所述第三报文数据是新落库的,并发起告警推送,以进行风险监控,所述第三报文数据是完成所述识别处理后的第二报文数据落库后得到的;若数据库中存在相同的所述哈希值,则判断是否存在相同的所述敏感标签,若是则设置所述第三报文数据的敏感标签的状态为已修复状态,若否则不进行更新操作;一种数字化信息风险监控装置,包括:获取模块:用于获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;去重模块:用于从所述获取模块的所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处理,得到第二报文数据;识别模块:用于利用多模式匹配算法对所述去重模块得到的所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;监控模块:用于将完成所述识别处理后的第二报文数据落库,并进行风险监控。

8.作为优选,所述获取模块具体包括:配置单元:用于通过配置脚本和应用接口,采集原始流量数据,所述脚本用于控制采集频率和限制采集的数据内容;解码单元:用于将所述配置单元得到所述原始流量数据按照网络报文格式进行解码获取第一报文数据;过滤单元:用于根据预设的过滤规则对所述解码单元得到的所述第一报文数据进行筛选过滤并格式化后,通过所述脚本推送到消息队列。

9.作为优选,所述去重模块具体包括:加密单元:用于从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,利用信息摘要算法将所述关键参数顺序拼接加密后生成唯一哈希值;去重子单元:用于根据所述加密单元得到的所述哈希值进行去重合并处理。

10.作为优选,所述识别模块具体包括:匹配单元:用于根据预设关键字和预设正则表达式对所述第二报文数据的正文内容进行匹配,当匹配相符时,对所述匹配相符的正文内容添加敏感标签;所述预设关键字表示个人隐私身份数据,所述预设正则表达式表示被用来检索、替换那些符合某个模式的文

本。

11.作为优选,所述监控模块具体包括:第一判断单元:用于通过所述哈希值判断第三报文数据是否是新落库的,若数据库中不存在相同的所述哈希值,所述第三报文数据是新落库的,并发起告警推送,以进行风险监控,所述第三报文数据是完成所述识别处理后的第二报文数据落库后得到的;第二判断单元:若数据库中存在相同的所述哈希值,则判断是否存在相同的所述敏感标签,若是则设置所述第三报文数据的敏感标签的状态为已修复状态,若否则不进行更新操作。

12.一种电子设备,包括存储器和处理器,所述存储器用于存储一条或多条计算机指令,其中,所述一条或多条计算机指令被所述处理器执行以实现如上述中任一项所述的一种数字化信息风险监控方法。

13.一种存储有计算机程序的计算机可读存储介质,所述计算机程序使计算机执行时实现如上述中任一项所述的一种数字化信息风险监控方法。

14.本发明具有如下有益效果:本技术整个过程自动化程度高,具有采集、清洗、识别、展示、告警等一系列功能;各模块通过协同工作和逻辑判断,完成敏感数据发现、告警、处理、验证等的全生命周期管理;并且该装置使用简单,可扩展性强,可适用于应用接口敏感数据识别和数据库敏感数据识别,极大的方便企业信息风险管理。

附图说明

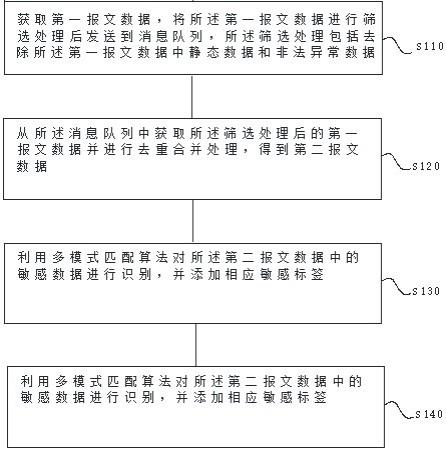

15.图1是本发明实施例实现一种数字化信息风险监控方法第一流程图;图2是本发明实施例实现一种数字化信息风险监控方法第二流程图;图3是本发明实施例实现一种数字化信息风险监控方法第三流程图;图4是本发明实施例实现一种数字化信息风险监控方法具体实施流程图;图5是本发明实施例实现一种数字化信息风险监控装置示意图;图6是本发明实施例实现一种数字化信息风险监控装置的获取模块示意图;图7是本发明实施例实现一种数字化信息风险监控装置的去重模块示意图;图8是本发明实施例实现一种数字化信息风险监控装置的识别模块示意图;图9是本发明实施例实现一种数字化信息风险监控装置的监控模块示意图;图10是本发明实施例实现一种数字化信息风险监控装置具体实施流程图;图11是本发明实施例实现一种数字化信息风险监控装置的一种电子设备示意图。

具体实施方式

16.下面将结合附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例,基于本发明中的实施例,本领域技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

17.本技术的权利要求书和说明书的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序,应该理解这样使用的术语在适当情况下可以互

换,这仅仅是描述本技术的实施例中对相同属性的对象在描述时所采用的区分方式,此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,以便包含一系列单元的过程、方法、系统、产品或设备不必限于那些单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其他单元。

18.除非另有定义,本文所使用的所有的技术和科学术语与属于本技术的技术领域的技术人员通常理解的含义相同,本文中在本技术的说明书中所使用的术语只是为了描述具体的实施例的目的,不是在于限制本技术。

19.实施例1如图1所示,一种数字化信息风险监控方法,包括以下步骤:s110、获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;s120、从所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处理,得到第二报文数据;s130、利用多模式匹配算法对所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;s140、将完成所述识别处理后的第二报文数据落库,并进行风险监控。

20.在实施例1中,数字信息主要是指企业的信息资产数据,而敏感数据是指泄漏后可能会给社会或个人带来严重危害的数据。包括个人隐私数据,如姓名、身份证号码、住址、电话、银行账号、邮箱、密码、医疗信息、教育背景等;也包括企业或社会机构不适合公布的数据,如企业的经营情况,企业的网络结构、ip地址列表等。静态资源可以理解为前端的固定页面,这里面包含html、css、js、图片等等,不需要查数据库也不需要程序处理,直接就能够显示的页面,如果想修改内容则必须修改页面,但是访问效率相当高,因此这类数据不需要参与敏感数据的识别和标记中,还有其中的非法异常数据,这类数据可能会直接造成服务器的崩溃,或者本身内容是不合法,也是企业风险监控中不需要的。从消息队列中源源不断的获取报文数据,再进行判断是否有重复的,减少不必要的工作量,提高效率。然后,进行敏感数据识别处理,若视为敏感数据则需要添加敏感标签,以表明该数据为敏感内容,再后续落库中提醒相关人员。最后,经过所有处理后,存储入数据库中,并发起告警推送,以进行风险监控。本技术整个过程自动化程度高,具有采集、清洗、识别、展示、告警等一系列功能;各模块通过协同工作和逻辑判断,完成敏感数据发现、告警、处理、验证等的全生命周期管理;并且该装置使用简单,可扩展性强,可适用于应用接口敏感数据识别和数据库敏感数据识别,极大的方便企业信息风险管理。

21.实施例2如图2所示,一种数字化信息风险监控方法,包括:s210、通过配置脚本和应用接口,采集原始流量数据,所述脚本用于控制采集频率和限制采集的数据内容;s220、将所述原始流量数据按照网络报文格式进行解码获取第一报文数据;s230、根据预设的过滤规则对所述第一报文数据进行筛选过滤并格式化后,通过所述脚本推送到消息队列;s240、从所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处

理,得到第二报文数据;s250、利用多模式匹配算法对所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;s260、将完成所述识别处理后的第二报文数据落库,并进行风险监控。

22.由实施例2可知,首先在企业应用网关层也就是防火墙,负载均衡软件中插入配置脚本,并设置采集频率、采集数据内容、kafka服务ip、kafka服务队列、过滤规则等必要参数。再通过软件服务端的ngx_lua模块提供的开放接口获取原始的流量数据,这里的脚本为接口限定了采集的数据内容,也就通过接口就可以采集到需要的内容,其中ngx

‑

lua模块的原理是在每个工作进程中创建一个lua vm,工作线程内所有协程共享vm,将接口获得的数据原语封装注入lua vm,允许lua代码直接访问;每个外部请求都由一个lua协程处理,协程之间数据隔离,lua代码调用接口时,会挂起当前协程以保护上下文数据,而不阻塞工作线程,接口完成时还原相关协程上下文数据,并继续运行。获得原始的流量数据后,按照网络报文格式进行解码获取可读的报文内容。再按照设置的过滤规则对解码后的报文数据进行过滤,所述过滤规则具体如:通过匹配资源请求参数过滤静态资源请求报文、匹配响应状态值过滤非法或异常的报文数据。将过滤处理后的报文进行压缩、格式化处理,组装成格式一致的json字符串,将格式化组装后的报文通过脚本推送到预设的kafka服务器消息队列中。这里配置脚本可以采集需要的内容和采集频率,结合将报文数据缓存在消息队列中可以避免流量过大,达到流量削锋的效果。

23.实施例3如图3所示,一种数字化信息风险监控方法,包括:s310、获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;s320、从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,利用信息摘要算法将所述关键参数顺序拼接加密后生成唯一哈希值;根据所述哈希值进行去重合并处理;s330、根据预设关键字和预设正则表达式对所述第二报文数据的正文内容进行匹配,当匹配相符时,对所述匹配相符的正文内容添加敏感标签;所述预设关键字表示个人隐私身份数据,所述预设正则表达式表示被用来检索、替换那些符合某个模式的文本;s340、将完成所述识别处理后的第二报文数据落库,并进行风险监控。

24.实施例3中,从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,所述关键参数包括url值、host值、请求方法method值、请求参数key等暴露地址的数据,按顺序拼接后通过md5加密生成唯一哈希值。具有相同哈希值的报文视为同一数据,仅保留第一个报文,后续具有相同哈希值的报文直接舍弃;因为推送到消息队列中的报文数据是源源不断的,每获取一个报文数据,则生成对应的哈希值,通过哈希值来判断是否存在相同的报文数据。再进行敏感数据识别,首先将报文中的正文内容(包括请求头、请求体、响应头、响应体)与预先定义的关键字(如:phonenumber(电话号码)、cardno(卡号)、idcard(身份证号)等)进行匹配,当报文内容中存在相应关键字时,对该报文数据设置对应的敏感标签(如:手机号、身份证等)。再使用预先定义的正则表达式与报文内容进行匹配,当报文内容与正则匹配时,也对该报文数据设置对应的敏感标签;这样经过去重后的报文数据再

进行敏感数据识别,可减少工作量,提高识别效率。

25.实施例4如图4所示,一种具体的实施方式可为:s410、基于lua语言自主开发了流量采集器,用于采集并解码企业应用网关层的请求和响应报文,采集后初步进行筛选处理,去除静态资源文件及非法异常的报文,将纯净报文数据格式化后发送到kafka消息队列。改采集器核心功能用于解码企业应用网关层的请求和响应报文数据,包括初始化、数据采集、报文解码、报文过滤、报文格式化、消息推送等,具体工作流程如下:1)报文初始化:在应用网关层(防火墙)负载均衡软件中插入配置脚本,并设置采集频率、采集数据内容、kafka服务ip、kafka服务队列、过滤规则等必要参数;2)数据采集:通过ngx_lua提供的开放api获取原始的流量数据;3)报文解码:将采集的原始数据按照http/https网络报文格式进行解码获取可读的报文内容;4)报文过滤:按照设置的过滤规则对解码后的报文数据进行过滤,具体如:通过匹配资源请求参数url过滤静态资源请求报文、匹配响应状态值过滤非法、异常的报文数据;5)报文格式化:将过滤处理后的报文进行压缩、格式化处理,组装成格式一致的json字符串;6)消息推送:将格式化组装后的报文通过lua脚本推送到预设的kafka服务器队列中;s420、使用基于flink流处理程序自主开发消费端,获取采集后的纯净数据。将数据进行去重合并,使用多模式匹配算法引擎对敏感数据进行识别,并添加相应标识字段,具体流程如下:1)获取数据:通过消费kafka数据,获取第1步中推送到kafka的格式化报文数据,根据组装时的数据格式还原出可读的报文数据;2)数据去重:提取报文数据中的url值、host值、请求方法method值、请求参数key等关键参数,按顺序拼接后通过md5生成唯一哈希值。具有相同哈希值的报文视为同一数据,仅保留第一个报文,后续具有相同哈希值的报文直接舍弃;3)敏感数据识别:首先将报文中的正文内容(包括请求头、请求体、响应头、响应体)与预先定义的关键字(如:phonenumber(电话号码)、cardno(卡号)、idcard(身份证号)等)进行匹配,当报文内容中存在相应关键字时,对该报文数据设置对应的敏感标签(如:手机号、身份证等)。再使用预先定义的正则表达式与报文内容进行匹配,当报文内容与正则匹配时,也对该报文数据设置对应的敏感标签;4)数据格式化:将识别后的数据按照哈希值

‑

报文内容

‑

敏感标签进行转换,方便下一步进行数据存储;s430、将完成标识符处理后的数据落库保存,具体流程如下:1)通过所述哈希值判断第三报文数据是否是新落库的,若数据库中不存在相同的所述哈希值,所述第三报文数据是新落库的,并发起告警推送,以进行风险监控,所述第三报文数据是完成所述识别处理后的第二报文数据落库后得到的;2)若数据库中存在相同的所述哈希值,则判断是否存在相同的所述敏感标签,若

是则设置所述第三报文数据的敏感标签的状态为已修复状态,若否则不进行更新操作;通过s520步骤的去重步骤,原则上,相同哈希值的报文数据是不会到次步骤的,但是存在这样一种情况:报文数据中的关键参数有遗漏或者获取到就存在少几项关键参数,这样经过顺序拼接再加密后的哈希值也可能不一样,但是其实报文内容其实是一致的,经过敏感标签标注的内容是一致的,经过此步骤更进一步的去重处理,便于后续的风险监控。

26.s440、展示端读取落库后的数据,以图表形式进行展示,平台运营人员可以通过该展示端查看日常运营数据,增改敏感数据匹配规则,设置告警模版,告警周期等。

27.s450、告警数据推送,当某报文新增敏感数据标签时自动生成相应告警工单发送给相应管理、开发等负责人员,具体流程如下:1)流程发起:当新增数据落库后自动发起告警推送流程;2)关联数据获取:读取落库后的报文内容和敏感标签,解析报文中的header值(对报文中的header字段身份验证),获取header中的服务名称,通过内部资产管理平台开放api获取该服务对应的开发负责人、运维负责人、项目管理负责人等相关的信息;3)工单生成:在预设的模版中设置相关参数,如:告警来源、服务名、报文内容、开发负责人、运维负责人、项目管理负责人等相关信息,生成告警工单;4)告警推送:将自动生成的工单通过邮件和企业im推送给开发负责人、运维负责人、项目管理负责人等相关人员;s460、负责人员完成敏感数据的脱敏治理后处理告警工单,平台在t+1日后自动完成新数据的识别,若不存在敏感数据,则完成治理,关闭告警工单;若仍旧存在敏感数据,则治理未成功,重置告警工单,重新发送告警给相应负责人员并定起跟进提醒;实施例5如图5所示,一种数字化信息风险监控装置,包括:获取模块10:用于获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;去重模块20:用于从所述获取模块10的所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处理,得到第二报文数据;识别模块30:用于利用多模式匹配算法对所述去重模块20得到的所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;监控模块40:用于将完成所述识别处理后的第二报文数据落库,并进行风险监控。

28.上述装置的一种实施方式可为:获取模块10获取第一报文数据,将所述第一报文数据进行筛选处理后发送到消息队列,所述筛选处理包括去除所述第一报文数据中静态数据和非法异常数据;去重模块20从所述获取模块10的所述消息队列中获取所述筛选处理后的第一报文数据并进行去重合并处理,得到第二报文数据;识别模块30利用多模式匹配算法对所述去重模块20得到的所述第二报文数据中的敏感数据进行识别,并添加相应敏感标签;监控模块40将完成所述识别处理后的第二报文数据落库,并进行风险监控。

29.实施例6如图6所示,一种数字化信息风险监控装置的获取模块10包括:配置单元12:用于通过配置脚本和应用接口,采集原始流量数据,所述脚本用于控制采集频率和限制采集的数据内容;

解码单元14:用于将所述配置单元12得到所述原始流量数据按照网络报文格式进行解码获取第一报文数据;过滤单元16:用于根据预设的过滤规则对所述解码单元14得到的所述第一报文数据进行筛选过滤并格式化后,通过所述脚本推送到消息队列。

30.上述装置的获取模块10的一种实施方式可为:配置单元12通过配置脚本和应用接口,采集原始流量数据,所述脚本用于控制采集频率和限制采集的数据内容;解码单元14将所述配置单元12得到所述原始流量数据按照网络报文格式进行解码获取第一报文数据;过滤单元16根据预设的过滤规则对所述解码单元14得到的所述第一报文数据进行筛选过滤并格式化后,通过所述脚本推送到消息队列。

31.实施例7如图7所示,一种数字化信息风险监控装置的去重模块20包括:加密单元22:用于从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,利用信息摘要算法将所述关键参数顺序拼接加密后生成唯一哈希值;去重子单元24:用于根据所述加密单元22得到的所述哈希值进行去重合并处理。

32.上述装置的去重模块20的一种实施方式可为:加密单元22从所述消息队列中获取所述筛选处理后的第一报文数据,从中提取关键参数,利用信息摘要算法将所述关键参数顺序拼接加密后生成唯一哈希值;去重子单元24根据所述加密单元22得到的所述哈希值进行去重合并处理。

33.实施例8如图8所示,一种数字化信息风险监控装置的识别模块30包括:匹配单元32:用于根据预设关键字和预设正则表达式对所述第二报文数据的正文内容进行匹配,当匹配相符时,对所述匹配相符的正文内容添加敏感标签;所述预设关键字表示个人隐私身份数据,所述预设正则表达式表示被用来检索、替换那些符合某个模式的文本。

34.实施例9如图9所示,一种数字化信息风险监控装置的监控模块40包括:第一判断单元42:用于通过所述哈希值判断第三报文数据是否是新落库的,若数据库中不存在相同的所述哈希值,所述第三报文数据是新落库的,并发起告警推送,以进行风险监控,所述第三报文数据是完成所述识别处理后的第二报文数据落库后得到的;第二判断单元44:若数据库中存在相同的所述哈希值,则判断是否存在相同的所述敏感标签,若是则设置所述第三报文数据的敏感标签的状态为已修复状态,若否则不进行更新操作。

35.实施例10如图10所示,一种具体的实施装置可为:数据采集层:基于lua语言自主开发了流量采集器,用于采集并解码企业应用网关层的请求和响应报文,采集后初步进行筛选处理,去除静态资源文件及非法异常的报文,将纯净报文数据格式化后发送到kafka消息队列。改采集器核心功能用于解码企业应用网关层的请求和响应报文数据,包括初始化、数据采集、报文解码、报文过滤、报文格式化、消息推送等。

36.数据处理层:使用基于flink流处理程序自主开发消费端,获取采集后的纯净数据。将数据进行去重合并,使用多模式匹配算法引擎对敏感数据进行识别,并添加相应标识字段。

37.数据存储层:将完成标识符处理后的数据落库保存。

38.数据展示层:展示端读取落库后的数据,以图表形式进行展示,平台运营人员可以通过该展示端查看日常运营数据,增改敏感数据匹配规则,设置告警模版,告警周期等。

39.实施例11如图11所示,一种电子设备,包括存储器1101和处理器1102,所述存储器1101用于存储一条或多条计算机指令,其中,所述一条或多条计算机指令被所述处理器1102执行以实现上述的一种数字化信息风险监控方法。

40.所属领域的技术人员可以清楚地了解到,为描述的方便和简洁,上述描述的电子设备的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

41.一种存储有计算机程序的计算机可读存储介质,所述计算机程序使计算机执行时实现如上述的一种数字化信息风险监控方法。

42.示例性的,计算机程序可以被分割成一个或多个模块/单元,一个或者多个模块/单元被存储在存储器1101中,并由处理器1102执行,并由输入接口1105和输出接口1106完成数据的i/o接口传输,以完成本发明,一个或多个模块/单元可以是能够完成特定功能的一系列计算机程序指令段,该指令段用于描述计算机程序在计算机设备中的执行过程。

43.计算机设备可以是桌上型计算机、笔记本、掌上电脑及云端服务器等计算设备。计算机设备可包括,但不仅限于,存储器1101、处理器1102,本领域技术人员可以理解,本实施例仅仅是计算机设备的示例,并不构成对计算机设备的限定,可以包括更多或更少的部件,或者组合某些部件,或者不同的部件,例如计算机设备还可以包括输入器1107、网络接入设备、总线等。

44.处理器1102可以是中央处理单元(centralprocessingunit,cpu),还可以是其他通用处理器1102、数字信号处理器1102(digitalsignalprocessor,dsp)、专用集成电路(applicationspecificintegratedcircuit,asic)、现成可编程门阵列(field

‑

program503mablegatearray,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器1102可以是微处理器1102或者该处理器1102也可以是任何常规的处理器1102等。

45.存储器1101可以是计算机设备的内部存储单元,例如计算机设备的硬盘或内存。存储器1101也可以是计算机设备的外部存储设备,例如计算机设备上配备的插接式硬盘,智能存储卡(smartmediacard,smc),安全数字(securedigital,sd)卡,闪存卡(flashcard)等,进一步地,存储器1101还可以既包括计算机设备的内部存储单元也包括外部存储设备,存储器1101用于存储计算机程序以及计算机设备所需的其他程序和数据,存储器1101还可以用于暂时地存储在输出器1108,而前述的存储介质包括u盘、移动硬盘、只读存储器rom1103、随机存储器ram1104、碟盘或光盘等各种可以存储程序代码的介质。

46.以上所述仅为本发明的具体实施例,但本发明的技术特征并不局限于此,任何本领域的技术人员在本发明的领域内,所作的变化或修饰皆涵盖在本发明的专利范围之中。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1