一种带噪的半监督意图识别模型训练方法与流程

1.本发明涉及客服机器人技术领域,具体涉及一种带噪的半监督意图识别模型训练方法。

背景技术:

2.随着自然语言处理技术的发展,机器与人的沟通变得越来越流畅,客服行业将变成人工智能技术争相抢占的“新高地”,越来越多的人工客服可能会被智能机客服机器人所取代。在客服机器人接受客户咨询时,首先要解决的就是意图识别的问题,即客服机器人需要理解客户的咨询目的,然后进入下一步节点动作。因此,对于智能客服服务而言,意图识别模型的识别准确度至关重要,而如何基于神经网络训练形成具有高识别准确率的意图识别模型成为意图识别的技术关键。

3.不同于“小爱同学”“siri”等现有的“闲聊型”机器人,客服机器人具有更强地服务目的,属于“任务型”智能机器人。在训练意图识别模型时,通常先列举出客户可能的咨询目的,在客户咨询时将客户话术分类为某个意图,也就是说将意图识别转化为一个文本分类的问题。

4.意图识别模型的训练优化依赖于企业客服部门接受客户咨询时记录的大量语料数据。目前,需要意图识别模型主要采用全监督训练和半监督训练方法,在全监督训练中,所有的语料数据需要经人工标注,赋予每条语料数据对应的“意图标签”后进行模型训练。但由于大量语料数据不容易得到,现在出现了一些半监督的模型训练方法,例如“pi”和“虚拟对抗”训练方法,二者都有带标签训练和无标签训练两个过程。带标签训练都是传统的全监督训练过程。在无标签训练时,两者都依靠一致性正则的思路,对同一批次输入样本,需要添加扰动后进行两次前向运算,对于同一输入计算得到两个预测结果,由于扰动以及模型结构中的随机因素,两个预测结果并不相同。之后用一种损失函数来衡量两个预测结果之间的“距离”,通过减小该距离来提升模型在扰动下的一致性。“pi”和“虚拟对抗”的半监督模型训练方法的区别在于扰动的产生方式和损失函数的选择不同,“pi”方法选择随机数作为扰动,选择最小均方误差(mse)作为损失函数;“虚拟对抗”方法则是利用“梯度上升”方法改变输入,选择kl散度作为损失函数。

5.综上所述,现有的全监督以及例如“pi”“虚拟对抗”等半监督的意图识别模型训练方法存在以下几个缺陷:

6.1、全监督模型训练需要大量的标注数据,大量样本数据不易获得,且对大量样本数据进行人工标注工作量巨大;

7.2、现有的半监督模型训练方法同时需要带标签数据和无标签数据,训练效果十分依赖于带标签数据,但很少有人考虑其中带标签数据的标签正确率问题,实际上,人工标注结果可能并不十分理想,获取的标注数据可能含有一定比例的错误标签,即标签噪声。研究表明,神经网络模型在训练过程中,总是会学到错误标签中的信息,而半监督的训练过程甚至可能会加剧这种错误印象,当标签错误率超出一定范围,多用了很多无标签数据的半监

督训练可能还不如使用少量标签数据的全监督训练得到的模型精度来得高。

技术实现要素:

8.本发明的目的是提供一种带噪的半监督意图识别模型训练方法,通过融合并改进“pi”和“虚拟对抗”这两种经典的半监督训练方法,充分利用无标签语料数据,并减少带标签数据中错误标签对半监督训练效果的影响,大幅提高了意图识别模型训练效果。

9.为达此目的,本发明采用以下技术方案:

10.提供一种带噪的半监督意图识别模型训练方法,步骤包括:

11.s1,将无标签数据集合xu和带标签数据集合x

l

打乱混合得到混合数据集合xm;

12.s2,从所述混合数据集合xm中取出一个批次数据集xm是一个大小为[b,d,v]的三维张量,b为该批次数据数量,d为每条数据的截断长度,v为词向量长度,表示数据集xm中的第i个数据;

[0013]

s3,对所述数据集xm进行无标签训练,得到意图识别模型对所述数据集xm的预测输出f(xm,θ)、对所述数据集xm加高斯随机噪声张量r后的预测输出f(xm+r,θ)以及对所述数据集xm添加扰动n后的预测输出f(xm+n,θ),然后计算所述预测输出f(xm,θ)分别与所述预测输出f(xm+r,θ)、所述预测输出f(xm+n,θ)的对称交叉熵

[0014]

θ表示所述意图识别模型的模型参数;

[0015]

s4,取出所述数据集xm中的带标签数据集x

l

及所述带标签数据集x

l

对应的one-hot标签y

l

;

[0016]

s5,对所述带标签数据集x

l

做全监督训练,得到所述意图识别模型对所述带标签数据集x

l

的预测输出f(x

l

,θ),并计算所述预测输出f(x

l

,θ)与所述带标签数据集x

l

对应的数据标签y

l

的对称交叉熵l

sce

;

[0017]

s6,对所述对称交叉熵l

sce

进行求和,得到所述意图识别模型的预测损失loss;

[0018]

s7,根据所述预测损失loss更新模型参数并重复所述步骤s2-s6,经迭代更新训练形成最终的意图识别模型。

[0019]

作为本发明的一种优选方案,步骤s3中,对所述数据集xm进行无标签训练包括第一无标签训练和第二无标签训练,所述第一无标签训练的方法步骤包括:

[0020]

a1,将所述数据集xm输入到所述意图识别模型中,得到模型对所述数据集xm的所述预测输出f(xm,θ);

[0021]

a2,对所述数据集xm加高斯随机噪声张量r后得到数据集xm+r,将所述数据集xm+r输入到所述意图识别模型,得到模型对所述数据集xm+r的所述预测输出f(xm+r,θ);

[0022]

a3,通过以下公式(1)计算所述预测输出f(xm,θ)和所述预测输出f(xm+r,θ)的所述对称交叉熵

[0023][0024]

公式(1)中,表示所述数据集xm中的第i个数据样本;

[0025]ri

表示加在数据样本上的第i个高斯随机噪声张量;

[0026]

表示所述意图识别模型对输入为所述数据样本预测输出的各意图概率分布向量;

[0027]

表示对概率分布向量中的各元素分别求对数;

[0028]

表示所述意图识别模型对输入为数据样本预测输出的各意图概率分布向量;

[0029]

表示对概率分布向量中的各元素分别求对数;

[0030]

权重超参数α1》0、β1》0;

[0031]“·”表示对向量作点积运算。

[0032]

作为本发明的一种优选方案,所述第二无标签训练的步骤包括:

[0033]

b1,计算添加到所述数据集xm上的扰动n;

[0034]

b2,对所述数据集xm添加所述扰动n,得到数据集xm+n;

[0035]

b3,将所述数据集xm+n输入到所述意图识别模型中,得到模型对所述数据集xm+n的所述预测输出f(xm+n,θ);

[0036]

b4,通过以下公式(2)计算所述预测输出f(xm,θ)与所述预测输出f(xm+n,θ)的所述对称交叉熵

[0037][0038]

公式(2)中,ni表示加在所述数据样本上的扰动;

[0039]

表示所述意图识别模型对输入为数据样本预测输出的各意图概率分布向量;

[0040]

表示对分布向量中的各元素分别求对数。

[0041]

作为本发明的一种优选方案,步骤b1中计算所述扰动n的方法包括步骤:

[0042]

b11,计算所述对称交叉熵对所述数据集xm+r的梯度

[0043]

b12,根据以下公式(3)计算所述扰动n:

[0044][0045]

公式(3)中,超参数ε》0;

[0046]

||g||2表示求张量g的二范数,

[0047]ghjk

表示张量g中的每个元素,h,j,k分别对应表示所述数据集xm的三个维度b、d、v。

[0048]

作为本发明的一种优选方案,步骤s5中,所述对称交叉熵l

sce

通过以下公式(4)计算而得:

[0049]

公式(4)中,为一标量,表示标签中“1”对应意图的概率;

[0050]

a为定义的超参数,a=log0;

[0051]

权重超参数α2》0、β2》0。

[0052]

作为本发明的一种优选方案,从thucnews数据集中获取所述无标签数据集合xu和所述带标签数据集合x

l

。

[0053]

本发明具有以下有益效果:

[0054]

1、本发明融合并改进了经典的“pi”和“虚拟对抗”半监督训练方法,在训练意图识别模型时,未经标注的大量无标签语料数据得到了更充分的利用,模型训练效果超越了传统全监督训练方法和“pi”、“虚拟对抗”半监督训练方法;

[0055]

2、考虑到语料数据的人工标注可能存在错误,本发明舍弃了“pi”和“虚拟对抗”半监督方法中使用的mse误差、kl散度传统损失函数,而是将带噪学习领域的对称交叉熵引入半监督学习领域,使得本发明能够有效降低错误标签对模型训练的干扰。

附图说明

[0056]

为了更清楚地说明本发明实施例的技术方案,下面将对本发明实施例中所需要使用的附图作简单地介绍。显而易见地,下面所描述的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0057]

图1是本发明一实施例提供的一种带噪的半监督意图识别模型训练方法的实现步骤图;

[0058]

图2是本发明一实施例提供的第一无标签训练方法的实现步骤图;

[0059]

图3是本发明一实施例提供的第二无标签训练方法的实现步骤图;

[0060]

图4是本发明一实施例计算扰动的方法步骤图;

[0061]

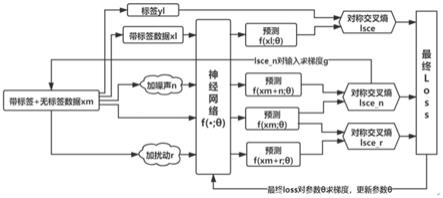

图5是本发明实施例提供的带噪的半监督意图识别模型训练方法的实现原理框图;

[0062]

图6是本发明与传统全监督训练方法、pi半监督训练方法、虚拟对抗半监督训练方法的效果对比图。

具体实施方式

[0063]

下面结合附图并通过具体实施方式来进一步说明本发明的技术方案。

[0064]

其中,附图仅用于示例性说明,表示的仅是示意图,而非实物图,不能理解为对本专利的限制;为了更好地说明本发明的实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;对本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

[0065]

本发明实施例的附图中相同或相似的标号对应相同或相似的部件;在本发明的描述中,需要理解的是,若出现术语“上”、“下”、“左”、“右”、“内”、“外”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示

或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此附图中描述位置关系的用语仅用于示例性说明,不能理解为对本专利的限制,对于本领域的普通技术人员而言,可以根据具体情况理解上述术语的具体含义。

[0066]

在本发明的描述中,除非另有明确的规定和限定,若出现术语“连接”等指示部件之间的连接关系,该术语应做广义理解,例如,可以是固定连接,也可以是可拆卸连接,或成一体;可以是机械连接,也可以是电连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个部件内部的连通或两个部件的相互作用关系。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

[0067]

本发明实施例提供的一种带噪的半监督意图识别模型训练方法,如图1和图5所示,步骤包括:

[0068]

s1,将无标签数据集合xu和带标签数据集合x

l

打乱混合得到混合数据集合xm;无标签数据集合xu和带标签数据集合x

l

优选从thucnews数据集中获取。

[0069]

thucnews数据集是根据新浪新闻rss订阅频道2005-2011年间的历史数据筛选过滤生成,包含74万篇新闻文档,均为utf-8纯文本格式,thucnews数据集中的数据包含财经、彩票、房产、股票、家居、教育、科技、社会、时尚、时政、体育、星座、游戏、娱乐等10余个类别,我们随机选取其中10个类别共1000条带标签数据形成带标签数据集合x

l

和10000条无标签数据形成无标签数据集合xu。

[0070]

s2,从混合数据集合xm中取出一个批次数据集xm(混合批次数据)是一个大小为[b,d,v]的三维张量,b为该批次数据数量,d为每条数据的截断长度,v为词向量长度,表示数据集xm中的第i个数据;

[0071]

本实施例中,一条数据或样本为一句话。一句话有长有短,一般采取“长截断短填充”的方式,即设定好每句话的“截断长度”d,长于这个长度的部分删去不要,短于这个长度的用固定的字符填充。

[0072]

每句话中每一个字用一个向量替换,即“字向量”,“字向量”的维度为v(也有以词为单位的,但本实施例中以字为单位)。

[0073]

这样处理之后,每一句话(或者说每一条数据)都用一个大小为[d,v]的矩阵(或者说向量组)表示,一批次数据用一个大小为[b,d,v]的三维张量表示。

[0074]

s3,对数据集xm进行无标签训练,得到意图识别模型对数据集xm的预测输出f(xm,θ)、对数据集xm加高斯随机噪声张量r后的预测输出f(xm+r,θ)以及对数据集xm添加扰动n后的预测输出f(xm+n,θ),然后计算预测输出f(xm,θ)分别与预测输出f(xm+r,θ)、所述预测输出f(xm+n,θ)的对称交叉熵θ表示意图识别模型的模型参数;

[0075]

本实施例中,对数据集xm进行无标签训练包括第一无标签训练和第二无标签训练,第一无标签训练的方法步骤如图2所示,包括:

[0076]

a1,将数据集xm输入到意图识别模型中,得到模型对数据集xm的预测输出f(xm,θ),f(xm,θ)表示数据集xm对应的各意图概率分布向量组,比如为数据集xm中的第i个数据样本,则模型输出的对应的各意图概率分布向量表示为例如,数据样本为“退货”,“退货”对应的意图包括:(1)怎么退货;(2)退货时限;(3)退款到账时间,根据大数据分

析,当客户与服务机器人聊天时输入“退货”时,意图为“怎么退货”的概率为70%,意图为“退货时限”的概率为10%;意图为“退款到账时间”的概率为20%,则“退货”这一样本数据对应的各意图概率分布向量可以表示为[怎么退货:70%;退货到账时间:10%;退款到账时间:20%]。

[0077]

a2,对数据集xm加高斯随机噪声张量r后得到数据集xm+r,将数据集xm+r输入到意图识别模型,得到模型对数据集xm+r的预测输出f(xm+r,θ);

[0078]

a3,通过以下公式(1)计算预测输出f(xm,θ)和预测输出f(xm+r,θ)的对称交叉熵

[0079][0080]

例如:样本标签可表示为one-hot形式。如果是一个三分类问题,则样本的预测和都可表示成三维向量,假设对于样本

[0081][0082]

则

[0083]

所以就是对向量和向量求点积,即

[0084][0085]

第二项也同理。最终计算所得是一个标量。

[0086]

公式(1)中,表示数据集xm中的第i个数据样本;

[0087]ri

表示加在数据样本上的第i个高斯随机噪声张量;

[0088]

表示意图识别模型对输入为数据样本预测输出的各意图概率分布向量;

[0089]

表示对分布向量中的各元素分别求对数;

[0090]

表示意图识别模型对输入为数据样本预测输出的各意图概率分布向量;

[0091]

表示对分布向量中的各元素分别求对数;

[0092]

权重超参数α1》0、β1》0;

[0093]“·”表示对向量作点积运算。

[0094]

因为模型输出的概率分布向量和没有0元素,故在无标签训练过程中,对称交叉熵的计算不会像传统全监督训练过程中那样出现负无穷大项log0。

[0095]

这里需要说明的是,模型最后的输出之所以是概率分布的形式,是因为模型在最

终输出前做了一个softmax操作,对每一条输入,假设模型在softmax之前计算得到的中间向量为[a1,a2,a3],对该向量做softmax操作后得到因为ea》0恒成立,故模型预测输出向量不会含有0元素。

[0096]

请参照图3,第二无标签训练的方法步骤包括:

[0097]

b1,计算添加到数据集xm上的扰动n;如图4所示,扰动n的计算方法具体包括步骤:

[0098]

b11,计算对称交叉熵对数据集xm+r的梯度g,梯度

[0099]

b12,通过以下公式(3)计算扰动n,

[0100][0101]

公式(3)中,超参数ε》0;

[0102]

||g||2表示求张量g的二范数,

[0103]ghlk

表示张量g中的每个元素,h,l,k分别对应表示数据集xm的三维张量[b,d,v]中的b、d、v,b为数据集xm的数据数量,d为数据集xm中的每条数据的截断长度,v为词向量长度。

[0104]

在b11中,其中是标量,xm+r和xm形状一样,都是维度为[b,d,v]的三维张量。所以求梯度后,g也是维度为[b,d,v]的三维张量,这里用h,j,k三个字母分别对应g的三个维度,g张量里的每个元素记为为g

hjk

。||g||2表示求张量g的二范数,即表示求张量g的二范数,即也就是求这个三维张量中所有元素的平方和后开根号。b为该批次数据数量,d为每条数据的截断长度,v为词向量长度。

[0105]

请继续参照图3,第二无标签训练方法还包括步骤:

[0106]

b2,对数据集xm添加扰动n,得到数据集xm+n;

[0107]

b3,将数据集xm+n输入到意图识别模型中,得到模型对数据集xm+n的预测输出f(xm+n,θ);

[0108]

b4,通过以下公式(2)计算预测输出f(xm,θ)与预测输出f(xm+n,θ)的对称交叉熵+n,θ)的对称交叉熵

[0109]

公式(2)中,ni表示加在数据样本上的扰动;

[0110]

表示意图识别模型对输入为数据样本预测输出的各意图概率分布向量;

[0111]

表示对分布向量中的各元素分别求对数。

[0112]

对称交叉熵的计算过程与对称交叉熵的计算过程相同,在此不再赘述。

[0113]

请继续参照图1和图5,本实施例提供的带噪的半监督意图识别模型训练方法步骤还包括:

[0114]

s4,取出数据集xm中的带标签数据集x

l

及带标签数据集x

l

对应的one-hot标签y

l

,数据集x

l

中数据数量为b

l

;

[0115]

s5,对带标签数据集x

l

做全监督训练,得到意图识别模型对带标签数据集x

l

的预测输出f(x

l

,θ),并通过以下公式(4)计算预测输出f(x

l

,θ)与带标签数据集x

l

对应的数据标签y

l

的对称交叉熵l

sce

:

[0116][0117]

公式(4)中,为一标量,表示标签中“1”对应意图的概率;例如:标签可表示为one-hot形式。如果是一个三分类问题,则样本的标签和预测都可表示成三维向量。若样本属于这三类中的第一类,则其标签假设则即在神经网络模型看来样本属于第一类的概率为0.7。

[0118]

标签中必定含有0元素,这里在计算时必定产生负无穷大项log0。

[0119]

a=log0;

[0120]

权重超参数α2》0、β2》0。

[0121]

因为标签含有0元素,故会出现无穷大项log0。

[0122]

s6,对交叉熵l

sce

进行求和,得到意图识别模型的预测损失loss,即

[0123]

s7,根据预测损失loss更新模型参数并重复步骤s2-s6,经迭代更新训练形成最终的意图识别模型(textcnn网络模型)。具体地,对损失函数loss求梯度,并更新意图识别模型的模型参数θ,即η表示学习率。重复步骤s2-s6,每隔一段时间验证模型的意图识别准确率,若更新了当前最高正确率则保存模型参数。若模型在某次保存参数后,又经过10批次训练模型识别准确率仍未有所提升,则迭代训练过程结束,取最后保存的参数为模型最终的参数,训练得到最终的意图识别模型。

[0124]

图6示出了本发明与传统全监督训练方法、pi半监督训练方法、虚拟对抗半监督训练方法的效果对比图。图6横轴表示带标签数据的标签错误率,从1000个带标签数据中随机选取一定比例,将其标签改错,然后投入训练;纵轴为训练20轮后模型在测试集上的识别正确率,以模型在测试集上的识别正确率作为训练效果的评判基准。根据图6可知:

[0125]

1、当标签错误率为0时,使用了更多无标签数据的三种半监督训练方法都取得了优于全监督训练的效果,这说明在数据集质量较高时,半监督训练方法相比较全监督训练方法更有效。而本发明虽然基于经典的“pi”和“虚拟对抗”两种半监督方法,但相比两者取

得了更好地训练效果。

[0126]

2、随着标签错误率的提升,4种训练方法的训练效果都逐渐下降,这说明错误标签确实会对训练效果产生影响。当标签错误率超过20%(0.2)时,“pi”和“虚拟对抗”两种半监督方法的训练效果甚至不如传统的全监督方法。而本发明的训练效果在4种方式中始终最为优良,这说明本发明通过融合并改良“pi”和“虚拟对抗”两种半监督训练方法,有效降低了错误标签对于意图识别模型训练的影响,具有较强地抗噪性能。

[0127]

需要声明的是,上述具体实施方式仅仅为本发明的较佳实施例及所运用技术原理。本领域技术人员应该明白,还可以对本发明做各种修改、等同替换、变化等等。但是,这些变换只要未背离本发明的精神,都应在本发明的保护范围之内。另外,本技术说明书和权利要求书所使用的一些术语并不是限制,仅仅是为了便于描述。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1