旋转框定位多形态瓶状物品分拣目标检测方法与流程

1.本发明涉及垃圾自动分拣领域,具体涉及一种旋转框定位多形态瓶状物品分拣目标检测方法。

背景技术:

2.在“智能制造”的背景下,利用机器视觉与自动化设备协同配合代替人工流水线垃圾分拣成为发展趋势。若需要对于目标物进行精准且高效率分拣,首先需要机器视觉相关技术获取目标物类别、位姿等信息。

3.垃圾分类标准多样,若采用机械硬件分拣大多按目标物形状大小、质量大小、是否具有磁性等物理性质分类,若采用机器视觉技术分拣,则大多按目标材料、颜色等进行精细分类。同类材质或颜色的目标具有多样化形态结构和多尺度的外形尺寸。瓶状物品是一类高值可回收物品,通常由塑料、玻璃、金属等材质制成。以塑料制品瓶状物为例,药包瓶、眼药水瓶等外形尺寸极小,但大容量矿泉水瓶、饮料瓶等外形尺寸极大,且都易发生变形、堆叠、遮挡与分拣背景混淆等情况,此外分拣流水线高密度堆叠目标物品的复杂场景导致传统目标检测算法模型受特定参数约束条件,在复杂场景下对分拣对象检测的准确性降低,出现较高漏检率及误检率。由于需要对于目标物位姿进行准确识别,即需要获取其位置信息、旋转角度信息等,才可使工业机器人完成精准的抓取分拣操作,快速、准确的图像识别定位方法成为影响整体分拣系统效率的关键因素。综上,亟需开发一种可以解决机器分拣场景时瓶状物品任意位姿和同类别物品多样化形态结构和多尺度外形尺寸导致识别出现较高漏检、误检等问题的目标检测算法。

技术实现要素:

4.本发明要克服现有技术的上述缺点,提供一种旋转框定位多形态瓶状物品分拣目标检测方法。

5.本发明提出旋转框精准定位网络mr

2-yolov5(multi-scale refined rotated yolov5),在保证检测速度的前提下,达到对于垃圾分拣场景目标物的位姿、分类信息的检测。

6.本发明的技术方案是:

7.旋转框定位多形态瓶状物品分拣目标检测方法,包括如下步骤:

8.1、建立数据集;

9.实际流水线垃圾分拣过程中高密度分拣对象导致的复杂背景,以及同类物体具有多形态结构的特点,并且分拣物在流水线上状态多变,随机性强,竖放、平放、堆叠、弯曲变形等情况均有可能出现。针对上述情况,本发明模拟实际分拣情况以及多种随机性状况,并搜集同类物品多种形态结构,利用移动端设备进行拍摄制作数据集,对于目标物拍摄角度尽可能与分拣场景相同,尽可能使训练集中目标角度覆盖角度分类范围。

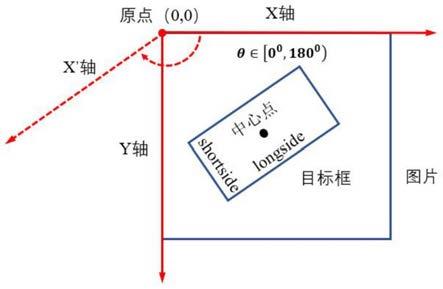

10.利用标注工具对数据集图片进行旋转框标注,以及归一化处理。物品左上角作为

标注起始点,利于旋转角度目标的头部判断,将标注文件转换为符合为本文所需标签文件,并将参数基于图像自身宽高进行归一化处理,标签参数定义为(classnameid,rx,ry,longside,shortside,θ)。classnameid为类别id参数,r

x

和ry为目标中心点横纵坐标,longside为目标框较长边,shortside为目标框较短边,θ定义为x轴顺时针旋转至与目标框长边平行所经过的角度。

11.2、对于数据集图像采用mosaic数据增强方法;

12.对于传入图像进行随机翻转、缩放、裁剪等处理,并将得到的图像进行依次拼接,大幅度提高了训练时目标背景复杂度。

13.3、将图像信息输入旋转框定位的目标检测模型进行训练;

14.改进所述旋转框定位的目标检测算法模型结构:基于yolov5模型将角度预测作为分类问题,并引入环形平滑标签(csl)角度分类方法,用于对于目标物角度的精准预测。增加模型检测层数,原始panet网络结构改进为bifpn,在主干网络末端利用transformer模块替换yolov5的c3模块的模型改进方法,解决垃圾分拣场景下同材质物品结构、尺度多样而导致的高漏检率、误检率。

15.3.1)csl角度分类方法具体包括:

16.将目标物角度预测视为分类问题,设计符合垃圾分拣物理场景的环形平滑标签(csl)来解决角度的周期性问题,增加相邻角度之间的误差容忍度。csl具体表达式如下:

[0017][0018]

式中:g(x)表示窗口函数(本次选择高斯函数),r表示窗函数的半径,θ表示当前边界框的角度。

[0019]

旋转框参数表达选择长边定义法,具体表示为(r

x

,ry,longside,shortside,θ),其中r

x

和ry为目标中心点横纵坐标,longside为目标框较长边,shortside为目标框较短边。与现有长边定义法不同的是θ定义为x轴顺时针旋转至与长边平行的角度,若出现目标框为正方形,则θ定义为x轴顺时针旋转至较近边平行的角度。结合目前yolov5模型中置信度损失以及类别损失计算方法,采用二分类交叉熵损失函数bcewithlogitsloss对于角度损失进行计算。具体定义如下式:

[0020][0021]

式中:n表示样本数量,i为角度范围,δ表示sigmoid函数,z

n,i

表示预测第n个样本为第i个角度的概率值,最大值z

n,i

=1,即预测值。y

n,i

表示第n个样本在csl(x)表达式下第i个角度标签值,即真实值,且最大值y

n,i

=1。将第n个样本的各个角度预测值与真实值依次带入l

n,i

计算,第n个样本所有角度结果求和得到ln,将n个样本的计算结果求平均,即为此次角度损失。

[0022]

加入角度检测分支后,检测网络参数输出特征图通道数m具体定义如下:

[0023]

m=(nc+5+ω)

×

na.(3)

[0024]

式中:nc表示检测类别数;na表示锚框数量;5表示旋转框定义代表中心点坐标r

x

,ry

,以及预测框长短边longside,shortside,以及该预测框置信度;

ω

代表角度检测分支对于角度分类数量。

[0025]

3.2)改进模型具体包括:

[0026]

(1)将focus模块作为第一层,以此类推。在第9层及spp层(池化层)后添加transformer模块,通过对于各个通道赋予权重,强化特征提取。transformer网络将多个缩放点积注意力机制结合,形成多头注意力机制。缩放点积注意力机制可批量处理数据,表达式如下:

[0027][0028]

式中:q、k、v分别代表查询向量、键向量、值向量,dk表示输入数据维度。

[0029]

多头注意力机制具有更高的运算效率,且可以从不同的特征空间中学习自适应注意力分布,表达式如下:

[0030][0031]

式中:参数矩阵d

model

为向量维度。

[0032]

(2)过多的下采样层会导致图像中小目标特征消失,导致网络无法学习到相应的特征,出现漏检、误检的情况。mr

2-yolov5保留原始检测尺寸,不降低该尺度下特征学习能力,通过增加concat层、卷积层、c3模块的方法,多进行上采样和下采样,将主干网络中保留较多小目标特征信息的同尺度特征层输入concat层,进行特征融合操作。新增检测层对于小目标特征更为敏感,虽然计算成本增加,但是小目标检测性能提高。由于yolov5具有自适应锚框计算,会采用k均值和遗传算法对于自定义数据集进行分析计算,获得该数据集各尺度所需预测锚框。

[0033]

(3)随着网络层数的加深,每一层网络都会一定程度上造成特征丢失,因此对于不同层级进行特征融合尤为重要。将主干网络多层计算结果一次或多次输入进入bifpn加强特征提取网络,当bifpn自下而上的部分对于两个同尺度特征进行融合;到自上而下结构时,同时对于三个同尺度特征利用跳跃连接的方式进行融合。并在经过c3模块以及conv2d模块计算后,对于多个不同尺度目标进行预测。利用bifpn网络,使得预测网络对于不同大小的目标更为敏感,提升了整体模型检测能力,并降低了漏检率与误检率。

[0034]

4、mr

2-yolov5将ciou损失函数作为边界框回归损失,置信度、类别、角度损失均采用二分类交叉熵损失函数bcewithlogitsloss。

[0035]

具体的ciou损失函数定义如下:

[0036][0037]

式中:iou表示预测框与真实框相交区域与交并区域面积的比值,a和b分别表示两个边界框的面积。b,b

gt

分别表示预测框中心点和真实框中心点,ρ2(b,b

gt

)表示两个边界框中心点欧氏距离,c2表示预测框与真实框形成最小矩形区域对角线长度,α为权重函数,v用

于横梁边界框长宽比,w、h表示框的长与框,gt代表真实框(ground truth)。

[0038]

5、设置模型训练参数;

[0039]

模型训练参数输入尺寸为640

×

640,batchsize设置为16,迭代次数epochs为300次,优化器选择随机梯度下降(sgd),学习率选择余弦退火学习率。

[0040]

6、模型评价指标;

[0041]

将平均精度均值(map)作为模型的评价指标,以及模型参数量和计算量作为模型轻量化标准。

[0042]

7、将垃圾分拣场景下采集到的图像输入所述mr

2-yolov5模型,识别出各个目标物的类别、坐标信息、旋转角度。

[0043]

本发明的工作原理:基于yolov5网络添加角度预测分支,引入环形平滑标签(csl)角度分类方法,完成旋转角度精准检测。增加目标检测层用于提升模型不同尺度检测能力,在主干网络末端利用transformer注意力机制对各通道赋予不同的权重,强化特征提取。利用主干网络提取到的不同层次特征图输入bifpn网络结构中,开展多尺度特征融合。以此解决再生物品分拣场景下物品结构、尺度多样而导致的高漏检率、误检率的问题。

[0044]

本发明的优先是:通过增加角度检测分支,引入csl角度分类方法,可以对目标物完成角度预测,降低传统识别旋转角度设备的成本,为再生物品分拣提供新的思路。改进后的模型对于多尺度目标(小目标至大目标),目标物遮挡、透明度较高、发生变形等情况均有出色的识别效果,且模型体积小,识别速度快,满足分拣场景下对目标检测算法检测图像的速度要求。

附图说明

[0045]

图1是本发明的角度定义示意图

[0046]

图2是本发明的mosaic数据增强方法后的train_batch;

[0047]

图3是本发明的mr

2-yolov5网络结构;

[0048]

图4是本发明的mr

2-yolov5各模块结构;

[0049]

图5是本发明的csl示意图;

[0050]

图6是本发明的mr

2-yolov5模型检测结果。

具体实施方式

[0051]

下面结合附图,进一步说明本发明的技术方案。

[0052]

本发明的旋转框定位多形态瓶状物品分拣目标检测方法:包括如下步骤:

[0053]

1、建立数据集;

[0054]

对于垃圾分拣场景缺乏具有代表性数据集,现有研究均由自身搭建实验平台利用工业相机进行拍摄。考虑实际流水线垃圾分拣过程中高密度分拣对象导致的复杂背景,以及同类物体具有多形态结构的特点,并且分拣物在流水线上状态多变,随机性强,竖放、平放、堆叠、弯曲变形等情况均有可能出现。针对上述情况,本发明模拟实际分拣情况以及多种随机性状况,并搜集同类物品多种形态结构,利用移动端设备进行拍摄,且对于目标物拍摄角度尽可能与分拣场景相同,尽可能使训练集中目标角度覆盖[0

°

,180

°

)。数据集共计包含6064幅分辨率大小为1280x720至1920x1080的可见光图像,其中4964张作为训练集、550

张作为验证集、550张为测试集,且部分图片中包含多类物体。数据集共计三类可回收垃圾,分别是金属罐状物(cans)、塑料制品瓶装物(plastic_bottle)、玻璃制品瓶装物(glass_bottle),这三类物体长宽比值较大,对于角度检测更为敏感,并且外形具有相似特征,较多都是柱状物,塑料制品和玻璃制品透明度较高,易与背景混淆,更能体现模型性能。

[0055]

并利用rolabelimg对数据集图片进行旋转框标注,以及归一化处理。并将上述三类物品的瓶口或开口处左作为起始点,利于旋转角度目标的头部判断,将标注文件(xml格式)转换为符合为本文所需标签文件(txt格式),并将参数基于图像自身宽高进行归一化处理,标签参数定义为(classnameid,rx,ry,longside,shortside,θ)。classnameid为类别id参数,r

x

和ry为目标中心点横纵坐标,longside为目标框较长边,shortside为目标框较短边,θ定义为x轴顺时针旋转至与目标框长边平行所经过的角度,θ定义如图1所示。

[0056]

2、对于数据集图像采用mosaic数据增强方法;

[0057]

对于传入图像进行随机翻转、缩放、裁剪等处理,并将得到的图像进行依次拼接,大幅度提高了训练时目标背景复杂度。使用mosaic数据增强方法后的train_batch如说明书附图2。

[0058]

3、将图像信息输入旋转框定位的目标检测模型进行训练;

[0059]

所述旋转框定位的目标检测算法模型结构改进如下:mr

2-yolov5具体网络结构如图3所示,具体模块结构如图4所示。基于yolov5模型,将角度预测作为分类问题,并引入环形平滑标签(csl)角度分类方法,用于对于目标物角度的精准预测。采用将检测层增加到4层,原始panet网络结构改进为bifpn,在主干网络末端利用transformer模块替换yolov5的c3模块的模型改进方法,解决垃圾分拣场景下同材质物品结构、尺度多样而导致的高漏检率、误检率。

[0060]

具体的:

[0061]

csl角度分类方法:

[0062]

将目标物角度预测视为分类问题,设计符合垃圾分拣物理场景的环形平滑标签(csl)来解决角度的周期性问题,增加相邻角度之间的误差容忍度。修改后的csl可视化表达如图5所示,csl具体表达式如下:

[0063][0064]

式中:g(x)表示窗口函数(本次选择高斯函数),r表示窗函数的半径,θ表示当前边界框的角度。

[0065]

本次csl角度范围为[0

°

,180

°

),由于角度呈环形分布,此时180

°

与0

°

结果相同。旋转框参数表达选择长边定义法,具体表示为(r

x

,ry,longside,shortside,θ),其中r

x

和ry为目标中心点横纵坐标,longside为目标框较长边,shortside为目标框较短边。与现有长边定义法不同的是θ定义为x轴顺时针旋转至与长边平行的角度,若出现目标框为正方形,则θ定义为x轴顺时针旋转至较近边平行的角度。结合目前yolov5模型中置信度损失以及类别损失计算方法,采用二分类交叉熵损失函数bcewithlogitsloss对于角度损失进行计算。具体定义如下式:

[0066][0067]

式中:n表示样本数量,i∈[0,180),共计180个类别,δ表示sigmoid函数,z

n,i

表示预测第n个样本为第i个角度的概率值,最大值z

n,i

=1,即预测值。y

n,i

表示第n个样本在csl(x)表达式下第i个角度标签值,即真实值,且最大值y

n,i

=1。第n个样本的各个角度预测值与真实值依次进行计算并求和,将n个样本的计算结果求平均即为此次角度损失。

[0068]

图4中检测网络参数m代表输出特征图通道数,具体定义如下:

[0069]

m=(nc+5+ω)

×

na.(3)

[0070]

式中:nc表示检测类别数;na表示锚框数量;5表示旋转框定义代表中心点坐标r

x

,ry,以及预测框长短边longside,shortside,以及该预测框置信度;ω代表角度检测分支对于角度分类数量。

[0071]

此次检测类别数为3,锚框数量为3,角度θ范围[0

°

,180

°

),共分为180个类别,可知输出特征图通道数m=(3+5+180)

×

3=564。

[0072]

模型改进方法:

[0073]

(1)将focus模块作为第一层,以此类推。在第9层及spp层(池化层)后添加transformer模块,通过对于各个通道赋予权重,强化特征提取。transformer网络结构如图4所示,主要包括两个主要模块,多头注意力机制模块(multi-headattention)和前馈神经网络(mlp),ln(layerform)层和dp(dropout)层可防止网络过拟合,提高特征融合。

[0074]

transformer网络将多个缩放点积注意力机制结合,形成多头注意力机制。缩放点积注意力机制可批量处理数据,表达式如下

[20]

:

[0075][0076]

式中:q、k、v分别代表查询向量、键向量、值向量,dk表示输入数据维度。

[0077]

多头注意力机制具有更高的运算效率,且可以从不同的特征空间中学习自适应注意力分布,表达式如下:

[0078][0079]

式中:参数矩阵d

model

为向量维度。

[0080]

(2)过多的下采样层会导致图像中小目标特征消失,导致网络无法学习到相应的特征,出现漏检、误检的情况。原始yolov5网络的检测层尺度分别为20

×

20、40

×

40、80

×

80,由图3可知,mr

2-yolov5保留原始检测尺寸,不降低该尺度下特征学习能力,通过增加concat层、卷积层、c3模块的方法,多进行了一次上采样和下采样,将主干网络中保留较多小目标特征信息的同尺度特征层输入concat层,进行特征融合操作。新增检测层对于小目标特征更为敏感,虽然计算成本增加,但是小目标检测性能提高。由于yolov5具有自适应锚框计算,会采用k均值和遗传算法对于自定义数据集进行分析计算,获得该数据集各尺度所需预测锚框。最终检测层尺度变为20

×

20、40

×

40、80

×

80、160

×

160。

[0081]

(3)随着网络层数的加深,每一层网络都会一定程度上造成特征丢失,因此对于不

同层级进行特征融合尤为重要。将主干网络第三层、第五层、第七层、第十层计算结果一次或多次输入进入bifpn加强特征提取网络,当bifpn自下而上的部分对于两个同尺度特征进行融合;到自上而下结构时,同时对于三个同尺度特征利用跳跃连接的方式进行融合。并在经过c3模块以及conv2d模块计算后,对于4个不同尺度目标进行预测。利用bifpn网络,使得预测网络对于不同大小的目标更为敏感,提升了整体模型检测能力,并降低了漏检率与误检率。

[0082]

4、mr

2-yolov5将ciou损失函数作为边界框回归损失,置信度、类别、角度损失均采用二分类交叉熵损失函数bcewithlogitsloss。

[0083]

具体的ciou损失函数定义如下:

[0084][0085]

式中:iou表示预测框与真实框相交区域与交并区域面积的比值,a和b分别表示两个边界框的面积。b,b

gt

分别表示预测框中心点和真实框中心点,ρ2(b,b

gt

)表示两个边界框中心点欧氏距离,c2表示预测框与真实框形成最小矩形区域对角线长度,α为权重函数,v用于横梁边界框长宽比,w、h表示框的长与框,gt代表真实框(ground truth)。

[0086]

5、设置模型训练参数;

[0087]

模型训练参数输入尺寸为640

×

640,batchsize设置为16,迭代次数epochs为300次,优化器选择随机梯度下降(sgd),学习率选择余弦退火学习率。

[0088]

6、模型评价指标;

[0089]

将平均精度均值(map)作为模型的评价指标,以及模型参数量和计算量作为模型轻量化标准。

[0090]

7、将垃圾分拣场景下采集到的图像输入所述mr

2-yolov5模型,识别出各个目标物的类别、坐标信息、旋转角度。模型检测结果如图6所示,由图可知该模型对于多尺度目标(小目标至大目标),目标物堆叠、遮挡,排列式目标,透明度较高目标,复杂背景下多目标检测等均有出色的识别效果,并可以精确检测其旋转角度。图中显示的参数分别是该物品类别、置信度、旋转角度。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1