一种数据迁移方法、装置、电子设备以及存储介质与流程

1.本发明涉及数据处理技术领域,特别是涉及一种数据迁移方法、装置、电子设备以及存储介质。

背景技术:

2.elasticsearch集群实时数据同步迁移方法能在迁移网络环境复杂、性能要求较高、数据量大且难以启停服务的场景下实现业务7*24不间断服务。通常的elasticsearch集群实时数据同步迁移方法采用集群自带的snapshot快照功能进行数据同步,它对集群本身性能要求较高,同时对网络稳定性要求较高,当发生网络抖动或遇到业务访问高峰期时,会对备份结果产生不稳定因素。其次,对于某些对集群依赖度较高的行业,在进行实时写入的情况下,无法做到按需快照还原。因此,如何实现多elasticsearch集群下数据的实时迁移,成为亟待解决的问题。

技术实现要素:

3.本技术实施例提供了一种数据迁移方法、装置、电子设备以及存储介质,可以在第一集群中的源实例产生新的数据时,立即将新产生的数据同步迁移到第二集群中的目标实例中,实现了elasticsearch集群之间的数据的实时迁移。具体技术方案如下:

4.在本技术实施例的第一方面,首先提供了一种数据迁移方法,应用于数据迁移服务系统,所述方法包括:

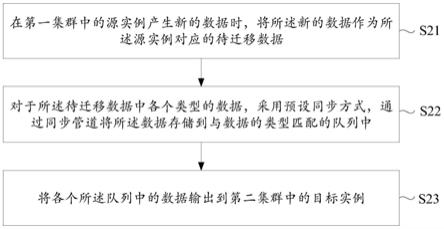

5.在第一集群中的源实例产生新的数据时,将所述新的数据作为所述源实例对应的待迁移数据;

6.对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中;

7.将各个所述队列中的数据输出到第二集群中的目标实例。

8.可选地,所述各个类型的数据包括正常数据和异常数据;对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

9.对于所述待迁移数据中的正常数据,采用预设同步方式,通过同步管道将所述正常数据存储到第一队列中;

10.对于所述待迁移数据中的异常数据,采用预设同步方式,通过同步管道将所述异常数据存储到第二队列中。

11.可选地,在将各个所述队列中的数据输出到第二集群中的目标实例后,所述方法还包括:

12.在所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与所述目标实例的相应参数一致,且所述同步管道中输入文件的数量与输出文件的数量一致时,确定数据迁移成功。

13.可选地,所述方法还包括:

14.检测所述同步管道的运行状态是否正常;

15.通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

16.在所述同步管道的运行状态正常时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

17.可选地,在通过同步管道将所述数据存储到与数据的类型匹配的队列的过程中,所述方法还包括:

18.根据所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量中的一者或多者,分别与所述目标实例的相应参数的对比结果,得到数据迁移进度;

19.输出所述数据迁移进度。

20.可选地,在通过同步管道将所述数据存储到与数据的类型匹配的队列的过程中,所述方法还包括:

21.获取所述第一集群中的源实例的master节点状态,和所述第二集群中的目标实例的master节点状态;

22.通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

23.在所述源实例的master节点状态和所述目标实例的master节点状态均表示未重新选主时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

24.可选地,在通过同步管道将所述数据存储到与数据的类型匹配的队列之前,所述方法还包括:

25.对所述第一集群中的源实例、所述第二集群中的目标实例以及所述第一队列与所述第二队列所在的存储系统的存活状态进行检测;

26.通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

27.在所述源实例、所述目标实例以及所述存储系统各自的存活状态均检测通过时,通过同步管道将所述数据存储到与数据的类型匹配的队列。

28.可选地,对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

29.将全量同步、增量同步以及全量加增量同步中的任意一种方式确定为目标同步方式;

30.对于所述待迁移数据中各个类型的数据,采用所述目标同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

31.在本技术实施例的第二方面,还提供了一种数据迁移装置,应用于数据迁移服务系统,所述装置包括:

32.第一确定模块,用于在第一集群中的源实例产生新的数据时,将所述新的数据作为所述源实例对应的待迁移数据;

33.存储模块,用于对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中;

34.第一输出模块,用于将各个所述队列中的数据输出到第二集群中的目标实例。

35.可选地,所述各个类型的数据包括正常数据和异常数据;所述存储模块包括:

36.第一存储子模块,用于对于所述待迁移数据中的正常数据,采用预设同步方式,通过同步管道将所述正常数据存储到第一队列中;

37.第二存储子模块,用于对于所述待迁移数据中的异常数据,采用预设同步方式,通过同步管道将所述异常数据存储到第二队列中。

38.可选地,所述装置还包括:

39.第二确定模块,用于在所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与所述目标实例的相应参数一致,且所述同步管道中输入文件的数量与输出文件的数量一致时,确定数据迁移成功。

40.可选地,所述装置还包括:

41.第一检测模块,用于检测所述同步管道的运行状态是否正常;

42.所述存储模块包括:

43.第三存储子模块,用于在所述同步管道的运行状态正常时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

44.可选地,所述装置还包括:

45.第一获取模块,用于根据所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量中的一者或多者,分别与所述目标实例的相应参数的对比结果,得到数据迁移进度;

46.第二输出模块,用于输出所述数据迁移进度。

47.可选地,所述装置还包括:

48.第二获取模块,用于获取所述第一集群中的源实例的master节点状态,和所述第二集群中的目标实例的master节点状态:

49.第四存储子模块,用于在所述源实例的master节点状态和所述目标实例的master节点状态均表示未重新选主时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

50.可选地,所述装置还包括:

51.第二检测模块,用于对所述第一集群中的源实例、所述第二集群中的目标实例以及所述第一队列与所述第二队列所在的存储系统的存活状态进行检测;

52.所述存储模块包括:

53.第五存储子模块,用于在所述源实例、所述目标实例以及所述存储系统各自的存活状态均检测通过时,通过同步管道将所述数据存储到与数据的类型匹配的队列。

54.可选地,所述存储模块包括:

55.确定子模块,用于将全量同步、增量同步以及全量加增量同步中的任意一种方式确定为目标同步方式;

56.第六存储子模块,用于对于所述待迁移数据中各个类型的数据,采用所述目标同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

57.在本技术实施例的第三方面,还提供了一种终端设备,包括处理器、通信接口、存储器和通信总线,其中,处理器,通信接口,存储器通过通信总线完成相互间的通信;

58.存储器,用于存放计算机程序;

59.处理器,用于执行存储器上所存放的程序时,实现本技术实施例的第一方面所述

的数据迁移方法中的步骤。

60.在本技术实施例的第四方面,还提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述任一所述的数据迁移方法中的步骤。

61.采用本技术的数据迁移方法,在第一集群中的源实例产生新的数据时,将新的数据作为源实例对应的待迁移数据,接着,对于待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将数据存储到与数据的类型匹配的队列中。最后,将各个队列中的数据输出到第二集群中的目标实例。通过该方法,可以在第一集群中的源实例产生新的数据时,立即将新产生的数据同步迁移到第二集群中的目标实例中,实现了elasticsearch集群之间的数据的实时迁移。

附图说明

62.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍。

63.图1是本技术一实施例示出的一种数据迁移架构图;

64.图2是本技术一实施例示出的一种数据迁移方法的流程图;

65.图3是本技术一实施例示出的一种数据迁移方法的完整过程示意图;

66.图4是本技术一实施例示出的一种停止数据迁移方法的完整过程示意图;

67.图5是本发明一实施例示出的一种数据迁移装置的结构框图;

68.图6是本技术一实施例示出的一种终端设备的结构示意图。

具体实施方式

69.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行描述。

70.本技术提供了一种基于elasticsearch集群的实时数据同步迁移方法。在同步迁移时,可采用elasticsearch-sync服务(elasticsearch同步服务)。elasticsearch是一个分布式、高扩展、高实时的搜索与数据分析引擎。elasticsearch-sync服务主要包含logstash和comparison两个组件。其中,logstash是基于persistent queues、dead letter queues进行数据同步和迁移的工具组件。comparison是基于logstash监控api对管道任务进行全量一致性校验的工具组件。

71.logstash是一个开源数据收集引擎,具有实时管道功能。logstash可以动态地将来自不同数据源的数据统一起来,并将数据标准化到给定的地址。

72.图1是本技术一实施例示出的一种数据迁移架构图。图1中示出了两个elasticsearch集群,分别为k8s(kubernetes,是一个开源的,用于管理云平台中多个主机上的容器化的应用)集群s1和k8s集群s2。k8s集群s1中包括源elasticsearch集群a,源elasticsearch集群a中有源elasticsearch实例(本技术中,elasticsearch实例是指一个正在运行着elasticsearch程序的程序本身)。k8s集群s2中包括目标elasticsearch集群b,目标elasticsearch集群b中有目标elasticsearch实例。elasticsearch管理服务中包括elasticsearch业务服务api(application programming interface,应用程序接口)和elasticsearch业务服务coreserver。k8s集群s2中还部署有elasticsearch-job operator

letter queues。

82.步骤s23:将各个所述队列中的数据输出到第二集群中的目标实例。

83.在本实施例中,在将待迁移数据持久化存储到队列中后,接着将队列中的数据输出到第二集群中的目标实例。

84.以图1为例,只要源elasticsearch集群a中的源elasticsearch实例产生了新的数据,那么首先将产生的新的数据同步到ceph集群中的队列中进行持久化存储,然后再将队列中的数据同步到目标elasticsearch集群b中的目标elasticsearch实例。

85.采用本技术的数据迁移方法,在第一集群中的源实例产生新的数据时,将新的数据作为源实例对应的待迁移数据,接着,对于待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将数据存储到与数据的类型匹配的队列中。最后,将各个队列中的数据输出到第二集群中的目标实例。通过该方法,可以在第一集群中的源实例产生新的数据时,立即将新产生的数据同步迁移到第二集群中的目标实例中,实现了elasticsearch集群之间的数据的实时迁移。

86.结合以上实施例,在一种实施方式中,各个类型的数据包括正常数据和异常数据。在此基础上,对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中,可以包括:

87.对于所述待迁移数据中的正常数据,采用预设同步方式,通过同步管道将所述正常数据存储到第一队列中;

88.对于所述待迁移数据中的异常数据,采用预设同步方式,通过同步管道将所述异常数据存储到第二队列中。

89.在本实施例中,第一队列是指persistent queues,第二队列是指dead letter queues,persistent queues和dead letter queues均存放在ceph集群中。

90.在本实施例中,为了防止数据迁移过程中出现异常情况而导致数据丢失,在数据迁移过程中,首先通过logstash创建的同步管道,将第一集群中源elasticsearch实例中的数据输入到ceph集群的persistent queues以实现持久化存储,然后再通过同步管道将数据从persistent queues输出到第二集群中的目标elasticsearch实例,从而实现数据的迁移。

91.在本实施例中,如果在数据实时迁移过程中遇到由于数据包含映射错误或其他无法重试事件(响应码为400/404)而导致的数据问题,为了使得异常数据也可以实现迁移,对于待迁移数据中的异常数据,首先通过logstash创建的同步管道,将异常数据(例如挂起或要丢弃的数据)输出到ceph集群的dead letter queues以实现持久化存储,同时,再通过logstash创建的另外一个异常管道,对dead letter queues中的数据进行过滤处理,使得异常数据可以通过过滤处理而被继续迁移。处理完成后,再通过同步管道将dead letter queues中的数据输出到第二集群中的目标elasticsearch实例,从而实现数据的迁移。

92.在本实施例中,logstash创建的管道(包括同步管道和异常管道)都可以对数据进行过滤处理。

93.在本实施例中,logstash通过持久化persistent queues和dead letter queues相结合的方式,启动第一集群向第二集群的全量、增量、全量+增量的实时迁移任务。如果第一集群中不断有新的数据输入,logstash负责实时向第二集群同步新增的数据,直到第一

集群中没有新的数据输入。

94.结合以上实施例,在一种实施方式中,在将各个所述队列中的数据输出到第二集群中的目标实例后,本技术的数据迁移方法还可以包括如下步骤:

95.在所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与所述目标实例的相应参数一致,且所述同步管道中输入文件的数量与输出文件的数量一致时,确定数据迁移成功。

96.在本实施例中,若实时迁移完成,elasticsearch job controller调用comparison进行全量数据一致性校验。具体地,如果满足下述条件1-4,那么源实例的数据和目标实例中的数据完全一致,表示数据迁移成功:

97.1、源elasticsearch实例的索引文件的总数量和目标elasticsearch实例的索引文件的总数量一致;

98.2、源elasticsearch实例的所有文件的总数量和目标elasticsearch实例的所有文件的总数量一致;

99.3、源elasticsearch实例的每个索引文件中文件的数量和目标elasticsearch实例的每个索引文件中文件的数量一致;

100.4、同步管道中输入文件的数量与输出文件的数量一致。

101.在本实施例中,还可以根据同步管道的异常加载次数来对数据迁移效果进行评判。异常加载次数越少,数据迁移效果越好,异常加载次数越多,数据迁移效果越差。

102.结合以上实施例,在一种实施方式中,本技术的数据迁移方法还可以包括如下步骤:

103.检测所述同步管道的运行状态是否正常。

104.在此基础上,通过同步管道将所述数据存储到与数据的类型匹配的队列中,可以包括:

105.在所述同步管道的运行状态正常时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

106.在本实施例中,logstash提供有监控api接口,用于监控logstash及管道的内部情况。正常情况下,如果数据迁移完成,检查点checkpoint.head文件会停止增长,page.x不存在(随着同步完成,队列页文件被目标elasticsearch回放完成)。

107.在实时迁移的过程中,elasticsearch-job controller会对logstash的同步管道的运行状态进行api监控,以检测同步管道的运行状态是否正常。在同步管道的运行状态正常时,才会通过同步管道将数据存储到与数据的类型匹配的队列中。

108.结合以上实施例,在一种实施方式中,本技术还提供了一种获得实时迁移进度的方法。具体地,在通过同步管道将所述数据存储到与数据的类型匹配的队列的过程中,本技术的方法还可以包括:

109.根据所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量中的一者或多者,分别与所述目标实例的相应参数的对比结果,得到数据迁移进度;

110.输出所述数据迁移进度。

111.在本实施例中,可以根据目标实例的索引文件的总数量占源实例的索引文件的总

数量的比值、目标实例的所有文件的总数量占源实例的所有文件的总数量的比值、目标实例的每个索引文件中文件的数量占源实例的每个索引文件中文件的数量的比值中的一者或多者,得到数据迁移进度。

112.在得到数据迁移进度后,可以输出数据迁移进度,便于用户实时了解整个数据迁移情况。

113.结合以上实施例,在一种实施方式中,在通过同步管道将所述数据存储到与数据的类型匹配的队列的过程中,本技术的数据迁移方法还可以包括:

114.获取所述第一集群中的源实例的master节点状态,和所述第二集群中的目标实例的master节点状态。

115.在此基础上,通过同步管道将所述数据存储到与数据的类型匹配的队列中,具体可以包括:

116.在所述源实例的master节点状态和所述目标实例的master节点状态均表示未重新选主时,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

117.在本实施例中,logstash在同步迁移前和同步迁移过程中,elasticsearch-job controller会不断探测源实例的master节点状态和目标elasticsearch集群实例的master节点状态,以防止master节点重新选主(某些情况下master异常退出,导致其他的节点竞选成master,因为数据不存在master,会导致该竞选成功的节点数据要迁出该节点)。在源实例的master节点状态和目标实例的master节点状态均表示未重新选主时,才通过同步管道将数据存储到与数据的类型匹配的队列中。

118.结合以上实施例,在一种实施方式中,在通过同步管道将所述数据存储到与数据的类型匹配的队列之前,本技术的数据迁移方法还可以包括:

119.对所述第一集群中的源实例、所述第二集群中的目标实例以及所述第一队列与所述第二队列所在的存储系统的存活状态进行检测。

120.在此基础上,通过同步管道将所述数据存储到与数据的类型匹配的队列中,包括:

121.在所述源实例、所述目标实例以及所述存储系统各自的存活状态均检测通过时,通过同步管道将所述数据存储到与数据的类型匹配的队列。

122.在通过同步管道将数据存储到与数据的类型匹配的队列之前,elasticsearch-job operator触发变更准入mutating webhook,mutating webhook通过webhook回调的方式启动对源elasticsearch实例、目标elasticsearch实例以及ceph存储等存活状态检查,如果检查通过,则通过同步管道将数据存储到与数据的类型匹配的队列,否则提示异常并通知用户进行检查。

123.本实施例中,在源实例、目标实例以及存储系统各自的存活状态均检测通过时,通过同步管道将数据存储到与数据的类型匹配的队列,可保证源实例中的数据顺利迁移到目标实例。

124.存活状态可以理解为运行健康状态,在实施时可以通过api获取到elasticsearch集群的运行健康状态和ceph集群的运行健康状态。只有当源实例、目标实例以及存储系统均处于健康的运行状态时,才能进一步实施数据迁移。

125.结合以上实施例,在一种实施方式中,对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中,具体可以

包括:

126.将全量同步、增量同步以及全量加增量同步中的任意一种方式确定为目标同步方式;

127.对于所述待迁移数据中各个类型的数据,采用所述目标同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中。

128.在本实施例中,预设同步方式可以是全量同步、增量同步以及全量加增量同步中的任意一种方式。

129.在本实施例中,在将源实例中的数据同步到目标实例中时,可以采用先全量同步一次(保证同步效率)再进行增量同步(保证数据实时迁移)的方式,既能保证同步效率,也能保证目标实例中的数据的实时性,显著提升数据迁移效果。在进行全量同步时,可以采用集群自带的snapshot(快照技术,主要采用copy on write的算法)快照功能进行数据同步。在进行增量实时同步时,可采用前文所述的步骤s21-步骤s23进行同步。

130.图3是本技术一实施例示出的一种数据迁移方法的完整过程示意图。下面将结合图3,以一个完整实施例对本技术的数据迁移方法进行详细说明。该实施例旨在将图1中的源elasticsearch集群a的源elasticsearch实例中的数据同步到目标elasticsearch集群b中的目标elasticsearch实例,具体包括如下步骤1-步骤11。

131.步骤1:通过elasticsearch业务服务api,向elasticsearch业务服务coreserver发起创建并启动实时迁移任务的请求。elasticsearch业务服务coreserver可以理解为针对elasticsearch编写的前置api,用于操作各个elasticsearch集群。

132.步骤2:elasticsearch业务服务coreserver创建实时迁移任务,将创建的实时迁移任务存入mysql源数据库。接着,elasticsearch业务服务coreserver通过https向k8s api server(k8s api server是每个elasticsearch集群内置的模块)发起请求,由k8s api server做内部认证授权(elasticsearch-job operator运行在k8s之上,通过k8s api server访问它需要进行授权认证,该认证由程序自动处理)。

133.步骤3:elasticsearch-job operator触发变更准入mutating webhook,mutating webhook通过webhook回调的方式启动对源elasticsearch实例、目标elasticsearch实例和ceph存储等存活状态检查。检查通过则进入步骤4,否则提示异常,并通知用户进行检查。

134.其中,存活状态可以理解为运行健康状态,在实施时可以通过api获取到elasticsearch集群的运行健康状态和ceph集群的运行健康状态。

135.其中,elasticsearch通过elasticsearch openapi对外提供服务,ceph集群通过s3 api对外提供服务。

136.步骤4:validating webhook做准入验证校验及缺省项默认规则初始化。完成校验和初始化后,由elasticsearch-job controller启动、控制和加载logstash配置和pipeline管道配置。进行准入验证校验是为了确保迁移程序能够创建成功,初始化是指将运行operator迁移服务需要的资源和镜像进行初始化,确保参数正确且有足够的资源进行迁移。

137.步骤5:在logstash进行数据的同步迁移前和同步迁移过程中,elasticsearch-job controller不断探测源elasticsearch实例的master节点状态和目标elasticsearch实例的master节点状态,以防止master节点重新选主。只有源elasticsearch实例的master

节点状态和目标elasticsearch实例的master节点状态均表示未重新选主时,才继续进行数据迁移。master节点重新选主是指某些情况下master异常退出,导致其他的节点竞选成master,因为数据不存在master,所以会导致该竞选成功的节点数据要迁出该节点,进而导致数据同步出现异常。

138.步骤6:为了防止实时迁移过程中因为异常情况导致数据丢失,logstash启动实时迁移任务后,通过logstash创建的同步管道将源elasticsearch实例中的数据持久化到ceph集群中的persistent queues中,然后通过同步管道将数据从persistent queues输出到目标源elasticsearch实例。

139.同步管道是logstash创建的一个共享内存区域,在这个共享内存区域中,各个进程之间可以相互通讯。首先,logstash从源elasticsearch实例中获得待迁移数据,将待迁移数据存入同步管道。接着,同步管道将待迁移数据输入ceph集群的persistent queues进行持久化存储。接着,同步管道再将persistent queues中的待迁移数据输入目标elasticsearch实例。

140.步骤7:如果在数据实时迁移过程中遇到由于数据包含映射错误或其他无法重试事件(响应码为400/404)而导致的数据问题,为了使得异常数据也可以实现迁移,在实时迁移过程中,通过logstash创建的同步管道将异常数据(挂起或要丢弃的数据)输入到ceph集群的dead letter queues。同时,通过logstash创建的另外一个异常管道,对持久化存入dead letter queues的数据进行异常数据过滤处理,使得异常数据可以通过过滤处理而被继续迁移。然后通过同步管道将处理后的数据从dead letter queues输出到目标elasticsearch实例。

141.步骤8:logstash通过持久化persistent queues和dead letter queues相结合的方式,启动源elasticsearch集群向目标elasticsearch集群的全量、增量、全量+增量的实时迁移任务。如果源elasticsearch集群不断有新的数据存入,logstash负责实时向目标elasticsearch集群同步新增的数据,直到源elasticsearch集群内没有新的数据存入。

142.步骤9:logstash提供有监控api接口,通过该监控api接口,elasticsearch-job controller可以对logstash的同步管道的运行状态进行监控,以及时检测出数据同步是否出现异常。

143.正常情况下,如果实时迁移任务完成,检查点checkpoint.head文件会停止增长,page.x不存在(随着同步完成,队列页文件被目标elasticsearch实例回放完成)。

144.步骤10:若实时迁移任务完成,elasticsearch-job controller调用comparison进行全量数据一致性校验,具体操作包括:将源elasticsearch实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与目标elasticsearch实例的相应参数进行对比,将同步管道中输入文件的数量与输出文件的数量进行对比,如果源elasticsearch实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与目标elasticsearch实例的相应参数一致,且同步管道中输入文件的数量与输出文件的数量一致,可以确定数据迁移成功。

145.步骤11:同步完成之后,elasticsearch-job controller通知elasticsearch业务服务coreserver更新本次实时迁移任务的状态,并将本次实时迁移任务的状态存入mysql源数据库中,elasticsearch业务服务api通过刷新即可查看最新状态。

146.在执行上述步骤步骤1-步骤11时,如果需要停止实时迁移任务,通过elasticsearch业务服务api,向elasticsearch业务服务coreserver发起停止实时迁移任务的请求。具体如图4所示。图4是本技术一实施例示出的一种停止数据迁移方法的完整过程示意图。

147.具体地,elasticsearch业务服务coreserver向operator controller发送停止实时迁移任务的指令,operator controller控制logstash退出实时迁移任务。operator controller将同步状态返回至elasticsearch业务服务coreserver,elasticsearch业务服务coreserver更新实时迁移任务的停止状态,并将实时迁移任务的状态存入mysql源数据库中,elasticsearch业务服务api通过刷新即可查看最新状态。

148.本技术提供了一种在多elasticsearch集群业务数据连续增长的情况下,保持目标elasticsearch实例与源elasticsearch实例的数据的同步的方法。通过引入了logstash进行中间管道实时同步机制,汇聚融合全量迁移和增量同步迁移各技术特点,可以实现跨集群下数据的实时迁移、跨集群下全量数据的迁移以及跨集群下全量加增量数据的同步追平(追平是指在一段时间内源elasticsearch实例和目标elasticsearch实例中的数据一致)。

149.需要说明的是,对于方法实施例,为了简单描述,故将其都表述为一系列的动作组合,但是本领域技术人员应该知悉,本发明实施例并不受所描述的动作顺序的限制,因为依据本发明实施例,某些步骤可以采用其他顺序或者同时进行。其次,本领域技术人员也应该知悉,说明书中所描述的实施例均属于优选实施例,所涉及的动作并不一定是本发明实施例所必须的。

150.基于同一发明构思,本发明一实施例提供一种数据迁移装置500,应用于数据迁移服务系统。参考图5,图5是本发明一实施例示出的一种数据迁移装置的结构框图。如图5所示,该装置500包括:

151.第一确定模块501,用于在第一集群中的源实例产生新的数据时,将所述新的数据作为所述源实例对应的待迁移数据;

152.存储模块502,用于对于所述待迁移数据中各个类型的数据,采用预设同步方式,通过同步管道将所述数据存储到与数据的类型匹配的队列中;

153.第一输出模块503,用于将各个所述队列中的数据输出到第二集群中的目标实例。

154.可选地,所述各个类型的数据包括正常数据和异常数据;所述存储模块502包括:

155.第一存储子模块,用于对于所述待迁移数据中的正常数据,采用预设同步方式,通过同步管道将所述正常数据存储到第一队列中;

156.第二存储子模块,用于对于所述待迁移数据中的异常数据,采用预设同步方式,通过同步管道将所述异常数据存储到第二队列中。

157.可选地,所述装置500还包括:

158.第二确定模块,用于在所述源实例的索引文件的总数量、所有文件的总数量以及每个索引文件中文件的数量,与所述目标实例的相应参数一致,且所述同步管道中输入文件的数量与输出文件的数量一致时,确定数据迁移成功。

159.可选地,所述装置500还包括:

160.第一检测模块,用于检测所述同步管道的运行状态是否正常;

interconnect,简称pci)总线或扩展工业标准结构(extended industry standard architecture,简称eisa)总线等。该通信总线可以分为地址总线、数据总线、控制总线等。为便于表示,图中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

185.通信接口用于上述终端与其他设备之间的通信。

186.存储器可以包括随机存取存储器(random access memory,简称ram),也可以包括非易失性存储器(non-volatile memory),例如至少一个磁盘存储器。可选的,存储器还可以是至少一个位于远离前述处理器的存储装置。

187.上述的处理器可以是通用处理器,包括中央处理器(central processing unit,简称cpu)、网络处理器(network processor,简称np)等;还可以是数字信号处理器(digital signal processing,简称dsp)、专用集成电路(application specific integrated circuit,简称asic)、现场可编程门阵列(field-programmable gate array,简称fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。

188.在本发明提供的又一实施例中,还提供了一种计算机可读存储介质,该计算机可读存储介质中存储有指令,当其在计算机上运行时,使得计算机执行上述实施例中任一所述的数据迁移方法。

189.在本发明提供的又一实施例中,还提供了一种包含指令的计算机程序产品,当其在计算机上运行时,使得计算机执行上述实施例中任一所述的数据迁移方法。

190.在上述实施例中,可以全部或部分地通过软件、硬件、固件或者其任意组合来实现。当使用软件实现时,可以全部或部分地以计算机程序产品的形式实现。所述计算机程序产品包括一个或多个计算机指令。在计算机上加载和执行所述计算机程序指令时,全部或部分地产生按照本发明实施例所述的流程或功能。所述计算机可以是通用计算机、专用计算机、计算机网络、或者其他可编程装置。所述计算机指令可以存储在计算机可读存储介质中,或者从一个计算机可读存储介质向另一个计算机可读存储介质传输,例如,所述计算机指令可以从一个网站站点、计算机、服务器或数据中心通过有线(例如同轴电缆、光纤、数字用户线(dsl))或无线(例如红外、无线、微波等)方式向另一个网站站点、计算机、服务器或数据中心进行传输。所述计算机可读存储介质可以是计算机能够存取的任何可用介质或者是包含一个或多个可用介质集成的服务器、数据中心等数据存储设备。所述可用介质可以是磁性介质,(例如,软盘、硬盘、磁带)、光介质(例如,dvd)、或者半导体介质(例如固态硬盘solid state disk(ssd))等。

191.需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

192.本说明书中的各个实施例均采用相关的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于系统实施例而言,由于其基本相似于方法实施例,所以描述的比较简单,相关之处参见方法实施例

的部分说明即可。

193.以上所述仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进等,均包含在本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1