基于深度强化学习的节能型自动互联车辆服务卸载方法

1.本发明属于边缘计算技术领域,具体涉及基于深度强化学习的节能型自动互联车辆服务卸载方法。

背景技术:

2.互联自动车辆(cavs)是车对一切(v2x)通信赋能的自动驾驶车辆,是车联网和自动控制技术共同发展的产物。在自动驾驶车辆的基础上,cavs通过无线通信技术连接到其它车辆、路边单元和外部服务器,使它们成为一个协同工作的整体。在cavs中,车辆的决策不再只依赖车载传感器的数据收集和车载计算设备的计算,同时依赖其它车辆和道路智能体的共享数据,以及外部服务器,如边缘计算和云计算的支持。这种工作范式的一大显著优势是解决了计算资源受限的自动车辆对于许多计算密集型服务的需求,例如增强现实、目标检测等,同时提高了数据的有效性、系统安全性,进一步提高了服务质量(qos)。自动车辆将请求和收集到的数据发往服务端,服务器统筹路况数据并为各车辆分别提供相应的服务,包括路径规划、危险预警、路况分析、行为模拟、自动控制、绿色出行等,以保障自动驾驶的安全性和用户体验。这一过程被称为服务卸载

3.云服务器和边缘服务器是车载任务卸载的两大目的地。通常云服务器有充足的计算资源,适合处理计算密集型任务,但云端和车辆间较大的物理距离导致决定了通信过程中不可忽略的往返时延(round-trip time,rtt),这对于高速行驶的车辆中的时延敏感型任务而言是不可接受的。而边缘计算则将服务器部署到靠近用户的边缘计算设备(ecd),以此缩短用户和计算资源的距离,有效改善传输过程的通信时延。不过ecd中的算力、缓存等资源通常有限,面对高密度的车辆服务请求甚至可能过载和阻塞,反而会大大增加延迟[6]。因此,纯粹的边缘计算也不足以应对高车流量下的服务请求。

[0004]

能耗是计算卸载过程中的另一个关键问题。不同的卸载方案也会产生不同能耗,例如,在数据传输过程由于传输功率不同导致的不同的通信能耗、或不同算力的设备计算同一任务产生的不同计算能耗等。得益于第五代通信技术(5g)的到来,为未来的cav网络赋予了更高的频谱效率和数据速率,使得卸载方案在考虑时延之余能更多关注能耗问题。相比本地计算,边云服务器会带来明显的能耗。并且伴随路侧单元(rsus)、ecds等网络基础设施数目的不断增加,cav系统中的关键能耗从车辆转移到了互联的基础设施中。

[0005]

此外,人工智能技术在近几年取得了飞速进步,在包括自动控制、模式识别、自然语言处理等许多场景取得了成功的应用。这推动了人工智能赋能的车联网的发展,因此也诞生一些尝试用dl或drl解决cavs网络中计算卸载的研究。例如文献“l.huang,x.feng,a.feng,y.huang,l.p.qian,distributed deep learning-based offloading for mobile edge computing networks,mobile networks and applications(2018).”设计了一种使用多个并行dnn生成卸载决策(offloading decisions)的分布式深度学习算法ddlo,解决了深度学习的维度数限制。ddlo使用共享重放内存(shared replay memory)来存储dnn输出的卸载决策,并用它进一步训练dnn。这种思想类似于drl中的经验回放、能提高在过去的

决策中积累的经验的利用率、改善模型训练效果。文献“p.yao,x.chen,y.chen,z.li,deep reinforcement learning based offloading scheme for mobile edge computing,in:2019ieee international conference on smart internet of things(smartiot),2019,pp.1

–

7.”利用深度q网络(dqn)来解决mec的计算卸载中当用户数据的大小和优先级给定时,队列中的任务调度问题,它与资源分配一样是卸载决策的主要内容。文献“y.wang,k.wang,h.huang,t.miyazaki,s.guo,traffic and computation co-offloading with reinforcement learning in fog computing for industrial applications,ieee transactions on industrial informatics15(2)(2019)976

–

986.”设计了两种基于强化学习的交通和计算的协同卸载算法(co-offloading algorithm of traffic and computation),能在满足车辆机动性和资源约束的条件下最小化卸载成本。不过,这些使用了drl的研究,没有充分利用边-云协同的模式下ecds本身的分布式特征,而是孤立地进行每个ecd卸载方案的学习,这不仅增大了系统的学习负担,还不利于提升系统对环境的泛化能力。最后,还有一些卸载方法不能根据服务类型动态权衡时延和能耗对于决策结果的影响比重、或根本不考虑能耗。这一算法在计算成本时同时考虑了能耗与延迟,但是不能根据任务类型动态改变能耗与延迟的权重。

技术实现要素:

[0006]

本发明正是为了解决上述技术问题而设计的基于深度强化学习的节能型自动互联车辆服务卸载方法,该发明使用户车辆在发送服务请求时,除了数据量和计算量等必要信息外,增加对服务时延敏感度的描述,并使此敏感度参与网络的输入和计算即时奖励中时延和能耗的权重。

[0007]

本发明解决其技术问题所采用的技术方案是:

[0008]

基于深度强化学习的节能型自动互联车辆服务卸载方法,基于由各车辆、各边缘计算设备、以及云服务器构成的端-边-云协同系统下,各边缘计算设备分别与各预设区域一一对应,针对预设时间段内各预设区域中的服务请求,端-边-云协同系统执行以下步骤,得到各边缘计算设备分别对应的车辆服务卸载模型,实现各边缘计算设备为对应预设区域的服务请求提供相应的服务卸载决策:

[0009]

步骤a:针对端-边-云协同系统,基于各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,构建端-边-云协同系统的目标函数与约束条件;

[0010]

步骤b:基于端-边-云协同系统的目标函数与约束条件,针对预设时间段内各预设区域中的服务请求,采用异步强化学习方法对各边缘计算设备的服务卸载决策模型进行优化,得到各边缘计算设备分别一一对应的车辆服务卸载模型;

[0011]

步骤c:基于各边缘计算设备分别一一对应的车辆服务卸载模型,各边缘计算设备为对应区域的自动车辆的服务请求提供相应的服务卸载决策。

[0012]

作为本发明的一种优选技术方案,所述步骤a中各边缘计算设备执行服务卸载决策时由步骤a1至步骤a3,得到各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务

卸载到云服务器执行时的时延模型和能耗模型;

[0013]

步骤a1:针对预设时间段内任意边缘计算设备中的第i个服务si,车辆到边缘计算设备的最大通信速率表示为:

[0014][0015]

其中,bi表示分配给服务si的带宽,pi表示自动车辆vi与边缘计算设备间的传输功率,vi表示产生服务请求的车辆,gi表示自动车辆vi与边缘计算设备间的信道增益,n0则代表信道的噪声功率密度;

[0016]

当服务在车辆本地计算,总时延表示为:

[0017][0018]

其中,表示产生服务si的自动车辆的本地计算速率,ci表示服务si的计算量;

[0019]

车辆本地的能耗表示为:

[0020][0021]

其中,k表示能量因子;

[0022]

步骤a2:当服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,计算过程如下:

[0023]

步骤a2.1:针对服务si被服务卸载决策模型要求服务卸载到边缘计算设备执行时,边缘计算设备针对该服务si分配计算资源;

[0024]

车辆到边缘计算设备的传输时延表示为:

[0025][0026]

式中,di表示服务si的数据量;

[0027]

车辆到边缘计算设备对应的传输能耗表示为:

[0028][0029]

式中,pi表示车辆到边缘计算设备的传输功率,表示车辆到边缘计算设备的传输时间;

[0030]

步骤a2.2:边缘计算设备中总的计算资源平均地划分为各个可分配的子计算资源,每个子计算资源贡献固定份额的计算速率fi,即其中表示为服务si分配的子计算资源个数,c

single

表示每个子计算资源的算力,当服务传输到边缘计算设备后,边缘计算设备基于该服务所分配的计算资源执行该服务,服务的计算耗时为:

[0031][0032]

该服务的计算能耗为:

[0033][0034]

步骤a2.3:最后,基于从该服务si全部上传到边缘计算设备中到被边缘计算设备执行该服务的过程中,存在等待边缘计算设备服务器空出个子计算资源算力的时延

[0035][0036]

式中,表示服务开始执行的时刻,而表示服务数据全部卸载到边缘计算设备中的时刻;

[0037]

步骤a2.4:综上,当服务卸载到边缘计算设备执行时,整个端-边-云协同系统的总时延表示为:

[0038][0039]

整个端-边-云协同系统的总能耗表示为:

[0040][0041]

步骤a3:当服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,计算过程如下:

[0042]

步骤a3.1:针对服务si被服务卸载决策模型要求服务卸载到云服务器执行时,先将服务数据卸载到边缘计算设备中,再从边缘计算设备卸载到云服务器中;

[0043]

从边缘计算设备到云服务器之间的数据传输时延表示为:

[0044][0045]

其中,表示边云之间的传输功率,表示边云之间的信道增益;

[0046]

云服务器执行过程的计算能耗为:

[0047][0048]

式中,c

cloud

表示云服务器的算力;

[0049]

步骤a3.2:综上,当服务卸载到云服务器执行时,整个端-边-云协同系统的总时延表示为:

[0050][0051]

式中,rtt表示边缘计算设备到云服务器之间的物理传输时延;

[0052]

整个端-边-云协同系统的总能耗表示为:

[0053][0054]

作为本发明的一种优选技术方案,基于各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,构建端-边-云协同系统

的目标函数与约束条件;

[0055]

目标函数为:

[0056][0057]

其中,表示卸载方法为si分配的信道数,表示卸载方法为si分配的计算资源数,θ表示该卸载方法的全部参数,statei表示处理si时对应边缘计算设备的状态;nm(t)表示第m个边缘计算设备em在预设时间段t中的总服务数目,端-边-云协同系统中边缘计算设备总数为m;

[0058]

esti表示为服务si卸载决策的得分:,

[0059]

esti=wi·

δti+ζ

·

(1-wi)

·

δei[0060]

其中,δti表示本地和卸载后服务所需时延的差值,δei表示本地和卸载后服务所需能耗的差值,ζ是时延-能耗修正的超参数,wi表示服务的延迟敏感度;

[0061]

约束条件如下:

[0062][0063]

表示每个服务分配到的信道数不得超过总信道数且每个服务必须分配信道;

[0064][0065]

表示每个服务分配到的子计算资源个数不得超过总数,且可以不分配资源,代表卸载到云服务器处理;

[0066][0067]

表示服务的时延敏感度必须为0到1之间的数;

[0068]

其中,nb表示每个边缘计算设备中总共的信道数目,nc表示每个边缘计算设备中总共的计算资源数。

[0069]

作为本发明的一种优选技术方案,所述步骤b中,基于各边缘计算设备内包括策略网络、价值网络,采用异步强化学习方法,即异步优势行动者-评论家算法,各边缘计算设备针对预设时间段内对应预设区域中的各服务请求执行步骤b1至b4,分别对各边缘计算设备的服务卸载决策进行优化,直到模型收敛或达到预设迭代次数,得到各边缘计算设备分别一一对应的车辆服务卸载模型:

[0070]

步骤b1:边缘计算设备基于预设时间段内任意边缘计算设备中的第i个服务,结合该边缘计算设备中当前剩余资源,得到当前边缘计算设备状态,输入策略网络;

[0071]

步骤b2:策略网络基于当前边缘计算设备状态,输出边缘计算设备服务卸载决策的概率分布,边缘计算设备基于策略网络输出的概率分布执行服务卸载决策,并为该服务分配信道和计算资源;

[0072]

步骤b3:基于边缘计算设备执行服务卸载决策和对应的时延和能耗,得到当前服务卸载决策动作的即时奖励;

[0073]

步骤b4:基于边缘计算设备执行服务卸载决策后,价值网络对当前边缘计算设备的状态价值进行评价。

[0074]

作为本发明的一种优选技术方案,所述价值网络以当前边缘计算设备状态为输入,当前边缘计算设备的状态价值为输出,采用多步时间差分误差来拟合目标模型,即经过

n次交互得到的包含n次即时奖励的状态价值与边缘计算设备对当前状态的价值评价接近;以第i个服务si为起点,多步时间差分误差δi表示为:

[0075][0076]

其中,n表示步数,γ为超参数,r

i+j

为环境为第i+j个服务的卸载决策取得的奖励,statei表示第i个服务卸载决策后边缘计算设备状态,v(statei)表示表示第i个服务卸载决策后边缘计算设备的状态价值。

[0077]

作为本发明的一种优选技术方案,所述策略网络以当前边缘计算设备状态为输入,以服务卸载决策的概率分布为输出,采用策略梯度算法引导边缘计算设备做出得到更高状态价值v(state)的决策,基于v(state)对于策略网络参数θ的梯度,采用梯度上升算法更新策略网络;

[0078]

通过蒙特卡罗方法近似,v(s)对于策略网络参数θ的梯度表示为:

[0079][0080]

其中,ai表示基于策略网络π输出的动作,δi为多步时间差分误差作为异步优势行动者-评论家算法中优势函数的权重;

[0081]

基于系统中采用的多动作-单向量表示法,策略梯度改写为:

[0082][0083]

其中,为服务分配的信道数,为服务分配的计算资源数。

[0084]

作为本发明的一种优选技术方案,所述即时奖励ri为:

[0085]ri

=est

i-b

[0086]

其中,b是超参数;

[0087]

esti表示为服务卸载决策的得分:

[0088]

esti=wi·

δti+ζ

·

(1-wi)

·

δei[0089]

其中,δti表示本地和卸载后服务所需时延的差值,δei表示本地和卸载后服务所需能耗的差值,ζ是时延-能耗修正的超参数,wi表示服务的延迟敏感度。

[0090]

作为本发明的一种优选技术方案,所述各边缘计算设备中策略网络参数和价值网络参数的更新为将参数传递至云服务器中进行整合更新,再将云服务器的参数拷贝到对应的边缘计算设备中更新策略网络参数和价值网络参数。

[0091]

作为本发明的一种优选技术方案,所述边缘计算设备的服务卸载决策过程满足马尔可夫决策过程。

[0092]

本发明的有益效果是:本发明提出了基于深度强化学习的节能型自动互联车辆服务卸载方法,该发明提出名为ecac的分布式服务卸载方法。ecac基于异步深度强化学习方法——异步优势行动者-评论家(a3c)算法,将a3c映射到了端-边-云协同系统中。其核心思想是将ecd映射为a3c中的智能体,指导自己对于车辆服务的卸载决策;将云服务器映射为a3c中的中央网络,用于统筹和归纳各agent的学习结果,并在每次参数更新后将自身参数

拷贝到对应的ecd中。整个算法具备根据cavs系统的需求动态学习、自动调整卸载策略的特征,能够满足不同时延敏感度的服务的需求。可以很好地适应车联网环境下动态变化的服务规模和类型,并且符合车联网环境下的天然分布式系统架构,以及能用每个边缘计算设备中仅使用多核cpus就能取得良好的模型训练效果。此外,本发明给出了一种针对不同时延敏感度任务的动态奖励设计方法,以动态权衡时延和能耗的关系、适应不同类型的任务的资源配给。同时,该发明提出自动互联车辆(cavs)中服务时延敏感度的机制,用于指导卸载决策。还给出一种cavs系统中可以客观评价一次决策优劣性的评价标准。以及给出端-边-云协同的分布式cavs系统中,服务卸载的马尔可夫决策过程(mdp)模型。包括对于动作空间、状态空间、环境、交互过程、即时奖励的设计。其中的即时奖励可以兼顾时延和能耗,并能反应系统对于时延和能耗的考虑比重。能长远地兼顾能耗和时延问题,做到绿色、高质量服务。

附图说明

[0093]

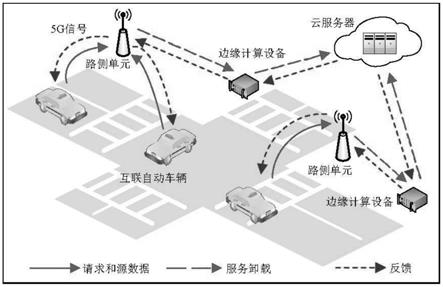

图1是端-边-云协同系统的互联自动车辆服务卸载模型;

[0094]

图2是互联自动车辆场景中的马尔可夫决策过程模型;

[0095]

图3是ecac算法运行框架。

具体实施方式

[0096]

下面结合附图对本发明进行进一步说明。

[0097]

本发明提出了基于深度强化学习的节能型自动互联车辆服务卸载方法,即一种多用户模式的基于异步行动者-评论家(a3c)的节能分布式计算卸载方法,名为ecac。ecac与大部分主流强化学习算法一样,可以很好地适应车联网环境下动态变化的服务规模和类型,而它的优势在于符合车联网环境下的天然分布式系统架构,并且能用每个ecd中仅使用多核cpus(无需gpus)就能取得良好的模型训练效果。ecac将ecd与智能体一一对应,完美地将a3c映射到端边云协同的车联网中。每个ecd收集来自互联自动车辆(cavs)的服务请求,形成环境信息,并用反向求导所得的梯度来更新位于云端的中央策略网络和价值网络,最后定期、异步拷贝中央网络的参数。此外,本发明给出了一种针对不同时延敏感度任务的动态奖励设计方法,以动态权衡时延和能耗的关系、适应不同类型的任务的资源配给。本技术方案能长远地兼顾能耗和时延问题,做到绿色、高质量服务。etac利用cav系统天然的分布式架构来实现异步深度强化学习(drl),并且能够根据服务类型和系统需求动态调整卸载策略。

[0098]

首先给出互联自动车辆(cvas)网络下的计算卸载系统模型,各使用到的物理量含义如表1所示。

[0099]

表1各关键物理量及其定义

[0100][0101]

在这个cavs网络中,服务以端-边-云协同的模式进行卸载,如图1所示。其中端指车辆,即服务请求的发起者,用集合v={v1,v2,v3,

···

,vk}表示,k是车辆总数。在车对基础设施通信(v2i)中,自动车辆首先将任务请求提交至rsus,考虑到在该发明的卸载模型中,rsus仅仅充当中间通信桥梁的作用,因此rsus被直接增强为ecds,即ecds与rsus位于同一位置。ecds被表示为集合e={e1,e2,e3,

···

,em},其中m是确定区域内ecds的总数目。在该发明的算法中,时间被离散化为一个个小的时间段;在每个时段τ内,每个ecd(表示为em)统计收集到的来自车辆不同车辆的服务,形成服务集每个ecd有自己的管辖范围,它们只接受所在辖区的道路上的车辆的请求,因此假设每个ecd的中的服务互不重复,表示为

[0102][0103]

此外,由于5g技术对于通信效果的保障,本发明假设从服务请求的提交到服务执行完毕,车辆都能与同一ecd保持稳定连接。ecd的决策任务是不仅决定对于当前服务集中的某个服务,应该由自己来计算还是卸载到云服务器执行。若在ecd中执行,卸载决策需要告知为服务分配多少计算资源和信道;若卸载到云执行,则卸载决策需要确定分配的信道数。

[0104]

基于深度强化学习的节能型自动互联车辆服务卸载方法,基于由各车辆、各边缘计算设备、以及云服务器构成的端-边-云协同系统下,各边缘计算设备分别与各预设区域一一对应,针对预设时间段内各预设区域中的服务请求,端-边-云协同系统执行以下步骤,得到各边缘计算设备分别对应的车辆服务卸载模型,实现各边缘计算设备为对应预设区域的服务请求提供相应的服务卸载决策。

[0105]

步骤a:针对端-边-云协同系统,基于各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,构建端-边-云协同系统的目标函数与约束条件。

[0106]

所述步骤a中各边缘计算设备执行服务卸载决策时由步骤a1至步骤a3,得到各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务卸载到云服务器执行时的时延模

型和能耗模型。

[0107]

步骤a1:针对预设时间段内任意边缘计算设备中的第i个服务si,服务表示为一个四元组,即si=<di,ci,wi,vi>,其中di表示服务的数据量,ci表示服务的计算量,wi表示服务的延迟敏感度,最后vi表示产生服务请求的车辆。这是影响决策结果的四个因素,其中vi决定了cav与ecd间的传输功率pi和信道增益gi。

[0108]

车辆到边缘计算设备的最大通信速率表示为:

[0109][0110]

其中,bi表示分配给服务si的带宽,pi表示自动车辆vi与边缘计算设备间的传输功率,vi表示产生服务请求的车辆,gi表示自动车辆vi与边缘计算设备间的信道增益,n0则代表信道的噪声功率密度;

[0111]

当服务在车辆本地计算,总时延表示为:

[0112][0113]

其中,表示产生服务si的自动车辆的本地计算速率,ci表示服务si的计算量;

[0114]

车辆本地的能耗表示为:

[0115][0116]

其中,k表示能量因子;

[0117]

步骤a2:当服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,计算过程如下:

[0118]

步骤a2.1:针对服务si被服务卸载决策模型要求服务卸载到边缘计算设备执行时,那么分配给该服务的信道数和计算资源数也已确定。如前所述,由于该发明的cavs模型将rsu上升为了ecd,数据从车辆到ecd的传输视作一步到位的;

[0119]

车辆到边缘计算设备的传输时延表示为:

[0120][0121]

式中,di表示服务si的数据量;

[0122]

车辆到边缘计算设备对应的传输能耗表示为:

[0123][0124]

式中,pi表示车辆到边缘计算设备的传输功率,表示车辆到边缘计算设备的传输时间;由于服务的计算结果大小要远远小于原始数据大小,返程时的代价可以忽略不记。

[0125]

步骤a2.2:边缘计算设备中总的计算资源平均地划分为各个可分配的子计算资源,每个子计算资源贡献固定份额的计算速率fi,即其中表示为服务si分配的子计算资源个数,c

single

表示每个子计算资源的算力,当服务传输到边缘计算设备后,边缘计算设备基于该服务所分配的计算资源执行该服务,服务的计算耗时为:

[0126][0127]

该服务的计算能耗为:

[0128][0129]

步骤a2.3:最后,基于从该服务si全部上传到边缘计算设备中到被边缘计算设备执行该服务的过程中,存在等待边缘计算设备服务器空出个子计算资源算力的时延

[0130][0131]

式中,表示服务开始执行的时刻,而表示服务数据全部卸载到边缘计算设备中的时刻;

[0132]

步骤a2.4:综上,当服务卸载到边缘计算设备执行时,整个端-边-云协同系统的总时延表示为:

[0133][0134]

整个端-边-云协同系统的总能耗表示为:

[0135][0136]

步骤a3:当服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,计算过程如下:

[0137]

步骤a3.1:针对服务si被服务卸载决策模型要求服务卸载到云服务器执行时,先将服务数据卸载到边缘计算设备中,再从边缘计算设备卸载到云服务器中;由于ecd由rsus升级而成,卸载时以一个ecd为中间通信设备,即先将数据卸载到ecd中,再从ecd卸载到云服务器中,所以会产生两次数据传输时间。在这两个传输过程中,服务始终占用最初被分配到的信道数。此外,云服务器通常与ecd距离较远,因此它们之间存在一个不可忽略的物理传输时延,它与任务类型、数据量大小无关,且往返过程的时延相近,所以该发明中直接考虑整个过程的物理传输时延,即round-trip time,rtt。

[0138]

此外,还应考虑从边缘计算设备到云服务器之间的数据传输时延表示为:

[0139][0140]

其中,表示边云之间的传输功率,表示边云之间的信道增益;

[0141]

云服务器执行过程的计算能耗为:

[0142][0143]

式中,c

cloud

表示云服务器的算力;

[0144]

步骤a3.2:综上,云服务器处理任务的优势在于算力资源充足、计算高效,因此该发明忽略服务在云中执行的耗时和服务排队等待计算资源的时间。但是执行过程中的能耗

不可忽略。当服务卸载到云服务器执行时,整个端-边-云协同系统的总时延表示为:

[0145][0146]

式中,rtt表示边缘计算设备到云服务器之间的物理传输时延;

[0147]

整个端-边-云协同系统的总能耗表示为:

[0148][0149]

为了体现卸载方案的优势,本地计算的时延和能耗被作为基础,用δti和δei分别表示本地和卸载后服务所需时延和能耗的差值。同时为了动态权衡不同时延敏感度的服务时延和能耗的关系,形成最后的卸载评价,令esti表示为si卸载决策的得分,即在当下时刻的卸载优势大小,基于各边缘计算设备的服务卸载决策模型要求服务卸载到边缘计算设备执行时的时延模型和能耗模型,以及各边缘计算设备的服务卸载决策模型要求服务卸载到云服务器执行时的时延模型和能耗模型,构建端-边-云协同系统的目标函数与约束条件;

[0150]

算法最终目标是找到一种卸载方法使得某个端-边-云协同的系统能在给定时间段t内取得最大的平均卸载优势,目标函数为:

[0151][0152]

其中,表示卸载方法为si分配的信道数,表示卸载方法为si分配的计算资源数,θ表示该卸载方法的全部参数,statei表示处理si时对应边缘计算设备的状态;nm(t)表示第m个边缘计算设备em在预设时间段t中的总服务数目,端-边-云协同系统中边缘计算设备总数为m;

[0153]

esti表示为服务si卸载决策的得分:,

[0154]

esti=wi·

δti+ζ

·

(1-wi)

·

δei[0155]

其中,δti表示本地和卸载后服务所需时延的差值,δei表示本地和卸载后服务所需能耗的差值,ζ是时延-能耗修正的超参数,用来修正能耗和时间之间的量纲不同带来的数量级偏差,同时用于表示不同车联网系统对于时延和能耗考虑的比重的不同;wi表示服务的延迟敏感度;

[0156]

约束条件如下:

[0157][0158]

表示每个服务分配到的信道数不得超过总信道数且每个服务必须分配信道;

[0159][0160]

表示每个服务分配到的子计算资源个数不得超过总数,且可以不分配资源,代表卸载到云服务器处理;

[0161][0162]

表示服务的时延敏感度必须为0到1之间的数;

[0163]

其中,nb表示每个边缘计算设备中总共的信道数目,nc表示每个边缘计算设备中总共的计算资源数。

[0164]

步骤b:基于端-边-云协同系统的目标函数与约束条件,针对预设时间段内各预设区域中的服务请求,采用异步强化学习方法对各边缘计算设备的服务卸载决策模型进行优化,得到各边缘计算设备分别一一对应的车辆服务卸载模型。

[0165]

步骤c:基于各边缘计算设备分别一一对应的车辆服务卸载模型,各边缘计算设备为对应区域的自动车辆的服务请求提供相应的服务卸载决策。

[0166]

所述步骤b中,基于各边缘计算设备内包括策略网络、价值网络,采用异步强化学习方法,即异步优势行动者-评论家算法,各边缘计算设备针对预设时间段内对应预设区域中的各服务请求执行步骤b1至b4,分别对各边缘计算设备的服务卸载决策进行优化,直到模型收敛或达到预设迭代次数,得到各边缘计算设备分别一一对应的车辆服务卸载模型:

[0167]

异步优势行动者-评论家(a3c)是优势行动者-评论家算法(a2c)的异步化改进,它较其它深度强化学习方法有许多性能优势。早期的drl算法中,智能体对于环境连续的观测数据间通常是强相关的,这会导致了训练结果的不稳定。a3c通过对环境信息的异步提取和训练,可以解决这种连续样本间的相关性。并且相较于dqn等采用经验回放技术的算法,a3c不需要额外的内存开销来记录经验数据,这降低了将rsus升级为ecds或有决策能力的智能设备的成本。在ecac中,为每个ecd内置一个智能体(agent),智能体中含有本地网络,而云服务器中内中中央网络,所有网络结构相同。此外,a3c是一种分布式方法,可以完美契合边缘协同的车联网场景,即将ecd视作每个异步更新的智能体(agent),将云服务器视作统筹所有ecds进行参数整合和更新的中央网络。因此它被使用在ecac中。cavs场景中的ecac算法运行框架如图3所示。ecac方法是policy-based和value-based方法的结合,每个ecd存储一个参数独立的策略网络和价值网络,这两个网络共享一部分参数。训练阶段行动者依靠策略网络输出的概率分布来随机选择动作进行卸载决策,这保证了模型对未知动作的探索性;评论家依靠价值网络来评价动作执行后环境的状态价值。

[0168]

步骤b1:边缘计算设备基于预设时间段内任意边缘计算设备中的第i个服务,结合该边缘计算设备中当前剩余资源,得到当前边缘计算设备状态,输入策略网络;

[0169]

步骤b2:策略网络基于当前边缘计算设备状态,输出边缘计算设备服务卸载决策的概率分布,边缘计算设备基于策略网络输出的概率分布执行服务卸载决策,并为该服务分配信道和计算资源;所述策略网络以当前边缘计算设备状态为输入,以服务卸载决策的概率分布为输出,采用策略梯度算法引导边缘计算设备做出得到更高状态价值v(state)的决策,基于v(state)对于策略网络参数θ的梯度,采用梯度上升算法更新策略网络;

[0170]

通过蒙特卡罗方法近似,v(s)对于策略网络参数θ的梯度表示为:

[0171][0172]

其中,ai表示基于策略网络π输出的动作,δi为多步时间差分误差作为异步优势行动者-评论家算法中优势函数的权重;

[0173]

基于系统中采用的多动作-单向量表示法,策略梯度改写为:

[0174]

[0175]

其中,为服务分配的信道数,为服务分配的计算资源数。

[0176]

步骤b3:基于边缘计算设备执行服务卸载决策和对应的时延和能耗,得到当前服务卸载决策动作的即时奖励;

[0177]

所述即时奖励ri为:

[0178]ri

=est

i-b

[0179]

其中,b是超参数。

[0180]

由于服务si的卸载优势esti可以很好地表示一次决策的优劣性,最初它被考虑直接作为即时奖励ri使用。而前期实验的结果证明这存在一定的不稳定性:若ecac算法能在前几轮游戏中取得相对较高的成绩,它就能在未来学得越来越好;而若ecac算法在前几轮游戏中取得相对较低的成绩,它在未来就会学得越来越糟糕。这是因为:由于服务计算较本地计算的优越性,在大部分时候,即使一个不好的决策也会取得大于零的分数,即哪怕资源分配不够合理,卸载到边和云执行的服务也很可能比在本地执行效果要好。这就会影响网络的判断,误导策略网络学习那些不够好却能取得正分的动作、同时误导价值网络为不够好的状态打高分。尽管actor-critic的模型中,策略网络属于policy-based,它能保留对所有动作的探索性,但不足以完全解决上述问题。因此,本发明中,即时奖励被修改为ri=est

i-b。这么做是为了让ri有明显的正负之分。负分动作被认为是坏动作,网络一定会避而远之。这成功地避免了上述问题。

[0181]

在ecac中,决定最后模型训练结果的是ζ。它不仅用于弥补时延和能耗的量纲差异,同时也反应了cavs系统的实际需求。当系统更倾向于节省能耗,那ζ应适当调大,同时系统的均分会降低,因为无论服务卸载到云端还是边缘段,都会比本地计算更耗能。经过长期学习,价值网络能够给当前状态打出一个客观的分数,而策略网络对任何状态则能够给出一个让价值网络打高分得卸载决策。这就意味着,ecd总能采取长期最优的策略,这个策略不仅保证当前服务卸载的质量,也能为未来服务的卸载创造优势;更重要的是,它动态地兼顾了时延和能耗。

[0182]

步骤b4:基于边缘计算设备执行服务卸载决策后,价值网络对当前边缘计算设备的状态价值进行评价。所述价值网络以当前边缘计算设备状态为输入,当前边缘计算设备的状态价值为输出,采用多步时间差分误差来拟合目标模型,即经过n次交互得到的包含n次即时奖励的状态价值与边缘计算设备对当前状态的价值评价接近;以第i个服务si为起点,多步时间差分误差δi表示为:

[0183][0184]

其中,n表示步数,γ为超参数,r

i+j

表示环境为第i+j个服务的卸载决策取得的奖励,statei表示第i个服务卸载决策后边缘计算设备状态,v(statei)表示表示第i个服务卸载决策后边缘计算设备状态价值。

[0185]

.所述边缘计算设备的服务卸载决策过程满足马尔可夫决策过程。ecac中的马尔可夫决策过程(mdp)模型如下:

[0186]

在ecac中,每个ecd对应一个agent,而云服务器中存有中央网络。em不停地从服务队列中顺序取出请求,直至没有待处理的请求为止。em将服务请求的参数(数据量、计算量、时延敏感度等)结合em中当前剩余资源(剩余信道数、计算资源)形成状态statei。显然,尽管

所有ecd的服务请求来自同一区域内的车辆,即它们共享同一个环境,但它们从环境中观测到的状态各有不同。如图2所示,所有em重复做同一件事:确定状态statei,将statei输入到drl的agent中、根据agent输出的动作ai决定服务在云端还是在边缘执行以及为服务分配的资源数目、完成服务的计算并统计时延和能耗,得到ri。当决策完成,em取出下一个服务并形成下一步状态state

i+1

,进行下一步决策。此过程中,直接决定当前动作ai的只有当前状态si,因此该cavs服务卸载过程满足马尔可夫决策过程(mdp)。drl的决策目标是取得全局最优解,对于cavs卸载决策而言是平均奖励取得最大值。

[0187]

ecac的状态空间至少为5维向量,由剩余信道数、计算资源数和待处理服务的数据量、计算量、时延敏感度构成。对于不同车辆和ecd间的传输功率与信道增益有明显差异的cavs网络,也只需要在状态空间额外扩展2个维度进行描述即可。策略网络输出的是执行每一种动作的概率分布,而agent共能执行选择资源数和选择信道数两类动作,每类动作分别有nb和nc+1种可能,用独热向量表示。为了降低动作空间维度数,进而提升模型训练和决策的效率,该发明采用多动作-单向量表示法(而非采用子动作的笛卡尔积)。因此,神经网络输出维度为nb+nc+1的向量,并分别将其切割为长度为nb和nc+1的两段,分别用激活函数转化为两个子动作的概率密度。

[0188]

ecac卸载决策的总体流程如表2中所示。在每一次的决策中,除了获得请求和处理服务外,ecd存储状态、动作、即时奖励到一个buffer中(line 11

–

line 15)。每当一轮游戏结束,结尾状态的状态价值即为0,而不再是价值网络的输出(line 17)。

[0189]

表2

[0190][0191][0192]

每当一个buffer填满,需要通过multi-step td-error和策略梯度计算ecd中所有网络的梯度。根据a3c的异步特性,ecac中每个ecd内两个网络独立地计算出各自梯度后,不直接更新自身参数,而是将参数传递至云端并更新中央网络的参数;每次更新结束后从中央网络拷贝参数到提交梯度的ecd中。这样做的好处是,由于每个ecd所观测到的环境状态各不相同,很好地消除了相邻状态间的相关性;同时并行化也提高的网络学习的效率。所有服务器异步、并行地重复执行上述操作,直到模型收敛。

[0193]

所述各边缘计算设备中策略网络参数和价值网络参数的更新为将参数传递至云服务器中进行整合更新,再将云服务器的参数拷贝到对应的边缘计算设备中更新策略网络参数和价值网络参数。

[0194]

本发明设计了基于深度强化学习的节能型自动互联车辆服务卸载方法,该发明提出名为ecac的分布式服务卸载方法。ecac基于异步深度强化学习方法——异步优势行动者-评论家(a3c)算法,将a3c映射到了端-边-云协同的cav模型中。其核心思想是将ecd映射为a3c中的agent,指导自己对于cav车辆服务的卸载决策;将云服务器映射为a3c中的中央网络,用于统筹和归纳各agent的学习结果,并在每次参数更新后将自身参数拷贝到对应的ecd中。整个算法具备根据cavs系统的需求动态学习、自动调整卸载策略的特征,能够满足不同时延敏感度的服务的需求。同时,该发明提出自动互联车辆(cavs)中服务时延敏感度的机制,即让cavs在发送服务请求时提供一位对于服务时延忍受能力的表述,用0-1之间的小数表示,用于指导卸载决策。还给出一种cavs系统中可以客观评价一次决策优劣性的评价标准,它与服务计算的消耗较本地计算消耗的差值、服务的时延敏感度、系统对于卸载决策的要求有关。以及给出端-边-云协同的分布式cavs系统中,服务卸载的马尔可夫决策过程(mdp)模型。包括对于动作空间、状态空间、环境、交互过程、即时奖励的设计。其中的即时奖励可以兼顾时延和能耗,并能反应系统对于时延和能耗的考虑比重。

[0195]

上面结合附图对本发明的实施方式作了详细说明,但是本发明并不限于上述实施方式,在本领域普通技术人员所具备的知识范围内,还可以在不脱离本发明宗旨的前提下做出各种变化。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1