一种基于法律要素的类案检索方法及系统

1.本发明涉及一种基于法律要素的类案检索方法及系统,属于文本相似度计算的技术领域。

背景技术:

2.随着中国智慧司法的发展深入,在持续全面推行“类案及关联案件强制检索”制度背景下,司法大数据不断公开,“类案检索”的应用范围不断扩大,因此,类案检索结果的准确性亟待提升。

3.法律案例检索是一种特殊的检索任务,它是指检索给定查询用例的类似案例。与传统的文本检索相比,法律案例检索具有不同的特点和更大的挑战性,主要体现在以下几个方面:

4.(一)法律案例文本往往为长文本。冗长的文本会导致模型对文本建立向量表示的时候无法顾全所有的有用信息。而目前,在文本领域最常用的神经网络模型如长短时记忆网络的记忆能力并不强,在长文本方面的应用效果不佳,这也导致针对通用文本相似度计算的方法和模型在法律领域效果不好的一大原因。

5.(二)法律案件的相似不同于通用的文本相似,在某种程度上也超出了文本主题相关性的一般定义,它需要挖掘文本中所包含的法律要素的相似性,传统的文本相似度计算方法的确可以对语义进行学习,但由于模型不了解法律领域知识,可能无法学习到表层语义下面更深的法律相关的逻辑联系,这就导致了单纯使用文本相似度计算方法并不能找到高度相似的法律案件。因此,识别案件在法律问题和法律流程方面的相似性至关重要。

6.(三)法律文本结构与一般文本结构不同。通用文本相似性模型考虑的主要是文本的结构性特点,比如,句法结构,却不能很好的表示法律文本。判决文书虽然是非结构化的文本,但判决文书的书写有着特定的格式要求,如果能够将判决文书的结构特点与传统文本相似度的计算相结合,可能会产生更好的效果。

7.在考虑两个案件是否相似时,实际上是在考虑两个案件中所包含的法律要素及其组成的事件逻辑是否相似,这些法律要素往往体现在被告人的行为上,是用于判定被告人是否触犯某些法律法规,以及应该判处何种罪名,刑期时间长短的关键要素。

技术实现要素:

8.针对现有技术的不足,本发明提供一种基于法律要素的类案检索方法。

9.本发明还提供了一种基于法律要素的类案检索系统。

10.发明概述:

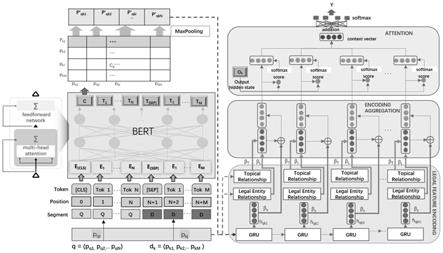

11.本发明模型框架包含三个模块,第一部分为法律特征编码模块,其中包含基于bert的语义编码模块、基于lda的主题分布编码模块和法律实体编码模块;第二部分为编码聚合模块,在进入第三部分之前,第二部分负责将第一部分输出的结果进行编码聚合;第三部分为相似度计算模块。

12.针对传统文本相似性方法在法律文本相似性方面的不足,本发明通过三种编码模块对法律要素信息进行提取,通过基于bert的语义编码模块捕获案件的语义上下文信息,通过主题编码模块聚类案件描述的主题信息,通过法律要素编码模块更精准地加强法律要素信息的作用,并将聚合之后的段落编码信息输入门限循环神经网络gru(gate recurrent unit),来提取法律案件描述的段落级逻辑关系,最后通过注意力机制实现段落级关键信息的识别。

13.术语解释:

14.1、bert:一种自编码语言模型,用于提取词语在句子中的关系特征,并根据句子上下文获取语义特征。

15.2、[cls]标志:放在第一个句子的首位,经过bert得到的的表征向量c可以用于后续的分类任务。

[0016]

3、[sep]标志:用于分开两个输入句子,例如输入句子a和b,要在句子a、b后面增加[sep]标志。

[0017]

4、lda模型:主题概率模型,可以根据基于lda的文档生成的逆过程求得文档的主题分布。

[0018]

5、gru模型:长短时记忆网络lstm的变体,属递归神经网络,可以用于解决文本编码中的长依赖问题。

[0019]

6、注意力机制。注意力机制最早由机器翻译任务提出,通过计算模型解码器端生成序列的单词对编码器中每个单词的权重分布,得到有权重关联信息的特征向量表示,提高模型翻译效果。在这里可以理解为对输入权重进行关注性分配的机制。

[0020]

7、狄利克雷分布:即dirichlet分布,是一组连续多变量概率分布,是多变量普遍化的b分布。

[0021]

8、gibbs sampling方法,吉布斯采样方法,常用于dbm和dbn,吉布斯采样主要用在像lda和其它模型参数的推断上。

[0022]

9、bm25,是一种用来评价搜索词和文档之间相关性的算法,它是一种基于概率检索模型提出的算法。

[0023]

10、tf-idf(term frequency

–

inverse document frequency,词频-逆向文件频率),是一种用于信息检索(information retrieval)与文本挖掘(text mining)的常用加权技术,是一种统计方法,用以评估一字词对于一个文件集或一个语料库中的其中一份文件的重要程度。字词的重要性随着它在文件中出现的次数成正比增加,但同时会随着它在语料库中出现的频率成反比下降,如果某个单词在一篇文章中出现的频率tf高,并且在其他文章中很少出现,则认为此词或者短语具有很好的类别区分能力。

[0024]

11、lmir,是1999年提出一种信息检索语言模型,它是基于一系列的数据平滑技术,包括good-turing估计,曲线拟合函数和模型组合,该模型可以很容易地扩展到包含短语的概率,比如词对和词三元组。

[0025]

12、bert模型,bidirectional encoder representations from transformer,是一种预训练语言模型,如图2所示,就是基于transformer的双向编码器表征。顾名思义,bert采用的是transformer,并且在处理一个单词的时候,还能够考虑到该词前面的和后面的单词,得到它在上下文中的含义。其目的是提前训练好下游任务中底层的、共性的部分模

型,然后再用下游任务各自的样本数据来训练各自的模型,这样就可以极大地加快收敛速度。对于nlp的下游任务,尽管最终目标各不相同,但是它们也有着共同的必要步骤,即将文本中的无法直接计算的单词转变为可以计算的向量或者矩阵等形式,并且这些数字化的向量要能够比较好地反映出对应单词在句子中的含义。

[0026]

13、gru模型,是lstm网络的一种效果很好的变体,它较lstm网络的结构更加简单,而且效果也很好。如图3所示,在lstm中引入了三个门函数:输入门、遗忘门和输出门来控制输入值、记忆值和输出值。而在gru模型中只有两个门:分别是更新门和重置门,gru的参数较少,因此训练速度更快,gru也是可以解决rnn网络中的长依赖问题,能够降低过拟合的风险。

[0027]

12、bert-pli,是2020年提出的一种法律案件检索模型,该模型利用bert来捕获段落级语义关系,然后通过聚合段落级交互来推断两个案例之间的相关性。

[0028]

本发明的技术方案为:

[0029]

一种基于法律要素的类案检索方法,包括步骤如下:

[0030]

步骤1:语义编码;是指:先将长文本按案件描述顺序划分为短的段落,再通过基于bert的文本编码方法对查询段落和候选段落进行语义编码表示;

[0031]

步骤2:主题分布编码;是指:基于lda模型文档生成的逆过程,分别获得查询文档段落集与每篇候选文档段落集的主题概率分布交互矩阵;

[0032]

步骤3:法律实体编码;是指:从文书中抽取法律要素,并对每一个案件中所包含的法律要素进行同义词扩展,最终对两个案件段落间的相似度进行计算;

[0033]

步骤4:编码聚合及相似度计算;是指:将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,选取相似度较大的前几个对应的候选文档作为类案。

[0034]

根据本发明优选的,步骤1的具体实现过程如下:

[0035]

步骤1.1:形式化地描述,对于一个查询文档q和任一候选文档dk分别表示为q=(p

q1

,p

q2

,

…

,p

qi

…

,p

qn

),dk=(p

k1

,p

k2

,

…

,p

kj

…

,p

km

);其中,n和m分别为查询文档q和候选文档dk的总段落数;对于查询文档q和候选文档dk中的每个段落,构造一个查询-候选段落对(p

qi

,p

kj

),其中,1≤i≤n和1≤j≤m;

[0036]

步骤1.2:将段落对(p

qi

,p

kj

)连同保留的标记即[cls]和[sep]一起输入bert模型;第一个令牌[cls]的最终隐藏层向量输出作为查询-候选段落对(p

qi

,p

kj

)的语义聚合表示,具体如式(1)所示:

[0037]cij

=bert(p

qi

,p

kj

)

ꢀꢀ

(1)

[0038]

这样,得到所有查询-候选段落对的交互矩阵,每个查询-候选段落对(p

qi

,p

kj

)的语义表示为c

ij

,c

ij

∈r

hb

;

[0039]

步骤1.3:对于查询文档的每一段落,使用maxpooling候选文档的最强匹配段落,从而得到一个向量序列,表示为p’qk

=[p’qk1

,p’qk2

,...,p’qki

...,p’qkn

];p’qki

如式(2)所示:

[0040][0041]

步骤1.4:通过gru模型对p’qki

进行进一步的编码,得到语义编码结果h

qk

=[h

qk1

,h

qk2

,

…

,h

qki

…

,h

qkn

],h

qki

∈r

hr

。

[0042]

根据本发明优选的,步骤2的具体实现过程如下:

[0043]

步骤2.1:利用生成的文档推断其隐藏的主题的过程即lda模型文档生成的逆过程,只有文档d中单词w是被观察到的,主题z是隐藏的,根据大量已知的文档-词项信息即文档d中单词w,计算得到每个文档上主题的后验分布,如式(3)所示:

[0044][0045]

其中,是主题分布,是的狄利克雷分布,是主题分布的先验分布参数,构成文档m的主题数向量,是确定的主题,通过gibbs sampling方法求解出主题的后验分布

[0046]

步骤2.2:根据公式(3)得到段落p

qi

,p

kj

的主题的后验分布分别为zp

qi

=[zp

qi-1

,zp

qi-2

,...,zp

qi-v

]和zp

kj

=[zp

kj-1

,z

kj-2

,...,zp

kj-v

],

[0047]

计算得到查询文档段落集与候选文档段落集的主题概率分布交互矩阵t

qik

,查询文档段落集、候选文档段落集分别是指在查询文档q=(p

q1

,p

q2

,

…

,p

qi

…

,p

qn

)、任一候选文档dk=(p

k1

,p

k2

,

…

,p

kj

…

,p

km

)的所有段落组成的集合,其中,n和m分别为查询文档q和候选文档dk的总段落数;如式(4)所示:

[0048][0049]

其中,v为主题个数超参数,每个元素用t

qik

表示。

[0050]

根据本发明优选的,步骤3的具体实现过程如下:

[0051]

步骤3.1:采用正则表达式的方式从文书中抽取法律要素,法律要素包括罪名ccg、犯罪行为co、人物类型ct、犯罪后果cc、补偿行为cb、和解情况r;进而对每一个案件中所包含的法律要素进行同义词扩展;

[0052]

步骤3.2:对于两个案件段落间的相似度进行计算,分两部分进行:

[0053]

罪名或补偿行为的相似度计算公式方式如式(5)所示:

[0054][0055]

其中,entityname1代表段落提取的罪名或补偿行为集合;

[0056]

犯罪行为co、人物类型ct、犯罪后果cc或和解情况r的相似度计算方式如式(6)所示:

[0057][0058]

其中,entityname2代表段落分别提取的犯罪行为co、人物类型ct、犯罪后果cc或和解情况r;

[0059]

基于所有法律要素的段落间相似度sim_e(e

qi

,e

kj

)计算方式如式(7)所示:

[0060][0061]

其中,μ1,μ2,μ3分别为权重参数,sim_e(e

qi

,e

kj

)是指基于法律要素的段落间相似度,e

qi

和e

kj

代表查询段落和候选段落的实体集合;这样,对于查询段落集和候选段落集,得到一个相似度矩阵le

qk

=[le

q1k

,le

q2k

,

…

,le

qik

…

,le

q1k

],le

qik

=sim_e(e

qi

,e

kj

)。

[0062]

根据本发明优选的,步骤4的具体实现过程如下:

[0063]

将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,计算公式如式(8)所示:

[0064]eqki

=β

shqki

+β

t

t

qik

+β

l

le

qik

[0065]

=βs[gru(h

qk

(i-1),p’qki

)]+β

t

t

qik

+β

l

le

qik

ꢀꢀꢀ

(8)

[0066]

其中,βs,β

t

,β

l

分别为权重参数;

[0067]

对查询-候选对的聚合编码输出,添加注意力机制来进一步编码位置信息,注意力权重计算法方式如式(9)所示:

[0068][0069]

α

qki

、u

qk

分别是指注意力机制中的权重及参数;

[0070]

其中,u

qk

的计算方式如式(10)所示:

[0071]uqk

=wu·

maxpool(e

qk

)+buꢀꢀꢀ

(10)

[0072]

式(10)中,maxpool()是指对每行数据选取一行中最大的值,q为查询文档,k为某一候选文档,e

qk

为查询文档q与某候选文档k的聚合编码;wu∈r

hr

×

hr

,bu∈r

hr

;

[0073]

通过聚合公式式(11)得到文档级的相似性关系:

[0074][0075]

最后,所有d

qk

经过一个全连接层和一个softmax函数获得两个法律案件描述文档的相似性概率值;找到相似性概率值最大的值对应的文档即为要求取的类案。

[0076]

一种基于法律要素的类案检索系统,包括语义编码模块、主题分布编码模块、法律实体编码模块、编码聚合及相似度计算模块;

[0077]

所述语义编码模块,被配置为:先将长文本按案件描述顺序划分为短的段落,再通过基于bert的文本编码方法对查询段落和候选段落进行语义编码表示;

[0078]

所述主题分布编码模块,被配置为:基于lda模型文档生成的逆过程,分别获得查询文档段落集与每篇候选文档段落集的主题概率分布交互矩阵;

[0079]

所述法律实体编码模块,被配置为:从文书中抽取法律要素,并对每一个案件中所包含的法律要素进行同义词扩展,最终对两个案件段落间的相似度进行计算;

[0080]

所述编码聚合及相似度计算模块,被配置为:将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,选取相似度较大的前几个对应的候选文档作为类案。

[0081]

一种计算机可读存储介质,其中存储有多条指令,所述指令适于由终端设备的处理器加载并执行所述的基于法律要素的类案检索方法。

[0082]

一种终端设备,包括处理器和计算机可读存储介质,处理器用于实现各指令;计算机可读存储介质用于存储多条指令,所述指令适于由处理器加载并执行所述的基于法律要素的类案检索方法。

[0083]

本发明的有益效果为:

[0084]

1、本发明采用基于段落切割聚合的架构,将长法律文本按案件逻辑顺序划分为短段落,然后通过基于bert的文本编码方法对查询和候选段落进行语义编码表示。一方面可以利用bert强大的语义学习能力,另一方面可以解决法律案例的长文本编码问题。

[0085]

2、本发明挖掘了法律案件中的罪名、犯罪行为、犯罪实体类型、犯罪后果、补偿行为、和解情况几个对判决产生决定性影响的法律要素实体,并对每一个案件中所包含的法律要素进行同义词扩展,精准挖掘了法律案件中的法律要素。

[0086]

3、本发明通过线性拟合方式将传统语义编码方式与法律文本主题分布、法律案件实体进行聚合,通过法律要素实体与文档主题的深度结合使得文档表示向量更适用于法律场景。

[0087]

4、本发明通过卷积神经网络及注意力机制不仅对段落内法律语义的位置信息进行编码,而且将段落间的法律要素进行逻辑判断与加强。

附图说明

[0088]

图1为本发明基于法律要素的类案检索系统的示意图;

[0089]

图2为bert模型的网络架构示意图;

[0090]

图3为gru模型的网络架构示意图;

[0091]

图4为bert模型的预训练过程示意图;

[0092]

图5为lda主题模型的示意图。

具体实施方式

[0093]

下面结合说明书附图和实施例对本发明作进一步限定,但不限于此。

[0094]

实施例1

[0095]

一种基于法律要素的类案检索方法,包括步骤如下:

[0096]

步骤1:语义编码;是指:先将长文本按案件描述顺序划分为短的段落,再通过基于bert的文本编码方法对查询段落和候选段落进行语义编码表示;一方面可以利用bert强大的语义学习能力,两一方面可以解决法律案例的长文本编码问题。

[0097]

步骤2:主题分布编码;是指:基于lda模型文档生成的逆过程,分别获得查询文档段落集与每篇候选文档段落集的主题概率分布交互矩阵;

[0098]

步骤3:法律实体编码;是指:本发明主要关注法律案件中的犯罪行为、人物类型、补偿行为等几个部分,这三部分都包含了对判决产生决定性影响的法律要素。其中人物类型及补偿行为对所有法律案件类型都适用,犯罪行为因罪名的不同而各异。法律判决文书虽属于非结构化的文本类信息,但判决文书的构成及书写顺序往往要依据一定的书写规范。采用正则表达式的方式从文书中抽取法律要素,并对每一个案件中所包含的法律要素

进行同义词扩展,最终对两个案件段落间的相似度进行计算;

[0099]

步骤4:编码聚合及相似度计算;是指:将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,选取相似度较大的前几个对应的候选文档作为类案。

[0100]

实施例2

[0101]

根据实施例1所述的一种基于法律要素的类案检索方法,其区别在于:

[0102]

步骤1的具体实现过程如下:

[0103]

步骤1.1:形式化地描述,对于一个查询文档q和任一候选文档dk分别表示为q=(p

q1

,p

q2

,

…

,p

qi

…

,p

qn

),dk=(p

k1

,p

k2

,

…

,p

kj

…

,p

km

);其中,n和m分别为查询文档q和候选文档dk的总段落数;对于查询文档q和候选文档dk中的每个段落,构造一个查询-候选段落对(p

qi

,p

kj

),其中,1≤i≤n和1≤j≤m;

[0104]

步骤1.2:将段落对(p

qi

,p

kj

)连同保留的标记即[cls]和[sep]一起输入bert模型;为了捕获词序,添加了位置嵌入,这些嵌入信息输入transformers,在transformers的每一层通过计算与其它token嵌入的加权和,生成新的上下文化嵌入表示。权重值由多头注意力机制计算而来。注意力权重大的词被认为与目标词更相关。不同的注意矩阵捕捉不同类型的词关系,如精确匹配和同义词关系。最后,第一个令牌[cls]的最终隐藏层向量输出作为查询-候选段落对(p

qi

,p

kj

)的语义聚合表示,具体如式(1)所示:

[0105]cij

=bert(p

qi

,p

kj

)

ꢀꢀꢀ

(12)

[0106]

这样,得到所有查询-候选段落对的交互矩阵,每个查询-候选段落对(p

qi

,p

kj

)的语义表示为c

ij

,c

ij

∈r

hb

;

[0107]

步骤1.3:对于查询文档的每一段落,使用maxpooling候选文档的最强匹配段落,从而得到一个向量序列,表示为p’qk

=[p’qk1

,p’qk2

,...,p’qki

...,p’qkn

];p’qki

如式(2)所示:

[0108][0109]

步骤1.4:模型初始化使用预训练的bert模型,以利用预训练的语言模型。通过gru模型对p’qki

进行进一步的编码,得到语义编码结果h

qk

=[h

qk1

,h

qk2

,

…

,h

qki

…

,h

qkn

],h

qki

∈r

hr

。

[0110]

bert模型训练主要分为两个阶段:预训练阶段和fine-tuning阶段。预训练阶段是在大型数据集上根据一些预训练任务训练得到。本发明使用基于预训练任务masked lm的预训练模型(直接使用google开源的中文bert预训练语言模型bert-base-chinese),即在句子中随机遮盖一部分单词,然后同时利用上下文的信息预测遮盖的单词,这样可以更好地根据全文理解单词的意思。具体的:

[0111]

如图4所示,bert在预训练时只预测[mask]位置的单词,这样就可以同时利用上下文信息。但是在后续使用的时候,句子中并不会出现[mask]的单词,这样会影响模型的性能。因此在训练时采用如下策略,随机选择句子中15%的单词进行mask,在选择为mask的单词中,有80%真的使用[mask]进行替换,10%不进行替换,剩下10%使用一个随机单词替换。

[0112]

例如,句子

″

my dog is hairy

″

,选择了单词

″

hairy

″

进行mask,则:

[0113]

80%的概率,将句子

″

my dog is hairy

″

转换为句子

″

my dog is[mask]

″

。

[0114]

10%的概率,保持句子为

″

my dog is hairy

″

不变。

[0115]

10%的概率,将单词

″

hairy

″

替换成另一个随机词,例如

″

apple

″

。将句子

″

my dog is hairy

″

转换为句子

″

my dog is apple

″

。

[0116]

fine-tuning阶段是后续用于一些下游任务的时候进行微调,bert无需调整结构就可以用在下游任务上进行微调。本发明中将cls层输出的向量作为句子对的语义编码向量。

[0117]

gru模型的训练如下:

[0118]

如图3中z

t

和r

t

分别表示更新门和重置门。更新门用于控制前一时刻的状态信息被带入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息带入越多。重置门控制前一状态有多少信息被写入到当前的候选集上,重置门越小,前一状态的信息被写入的越少。

[0119]

gru网络的前向传播公式:

[0120]rt

=σ(wr·

[h

t-1

,x

t

])

[0121]zt

=σ(wz·

[h

t-1

,x

t

])

[0122][0123][0124]yt

=σ(wo·ht

)

[0125]

其中[]表示两个向量相连,*表示矩阵的乘积。

[0126]

从前向传播过程中的公式可以看出要学习的参数有wr、wz、wh、wo。其中前三个参数都是拼接的(因为后先的向量也是拼接的),所以在训练的过程中需要将它们分割出来:

[0127]

wr=w

rx

+w

rh

[0128]

wz=w

zx

+w

zh

[0129][0130]

输出层的输入:

[0131][0132]

输出层的输出:

[0133][0134]

在得到最终的输出后,就可以写出网络传递的损失,单个样本某时刻的损失为:

[0135][0136]

则单个样本的在所有时刻的损失为:

[0137][0138]

采用后向误差传播算法来学习网络,所以先得求损失函数对各参数的偏导(总共有7个):

[0139]

[0140][0141][0142][0143][0144][0145][0146]

其中,各中间参数为:

[0147][0148][0149][0150]

δ

t

=δ

h,t

·zt

·

φ

′

[0151][0152]

在算出了对各参数的偏导之后,就可以更新参数,依次迭代直到损失收敛。

[0153]

步骤2的具体实现过程如下:

[0154]

在lda主题模型(lda模型)中,如图5所示,生成文档的过程分为三层,文档生成->主题生成->词语生成:具体包括如下:

[0155]

①

按照先验概率选择一篇文档d;

[0156]

②

根据先验知识α从狄利克雷分布(即dirichlet分布)中取样生成文档的主题的多项式分布θ;

[0157]

③

从主题的多项式分布θ中取样生成文档第j个词的主题z;

[0158]

④

根据先验知识β从狄利克雷分布(即dirichlet分布)中取样生成主题z对应的词语的多项式分布φ。

[0159]

⑤

从词语的多项式分布φ中采样最终生成词语w。

[0160]

步骤2.1:利用生成的文档推断其隐藏的主题(分布)的过程即lda模型文档生成的逆过程,只有文档d中单词w是被观察到的,主题z是隐藏的,根据大量已知的文档词项信息即文档d中单词w,计算得到每个文档上主题(topic)的后验分布,如式(3)所示:

[0161][0162]

其中,是主题分布,是的狄利克雷分布,是主题分布的先验分

布参数,构成文档m的主题数向量,是确定的主题,通过gibbs sampling方法求解出主题的后验分布

[0163]

步骤2.2:根据公式(3)得到段落p

qi

,p

kj

的主题的后验分布分别为zp

qi

=[zp

qi-1

,zp

qi-2

,...,zp

qi-v

]和zp

kj

=[zp

kj-1

,z

kj-2

,...,zp

kj-v

],

[0164]

计算得到查询文档段落集与候选文档段落集的主题概率分布交互矩阵t

qik

,查询文档段落集、候选文档段落集分别是指在查询文档q=(p

q1

,p

q2

,

…

,p

qi

…

,p

qn

)、任一候选文档dk=(p

k1

,p

k2

,

…

,p

kj

…

,p

km

)的所有段落组成的集合,其中,n和m分别为查询文档q和候选文档dk的总段落数;如式(4)所示:

[0165][0166]

其中,v为主题个数超参数,每个元素用t

qik

表示。

[0167]

步骤3的具体实现过程如下:

[0168]

步骤3.1:采用正则表达式的方式从文书中抽取法律要素,法律要素包括罪名ccg、犯罪行为co、人物类型ct、犯罪后果cc、补偿行为cb、和解情况r;本发明主要关注法律案件中的罪名ccg、犯罪行为co、人物类型ct、犯罪后果cc、补偿行为cb、和解情况r这几个部分,这些部分都包含了对判决产生决定性影响的法律要素。其中人物类型及补偿行为对所有法律案件类型都适用,犯罪行为因罪名的不同而各异。法律判决文书虽属于非结构化的文本类信息,但判决文书的构成及书写顺序往往要依据一定的书写规范。进而对每一个案件中所包含的法律要素进行同义词扩展;

[0169]

步骤3.2:对于两个案件段落间的相似度进行计算,分两部分进行:

[0170]

罪名或补偿行为的相似度计算公式方式如式(5)所示:

[0171][0172]

其中,entityname1代表段落提取的罪名或补偿行为集合;

[0173]

犯罪行为co、人物类型ct、犯罪后果cc或和解情况r的相似度计算方式如式(6)所示:

[0174][0175]

其中,entityname2代表段落分别提取的犯罪行为co、人物类型ct、犯罪后果cc或和解情况r;

[0176]

基于所有法律要素的段落间相似度sim_e(e

qi

,e

kj

)计算方式如式(7)所示:

[0177]

[0178]

其中,μ1,μ2,μ3分别为权重参数,sim_e(e

qi

,e

kj

)是指基于法律要素的段落间相似度,e

qi

和e

kj

代表查询段落和候选段落的实体集合;这样,对于查询段落集和候选段落集,得到一个相似度矩阵le

qk

=[le

q1k

,le

q2k

,

…

,le

qik

…

,le

q1k

],le

qik

=sim_e(e

qi

,e

kj

)。

[0179]

步骤4的具体实现过程如下:

[0180]

将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,计算公式如式(8)所示:

[0181]eqki

=β

shqki

+β

t

t

qik

+β

l

le

qik

[0182]

=βs[gru(h

qk

(i-1),p’qki

)]+β

t

t

qik

+β

l

le

qik

ꢀꢀꢀ

(19)

[0183]

其中,βs,β

t

,β

l

分别为权重参数;

[0184]

对查询-候选对的聚合编码输出,添加注意力机制来进一步编码位置信息,注意力权重计算法方式如式(9)所示:

[0185][0186]

α

qki

、u

qk

分别是指注意力机制中的权重及参数;

[0187]

其中,u

qk

的计算方式如式(10)所示:

[0188]uqk

=wu·

maxpool(e

qk

)+buꢀꢀꢀ

(21)

[0189]

式(10)中,maxpool()是指对每行数据选取一行中最大的值,q为查询文档,k为某一候选文档,e

qk

为查询文档q与某候选文档k的聚合编码;wu∈r

hr

×

hr

,bu∈r

hr

;

[0190]

通过聚合公式式(11)得到文档级的相似性关系:

[0191][0192]

最后,所有d

qk

经过一个全连接层和一个softmax函数获得两个法律案件描述文档的相似性概率值;找到相似性概率值最大的值对应的文档即为要求取的类案。

[0193]

用softmax做多分类,它将多个神经元的输出,映射到(0,1)区间内,比如有10个候选,那么就有10个神经元输出,现在根据每个输入d

qk

,来预测输出概率,最终得到的一系列概率序列就可以知道哪个文档相似度最大,比如在一次的输出过程中输出结点的值是如下:

[0194]

[0.2,0.1,0.05,0.1,0.2,0.02,0.08,0.01,0.01,0.23]

[0195]

由此可知,第10篇候选文档个与查询文档q相似度最大,因为0.23是这次概率最大的。

[0196]

本发明在lecard法律案例检索数据集上进行了对比实验,结果证明了本发明提出方法的有效性,结果如表1所示,其中,p@5、p@10为准确率指标,map为平均准确率指标,ndcg@10、ndcg@20、ndcg@30为排名指标。

[0197]

表1

[0198][0199]

实施例3

[0200]

一种基于法律要素的类案检索系统,包括语义编码模块、主题分布编码模块、法律实体编码模块、编码聚合及相似度计算模块;

[0201]

语义编码模块,被配置为:先将长文本按案件描述顺序划分为短的段落,再通过基于bert的文本编码方法对查询段落和候选段落进行语义编码表示;

[0202]

主题分布编码模块,被配置为:基于lda模型文档生成的逆过程,分别获得查询文档段落集与每篇候选文档段落集的主题概率分布交互矩阵;

[0203]

法律实体编码模块,被配置为:从文书中抽取法律要素,并对每一个案件中所包含的法律要素进行同义词扩展,最终对两个案件段落间的相似度进行计算;

[0204]

编码聚合及相似度计算模块,被配置为:将语义编码、主题分布编码及法律实体编码三部分进行编码聚合并对查询-候选对进行相似度计算,选取相似度较大的前几个对应的候选文档作为类案。

[0205]

图1为本发明基于法律要素的类案检索系统的示意图,legal feature encoding代表法律特征编码,包含了基于bert的语义编码模块、基于lda的主题分布编码模块(topicalrelationship模块)和法律实体编码模块(legalentityrelationship模块)三部分。encoding aggregation对应编码聚合模块。attention为注意力机制的通用代表符号。

[0206]

实施例4

[0207]

一种计算机可读存储介质,其中存储有多条指令,所述指令适于由终端设备的处理器加载并执行所述的基于法律要素的类案检索方法。

[0208]

实施例5

[0209]

一种终端设备,包括处理器和计算机可读存储介质,处理器用于实现各指令;计算机可读存储介质用于存储多条指令,所述指令适于由处理器加载并执行所述的基于法律要素的类案检索方法。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1