基于图像色域分布自适应调整的文本行人重识别算法

1.本发明涉及一种基于图像色域分布自适应调整的文本行人重识别算法,属于计算机视觉技术领域。

背景技术:

2.行人重识别是视频监控领域的一项基本任务,其目的是在给定的查询条件下,在大规模的人物图像数据库中识别出相应的行人。

3.如今,随着上传到网络或存储在个人设备上的视频数量不断增加,能够在成千上万张图片中找到目标人物的系统的需求也越来越大。虽然通过基于属性的搜索方法可以用来在数据集中找到一个人,但这种方法需要那个人的示例图像。就可用性而言,如果可以使用更容易获得的文本查询,那将是更可取的,因此基于文本的行人重识别方法逐渐受到大家关注。

4.当前大多数行人重识别技术只能通过现有的几个行人数据集如cuhk-pedes、rstpreid等来训练模型,不能适应现实生活中千变万化的光照场景,例如有时艳阳高照,有时却阴云密布,从而导致模型对于不同数据的适应性较差。如果能够通过相应的方法对图像的色彩域的分布进行自适应的调整,不仅能够增加训练数据的多样性,同时还能够大大提高行人重识别模型对于不同数据的适应性。

技术实现要素:

5.本发明的目的是针对当前大多数行人重识别技术只能够通过现有几个行人数据集来训练模型,不能适应现实生活中千变万化的光照场景,从而导致模型对于不同数据的适应性较差的问题,提出一种基于图像色域分布调整的文本行人重识别方法,可增加训练数据的多样性,提高模型的对于不同数据的适应性。

6.本发明提供一种基于图像色域分布自适应调整的文本行人重识别算法,其特征在于,所述方法包括以下步骤:

7.步骤1、通过图像色域分布自适应调整模块对输入图像的色彩域进行调整,得到调整过后的图像;

8.步骤2、使用图-文预训练方法得到所述行人的文本特征向量e与视觉特征图f;

9.步骤3、将前述行人文本特征向量e与视觉特征图f通过监督学习的行人重识别方法进行处理,获取文本与视觉的全局与局部特征;

10.步骤4、将前述多模态特征通过信息投影模块得到彼此模态的信息,计算相似度,进行模型训练,计算损失,得到训练模型;

11.步骤5、利用所述训练模型结合目标行人的文本描述和待识别行人图像进行行人重识别,从而得到行人重识别结果;

12.进一步的,所述步骤1中的图像色域分布自适应调整模块包含3个主要参数,在一些优选的实施方式中,所述图像色域分布自适应调整模块(d2avm)主要对图像的光照、对比

度、色温3个参数进行自适应的调整,得到变化后的图像:

13.iv=d2avm(io)

14.其中io为原始图片,iv为经过图像色域分布调整模块处理过后的图片。

15.进一步的,所述步骤2中的图-文预训练方法包含1个视觉编码器,1个文本编码器,在一些优选的实施方式中,所述视觉编码器为所述视觉编码器为1个增加1个归一化层,同时在变形操作之前加入位置编码的vision transformer模型,继而得到视觉特征图f:

16.f=ie(iv)

17.其中ie为视觉编码器,本算法中采用改进的vision transformer模型。

18.在一些优选的实施方式中,所述文本编码器为1个包含有多头注意力机制的bert模型与1个双向lstm模块,继而得到文本特征向量e:

19.e=te(s)

20.其中,te为文本编码器,本算法中采用改进的bert模型与双向lstm模块,s为未处理的文本描述。

21.进一步的,所述步骤3中的行人重识别方法包括1个全局特征提取网络和1个局部特征提取网络用来提取提取全局与局部特征,获取特征的方法具体为:

22.步骤3.1、首先通过全局特征提取网络提取两模态的全局特征,对前述文本特征向量e进行池化(rmp)与卷积(wg)操作,得到文本全局特征为:

23.tg=wgrmp(e)

24.对前述视觉特征图f进行池化(gmp)与卷积(wg)操作,得到视觉全局特征为:

25.vg=wggmp(f)

26.步骤3.2、下一步通过局部特征提取网络提取两模态的局部特征,在文本模态,将前述文本特征向量e,首先通过词注意力模块进行处理,得到第i个单词属于第k个部分的概率为:

[0027][0028]

其中pi包含上下文线索,可以用来推断第i个单词对应的部分,αi表示表示该单词在句中所占权重;

[0029]

第k个部分的文本特征向量ek为:

[0030][0031]

步骤3.3、对第k个部分的文本特征向量ek进行池化与卷积(wi)操作,得到文本模态局部特征为:

[0032][0033][0034]

其中ei为通过行最大池化层获得到第k部分文本特征向量,αi为第i个文本局部特征向量权重;

[0035]

步骤3.4、对前述视觉特征图f水平分割为k份(不重叠),可得第k个部分的视觉特

征向量fk;

[0036]

步骤3.5、对前述fk进行池化与卷积(wi)操作,得到视觉模态不局部特征为:

[0037][0038][0039]

其中,fi是通过全局最大池化层处理得到的第i个部分的视觉特征块,βi为第i个视觉局部特征向量权重。

[0040]

进一步的,步骤4中所述得的信息投影模块(iprojm)将两种模态的信息互相通过投影方式传递到对方模态,目的是能够更好的将两种模态的信息匹配

[0041]fp

=iprojm(fo,f

t

)

[0042]

其中,fo为源模态下的特征信息,f

t

为目标模态下的特征信息,f

p

为源模态在目标模态下的特征信息,4种特征信息投影到对应模态表示为:

[0043][0044][0045][0046][0047]

其中,为视觉全局特征投影在文本模态所得到新的特征信息,为文本全局特征投影在视觉模态所得到新的特征信息,为视觉局部特征投影在文本模态所得到新的特征信息,为文本局部特征投影在视觉模态所得到新的特征信息;将两种粒度特征融合得到:

[0048][0049][0050]

进一步的,所述的步骤4中的相似度计算均采用欧氏距离来计算,两模态全局特征的相似性为:

[0051][0052]

两模态局部特征的相似性为:

[0053][0054]

两模态信息共享后的相似性为:

[0055][0056]

其中,e(.,.)表示两个向量间的欧氏距离;

[0057]

最终,两模态的相似性为:

[0058]

sim=s

p

+λ1sg+λ2sg[0059]

其中,λ1与λ2为超参,可根据实验进行相应调整。

[0060]

进一步的,所述的步骤4中损失计算采用混合三元组损失函数与归一化指数函数同时进行训练,所述混合三元组损失函数为:

[0061][0062]

其中,或表示未匹配成功的图像文本对,s(.,.)为两个向量的余弦相似度,利用边界α来约束成功匹配的图像文本对,使其比未匹配成功的图像文本对更加接近;

[0063]

所述归一化指数函数为:

[0064][0065]

其中,n表示数据集中行人的id总数,xi表示行人i的id真值,表示行人i的非id真值。

[0066]

与现有技术相比,本发明有益效果:使用图像色域分布自适应调整某块提高训练数据的多样性,增强了模型对于不同数据的适应性。然后将得到的文本特征向量和视觉特征图输入到模型主网络中,与以往行人重识别任务不同,本发明在进入主干网络提取特征进行训练之前,采用了预训练的方法来获得文本特征向量和视觉特征图,充分挖掘了图文中所包含的信息,从而提高了网络的特征的表示能力和判断能力,提高行人重识别准确率。

[0067]

本发明的其它特征和优点将在随后具体实施方式部分予以详细说明。

附图说明

[0068]

通过结合附图对本发明示例性实施方式进行更详细的描述,本发明的上述以及其它目的、特征和优势将变得更加明显,其中,在本发明示例性实施方式中,相同的参考标号通常代表相同部件。

[0069]

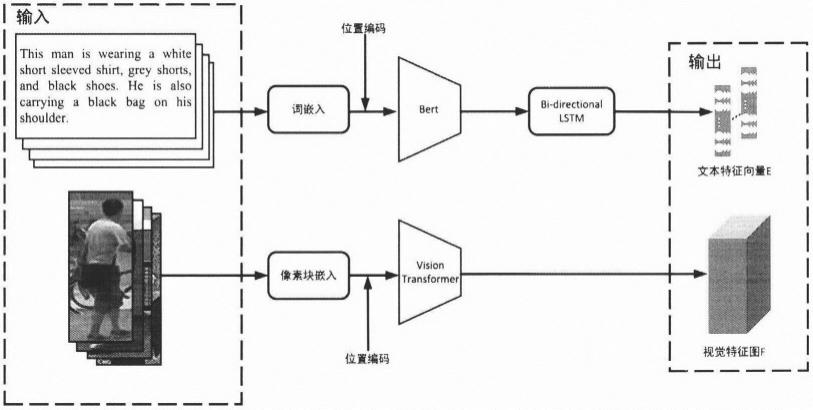

图1是基于文本的行人重识别算法的流程图。

[0070]

图2是图像色域分布自适应调整模块示意图。

[0071]

图3是多模态transformer与训练方法。

[0072]

图4是基于监督机制的全局特征提取网络图。

[0073]

图5是基于监督机制的局部特征提取网络图。

具体实施方式

[0074]

下面将参照附图更详细地描述本发明的优选实施方式。虽然附图中显示了本发明的优选实施方式,然而应该理解,可以以各种形式实现本发明而不应被这里阐述的实施方式所限制。

[0075]

如图1所示,本发明提供一种基于图像色域分布自适应调整的文本行人重识别算法,该方法包括以下步骤:

[0076]

步骤一、选取数据集,读取行人重识别数据集中的图片以及文本描述,本发明以cuhk-pedes和restpreid数据集为例;

[0077]

步骤二、将数据集中的图片通过图像色域分布自适应调整模块(d2avm)处理得到变化后的图像:

[0078]iv

=d2avm(io)

[0079]

其中io为原始图片,iv为经过图像色域分布调整模块处理过后的图片。

[0080]

步骤三、如图3所示,将经过色域分布自适应调整模块处理过后的的图片和未处理的文本描述输入到图-文预训练模型中进行预训练,得到文本特征向量e与视觉特征图f:

[0081]

e=te(s)

[0082]

f=ie(iv)

[0083]

其中,te为文本编码器,本算法中采用改进的bert模型与双向lstm模块,其中ie为视觉编码器,本算法中采用改进的vision transformer模型,s为未处理的文本描述,

[0084]

步骤四、将获取到的文本特征向量e和视觉特征图f送入多粒度多模态的特征提取网络进行处理,主要作用是提取两模态的全局特征和局部特征,所示具体方法包括以下步骤:

[0085]

步骤4.1、如图4所示,首先提取文本模态与视觉模态的全局特征,对前述文本特征向量e进行池化(rmp)与卷积(wg)操作,得到一个1024维文本全局特征:

[0086]

tg=wgrmp(e)

[0087]

对前述视觉特征图f进行池化(gmp)与卷积(wg)操作,得到一个1024维视觉全局特征:

[0088]

vg=wggmp(f)

[0089]

步骤4.2、下一步,如图5所示,提取文本模态与视觉模态的局部特征。对文本模态而言,首先通过词注意力模块进行处理,得到第i个单词属于第k个部分的概率为:

[0090][0091]

其中pi包含上下文线索,可以用来推断第i个单词对应的部分,αi表示表示该单词在句中所占权重;

[0092]

第k个部分的文本特征向量ek为:

[0093][0094]

步骤4.3、然后对第k个部分的文本特征向量ek进行池化与卷积(wi)操作,得到一个1024维的文本模态局部特征向量:

[0095][0096][0097]

其中ei为通过行最大池化层获得到第k部分文本特征向量,αi为第i个文本局部特征向量权重;

[0098]

步骤4.4、对视觉模态而言,首先对前述视觉特征图f水平分割为k份(不重叠),可得第k个部分的视觉特征向量fk,然后进行池化与卷积(wi)操作,得到一个1024维视觉模态局部特征向量:

[0099][0100]

[0101]

其中,fi是通过全局最大池化层处理得到的第i个部分的视觉特征块,βi为第i个视觉局部特征向量权重。

[0102]

步骤五、对得到的全局与局部特征通过信息投影模块,实现两种模态间的信息互通,目的是能够更好的将两种模态的信息匹配

[0103]fp

=iprojm(fo,f

t

)

[0104]

其中,fo为源模态下的特征信息,f

t

为目标模态下的特征信息,f

p

为源模态在目标模态下的特征信息,4种特征信息投影到对应模态表示为:

[0105][0106][0107][0108][0109]

其中,为视觉全局特征投影在文本模态所得到新的特征信息,为文本全局特征投影在视觉模态所得到新的特征信息,为视觉局部特征投影在文本模态所得到新的特征信息,为文本局部特征投影在视觉模态所得到新的特征信息;将两种粒度特征融合得到:

[0110][0111][0112]

步骤六、对得到的全局与局部特征均采用欧氏距离来计算文本与视觉两模态间的相似性,两模态全局特征的相似性为:

[0113][0114]

两模态局部特征的相似性为:

[0115][0116]

两模态信息共享后的相似性为:

[0117][0118]

其中,e(.,.)表示两个向量间的欧氏距离;

[0119]

最终,两模态的相似性为:

[0120]

sim=s

p

+λ1sg+λ2sg[0121]

其中,λ1与λ2为超参,可根据实验进行相应调整。

[0122]

步骤七、文本与视觉的全局与局部特征采用混合三元组损失函数与归一化指数函数同时进行训练,所述混合三元组损失函数为:

[0123][0124]

其中,或表示未匹配成功的图像文本对,s(.,.)为两个向量的余弦相似度,利用边界α来约束成功匹配的图像文本对,使其比未匹配成功的图像文本对更加接近;

[0125]

所述归一化指数函数为:

[0126][0127]

其中,n表示数据集中行人的id总数,xi表示行人i的id真值,表示行人i的非id真值。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1