基于离散MADDPG的边缘缓存决策模型、方法和系统

基于离散maddpg的边缘缓存决策模型、方法和系统

技术领域

1.本发明涉及协作边缘缓存领域,尤其涉及一种基于离散maddpg的边缘缓存决策模型、方法和系统。

背景技术:

2.随着5g技术的逐步成熟,用户可以使用移动设备体验vr(虚拟现实)、超高清实时直播等应用,但这些应用会带来数据量的激增,而体验用户却需要低延迟的服务质量,传统的云服务方式因为用户距离云服务器较远导致延迟较高,从而无法满足用户对vr等应用的高质量体验。

3.针对传统云服务方式的不足,边缘缓存技术逐渐成为一种可行的方案。边缘缓存技术是将部分云端数据下放到离用户更近的边缘端,从而使用户可以得到更低延迟的请求响应。边缘缓存技术可分为单节点边缘缓存和协作边缘缓存,因为单节点边缘缓存存储的内容有限,所以协作边缘缓存技术是目前主流的技术。

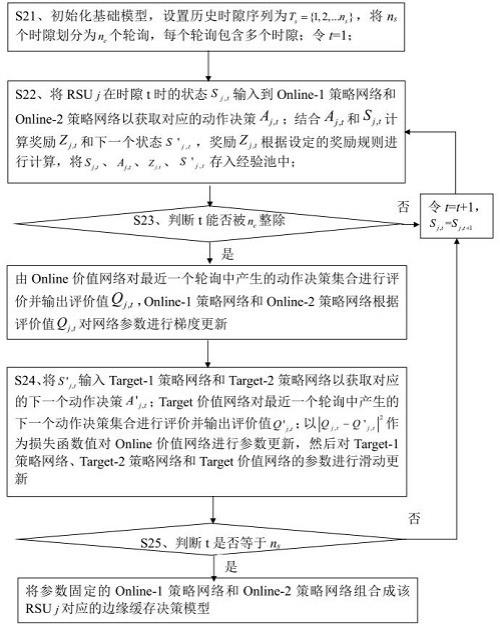

4.然而目前大部分的协作边缘缓存方案仅考虑内容传输时的协作,而不考虑缓存决策时的协作,即在缓存决策时仅依据单个节点的缓存状态,而不考虑其他节点的缓存状态。这种形式的协作缓存可能导致通信网络中rsu(路边单元)存储的内容冗余过高,从而降低缓存空间的利用率。

技术实现要素:

5.为了解决上述现有技术中的协作缓存方案缓存空间利用率低的缺陷,本发明提出了一种基于离散maddpg的边缘缓存决策模型,大大提高了通信网络的缓存命中率,提高了缓存空间利用效率。

6.本发明提出的一种基于离散maddpg(多智能体深度确定性策略梯度)的边缘缓存决策模型,适用于用户终端、云服务器和多个rsu组成的通信网络,所述边缘缓存决策模型为离散maddpg架构内的神经网络,其与rsu一一对应,所述边缘缓存决策模型用于根据rsu的状态生成对应的动作决策;rsuj表示通信网络中第j个rsu,令rsuj在时隙t的状态记作s

j,t

,令rsuj在时隙t时决定缓存下来的内容集合记作,rsuj在时隙t时选择从缓存空间中移出的内容集合记作,rsuj在时隙t时的动作决策记作;;其中,f

j,t

为rsuj在时隙t时的内容存储状态、r

j,t

为rsuj在时隙t内处理的内容请求集合,内容请求集合指的是请求指向的内容的集合;为rsuj在时隙t时已缓存的内容的流行度集合、为rsuj在时隙t时未命中的内容的流行度集合;rsuj在时隙t时被请求且已经存储在缓存空间中的内容称为命中的内容;rsuj在时隙t时被请求且未存储的内容称为未命中的内容;为rsuj在时隙t时已缓存的内容的大小、为rsuj在时隙t时未

命中的内容的大小;内容的流行度为内容被请求的概率;命中的内容的大小;内容的流行度为内容被请求的概率;为二进制数,;rsu和云服务器存储的所有内容集合为i,i={内容1,内容2,

…

,内容i,

…

,内容i

max

},i

max

为内容集合i中的内容总数量,内容集合中任意两个内容相异,i为序数,1≤i≤i

max

;;表示rsuj在时隙t内处理的第k j

个请求指向的内容,表示rsuj在时隙t内处理的请求的总数量;rsuj在时隙t内处理的任一个请求指向的内容均属于内容集合i,记作;设rsuj在时隙t时缓存的内容集合为,将中的第n个内容记作内容;rsuj在时隙t时未命中的内容集合为,将中的第m个内容记作内容,内容i的流行度记作pi,内容i的大小记作ci;优选的,内容i的流行度记作pi,其计算公式如下:其中,ui表示内容i在内容集合i的所有内容中请求频次由高到低的排名,θ为偏斜因子,且θ为经验值。

7.优选的,通过以下步骤训练获得:s1、基于神经网络构建基础模型,基础模型包括online-1策略网络、online-2策略网络、online价值网络、target-1策略网络、target-2策略网络和target价值网络;设置经验池用于存储经验样本;rsuj在时隙t时的状态记作s

j,t

,online-1策略网络根据状态s

j,t

生成rsuj决定缓存的内容集合,online-2策略网络根据s

j,t

生成rsuj将要移出缓存空间的内容集合;令,a

j,t

表示rsuj在时隙t时的动作决策;online价值网络用于对一个轮询中所有时隙产生的动作决策集合{a

j,t

}进行评价;所述轮询包含多个时隙;将rsuj执行动作决策后的状态记作下一个状态s’j,t

,target-1策略网络根据下一个状态s’j,t

生成rsuj决定缓存的内容集合,target-2策略网络根据下一个状态

s’j,t

生成rsuj将要移出缓存空间的内容集合,a’j,t

表示下一个动作决策,;target价值网络用于对一个轮询中所有时隙产生的下一个动作决策集合{a’j,t

}进行评价;从历史数据中获取训练样本集合,ts表示训练样本集合对应的采样时隙维度,记作历史时隙序列,ts包含ns个时隙;q表示通信网络中rsu的数量;s2、基于基础模型和经验池训练基础模型的参数,获取与各rsu对应的边缘缓存决策模型,训练rsuj对应的边缘缓存决策模型包括以下步骤:s21、初始化基础模型,将ns个时隙划分为ne个等长的轮询,每个轮询包含多个时隙;令t=1;s22、将rsuj在时隙t时的状态s

j,t

输入到online-1策略网络和online-2策略网络以获取对应的动作决策a

j,t

;结合a

j,t

和s

j,t

计算奖励z

j,t

和下一个状态s’j,t

,奖励z

j,t

根据设定的奖励规则进行计算,将s

j,t

、a

j,t

、z

j,t

、s’j,t

存入经验池中;;s

j,t

和s’j,t

满足以下约束条件:其中,ci表示内容i的大小,c表示rsuj的缓存空间大小,t

j,t

表示rsuj在时隙t时存储的所有内容的传输时间,表示时隙t内在rsuj中命中的所有内容的总传输时间,表示在rsuj附近的rsu中命中的所有内容的传输时间,在rsuj附近的rsu指的是通信覆盖范围与rsuj通信覆盖范围邻接的rsu,表示未在边缘端命中而由云服务器传输的所有内容的传输时间;其中,其中,d

j,t

表示rsuj在时隙t上传输的内容集合,d为内容集合d

j,t

中的任一个内容,cd表示内容d的大小,v

j,t

表示rsu与用户终端之间的无线传输速度,vo表示rsu之间的传输速率,vr表示rsu与云服务器之间的传输速率;为二进制数,xo、xr为二元变量;

其中,

ᴪ

表示序数;s23、判断t能否被ne整除,不能,则令t=t+1,s

j,t

=s

j,t+1

并返回步骤s22;能,则由online价值网络对最近一个轮询中产生的动作决策集合进行评价并输出评价值q

j,t

,online-1策略网络和online-2策略网络根据评价值q

j,t

对网络参数进行梯度更新,然后执行以下步骤s24;s24、将s’j,t

输入target-1策略网络和target-2策略网络以获取对应的下一个动作决策a’j,t

;target价值网络对最近一个轮询中产生的下一个动作决策集合进行评价并输出评价值q’j,t

;以| q

j,t

‑ꢀ

q’j,t

|2作为损失函数值对online价值网络参数进行梯度更新,然后对target-1策略网络、target-2策略网络和target价值网络的参数进行滑动更新;s25、判断t是否等于ns;否,则令t=t+1,s

j,t

=s

j,t+1

并返回步骤s22;是,则将参数固定的online-1策略网络和online-2策略网络组合成该rsuj对应的边缘缓存决策模型。

8.优选的,步骤s22中设定的奖励规则为:优选的,步骤s22中设定的奖励规则为:均恒等于1,a1、a2均指代内容;表示rsuj在时隙t时决定缓存下来的内容集合,表示rsuj在时隙t时选择从缓存空间中移出的内容集合,表示rsuj在时隙t+1内处理的内容请求集合。

9.优选的,步骤s22中设定的奖励规则为:其中,表示时隙t上内容a的冗余度,表示函数,表示时隙t上内容a1的冗余度,表示时隙t上内容a2的冗余度;λ

in

、λ

out

为设定常数,分别表示正奖励因子和负奖励因子;均恒等于1;表示rsuj在时隙t时决定缓存下来的内容集合,表示rsuj在时隙t时选择从缓存空间中移出的内容集合,r

j,t+1

表示rsuj在时隙t+1

内处理的内容请求集合;内容i在时隙t上的冗余度的计算公式为:;q表示rsu总数量。

10.优选的,s1中online-1策略网络和online-2策略网络输出的集合和集合满足以下约束:;其中,a3、a4均指代内容,c

a3

表示内容a3的大小,c

a4

表示内容a4的大小;target-1策略网络和target-2策略网络输出的集合和集合满足以下约束:;其中,a5、a6均指代内容,c

a5

表示内容a5的大小,c

a6

表示内容a6的大小。

11.优选的,基础模型采用马尔科夫博弈模型表示。

12.本发明还提出了一种基于离散maddpg的边缘缓存决策方法,采用上述边缘缓存决策模型实现协作边缘缓存。

13.本发明提出的一种基于离散maddpg的边缘缓存决策方法,包括以下步骤:sa1、获取边缘缓存决策模型和当前时隙各rsu的状态,所述边缘缓存决策模型采用所述的基于离散maddpg的边缘缓存决策模型,rsuj在当前时隙的状态记作s

j,t

,,t表示当前时隙,f

j,t

为rsuj在当前时隙的内容存储状态、r

j,t

为rsuj在当前时隙内处理的内容请求集合、为rsuj在当前时隙已缓存的内容的流行度集合、为rsuj在当前时隙未命中的内容的流行度集合;为rsuj在当前时隙已缓存的内容的大小、为rsuj在当前时隙未命中的内容的大小;sa2、将各rsu的当前状态输入对应的边缘缓存决策模型,获取各rsu的动作决策,rsuj在当前时隙的动作决策记作a

j,t

,表示rsuj在当前时隙决定缓存下来的内容集合,表示rsuj在当前时隙选择从缓存空间中移出的内容集合;sa3、控制各rsu执行对应的动作决策。

14.本发明还提出了一种基于离散maddpg的边缘缓存决策系统,为上述基于离散maddpg的边缘缓存决策方法提供载体。

15.本发明提出的一种基于离散maddpg的边缘缓存决策系统,包括存储模块,存储模块中存储有计算机程序和所述的基于离散maddpg的边缘缓存决策模型,所述计算机程序被执行时用于实现所述的基于离散maddpg的边缘缓存决策方法。

16.优选的,还包括处理器,处理器与存储模块连接,处理器用于执行所述计算机程序以实现所述的基于离散maddpg的边缘缓存决策方法。

17.本发明的优点在于:(1)本发明中的边缘缓存决策模型将离散maddpg算法引入协作边缘缓存,能够实现智能体(即rsu)间的合作通信且有强大的决策能力,可以很好地实现缓存决策且控制缓存冗余。本发明中的边缘缓存决策模型的输入数据为系统中rsu的状态,其输出为对应的rsu的动作决策。本发明中定义的rsu的状态包括内容存储、迁入迁出内容的流行度、迁入迁出内容的大小等。如此,本发明可保证系统缓存命中率能够随缓存空间增大而保持较为稳定的增长;缓存命中率为整个通信网络中所有智能体在设定数量的时隙内缓存命中数与处理请求数的比值。

18.(2)本发明中采用离散maddpg算法获取边缘缓存决策模型,maddpg算法强大的决策能力能够很好地应对协作缓存的不稳定性,做出最优的缓存决策,从而提高通信网络的缓存命中率,使通信网络处理更多的内容请求。本发明能够在一个时隙内决策缓存多个内容且移除缓存空间中的多个内容,而现有的大部分协作缓存模型在一个时隙仅仅决定一个未命中的内容是否缓存,可见采用本发明的边缘缓存决策模型有着更高缓存效率。另外,为了使智能体能够同时做出缓存内容和移除内容的决策,本发明将maddpg传统架构的单actor网络改进为双actor网络,让一个actor网络输出需缓存的内容,另一个actor网络输出需移出缓存空间的内容。

19.(3)本发明在训练边缘缓存决策模型的过程中,可以通过通信网络的全局状态来训练网络的参数,从而可以很好地解决多智能体训练时环境不稳定的问题,得到最优的缓存策略参数。另外因为智能体能够掌握全局的状态,从而能够了解通信网络的内容冗余情况并通过改进的奖励来控制冗余。该算法在执行时只需智能体的局部状态而无需通信网络的全局状态,那么在实际应用时能够有较快的执行效率。本发明充分考虑了迁入迁出内容对缓存空间的影响,通过设置约束,保证了rsu动作过程中缓存空间的正常工作。

20.(4)本发明中通过奖励的设置,进一步提高了边缘缓存决策模型训练过程中的强化学习能力,有利于提高模型性能。本发明中,给出了两种奖励规则,但具体实施时,奖励也可根据现有的任意方法进行计算。

21.(5)本发明还提出了一种基于离散maddpg的边缘缓存决策方法,采用上述边缘缓存决策模型控制通信网络中各rsu的存储动作,如此不仅在内容传输时进行协作,而且在缓存决策时也能够进行协作,从而在缓存决策时也能够了解通信网络的冗余情况,进而进行缓存冗余控制。

22.(6)本发明还提出了一种基于离散maddpg的边缘缓存决策系统,为上述基于离散maddpg的边缘缓存决策方法的实施提供了载体。

附图说明

23.图1为系统中基于离散maddpg的边缘缓存决策模型的获取方法;图2为基于离散maddpg的边缘缓存决策模型具体的获取方法流程图;图3为一种基于离散maddpg的边缘缓存决策方法流程图;图4为实施例中基于离散maddpg的边缘缓存决策模型的收敛对比图;

图5为zipf参数θ=0.7时各算法缓存命中率对比图;图6为zipf参数θ=0.9时各算法缓存命中率对比图;图7为zipf参数θ=1.1时各算法缓存命中率对比图;图8为zipf参数θ=0.7时各算法请求处理数对比图;图9为zipf参数θ=0.9时各算法请求处理数对比图;图10为zipf参数θ=1.1时各算法请求处理数对比图;图11为内容冗余度分布图。

具体实施方式

24.实施例本实施例结合一个具体的通信网络对本发明提供的基于离散maddpg的边缘缓存决策系统的效果进行验证,本实施例中设置相关参数如下表1所示:表1:实施例参数设置本实施例中定义一个轮询等于100个时隙,即ne=100ns。本实施例中以轮询为横坐标以每一个轮询内所有rsu的奖励均值z

avg

为纵坐标绘制波形以估算本发明中边缘缓存决策模型的收敛性;;z

j,t

为rsuj在时隙t上的奖励。

25.本实施例中,采用本发明提供的边缘缓存决策模型获得各rsu的动作决策,具体如图2所示。该边缘缓存决策模型的学习过程如图1、图3所示。具体的,本实施例中采用如图3所示方法训练边缘缓存决策模型时,步骤s24中对target-1策略网络、target-2策略网络和target价值网络的参数进行滑动更新时采用的滑动更新因子如表1所示,即τ=0.01。参照图4,本实施例经过仿真可知,该边缘缓存决策模型在不同zipf(齐普夫定律)分布下的收敛性不同,具体的:当θ=0.7时,所述模型大概在第30个轮询处收敛;当θ=0.9时,所述模型大概在

第50个轮询处收敛;当θ=1.1时,所述模型大概在第30个轮询处收敛。显然,收敛后的奖励值随θ值增大而增大,这是因为当zipf分布的θ越大时,内容请求越集中、更规律,从而在智能体即rsu做出正确的缓存决策后,有更多的内容请求在下一个时隙命中,由此奖励值会更高。

26.为了进一步验证本发明的技术效果,以下结合3个对比例对本发明提供的边缘缓存决策模型进行说明。

27.表2:对比例统计表系统缓存命中率分析图5-7展示了表2中4种算法在在采用不同偏斜因子θ的zipf(齐普夫定律)分布下的系统缓存命中率随智能体(即rsu)缓存空间变化而变化的情况。图5-7中的横坐标表示智能体(即rsu)缓存空间的大小,纵坐标表示缓存命中率,缓存命中率为整个通信网络中所有智能体在100个时隙内缓存命中数与处理请求数的比值。

28.结合图5-7可知,在θ取任意值时,采用表2中任一算法的系统的缓存命中率均随着智能体缓存空间的增加而升高;且本发明实施例对应的系统的缓存命中率始终是最高的,即本实施例采用离散maddpg算法构建的边缘缓存决策模型能够使系统处理更多的内容请求。

29.从图7可以看出,θ为1.1且智能体的缓存空间为400m时,本发明实施例的缓存命中率达到75%,相比ddpg算法即对比例3,其缓存命中率提升了7.1%,相比传统的lru算法即对比例2,缓存命中率提升了15.4%,这是因为离散maddpg算法强大的决策能力能够很好地应对协作缓存的不稳定性,做出最优的缓存决策,从而提高系统的缓存命中率。

30.通过图5-7也可以看出随着θ的增加,本发明实施例与3个对比例的缓存命中率都随之增加,但是当θ为1.1且智能体缓存空间增加到300m时,对比例1和对比例2的缓存命中率难以随着缓存空间增大而显著增大,这是因为智能体缓存空间已经能够缓存大部分内容流行度高的内容,当缓存空间继续增大的话,智能体会缓存请求频次低的内容,从而导致缓存命中率增长不显著。而本发明实施例和对比例3除内容流行度外,还综合考虑了缓存状态、请求内容大小等,因此缓存命中率能够随缓存空间增大而保持较为稳定的增长。而本实施例采用离散maddpg算法训练的边缘缓冲决策模型相对于对比例3中ddpg算法进一步考虑到了智能体之间的互动,因此本实施例中的系统在对比例3的基础上进一步显著提高了缓

存命中率。

31.系统请求处理能力分析图8-10展示了4种算法在采用不同偏斜因子θ的zipf(齐普夫定律)分布下的系统处理的请求数随智能体缓存空间变化而变化的情况。图中的横坐标为智能体缓存空间的大小,纵坐标表示通信网络中所有智能体在一个轮询上处理的内容请求数之和。

32.通过图8-10可以看出随着参数θ和智能体缓存空间的变化,本发明实施例提出的系统始终比另外3个对比例有着更高的请求处理能力。另外,通过图10可以看出当zipf分布的θ为1.1且智能体的缓存空间为400m时,本发明实施例中系统处理的请求数达到了4780,相比采用ddpg算法的对比例3提升了3.6%,相比传统的采用lru算法的对比例2和采用fifo算法的对比例1分别提升了6%和7%。显然,基于学习的算法相比传统算法有着更高的处理请求的能力,这是因为基于学习的算法能够在内容数量较大且状态不确定时通过训练和奖励反馈机制不断寻找最优的缓存策略,让更多的请求在本地得到满足。而基于离散maddpg算法的本发明实施例比基于ddpg的对比例3性能更优则是因为离散maddpg能同时考虑智能体状态和其他智能体动作对环境的影响,从而能够基于整个通信网络的状态做出更优的缓存决策,进一步提升系统处理请求的能力。

33.缓存冗余度分析图11展示了本发明实施例和3个对比例在zipf参数θ为0.7且智能体缓存空间为400m时的内容冗余分布情况,其中纵坐标为每个内容在100个时隙上的平均冗余度,内容i的平均冗余度计算为:容i的平均冗余度计算为:表示时隙t时内容i的冗余度。

34.从图11可以看出基于lru算法的对比例2和基于ddpg算法的对比例3有较多的离群点,这是因为lru算法的机制会使智能体缓存内容流行度较高的内容,那么大部分内容流行度较低的内容较少有机会被缓存,从而导致内容冗余度较分散。而ddpg算法可能在训练时更多的考虑了内容流行度的特征而导致内容冗余度分散。基于fifo算法的对比例1的内容冗余度比对比例2-3更集中,但是相比基于离散maddpg算法的本发明实施例还是更为分散。另外,基于fifo算法的对比例1的内容冗余度集中分布在0.12左右,而基于离散maddpg算法的本发明实施例的内容冗余度集中分布在0.2左右,这表明本发明实施例中大部分内容在每个时隙至少会被其中一个智能体所缓存。另外从图中maddpg算法的离群点可以看出离散maddpg算法也能够抑制产生较大的内容冗余度,可见离散maddpg算法在训练时能够了解其他智能体的缓存状态,且利用奖励的反馈机制来辅助训练,从而能够达到控制冗余的效果。

35.以上仅为本发明创造的较佳实施例而已,并不用以限制本发明创造,凡在本发明创造的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明创造的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1