用于手术导航的障碍物回避技术的制作方法

用于手术导航的障碍物回避技术

1.相关申请的交叉引用

2.本技术要求于2019年7月3日提交的美国临时专利申请号62/870,284的优先权和所有权益,所述专利申请的内容特此以引用方式整体并入。

技术领域

3.本公开总体上涉及手术导航系统。

背景技术:

4.手术导航系统有助于相对于患者组织的目标体积定位手术器械以进行治疗。在手术程序期间,要治疗的目标体积经常位于应该回避的敏感的解剖结构和手术工具附近。由于结构的柔性性质,使用附接的追踪器追踪这些相邻的解剖结构通常很困难。此外,将追踪器附接到与目标体积相邻的每个对象使手术工作空间拥挤并且增加手术导航系统的成本和复杂性。

技术实现要素:

5.在第一方面,提供了一种导航系统,所述导航系统包括:定位器,所述定位器被配置为检测第一对象;视觉装置,所述视觉装置被配置为生成所述第一对象附近的表面的实际深度图;以及控制器,所述控制器耦接到所述定位器和所述视觉装置,所述控制器被配置为:访问与所述第一对象相对应的虚拟模型;标识所述定位器与所述视觉装置之间在公共坐标系中的位置关系;基于所述第一对象的所检测到的位置、所述虚拟模型以及所述位置关系生成所述视觉装置的预期深度图;标识所述实际深度图的未能与所述预期深度图匹配的部分;并且基于所标识部分识别第二对象。

6.在第二方面,机器人操纵器与第一方面的导航系统一起利用,其中所述机器人操纵器支撑手术工具并且包括多个连杆和多个致动器,所述多个致动器被配置为使所述连杆移动以移动所述手术工具,并且其中所述机器人操纵器被控制以回避所述第二对象。

7.在第三方面,提供了一种操作导航系统的方法,所述导航系统包括:定位器,所述定位器被配置为检测第一对象的位置;视觉装置,所述视觉装置被配置为生成所述第一对象附近的表面的实际深度图;以及控制器,所述控制器耦接到所述定位器和所述视觉装置,所述方法包括:访问与所述第一对象相对应的虚拟模型;标识所述定位器与所述视觉装置之间在公共坐标系中的位置关系;基于所述第一对象的所检测到的位置、所述虚拟模型以及所述位置关系生成所述视觉装置的预期深度图;标识所述实际深度图的未能与所述预期深度图匹配的部分;并且基于所标识部分识别第二对象。

8.在第四方面,提供了一种计算机程序产品,其包括非暂时性计算机可读介质,所述非暂时性计算机可读介质具有存储在其上的指令,所述指令在由一个或多个处理器执行时被配置为实施第三方面的方法。

9.根据上述方面中的任一个的一个实现方式:所述定位器被配置为是:被配置为检

测与所述第一对象相关联的光学特征的光学定位器;被配置为检测与所述第一对象相关联的电磁特征的电磁定位器;被配置为在有或没有任何追踪器的情况下检测所述第一对象的超声定位器;被配置为检测与所述第一对象相关联的惯性特征的惯性定位器;或前面提及的任何组合。

10.根据上述方面中的任一个的一个实现方式:所述第一对象可以是以下中的任一者:患者的解剖结构或骨骼;手术室中的装备,诸如但不限于:机器人操纵器、手持器械、附接到所述机器人操纵器的末端执行器或工具、手术台、移动推车、可将患者放置在其上的手术台、成像系统、牵开器,或前面提及的任何组合。

11.根据上述方面中的任一个的一个实现方式:所述视觉装置耦接到以下中的任一者:所述定位器;与所述定位器分开的单元;所述导航系统的相机单元;可调节臂;所述机器人操纵器;末端执行器;手持工具;手术吊臂系统,诸如安装在天花板的吊臂、肢体固定装置,或前面提及的任何组合。

12.根据上述方面中的任一个的一个实现方式,所述第一对象附近的表面可以是:与所述第一对象相邻的表面;与所述第一对象间隔开一定距离的表面;接触所述第一对象的表面;直接在所述第一对象的顶部的表面;位于所述第一对象附近的环境中的表面;位于所述第一对象后面或周围的环境中的表面;在所述第一对象的阈值距离内的表面;在所述定位器的视场内的表面;或前面提及的任何组合。

13.根据上述方面中的任一个的一个实现方式:所述第二对象可以是可形成障碍物的对象,其包括以下中的任一者:所述患者的所述解剖结构的第二部分,诸如周围的软组织;所述手术室中的装备,诸如但不限于:机器人操纵器、所述机器人操纵器的一个或多个臂、第二机器人操纵器、手持器械、附接到所述机器人操纵器或手持器械的末端执行器或工具、手术台、移动推车、可将所述患者放置在其上的手术台、成像系统、牵开器、追踪装置的主体;正在所述手术室中的人的身体部位,或前面提及的任何组合。

14.根据上述方面中的任一个的一个实现方式:所述控制器可以是一个或多个控制器或控制系统。根据一个实现方式,所述控制器被配置为标识所述第二对象相对于所述第一对象在所述公共坐标系中的位置。根据一个实现方式,所述控制器基于所述第一对象的所检测到的位置、所述第二对象在所述实际深度图中的定位以及所述位置关系进行标识。

15.根据一个实现方式,所述第一对象限定要根据手术计划治疗的患者组织的目标体积。根据一个实现方式,所述控制器被配置为:基于所述第二对象相对于所述目标体积在所述公共坐标系中的所述位置以及所述手术计划,确定所述第二对象是否是根据所述手术计划治疗所述目标体积的障碍物。根据一个实现方式,响应于确定所述第二对象是所述手术计划的障碍物,所述控制器被配置为:修改所述手术计划和/或触发通知和/或停止手术导航。

16.根据一个实现方式,追踪器耦接到所述第一对象。根据一个实现方式,所述控制器被配置为:经由所述定位器检测所述追踪器在特定于所述定位器的第一坐标系中的位置。根据一个实现方式,所述控制器可基于所述追踪器在所述第一坐标系中的所检测到的位置以及所述追踪器与所述第一对象之间在所述第一坐标系中的位置关系标识所述虚拟模型在所述第一坐标系中的位置。根据一个实现方式,所述控制器基于所述虚拟模型在所述第一坐标系中的所述位置以及所述定位器与所述视觉装置之间在所述第二坐标系中的位置

关系将所述虚拟模型在所述第一坐标系中的所述位置转换为所述虚拟模型在特定于所述视觉装置的第二坐标系中的位置。根据一个实现方式,所述控制器可基于所述虚拟模型在所述第二坐标系中的所述位置生成所述预期深度图。

17.根据一个实现方式,所述控制器被配置为通过被配置为进行以下项来标识所述实际深度图的未能与所述预期深度图匹配的部分:比较所述实际深度图和所述预期深度图。在一些实现方式中,所述控制器计算所述实际深度图与所述预期深度图之间的差异。根据一个实现方式,所述控制器确定确定所述差异的第一区段是否指示大于阈值深度的绝对深度。根据一个实现方式,所述控制器响应于确定所述差异的所述第一区段指示大于阈值深度的绝对深度来将所述实际深度图的与所述差异的所述第一区段相对应的第二区段标识为所述部分。根据一个实现方式,所述阈值深度是非零的。

18.根据一个实现方式,所述控制器被配置为标识所述实际深度图的未能与所述预期深度图匹配的所述部分。在一些实现方式中,所述控制器通过被配置为确定所述第一区段的大小是否大于最小大小阈值来这样做。在一些实现方式中,所述控制器响应于确定所述第一区段的所述大小大于所述最小大小阈值来将所述第二区段标识为所述部分。

19.根据一个实现方式,所述控制器被配置为通过被配置为进行以下项来基于所标识部分识别第二对象:将所标识部分同与所述第二对象相对应的预定轮廓匹配。

20.根据一个实现方式,所述实际深度图的所述部分包括与所述第二对象相对应的并且位于所述实际深度图的第一位置中的特征的布置。根据一个实现方式,所述控制器被配置为通过监测所述特征的布置是否移动到第二位置来追踪所述第二对象的移动,所述第二位置与所述第一位置不同。根据一个实现方式,所述控制器在随后由所述视觉装置生成的另外的实际深度图中监测此类内容。

21.根据一个实现方式,所述控制器被配置为在所述公共坐标系中生成与所述第二对象相对应的虚拟边界。根据一个实现方式,所述虚拟边界提供约束。在一些实例中,所述约束是针对对象诸如手术工具、机器人操纵器、机器人手持手术装置的工作端、成像装置或所述手术室中的任何其他可移动装备的运动。在一些实例中,所述约束是禁出边界或禁入边界。

22.根据一个实现方式,所述控制器被配置为基于所述虚拟模型、所述第一对象的所检测到的位置以及所述定位器与所述视觉装置之间在公共坐标系中的所述位置关系将所述实际深度图裁剪为感兴趣区域。在一些实现方式中,所述控制器被配置为通过被配置为进行以下项来比较所述实际深度图:比较所裁剪的实际深度图。

23.根据一个实现方式,所述控制器被配置为通过被配置为进行以下项来标识所述定位器与所述视觉装置之间在所述公共坐标系中的所述位置关系:将图案投影到在所述视觉装置的视野中(和任选地也在所述定位器的视野内)的表面上。在一些实现方式中,所述控制器使用所述定位器生成定位数据,所述定位数据指示所述图案在特定于所述定位器的第一坐标系中的位置。在一些实现方式中,所述控制器接收由所述视觉装置生成的示出所投影图案的校准深度图。在一些实现方式中,所述控制器基于所述校准深度图标识所投影图案在特定于所述视觉装置的第二坐标系中的位置。在一些实现方式中,所述控制器基于所述图案在所述第一坐标系中的所述位置和所述图案在所述第二坐标系中的所述位置标识所述定位器与所述视觉装置之间在所述公共坐标系中的所述位置关系。在一些实现方式

中,所述控制器被配置为在第一光谱带中操作以检测所述第一对象的所述位置,所述视觉装置被配置为在第二光谱带中操作以生成所述第一对象附近的所述表面的所述实际深度图,并且所述第一光谱带与所述第二光谱带不同。

24.上述任何方面均可全部或部分组合。上述任何方面均可全部或部分组合。

25.上述发明内容可呈现本发明的一些方面的简化概述,以便提供对本文所讨论的本发明的某些方面的基本理解。发明内容不旨在提供本发明的广泛概述,也不旨在标识本发明的任何重要或关键要素或标示本发明的范围。发明内容的唯一目的仅仅是以简化的形式呈现一些概念作为对下面呈现的具体实施方式的介绍。

附图说明

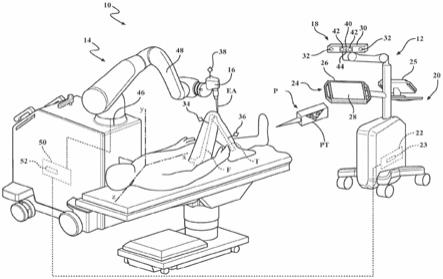

26.图1是包括定位器和视觉装置的手术导航系统的透视图。

27.图2是用于控制图1的手术导航系统的控制系统的示意图。

28.图3是在图1的手术导航系统中使用的坐标系的透视图。

29.图4是使用基于追踪器的定位和机器视觉导航目标部位的一个实例的方法的流程图。

30.图5是目标部位例如在手术程序期间被治疗的解剖结构的一个实例的图示。

31.图6是与图5的目标部位中的对象相对应的虚拟模型的位置的图示。

32.图7是基于图6的虚拟模型的预期深度图的图示。

33.图8是由图1的视觉装置捕获的实际深度图的图示。

34.图9是图8的实际深度图的被裁剪为感兴趣区域的图示。

35.图10是图7的预期深度图与图9的实际深度图之间的差异的图示。

36.图11是与图9的实际深度图中所标识的手术牵开器相对应的虚拟模型的图示。

37.图12是与图9的实际深度图中所标识的韧带相对应的虚拟模型的图示。

38.图13是与图9的实际深度图中所标识的表皮组织相对应的虚拟模型的图示。

39.图14是图6和图11至图13的虚拟模型在公共坐标系中的图示。

40.图15是随后由图1的视觉装置捕获的实际深度图的图示。

41.图16是图14的基于图15的实际深度图具有更新的定位的虚拟模型的图示。

具体实施方式

42.图1示出用于治疗患者的手术系统10。手术系统10可位于手术设置诸如医疗机构的手术室中。手术系统10可包括手术导航系统12和机器人操纵器14。机器人操纵器14可耦接到手术器械16,并且可被配置为诸如在外科医生和/或手术导航系统12的指导下操纵手术器械16以治疗患者组织的目标体积。例如,手术导航系统12可致使机器人操纵器14操纵手术器械16以移除患者组织的目标体积,同时回避与目标体积相邻的其他对象,诸如其他医疗工具和相邻的解剖结构。替代地,外科医生可在接收来自手术导航系统12的引导时手动保持和操纵手术器械16。作为一些非限制性实例,手术器械16可以是去毛刺器械、电外科器械、超声器械、铰刀、冲击器或矢状锯。

43.在手术程序期间,手术导航系统12可使用基于追踪器的定位和机器视觉的组合来追踪感兴趣对象在手术工作空间内的位置(定位和取向)。用于手术程序的手术工作空间可

被认为包括患者组织的被治疗的目标体积和紧接在被治疗的目标体积周围的可能存在治疗障碍物的区域。被追踪对象可包括但不限于患者的解剖结构、解剖结构的要治疗的目标体积、诸如手术器械16的手术器械以及手术人员的解剖结构诸如外科医生的手或手指。被追踪的患者的解剖结构和目标体积可包括软组织,诸如韧带、肌肉和皮肤,可包括硬组织,诸如骨骼。被追踪的手术器械可包括在手术程序期间使用的牵开器、切割工具和废物管理装置。

44.将追踪器固定到手术工作空间中的感兴趣对象可为手术导航系统12提供准确且有效的机制以确定此类对象在手术工作空间中的位置。在所述程序期间,追踪器可诸如在特定的不可见光带(例如,红外光、紫外光)中生成已知的信号模式。手术导航系统12可包括专用于检测特定不可见光带中的信号并且忽略该带外的光信号的定位器。响应于定位器检测到与给定追踪器相关联的信号模式,手术导航系统12可基于检测到模式的角度确定追踪器相对于定位器的位置。然后,手术导航系统12可基于追踪器的所确定位置和对象与追踪器之间的固定位置关系推断追踪器所附贴的对象的位置。

45.虽然以上追踪器可使手术导航系统12能够准确且有效地追踪手术工作空间中的硬组织对象,诸如骨骼和手术器械,但这些追踪器通常不足以追踪软组织对象,诸如皮肤和韧带。具体地,由于软组织对象的柔性性质,因此在手术程序的过程期间保持整个软组织对象与追踪器之间的固定位置关系是困难的。此外,将追踪器附接到手术程序中所涉及的若干患者组织和器械中的每一者会使手术工作空间拥挤,从而使得难以导航,并且增加了手术导航系统12的成本和复杂性。因此,除了基于追踪器的定位之外,手术导航系统12还可实现机器视觉以在手术程序期间追踪手术工作空间中的对象。

46.具体地,除了使用定位器和附贴的追踪器检测手术工作空间中的对象的位置之外,手术导航系统12可包括被配置为生成工作空间(在本文中也称为目标部位)中的表面的深度图的视觉装置。目标部位可以是各种不同的对象或部位。在一个实例中,目标部位是手术部位,诸如需要治疗或组织清除的解剖结构(例如,骨骼)的一部分。在其他实例中,目标部位可以是手术室中的装备,诸如机器人操纵器、附接到机器人操纵器的末端执行器或工具、手术台、移动推车、可将患者放置在其上的操作台、成像系统等。

47.手术导航系统12还可被配置为标识定位器与视觉装置在公共坐标系中的位置关系,并且可被配置为基于使用定位器检测到的对象在目标部位中的位置、与对象相对应的虚拟模型以及位置关系生成视觉装置的预期深度图。此后,手术导航系统12可被配置为将预期深度图与由视觉装置生成的实际深度图进行比较,并且基于所述比较标识实际深度图的未能与估计深度图匹配的部分。手术导航系统12可被配置为然后基于所标识部分标识目标部位中的对象,并且被配置为确定对象是否是当前手术计划的障碍物。

48.手术导航系统12可显示在手术程序期间被追踪的对象的相对位置以辅助外科医生。手术导航系统12还可控制和/或约束机器人操纵器14和/或手术器械16到与被追踪对象相关联的虚拟边界的移动。例如,手术导航系统12可基于被追踪对象标识要治疗的患者组织的目标体积和手术工作空间中的潜在障碍物。然后,手术导航系统12可限制手术工具(例如,手术器械16的末端执行器ea)接触超出要治疗的患者组织的目标体积的任何事物,从而改进患者安全性和手术准确性。手术导航系统12还可消除由与其他对象的无意接触引起的对手术器械的损坏,所述损坏也可导致目标部位处的不期望的碎片。

49.如图1所示,手术导航系统12可包括定位器18和导航推车组件20。导航推车组件20可容纳导航控制器22,所述导航控制器22被配置为实现本文所描述的手术导航系统12的功能、特征和过程。特别地,导航控制器22可包括处理器23,所述处理器23被编程为实现本文所描述的导航控制器22和手术导航系统12的功能、特征和过程。例如,处理器23可被编程为将从定位器18接收的基于光学的信号转换成定位器数据,所述定位器数据代表附贴到手术工作空间中的追踪器的对象的位置。

50.导航控制器22可与手术导航系统12的用户接口24操作通信。用户接口24可促进用户与手术导航系统12和导航控制器22的交互。例如,用户接口24可包括向用户提供信息诸如来自导航控制器22的信息的一个或多个输出装置。输出装置可包括适于位于包括手术工作空间的无菌区外部的显示器25并且可包括适于位于无菌区内部的显示器26。显示器25、26能够可调节地安装到导航推车组件20。用户接口24还可包括使用户能够输入到手术导航系统12的一个或多个输入装置。输入装置可包括可由用户与其交互以输入手术参数和导航控制器22的控制方面的键盘、鼠标和/或触摸屏28。输入装置还可包括通过语音识别技术实现用户输入的传声器。

51.定位器18可被配置为诸如通过检测附贴到对象的追踪器的位置来检测附接贴到追踪器的一个或多个对象在手术工作空间中的位置。具体地,定位器18可耦接到手术导航系统12的导航控制器22,并且可生成指示一个或多个追踪器在手术工作空间中的位置的基于光学的信号并将所述基于光学的信号传达到导航控制器22。导航控制器22然后可被配置为基于基于光学的信号和对象与追踪器之间的固定位置关系生成定位器数据,所述定位器数据指示附贴到追踪器的对象在手术工作空间中的位置。利用定位器18追踪的目标部位中的对象在本文中可被称为“定位对象”。

52.定位器18可具有容纳至少两个光学传感器32的外壳30。光学传感器32中的每一个可适于检测追踪器特有的特定不可见光带诸如红外光或紫外光中的信号。虽然图1将定位器18示出为具有多个光学传感器32的单个单元,但是在替代实例中,定位器18可包括围绕手术工作空间布置的单独单元,每个单元具有单独的外壳和一个或多个光学传感器32。

53.光学传感器32可以是一维或二维电荷耦合装置(ccd)。例如,外壳30可容纳两个二维ccd以用于对追踪器在手术工作场所中的位置进行三角测量,或者可容纳三个一维ccd以用于对追踪器在手术工作场所中的位置进行三角测量。除此之外或替代地,定位器18可采用其他光学感测技术,诸如互补金属氧化物半导体(cmos)有源像素。

54.在一些实现方式中,导航系统和/或定位器18是基于电磁(em)的。例如,导航系统可包括耦接到导航控制器22和/或耦接到另一个计算装置、控制器等的em收发器。在此,追踪器可包括与之附接的em部件(例如,各种类型的磁追踪器、电磁追踪器、感应追踪器等),所述em部件可以是无源的或者可以是有源激励的。em收发器生成em场,并且em部件以em信号作出响应,使得被追踪状态被传达到导航控制器22(或由所述导航控制器22解释)。导航控制器22可分析接收到的em信号以将相关状态与之相关联。在此也应当了解,基于em的导航系统的实施方案可具有与本文所示的基于有源标记的导航系统不同的结构配置。

55.在其他实现方式中,导航系统和/或定位器18可基于一种或多种类型的成像系统,所述成像系统不一定需要将追踪器固定到对象以便确定与之相关联的定位数据。例如,可提供基于超声的成像系统以促进获取(例如,被追踪对象的特定已知结构特征、紧固到被追

踪对象的标记或贴纸等的)超声图像,使得被追踪状态(例如,位置、取向等)基于所述超声图像传达到导航控制器22(或由所述导航控制器22解释)。超声图像可以是2d的、3d的或它们的组合。导航控制器22可近实时地处理超声图像以确定被追踪状态。超声成像装置可具有任何合适的配置并且可与如图1所示的相机单元不同。作为另一个实例,可提供基于荧光透视的成像系统以促进获取不透射线标记(例如,附接到被追踪对象的具有已知结构特征的贴纸、标签等)的x射线图像,使得被追踪状态基于x射线图像传达到导航控制器22(或由所述导航控制器22解释)。导航控制器22可近实时地处理x射线图像以确定被追踪状态。类似地,可提供其他类型的基于光学的成像系统以(例如,基于与被追踪对象或其结构部件或特征的虚拟表示的比较)促进获取特定已知对象和/或标记(例如,附接到被追踪对象的贴纸、标签等)的数字图像、视频等,使得被追踪状态基于数字图像传达到导航控制器22(或由所述导航控制器22解释)。导航控制器22可近实时地处理数字图像以确定被追踪状态。

56.因此,应当了解,在不脱离本公开的范围的情况下,各种类型的成像系统(包括相同或不同类型的多个成像系统)可形成导航系统的一部分。本领域的普通技术人员将了解,导航系统和/或定位器18可具有本文未具体列举的任何其他合适的部件或结构。例如,导航系统可单独利用惯性追踪或追踪技术的任何组合。此外,与图1所示的导航系统相关联的技术、方法和/或部件中的任一者可以多种不同的方式实现,并且本公开还设想其他配置。

57.定位器18可安装到可调节臂以选择性地将光学传感器32定位成具有手术工作空间和目标体积的理想地没有障碍物的视场。定位器18可能够通过围绕旋转接头旋转而在至少一个自由度上进行调节,并且可能够在两个或更多个自由度上进行调节。

58.如先前所描述,定位器18可与多个追踪装置(本文也称为追踪器)协作以确定追踪器所附贴的对象在手术工作空间内的位置。通常,每个追踪器所附贴的对象可以是刚性且非柔性的,使得对象的移动不能或不可能更改对象与追踪器之间的位置关系。换句话说,尽管对象在手术工作空间内的位置发生改变,但是手术工作空间中的追踪器与追踪器所附接的对象之间的关系可保持固定。例如,追踪器可牢固地附贴到患者骨骼和手术器械,诸如牵开器和手术器械16。以此方式,响应于使用定位器18确定追踪器在手术工作空间中的位置,导航控制器22可基于追踪器的所确定位置推断追踪器所附贴的对象的位置。

59.例如,当要治疗的目标体积位于患者的膝关节区域时,追踪器34可牢固地附贴到患者的股骨f,追踪器36可牢固地附贴到患者的胫骨t,并且追踪器38可牢固地附贴到手术器械16。追踪器34、36可以特此通过引用方式并入的美国专利号7,725,162所示的方式附接到股骨f和胫骨t。追踪器34、36也可像特此通过引用方式并入的于2014年1月16日提交的名称为"navigation systems and methods for indicating and reducing line-of-sight errors"的美国专利申请公布号2014/0200621所示的那样安装。在制造期间,可将追踪器38集成到手术器械16中,或者可单独安装到手术器械16以为手术程序做准备。

60.在使用手术系统10的手术程序开始之前,可针对感兴趣的解剖结构生成术前图像,诸如限定和/或邻近要由手术器械16治疗的患者组织的目标体积的解剖结构。例如,当要治疗的患者组织的目标体积位于患者的膝关节区域中时,可拍摄患者的股骨f和胫骨t的术前图像。这些图像可基于患者的解剖结构的mri扫描、放射扫描或计算机断层(ct)扫描,并且可用于研制解剖结构的虚拟模型。解剖结构的每个虚拟模型可包括三维模型(例如,点云、网格、cad),所述三维模型包括表示解剖结构的整个或至少一部分的数据和/或表示解

剖结构的要治疗的目标体积的数据。这些虚拟模型可在手术程序之前提供给导航控制器22并存储在导航控制器22中。

61.除了拍摄术前图像之外或替代拍摄术前图像,还可在手术室中根据运动学研究、骨骼追踪和其他方法研制治疗计划。这些相同的方法也可用于生成上述虚拟模型。

62.除了与感兴趣的患者的解剖结构相对应的虚拟模型之外,在手术程序之前,导航控制器22可接收并存储手术程序感兴趣的其他被追踪对象(诸如手术器械和潜在地存在于手术工作空间中的其他对象(例如,外科医生的手和/或手指))的虚拟模型。导航控制器22还可接收并存储特定于手术程序的手术数据,诸如追踪器与固定到追踪器的对象之间的位置关系、定位器18与视觉装置之间的位置关系以及手术计划。手术计划可标识手术程序中所涉及的患者解剖结构,可标识在手术程序中使用的器械,并且可限定在手术程序期间器械的计划轨迹和患者组织的计划移动。

63.在手术程序期间,定位器18的光学传感器32可检测来自追踪器34、36、38的诸如在不可见光带(例如,红外光或紫外光)中的光信号,并且可基于所检测到的光信号向导航控制器22输出指示追踪器34、36、38相对于定位器18的位置的基于光学的信号。然后,导航控制器22可基于追踪器34、36、38的所确定位置和追踪器34、36、38与对象之间的已知位置关系生成指示固定到追踪器34、36、38的对象相对于定位器18的位置的定位器数据。

64.为了补充由定位器18提供的基于追踪器的对象追踪,手术导航系统12还可包括视觉装置40。视觉装置40可能够实时地生成手术工作空间部位的三维图像。与可限于检测和精确定位从追踪器34、36、38传输的不可见光信号的位置的定位器18不同,视觉装置40可被配置为生成位于视觉装置40的视场中的在目标体积中及其周围的表面的三维图像,诸如呈深度图的形式。视觉装置40可包括一个或多个图像传感器42和光源44。图像传感器42中的每一个可以是cmos传感器。

65.例如,视觉装置40可通过利用不可见光诸如红外光或紫外光照射手术工作空间中的暴露表面来生成手术工作空间的深度图。然后表面可反射回不可见光,所述不可见光可被视觉装置40的一个或多个图像传感器42检测到。基于不可见光自传输起到被视觉装置40检测到的飞行时间,视觉装置40可确定视觉装置40与手术工作空间的暴露表面上的若干点之间的距离。视觉装置40然后可生成指示视觉装置40与每个表面点之间的距离和角度的深度图。替代地,视觉装置40可利用其他模态来生成深度图,诸如但不限于结构光投影、激光测距或体视法。

66.与定位器18类似,在手术程序之前,视觉装置40可被定位成具有手术工作空间的优选地没有障碍物的视场。视觉装置40可与定位器18集成,如图1所示。替代地,视觉装置40可安装到单独的可调节臂,以将视觉装置40与定位器18分开定位。视觉装置40也可直接附接到机器人操纵器14,诸如例如,如名称为“systems and methods for identifying and tracking physical objects during a robotic surgical procedure”的美国专利10,531,926中所描述的,所述专利的内容特此以引用方式整体并入。视觉装置40还可与导航控制器22操作通信。

67.如上所述,导航控制器22可被配置为基于使用定位器18生成的基于追踪器的定位数据和由视觉装置40生成的深度图追踪对象并标识手术工作空间中的障碍物。特别地,在视觉装置40生成手术工作空间的深度图的视觉时间的同时,定位器18可生成用于生成定位

器数据的基于光学的数据,所述定位器数据指示固定到手术工作空间中的追踪器的对象相对于定位器18的位置。由视觉装置40生成的深度图和利用定位器18生成的定位器数据因此可在时间上交错。换句话说,利用定位器18生成的定位器数据的每个实例可在时间上与由视觉装置40生成的不同深度图相关联,使得在定位器数据中指示的对象的位置和在相关联的深度图中的那些对象的位置对应于手术程序期间的同一时刻。

68.响应于确定定位器数据,导航控制器22可被配置为生成要被视觉装置40捕获并与定位数据相关联的预期深度图。预期深度图可以是预期由视觉装置40生成的在时间上与定位器数据相关联的深度图,假设手术工作空间中仅存在固定到追踪器的对象。导航控制器22可被配置为基于如在定位器数据中指示的固定到手术工作空间中的追踪器的对象的所检测到的位置、对应于对象的虚拟模型以及定位器18与视觉装置40之间的位置关系来确定预期深度图。

69.此后,导航控制器22可检索由视觉装置40生成的在时间上与定位器数据相关联的实际深度图,并且可标识实际深度图的未能与预期深度图匹配的部分。导航控制器22然后可基于所标识部分标识手术工作空间中的对象,诸如除了固定到追踪器的对象之外的与要治疗的患者组织的目标体积相邻的对象,并且可确定任何此类对象是否对当前的手术轨迹构成障碍。

70.手术器械16可形成机器人操纵器14的末端执行器的一部分。机器人操纵器14可包括基座46、从基座46延伸的若干连杆48以及用于使手术器械16相对于基座46移动的若干活动接头。连杆48可形成如图1所示的串联臂结构、并联臂结构(例如图3所示)或其他合适的结构。机器人操纵器14可包括在手动模式下操作的能力,在所述手动模式下,用户抓住机器人操纵器14的末端执行器以致使手术器械16(例如,直接地或通过致使机器人操纵器14主动驱动的力/扭矩传感器测量结果)移动。机器人操纵器14还可包括半自主模式,在所述半自主模式下,手术器械16由机器人操纵器14沿着预定义工具路径移动(例如,机器人操纵器14的活动接头被操作以使手术器械16移动而不需要来自用户的末端执行器上的力/扭矩)。在特此通过引用方式并入的bowling等人的美国专利号9,119,655中描述了半自主模式下的操作的实例。单独的追踪器可附接到机器人操纵器14的基座46以通过定位器18追踪基座46的移动。

71.与手术导航系统12类似,机器人操纵器14可容纳操纵器控制器50,所述操纵器控制器50包括处理器52,所述处理器52被编程为实现机器人操纵器14的过程,或更特别地,本文描述的操纵器控制器50的过程。例如,处理器52可被编程为诸如在手术导航系统12的指导下通过连杆48的移动来控制手术器械16的操作和移动。

72.在手术程序期间,操纵器控制器50可被配置为诸如基于从导航控制器22接收的导航数据确定手术器械16应该移动到的期望定位。基于该确定以及与手术器械16的当前位置相关的信息,操纵器控制器50可被配置为确定连杆48中的每一个需要被移动以将手术器械16从当前位置重新定位到期望位置的程度。指示连杆48将被重新定位的位置的数据可被转发到控制机器人操纵器14的活动接头的接头电机控制器(例如,用于控制每个电机的一个接头电机控制器)。响应于接收到此类数据,接头电机控制器可被配置为根据数据使连杆48移动,并且因此使手术器械16移动到期望位置。

73.现在参考图2,定位器18和视觉装置40可分别包括定位器控制器62和视觉控制器

64。定位器控制器62可通信地耦接到定位器18的光学传感器32并且耦接到导航控制器22。在手术程序期间,定位器控制器62可被配置为操作光学传感器32以致使它们生成指示从追踪器34、36、38接收的光信号的基于光学的数据。

74.追踪器34、36、38可以是有源追踪器,每个追踪器有至少三个有源标记以用于将光信号传输到光学传感器32。追踪器34、36、38可由内部电池供电,或者可具有通过导航控制器22接收电力的引线。每个追踪器34、36、38的有源标记可以是传输光诸如红外光或紫外光的发光二极管(led)65。追踪器34、36、38中的每一个还可包括连接到追踪器34、36、38的led 65并且连接到导航控制器22的追踪器控制器66。追踪器控制器66可被配置为诸如在导航控制器22的指导下控制追踪器34、36、38的led 65发光的速率和顺序。例如,追踪器34、36、38的追踪器控制器66可致使每个追踪器34、36、38的led 65以不同的速率和/或时间发光以促进导航控制器22区分追踪器34、36、38。

75.光学传感器32的采样率是光学传感器32从顺序发光的led 65接收光信号的速率。光学传感器32可具有100hz或更高,或更优选地300hz或更高,或最优选地500hz或更高的采样率。例如,光学传感器32可具有8000hz的采样率。

76.追踪器34、36、38不是有源追踪器,而是包括无源标记(未示出)的无源追踪器,诸如反射从定位器18发射的光(例如,从光源44(图1)发射的光)的反射器。反射光然后可由光学传感器32接收。

77.响应于光学传感器32从追踪器34、36、38接收光信号,光学传感器32可将基于光学的数据输出到定位器控制器62,所述基于光学的数据指示追踪器34、36、38相对于定位器18的位置,并且对应地,指示牢固地附贴到追踪器34、36、38的对象相对于定位器18的位置。特别地,每个光学传感器32可包括检测来自追踪器34、36、38的光信号的一维或二维传感器区域,并且响应地指示在传感器区域内检测到每个光信号的位置。每个光信号在给定传感器区域内的检测位置可基于包括传感器区域的光学传感器32接收光信号的角度,并且类似地可对应于光信号的源在手术工作空间中的位置。

78.因此,响应于从追踪器34、36、38接收光信号,每个光学传感器32可生成指示在光学传感器32的传感器区域内检测到光信号的位置的基于光学的数据。光学传感器32可将这种基于光学的数据传达到定位器控制器62,然后定位器控制器62可将基于光学的数据传达到导航控制器22。导航控制器22然后可基于基于光学的数据生成指示追踪器34、36、38相对于定位器18的位置的追踪器位置数据。例如,导航控制器22可基于基于光学的数据对led 65相对于定位器18的位置进行三角测量,并且可将存储的追踪器34、36、38与标记之间的位置关系应用于led 65相对于定位器18的所确定位置以确定追踪器34、36、38相对于定位器18的位置。

79.此后,导航控制器22可基于追踪器位置数据生成指示牢固地附贴到追踪器34、36、38的对象相对于定位器18的位置的定位器数据。具体地,导航控制器22可检索存储的追踪器34、36、38与追踪器34、36、38所附贴的对象之间的位置关系,并且可将这些位置关系应用到追踪器位置数据以确定固定到追踪器34、36、38的对象相对于定位器18的位置。替代地,定位器控制器62可被配置为基于接收到的基于光学的数据确定追踪器位置数据和/或定位器数据,并且可将追踪器位置数据和/或定位器数据传输到导航控制器22以供进一步处理。

80.视觉控制器64可通信地耦接到视觉装置40的光源44和一个或多个图像传感器42,

并且耦接到导航控制器22。在定位器控制器62致使定位器18生成指示追踪器34、36、38在手术工作空间中的位置的基于光学的数据的同时,视觉控制器64可致使视觉装置40生成手术工作空间的暴露表面的深度图。具体地,视觉控制器64可致使图像传感器42生成形成深度图的基础的图像数据,并且可基于图像数据生成深度图。视觉控制器64然后可将深度图转发到导航控制器22以供进一步处理。替代地,视觉控制器64可将图像数据传达到导航控制器22,所述导航控制器22然后可基于接收到的图像数据生成深度图。

81.通常,由视觉装置40生成的深度图可指示视觉装置40与视觉装置40的视场中的表面之间的距离。换句话说,深度图可从视觉装置40的视点示出手术工作空间中的表面的形貌。由视觉装置40生成的每个深度图可包括形成视觉装置40的图像帧的多个图像分量。每个图像分量可近似于深度图的像素,并且可限定从视觉装置40的中心到视觉装置的视场中的表面上的点的向量。例如,图像分量在视觉装置40的图像帧中的定位可对应于由图像分量限定的向量的水平分量和垂直分量,并且图像分量的颜色可对应于由图像分量限定的向量的深度分量。作为实例,表示手术工作空间中更靠近视觉装置40的表面点的图像分量与表示距视觉装置40较远的表面点的那些图像分量相比可具有更亮的颜色。

82.视觉装置40可以是包括一个或多个深度传感器68的深度相机。深度传感器68可适于检测反射离开深度传感器68的视场内的表面的光,诸如不可见光。在手术程序期间,视觉控制器64可致使光源44利用不可见光诸如红外光或紫外光照射目标部位。深度传感器68然后可检测到不可见光离开目标部位的表面的反射,这可使视觉控制器64能够生成深度图。

83.例如,视觉控制器64可基于从光源44传输的光反射离开目标部位中的暴露表面上的点的时间(即,飞行时间方法)生成深度图,所述时间可对应于视觉装置40与各个点之间的距离。视觉控制器64然后可利用这些所确定距离来生成深度图。作为替代实例,光源44可将已知的结构化不可见光图案投影到手术部位中的暴露表面上。深度传感器68然后可检测到已知图案的反射,所述反射可基于目标部位中的表面的形貌而失真。视觉控制器64因此可被配置为基于已知图案与由深度传感器68检测到的图案的失真版本之间的比较生成目标部位的深度图。

84.替代地,视觉装置40可以是包括一个或多个rgb传感器70的rgb相机。rgb传感器70可被配置为生成目标部位中的暴露表面的彩色图像,并且视觉控制器64可被配置为基于彩色图像生成深度图。

85.例如,与上述结构光方法类似,视觉控制器64可被配置为致使光源44诸如以偏离目标部位中的颜色的颜色将已知的结构光图案投影到目标部位上。rgb传感器70然后可生成目标部位的rgb图像,所述rgb图像可基于目标部位的表面形貌描绘已知结构光图案的失真版本。视觉控制器64可诸如使用图案识别、边缘检测和颜色识别来从rgb图像提取已知结构光图案的失真版本,并且可基于已知结构光图案与所提取失真版本之间的比较确定深度图。

86.作为另一个替代方案,视觉装置40可被配置为使用体视法中的原理来生成目标部位的深度图。更特别地,多个图像传感器42,诸如多个深度传感器68或rgb传感器70,可被定位成具有目标部位的来自不同角度的视场。视觉控制器64可被配置为致使每个图像传感器42从不同角度同时生成目标部位的图像。例如,当图像传感器42是深度传感器68时,视觉控制器64可被配置为致使光源44以不可见光的图案照射目标部位的暴露表面,并且每个深度

传感器68可对从不同角度反射离开暴露表面的不可见光的图案进行成像。视觉控制器64然后可基于表面点在每个图像中的位置和图像传感器42之间的已知位置关系确定目标部位中的表面上的点相对于视觉装置40的三维位置。视觉控制器64此后可基于所确定三维位置生成深度图。

87.为了在手术程序期间减少定位器18与视觉装置40之间的干扰,定位器18和视觉装置40可被配置为在不同的光谱带中操作以检测目标部位中的对象的位置。除此之外或替代地,当视觉装置40使用光源44来照射目标部位中的暴露表面时,诸如当视觉装置40在不可见光带中操作时,定位器18可被配置为在时间曝光率足够短的情况下操作,使得视觉装置40的光源44对于定位器18是不可见的。

88.如先前所描述,导航控制器22可包括处理器23,所述处理器23被编程为执行本文描述的导航控制器22的功能、特征和过程,诸如基于使用定位器18生成的定位器数据计算预期深度图,并且通过将预期深度图与由视觉装置40生成的实际深度图进行比较来确定与在手术部位中要治疗的患者组织的目标体积相邻的对象。除了处理器23之外,导航控制器22可包括存储器72和非易失性存储装置74,每个都可操作地耦接到处理器23。

89.处理器23可包括选自以下项的一个或多个装置:微处理器、微控制器、数字信号处理器、微型计算机、中央处理单元、现场可编程门阵列、可编程逻辑装置、状态机、逻辑电路、模拟电路、数字电路或基于存储在存储器72中的操作指令操纵(模拟或数字)信号的任何其他装置。存储器72可包括单个存储器装置或多个存储器装置,所述单个存储器装置或多个存储器装置包括但不限于:只读存储器(rom)、随机存取存储器(ram)、易失性存储器、非易失性存储器、静态随机存取存储器(sram)、动态随机存取存储器(dram)、快闪存储器、高速缓存存储器或能够存储信息的任何其他装置。非易失性存储装置74可包括一个或多个持久性数据存储装置,诸如硬盘驱动器、光盘驱动器、磁带驱动器、非易失性固态装置或能够持久存储信息的任何其他装置。

90.非易失性存储装置74可存储软件,诸如定位引擎76、转换引擎78、视觉引擎80和手术导航器81。软件可由计算机可执行指令体现,所述计算机可执行指令由多种编程语言和/或技术编译或解释,所述多种编程语言和/或技术包括但不限于以下单独一个或组合:java、c++、c++、c#、objective c、fortran、pascal、java script、python、perl以及pl/sql。

91.处理器23可在存储在非易失性存储装置74中的软件的控制下操作。特别地,处理器23可被配置为通过读入存储器72并执行软件的计算机可执行指令来将软件作为主动运行的过程来执行。在由处理器23执行时,计算机可执行指令可被配置为致使处理器23实现本文描述的导航控制器22的配置功能、特征和过程。因此软件可被配置为借助于正被配置的软件的计算机可执行指令致使导航控制器22实现本文描述的导航控制器22的功能、特征和过程,所述计算机可执行指令在由处理器23执行时被配置为致使导航控制器22的处理器23实现本文描述的导航控制器22的过程。

92.导航控制器22的非易失性存储装置74还可存储便于导航控制器22的操作的数据。具体地,导航控制器22的软件可被配置为访问存储在非易失性存储装置74中的数据,并且被配置为基于所述数据实现本文描述的导航控制器22的功能、特征和过程。

93.例如但不限于,存储在非易失性存储装置74中的数据可包括模型数据82、转换数据83和手术计划84。模型数据82可包括手术程序感兴趣的解剖结构的虚拟模型,包括潜在

障碍物诸如外科医生的手或手指的虚拟模型以及在手术程序中正使用的手术器械的虚拟模型,如上所述。转换数据83可包括本文的位置关系,所述位置关系可使得能够将手术工作空间中的对象相对于诸如追踪器34、36、38或定位器18或视觉装置40的一个装置的位置转换为对象相对于另一个装置的位置。例如,转换数据83可阐明追踪器34、36、38与牢固地附贴到追踪器34、36、38的对象之间的固定位置关系,以及定位器18与视觉装置40之间的位置关系。手术计划84可标识手术程序中所涉及的患者解剖结构目标体积,可标识在手术程序中使用的器械,并且可限定在手术程序期间器械的计划轨迹和患者组织的计划移动。

94.再次参考在导航控制器22上运行的软件,定位引擎76可被配置为诸如基于由定位器18的光学传感器32生成的基于光学的数据生成定位数据,所述定位数据指示牢固地附贴到追踪器34、36、38的对象相对于定位器18的位置。转换引擎78可被配置为诸如基于由转换数据83表示的位置关系将对象相对于手术系统10的一个装置的位置转换为对象相对于手术系统10的另一个装置的位置。视觉引擎80可被配置为基于由定位引擎76生成的定位数据和转换数据83生成预期深度图,并且被配置为将预期深度图与由视觉装置40生成的实际深度图进行比较以标识和追踪手术工作空间中的对象。手术导航器81可被配置为基于由视觉引擎80确定的标识和追踪提供手术指导。下面更详细地讨论了这些软件部件的功能性的另外的细节。

95.尽管未示出,但操纵器控制器50、定位器控制器62和视觉控制器64中的每一者还可包括处理器、存储器和包括数据和软件的非易失性存储装置,所述数据和软件被配置为在执行其计算机可执行指令时实现本文描述的控制器的功能、特征和过程。

96.虽然示例性手术系统10在图1中示出,并且在图2中进一步详述,但是该实例并非旨在进行限制。实际上,手术系统10可具有更多或更少的部件,并且可使用替代部件和/或实现方式。例如,定位器引擎76的全部或一部分可由定位器控制器62实现。作为实例,定位器控制器62可被配置为基于模型数据82生成指示牢固地附贴到追踪器34、36、38的对象的位置的定位器数据。

97.图3示出与手术系统10一起使用的各种对象和装置的坐标系。导航控制器22可被配置为诸如经由转换引擎78诸如基于存储在导航控制器22中的转换数据83中限定的位置关系将对象在一个坐标系中的位置转换为对象在另一个坐标系中的位置。此类转换可使导航控制器22能够相对于公共坐标系追踪手术系统10中的对象。此外,所述转换可使导航控制器22诸如经由视觉引擎80能够基于由定位引擎76生成的定位数据计算要由视觉装置40生成的预期深度图,并且能够基于由视觉装置40生成的实际深度图与预期深度图之间的比较标识和追踪对象。作为一个非限制性实例,由转换数据83限定并且能够在坐标系之间进行转换的每个位置关系可由转换数据83所限定的转换矩阵表示。

98.导航控制器22可被配置为参考定位器坐标系lclz来追踪目标部位中的对象,诸如目标部位中的附贴到追踪器34、36、38的对象。定位器坐标系lclz可包括可由x轴、y轴和z轴相对于手术工作空间的位置来限定的原点和取向。定位器坐标系lclz可固定到定位器18并以定位器18为中心。具体地,定位器18的中心点可限定定位器坐标系lclz的原点。如上所述的可指示对象相对于定位器18的使用定位器18确定的位置的定位器数据可类似地指示此类对象在定位器坐标系lclz中的位置。

99.在所述程序期间,一个目标是将定位器坐标系lclz保持在已知位置中。加速度计

可安装到定位器18以检测定位器坐标系lclz的突然或意外的移动,所述移动在定位器18被手术人员无意中碰撞时可能发生。响应于检测到的定位器坐标lclz的移动,导航控制器22可被配置为诸如经由手术导航器81,通过用户接口24向手术人员呈现警报以停止手术导航和/或被配置为向操纵器控制器50传达致使操纵器控制器50停止手术器械16的移动的信号直到重新校准手术系统10。

100.由手术系统10追踪的每个对象还可具有其自己的坐标系,所述坐标系固定到对象并以所述对象为中心,并且所述坐标系与定位器坐标系lclz分开。例如,追踪器34、36、38可分别固定在骨骼追踪器坐标系btrk1、骨骼追踪器坐标系btrk2和器械追踪器坐标系tltr内并在这些坐标系内居中。患者的股骨f可固定在股骨坐标系fbone内并在所述坐标系内居中,并且患者的胫骨t可固定在胫骨坐标系tbone内并在所述坐标系内居中。在手术程序之前,每个被追踪对象诸如股骨f、胫骨t和手术器械16的术前图像和/或虚拟模型可根据对象在坐标系中的固定位置诸如通过映射到对象的坐标系并固定在对象的坐标系内来映射到对象。

101.在手术程序的初始阶段期间,追踪器34、36可分别牢固地附贴到患者的股骨f和胫骨t。坐标系fbone和tbone的位置然后可分别映射到坐标系btrk1和btrk2。例如,诸如在特此通过引用方式并入的malackowski等人的美国专利号7,725,162中公开的具有其自己的追踪器pt的指针式仪表p(图1)可用于将股骨坐标系fbone和胫骨坐标系tbone分别配准到骨骼追踪器坐标系btrk1和btrk2。股骨坐标系fbone与骨骼追踪器坐标系btrk1之间的固定位置关系以及胫骨坐标系tbone与骨骼追踪器坐标系btrk2之间的固定位置关系可作为转换数据83存储在导航控制器22上。

102.给定股骨f和胫骨t及其追踪器34、36之间的固定空间关系,导航控制器22可诸如经由转换引擎78将股骨f在股骨坐标系fbone中的位置转换为股骨f在骨骼追踪器坐标系btrk1中的位置,并且可将胫骨t在胫骨坐标系tbone中的位置转换为胫骨t在骨骼追踪器坐标系btrk2中的位置。因此,通过使用定位器18确定追踪器34、36在定位坐标系lclz中的位置,导航控制器22可分别确定股骨坐标系fbone在定位坐标系lclz中的位置和胫骨坐标系tbone在定位坐标系lclz中的位置,并且可分别对应地确定股骨f和胫骨t在定位坐标系lclz中的位置。

103.类似地,手术器械16的治疗端可固定在其坐标系eapp内并在所述坐标系内居中。例如,坐标系eapp的原点可固定到手术切割钻的质心。在程序开始之前,坐标系eapp的位置以及对应地手术器械16的治疗端的位置可固定在追踪器38的器械追踪器坐标系tltr内。坐标系eapp与器械追踪器坐标系tltr之间的固定位置关系也可作为转换数据83存储在导航控制器22中。因此,通过使用定位器18确定器械追踪器坐标系tltr在定位坐标系lclz中的位置,导航控制器22可诸如经由转换引擎78基于器械追踪器坐标系tltr与坐标系eaap之间的位置关系确定坐标系eapp在定位坐标系lclz中的位置,并且可对应地确定手术器械16的治疗端在定位坐标系lclz中的位置。

104.视觉装置40同样可被固定在视觉坐标系vis内并在所述坐标系内居中。视觉坐标系vis的原点可表示视觉装置40的质心。由视觉装置40生成的如上所述可指示目标部位中的暴露表面相对于视觉装置40的位置的每个实际深度图可类似地指示暴露表面在坐标系vis中的位置。

105.当视觉装置40与定位器18集成在一起时,诸如图1所示,视觉坐标系vis和定位器坐标系lclz可被认为是等效的。换句话说,对象或坐标系在定位器坐标系lclz中的位置可与对象或坐标系在视觉坐标系vis中的位置非常接近或相等,以至于不需要转换。替代地,由于当视觉装置40与定位器18集成时,视觉坐标系vis可固定在定位器坐标系lclz内,或反之亦然,所以视觉坐标系vis与定位器坐标系lclz之间的位置关系以及对应地视觉装置40与定位器18之间的位置关系可在手术系统10的制造期间确定,并且可作为转换数据83被工厂存储在导航控制器22中。

106.当视觉装置40与定位器18分开时,视觉装置40可包括刚性地安装到视觉装置40的外壳的追踪器(未示出)以建立视觉坐标系vis与定位器坐标系lclz之间以及对应地视觉装置40与定位器18之间的位置关系。导航控制器22可预先加载追踪器的坐标系与视觉坐标系vis之间的位置关系作为转换数据83。因此,通过使用定位器18确定追踪器的坐标系在定位坐标系lclz中的位置,导航控制器22可基于追踪器的坐标系与视觉坐标系vis之间的所存储位置关系确定视觉坐标系vis在定位坐标系lclz中的位置,并且对应地可确定视觉装置40在定位器坐标系lclz中的位置。进一步对应地,导航控制器22可在定位器坐标系lclz和视觉坐标系vis中确定视觉装置40相对于定位器18的位置。

107.替代地,导航控制器22可被配置为基于插入目标部位中并可由定位器18和视觉装置40两者检测到的公共光图案标识定位器公共坐标系lclz与视觉坐标系vis之间的位置关系。例如,在定位器18和视觉装置40被定位成具有目标部位的视场之后,光(诸如不可见光)的图案可投影到目标部位上,所述目标部位可将光图案反射回到定位器18和视觉装置40。导航控制器22可致使视觉装置40的光源44将该光图案投影到目标部位中,或者可使用单独的光投影仪(未示出)来投影所述光图案。作为另一个实例,具有被配置为传输可由定位器18和视觉装置40检测到的光图案的标记的追踪器或其他物理装置诸如指针pt(图1)可放置在目标部位内并且放置在定位器18和视觉装置40的视场中。

108.导航控制器22可被配置为诸如经由定位器引擎76并且使用定位器18来生成指示光图案在特定于定位器18的定位器坐标系lclz中的位置的定位数据。导航控制器22还可从视觉装置40接收示出光图案的校准深度图,并且可被配置为诸如经由转换引擎78基于校准深度图标识光图案在视觉坐标系vis中的位置。然后,导航控制器22可被配置为诸如经由转换引擎78基于所投影图案在定位坐标系lclz和视觉坐标系lclz中的所确定位置诸如使用回归算法来确定定位坐标系lclz与视觉坐标系lclz之间的位置关系。

109.图4示出使用基于追踪器的定位和机器视觉来追踪手术工作空间中的对象并确定对象是否阻碍手术计划的方法100。方法100可由手术导航系统12执行,或更特别地由导航控制器22执行。

110.在框102中,可标识定位器18与视觉装置40之间在公共坐标系中的位置关系。具体地,导航控制器22可被配置为诸如经由转换引擎78使用上述方法中的任何一种来标识定位器18与视觉装置40之间的位置关系以及对应地定位器坐标系lclz与视觉坐标系vis之间的位置关系。例如,追踪器可固定到视觉装置40,或者可将光图案放置在可由定位器18和视觉装置40两者检测到的目标部位中。替代地,在制造期间,当定位器18与视觉装置40集成或以其他方式相对于视觉装置40固定时,位置关系可在制造期间被确定并作为转换数据83预存储在导航控制器22中。

111.在框104中,可诸如基于转换数据83访问与目标部位中的一个或多个对象相对应的虚拟模型。转换数据83可指示目标部位中的追踪器诸如追踪器34、36、38所附贴的对象。导航控制器22可被配置为检索附贴到追踪器的对象中的每一个的虚拟模型。在一些情况下,这些检索到的虚拟模型中的一个或多个也可限定在手术程序期间要治疗的目标体积。

112.图5示出经历膝关节置换程序的患者的目标部位200。目标部位200可包括患者股骨f的一部分,其可包含骨组织的要用手术器械(例如,手术器械16)清除的目标体积202。目标部位200还可包括与目标体积202相邻的软组织,诸如韧带204和表皮组织206。目标部位200还可包括手术工具,诸如被定位成牵开表皮组织206并提供接近患者的股骨f的牵开器208。目标部位200另外可包括牢固地附贴到患者的股骨f的追踪器209。导航控制器22因此可从模型数据82中检索与股骨f相对应的虚拟模型,其实例在图6中示出。

113.再次参考图4,在框106中,可使用定位器18来检测目标部位中的附贴到追踪器的对象的位置。特别地,定位器18可被配置为生成基于光学的数据,所述基于光学的数据指示每个追踪器坐标系的位置以及对应地每个追踪器在定位器坐标系lclz中的位置,如上所述。导航控制器22然后可被配置为诸如经由定位引擎76诸如基于追踪器及其坐标系的所检测到的位置以及在转换数据83中指示的追踪器与对象之间的位置关系标识附贴到追踪器的对象的坐标系在定位器坐标系lclz中的位置,以及对应地对象在定位器坐标系lclz中的位置。因为附贴到追踪器的每个对象的虚拟模型可映射到转换数据83中的对象的坐标系,所以导航控制器22可基于对象所附贴的追踪器的所检测到的位置以及追踪器与对象之间的位置关系类似地标识附贴到追踪器的每个对象的虚拟模型在定位器坐标系lclz中的位置。

114.图6示出图5的目标部位200的延续并且示出可与患者的股骨f相对应的虚拟模型210,所述虚拟模型210可附贴到目标部位200中的追踪器209。虚拟模型210可根据利用定位器18确定的追踪器209和股骨f在定位器坐标系lclz中的位置来定位在定位器坐标系lclz中。虚拟模型210可限定在治疗期间要从股骨f清除的虚拟目标体积212,所述虚拟目标体积212可与图5所示的目标体积202相对应。

115.在框108中,诸如基于访问的虚拟模型、与虚拟模型相对应的对象在定位器坐标系lclz中的所检测到的位置以及定位器18与视觉装置40之间在公共坐标系中的位置关系生成预期深度图。如先前所描述,虚拟模型在定位器坐标系lclz中的位置可与使用定位器18确定的对象在定位器坐标系lclz中的位置相对应。导航控制器22可被配置为诸如经由视觉引擎80基于定位器18与视觉装置40之间的位置关系以及对应地定位器坐标系lclz与视觉坐标系vis之间在公共坐标系中的位置关系将虚拟模型在定位器坐标系lclz中的位置转换为虚拟模型在视觉坐标系vis中的位置。

116.此后,导航控制器22可基于虚拟模型在视觉坐标系vis中的位置生成预期深度图。如上所述,由视觉装置40生成的深度图可示出目标部位中的暴露对象表面相对于视觉装置40的位置(例如,深度和定位)。虚拟模型在视觉坐标系vis中的位置可概括地指示由虚拟模型表示的对象表面相对于视觉装置40的位置,所述位置可固定在视觉坐标系vis内。因此,导航控制器22可被配置为诸如经由视觉引擎80基于虚拟模型在视觉坐标系vis中的所确定位置模拟预期由具有目标部位的视场的视觉装置40生成的深度图,假设目标部位没有任何其他对象。

117.图7示出可基于图6的虚拟模型210生成的预期深度图。图7的预期深度图可根据虚拟模型210在视觉坐标系vis中的转换位置来模拟患者的股骨f的预期由视觉装置40生成的深度图,假设目标部位不存在其他对象,诸如韧带204、表皮组织206、牵开器208和追踪器209。图7的预期深度图也可以已被裁剪为感兴趣区域,下面更详细地讨论。

118.在框110中,可接收由视觉装置40捕获的实际深度图。特别地,与在框106中定位器18生成指示附贴到目标部位中的追踪器的对象的位置的定位器数据的同时,视觉装置40可生成目标部位的深度图,如上所述。以此方式,深度图可与定位数据在时间上交错,并且也可与基于定位数据生成的估计深度图在时间上交错。换句话说,实际深度图和预期深度图两者可表示手术程序期间在时间上处于基本上相同时刻的目标部位。

119.图8示出可由具有图5所描绘的目标部位200的视场的视觉装置40生成的深度图,其中为简单起见移除了追踪器209。深度图可包括近似于像素的若干图像分量,所述图像分量被布置为矩阵并且形成深度图的图像帧。方格214已被人为地放置在所示的深度图上以突出显示图像分量中的示例性图像分量。每个图像分量在深度图图像帧中的定位可表示距视觉装置40的中心视点的水平距离和竖直距离,并且每个图像分量的亮度可与由来自视觉装置40的图像分量表示的对象表面点的距离相对应。在所示的实例中,较亮的图像分量表示目标部位中的更靠近视觉装置40的表面点,而较暗的图像分量表示目标部位中的距视觉装置40较远的表面点。

120.在框112中,可诸如基于在框104中访问的虚拟模型、与虚拟模型相对应的对象在定位器坐标系lclz中的所检测到的位置以及定位器18与视觉装置40之间在公共坐标系中的位置关系将实际深度图裁剪为手术程序的感兴趣区域(roi)。如下面进一步详细解释的,可将实际深度图与预期深度图进行比较以标识目标部位中的对象并且确定任何此类对象是否可能阻碍目标部位中的目标体积的治疗。被比较的实际深度图和预期深度图的尺寸越大,比较中所涉及的计算量越大。因此导航控制器22可被配置为诸如经由视觉引擎80基于虚拟模型在视觉坐标系vis中的位置将实际深度图裁剪为roi以减小所比较深度图像的尺寸。如上所述,虚拟模型在视觉坐标系vis中的位置可基于对象定位器坐标系lclz的所确定位置以及定位器18与视觉装置40之间在公共坐标系中的位置关系来确定。

121.例如,在框104中访问的虚拟模型可限定在手术程序期间要治疗的目标体积。因此,虚拟模型在视觉坐标系vis中的位置可指示目标体积在视觉坐标系vis中的位置,并且对应地,可指示目标体积在由视觉装置40生成的实际深度图中的位置。导航控制器22可被配置为诸如经由视觉引擎80裁剪实际深度图以移除与目标体积在视觉坐标系vis中的位置相距大于阈值距离的任何区域。除此之外或替代地,导航控制器22可被配置为诸如经由视觉引擎80将用户选择的或程序特定的形状在目标体积在实际深度图中的位置上居中,并且被配置为移除实际深度图的形状之外的任何区域。导航控制器22可被配置为诸如在预期深度图的计算期间或之后将预期深度图的尺寸和形状限制为所裁剪的实际深度图的尺寸和形状。

122.图9示出图8的基于与图6中的股骨f相对应的虚拟模型210被裁剪为roi的实际深度图。虚拟模型210可限定与在手术程序期间要治疗的目标体积202相对应的虚拟目标体积212。导航控制器22可基于目标体积在视觉坐标系vis中的所确定位置诸如通过将所选择形状在深度图中的目标体积上居中并移除深度图的形状之外的区域来裁剪图8的实际深度

图,所述目标体积在视觉坐标系vis中的位置可指示目标体积在实际深度图中的位置。图7的预期深度图类似地限于所裁剪的实际深度图的尺寸和形状。

123.在框114和框116中,标识出深度图的未能与预期深度图匹配的部分。具体地,在框114中,可诸如通过计算实际深度图与预期深度图之间的差异来将实际深度图与预期深度图进行比较。导航控制器22可被配置为诸如经由视觉引擎80通过计算预期深度图和实际深度图中的每对对应的图像分量处的深度之间的差异来计算预期深度图与实际深度图之间的差异。预期深度图和实际深度图中一对对应的图像分量可包括每个深度图在同一水平和竖直定位处的图像分量。假设在框112中实际深度图已被裁剪为roi,则在框114中比较的深度图可以是所裁剪的深度图。

124.实际深度图与估计深度之间的差异可指示目标部位中的尚未标识和追踪的对象,诸如使用所附贴追踪器未能或不能充分追踪的对象(例如,软组织、外科医生的手)。所述差异可由差异深度图表示,其中差异深度图的每个图像分量指示针对位于实际深度图和预期深度图中的与差异深度图中的图像分量处于同一水平和竖直位置处的对应图像分量计算的深度差异。图10示出在图9的实际深度图与图7的预期深度图之间计算的差异深度图。

125.来自实际深度图和预期深度图的指示同一深度的对应图像分量将导致零深度差异,并且可与先前诸如使用追踪器和定位器18标识和追踪的对象相对应。零深度差异可在差异的深度图中由具有最大亮度或特定于零深度的颜色和/或色调的图像分量表示。在图10的差异深度图中,区域216、218和220表示来自实际深度图和预期深度图的具有零深度差异的对应图像分量。

126.实际深度图和预期深度图的不指示同一深度的对应图像分量将导致非零深度差异,并且可与先前未诸如使用追踪器和定位器18标识和追踪的对象相对应。非零深度差异可在差异的深度图中利用小于最大亮度的亮度或不同于特定于零深度的颜色和/或色调的颜色的图像分量来表示。在图10的差异深度图中,与区域216、218和210相邻的较暗区域表示实际深度图和预期深度图的具有非零深度差异的对应图像分量。

127.在框116中,可基于一个或多个对象阈值对所计算差异进行滤波。对象阈值可被设计为区分由于噪声或无关紧要的校准不准确而导致的非零差异和由于目标部位中存在另外的对象而导致的非零差异。对象阈值可包括但不限于阈值深度和/或最小大小阈值,它们中的每一者都可以是非零的。

128.作为实例,对于差异深度图的一个或多个非零区段中的每一个,导航控制器22可被配置为确定非零区段是否指示大于深度阈值的绝对深度。具体地,差异深度图可包括一个或多个非零区段,所述非零区段中的每一个包括一组连续图像分量,所述图像分量各自指示非零深度差异。如果由非零区段中的每个图像分量指示的非零深度差异的量值(不参考符号)大于深度阈值,则可认为差异深度图的非零区段具有大于深度阈值的绝对深度。响应于确定差异的非零区段指示大于阈值深度的绝对深度,导航控制器22可被配置为诸如借助于实际深度图的区段在实际深度图中处于与差异深度图中的非零区段相同的水平和竖直位置处来将实际深度图的与差异的非零区段相对应的区段标识为实际深度图的未能与估计深度图匹配的部分。

129.作为另一个实例,对于差异的每个非零区段,导航控制器22可被配置为确定非零区段的大小(例如,面积)是否大于最小大小阈值。响应于确定非零区段的大小大于最小大

小阈值,导航控制器22可被配置为诸如经由视觉引擎80诸如借助于实际深度图的区段在实际深度图中处于与差异深度图中的非零区段相同的水平和竖直位置处来将实际深度图的与差异的非零区段相对应的区段标识为实际深度图的未能与预期深度图匹配的部分。

130.在另一个实例中,导航控制器22可被配置为响应于确定非零区段的大小大于最小大小阈值并且非零区段指示大于阈值深度的绝对深度来将实际深度图的与差异的非零区段相对应的区段标识为实际深度图的未能与估计深度图匹配的部分。

131.在框118中,可基于经滤波的差异来确定目标部位中是否存在对象。具体地,导航控制器22可被配置为诸如经由视觉引擎80确定是否标识出实际深度图的与预期深度图不匹配的任何部分。如果否(框118的“否”分支),则方法100可返回到框106以再次使用定位器18检测追踪器附贴的对象的位置。如果是(框118的“是”分支),则方法100可进行到框120以通过将机器视觉技术应用于实际深度图的未能与预期深度图匹配的部分来识别目标部位中的对象。

132.在框120中,导航控制器22可被配置为诸如经由视觉引擎80将机器视觉技术应用于实际深度图的未能与预期深度图匹配的所标识部分以根据所标识部分识别目标部位中的对象。例如但不限于,导航控制器22可被配置为利用模式识别、边缘检测、颜色识别、波长分析、图像分量强度分析(例如,像素或体素强度分析)、深度分析和通过机器学习生成的度量以在实际深度图的所标识部分中表示的对象之间进行分割。作为一些实例,所标识部分的由边缘分隔的、具有不同规则图案、具有不同调色板和/或指示不同深度范围的区域可与不同对象相对应。作为另外的实例,目标部位中的不同对象(例如,不同组织)的表面可产生不同的波长和/或不同强度的信号,所述信号反射到视觉装置40并由视觉装置40检测到。视觉装置40可被配置为输出实际深度图的每个图像分量的此类信息,并且基于该信息,导航控制器22可被配置为基于跨实际深度图的所标识部分发生的变化的波长和/或信号强度对所标识部分中的不同对象进行分割。如果导航控制器22不能使用机器视觉发现所标识部分中的多个对象,则导航控制器22可被配置为将整个所标识部分视为目标部位中的单个对象。

133.除此之外或替代地,导航控制器22可被配置为诸如经由视觉引擎80诸如基于存储在导航控制器22中的模型数据82标识实际深度的所标识部分中的对象。标识与分割的不同之处可在于,标识可标识在实际深度图中表示的每个对象的描述对象类型的标签,诸如将对象标识为韧带、牵开器、表皮组织等。目标部位中的每个对象的标识可使导航控制器22诸如经由视觉引擎80能够对整个对象而不仅仅是对象的表面进行建模,并且能够更好地预测对象在手术程序期间的移动和其他反应,这可使导航控制器22的手术导航器81能够做出越来越明智的导航决定。

134.如上所述,存储在导航控制器22中的模型数据82可限定与目标部位中潜在存在的对象相对应的三维模型。模型数据82还可为目标部位中潜在存在的各种对象限定预定轮廓,每个轮廓阐明帮助导航控制器22根据实际深度图标识对象的特定于对象的一个或多个特征。例如,给定对象的轮廓可包括但不限于调色板、波长范围、信号强度范围、距离或深度范围、面积、体积、形状、偏振以及从与对象相对应的学习或统计模型输出的深度度量中的一者或多者。给定对象的轮廓还可包括对象的三维模型,诸如根据上述患者扫描生成的三维模型。

135.导航控制器22因此可被配置为基于实际深度图的未能与估计深度图匹配的所标识部分通过将所标识部分的至少一部分与预定义轮廓中的一个(即,与对象相对应的预定义轮廓)相匹配来标识对象。导航控制器22然后可被配置为将实际深度图的所标识部分的至少一部分标记为与轮廓相对应的特定对象,然后所述对象可被视为与定位器对象相邻。

136.在替代实例中,用户可与用户接口24交互以手动选择由导航控制器22分割的所标识部分的对象,和/或为所选择对象选择预定义轮廓。用户还可与用户接口24交互以手动追踪诸如在所标识部分中的由实际深度图表示的对象和/或为被追踪对象选择预定义轮廓。导航控制器22然后可被配置为利用与所选择的预定义轮廓相对应的标记来标记所选择的被分割或被追踪对象,并且被配置为相应地追踪所选择或被追踪对象。

137.在框122中,可在具有定位对象的公共坐标系诸如视觉坐标系vis或定位器坐标系lclz中确定根据实际深度图识别的每个对象的位置。例如,导航控制器22可被配置为诸如经由视觉引擎80确定根据深度图识别的每个对象的位置和每个定位对象在公共坐标系中相对于目标体积的位置,所述位置可由定位对象限定,使得导航控制器22可确定所识别对象和/或定位对象中的任一者是否对治疗目标体积构成障碍。

138.导航控制器22可被配置为基于使用定位器18在定位器坐标系lclz中检测到的定位对象的定位、所识别对象在实际深度图中的定位以及可由存储在导航控制器22中的转换数据83限定的定位器18与视觉装置40之间在公共坐标系中的位置关系来确定每个所识别对象相对于定位对象的位置。如先前所描述,所识别对象在实际深度图中的位置可指示所识别对象在视觉坐标系vis中的位置。例如,实际深度图的形成所识别对象的每个图像分量可表示从视觉装置40的中心视点到视觉坐标系vis中的位置的向量。每个图像分量在实际深度图的图像帧中的位置可指示向量的水平和竖直分量,并且由每个图像分量指示的深度可表示向量的深度分量。

139.导航控制器22因此可被配置为基于对象在实际深度图中的位置确定每个所识别对象在视觉部件系统vis中的位置,并且然后可被配置为使用定位器18与视觉装置40之间的位置关系、每个所识别对象在视觉坐标系vis中的位置和/或每个定位对象在定位器坐标系lclz中的位置来确定每个所识别对象相对于定位对象在公共坐标系中的位置。

140.在框124中,对于每个被追踪对象(包括根据实际深度图识别的对象和利用定位器18定位的对象),可诸如基于对象在公共坐标系中的所确定位置在公共坐标系中生成与所述对象相对应的虚拟边界。特别地,导航控制器22可被配置为诸如经由视觉引擎80在公共坐标系中生成虚拟边界以提供对诸如手术器械16的手术工具的运动的约束。为此,导航控制器22还可被配置为诸如利用定位器18在公共坐标系中追踪手术器械16的移动。由导航控制器22生成的虚拟边界可限定公共坐标系的手术器械16不应进入或靠近的区域,因为所述空间可能被包括敏感解剖结构和其他手术工具的其他对象占据。

141.例如,导航控制器22可被配置为根据定位对象在公共坐标系中的所确定位置来将针对每个定位对象存储的三维虚拟模型插入公共坐标系中。当存储在导航控制器22中的模型数据82为根据实际深度图的所标识部分识别的给定对象限定三维虚拟模型时,导航控制器22可被配置为根据给定的所识别对象在公共坐标系中的所确定位置来将三维虚拟模型插入公共坐标系中。除此之外或替代地,模型数据82可指示根据实际深度图的所标识部分识别的给定对象的一个或多个原始几何形状(例如,球体、圆柱体、长方体)。在这种情况下,

导航控制器22可被配置为基于对象的由实际深度图指示的表面形貌对所指示的原始几何形状进行大小设定和/或布置,并且被配置为根据给定对象在公共坐标系中的所确定位置来将大小设定的和/或布置的原始几何形状插入公共坐标系中。除此之外或替代地,诸如当没有为根据实际深度图的所标识部分识别的给定对象指示虚拟模型或原始几何形状时,导航控制器22可被配置为基于对象的在实际深度图中指示的表面形貌构造网格边界,并且被配置为根据给定对象在公共坐标系中的所确定位置来将网格边界插入公共坐标系中。

142.作为另一个实例,除了上述技术中的一个或多个之外或作为其替代,导航控制器22可被配置为通过根据给定对象在公共坐标系中的所确定位置将力粒子插入公共坐标系中来近似给定对象在公共坐标系中的边界。具体地,导航控制器22可被配置为选择所识别对象的表面上的各个点,并且被配置为在公共坐标系中将力粒子放置在各个点在公共坐标系中的所确定位置处。力粒子中的每一个可被配置为排斥在公共坐标系中靠近力粒子移动诸如进入预定距离内的其他对象。因此,在手术器械16在公共坐标系中的被追踪移动期间,力粒子可排斥手术器械16,从而防止手术器械16与由力粒子表示的对象碰撞。将与所识别对象的表面上的各个点而不是表示所识别对象的整个表面的虚拟边界相对应的力粒子插入公共坐标系中可导致使用相对减少的处理带宽和较少数据来生成对象的虚拟边界。

143.作为实例,图11至图13示出公共坐标系中的与目标部位200(图5)中的对象相对应的虚拟边界,所述对象可基于图10所示的差异根据图9的实际深度图的未能与图7的预期深度图匹配的所标识部分识别出来。具体地,图11在公共坐标系中示出与目标部位200中的牵开器208相对应的并且在实际深度图中描绘的牵开器虚拟模型,图12在公共坐标系中示出与目标部位200中的韧带204相对应的并且在实际深度图中描绘的韧带虚拟模型,并且图13在公共坐标系中示出与目标部位200中的表皮组织206相对应的并且在实际深度图中描绘的表皮组织虚拟模型。作为替代实例,目标部位200中的韧带204的虚拟边界可以是根据韧带204在公共坐标系中的所确定位置来插入公共坐标系中的原始几何对象的形式,诸如圆柱体,并且目标部位200中的表皮组织206的虚拟边界可以是以表皮组织206在公共坐标系中的所确定位置来插入公共坐标系中的网格表面或力粒子的形式。

144.图14示出根据实际深度图识别的对象和利用定位器18定位的患者的股骨f在公共坐标系中的相对位置。特别地,图示包括图11至图13的虚拟模型,并且患者的股骨f的虚拟模型210在图6中示出。在手术程序期间,导航控制器22可被配置为诸如经由手术导航器81显示图14的图示以及诸如利用定位器18追踪的手术器械16在公共坐标系中的当前位置处的手术器械16的图像或虚拟模型以帮助外科医生将手术器械16引导至目标体积202。

145.在框126中,可基于被追踪对象和/或手术计划84确定目标部位中是否存在潜在障碍物。具体地,导航控制器22可被配置为诸如经由手术导航器81基于对象相对于目标体积在公共坐标系中的位置以及手术计划84确定被追踪对象中的一个(诸如根据实际深度图识别的对象)是否是手术计划84的障碍物。例如,手术计划84可限定手术器械16的通过公共坐标系以治疗目标体积的计划轨迹。如果计划轨迹导致与被追踪对象的虚拟边界中的一个发生碰撞,则导航控制器22可被配置为确定存在障碍物。

146.响应于确定存在障碍物(框126的“是”分支),在框128中,可触发补救动作。导航控制器22可被配置为诸如经由手术导航器81通过执行若干可用动作中的一者或多者来触发补救动作。作为实例,响应于确定对象是手术计划84的障碍物,导航控制器22可被配置为更

改手术计划84以回避障碍物。例如,导航控制器22可被配置为更改手术器械16的轨迹以回避障碍物,并且被配置为将更改的手术计划84传输到操纵器控制器50以用于实现。作为另一个实例,导航控制器22可被配置为停止由手术导航系统12提供的手术引导和机器人操纵器14的移动,直到如由导航控制器22检测到的障碍物被清除。导航控制器22还可被配置为经由手术导航系统12的用户接口24触发障碍物的警报和/或通知。作为另一个实例,当导致障碍物的对象被标识为软组织时,导航控制器22可被配置为经由用户接口24提供软组织引导。例如,导航控制器22可被配置为示出导致障碍物的软组织对象相对于目标部位中的其他对象的位置,并且提供用于移动软组织以清除障碍物的建议。导航控制器22可被配置为在提供软组织引导的同时继续监测软组织在公共坐标系中的位置,并且在障碍物威胁被清除时向用户提供通知。

147.触发和/或克服补救动作(框128)后,或响应于未标识障碍物(框126的“否”分支),在框130中,可使用视觉装置40追踪根据实际深度识别的对象的移动。具体地,导航控制器22可被配置为诸如经由视觉引擎80通过被配置为进行以下项来追踪每个所识别对象的移动:在随后由视觉装置40生成的另外的实际深度图中,监测实际深度图的与所识别对象相对应的部分的状态。通过关注先前确定的实际深度图的与随后生成的深度图中的所识别对象相对应的部分的改变,而不是为每个随后生成的实际深度图生成预期深度图,计算预期深度图与随后的实际深度图之间的差异,并且将存储的轮廓与差异匹配,导航控制器22可能够监测所识别对象的以增加的速度前进的移动。

148.更特别地,实际深度图的与所识别对象相对应的每个部分可描绘特定于对象并且位于实际深度图的特定位置的特征的布置。例如但不限于,特征的布置可以是具有特定于对象的几何关系的顶点的布置、具有特定于对象的几何关系的边缘或线的布置、或具有特定于对象的相对和几何关系的深度的布置。此外,对象的特征的布置与对象的其余部分之间的空间关系可以是固定的。

149.导航控制器22因此可被配置为通过监测实际深度中的特定于对象的特征的布置是否移动到另外的深度图中的与实际深度图中的布置的位置不同的位置来监测根据实际深度图识别的对象的移动。如果是,则导航控制器22可被配置为基于与对象相对应的特征的布置在另外的深度图中的新位置确定对象在公共坐标系中的新位置,并且被配置为相应地更新公共坐标系中的与对象相关联的虚拟边界。用于监测给定对象的移动的特征的布置可在对象的模型数据82中指示,或者可由用户通过使用用户接口24选择实际深度图的与对象相对应的部分中的点来手动设置。

150.例如,图15示出在生成图9所示的实际深度图之后随后由视觉装置40生成的另外的实际深度图。图15中的另外的深度图的表示牵开器208(图5)的部分的位置与该部分在图9的深度图中的位置不同,从而指示牵开器208已移动。导航控制器22可被配置为通过监测另外的深度图中的特定特征布置相对于先前实际深度图的改变位置来追踪牵开器208的这种移动,所述特征特定布置在表示牵开器208的部分中并且相对于牵开器208的其余部分在位置上是固定的。例如,导航控制器22可监测另外的深度图以了解牵开器208的头部和主体之间的顶点222的布置的位置的变化。

151.响应于确定顶点222的布置的位置的变化,导航控制器22可被配置为基于顶点222的布置在图15的另外的深度图中的所更新位置以及顶点222的布置与牵开器208的其余部

分之间的固定位置关系确定牵开器208在公共坐标系中的所更新位置。导航控制器22然后可被配置为基于所更新位置调节公共坐标系中的与牵开器208相关联的虚拟边界。图16示出根据图15的另外的深度图中所描绘的顶点222的布置的新位置的牵开器208的虚拟边界(即,与牵开器208相对应的虚拟模型)在公共坐标系中的所更新位置。

152.本文公开了使用机器视觉和基于追踪器的定位的组合来追踪手术工作空间中的对象的系统和方法。由于软组织诸如肌肉、皮肤和韧带的柔性性质,基于追踪器的定位通常不足以追踪软组织。因此,除了使用基于追踪器的定位来检测手术工作空间中的刚性对象的位置之外,手术导航系统还可包括被配置为生成手术工作空间中的暴露表面的深度图的视觉装置。手术导航系统可进一步被配置为基于使用定位检测到的目标部位中的对象的位置、与对象相对应的虚拟模型以及定位器与视觉装置之间在公共坐标系中的位置关系来生成视觉装置的预期深度图。手术导航系统然后可被配置为标识实际深度图的未能与估计深度图匹配的部分,并且被配置为基于所标识部分识别目标部位中的对象,包括软组织。手术导航系统然后可被配置为确定对象是否构成当前手术计划的障碍物。

153.通常,为了实现本发明的实施方案而执行的例程,无论是作为操作系统的一部分还是作为特定应用程序、部件、程序、对象、模块或指令序列,或者甚至其子集来实现的例程都可作为“计算机程序代码”或简称为“程序代码”在本文中提及。程序代码通常包括在不同时间驻留在计算机中的各种存储器和存储装置中的计算机可读指令,并且所述计算机可读指令在由计算机中的一个或多个处理器读取和执行时,致使该计算机执行实行体现本发明的实施方案的各个方面的操作和/或要素所必需的操作。用于执行本发明的实施方案的操作的计算机可读程序指令可以是例如汇编语言或以一种或多种编程语言的任意组合编写的源代码或目标代码。

154.本文描述的各种程序代码可基于其在本发明的特定实施方案中实现的应用程序来标识。然而,应当了解,以下所使用的任何特定的程序命名法仅仅是为了方便起见,并且因此本发明不应该限于仅在这种命名法所标识和/或所暗示的任何特定应用程序中使用。此外,考虑到计算机程序可被组织成例程、规程、方法、模块、对象等的方式以及可在驻留在典型计算机内的各种软件层(例如,操作系统、库、api、应用程序、小程序等)之间分配程序功能的各种方式通常是无穷无尽的,应当了解,本发明的实施方案不限于本文描述的程序功能的特定组织和分配。

155.体现在本文描述的任何应用程序/模块中的程序代码能够以多种不同形式作为程序产品单独或共同分发。特别地,可使用计算机可读存储介质来分发程序代码,所述计算机可读存储介质在其上具有用于致使处理器执行本发明的实施方案的方面的计算机可读程序指令。

156.固有非暂时性的计算机可读存储介质可包括在任何方法或技术中实现的用以存储信息诸如计算机可读指令、数据结构、程序模块或其他数据的易失性和非易失性介质以及可移动和不可移动介质。计算机可读存储介质还可包括ram、rom、可擦除可编程只读存储器(eprom)、电可擦除可编程只读存储器(eeprom)、快闪存储器或其他固态存储器技术、便携式光盘只读存储器(cd-rom)或其他光学存储装置、磁带盒、磁带、磁盘存储装置或其他磁存储装置或可用于存储所需信息并可由计算机读取的任何其他介质。计算机可读存储介质不应被解释为瞬态信号本身(例如,无线电波或其他传播的电磁波、通过诸如波导的传输介

质传播的电磁波或通过电线传输的电信号)。计算机可读程序指令可从计算机可读存储介质下载到计算机、另一种类型的可编程数据处理设备或另一个装置,或者经由网络下载到外部计算机或外部存储装置。

157.存储在计算机可读介质中的计算机可读程序指令可用于指导计算机、其他类型的可编程数据处理设备或其他装置以特定方式运行,使得存储在计算机可读介质中的指令产生包括实现在流程图、序列图和/或框图中指定的功能、动作和/或操作的指令的制品。计算机程序指令可提供给通用计算机、专用计算机或其他可编程数据处理设备的一个或多个处理器以产生机器,使得经由一个或多个处理器执行的指令致使执行一系列计算以实现在流程图、序列图和/或框图中指定的功能、动作和/或操作。

158.在某些替代实施方案中,在流程图、序列图和/或框图中指定的功能、动作和/或操作可与本发明的实施方案一致地重新排序、串行处理和/或并发处理。此外,流程图、序列图和/或框图中的任一者可包括比与本发明的实施方案一致的那些图示多或少的框。

159.本文所使用的术语仅仅是为了描述特定实施方案,并且并不旨在限制本发明的实施方案。如本文所用,单数形式“一个”、“一种”和“所述”也旨在包括复数形式,除非上下文另外明确指示。还应当理解,术语“包括(comprises)”和/或“包括(comprising)”,当在本说明书中使用时,指定存在陈述的特征、整体、步骤、操作、元件和/或部件,但是并不排除存在或添加一个多个其他特征、整体、步骤、操作、元件、部件和/或其群组。此外,如果在具体实施方式或权利要求书中使用了术语“包括”、“具有(having)”、“具有(has)”、“拥有”、“由

……

组成”或其变体,则此类术语旨在以与术语“包括”类似的方式包含。

160.虽然已经通过对各种实施方案的描述来说明本发明的所有内容,并且虽然已经对这些实施方案进行了相当详细的描述,但是本技术人不意欲将所附权利要求书的范围限定或以任何方式限制于此类细节。本领域技术人员将很容易理解其他优点和修改。因此,本发明在其更广泛的方面不限于所示和所述的具体细节、代表性设备和方法以及说明性实例。因此,可在不背离本技术人的总体发明概念的精神或范围的情况下偏离此类细节。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1