基于全注意力机制的多模态抑郁症检测方法和系统

1.本发明涉及抑郁症检测技术领域,具体涉及一种基于全注意力机制的多模态抑郁症检测方法、系统、存储介质和电子设备。

背景技术:

2.抑郁症是现在最常见的一种心理疾病,以连续且长期的心情低落为主要的临床特征,是现代人心理疾病最重要的类型。

3.目前,抑郁症检测现主要通过两种技术:第一,基于单模态(采用文本、语音、视觉中的一个信息源),例如通过对视频中用户的个体步态进行分析,采集关键数据并提取特征,用自己搭建的模型进行抑郁症检测。第二,基于多模态(采用文本、语音、视觉中的多个信息源),例如采集用户语音、文本等多种信息,进行特征提取和融合,用自己搭建的模型进行抑郁症检测。

4.虽然上述基于多模态方式相对于基于单模态式方式,较为全面地反映了患者的抑郁状况,但是其使用数据集部分仅为模拟数据,数据来源的真实性和数据质量无法得到保证,进而影响了最终检测结果的准确性。

技术实现要素:

5.(一)解决的技术问题

6.针对现有技术的不足,本发明提供了一种基于全注意力机制的多模态抑郁症检测方法、系统、存储介质和电子设备,解决了检测结果不准确的技术问题。

7.(二)技术方案

8.为实现以上目的,本发明通过以下技术方案予以实现:

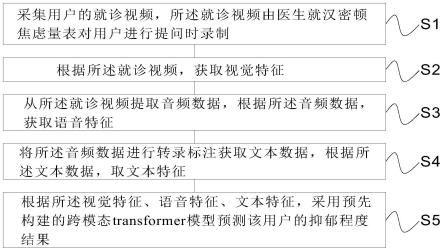

9.一种基于全注意力机制的多模态抑郁症检测方法,包括:

10.采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;

11.根据所述就诊视频,获取视觉特征;

12.从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;

13.将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;

14.根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。

15.优选的,所述视觉特征包括视频帧序列、人脸关键点二值图、复杂情绪序列、肢体活跃度序列以及注视角热力图中的一种或者几种任意组合;获取过程包括:

16.采用openface工具包对所述就诊视频进行抽帧,获取所述视频帧序列;

17.并对每一帧中的的用户进行人脸检测和人脸对齐,提取出2d人脸关键点和对齐后的人脸图片,将人脸关键点绘制在纯黑色背景上获取所述人脸关键点二值图;

18.将对齐后的人脸图片输入emonet模型,对用户的效价和唤醒二维情绪进行预测,

得到基础情绪,再通过预设的va环形模型将基础情绪映射为复杂情绪向量,获取所述复杂情绪序列;

19.采用飞桨框架的实时关键点检测模型提取用户的身体关键点,将身体关键点坐标转化为向量,分别计算鼻子、四肢向量的变化模长,组成所述肢体活跃度序列;

20.采用openface工具包提取用户的视线、头部姿态特征,将提取出的特征转换成眼睛凝视序列,并根据眼睛凝视序列得到热力图的边界和中心点,去除遍历中心点最远的部分点后,使用八邻域法将眼睛凝视序列转换成所述注视角热力图。

21.优选的,所述根据所述音频数据,获取语音特征,包括:

22.首先对所述音频数据进行了文本转录,标注了音频中每一句话的说话角色、起止时间、持续时间、文本内容;再根据标注的起止时间将录音中用户回答医生的语音数据切分出来;最终采用开源工具opensmile提取所述语音特征。

23.优选的,所述根据所述文本数据,取文本特征,包括:

24.预先根据回答信息的有效性构建停止词典;

25.根据所述停止词典清洗了数据,获取包含有效信息的文本内容;

26.采用chinese-roberta模型将文本内容转换为文本特征。

27.优选的,所述根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果,包括:

28.s51、根据起始时间和终止时间截取相应的视觉特征,完成所述视觉特征、语音特征和文本特征在时间维度上的对齐;

29.s52、将所述视频帧序列、人脸关键点二值图以及注视角热力图划分为三维视觉特征;将所述复杂情绪序列、肢体活跃度序列以及语音特征划分为一维时序特征;

30.s53、根据所述三维视觉特征、一维时序特征和文本特征,引入可学习矩阵,获取各自对应且维度相同的初始语义特征;

31.s54、将所述三维视觉特征、一维时序特征和文本特征对应的初始语义特征,结合位置编码信息,获取各自对应的高级语义特征;包括:

32.z0=[x0wp;x1w

p

;...;xnw

p

]+e

pos

[0033]

其中,x0,x1…

,xn依次表示某类特征的各个patch;w

p

表示可学习矩阵;e

pos

表示位置编码;

[0034]

随后将z0输入由l个transformer encoder模块堆叠而成的模型中进行高级语义特征提取,

[0035]z′

l

=mha(ln(z

l-1

))+z

l-1

,l=1...l

[0036]zl

=mlp(ln(z

′

l

))+z

′

l

,l=1...l

[0037]zout

=ln(z

l

)

[0038]

其中,mha代表multi-head-attention;mlp代表多层感知机;ln代表layer normaliztion;l代表transformer encoder的总个数,l代表第l块transformer encoder;z

′

l

表示对上一层的输出z

l-1

执行ln和mha后再加上上一层的输出z

l-1

所得到的结果;z

l

表示对z

′

l

执行ln和mlp后再加上z

′

l

所得到的结果,z

out

表示对z

l

做ln所得到的结果;

[0039]

s55、融合所述三维视觉特征、一维时序特征和文本特征对应的高级语义特征;包括:

[0040]

将视觉特征和音频特征的模型输出投影到文本特征空间得到zv→

t

、za→

t

:

[0041][0042][0043]

将投影到语音特征空间得到z

t

→a、zv→a;

[0044][0045][0046]

将投影到视觉特征空间得到z

t

→v、za→v;

[0047][0048][0049]

其中,

[0050][0051][0052][0053][0054][0055]

其中,wk为可学习的矩阵,d为特征的长度,k=1,2,3时分别代表video、audio、text;

[0056]

将同一特征空间中的信息进行拼接得到y

t

、ta、yv,过程如下:

[0057]yt

=[zv→

t

,za→

t

]

[0058]

ta=[z

t

→a,zv→a]

[0059]yv

=[z

t

→v,za→v]

[0060]

将y

t

、ya、yv分别送入transformer编码块中得到各自的输出y

′

t

、y

′a、y

′v;

[0061]

s56、拼接所述y

′

t

、y

′a、y

′v得到y

′

=[y

′

t

、y

′a、y

′v],最后将y

′

通过全连接层输出该用户的抑郁程度的预测结果。

[0062]

优选的,所述s52具体包括:

[0063]

s521、将各个三维视觉特征video切分为若干三维patch:

[0064][0065]

其中,

[0066]

i=1,2,3时分别表示所述视频帧序列、人脸关键点二值图、注视角热力图;t、h、w分别代表一个三维视觉特征的图像帧长、帧高和帧宽,t、h、w分别代表一个三维视觉特征patch的图像帧长、高度和宽度;3代表每一帧图片的rgb三通道;3dpatchpartition表示将video

clip

通过3d卷积切分为若干video

patch

;

[0067]

引入可学习的矩阵w

vp

∈r

t

·h·w·3×d,投影得到每个patch的d维特征x

video

:

[0068]

x

video

=flatten(video

patch

)*w

vp

[0069]

其中,flatten表示合并video

patch

的前三个维度;

[0070]

s522、将各个一维时序特征audio进行分段,其中一维时序特征长度为1

×

t

′

;每个片段长度是,j=1,2,3时分别表示所述肢体活跃度时序、复杂情绪时序、语音特征;

[0071]

引入可学习的矩阵w

ap

∈r

t

′×d,投影得到每个片段的d维特征x

audio

:

[0072]

x

audio

=audio

seg

*w

ap

[0073]

s523、将文本特征text的每一单词,根据预设的词汇表映射成词向量;

[0074]

引入可学习的矩阵w

tp

∈rv×d,投影得到每个词向量的d维特征x

text

:

[0075]

x

text

=word

vec

*w

tp

[0076]

其中,word

vec

表示one-hot词向量。

[0077]

优选的,所述s56中将y

′

通过一层大小为17的全连接层,对汉密顿抑郁量表的17项分数进行预测;然后将17个神经元输出输入大小为4的全连接层,对抑郁程度做4分类任务,获取该用户的抑郁程度的预测结果。

[0078]

一种基于全注意力机制的多模态抑郁症检测系统,包括:

[0079]

采集模块,用于采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;

[0080]

第一获取模块,用于根据所述就诊视频,获取视觉特征;

[0081]

第二获取模块,用于从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;

[0082]

第三获取模块,用于将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;

[0083]

预测模块,用于根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。

[0084]

一种存储介质,其存储有用于基于跨模态transformer的多模态抑郁症检测的计算机程序,其中,所述计算机程序使得计算机执行如上所述的多模态抑郁症检测方法。

[0085]

一种电子设备,包括:

[0086]

一个或多个处理器;

[0087]

存储器;以及

[0088]

一个或多个程序,其中所述一个或多个程序被存储在所述存储器中,并且被配置成由所述一个或多个处理器执行,所述程序包括用于执行如上所述的多模态抑郁症检测方法。

[0089]

(三)有益效果

[0090]

本发明提供了一种基于跨模态transformer的多模态抑郁症检测方法、系统、存储介质和电子设备。与现有技术相比,具备以下有益效果:

[0091]

本发明中,采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;根据所述就诊视频,获取视觉特征;从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。数据采集结合了具有良好应用信度的汉密顿抑郁量表,全面采集了视频模态、音频模态、文本模态的数据,以及考虑了跨模态特征信息,补充了不同模态之间的潜在联系,用于对用户抑郁症状进行刻画评估,诊断结果更准确。

附图说明

[0092]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0093]

图1为本发明实施例提供的一种基于跨模态transformer的多模态抑郁症检测方法的流程示意图

[0094]

图2本发明实施例提供的一种va环形映射模型示意图。

具体实施方式

[0095]

为使本发明实施例的目的、技术方案和优点更加清楚,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0096]

本技术实施例通过提供一种基于跨模态transformer的多模态抑郁症检测方法、系统、存储介质和电子设备,解决了检测结果不准确的技术问题。

[0097]

本技术实施例中的技术方案为解决上述技术问题,总体思路如下:

[0098]

本发明实施例中,采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;根据所述就诊视频,获取视觉特征;从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模

态transformer模型预测该用户的抑郁程度结果。数据采集结合了具有良好应用信度的汉密顿抑郁量表,全面采集了视频模态、音频模态、文本模态的数据,以及考虑了跨模态特征信息,补充了不同模态之间的潜在联系,用于对用户抑郁症状进行刻画评估,诊断结果更准确。

[0099]

为了更好的理解上述技术方案,下面将结合说明书附图以及具体的实施方式对上述技术方案进行详细的说明。

[0100]

实施例:

[0101]

如图1所示,本发明实施例提供了一种基于全注意力机制的多模态抑郁症检测方法,包括:

[0102]

s1、采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;

[0103]

s2、根据所述就诊视频,获取视觉特征;

[0104]

s3、从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;

[0105]

s4、将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;

[0106]

s5、根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。

[0107]

本发明实施例中数据采集结合了具有良好应用信度的汉密顿抑郁量表,全面采集了视频模态、音频模态、文本模态的数据,以及考虑了跨模态特征信息,补充了不同模态之间的潜在联系,用于对用户抑郁症状进行刻画评估,诊断结果更准确。

[0108]

下面将详细介绍上述技术方案的各个步骤:

[0109]

首先需要说明的是,本发明实施例采用汉密顿抑郁量表总分作为抑郁症鉴别指标。汉密顿抑郁量表共17项,根据总分将抑郁症状划分为五类:7分以下为正常、7~14分可能有抑郁症、14~21分肯定有抑郁症、21分~29分有明显抑郁,29分以上可能为严重抑郁。

[0110]

汉密顿抑郁量表的总分能够很好的反映用户的抑郁程度,在临床上有良好的应用信度。本发明实施例采集了医生就汉密顿抑郁量表对就诊者进行提问的视频、录音数据,由专业的心理医生对就诊者的回答状况进行打分,由此得到每一个就诊者用户的汉密顿抑郁量表分数和抑郁程度,并将该汉密顿抑郁量表分数和抑郁程度用于训练跨模态transformer的标签。

[0111]

s1、采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制。

[0112]

s2、根据所述就诊视频,获取视觉特征。

[0113]

抑郁症患者常常表现出心情低落、自卑、思维迟缓、行动消沉等现象,在视觉上异于常人。所以本技术想到,可以捕捉以上现象所反应出的多种视觉特征,丰富多模态特征,以此提高抑郁症检测的准确度。

[0114]

因此,上述视觉特征包括视频帧序列、人脸关键点二值图、复杂情绪序列、肢体活跃度序列以及注视角热力图中的一种或者几种任意组合。

[0115]

获取过程包括:

[0116]

采用openface工具包对所述就诊视频进行抽帧,获取所述视频帧序列;

[0117]

并对每一帧中的的用户进行人脸检测和人脸对齐,提取出2d人脸关键点和对齐后的人脸图片,将人脸关键点绘制在纯黑色背景上获取所述人脸关键点二值图;

[0118]

将对齐后的人脸图片输入emonet模型,对用户的效价和唤醒二维情绪进行预测,得到基础情绪,再通过如图2所示,预设的va环形模型将基础情绪映射为复杂情绪向量,获取所述复杂情绪序列;

[0119]

采用飞桨框架的实时关键点检测模型提取用户的身体关键点,将身体关键点坐标转化为向量,分别计算鼻子、四肢向量的变化模长,组成所述肢体活跃度序列;

[0120]

采用openface工具包提取用户的视线、头部姿态特征,将提取出的特征转换成眼睛凝视序列,并根据眼睛凝视序列得到热力图的边界和中心点,去除遍历中心点最远的部分点后,使用八邻域法将眼睛凝视序列转换成所述注视角热力图。

[0121]

s3、从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征。

[0122]

抑郁症患者表现出的心情低落、反应迟缓等现象除了有视觉特征之外,还会通过声音(语调、语速等)表现出来。我们认为采集到的语音数据同时包含有效信息。

[0123]

所述s3具体包括:

[0124]

首先对所述音频数据进行了文本转录,标注了音频中每一句话的说话角色、起止时间、持续时间、文本内容;再根据标注的起止时间将录音中用户回答医生的语音数据切分出来;最终采用开源工具opensmile提取所述语音特征。

[0125]

s4、将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;包括:

[0126]

s41、预先根据回答信息的有效性构建停止词典,具体包括:

[0127]

停止词典的设定标准为:文本含义是否提供足够有效信息以帮助判断,例如:当医生提问用户是否失眠时,若用户回答仅为:“嗯”或“是”时,这句回答在无上下文的情况下就未提供足够信息,但是,若用户的回答详细描述了自己的失眠情况或未失眠情况时,即使没有上下文,也可以了解到用户的睡眠情况,此时,用户的回答是包含有效信息的。根据此条标准,整理出一个停止词典,其中包含“嗯。”、“是。”、“有。”、“没有。”等回答。当用户的回答出现在停止词典中时,将这句回答剔除,例如,当用户的回答仅为:“嗯。”时,则将这句回答剔除。

[0128]

s42、根据所述停止词典清洗了数据,获取包含有效信息的文本内容;

[0129]

s43、采用chinese-roberta模型将文本内容转换为文本特征。

[0130]

s5、根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。

[0131]

本发明实施例采用深度学习技术,以跨模态transformer为核心结构,结合上述标签数据,具体采用有监督式学习方式构建所述跨模态transformer模型。

[0132]

所述s5具体包括:

[0133]

s51、根据起始时间和终止时间截取相应的视觉特征,完成所述视觉特征、语音特征和文本特征在时间维度上的对齐;

[0134]

s52、将所述视频帧序列、人脸关键点二值图以及注视角热力图划分为三维视觉特征;将所述复杂情绪序列、肢体活跃度序列以及语音特征划分为一维时序特征;具体包括:

[0135]

所述s52具体包括:

[0136]

s521、将各个三维视觉特征video切分为若干三维patch:

[0137][0138]

其中,

[0139]

i=1,2,3时分别表示所述视频帧序列、人脸关键点二值图、注视角热力图;t、h、w分别代表一个三维视觉特征的图像帧长、帧高和帧宽,t、h、w分别代表一个三维视觉特征patch的图像帧长、高度和宽度;3代表每一帧图片的rgb三通道;3dpatchpartition表示将video

clip

通过3d卷积切分为若干video

patch

;

[0140]

引入可学习的矩阵w

vp

∈r

t

·h·w·3×d,投影得到每个patch的d维特征x

video

:

[0141]

x

video

=flatten(video

patch

)*w

vp

[0142]

其中,flatten表示合并video

patch

的前三个维度;

[0143]

s522、将各个一维时序特征audio进行分段,其中一维时序特征长度为1

×

t

′

;每个片段长度是,j=1,2,3时分别表示所述肢体活跃度时序、复杂情绪时序、语音特征;

[0144]

引入可学习的矩阵w

ap

∈r

t

′×d,投影得到每个片段的d维特征x

audio

:

[0145]

x

audio

=audio

seg

*w

ap

[0146]

s523、将文本特征text的每一单词,根据预设的词汇表映射成词向量;

[0147]

引入可学习的矩阵w

tp

∈rv×d,投影得到每个词向量的d维特征x

text

:

[0148]

x

text

=word

vec

*w

tp

[0149]

其中,word

vec

表示one-hot词向量。

[0150]

s53、根据所述三维视觉特征、一维时序特征和文本特征,引入可学习矩阵,获取各自对应且维度相同的初始语义特征;

[0151]

s54、将所述三维视觉特征、一维时序特征和文本特征对应的初始语义特征,结合位置编码信息,获取各自对应的高级语义特征;包括:

[0152]

z0=[x0w

p

;x1w

p

;...;xnw

p

]+e

pos

[0153]

其中,x0,x1…

,xn依次表示某类特征的各个patch;w

p

表示可学习矩阵;e

pos

表示位置编码;

[0154]

随后将z0输入由l个transformer encoder模块堆叠而成的模型中进行高级语义特征提取,

[0155]z′

l

=mha(ln(z

l-1

))+z

l-1,

l=1...l

[0156]zl

=mlp(ln(z

′

l

))+z

′

l

,l=1...l

[0157]zout

=ln(z

l

)

[0158]

其中,mha代表multi-head-attention;mlp代表多层感知机;ln代表layer normaliztion;l代表transformer encoder的总个数,l代表第l块transformer encoder;z

′

l

表示对上一层的输出z

l-1

执行ln和mha后再加上上一层的输出z

l-1

所得到的结果;z

l

表示对z

′

l

执行ln和mlp后再加上z

′

l

所得到的结果,z

out

表示对z

l

做ln所得到的结果;

[0159]

s55、融合所述三维视觉特征、一维时序特征和文本特征对应的高级语义特征;包括:

[0160]

将视觉特征和音频特征的模型输出投影到文本特征空间得到zv→

t

、za→

t

:

[0161][0162][0163]

将投影到语音特征空间得到z

t

→a、zv→a;

[0164][0165][0166]

将投影到视觉特征空间得到z

t

→v、za→v;

[0167][0168][0169]

其中,

[0170][0171][0172][0173][0174][0175]

其中,wk为可学习的矩阵,d为特征的长度,k=1,2,3时分别代表video、audio、text;

[0176]

将同一特征空间中的信息进行拼接得到y

t

、ta、yv,过程如下:

[0177]yt

=[zv→

t

,za

→

t

]

[0178]

ta=[z

t

→a,zv→a]

[0179]yv

=[z

t

→v,za→v]

[0180]

将y

t

、ta、yv分别送入transformer编码块中得到各自的输出y

′

t

、y

′a、y

′v;

[0181]

s56、拼接所述y

′

t

、y

′a、y

′v得到y

′

=[y

′

t

、y

′a、y

′v],最后将y

′

通过全连接层输出该用户的抑郁程度的预测结果。

[0182]

该步骤中具体将y

′

通过一层大小为17的全连接层,对汉密顿抑郁量表的17项分数进行预测;然后将17个神经元输出输入大小为4的全连接层,对抑郁程度做4分类任务,获取该用户的抑郁程度的预测结果。

[0183]

本发明实施例与抑郁量表结合,不仅采用了传统多模态抑郁症检测方法中的特征,还提取了与抑郁症患者状态更加贴合的特征,能够提供更加全面的诊断结果。

[0184]

应用过程中,本发明实施例还将模型输出的多模态高级语义特征进行深层次特征融合,更好的完善了不同模态之间的潜在联系,能够提供更加准确的诊断结果。

[0185]

本发明实施例提供了一种基于全注意力机制的多模态抑郁症检测系统,包括:

[0186]

采集模块,用于采集用户的就诊视频,所述就诊视频由医生就汉密顿抑郁量表对用户进行提问时录制;

[0187]

第一获取模块,用于根据所述就诊视频,获取视觉特征;

[0188]

第二获取模块,用于从所述就诊视频提取音频数据,根据所述音频数据,获取语音特征;

[0189]

第三获取模块,用于将所述音频数据进行转录标注获取文本数据,根据所述文本数据,取文本特征;

[0190]

预测模块,用于根据所述视觉特征、语音特征、文本特征,采用预先构建的跨模态transformer模型预测该用户的抑郁程度结果。

[0191]

本发明实施例提供了一种存储介质,其存储有用于基于跨模态transformer的多模态抑郁症检测的计算机程序,其中,所述计算机程序使得计算机执行如上所述的多模态抑郁症检测方法。

[0192]

本发明实施例还提供了一种电子设备,包括:

[0193]

一个或多个处理器;

[0194]

存储器;以及

[0195]

一个或多个程序,其中所述一个或多个程序被存储在所述存储器中,并且被配置成由所述一个或多个处理器执行,所述程序包括用于执行如上所述的多模态抑郁症检测方法。

[0196]

可理解的是,本发明实施例提供的基于跨模态transformer的多模态抑郁症检测系统、存储介质和电子设备与本发明实施例提供的基于跨模态transformer的多模态抑郁症检测方法相对应,其有关内容的解释、举例和有益效果等部分可以参考多模态抑郁症检测方法中的相应部分,此处不再赘述。

[0197]

综上所述,与现有技术相比,具备以下有益效果:

[0198]

1、本发明实施例中数据采集结合了具有良好应用信度的汉密顿抑郁量表,全面采集了视频模态、音频模态、文本模态的数据,以及考虑了跨模态特征信息,补充了不同模态之间的潜在联系,用于对用户抑郁症状进行刻画评估,诊断结果更准确。

[0199]

2、本发明实施例与抑郁量表结合,不仅采用了传统多模态抑郁症检测方法中的特征,还提取了与抑郁症患者状态更加贴合的特征,能够提供更加全面的诊断结果。

[0200]

3、应用过程中,本发明实施例还将模型输出的多模态高级语义特征进行深层次特

征融合,更好的完善了不同模态之间的潜在联系,能够提供更加准确的诊断结果。

[0201]

需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

[0202]

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1