一种高原智能预供氧方法

1.本发明涉及氧气控制技术领域,具体涉及一种高原智能预供氧方法。

背景技术:

2.高原环境下氧分压和氧含量较低,容易造成人体生理变化,发生高原反应。当人处于氧气浓度为15%~19%的环境中时,工作效率会降低,并可导致头部、肺部和循环系统出现问题;当氧气浓度为8%~10%时,会导致人体意识模糊、昏厥、脸色苍白、嘴唇发紫以及恶心呕吐等表现。同时持续低氧将加速引发肺水肿和脑水肿等相关病理进展,甚至威胁人员生命,在使用便携式供氧设备外出作业时,由于人工操作和机械控制导致的氧气浪费会缩短供氧时长,并增加缺氧带来的健康风险和生命威胁。相关研究对于高原(尤其是外出作业的)人员持续有效吸氧,以及其健康状态的保障具有重要意义。

3.现有的同步呼吸供氧方法,虽然能够做到利用二位三通电磁阀实现对呼吸气道的分离,以及对高压气流的稳压,然后通过监测人体呼吸特征,实现呼吸跟随式的供氧,但该研究仅能保证在跟随呼吸信号进行供氧过程时的精确性,而供氧过程无法做到真正的与呼吸同步。而部分现有技术虽然提出了基于人体呼吸肌施加努力水平的变化实现对供氧过程的分段控制,通过对气道参数的计算获得混合压力信号,并进一步确定呼吸过程的峰值瞬态和负瞬态,之后通过呼吸状态转换的时间比率计算负瞬态向瞬态转换的时刻,并进行及时供氧,而具体供氧量根据气道混合压力计算得到,但该方法仅利用人体的呼吸参数,其信号本身具有明显的滞后特点,并不适合用于及时供氧参数的计算源数据。此外,还有一些供氧设备,利用血氧监测仪监测人体实时血氧水平,并经由主控单元实现对供氧装置的自动控制,但该研究没有提供执行细节的实现与核心方法的进一步展开,如,如何基于血氧数据计算计算人类缺氧状态,以及如何克服数据计算耗时造成的供氧过程滞后。

技术实现要素:

4.本发明的目的在于提供一种高原智能预供氧方法,以解决现有的因为数据计算耗时造成的供氧过程滞后的问题。

5.本发明解决上述技术问题的技术方案如下:

6.本发明提供一种高原智能预供氧方法,所述高原智能预供氧方法包括:

7.s1:获取原始高原供氧相关数据;

8.s2:对所述原始高原供氧相关数据进行预处理,得到供氧相关数据;

9.s3:根据所述供氧相关数据,建立呼吸参数短期预测模型;

10.s4:根据所述呼吸参数短期预测模型,生成呼吸参数的编码解码网络;

11.s5:利用所述呼吸参数的编码解码网络,将时间序列数据解码为用户状态时间序列数据;

12.s6:对所述用户状态时间序列数据进行数据处理,得到处理结果;

13.s7:利用所述处理结果建立供氧参数预测算法;

14.s8:根据所述供氧参数预测算法、所述供氧相关数据,得到呼吸参数预测结果。

15.可选择地,所述步骤s1中,所述原始供氧相关数据包括:生理与缺氧状态源数据、环境参数源数据、运动状态源数据和呼吸数据源数据。

16.可选择地,所述步骤s2包括:

17.s21:判断所述原始供氧相关数据是否包括无状态标签的呼吸数据,若是,进入步骤s22;否则,进入步骤s23;

18.s22:移除所述无状态标签的呼吸数据后进入步骤s23;

19.s23:判断所述当前原始供氧相关数据是否包括异常数据,若是,进入步骤s24;否则,进入步骤s25;

20.s24:将所述异常数据替换为所述当前原始供氧相关数据中的最大正常数据和/或最小正常数据,以形成新的原始供氧相关数据后进入步骤s25;

21.s25:判断所述当前原始相关数据是否发生基线漂移,若是,进入步骤s26;否则,进入步骤s27;

22.s26:对所述当前原始相关数据进行数据归一化处理,并重新计算处理后的所述当前原始相关数据的基线,之后进入步骤s27;

23.s27:判断当前原始相关数据是否为离散数据,若是,则为其创建模糊集和数据插值并返回步骤s27;否则,将所述当前原始相关数据作为所述供氧相关数据输出。

24.可选择地,所述步骤s3包括:

25.s31:获取所述原始供氧相关数据;

26.s32:根据所述原始供氧相关参数,建立所述环境参数和所述人体生理参数的响应映射关系;

27.s33:利用所述响应映射关系,得到所述供氧参数预测算法对所述供氧相关参数的预测结果。

28.本发明的核心目标是提供一种具有预测能力的智能预供氧算法,以解决现有供氧设备和算法无法根据人类生理参数感知并预测其实时需氧状态的问题,并实现提前供氧,防止高原缺氧引起的进一步病理进展。

29.为了实现上述目标,本发明提供了如下技术方案:

30.本发明公开了一种基于lstm网络和编解码器网络的智能供氧参数智能预测算法,该算法包含两个层次的网络设计:(1)先对来自传感器的源数据进行预处理,使用其底层融合了一维卷积模块的长短期记忆网络提取人体生理参数、呼吸参数和环境参数的局部特征,结合训练集数据的状态标签,实现该算法对“外部参数-人体响应”映射关系的理解,进而实现呼吸参数的短时预测。(2)基于lstm构建的编码器网络这种端到端的神经网络模型,用于将外部参数时间序列数据解码为人的状态时间序列数据,实现中长期的呼吸状态(和供氧参数)的预测。

31.本发明将lstm与编解码器技术融合,使用人体血氧、心率、呼吸等生理参数和环境参数作为基础数据集,以人的评估结果作为状态标签数据,通过对上述数据的归一化、向量化处理和特征提取,结合标签数据建立供氧参数智能预测算法,实现高原场景下的预测性精确供氧。

32.主要的处理过程如下:

33.通过数据预处理算法将来自传感器的源数据中不完整数据、异常数据进行清洗,对存在基线漂移的数据进行基线校正,通过差值使离散的标签数据连续化。

34.预处理过的数据通过一维卷积获得特征数据块,对特征数据块进行切片记为x,传入切片x1中的数据,计算节点状态c1和隐藏状态h1。根据上一个节点状态选择需要被遗忘的参数y1,选择需要被记忆的参数存入c1传给下一个节点。循环传入下一个切片数据中的数据,更新节点状态参数ct,ht,y(t-1)。

35.读入压缩特征数据zf,从中抽取特征矩阵mt,解码器预测值与原始值之间的差值dt,创建正态分布的矩阵et,计算dt与et的克罗内克积作为修正参数。升采样后,尝试使用lstm模型解码特征数据,共享训练与预测模块的参数,使用标签数据校正参数。循环处理后续数据切片数据,完成编码器-解码器模型的训练。

36.本发明的有益效果如下:

37.本发明基于lstm与一维卷积构建,可实现算法模型对生理数据和环境参数的深入理解,充分挖掘相关数据的特征变量,有利于建立与标签数据的特殊映射,lstm模型本身具有一定的预测能力可以在处理数据时较好的保留时序特征之间的互作关系,为后续的特征值预测提供基础。

38.采用编解码器技术进行中长周期的供氧参数预测,借鉴了transformer领域的概念,将从“生理参数和环境参数构成的时间序列数据”到“人体呼吸响应参数的时间序列数据”视为编码与解码的过程,通过训练得到一套编解码器,可用于根据当前的人体生理参数和环境参数实现对未来一段时间呼吸参数的预测,并实现提前供氧。

39.本发明具有以下有益效果:

40.本发明基于lstm与一维卷积构建,可实现算法模型对生理数据和环境参数的深入理解,充分挖掘相关数据的特征变量,有利于建立与标签数据的特殊映射,lstm模型本身具有一定的预测能力可以在处理数据时较好的保留时序特征之间的互作关系,为后续的特征值预测提供基础。

41.本发明实现了模型算法对原始数据的深入理解,解决了传统供氧算法无法克服生理信号本身具有滞后性的问题,提供了具有预测能力的lstm-编解码器算法来实现对人体需氧状态的预测,并达到提前供氧的目的。

附图说明

42.图1为本发明所提供的高原智能预供氧方法的流程图1;

43.图2为图1中步骤s2的分步骤流程图;

44.图3为图1中步骤s3的分步骤流程图;

45.图4为本发明所提供的预供氧方法的流程图2;

46.图5为本发明所提供的lstm模型结构图;

47.图6为本发明环境参数与呼吸参数的映射过程;

48.图7为自编码器主要处理流程图;

49.图8为自编码器模型结构。

具体实施方式

50.以下结合附图对本发明的原理和特征进行描述,所举实例只用于解释本发明,并非用于限定本发明的范围。

51.实施例1

52.本发明提供一种高原智能预供氧方法,参考图1所示,所述高原智能预供氧方法包括:

53.s1:获取原始高原供氧相关数据;

54.s2:对所述原始高原供氧相关数据进行预处理,得到供氧相关数据;

55.s3:根据所述供氧相关数据,建立呼吸参数短期预测模型;

56.s4:根据所述呼吸参数短期预测模型,生成呼吸参数的编码解码网络;

57.s5:利用所述呼吸参数的编码解码网络,将时间序列数据解码为用户状态时间序列数据;

58.s6:对所述用户状态时间序列数据进行数据处理,得到处理结果;

59.s7:利用所述处理结果建立供氧参数预测算法;

60.s8:根据所述供氧参数预测算法、所述供氧相关数据,得到呼吸参数预测结果。

61.可选择地,所述步骤s1中,所述原始供氧相关数据包括:生理与缺氧状态源数据、环境参数源数据、运动状态源数据和呼吸数据源数据。

62.可选择地,参考图2所示,所述步骤s2包括:

63.s21:判断所述原始供氧相关数据是否包括无状态标签的呼吸数据,若是,进入步骤s22;否则,进入步骤s23;

64.s22:移除所述无状态标签的呼吸数据后进入步骤s23;

65.s23:判断所述当前原始供氧相关数据是否包括异常数据,若是,进入步骤s24;否则,进入步骤s25;

66.s24:将所述异常数据替换为所述当前原始供氧相关数据中的最大正常数据和/或最小正常数据,以形成新的原始供氧相关数据后进入步骤s25;

67.s25:判断所述当前原始相关数据是否发生基线漂移,若是,进入步骤s26;否则,进入步骤s27;

68.s26:对所述当前原始相关数据进行数据归一化处理,并重新计算处理后的所述当前原始相关数据的基线,之后进入步骤s27;

69.s27:判断当前原始相关数据是否为离散数据,若是,则为其创建模糊集和数据插值并返回步骤s27;否则,将所述当前原始相关数据作为所述供氧相关数据输出。

70.可选择地,参考图3所示,所述步骤s3包括:

71.s31:获取所述原始供氧相关数据;

72.s32:根据所述原始供氧相关参数,建立所述环境参数和所述人体生理参数的响应映射关系;

73.s33:利用所述响应映射关系,得到所述供氧参数预测算法对所述供氧相关参数的预测结果。

74.实施例2

75.本发明的核心目标是提供一种高原智能预供氧方法(总体流程如图4所示),以解

决现有供氧设备和算法无法根据人类生理参数感知并预测其实时需氧状态的问题,并实现提前供氧,防止高原缺氧引起的进一步病理进展。

76.本发明实现了模型算法对原始数据的深入理解,解决了传统供氧算法无法克服生理信号本身具有滞后性的问题,提供了具有预测能力的lstm-编解码器算法来实现对人体需氧状态的预测,并达到提前供氧的目的。

77.本发明专利公开了一种基于lstm-encoder(长短期记忆-编码器网络)网络模型的智能预供氧方法,主要应用于在高海拔条件下使用便携式供氧设备对人的实时供氧参数进行智能预测和调整。

78.该算法包含两个层次的网络设计:融合了一维卷积的长短期记忆网络(lstm)用于提取人体生理参数、呼吸参数和环境参数的局部特征,结合训练集数据的状态标签,实现对外部参数-人体响应映射关系的理解,并进行短时预测。在此之上,基于lstm构建的编码器网络(encoder)用于将外部参数时间序列数据解码为人的状态时间序列数据,实现中长期的状态预测。本发明将lstm与encoder技术融合,用于智能供氧领域的多参数建模和状态预测,提供了一种可实现中长期供氧参数智能预测的方法。

79.为了实现上述目标,本发明提供了如下技术方案:

80.本发明公开了一种基于lstm网络和编解码器网络的预供氧方法,该方法包含两个层次的网络设计:(1)先对来自传感器的源数据进行预处理,使用其底层融合了一维卷积模块的长短期记忆网络(lstm,具体网络结构如图5所示)提取人体生理参数、呼吸参数和环境参数的局部特征,结合训练集数据的状态标签,实现该算法对“外部参数-人体响应”映射关系的理解(主要映射过程如图6所示),进而实现呼吸参数的短时预测。(2)基于lstm构建的编码器网络这种端到端的神经网络模型,用于将外部参数时间序列数据解码为人的状态时间序列数据,实现中长期的呼吸状态(和供氧参数)的预测。

81.本发明将lstm与编解码器技术融合,使用人体血氧、心率、呼吸等生理参数和环境参数作为基础数据集,以人的评估结果作为状态标签数据,通过对上述数据的归一化、向量化处理和特征提取,结合标签数据建立智能供氧参数预测算法(运行过程图7,详细结构如图8所示),实现高原场景下的预测性精确供氧。

82.主要过程的伪代码如下:

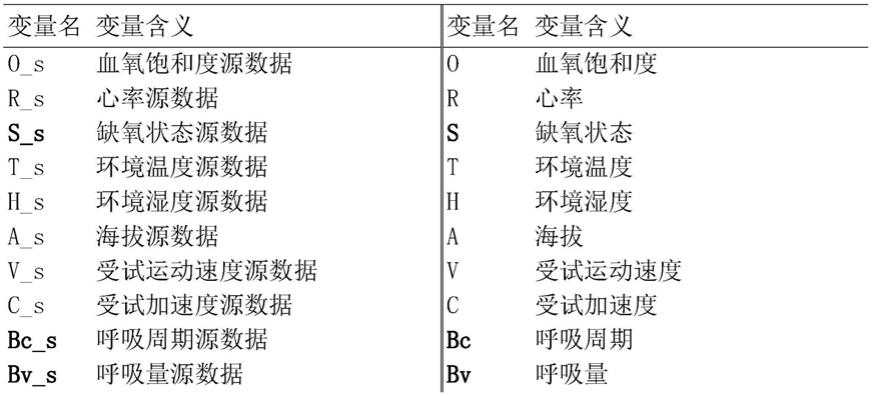

83.表1变量对照表

84.[0085][0086][0087][0088]

[0089][0090]

主要的处理过程如下:

[0091]

通过数据预处理算法将来自传感器的源数据中不完整数据、异常数据进行清洗,对存在基线漂移的数据进行基线校正,通过差值使离散的标签数据连续化。

[0092]

预处理过的数据通过一维卷积获得特征数据块,对特征数据块进行切片记为x,传入切片x1中的数据,计算节点状态c1和隐藏状态h1。根据上一个节点状态选择需要被遗忘的参数y1,选择需要被记忆的参数存入c1传给下一个节点。循环传入下一个切片数据中的数据,更新节点状态参数ct,ht,y(t-1)。

[0093]

读入压缩特征数据zf,从中抽取特征矩阵mt,解码器预测值与原始值之间的差值dt,创建正态分布的矩阵et,计算dt与et的克罗内克积修正参数。升采样后,尝试使用lstm模型解码特征数据,共享训练与预测模块的参数,使用标签数据校正参数。循环处理后续数据切片数据,完成编码器-解码器模型的训练。

[0094][0095]

本发明的有益效果如下:

[0096]

本发明基于lstm与一维卷积构建,可实现算法模型对生理数据和环境参数的深入理解,充分挖掘相关数据的特征变量,有利于建立与标签数据的特殊映射,lstm模型本身具有一定的预测能力可以在处理数据时较好的保留时序特征之间的互作关系,为后续的特征值预测提供基础。

[0097]

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1