一种端到端语音转文本罕见词优化方法与流程

1.本发明涉及人工智能技术领域,具体为一种端到端语音转文本罕见词优化方法。

背景技术:

2.长期以来,基于隐马尔可夫模型(hidden markov model,hmm)的语音识别方法一直是主流的大规模连续语音识别(large vocabulary continuous speech recognition,lvcsr)方法。截止到目前,基于深度神经网络

‑

隐马尔可夫模型(deep neural network

‑

hidden markov model,dnn

‑

hmm)的混合模型仍能达到最优的识别准确率,一般说来,基于hmm的语音识别模型由声学模型、发音词典和语言模型三个模块构成。声学模型主要用于建模输入语音和音素序列或子音素序列之间的映射关系;发音词典主要用于实现音素(或子音素) 与字符之间的映射,通常由专业的人类语言学家构建;语言模型将字符序列映射到流利的转录文本,然而,由于基于hmm的语音识别模型三个相对独立的组件需要单独设计且不同模块要分开训练,再通过构造加权有限状态转换器 (weighted finite state transduce,wfst)将不同模块进行融合,最后进行语音解码,该方法每个组件的设计和训练均需要专业的技术积累,训练步骤复杂且全局最优解优化困难;此外,模型构建过程中的条件独立性假设使得该方法与真实场景下的lvcsr不完全匹配。因此,基于hmm的语音识别方法的易用性、可维护性和可迁移性均受到了很大限制;

3.深度学习技术的出现极大地提高了语音识别模型的识别准确率,鉴于传统基于hmm模型方法的局限性,越来越多的研究机构开始研究基于端到端声学模型的lvcsr。端到端语音识别模型将传统语音识别系统的三大组件融合为一个网络模型,直接将输入音频序列映射为单词序列或其他字符序列,合并多个模块的好处是不需要设计很多模块来实现各种中间状态之间的映射,可以大大简化语音识别模型的构建和训练过程;联合训练使端到端模型能够使用与最终评价标准高度相关的函数作为全局优化的目标函数,更容易搜索得到全局最优解,从而进一步提升语音识别准确率,为此我们提出一种端到端语音转文本罕见词优化方法用于解决上述问题。

技术实现要素:

4.本发明的目的在于提供一种端到端语音转文本罕见词优化方法,以解决上述背景技术中提出的问题。

5.为实现上述目的,本发明提供如下技术方案:一种端到端语音转文本罕见词优化方法,训练集语料库对应标注文本中罕见词列表的构造,首先,整理分析训练集语料的标注文本;然后,使用分词工具对标注文本进行分词并使用 srilm语言模型工具统计单词词频;最后,将词频小于所设置的词频阈值的单词定义为罕见词,将其加入到罕见词列表中。

6.根据所构建的罕见词列表,从大规模语言模型训练语料中抽取包含罕见词的句子,一般说来,语言模型训练语料库中包含的文本语料远远多于声学模型训练集中所包含的文本语料,因此可以从语言模型文本语料中抽取得到包含罕见词的多个句子,用于合成

包含罕见词的语音数据。

7.合成包含罕见词句子的语音数据,首先,构造基于tacotron2的多说话人语音合成模型,然后,利用多说话人语音数据对tacotron2进行训练,最后,使用训练得到的多说话人语音合成模型对包含罕见词的句子进行文本语音合成,得到合成的罕见词语音语料库。

8.少量重口音语音数据下的模型优化。针对标准普通话语音数据下训练得到的通用语音识别模型,使用少量重口音语音数据对其进行优化。

9.训练语料库的扩充和端到端声学模型的构建,将合成的包含罕见词的多个说话人语音数据与原有的训练集语音数据进行合并,得到扩充的训练集语料。

10.端到端语音识别模型las的构建,本发明所构建的端到端语音模型是基于注意力机制的序列到序列的语音识别模型las,其主要包括编码器模块、注意力模块和解码器模块三部分。

11.端到端语音识别模型las的训练,使用扩充后的训练集语音数据对las模型进行训练,联合优化las模型的三个模块,使端到端模型可以使用与最终评估标准高度相关的函数作为全局优化的目标函数,从而有利于求解得到全局最优结果。

12.端到端语音识别模型的语音解码和语言模型重打分,首先,使用束搜索解码技术对联合优化后的语音识别模型进行解码搜索,得到声学模型分数;然后,使用已有的大规模语言模型对搜索得到的解码路径进行语言模型分数计算;最后,使用语言模型分数对声学模型分数进行重打分,得到解码搜索最终的分数,由该分数计算得到重口音语音对应的解码文本。

13.一种端到端语音转文本罕见词优化方法,包括以下步骤:

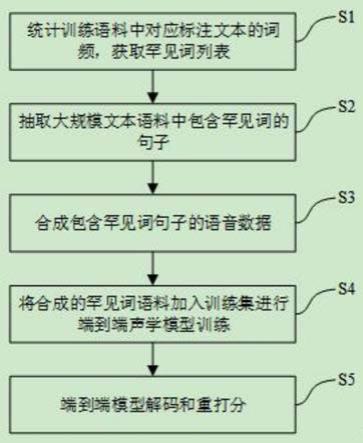

14.s1,统计训练语料中对应标注文本的词频,获取罕见词列表。首先,统计分析训练集语料库中对应的文本语料;然后使用分词工具对得到的文本语料进行分词,并使用srilm语言模型工具对分词后的语料进行词频统计,得到训练语料中单词的词频列表;分析词频列表,抽取罕见词构造罕见词词表,即针对单词词频n

word

设置词频阈值n

threshold

,当n

word

≤n

threshold

时,认为该词在训练集语料库中属于低频词或罕见词,将其加入罕见词词表中,处理完成即可得到当前训练集语料对应的罕见词词表;

15.s2,抽取大规模文本语料中包含罕见词的句子,构造得到罕见词文本语料库。针对步骤s1中抽取得到罕见词词表,从大规模语言模型文本语料库中抽取包含罕见词的多个句子,将其加入到罕见词文本语料库中,处理完成即可得到罕见词词表对应的包含罕见词的文本语料库;

16.s3,合成包含罕见词句子的语音数据,针对步骤s2抽取得到的罕见词文本语料库,使用较成熟的语音合成模型tacotron2进行罕见词文本语音合成, tacotron2是一个基于神经网络的语音合成方法,主要由声谱预测网络、声码器和中间连接模块构成;

17.声谱预测网络是一个基于注意力机制的序列到序列的网络结构,模型的输入为待合成的字符序列,输出为梅尔频谱声学特征帧序列,其中,编码器模块由包含512个神经元结点的字符嵌入层、3层各包含512个尺度为5*1的卷积核的卷积神经网络cnn层和一层包含256个隐藏层神经元结点的双向长短时记忆 lstm网络层构成,编码器模块的计算过程如公式(1)~(2)所示;

18.f

e

=relu(k3*relu(k2*relu(k1*e(ch))))

ꢀꢀꢀ

(1)

19.h=blstm(f

e

)

ꢀꢀꢀ

(2)

20.其中,k1、k2、k3分别表示三个卷积神经网络层的卷积核,relu表示非线性激活函数,e(

·

)表示对输入的字符序列ch做嵌入编码(embedding),blstm为双向长短时记忆网络,f

e

为卷积层输出的字符高层语义编码,h为双向长短时记忆网络(bidirectional long

‑

short term memory,blstm)层的输出。

21.注意力模块中使用了基于位置敏感的注意力机制,在对齐的过程中加入了位置特征,能够同时抽取输入的内容信息和输入元素的位置信息,其形式化表达如公式(3)所示;

[0022][0023]

其中,v

a

、w、v、u和b为可训练的参数,s

i

为当前解码器隐状态,h

j

为当前编码器隐状态,f

i,j

为注意力权重α

i

‑1经卷积操作得到的位置特征编码;

[0024]

解码器模块是一个自回归的循环神经网络模型,解码过程从输入上一步的输出声谱或上一步的真实声谱到预处理网络prenet开始,prenet的输出与使用上一个解码步输出计算得到的上下文相关的语义向量拼接后整体送入解码器网络中,基于rnn网络结构的解码器的输出用来计算当前步的上下文相关的语义向量,当前步的上下文相关的语义向量与当前步解码器的输出做拼接后送入线性投影网络中用于计算输出,解码器完成解码后将预测得到的梅尔谱送入到后处理网络中进行后处理,以提高梅尔谱的生成质量;

[0025]

声码器采用修正版的wavenet模型,用于把生成的频域梅尔谱声学特征转换为时域语音波形文件;

[0026]

本发明采用训练完备的tacotron2多说话人语音合成模型进行包含罕见词文本语料的语音合成,同时,为了缓解说话人信息对合成的语音的影响,实验中采用多个说话人的信息对没条目标文本进行合成,以此扩充目标文本语料的多样性;

[0027]

s4,将合成的罕见词语料加入训练集进行端到端声学模型训练,首先,将步骤s3中合成的多说话人语音语料x

synthesis

与训练集语料x

train

进行合并,得到扩充的训练集语料x

extension

,即x

extension

=x

train

∪x

synthesis

;

[0028]

构造并训练基于端到端的语音识别模型las。las模型主要由编码器模块、注意力模块和解码器模块三部分构成,其模型结构如图2所示,其中,编码器使用双向长短时记忆网络对输入的序列特征x

extension

进行时序关系建模,其形式化表示如公式(4)所示;

[0029][0030]

在blstm层之后堆叠了三层pblstm层,pblstm层的计算方式如公式(5) 所示;

[0031][0032]

引入上下文依赖的注意力机制可以使模型专注于序列中上下文相关语义显著特征的学习,从而提升模型推理的准确率,对于解码器输出的中间层语义特征h=(h1,h2,...,h

u

,...,h

u

),注意力层首先计算序列中第i个时间步输出特征h对应的权重α

i,u

,计算方式如公式(6)~(7)所示;

[0033][0034]

[0035]

其中,exp为以自然常数e为底的指数函数,φ、为带有可训练参数的全连接神经网络,上下文依赖的语义特征c

i

是输入序列的加权之和,是对一段语音整体语义的表征,其加权求和的方法如公式(8)所示;

[0036][0037]

解码器网络由两层各包含512个神经节点的单向lstm网络构成,其形式化表示如公式(9)~(10)所示;

[0038]

s

i

=lstm(s

i

‑1,y

i

‑1,c

i

‑1)

ꢀꢀꢀ

(9)

[0039]

p(y

i

|x,y

<i

)=mlp(s

i

,c

i

)

ꢀꢀꢀ

(10)

[0040]

其中,mlp为带有softmax激活函数的全连接神经网络,其输出是建模单元的后验概率;

[0041]

本发明构建的las模型的编码器、注意力层和解码器可以进行端到端联合训练,其目标函数如公式(11)所示;

[0042][0043]

其中,θ

e

、θ

a

、θ

d

分别为las的编码器模块、注意力模块、解码器模块的模型参数;表示第i个时间步之前时间步字符的真实标记;

[0044]

s5,由于基于贪心的解码策略每次都在当前位置直接取最优路径,不能保证生成整个序列的概率是最优的,此外,在实际的应用中,词表一般都很大,在有限的搜索时间内无法完成所有可能路径的解码搜索,因此,在实际的应用中,一般采用束搜索(beam search)的方法进行语音解码,同时,为了引入语音模型对解码结果进行校正,该技术中引入了语言模型对搜索出的路径进行重打分,其形式化表达如公式(12)所示;

[0045][0046]

其中,|y|

c

表示字符个数;log p

lm

(y)表示语言模型分数;λ表示语言模型分数权重,可由验证集确定。实际应用中的解码搜索采用beam数为32的束搜索,语言模型分数权重λ为0.008。

[0047]

与现有技术相比,本发明的有益效果是:

[0048]

本发明提出的一种端到端语音转文本罕见词优化技术,通过对训练集语料对应的文本标注进行统计分析,并构造包含罕见词的文本语料列表,能够有效搜索出端到端语音识别模型中未充分训练的文本语料;然后,通过成熟的多说话人语音合成模型对训练集中训练不充分的罕见词进行文本语音合成,能够有效扩充包含罕见词的文本语音,从而扩充训练集语料;最后,将合成的文本语音和原训练集语料融合后对端到端语音识别模型进行训练优化,能够显著提升端到端语音转文本模型对罕见词的泛化能力,从而缓解训练语料不足导致的罕见词识别效果差的问题,能够有效提升端到端语音识别的准确率。

附图说明

[0049]

图1为本发明的一种端到端语音转文本罕见词优化技术流程示意图;

[0050]

图2为本发明的端到端语音识别模型las模型结构图。

具体实施方式

[0051]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0052]

请参阅图1

‑

2,本发明提供一种技术方案:一种端到端语音转文本罕见词优化方法,训练集语料库对应标注文本中罕见词列表的构造,首先,整理分析训练集语料的标注文本;然后,使用分词工具对标注文本进行分词并使用srilm 语言模型工具统计单词词频;最后,将词频小于所设置的词频阈值的单词定义为罕见词,将其加入到罕见词列表中。

[0053]

根据所构建的罕见词列表,从大规模语言模型训练语料中抽取包含罕见词的句子,一般说来,语言模型训练语料库中包含的文本语料远远多于声学模型训练集中所包含的文本语料,因此可以从语言模型文本语料中抽取得到包含罕见词的多个句子,用于合成包含罕见词的语音数据。

[0054]

合成包含罕见词句子的语音数据,首先,构造基于tacotron2的多说话人语音合成模型,然后,利用多说话人语音数据对tacotron2进行训练,最后,使用训练得到的多说话人语音合成模型对包含罕见词的句子进行文本语音合成,得到合成的罕见词语音语料库。

[0055]

少量重口音语音数据下的模型优化。针对标准普通话语音数据下训练得到的通用语音识别模型,使用少量重口音语音数据对其进行优化。

[0056]

训练语料库的扩充和端到端声学模型的构建,将合成的包含罕见词的多个说话人语音数据与原有的训练集语音数据进行合并,得到扩充的训练集语料。

[0057]

端到端语音识别模型las的构建,本发明所构建的端到端语音模型是基于注意力机制的序列到序列的语音识别模型las,其主要包括编码器模块、注意力模块和解码器模块三部分。

[0058]

端到端语音识别模型las的训练,使用扩充后的训练集语音数据对las模型进行训练,联合优化las模型的三个模块,使端到端模型可以使用与最终评估标准高度相关的函数作为全局优化的目标函数,从而有利于求解得到全局最优结果。

[0059]

端到端语音识别模型的语音解码和语言模型重打分,首先,使用束搜索解码技术对联合优化后的语音识别模型进行解码搜索,得到声学模型分数;然后,使用已有的大规模语言模型对搜索得到的解码路径进行语言模型分数计算;最后,使用语言模型分数对声学模型分数进行重打分,得到解码搜索最终的分数,由该分数计算得到重口音语音对应的解码文本。

[0060]

一种端到端语音转文本罕见词优化方法,包括以下步骤:

[0061]

s1,统计训练语料中对应标注文本的词频,获取罕见词列表。首先,统计分析训练集语料库中对应的文本语料;然后使用分词工具对得到的文本语料进行分词,并使用srilm语言模型工具对分词后的语料进行词频统计,得到训练语料中单词的词频列表;分析词频列表,抽取罕见词构造罕见词词表,即针对单词词频n

word

设置词频阈值n

threshold

,当n

word

≤n

threshold

时,认为该词在训练集语料库中属于低频词或罕见词,将其加入罕见词词表中,处理完成即可得到当前训练集语料对应的罕见词词表;

[0062]

s2,抽取大规模文本语料中包含罕见词的句子,构造得到罕见词文本语料库。针对

步骤s1中抽取得到罕见词词表,从大规模语言模型文本语料库中抽取包含罕见词的多个句子,将其加入到罕见词文本语料库中,处理完成即可得到罕见词词表对应的包含罕见词的文本语料库;

[0063]

s3,合成包含罕见词句子的语音数据,针对步骤s2抽取得到的罕见词文本语料库,使用较成熟的语音合成模型tacotron2进行罕见词文本语音合成, tacotron2是一个基于神经网络的语音合成方法,主要由声谱预测网络、声码器和中间连接模块构成;

[0064]

声谱预测网络是一个基于注意力机制的序列到序列的网络结构,模型的输入为待合成的字符序列,输出为梅尔频谱声学特征帧序列,其中,编码器模块由包含512个神经元结点的字符嵌入层、3层各包含512个尺度为5*1的卷积核的卷积神经网络cnn层和一层包含256个隐藏层神经元结点的双向长短时记忆 lstm网络层构成,编码器模块的计算过程如公式(1)~(2)所示;

[0065]

f

e

=relu(k3*relu(k2*relu(k1*e(ch))))

ꢀꢀꢀ

(1)

[0066]

h=blstm(f

e

)

ꢀꢀꢀ

(2)

[0067]

其中,k1、k2、k3分别表示三个卷积神经网络层的卷积核,relu表示非线性激活函数,e(

·

)表示对输入的字符序列ch做嵌入编码(embedding),blstm为双向长短时记忆网络,f

e

为卷积层输出的字符高层语义编码,h为双向长短时记忆网络(bidirectional long

‑

short term memory,blstm)层的输出。

[0068]

注意力模块中使用了基于位置敏感的注意力机制,在对齐的过程中加入了位置特征,能够同时抽取输入的内容信息和输入元素的位置信息,其形式化表达如公式(3)所示;

[0069][0070]

其中,v

a

、w、v、u和b为可训练的参数,s

i

为当前解码器隐状态,h

j

为当前编码器隐状态,f

i,j

为注意力权重α

i

‑1经卷积操作得到的位置特征编码;

[0071]

解码器模块是一个自回归的循环神经网络模型,解码过程从输入上一步的输出声谱或上一步的真实声谱到预处理网络prenet开始,prenet的输出与使用上一个解码步输出计算得到的上下文相关的语义向量拼接后整体送入解码器网络中,基于rnn网络结构的解码器的输出用来计算当前步的上下文相关的语义向量,当前步的上下文相关的语义向量与当前步解码器的输出做拼接后送入线性投影网络中用于计算输出,解码器完成解码后将预测得到的梅尔谱送入到后处理网络中进行后处理,以提高梅尔谱的生成质量;

[0072]

声码器采用修正版的wavenet模型,用于把生成的频域梅尔谱声学特征转换为时域语音波形文件;

[0073]

本发明采用训练完备的tacotron2多说话人语音合成模型进行包含罕见词文本语料的语音合成,同时,为了缓解说话人信息对合成的语音的影响,实验中采用多个说话人的信息对没条目标文本进行合成,以此扩充目标文本语料的多样性;

[0074]

s4,将合成的罕见词语料加入训练集进行端到端声学模型训练,首先,将步骤s3中合成的多说话人语音语料x

synthesis

与训练集语料x

train

进行合并,得到扩充的训练集语料x

extension

,即x

extension

=x

train

∪x

synthesis

;

[0075]

构造并训练基于端到端的语音识别模型las。las模型主要由编码器模块、注意力模块和解码器模块三部分构成,其模型结构如图2所示,其中,编码器使用双向长短时记忆

网络对输入的序列特征x

extension

进行时序关系建模,其形式化表示如公式(4)所示;

[0076][0077]

在blstm层之后堆叠了三层pblstm层,pblstm层的计算方式如公式(5) 所示;

[0078][0079]

引入上下文依赖的注意力机制可以使模型专注于序列中上下文相关语义显著特征的学习,从而提升模型推理的准确率,对于解码器输出的中间层语义特征h=(h1,h2,...,h

u

,...,h

u

),注意力层首先计算序列中第i个时间步输出特征h对应的权重α

i,u

,计算方式如公式(6)~(7)所示;

[0080][0081][0082]

其中,exp为以自然常数e为底的指数函数,φ、为带有可训练参数的全连接神经网络,上下文依赖的语义特征c

i

是输入序列的加权之和,是对一段语音整体语义的表征,其加权求和的方法如公式(8)所示;

[0083][0084]

解码器网络由两层各包含512个神经节点的单向lstm网络构成,其形式化表示如公式(9)~(10)所示;

[0085]

s

i

=lstm(s

i

‑1,y

i

‑1,c

i

‑1)

ꢀꢀꢀ

(9)

[0086]

p(y

i

|x,y

<i

)=mlp(s

i

,c

i

)

ꢀꢀꢀ

(10)

[0087]

其中,mlp为带有softmax激活函数的全连接神经网络,其输出是建模单元的后验概率;

[0088]

本发明构建的las模型的编码器、注意力层和解码器可以进行端到端联合训练,其目标函数如公式(11)所示;

[0089][0090]

其中,θ

e

、θ

a

、θ

d

分别为las的编码器模块、注意力模块、解码器模块的模型参数;表示第i个时间步之前时间步字符的真实标记;

[0091]

s5,由于基于贪心的解码策略每次都在当前位置直接取最优路径,不能保证生成整个序列的概率是最优的,此外,在实际的应用中,词表一般都很大,在有限的搜索时间内无法完成所有可能路径的解码搜索,因此,在实际的应用中,一般采用束搜索(beam search)的方法进行语音解码,同时,为了引入语音模型对解码结果进行校正,该技术中引入了语言模型对搜索出的路径进行重打分,其形式化表达如公式(12)所示;

[0092][0093]

其中,|y|

c

表示字符个数;log p

lm

(y)表示语言模型分数;λ表示语言模型分数权重,可由验证集确定。实际应用中的解码搜索采用beam数为32的束搜索,语言模型分数权重

λ为0.008。

[0094]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1