一种基于注意力机制与扰动感知的声音分离方法

1.本发明属于声音信号分离技术领域,特别涉及一种基于注意力机制与扰动感知的声音分离方法。

背景技术:

2.语音分离是信号处理领域中的一项基础任务,并且在各项声音处理任务中有着广泛地应用,包括移动通信、语音识别以及情感识别等任务。单通道语音分离(single channel speech separation,scss)指从一维混合语音信号中恢复出多个独立源语音信号的过程。单通道语音分离通常难以利用源声音信号的空域信息。缺乏足够先验信息的指导使得单通道语音分离成为语音分离任务中亟待解决的重要课题之一。

3.随着深度学习技术的发展,神经网络也逐渐被广泛地应用于不同的声音信号处理任务中,传统的信号处理方法通常包含多个相互依赖的子步骤,当前步骤处理结果的好坏往往会影响下一步骤的处理结果。而深度学习可以将多个具有依赖关系的处理模块整合到一个神经网络中,大大降低了信号处理方法的实现复杂度,同时神经网络具有强大的拟合性能及映射能力,使得其在不同的信号处理任务中都获得了不俗的效果。

4.对于单通道语音分离任务而言,传统的u

‑

net结构无法得到多个分离后的独立源声音信号,需要对u

‑

net网络结构进行进一步改进,同时由于传统u

‑

net缺少对信号输入的充分学习,没有充分利用信号特征的一维空间信息,并且现有的深度学习方法缺乏对单通道语音中背景噪声的有效学习,导致相关方法得到的分离后声音信号准确率偏低。

技术实现要素:

5.为了提高单通道语音的分离效果,本发明提出一种基于注意力机制与扰动感知的声音分离方法,包括以下步骤:

6.s1、获取声音信号数据集,对该数据集的声音信号进行预处理得到混合声音信号,随后将混合声音信号划分为训练集、验证集;

7.s2、将训练集中的混合声音信号输入单通道语音分离网络模型,在交叉熵损失函数的指导下输出得到分离后的独立源信号;

8.s3、利用验证集数据验证每次单通道语音分离网络模型的正确率,并且保存正确率最高时的网络参数;

9.s4、将待分离的混合声音信号数据输入单通道语音分离网络模型,即可得到分割后的独立源声音信号。

10.进一步的,对声音信号进行预处理得到混合声音信号具体包括:

11.将多份独立源声音信号进行裁剪,每份信号裁剪后得到多段时长为n秒的声音信号切片;

12.将每份裁剪后的声音信号进行重采样,采样频率为8000hz;

13.将采样后的声音信号进行归一化处理;

14.将归一化处理后属于不同独立源信号的声音片段进行逐位相加,随后与一段时长为n秒、采样率为8000hz的噪声片段再次逐位相加,得到最终的混合声音信号。

15.优选的本发明将信号裁剪为2秒每段。

16.进一步的,单通道语音分离网络模型包括编码器网络、解码器网络以及注意力融合的掩模分离模块,单通道语音分离网络模型将混合声音信号分离得到独立声音信号的过程包括以下步骤:

17.编码器网络对输入的混合声音信号进行特征提取及降维,得到混合声音信号的深度特征;

18.注意力融合的掩模分离模块对深度特征进行过滤,并生成独立源信号掩膜和噪音掩膜;

19.令深度特征分别与每个掩膜进行向量间的逐元素相乘,得到每个独立源信号的特征以及噪音信号特征;

20.解码器网络对根据掩膜得到的每个信号特征进行数据重构,得到分离的每个独立信号。

21.进一步的,编码器网络包括4个级联的特征提取模块,即除第一个特征模块以混合声音信号作为输入外其他特征提取模块均以上一个特征模块的输出作为输入,每个特征分模块包括一个卷积核为1

×

w

′×

c的卷积操作、一个批标准化层以及一个relu激活函数,混合声音信号原始通道为1,四个特征提取模块按照级联顺序每个的通道数依次为16、32、64、128;其中,w

′

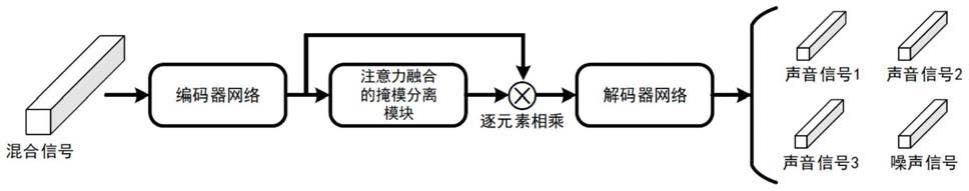

为输入特征提取模块信号的长度,c为当前信号的通道数。

22.进一步的,注意力融合的掩模分离模块对深度特征进行过滤包括:

23.对输入的深入特征使用全局平均池化进行基于通道上的压缩,得到一个1

×1×

c的压缩特征,随后依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及同样卷积核大小的卷积操作,将得到的激活特征使用sigmoid函数进行数值约束得到维度为1

×1×

c的特征图,其中c为当前信号的通道数;

24.将得到的维度为1

×1×

c的特征图与输入的深度特征相乘得到基于通道注意力过滤的深度特征;

25.使用大小为1

×

w的卷积核对深度特征;

26.进行基于空间的特征压缩并使用relu激活函数进行激活处理,随后将得到的激活特征依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及sigmoid函数得到维度为1

×

w

×

1的特征图;

27.将得到的维度为1

×

w

×

1的特征图与输入的深度特征相乘得到基于空间注意力过滤的深度特征;

28.将基于通道注意力过滤的深度特征和基于空间注意力过滤的深度特征进行拼接,得到大小为1

×

w

×

2*c的拼接特征,随后使用大小为1

×

1的卷积核进行卷积融合操作,得到注意力融合特征。

29.进一步的,生成独立源信号掩膜和噪音掩膜,即对得到的1

×

w

×

c的注意力融合特征使用大小为1

×

1的卷积进行通道压缩,随后使用sigmoid函数得到大小为1

×

w

×

1的信号掩模。

30.进一步的,解码器网络包括4个级联的信号重构模块,深度特征分别与每个掩膜进

行向量间的逐元素相乘得到的每个独立源信号的特征以及噪音信号特征作为第一个信号重构模块的输入,其他信号重构模块均以上一个特征模块的输出作为输入,每个特征提取模块包括上采样操作、一个卷积核大小为1

×1×

c的卷积操作、一个批标准化层以及一个relu激活函数,其中c为当前模块设计的通道数大小,第一个信号重构模块的输入信号通道数为128,信号重构模块依照级联顺序每个的通道数c依次为64、32、16、1。

31.本发明的有益效果在于:

32.1)本发明基于端到端的神经网络,相比于传统方法的分步骤处理,本发明将特征提取、信号分离以及信号重构的步骤整合到一个网络中进行,在降低处理过程的复杂性的同时提升了分离音频信号的时间效率。

33.2)本发明针对声音信号分离的神经网络中的信号分离模块提出了改进,使用了基于通道的注意力机制以及基于空间的注意力机制分别对提取得到的信号特征进行特征过滤,随后将不同机制过滤的特征进行特征融合以获得更鲁棒的特征表示。

34.本发明针对单通道语音分离网络对噪声鲁棒性不足的问题,在网络输入信号中添加一段额外的噪声信号,使得网络在学习目标信号分离的同时,能够进一步学习区分混合信号中的噪声信号。

附图说明

35.图1为本发明基于注意力机制与扰动感知的语音分离整体网络结构示意图;

36.图2为本发明的语音特征分离结构示意图;

37.图3为本发明的注意力融合结构示意图;

38.图4为编码器模块结构示意图;

39.图5为解码器模块结构示意图;

40.图6为一个合成混合声音信号的示意图;

41.图7为实施例中声音信号1的真实值;

42.图8为实施例中声音信号1的预测值;

43.图9为实施例中声音信号2的真实值;

44.图10为实施例中声音信号2的预测值;

45.图11为实施例中声音信号3的真实值;

46.图12为实施例中声音信号3的预测值。

具体实施方式

47.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

48.一种基于注意力机制与扰动感知的声音分离方法,包括以下步骤:

49.s1、获取声音信号数据集,对该数据集的声音信号进行预处理得到混合声音信号,随后将混合声音信号划分为训练集、验证集;

50.s2、将训练集中的混合声音信号输入单通道语音分离网络模型,在交叉熵损失函

数的指导下输出得到分离后的独立源信号;

51.s3、利用验证集数据验证每次单通道语音分离网络模型的正确率,并且保存正确率最高时的网络参数;

52.s4、将待分离的混合声音信号数据输入单通道语音分离网络模型,即可得到分割后的独立源声音信号。

53.实施例1

54.s1、获取声音信号数据集,对当前的声音信号进行预处理得到混合声音信号,随后将混合声音信号划分为训练集、验证集以及测试集;

55.作为一种实现方式,声音信号的获取方式包括相关设备现场采集、视频,音频声音截取以及人工合成声音信号。通过以上方法获取三份独立的声音样本,随后对当前的声音样本进行预处理。

56.具体的,声音样本预处理包括对声音样本进行裁剪,每份声音样本经过裁剪后得到多段时长为2秒的声音信号切片,若最后一段切片信号长度不足2秒,填充0样本直至时长达到2秒。随后对得到的声音切片重采样到指定采样率(如8000hz),根据原始声音信号采样率的不同,重采样的方法可以采用降采样、增采样、内插滤波采样以及非整数因子重采样方法。随后对采样后的各个声音切片进行归一化处理,具体归一化方法包括最小值

‑

最大值标准化、z

‑

score标准化等。

57.将属于不同源声音样本的三份归一化处理后的声音切片进行叠加,随后将叠加后的声音样本与一段时长为2秒,采样率为8000hz的噪声片段再次进行叠加,得到最终得混合声音样本。本实施例中选择为2秒长度的,但是实际操作过程中可以不限制剪裁长度,只需要保证每段音源以及噪音的剪裁长度一致即可。

58.将叠加后的混合声音样本划分为训练集、验证集以及测试集,具体划分比率为70%的数据为训练集,10%的数据为验证机,20%的数据为测试集。训练集用于训练网络,验证集用于在训练过程中测试网络性能,测试集用于测试训练后的网络性能;训练集数据中包括混合信号和混合信号中各个信号的独立音源信号和噪音信号,利用神经网络反向传播对掩膜中各个参数进行优化,直到其损失函数达到规定范围,掩膜参数是根据神经网络在训练阶段进行固定的,在训练过程中,将每段独立音源与掩膜音源的之间的损失进行反向传播优化掩膜,直到损失小于阈值,保存掩膜。

59.s2、将训练集中的混合声音信号输入单通道语音分离网络模型,在交叉熵损失函数的指导下输出得到分离后的独立源信号。如图1所示,单通道语音分离网络包括编码器网络、注意力融合的掩模分离模块以及解码器网络,混合声音信号首先输入至编码器网络中进行特征提取,随后将提取的深度特征送入注意力融合的掩模分离模块生成不同的声音特征掩模,将编码器得到的声音特征分别与不同的声音掩模进行逐元素相乘得到用于还原不同声音信号的重构特征。最后将不同的重构特征输入至解码器网络生成分离的声音信号。

60.具体的,注意力融合的掩模分离模块的整体结构如图2所示。将编码器网络生成的深度特征分别输入至四个相互独立的注意力融合模块中,得到四个不同的声音掩模,随后将编码器网络生成的深度特征与不同的掩模进行逐元素相乘,得到用于重构不同声音信号的重构特征。随后将不同的重构特征输入至解码器网络中。

61.具体的,掩模分离模块中的注意力融合结构如图3所示。对于形如1

×

w

×

c的深度

特征y,其中c为通道数。首先对深入特征y使用全局平均池化进行基于通道上的压缩,得到一个1

×1×

c的压缩特征,随后依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及同样卷积核大小的卷积操作,将得到的激活特征使用sigmoid函数进行数值约束得到维度为1

×1×

c的特征图。将此特征图与输入特征y相乘得到基于通道注意力过滤的深度特征y

c

;随后我们使用大小为1

×

w的卷积核对输入特征y进行基于空间的特征压缩并使用relu激活函数进行激活处理,随后将得到的激活特征依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及sigmoid函数得到维度为1

×

w

×

1的特征图,将此特征图与输入特征y相乘得到基于空间注意力过滤的深度特征y

s

。在分别得到基于通道注意力的深度特征y

c

以及基于空间注意力过滤的深度特征y

s

后,本模块随后将y

c

与y

s

在通道维度上进行拼接,得到大小为1

×

w

×

2*c的拼接特征,随后使用大小为1

×

1的卷积核进行卷积融合操作,得到注意力融合特征y

i

′

。随后本模块将大小为1

×

w

×

c的声音特征y

′

i

转换为对应的声音掩模m

i

,首先使用大小为1

×

1的卷积进行通道压缩,随后使用sigmoid函数得到大小为1

×

w

×

1的信号掩模m

i

。

62.具体的,编码器网络的编码模块与解码器网络的解码模块分别如图4与图5所示。每个编码模块包含一个卷积层、一个批标准化层以及一个relu激活函数。每个解码模块包含一个上采样层,具体上采样方法可以选用反卷积、双线性插值,三次线性插值以及临近插值等,一个卷积层,一个批标准化层以及一个relu激活函数。

63.在得到重构特征后,本方法使用交叉熵计算网络损失。首先分别计算原始声音信号与还原声音信号的交叉熵损失,随后将不同的还原声音信号进行叠加再与还原后的噪声信号进行叠加得到还原混合信号,将网络输入的混合信号与还原混合信号计算交叉熵损失。

64.s3、利用验证集数据验证每次迭代后单通道语音分离网络模型的正确率,并且保存正确率最高时的网络参数;

65.具体的,验证集与测试集的正确率计算方式包括计算平均峰值误差以及计算分离后声音信号与源声音信号的相关系数。平均峰值误差首先计算各个样本源声音信号峰值频率与分离后声音信号的峰值频率的差值绝对值,随后将误差绝对值除以真实峰值强度,然后所有样本求平均得到最终的平均峰值误差。分离后声音信号与源声音信号的相关系数计算方法如下:

[0066][0067]

其中s表示源声音信号,x表示分离后的声音信号。

[0068]

s4、将测试集中的混合声音信号数据输入单通道语音分离网络模型,即可得到分割后的独立源声音信号。

[0069]

实施例2

[0070]

本实施例给出单通道语音分离网络模型的结构以及其处理流程。

[0071]

单通道语音分离网络模型包括编码器网络,解码器网络、注意力融合的掩模分离模块,其中,整体网络处理流程如下:

[0072]

将混有三个独立音源信号s1,s2,s3以及一段噪声音频n1的混合音频x输入至网络

中,网络首先通过编码器网络e对输入数据信号特征提取及降维,得到提炼后的深度特征y:

[0073]

y=e(x);

[0074]

随后网络注意力融合的掩模分离模块对深度特征y进行进一步的特征过滤,并生成三分特征掩模m1~m4,其中,m1,m2,m3分别表示待分离的三个独立源声音信号的特征掩模,m4表示噪声片段的特征掩模。在得到不同的掩模后,网络将深度特征y与不同的特征掩模进行向量间的逐元素相乘,得到表示不同分离声音信号的特征f

i

:

[0075]

f

i

=y

⊙

m

i

;

[0076]

其中f1,f2,f3分别表示待分离的三个独立源声音的信号特征,f4表示噪声片段的信号特征。随后使用解码器网络d对四个声音特征进行数据重构,得到还原后的声音信号s

′

i

:

[0077]

s

′

i

=d(f

i

);

[0078]

最后通过对原始声音信号s

i

与s

′

i

计算交叉熵损失函数来指导网络训练。

[0079]

编码器网络负责对输入的混合声音信号进行特征提取,其中包含四个特征提取模块,每个模块以上一层模块的输出结果为输入,其中第一层模块的输入为混合声音信号x。每个特征提取模块包含一个卷积核大小为1

×

w

′×

c的卷积操作,其中c为当前模块设计的通道数大小、一个批标准化层(batch normalization)以及一个relu激活函数。原始输入的通道数为1,随后四个特征提取模块每个的通道数c依次为16,32,64,128。经过编码器网络的处理后,网络输入的混合音频x被转化成了深度特征y,随后交由注意力融合的掩模分离模块进行处理。

[0080]

注意力融合的掩模分离模块首先对输入的深度特征y进行基于注意力机制的特征过滤。对于形如1

×

w

×

c的深度特征y,其中c为通道数,本模块分别对其进行通道注意力过滤以及空间注意力过滤,并将两者的结果进行融合。具体操作如下:首先对深入特征y使用全局平均池化进行基于通道上的压缩,得到一个1

×1×

c的压缩特征,随后依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及同样卷积核大小的卷积操作,将得到的激活特征使用sigmoid函数进行数值约束得到维度为1

×1×

c的特征图。将此特征图与输入特征y相乘得到基于通道注意力过滤的深度特征y

c

;随后我们使用大小为1

×

w的卷积核对输入特征y进行基于空间的特征压缩并使用relu激活函数进行激活处理,随后将得到的激活特征依次经过卷积核大小为1

×

1的卷积操作、relu激活函数以及sigmoid函数得到维度为1

×

w

×

1的特征图,将此特征图与输入特征y相乘得到基于空间注意力过滤的深度特征y

s

。在分别得到基于通道注意力的深度特征y

c

以及基于空间注意力过滤的深度特征y

s

后,本模块随后将y

c

与y

s

在通道维度上进行拼接,得到大小为1

×

w

×

2*c的拼接特征,随后使用大小为1

×

1的卷积核进行卷积融合操作,得到注意力融合特征y

′

i

,对于不同的独立音源信号s1,s2,s3以及噪声片段n1,本网络会采用独立的注意力融合模块进行单独处理,因此最终会得到用于生成音源信号掩模的声音特征y

′1,y

′2,y

′3和生成噪声信号掩模的声音特征y

′

n

。

[0081]

随后本模块将大小为1

×

w

×

c的声音特征y

′

i

转换为对应的声音掩模m

i

,首先使用大小为1

×

1的卷积进行通道压缩,随后使用sigmoid函数得到大小为1

×

w

×

1的信号掩模m

i

,并约束各个掩模遵循:将输入特征y与不同掩模m

i

逐元素相乘得到用于重新生成独立音源信号s1,s2,s3的重构特征f1,f2,f3以及还原噪声信号的特征f

n

。

[0082]

在得到不同的重构特征f

i

后,本网络将其送入解码器网络中进行信号重构。解码器网络包含四个信号重构模块,其处理顺序与编码器网络相反:由底层模块依次向上执行处理,每个模块以下一层模块的输出结果为输入,其中最底层模块的输入为重构特征f

i

。每个特征提取模块包含上采样操作、一个卷积核大小为1

×1×

c的卷积操作,其中c为当前模块设计的通道数大小、一个批标准化层(batch normalization)以及一个relu激活函数。最底层处理模块的通道数为128,随后四个特征提取模块每个的通道数c依次为64,32,16,1。不同的重构特征f

i

依次经过编码器网络处理生成还原后的独立声音信号s

′1,s

′2,s

′3以及噪声信号n

′1。

[0083]

最后网络使用交叉熵损失函数进行loss计算,首先分别计算原始声音信号与还原声音信号的相似度损失,即分别计算s1与s

′1,s2与s

′2,s3与s

′3的交叉熵损失loss

i

:

[0084]

loss

i

=

‑

∑s

i

log(s

′

i

)+(1

‑

s

i

)log(1

‑

s

′

i

)

[0085]

随后将s

′1,s

′2,s

′3与n

′1进行叠加得到还原后的混合信号x

′

,并计算x

′

与网络输入混合信号x的交叉熵损失:

[0086]

loss

n

=

‑

∑xlog(x

′

)+(1

‑

x)log(1

‑

x

′

)

[0087]

最终的损失函数由三独立音源信号的损失函数以及混合信号的损失函数相加组成:

[0088]

sumloss=loss1+loss2+loss3+loss

n

。

[0089]

以上是独立音源为3个时训练网络时的过程,因此类推可以得到多个独立音源的训练过程,本实施例不再赘述。

[0090]

在编码器模块中进行的操作包括:

[0091]

201:将大小为1

×

w

×

c1的特征图输入到卷积核大小为1

×

w

′

且输出通道数为c2的卷积层中;

[0092]

202:将201中的卷积结果输入到批标准化处理函数中

[0093]

203:将202的结果输入到relu激活函数,得到大小为1

×

w

′×

c2的信号特征;

[0094]

其中,w表示输入特征的宽度,w

′

表示输出特征的宽度,c1表示输入特征的通道数,c2表示输出特征的通道数。

[0095]

在注意力融合的掩模分离模块的操作包括:

[0096]

211:对于来自编码器生成得到的大小为1

×

w

×

c的信号特征y,使用全局平局池化层进行通道压缩。

[0097]

212:将211的处理结果依次输入到卷积核大小为1

×

1的卷积层,relu激活函数以及卷积核大小为1

×

1的卷积层;

[0098]

213:将212的处理结果输入到sigmoid函数中,得到一个维度为1

×1×

c的激活向量,其中c为特征的通道数;

[0099]

214:将213的激活向量与信号特征y进行逐元素相乘,到基于通道注意力过滤的深度特征y

c

;

[0100]

215:对于来自编码器生成得到的大小为1

×

w

×

c的信号特征y,使用1

×

w的卷积核对以及relu激活函数对输入特征y进行基于空间的特征压缩;

[0101]

216:将215的压缩特征依次经过卷积核大小为1

×

1的卷积层、relu激活函数以及sigmoid函数得到维度为1

×

w

×

1的激活特征;

[0102]

217:将216的激活向量与信号特征y进行逐元素相乘,到基于空间注意力过滤的深度特征y

s

;

[0103]

218:将214以及216得到的深度特征y

c

与y

s

在通道的维度上进行拼接得到大小为1

×

w

×

2*c的拼接特征;

[0104]

219:将218的拼接特征输入至卷积核大小为1

×

1,输出通道数为c的卷积层,得到大小为1

×

w

×

c的融合特征y

′

i

。

[0105]

220:对于219处理后的融合特征y

′

i

,使用sigmoid函数得到大小为1

×

w

×

1的信号掩模m

i

,并遵循

[0106]

221:将输入特征y分别与不同的信号掩模m

i

相乘得到用于重构不同声音信号的重构特征f

i

。

[0107]

进一步的,在解码器模块中进行的操作包括:

[0108]

231:将大小为1

×

w

×

c1重构特征输入至上采样层,得到大小为1

×

w

′×

c2的重构信号;

[0109]

232:将231得到的重构特征输入到卷积核大小为1

×

1且输出通道数为c2的卷积层中;

[0110]

233:将232中的卷积结果输入到批标准化处理函数中

[0111]

234:将233的结果输入到relu激活函数,得到大小为1

×

w

′×

c2的信号特征;

[0112]

其中,w表示输入特征的宽度,w

′

表示上采样后输出特征的宽度,c1表示输入特征的通道数,c2表示输出特征的通道数。

[0113]

实施例3

[0114]

本实施例采样人工合成声音信号构成数据集,采用三个小型音响模拟三个声源,分别编号为1号、2号和3号,1号、2号和3号声源信号分别为:

[0115]

p

s1

=r

11

(t)sin(2πf

11

t)+r

12

(t)sin(2πf

12

t)

[0116]

p

s2

=r

21

(t)sin(2πf

21

t)+r

22

(t)sin(2πf

22

t)

[0117]

p

s3

=r

31

(t)sin(2πf

31

t)+r

32

(t)sin(2πf

32

t)

[0118]

其中,r

1i

(t),r

2i

(t)和r

3i

(t)(i=1,2)均为(0.7,1)区间中的随机数,代表声源振幅的随机波动。f

11

=300hz,f

12

=600hz,f

21

=500hz,f

22

=1000hz,f

31

=700hz,f

32

=1400hz。采样的声音时间长度为2秒。

[0119]

项目组将以下实验1、实验2、实验3中不同声源的特征数据输入网络进行统一训练。具体来说,基于仿真实验中训练获得的基础网络模型,基于迁移学习算法,将实验中不同声源的特征数据构造相应的(混合信号,声音信号1,声音信号2,声音信号3)数据集,进行100轮的参数调优,从而能够自适应实验环境,基于一个综合网络模型,同时对于三个实验中具有不同随机扰动的声音进行智能分离,获得相应的独立声音分量。

[0120]

图7~12为3个声音的真实值和预测值。

[0121]

在本组实验中,重复进行了30次实验,最终统计得到:

[0122]

1.全部的测试样本中,其分离得到的单源声音信号和真实单源声音信号的峰值频率一致,按照相应实验设置即可完全准确划分,达到了任务书指标:通过分离算法计算的声音源信号频谱特征(即突出线谱数量和位置)与源信号频谱特征一致;

[0123]

2.对于所有的测试样本,峰值平均相对误差为:6.08%,分离后的声音源与实际声音源信号相关系数大于0.9,分离后的声音源信号线谱峰值与源信号线谱峰值的估计误差不超过25%。

[0124]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1