一种统一的语音合成与语音转换的训练方法和系统

1.本发明属于语音克隆技术领域,尤其涉及一种统一的语音合成与语音转换的训练方法和系统。

背景技术:

2.克隆目标说话人的声音是一项极具吸引力的技术,可以应用于各种场景,如娱乐创作、个性化移动助手、安全领域等。最理想的语音克隆操作是只给未见过目标说话人的一句话语音作为参考,然后即可以合成目标说话人的任何语音,这称为单样本语音克隆。在语音研究领域,语音合成技术和语音转换技术是实现语音克隆的两种主流方式。两种技术在以往是作为独立的任务进行分别研究和开发的。

3.tts (text-to-speech):语音合成;vc (voice conversion):语音转换;虽然tts和vc技术是语音克隆的两种重要方法,两种技术在以往是作为独立的任务进行分别研究和开发的,它们之间没有太多的相互作用。困难的原因是因为这两项任务的语音内容表示不同。具体来说,tts中的语音内容是通过文本信息获得的,tts中的文本和语音是两个不相等的序列,通常需要注意机制来对齐它们。而注意机制往往受到说话人信息的影响,因此不可能学习到与说话人无关的语音内容表征。而在vc中,源语音和目标语音在语音内容上是对齐的,因此可以直接从源语音中提取语音内容,这与tts是不同。

技术实现要素:

4.为解决上述技术问题,本发明提出一种统一的语音合成与语音转换的训练方法和系统的技术方案,以解决上述技术问题。

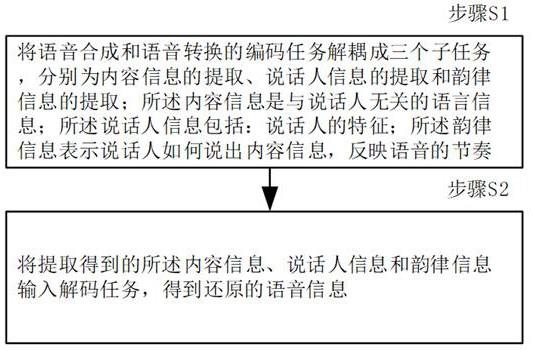

5.本发明第一方面公开了一种统一的语音合成与语音转换的训练方法,所述方法包括:步骤s1、将语音合成和语音转换的编码任务解耦成三个子任务,分别为内容信息的提取、说话人信息的提取和韵律信息的提取;所述内容信息是与说话人无关的语言信息;所述说话人信息包括:说话人的特征;所述韵律信息表示说话人如何说出内容信息,反映语音的节奏;步骤s2、将提取得到的所述内容信息、说话人信息和韵律信息输入解码任务,得到还原的语音信息。

6.根据本发明第一方面的方法,在所述内容信息的提取的子任务中,对于语音合成,语音内容的来源是文本,使用文本编码器对文本进行编码以获得上下文表示;根据音素的持续时间信息对所述上下文表示进行上采样,以获得语音的内容信息。

7.根据本发明第一方面的方法,在所述内容信息的提取的子任务中,对于语音转换,由于源语音与目标语音对齐,直接使用内容编码器从源语音中提取语音的内容信息。

8.根据本发明第一方面的方法,所述说话人信息的提取的编码器在语音合成与语音

转换的任务中是共享的,直接从没有文本的语音中提取所述说话人信息。

9.根据本发明第一方面的方法,所述韵律信息的提取的编码器在语音合成与语音转换的任务中是共享的,直接从语音中提取基频信息作为所述韵律信息。

10.根据本发明第一方面的方法,在训练阶段,以语音的内容信息和说话人信息为输入来预测基频信息。

11.根据本发明第一方面的方法,语音合成和语音转换的总损失函数包括三部分,语音合成的损失函数、语音转换的损失函数和额外的内容信息损失函数,即,总损失函数=语音合成的损失函数+语音转换的损失函数+额外的内容信息损失函数;所述额外的内容信息损失函数的构造方法包括:应用矢量量化码本进行编码分别提取语音合成的内容信息和语音转换的内容信息;再应用语音合成的内容信息和语音转换的内容信息的差值,构造所述额外的内容信息损失函数;语音合成的损失函数包含两部分,一部分是语音合成的语音的重构损失,另一部分是语音合成的基频的重构损失,即,语音合成的损失函数=语音合成的语音的重构损失+语音合成的基频的重构损失;语音转换的损失函数包含两部分,一部分是语音转换的语音的重构损失,另一部分是语音转换的基频的重构损失,即,语音转换的损失函数=语音转换的语音的重构损失+语音转换的基频的重构损失。

12.本发明第二方面公开了一种统一的语音合成与语音转换的训练系统,所述系统包括:第一处理模块,被配置为,将语音合成和语音转换的编码任务解耦成三个子任务,分别为内容信息的提取、说话人信息的提取和韵律信息的提取;所述内容信息是与说话人无关的语言信息;所述说话人信息包括:说话人的特征;所述韵律信息表示说话人如何说出内容信息,反映语音的节奏;第二处理模块,被配置为,将提取得到的所述内容信息、说话人信息和韵律信息输入解码任务,得到还原的语音信息。

13.根据本发明第二方面的系统,第一处理模块,被配置为,在所述内容信息的提取的子任务中,对于语音合成,语音内容的来源是文本,使用文本编码器对文本进行编码以获得上下文表示;根据音素的持续时间信息对所述上下文表示进行上采样,以获得语音的内容信息。

14.根据本发明第二方面的系统,第一处理模块,被配置为,在所述内容信息的提取的子任务中,对于语音转换,由于源语音与目标语音对齐,直接使用内容编码器从源语音中提取语音的内容信息。

15.根据本发明第二方面的系统,第一处理模块,被配置为,述韵律信息的提取的编码器在语音合成与语音转换的任务中是共享的,直接从语音中提取基频信息作为所述韵律信息。

16.根据本发明第二方面的系统,第一处理模块,被配置为,在训练阶段,以语音的内

容信息和说话人信息为输入来预测基频信息。

17.根据本发明第二方面的系统,第一处理模块,被配置为,语音合成和语音转换的总损失函数包括三部分,语音合成的损失函数、语音转换的损失函数和额外的内容信息损失函数,即,总损失函数=语音合成的损失函数+语音转换的损失函数+额外的内容信息损失函数;所述额外的内容信息损失函数的构造包括:应用矢量量化码本进行编码分别提取语音合成的内容信息和语音转换的内容信息;再应用语音合成的内容信息和语音转换的内容信息的差值,构造所述额外的内容信息损失函数;语音合成的损失函数包含两部分,一部分是语音合成的语音的重构损失,另一部分是语音合成的基频的重构损失,即,语音合成的损失函数=语音合成的语音的重构损失+语音合成的基频的重构损失;语音转换的损失函数包含两部分,一部分是语音转换的语音的重构损失,另一部分是语音转换的基频的重构损失,即,语音转换的损失函数=语音转换的语音的重构损失+语音转换的基频的重构损失。

18.本发明第三方面公开了一种电子设备。电子设备包括存储器和处理器,存储器存储有计算机程序,处理器执行计算机程序时,实现本发明公开第一方面中任一项的一种统一的语音合成与语音转换的训练方法中的步骤。

19.本发明第四方面公开了一种计算机可读存储介质。计算机可读存储介质上存储有计算机程序,计算机程序被处理器执行时,实现本发明公开第一方面中任一项的一种统一的语音合成与语音转换的训练方法中的步骤。

20.本发明提出的方案,具有如下有益效果:1.将语音合成与语音转换模型进行了统一,避免了独立搭建的困难。

21.2.使用无标注的语音提高语音合成与语音转换的性能。

附图说明

22.为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施方式,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

23.图1为根据本发明实施例的一种统一的语音合成与语音转换的训练方法的流程图;图2为根据本发明实施例的训练方法的结构图;图3为根据本发明实施例的子任务的结构图;图4为根据本发明实施例的一种统一的语音合成与语音转换的训练系统的结构图;图5为根据本发明实施例的一种电子设备的结构图。

具体实施方式

24.为使本发明实施例的目的、技术方案和优点更加清楚,下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例只是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

25.本发明第一方面公开了一种统一的语音合成与语音转换的训练方法。图1为根据本发明实施例的一种统一的语音合成与语音转换的训练方法的流程图,如图1所示,所述方法包括:步骤s1、将语音合成和语音转换的编码任务解耦成三个子任务,分别为内容信息的提取、说话人信息的提取和韵律信息的提取;所述内容信息是与说话人无关的语言信息;所述说话人信息包括:说话人的特征;所述韵律信息表示说话人如何说出内容信息,反映语音的节奏;步骤s2、将提取得到的所述内容信息、说话人信息和韵律信息输入解码任务,得到还原的语音信息。

26.在步骤s1,将语音合成和语音转换的编码任务解耦成三个子任务,分别为内容信息的提取、说话人信息的提取和韵律信息的提取;所述内容信息是与说话人无关的语言信息;所述说话人信息包括:说话人的特征,如音色、音量等;所述韵律信息表示说话人如何说出内容信息,反映语音的节奏。

27.在一些实施例中,为了生成可理解的语音信号,建模准确的语音内容信息是非常重要。由于tts和vc的输入信号类型不同,所以提取内容信息的方法也不同。在所述内容信息的提取的子任务中,对于语音合成,语音内容的来源是文本,使用文本编码器对文本进行编码以获得上下文表示;根据音素的持续时间信息对所述上下文表示进行上采样,以获得语音的内容信息;对于语音转换,由于源语音与目标语音对齐,直接使用内容编码器从源语音中提取语音的内容信息。

28.在一些实施例中,所述说话人信息的提取的编码器在语音合成与语音转换的任务中是共享的,直接从没有文本的语音中提取所述说话人信息;vc任务中大量没有文本标注的数据可以用于训练,这有助于提高模型的迁移学习能力。

29.在一些实施例中,由于基频信息能够反映语音的节奏,因此,基频信息被用来提取作为韵律信息。

30.在一些实施例中,所述韵律信息的提取的编码器在语音合成与语音转换的任务中是共享的,直接从语音中提取基频信息作为所述韵律信息;在训练阶段,以语音的内容信息和说话人信息为输入来预测基频信息。

31.在一些实施例中,语音合成和语音转换的总损失函数包括三部分,语音合成的损失函数、语音转换的损失函数和额外的内容信息损失函数,即,总损失函数=语音合成的损失函数+语音转换的损失函数+额外的内容信息损失函数;所述额外的内容信息损失函数的构造方法包括:应用矢量量化码本进行编码分别提取语音合成的内容信息和语音转换的内容信息;

再应用语音合成的内容信息和语音转换的内容信息的差值,构造所述额外的内容信息损失函数;语音合成的损失函数包含两部分,一部分是语音合成的语音的重构损失,另一部分是语音合成的基频的重构损失,即,语音合成的损失函数=语音合成的语音的重构损失+语音合成的基频的重构损失;语音转换的损失函数包含两部分,一部分是语音转换的语音的重构损失,另一部分是语音转换的基频的重构损失,即,语音转换的损失函数=语音转换的语音的重构损失+语音转换的基频的重构损失。

32.具体实施过程训练流程:1、首先训练输入tts数据,即文本x和其对应的语音y。

33.从y中提取基频信息f0和说话人信息s,再通过f0提取韵律信息p;从x中提取说话内容信息c。

34.这三种信息的提取过程可以用公式表示为:c = vq(text_encoder(x))s = speaker_encoder(y)p = prosody_encoder(y)vq表示为矢量量化;text_encoder(

•

)表示为文本编码器;speaker_encoder(

•

)表示为说话人信息编码器;prosody_encoder(

•

)表示为韵律信息编码器;最后将三个信息相加然后输入到解码器decoder模块中,还原出y信息。

35.y

’ꢀ

= decoder(c + s + p)f0

’ꢀ

= pitch_predictor(c+s)该过程的损失包含两部分,一部分是y的重构损失,一部分是基频的重构损失。

36.2、然后训练vc数据,只使用语音数据y即可。(y即包括无标注数据,也包括有标注数据)不同于tts,此时说话内容信息直接从y中提取。

37.c

’ꢀ

= vq(content_encoder(y))s

’ꢀ

= speaker_encoder(y)p

’ꢀ

= prosody_encoder(y)最后将三个信息相加然后输入到decoder模块中,还原出y信息。

38.y

’ꢀ

= decoder(c

’ꢀ

+ s

’ꢀ

+ p’)f0

’ꢀ

= pitch_predictor(c’+s’)该过程的损失包含两部分,一部分是y的重构损失,一部分是基频的重构损失。

39.3、tts和vc的内容信息损失对于有标注的数据y,在tts流程中和vc流程中会获得不同的说话内容信息c和c’。为了统一tts和vc框架,做了两个工作,分别是在提取c和c’的时候使用同一个vq码本进行编码。另一方面采用额外的内容损失对有标注的语音进行说话内容损失监督。损失如下:故,总的损失包含三个部分:测试阶段根据语音生成任务的不同,具体的,是需要语音合成任务还是语音转换任务,有不同的推理路径。

40.语音合成任务:推理采用图2中左侧的方式合成目标说话人的语音即可。

41.语音转换任务:推理采用图2中右侧的方式合成目标说话人的语音即可。

42.实施案例:所提的统一的tts和vc训练框架如图2所示。具体的,其中每个子模块的结构可以如图3示。文本编码器中的前馈变换器(fft)块数为2,解码器模块中为6。在每个fft块中,隐藏状态的维数为256。所有一维卷积的内核大小都设置为3。辍学率设置为0.5。解码器中最后一个线性层的维数为80,这与mel谱维数一致。编码器(文本编码器、韵律信息编码器、内容信息编码器)中最后一个线性层的尺寸是256。adam优化器用于更新参数。初始学习率为0.001,学习率呈指数下降。在推理阶段,hifigan被用作声码器。

43.此外需要额外训练一个时长模型,该时长模型在语音合成任务中非常常见,示例采用3层全连接层即可实现。

44.根据以上描述将模型进行构建之后,根据具体实施过程的第一步的方法进行训练模型。再根据具体实施过程的第二步的方法即可实现使用同一个框架对语音合成和语音转换任务进行实现。

45.综上,本发明提出的方案能够,1.将语音合成与语音转换模型进行了统一,避免了独立搭建的困难。

46.2.使用无标注的语音提高语音合成与语音转换的性能。

47.本发明第二方面公开了一种统一的语音合成与语音转换的训练系统。图4为根据本发明实施例的一种统一的语音合成与语音转换的训练系统的结构图;如图4所示,所述系统100包括:第一处理模块101,被配置为,将语音合成和语音转换的编码任务解耦成三个子任务,分别为内容信息的提取、说话人信息的提取和韵律信息的提取;所述内容信息是与说话人无关的语言信息;所述说话人信息包括:说话人的特征;所述韵律信息表示说话人如何说出内容信息,反映语音的节奏;第二处理模块102,被配置为,将提取得到的所述内容信息、说话人信息和韵律信息输入解码任务,得到还原的语音信息。

48.根据本发明第二方面的系统,第一处理模块101,被配置为,在所述内容信息的提

取的子任务中,对于语音合成,语音内容的来源是文本,使用文本编码器对文本进行编码以获得上下文表示;根据音素的持续时间信息对所述上下文表示进行上采样,以获得语音的内容信息。

49.根据本发明第二方面的系统,第一处理模块101,被配置为,在所述内容信息的提取的子任务中,对于语音转换,由于源语音与目标语音对齐,直接使用内容编码器从源语音中提取语音的内容信息。

50.根据本发明第二方面的系统,第一处理模块101,被配置为,述韵律信息的提取的编码器在语音合成与语音转换的任务中是共享的,直接从语音中提取基频信息作为所述韵律信息。

51.根据本发明第二方面的系统,第一处理模块101,被配置为,在训练阶段,以语音的内容信息和说话人信息为输入来预测基频信息。

52.根据本发明第二方面的系统,第一处理模块101,被配置为,语音合成和语音转换的总损失函数包括三部分,语音合成的损失函数、语音转换的损失函数和额外的内容信息损失函数,即,总损失函数=语音合成的损失函数+语音转换的损失函数+额外的内容信息损失函数;所述额外的内容信息损失函数的构造包括:应用矢量量化码本进行编码分别提取语音合成的内容信息和语音转换的内容信息;再应用语音合成的内容信息和语音转换的内容信息的差值,构造所述额外的内容信息损失函数;语音合成的损失函数包含两部分,一部分是语音合成的语音的重构损失,另一部分是语音合成的基频的重构损失,即,语音合成的损失函数=语音合成的语音的重构损失+语音合成的基频的重构损失;语音转换的损失函数包含两部分,一部分是语音转换的语音的重构损失,另一部分是语音转换的基频的重构损失,即,语音转换的损失函数=语音转换的语音的重构损失+语音转换的基频的重构损失。

53.本发明第三方面公开了一种电子设备。电子设备包括存储器和处理器,存储器存储有计算机程序,处理器执行计算机程序时,实现本发明公开第一方面中任一项的一种统一的语音合成与语音转换的训练方法中的步骤。

54.图5为根据本发明实施例的一种电子设备的结构图,如图5所示,电子设备包括通过系统总线连接的处理器、存储器、通信接口、显示屏和输入装置。其中,该电子设备的处理器用于提供计算和控制能力。该电子设备的存储器包括非易失性存储介质、内存储器。该非易失性存储介质存储有操作系统和计算机程序。该内存储器为非易失性存储介质中的操作系统和计算机程序的运行提供环境。该电子设备的通信接口用于与外部的终端进行有线或无线方式的通信,无线方式可通过wifi、运营商网络、近场通信(nfc)或其他技术实现。该电子设备的显示屏可以是液晶显示屏或者电子墨水显示屏,该电子设备的输入装置可以是显示屏上覆盖的触摸层,也可以是电子设备外壳上设置的按键、轨迹球或触控板,还可以是外接的键盘、触控板或鼠标等。

55.本领域技术人员可以理解,图5中示出的结构,仅仅是与本公开的技术方案相关的部分的结构图,并不构成对本技术方案所应用于其上的电子设备的限定,具体的电子设备可以包括比图中所示更多或更少的部件,或者组合某些部件,或者具有不同的部件布置。

56.本发明第四方面公开了一种计算机可读存储介质。计算机可读存储介质上存储有计算机程序,计算机程序被处理器执行时,实现本发明公开第一方面中任一项的一种统一的语音合成与语音转换的训练方法中的步骤中的步骤。

57.请注意,以上实施例的各技术特征可以进行任意的组合,为使描述简洁,未对上述实施例中的各个技术特征所有可能的组合都进行描述,然而,只要这些技术特征的组合不存在矛盾,都应当认为是本说明书记载的范围。以上实施例仅表达了本技术的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术构思的前提下,还可以做出若干变形和改进,这些都属于本技术的保护范围。因此,本技术专利的保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1