音乐生成方法、装置和电子设备与流程

1.本技术属于人工智能技术领域,具体涉及一种音乐生成方法、装置和电子设备。

背景技术:

2.现代很多人都被压力、焦虑、迷茫、身体亚健康所侵扰,音乐疗法便成为时下热门的疗愈方式。例如,颂钵音疗,其主要原理是采用声波共振疗法。颂钵音疗的钵体,由于特殊材质及敲击手法,其发出的音频振动会触达人体的听觉、触觉、感觉部位的神经,达到按摩振动到神经的作用。

3.相关技术中,通常是用户在视频网站下载预先上传的音乐,并播放下载的音乐,以放松心情,缓解焦虑。

4.但上述相关技术中,预先上传的音乐是公共音乐,比较通用。

技术实现要素:

5.本技术实施例的目的是提供一种音乐生成方法、装置和电子设备,能够解决音乐比较通用的问题。

6.第一方面,本技术实施例提供了一种音乐生成方法,该方法包括:

7.获取初始音乐数据和第一用户数据;所述第一用户数据为在播放所述初始音乐数据的情况下获取到的;

8.基于所述初始音乐数据确定音乐特征;

9.基于所述第一用户数据确定用户特征;

10.基于所述音乐特征和所述用户特征生成第一目标音乐数据。

11.第二方面,本技术实施例提供了一种音乐生成装置,该装置包括:

12.第一获取模块,用于获取初始音乐数据和第一用户数据;所述第一用户数据为在播放所述初始音乐数据的情况下获取到的;

13.第一确定模块,用于基于所述初始音乐数据确定音乐特征;

14.第二确定模块,用于基于所述第一用户数据确定用户特征;

15.生成模块,用于基于所述音乐特征和所述用户特征生成第一目标音乐数据。

16.第三方面,本技术实施例提供了一种电子设备,该电子设备包括处理器和存储器,所述存储器存储可在所述处理器上运行的程序或指令,所述程序或指令被所述处理器执行时实现如第一方面所述的方法的步骤。

17.第四方面,本技术实施例提供了一种可读存储介质,所述可读存储介质上存储程序或指令,所述程序或指令被处理器执行时实现如第一方面所述的方法的步骤。

18.第五方面,本技术实施例提供了一种芯片,所述芯片包括处理器和通信接口,所述通信接口和所述处理器耦合,所述处理器用于运行程序或指令,实现如第一方面所述的方法。

19.第六方面,本技术实施例提供一种计算机程序产品,该程序产品被存储在存储介

质中,该程序产品被至少一个处理器执行以实现如第一方面所述的方法。

20.在本技术实施例中,提取初始音乐数据中的音乐特征,并提取在播放初始音乐数据的情况下获取到的用户数据中的用户特征,基于音乐特征和用户特征生成第一目标音乐数据,在第一目标音乐数据的生成过程中考虑了用户收听初始音乐数据时对应的用户数据,从而实现了个性化音乐的生成。

附图说明

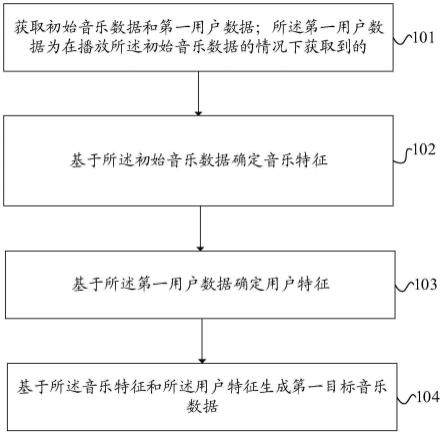

21.图1是本技术实施例提供的音乐生成方法的流程示意图之一;

22.图2是本技术实施例提供的音乐生成方法的流程示意图之二;

23.图3是本技术实施例提供的音乐生成方法的流程示意图之三;

24.图4是本技术实施例提供的网络结构示意图;

25.图5是本技术实施例提供的音乐生成方法的流程示意图之四;

26.图6是本技术实施例提供的音乐生成方法的流程示意图之五;

27.图7是本技术实施例提供的音乐生成装置的结构示意图;

28.图8是本技术实施例提供的电子设备的结构示意图;

29.图9为实现本技术实施例提供的电子设备的硬件结构示意图。

具体实施方式

30.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚地描述,显然,所描述的实施例是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员获得的所有其他实施例,都属于本技术保护的范围。

31.本技术的说明书和权利要求书中的术语“第一”、“第二”等是用于区别类似的对象,而不用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便本技术的实施例能够以除了在这里图示或描述的那些以外的顺序实施,且“第一”、“第二”等所区分的对象通常为一类,并不限定对象的个数,例如第一对象可以是一个,也可以是多个。此外,说明书以及权利要求中“和/或”表示所连接对象的至少其中之一,字符“/”,一般表示前后关联对象是一种“或”的关系。

32.下面结合附图,通过具体的实施例及其应用场景对本技术实施例提供的音乐生成方法、音乐生成装置、电子设备和可读存储介质进行详细地说明。

33.图1是本技术实施例提供的音乐生成方法的流程示意图之一,如图1所示,该音乐生成方法包括以下步骤101、步骤102、步骤103和步骤104;其中:

34.步骤101、获取初始音乐数据和第一用户数据;所述第一用户数据为在播放所述初始音乐数据的情况下获取到的。

35.其中,在播放初始音乐数据时,用户在收听播放的初始音乐数据。

36.示例地,在用户需要通过音乐放松心情时,可以在视频网站下载想收听的初始音乐数据,播放初始音乐数据,并在播放初始音乐数据的过程中,获取用户收听初始音乐数据时身体的变化信息,即获取第一用户数据。

37.步骤102、基于所述初始音乐数据确定音乐特征。

38.示例地,在获取到初始音乐数据时,对初始音乐数据进行特征分析,得到音乐特

征,该音乐特征可以为产生初始音乐的乐器尺寸特征、产生初始音乐的乐器操作手段特征、搭配的环境音特征以及适用的场景特征等,其中,乐器操作手段可以为敲击或者摩擦等,环境音可以为海浪声音、鸟叫声音等,场景可以为夏天、心跳过快等。

39.步骤103、基于所述第一用户数据确定用户特征。

40.示例地,在获取到第一用户数据时,对第一用户数据进行特征分析,得到用户特征,该用户特征可以为用户收听初始音乐数据的体温特征、心率特征、脑电波特征和表情特征等。

41.步骤104、基于所述音乐特征和所述用户特征生成第一目标音乐数据。

42.示例地,在得到音乐特征和用户特征时,将音乐特征和用户特征进行合成,得到第一目标音乐数据。

43.本技术实施例提供的音乐生成方法,提取初始音乐数据中的音乐特征,并提取在播放初始音乐数据的情况下获取到的用户数据中的用户特征,基于音乐特征和用户特征生成第一目标音乐数据,在第一目标音乐数据的生成过程中考虑了用户收听初始音乐数据时对应的用户数据,从而实现了个性化音乐的生成。

44.在一实施例中,图2是本技术实施例提供的音乐生成方法的流程示意图之二,如图2所示,上述步骤102具体可通过以下步骤实现:

45.步骤1021、将所述初始音乐数据输入至目标模型的编码器中,得到所述编码器输出的音乐向量。

46.步骤1022、将所述音乐向量输入至所述目标模型的分类器中,得到所述分类器输出的音乐特征。

47.其中,所述音乐特征包括以下至少一项:乐器尺寸特征、乐器操作手段特征、环境音特征和场景特征;所述目标模型是基于音乐数据样本和所述音乐数据样本对应的标签训练得到的;所述标签包括以下至少一项:乐器尺寸标签、乐器操作手段标签、环境音标签和场景标签。

48.示例地,目标模型包括编码器、分类器和生成器,其中,编码器可以为长短期记忆(long short-term memory,lstm)编码器,目标模型的训练过程具体为:首先对每个音乐数据样本进行打标签,以标注每个音乐数据样本对应的乐器尺寸、对应的乐器操作手段、是否搭配环境音以及每个音乐数据样本适用的场景,并构建初始编码器、初始分类器和初始合成器,然后将音乐数据样本拆分成多个音乐数据片段样本,不同长度的音乐数据片段样本可以填充到等长度,使用嵌入层embedding对每个音乐数据片段样本进行编码,得到每个音乐数据片段样本对应的编码得到的向量样本,例如,编码得到的向量样本可以表示为batch

×

length

×

1024,batch为每次输入lstm的数据数量,length表示音乐数据片段样本的长度,1024为超参数;将编码得到的向量样本输入至lstm,得到lstm输出的音乐向量样本,例如,音乐向量样本可以表示为batch

×

1024;再将音乐向量样本输入至初始分类器中,得到初始分类器输出的音乐特征样本,该音乐特征样本包括乐器尺寸样本、乐器操作手段样本、环境音样本以及场景样本等,基于标签和音乐特征样本确定第一交叉熵损失;再将音乐向量输入至初始生成器中,得到初始生成器输出的音乐序列样本,基于音乐序列样本和当前输入的音乐数据片段样本的下一音乐数据片段样本确定第二交叉熵损失,使用第一交叉熵损失和第二交叉熵损失的和作为总损失函数,基于总损失函数优化初始编码器的参数、初

始分类器的参数和初始生成器的参数,直至达到收敛条件,得到训练好的编码器、分类器和生成器,由训练好的编码器、分类器和生成器组成目标模型,实现了自编码生成训练和多任务训练。

49.示例地,假设目标模型是基于音乐数据样本和音乐数据样本对应的乐器尺寸标签、乐器操作手段标签、环境音标签和场景标签训练得到的,将初始音乐数据输入至目标模型的编码器中,由编码器对初始音乐数据进行编码,得到音乐向量,然后将音乐向量输入至目标模型的分类器中,由分类器基于音乐向量对音乐特征进行预测,得到乐器尺寸特征、乐器操作手段特征、环境音特征和场景特征。

50.需要说明的是,目标模型中的生成器可以包括lstm解码器和因素分类器,通过lstm解码器合成音乐序列,通过因素分类器将合成的音乐序列进行分类,得到乐器尺寸、乐器操作手段、环境音和场景等,使得生成器具备音乐合成的能力和音乐分类的能力。

51.本技术实施例提供的音乐生成方法,基于目标模型的编码器将初始音乐数据进行编码,得到音乐向量,再基于目标模型的分类器对音乐向量进行特征提取,得到音乐特征,实现了音乐特征的自动提取。

52.在一实施例中,所述第一用户数据包括以下至少一项:生理数据、表情数据和脑电波数据;所述生理数据包括以下至少一项:体温数据、心率数据和用户偏好数据;所述用户偏好数据包括以下至少一项:用户偏好乐器尺寸、用户偏好乐器操作手段、用户偏好环境音和用户偏好场景;上述步骤103具体可通过以下方式实现:

53.基于所述第一用户数据确定目标特征;所述目标特征包括以下至少一项:生理特征、表情特征和脑电波特征;所述体温数据对应的生理特征包括体温特征,所述心率数据对应的生理特征包括心率特征,所述用户偏好数据对应的生理特征包括用户偏好特征。

54.在所述目标特征包括所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征的情况下,将所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征均输入至第一特征融合模型中,得到所述第一特征融合模型输出的所述用户特征。

55.所述目标特征为通过第一特征提取模型对所述第一用户数据进行特征提取得到的;所述第一特征提取模型是基于第一用户数据样本训练得到的。

56.具体的,在目标特征为生理特征的情况下,第一特征提取模型包括第一特征提取子模型,所述生理特征为通过第一特征提取子模型对所述生理数据进行特征提取得到的;所述第一特征提取子模型是基于生理数据样本训练得到的;在目标特征为表情特征的情况下,第一特征提取模型包括第二特征提取子模型,所述表情特征为通过第二特征提取子模型对所述表情数据进行特征提取得到的;所述第二特征提取子模型是基于表情数据样本训练得到的;在目标特征为脑电波特征的情况下,第一特征提取模型包括第三特征提取子模型,所述脑电波特征为通过第三特征提取子模型对所述脑电波数据进行特征提取得到的;所述第三特征提取子模型是基于脑电波数据样本训练得到的。

57.其中,第一特征提取子模型可以为三层全连接网络,例如,第一层全连接网络的权重大小为3

×

128,第二层全连接网络的权重大小为128

×

512,第三层全连接网络的权重大小为512

×

256,则第一特征提取子模型输出的生理特征的维度为256;第二特征提取子模型可以为视觉几何组(visual geometry group,vgg)网络,输出的表情特征的维度可以为1024,;第三特征提取子模型可以为一层全连接层和transformer网络的组合,通过一层全

连接层将脑电波数据映射成300维度的向量表示,再使用6层的transformer网络学习脑电波的特征表示,输出的脑电波特征的维度可以为512。

58.示例地,可以通过用户佩戴的智能手表或手环等穿戴设备采集用户的心率数据和体温数据,并获取之前存储的用户偏好数据,在初始使用时,用户偏好数据为空值;用户喜欢搭配鸟叫声收听音乐,则用户偏好环境音为鸟叫声音;用户喜欢在心跳加快的时候收听音乐,则用户偏好场景为心跳加快场景;用户喜欢敲击钵体产生的音乐,则用户偏好乐器操作手段为敲击;用户喜欢尺寸较小的钵体产生的音乐,则用户偏好乐器尺寸为小尺寸,例如用户偏好口径为5厘米的钵体,将用户收听初始音乐数据时的心率数据、体温数据和用户偏好数据作为生理数据,更能够体现用户收听初始音乐数据时的反应,进一步在基于生理数据生成目标音乐数据时,使得生成的目标音乐数据更符合用户,更加个性化。

59.示例地,以第一用户数据包括生理数据、表情数据和脑电波数据为例,通过用户佩戴的智能手表或手环等穿戴设备定时采集生理数据,通过手机等终端设备的摄像头定时采集用户的表情图片作为表情数据,例如,每隔10秒采集一次表情图片,一分钟采集6张表情图片,对每张表情图片对应的表情特征求平均得到最终的表情特征;通过头戴设备定时采集用户的脑电波数据,例如,每隔1秒采集一次脑电波数据。

60.将生理数据输入至第一特征提取子模型中,由第一特征提取子模型对生理数据进行特征分析,得到生理特征;将表情数据输入至第二特征提取子模型中,由第二特征提取子模型对表情数据进行特征分析,得到表情特征;将脑电波数据输入至第三特征提取子模型中,由第三特征提取子模型对脑电波数据进行特征分析,得到脑电波特征,最后将生理特征、表情特征和脑电波特征进行融合,得到用户特征。

61.示例地,以目标特征包括生理特征、表情特征和脑电波特征为例,将生理特征、表情特征和脑电波特征输入至第一特征融合模型中,其中,第一特征融合模型可以为两层全连接层,例如,按照上述得到的生理特征的维度为256,表情特征的维度为1024,脑电波特征的维度为512,则第一层全连接层的权重大小可以为1792

×

2048,第二层全连接层的权重大小可以为2048

×

1024,最终第一特征融合模型输出的用户特征的维度为1024。

62.需要说明的是,在目标特征包括生理特征、表情特征和脑电波特征中的任一种特征的情况下,则该任一种特征就作为用户特征。

63.本技术实施例提供的音乐生成方法,基于第一特征提取子模型对生理数据进行特征提取得到生理特征,基于第二特征提取子模型对表情数据进行特征提取得到表情特征,基于第三特征提取子模型对脑电波数据进行特征提取得到脑电波特征,将生理特征、表情特征和脑电波特征确定为用户特征,实现了用户特征的自动提取;另外,将生理特征、表情特征和脑电波特征中的至少两种特征进行拼接,得到用户特征,使得用户特征比较丰富,更能够体现用户收听初始音乐数据时的反应,进一步在基于用户特征生成目标音乐数据时,使得生成的目标音乐数据更符合用户,更加个性化。

64.在一实施例中,图3是本技术实施例提供的音乐生成方法的流程示意图之三,如图3所示,上述步骤104具体可通过以下步骤实现:

65.步骤1041、将所述音乐特征和所述用户特征输入至第二特征融合模型中,通过所述第二特征融合模型基于所述用户特征确定所述音乐特征中包含的每个特征对应的余弦相似度,并将所述余弦相似度和对应的特征进行加权求和,得到所述第二特征融合模型输

出的音乐融合特征。

66.其中,第二特征融合模型可以为注意力(attention)模型。

67.示例地,在得到音乐特征和用户特征时,将音乐特征和用户特征输入至第二特征融合模型中,由第二特征融合模型基于用户特征计算音乐特征中包含的每个特征对应的余弦相似度,再将余弦相似度和对应的特征进行加权求和,得到音乐融合特征。

68.步骤1042、将所述音乐融合特征输入至所述目标模型的生成器中,通过所述生成器基于所述音乐融合特征得到所述第一目标音乐数据。

69.示例地,将音乐融合特征输入至上述训练好的目标模型的生成器中,由生成器基于音乐融合特征生成第一目标音乐数据。

70.另外,上述第一特征提取子模型、第二特征提取子模型、第三特征提取子模型、第一特征融合模型、第二特征融合模型以及生成器可以一起进行训练,具体训练过程为:收集音乐数据样本、生理数据样本、表情数据样本和脑电波数据样本和音乐数据样本,构建第一初始特征提取模型、第二初始特征提取模型、第三初始特征提取模型、第一初始特征融合模型和第二初始特征融合模型,将音乐数据样本进行用户特征标记,例如在音乐数据样本中进行高体温,中心率,面部紧张和脑电活跃等标记;将生理数据样本输入至第一初始特征提取模型中,得到第一初始特征提取模型输出的生理特征样本;将表情数据样本输入至第二初始特征提取模型中,得到第二初始特征提取模型输出的表情特征样本;将脑电波数据样本输入至第三初始特征提取模型中,得到第三初始特征提取模型输出的脑电波特征样本;然后将生理特征样本、表情特征样本和脑电波特征样本均输入至第一初始特征融合模型中,得到第一初始特征融合模型输出的用户特征样本,将用户特征样本和音乐特征样本均输入至第二初始特征融合模型中,得到第二初始特征融合模型输出的音乐融合特征样本,最后将音乐融合特征样本输入至生成器中,得到生成器输出的预测音乐向量,基于预测音乐向量和标记的音乐数据样本对应的音乐向量构建交叉熵损失函数,基于交叉熵损失函数优化第一初始特征提取模型的参数、第二初始特征提取模型的参数、第三初始特征提取模型的参数、第一初始特征融合模型的参数、第二初始特征融合模型的参数以及微调生成器的参数,直至达到收敛条件,得到第一特征提取子模型、第二特征提取子模型、第三特征提取子模型、第一特征融合模型、第二特征融合模型以及优化后的生成器。

71.图4是本技术实施例提供的网络结构示意图,如图4所示,该音乐生成方法包括目标模型401、第一特征提取子模型402、第二特征提取子模型403、第三特征提取子模型404、第一特征融合模型405和第二特征融合模型406,其中,目标模型401包括编码器4011、分类器4012和生成器4013,将初始音乐数据输入至目标模型401的编码器4011中,得到编码器4011输出的音乐向量;将音乐向量输入至目标模型401的分类器4012中,得到分类器4012输出的音乐特征;将生理数据输入至第一特征提取子模型402中,得到第一特征提取子模型402输出的生理特征,将表情数据输入至第二特征提取子模型403中,得到第二特征提取子模型403输出的表情特征,将脑电波数据输入至第三特征提取子模型404中,得到第三特征提取子模型404输出的脑电波特征,将生理特征、表情特征和脑电波特征输入至第一特征融合模型405中,得到第一特征融合模型405输出的用户特征;再将第一特征融合模型405输出的用户特征和分类器4012输出的音乐特征输入至第二特征融合模型406中,得到第二特征融合模型406输出的音乐融合特征,最后将音乐融合特征输入至目标模型401的生成器4013

中,得到最终输出的第一目标音乐数据。

72.本技术实施例提供的音乐生成方法,通过第二特征融合模型将音乐特征和用户特征进行融合,得到音乐融合特征,再将音乐融合特征输入至目标模型的生成器中,以生成符合用户自身的第一目标音乐数据,实现了个性化的第一目标音乐数据的在线生成。

73.在一实施例中,图5是本技术实施例提供的音乐生成方法的流程示意图之四,如图5所示,在上述步骤104之后,该音乐生成方法还包括以下步骤:

74.步骤105、播放所述第一目标音乐数据。

75.示例地,在生成符合用户的第一目标音乐数据时,将第一目标音乐数据通过扬声器进行播放,使得用户能够在线收听符合自己的第一目标音乐数据。

76.步骤106、获取第二用户数据。

77.示例地,在用户在线收听第一目标音乐数据的同时,继续采集用户在收听第一目标音乐数据时的身体数据,即通过用户佩戴的智能手表或手环等穿戴设备定时采集体温数据和心率数据,通过摄像头采集用户的表情数据,通过头戴设备采集用户的脑电波数据,将新采集的体温数据、心率数据、表情数据和脑电波数据作为第二用户数据。

78.步骤107、在确定所述第一用户数据与所述第二用户数据的差值小于或等于第一预设阈值的情况下,将所述第一用户数据更新为所述第二用户数据,并返回至所述基于所述第一用户数据确定用户特征的步骤,得到第二目标音乐数据。

79.示例地,在得到第二用户数据时,将第二用户数据与之前获取的第一用户数据进行比较,例如,第二用户数据包括新的脑电波数据和新的心率数据,首先确定新的脑电波数据对应的第一脑电波值和之前的脑电波数据对应的第二脑电波值,并确定新的心率数据对应的变异序列的第一排列熵值和之前的心率数据对应的变异序列的第二排列熵值,将第二脑电波值与第一脑电波值进行比较,并将第二排列熵值与第一排列熵值进行比较,在确定第二脑电波值与第一脑电波值的差值小于或等于第一预设阈值,例如,第一预设阈值为2赫兹,且确定第二排列熵值与第一排列熵值的差值小于或等于第一预设阈值,例如,第一预设阈值为3,则说明当前播放的第一目标音乐数据不是很符合用户,需要基于第二用户数据对应的用户特征和音乐特征重新生成第二目标音乐数据。

80.需要说明的是,在确定第二脑电波值与第一脑电波值的差值大于第一预设阈值,和/或,确定第二排列熵值与第一排列熵值的差值大于第一预设阈值时,说明当前播放的第一目标音乐数据符合用户,继续播放第一目标音乐数据,并继续获取用户在收听第一目标音乐数据时的第二用户数据。

81.需要说明的是,第二用户数据还可以包括心率数据、体温数据和表情数据等,例如,之前获取的表情数据为皱眉,新的表情数据可以皱眉,则说明当前播放的第一目标音乐数据不符合用户,需要重新生成第二目标音乐数据,本技术对此不作限定。

82.需要说明的是,在获取到第二用户数据时,还可以将第二用户数据作为用户数据样本继续对上述的目标模型、第一特征提取子模型、第二特征提取子模型、第三特征提取子模型、第一特征融合模型和第二特征融合模型的模型参数进行再学习,使得最终得到的各个模型更加准确。

83.步骤108、将所述第一目标音乐数据替换为所述第二目标音乐数据进行播放。

84.示例地,在重新生成第二目标音乐数据时,将第二目标音乐数据作为当前需要播

放的音乐进行播放,并继续获取用户在收听第二目标音乐数据时的第二用户数据,不断的更新播放的音乐,以实现音乐的个性化生成。

85.本技术实施例提供的音乐生成方法,在播放第一目标音乐数据的同时,通过继续监测用户数据进行反馈,实时调整正在播放的音乐,使得生成的音乐更加个性化。

86.在一实施例中,图6是本技术实施例提供的音乐生成方法的流程示意图之五,如图6所示,在上述步骤105之后,该音乐生成方法还包括以下步骤:

87.步骤109、获取停止播放指令;所述停止播放指令包括基于接收到的关闭输入生成的指令,或者,在所述第一用户数据中的脑电波数据小于或等于第二预设阈值的情况下生成的指令。

88.示例地,在播放第一目标音乐数据时,若用户不想收听第一目标音乐数据,则可以在播放界面上点击预先配置的关闭控件,执行关闭输入,使得电子设备接收到用户的关闭输入时生成停止播放指令;或者,电子设备将第一用户数据中的脑电波数据对应的脑电波值与第二预设阈值进行比较,例如第二预设阈值为7赫兹,在科学意义上脑电波值小于7赫兹时认为用户处于睡眠状态;在确定脑电波值小于或等于第二预设阈值时,则生成停止播放指令。

89.步骤110、响应于所述停止播放指令,关闭所述第一目标音乐数据。

90.示例地,在获取到停止播放指令时,响应于停止播放指令,停止播放第一目标音乐数据。

91.需要说明的是,在当前播放的音乐数据为替换后的第二目标音乐数据时,则关闭的也是第二目标音乐数据。

92.本技术实施例提供的音乐生成方法,可以基于用户需求触发关闭第一目标音乐数据,也可以在检测到用户处于睡眠状态时关闭第一目标音乐数据,实现第一目标音乐数据的实时关闭,避免给用户带来不良体验。

93.本技术实施例提供的音乐生成方法,执行主体可以为音乐生成装置。本技术实施例中以音乐生成装置执行音乐生成方法为例,说明本技术实施例提供的音乐生成装置。

94.图7是本技术实施例提供的音乐生成装置的结构示意图,如图7所示,该音乐生成装置700包括第一获取模块701、第一确定模块702、第二确定模块703和生成模块704;其中:

95.第一获取模块701,用于获取初始音乐数据和第一用户数据;所述第一用户数据为在播放所述初始音乐数据的情况下获取到的;

96.第一确定模块702,用于基于所述初始音乐数据确定音乐特征;

97.第二确定模块703,用于基于所述第一用户数据确定用户特征;

98.生成模块704,用于基于所述音乐特征和所述用户特征生成第一目标音乐数据。

99.本技术实施例提供的音乐生成装置,提取初始音乐数据中的音乐特征,并提取在播放初始音乐数据的情况下获取到的用户数据中的用户特征,基于音乐特征和用户特征生成第一目标音乐数据,在第一目标音乐数据的生成过程中考虑了用户收听初始音乐数据时对应的用户数据,从而实现了个性化音乐的生成。

100.可选地,所述第一确定模块702还用于:

101.将所述初始音乐数据输入至目标模型的编码器中,得到所述编码器输出的音乐向量;

102.将所述音乐向量输入至所述目标模型的分类器中,得到所述分类器输出的音乐特征;所述音乐特征包括以下至少一项:乐器尺寸特征、乐器操作手段特征、环境音特征和场景特征;

103.所述目标模型是基于音乐数据样本和所述音乐数据样本对应的标签训练得到的;所述标签包括以下至少一项:乐器尺寸标签、乐器操作手段标签、环境音标签和场景标签。

104.可选地,所述第一用户数据包括以下至少一项:生理数据、表情数据和脑电波数据;所述生理数据包括以下至少一项:体温数据、心率数据和用户偏好数据;所述用户偏好数据包括以下至少一项:用户偏好乐器尺寸、用户偏好乐器操作手段、用户偏好环境音和用户偏好场景;所述第二确定模块703还用于:

105.基于所述第一用户数据确定目标特征;所述目标特征包括以下至少一项:生理特征、表情特征和脑电波特征;所述体温数据对应的生理特征包括体温特征,所述心率数据对应的生理特征包括心率特征,所述用户偏好数据对应的生理特征包括用户偏好特征;

106.在所述目标特征包括所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征的情况下,将所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征均输入至第一特征融合模型中,得到所述第一特征融合模型输出的所述用户特征;

107.所述目标特征为通过第一特征提取模型对所述第一用户数据进行特征提取得到的;所述第一特征提取模型是基于第一用户数据样本训练得到的。

108.可选地,所述生成模块704还用于:

109.将所述音乐特征和所述用户特征输入至第二特征融合模型中,通过所述第二特征融合模型基于所述用户特征确定所述音乐特征中包含的每个特征对应的余弦相似度,并将所述余弦相似度和对应的特征进行加权求和,得到所述第二特征融合模型输出的音乐融合特征;

110.将所述音乐融合特征输入至所述目标模型的生成器中,通过所述生成器基于所述音乐融合特征得到所述第一目标音乐数据。

111.可选地,所述音乐生成装置700还包括:

112.播放模块,用于播放所述第一目标音乐数据;

113.第二获取模块,用于获取第二用户数据;

114.第三确定模块,用于在确定所述第一用户数据与所述第二用户数据的差值小于或等于第一预设阈值的情况下,将所述第一用户数据更新为所述第二用户数据,并返回至所述基于所述第一用户数据确定用户特征的步骤,得到第二目标音乐数据;

115.所述播放模块,还用于将所述第一目标音乐数据替换为所述第二目标音乐数据进行播放。

116.可选地,所述音乐生成装置700还包括:

117.第三获取模块,用于获取停止播放指令;所述停止播放指令包括基于接收到的关闭输入生成的指令,或者,在所述第一用户数据中的脑电波数据小于或等于第二预设阈值的情况下生成的指令;

118.关闭模块,用于响应于所述停止播放指令,关闭所述第一目标音乐数据。

119.本技术实施例中的音乐生成装置可以是电子设备,也可以是电子设备中的部件,例如集成电路或芯片。该电子设备可以是终端,也可以为除终端之外的其他设备。示例性

的,电子设备可以为手机、平板电脑、笔记本电脑、掌上电脑、车载电子设备、移动上网装置(mobile internet device,mid)、增强现实(augmented reality,ar)/虚拟现实(virtual reality,vr)设备、机器人、可穿戴设备、超级移动个人计算机(ultra-mobile personal computer,umpc)、上网本或者个人数字助理(personal digital assistant,pda)等,还可以为服务器、网络附属存储器(network attached storage,nas)、个人计算机(personal computer,pc)、电视机(television,tv)、柜员机或者自助机等,本技术实施例不作具体限定。

120.本技术实施例中的音乐生成装置可以为具有操作系统的装置。该操作系统可以为安卓(android)操作系统,可以为ios操作系统,还可以为其他可能的操作系统,本技术实施例不作具体限定。

121.本技术实施例提供的音乐生成装置能够实现图1至图6的方法实施例实现的各个过程,为避免重复,这里不再赘述。

122.可选地,如图8所示,本技术实施例还提供一种电子设备800,包括处理器801和存储器802,存储器802上存储有可在所述处理器801上运行的程序或指令,该程序或指令被处理器801执行时实现上述音乐生成方法实施例的各个步骤,且能达到相同的技术效果,为避免重复,这里不再赘述。

123.需要说明的是,本技术实施例中的电子设备包括上述所述的移动电子设备和非移动电子设备。

124.图9为实现本技术实施例的一种电子设备的硬件结构示意图。

125.该电子设备900包括但不限于:射频单元901、网络模块902、音频输出单元903、输入单元904、传感器905、显示单元906、用户输入单元907、接口单元908、存储器909、以及处理器910等部件。

126.本领域技术人员可以理解,电子设备900还可以包括给各个部件供电的电源(比如电池),电源可以通过电源管理系统与处理器910逻辑相连,从而通过电源管理系统实现管理充电、放电、以及功耗管理等功能。图9中示出的电子设备结构并不构成对电子设备的限定,电子设备可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置,在此不再赘述。

127.其中,处理器910,用于获取初始音乐数据和第一用户数据;所述第一用户数据为在播放所述初始音乐数据的情况下获取到的;

128.处理器910,还用于基于所述初始音乐数据确定音乐特征;

129.处理器910,还用于基于所述第一用户数据确定用户特征;

130.处理器910,还用于基于所述音乐特征和所述用户特征生成第一目标音乐数据。

131.上述实施方式中,提取初始音乐数据中的音乐特征,并提取在播放初始音乐数据的情况下获取到的用户数据中的用户特征,基于音乐特征和用户特征生成第一目标音乐数据,在第一目标音乐数据的生成过程中考虑了用户收听初始音乐数据时对应的用户数据,从而实现了个性化音乐的生成。

132.可选地,所述处理器910还用于:

133.将所述初始音乐数据输入至目标模型的编码器中,得到所述编码器输出的音乐向量;

134.将所述音乐向量输入至所述目标模型的分类器中,得到所述分类器输出的音乐特征;所述音乐特征包括以下至少一项:乐器尺寸特征、乐器操作手段特征、环境音特征和场景特征;

135.所述目标模型是基于音乐数据样本和所述音乐数据样本对应的标签训练得到的;所述标签包括以下至少一项:乐器尺寸标签、乐器操作手段标签、环境音标签和场景标签。

136.上述实施方式中,基于目标模型的编码器将初始音乐数据进行编码,得到音乐向量,再基于目标模型的分类器对音乐向量进行特征提取,得到音乐特征,实现了音乐特征的自动提取。

137.可选地,所述第一用户数据包括以下至少一项:生理数据、表情数据和脑电波数据;所述生理数据包括以下至少一项:体温数据、心率数据和用户偏好数据;所述用户偏好数据包括以下至少一项:用户偏好乐器尺寸、用户偏好乐器操作手段、用户偏好环境音和用户偏好场景;

138.所述处理器910还用于:

139.基于所述第一用户数据确定目标特征;所述目标特征包括以下至少一项:生理特征、表情特征和脑电波特征;所述体温数据对应的生理特征包括体温特征,所述心率数据对应的生理特征包括心率特征,所述用户偏好数据对应的生理特征包括用户偏好特征;

140.在所述目标特征包括所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征的情况下,将所述生理特征、所述表情特征和所述脑电波特征中的至少两种特征均输入至第一特征融合模型中,得到所述第一特征融合模型输出的所述用户特征;

141.所述目标特征为通过第一特征提取模型对所述第一用户数据进行特征提取得到的;所述第一特征提取模型是基于第一用户数据样本训练得到的。

142.上述实施方式中,基于第一特征提取模型对生理数据进行特征提取得到生理特征,基于第二特征提取模型对表情数据进行特征提取得到表情特征,基于第三特征提取模型对脑电波数据进行特征提取得到脑电波特征,将生理特征、表情特征和脑电波特征确定为用户特征,实现了用户特征的自动提取;另外,将生理特征、表情特征和脑电波特征中的至少两种特征进行拼接,得到用户特征,使得用户特征比较丰富,更能够体现用户收听初始音乐数据时的反应,进一步在基于用户特征生成目标音乐数据时,使得生成的目标音乐数据更符合用户,更加个性化。

143.可选地,所述处理器910还用于:

144.将所述音乐特征和所述用户特征输入至第二特征融合模型中,通过所述第二特征融合模型基于所述用户特征确定所述音乐特征中包含的每个特征对应的余弦相似度,并将所述余弦相似度和对应的特征进行加权求和,得到所述第二特征融合模型输出的音乐融合特征;

145.将所述音乐融合特征输入至所述目标模型的生成器中,通过所述生成器基于所述音乐融合特征得到所述第一目标音乐数据。

146.上述实施方式中,通过第二特征融合模型将音乐特征和用户特征进行融合,得到音乐融合特征,再将音乐融合特征输入至目标模型的生成器中,以生成符合用户自身的第一目标音乐数据,实现了个性化的第一目标音乐数据的在线生成。

147.可选地,处理器910,还用于播放所述第一目标音乐数据;

148.处理器910,还用于获取第二用户数据;

149.处理器910,还用于在确定所述第一用户数据与所述第二用户数据的差值小于或等于第一预设阈值的情况下,将所述第一用户数据更新为所述第二用户数据,并返回至所述基于所述第一用户数据确定用户特征的步骤,得到第二目标音乐数据;

150.处理器910,还用于将所述第一目标音乐数据替换为所述第二目标音乐数据进行播放。

151.上述实施方式中,在播放第一目标音乐数据的同时,通过继续监测用户数据进行反馈,实时调整正在播放的音乐,使得生成的音乐更加个性化。

152.可选地,处理器910,还用于获取停止播放指令;所述停止播放指令包括基于接收到的关闭输入生成的指令,或者,在所述第一用户数据中的脑电波数据小于或等于第二预设阈值的情况下生成的指令;

153.处理器910,还用于响应于所述停止播放指令,关闭所述第一目标音乐数据。

154.上述实施方式中,可以基于用户需求触发关闭第一目标音乐数据,也可以在检测到用户处于睡眠状态时关闭第一目标音乐数据,实现第一目标音乐数据的实时关闭,避免给用户带来不良体验。

155.应理解的是,本技术实施例中,输入单元904可以包括图形处理器(graphics processing unit,gpu)9041和麦克风9042,图形处理器9041对在视频捕获模式或图像捕获模式中由图像捕获装置(如摄像头)获得的静态图片或视频的图像数据进行处理。显示单元906可包括显示面板9061,可以采用液晶显示器、有机发光二极管等形式来配置显示面板9061。用户输入单元907包括触控面板9071以及其他输入设备9072中的至少一种。触控面板9071,也称为触摸屏。触控面板9071可包括触摸检测装置和触摸控制器两个部分。其他输入设备9072可以包括但不限于物理键盘、功能键(比如音量控制按键、开关按键等)、轨迹球、鼠标、操作杆,在此不再赘述。

156.存储器909可用于存储软件程序以及各种数据。存储器909可主要包括存储程序或指令的第一存储区和存储数据的第二存储区,其中,第一存储区可存储操作系统、至少一个功能所需的应用程序或指令(比如声音播放功能、图像播放功能等)等。此外,存储器909可以包括易失性存储器或非易失性存储器,或者,存储器909可以包括易失性和非易失性存储器两者。其中,非易失性存储器可以是只读存储器(read-only memory,rom)、可编程只读存储器(programmable rom,prom)、可擦除可编程只读存储器(erasable prom,eprom)、电可擦除可编程只读存储器(electrically eprom,eeprom)或闪存。易失性存储器可以是随机存取存储器(random access memory,ram),静态随机存取存储器(static ram,sram)、动态随机存取存储器(dynamic ram,dram)、同步动态随机存取存储器(synchronous dram,sdram)、双倍数据速率同步动态随机存取存储器(double data rate sdram,ddrsdram)、增强型同步动态随机存取存储器(enhanced sdram,esdram)、同步连接动态随机存取存储器(synch link dram,sldram)和直接内存总线随机存取存储器(direct rambus ram,drram)。本技术实施例中的存储器909包括但不限于这些和任意其它适合类型的存储器。

157.处理器910可包括一个或多个处理单元;可选的,处理器910集成应用处理器和调制解调处理器,其中,应用处理器主要处理涉及操作系统、用户界面和应用程序等的操作,调制解调处理器主要处理无线通信信号,如基带处理器。可以理解的是,上述调制解调处理

器也可以不集成到处理器910中。

158.本技术实施例还提供一种可读存储介质,所述可读存储介质上存储有程序或指令,该程序或指令被处理器执行时实现上述音乐生成方法实施例的各个过程,且能达到相同的技术效果,为避免重复,这里不再赘述。

159.其中,所述处理器为上述实施例中所述的电子设备中的处理器。所述可读存储介质,包括计算机可读存储介质,如计算机只读存储器rom、随机存取存储器ram、磁碟或者光盘等。

160.本技术实施例另提供了一种芯片,所述芯片包括处理器和通信接口,所述通信接口和所述处理器耦合,所述处理器用于运行程序或指令,实现上述音乐生成方法实施例的各个过程,且能达到相同的技术效果,为避免重复,这里不再赘述。

161.应理解,本技术实施例提到的芯片还可以称为系统级芯片、系统芯片、芯片系统或片上系统芯片等。

162.本技术实施例提供一种计算机程序产品,该程序产品被存储在存储介质中,该程序产品被至少一个处理器执行以实现如上述音乐生成方法实施例的各个过程,且能达到相同的技术效果,为避免重复,这里不再赘述。

163.需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者装置不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者装置所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者装置中还存在另外的相同要素。此外,需要指出的是,本技术实施方式中的方法和装置的范围不限按示出或讨论的顺序来执行功能,还可包括根据所涉及的功能按基本同时的方式或按相反的顺序来执行功能,例如,可以按不同于所描述的次序来执行所描述的方法,并且还可以添加、省去、或组合各种步骤。另外,参照某些示例所描述的特征可在其他示例中被组合。

164.通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分可以以计算机软件产品的形式体现出来,该计算机软件产品存储在一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端(可以是手机,计算机,服务器,或者网络设备等)执行本技术各个实施例所述的方法。

165.上面结合附图对本技术的实施例进行了描述,但是本技术并不局限于上述的具体实施方式,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本技术的启示下,在不脱离本技术宗旨和权利要求所保护的范围情况下,还可做出很多形式,均属于本技术的保护之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1