视频语音增强的方法及装置、电子设备和存储介质与流程

本技术涉及数据处理,尤其涉及一种视频语音增强的方法及装置、电子设备和存储介质。

背景技术:

1、人们越来越关注使用神经网络进行听觉和视觉信号的多模态融合,以解决各种与语音相关的问题。这些包括视听语音识别,从无声视频(例如唇读)中预测语音或文本,以及从视觉和语音信号中进行语言的无监督学习。这些方法利用同时记录的视觉和听觉信号之间的自然同步。

2、目前,常见的视听方法分析方法为基于卷积神经网络(convolution neuralnetwork,cnn)的多任务模型,该模型输出噪声语音频谱图以及输入嘴巴区域的重建,以完成视频画面中的音频分离,由此可见,相关技术中的视听方法也只用于语音分离,并不涉及针对视频数据中其他内容的处理过程。

技术实现思路

1、本技术提供了一种视频语音增强的方法、装置、电子设备和存储介质。其主要目的在于解决相关技术中的视听处理方法只用于语音分离的问题。

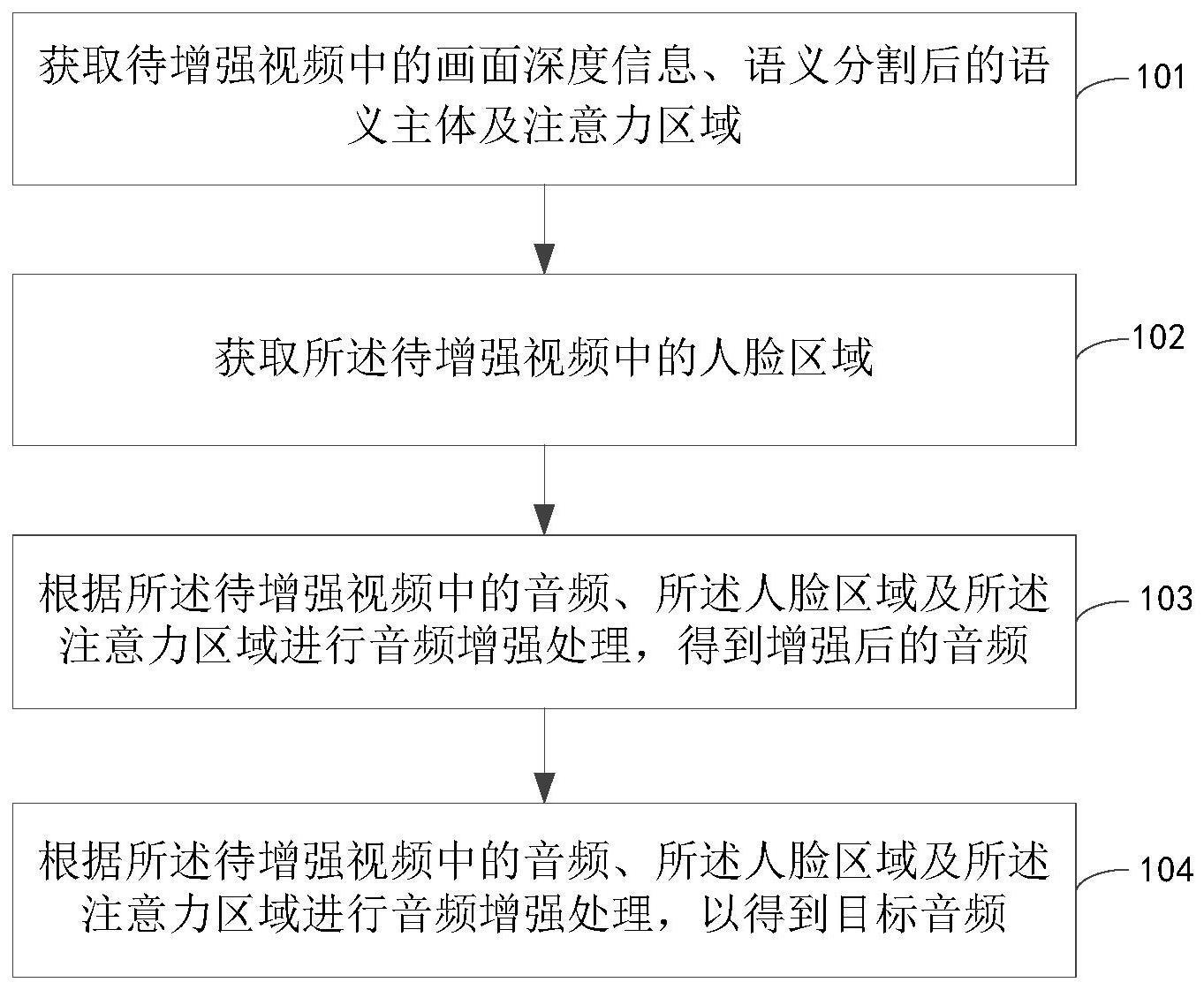

2、根据本技术的第一方面,提供了一种视频语音增强的方法,其中,包括:

3、获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域;

4、获取所述待增强视频中的人脸区域;

5、根据所述待增强视频中的音频、所述人脸区域及所述注意力区域进行音频增强处理,得到增强后的音频;

6、将所述画面深度信息、语义分割后的图像主体及增强后的音频进行融合,得到目标视频。

7、可选地,所述根据所述待增强视频中的音频、所述人脸区域及所述注意力区域进行音频增强处理,得到增强后的音频包括:

8、对所述待增强视频中的音频进行解码;

9、根据所述人脸区域及所述注意力区域对所述解码后的音频进行对齐,得到第一音频;

10、对所述第一音频进行背景噪声消除处理,得到第二音频;

11、对所述第二音频进行声轨增强处理,得到增强后的音频。

12、可选地,所述将所述画面深度信息、语义分割后的图像主体及增强后的音频进行融合,得到目标视频包括:

13、基于所述第三音频,确定所述待增强视频中的原始音频;

14、将所述语义分割后的图像主体与所述注意力区域进行融合处理,得到所述待增强视频的融合区域;

15、对除所述融合区域外的其他区域进行模糊处理,得到所述待增强视频的模糊区域,其中,所述模糊区域的大小根据画面深度值进行缩放得到;

16、将所述待增强视频的第三音频,分别与所述融合区域及模糊区域进行编码融合处理,得到所述目标视频。

17、可选地,所述获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域包括:

18、将所述待增强视频输入多任务场景解析模型,以获取所述增强视频的单幅图片每个像素的画面深度信息、所述增强视频的单幅图片的图像主体,以及所述待增强视频的单幅图片的注意力区域。

19、可选地,在获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域之前,所述方法还包括:

20、构建视频语音增强模型,所述视频语音增强模型包含场景解析模块、人脸检测模块、音频增强模块以及融合模块。

21、可选地,所述搭建视频语音增强模型包括:

22、配置所述场景解析模块使用多任务场景解析模型,用于实现对视频的场景解析,多任务包括语义分割任务、深度估计任务,以及注意力推断任务;

23、配置所述人脸检测模块使用目标检测模型,用于实现对视频中的人脸区域检测;

24、配置所述音频增强模块使用训练好的音频增强模型,用于将所述多任务场景解析模型中注意力推断任务的解析结果、所述目标检测模型的人脸检测结果、视频中的音频,作为所述音频增强模块输入,实现音频的增强;

25、配置所述融合模块使用训练好的融合模型,用于将所述多任务场景解析模型中语义分割任务、深度估计任务的解析结果、以及所述音频增强模块的增强结果,所述融合模型的输入,实现增强后的音频与视频的融合。

26、可选地,对所述音频增强模型进行训练包括:

27、提取样本视频中的初始单声轨音频,所述样本视频中还包含标记后的注意力区域,及自定义的注意力区域;

28、对所述样本视频中的训练人脸框进行增强处理,得到增强处理后的训练人脸框;

29、将所述初始单声轨音频、所述标记后的注意力区域,自定义的注意力区域,及增强处理后的训练人脸框输入所述音频增强模型进行训练,以得到训练好的音频增强模型。

30、可选地,对所述场景解析模型进行训练包括:

31、将样本视频传输至主干网络,以获取所述样本视频中单幅图片的特征向量;

32、根据所述特征向量分别进行语义分割训练、深度估计训练,以及注意力推断训练;

33、根据分别对语义分割训练、深度估计训练,以及注意力推断训练的训练结果,得到训练好的所述多任务场景解析模型。

34、可选地,对所述融合模型进行训练包括:

35、提取样本视频中标识的图像主体及注意力区域;

36、根据样本视频中的画面深度信息、图像主体及注意力区域进行画面融合训练;

37、根据所述融合训练的结果与样本视频中的音频进行视频融合训练,得到训练好的融合模型。

38、可选地,所述方法还包括:

39、根据所述目标检测模型的训练结果,通过剪枝处理生成基于目标检测模型的小模型。

40、根据本技术的第二方面,提供了一种视频语音增强的装置,包括:

41、第一获取单元,用于获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域;

42、第二获取单元,用于获取所述待增强视频中的人脸区域;

43、第一增强处理单元,用于根据所述待增强视频中的音频、所述人脸区域及所述注意力区域进行音频增强处理,得到增强后的音频;

44、第二增强处理单元,用于将所述画面深度信息、语义分割后的图像主体及增强后的音频进行融合,得到目标视频。

45、可选地,所述第一增强处理单元包括:

46、解码模块,用于对所述待增强视频中的音频进行解码;

47、对齐模块,用于根据所述人脸区域及所述注意力区域对所述解码后的音频进行对齐,得到第一音频;

48、噪声消除模块,用于对所述第一音频进行背景噪声消除处理,得到第二音频;

49、增强处理模块,用于对所述第二音频进行声轨增强处理,得到增强后的音频。

50、可选地,所述第二增强单元包括:

51、替换模块,用于使用增强后的音频替换所述待增强视频中的原音频;

52、融合处理模块,用于将所述语义分割后的图像主体与所述注意力区域进行融合处理,得到所述待增强视频的融合区域;

53、模糊处理模块,用于对除所述融合区域外的其他区域进行模糊处理,得到所述待增强视频的模糊区域,其中,所述模糊区域核的大小根据画面深度值进行缩放得到;

54、增强处理模块,用于将所述待增强视频的增强后的音频,分别与所述待增强视频的融合区域及模糊区域进行编码融合处理,得到目标视频。

55、可选地,所述第一获取单元,还用于:

56、将所述待增强视频输入多任务场景解析模型,以获取并行输出的所述增强视频的单幅图片每个像素的画面深度信息、所述增强视频的单幅图片的图像主体,以及所述待增强视频的单幅图片的注意力区域。

57、可选地,所述装置还包括:

58、构建单元,用于在所述第一获取单元获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域之前,搭建视频语音增强模型,所述视频语音增强模型包含场景解析模块、人脸检测模块、音频增强模块以及融合模块。

59、可选地,所述构建单元还用于:

60、配置所述场景解析模块使用多任务场景解析模型,用于实现对视频的场景解析,多任务包括语义分割任务、深度估计任务,以及注意力推断任务;

61、配置所述人脸检测模块使用目标检测模型,用于实现对视频中的人脸区域检测;

62、配置所述音频增强模块使用音频增强模型,用于将所述多任务场景解析模型中注意力推断任务的解析结果、所述目标检测模型的人脸检测结果、所述待增强视频中的音频,作为所述音频增强模块的输入,以实现音频的增强;

63、配置所述融合模块使用融合模型,用于将所述多任务场景解析模型中语义分割任务、深度估计任务的解析结果、以及所述音频增强模块的增强结果,所述融合模型的输入,以实现增强后的音频与视频的融合。

64、可选地,音频增强模型训练单元包括:

65、提取样本视频中的初始单声轨音频,所述样本视频中还包含标记后的注意力区域,及自定义的注意力区域;

66、对所述样本视频中的初始人脸框进行增强处理,得到目标人脸框;

67、基于所述初始单声轨音频、所述带标识的注意力区域,自定义的注意力区域,及目标人脸框,对所述音频增强模型进行训练,以得到训练好的音频增强模型。

68、可选地,场景解析模型训练单元包括:

69、将样本视频传输至主干网络,以获取所述样本视频中单幅图片的特征向量;

70、根据所述特征向量分别进行语义分割训练、深度估计训练,以及注意力推断训练,以得到训练好的所述多任务场景解析模型。

71、可选地,融合模型训练单元包括:

72、提取样本视频中标识的图像主体及注意力区域;

73、根据样本视频中的画面深度信息、图像主体及注意力区域进行画面融合训练;

74、根据所述融合训练的结果与样本视频中的音频进行视频融合训练,以得到训练好的融合模型。

75、可选地,目标检测模型训练单元包括:

76、对所述目标检测模型的训练结果进行剪枝处理,得到所述目标检测模型。

77、根据本技术的第三方面,提供了一种电子设备,包括:

78、至少一个处理器;以及

79、与所述至少一个处理器通信连接的存储器;其中,

80、所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行前述第一方面所述的方法。

81、根据本技术的第四方面,提供了一种芯片,包括一个或多个接口电路和一个或多个处理器;所述接口电路用于从电子设备的存储器接收信号,并向所述处理器发送所述信号,所述信号包括存储器中存储的计算机指令,当所述处理器执行所述计算机指令时,使得所述电子设备执行前述第一方面所述的方法。

82、根据本技术的第五方面,提供了一种存储有计算机指令的非瞬时计算机可读存储介质,其中,所述计算机指令用于使所述计算机执行前述第一方面所述的方法。

83、根据本技术的第六方面,提供了一种计算机程序产品,包括计算机程序,所述计算机程序在被处理器执行时实现如前述第一方面所述的方法。

84、本技术提供的视频语音增强的方法、装置、电子设备和存储介质,获取待增强视频中的画面深度信息、语义分割后的图像主体及注意力区域,获取所述待增强视频中的人脸区域,根据所述待增强视频中的音频、所述人脸区域及所述注意力区域进行音频增强处理,得到增强后的音频,将所述画面深度信息、语义分割后的图像主体及增强后的音频进行融合,得到目标视频。与相关技术相比,本技术实施例在对待增强视频中的音频进行增强处理时,将音频及对应的人脸区域及注意力区域进行了融合处理,使得音频与人脸区域及注意力区域保持同步增强,不仅增强视频中的声音,而且还对待增强视频中的显示画面进行了增强,从整体上提升了视频效果。

85、应当理解,本部分所描述的内容并非旨在标识本技术的实施例的关键或重要特征,也不用于限制本技术的范围。本技术的其它特征将通过以下的说明书而变得容易理解。

- 还没有人留言评论。精彩留言会获得点赞!