说话人转换点的检测方法、训练检测模型的方法及装置与流程

本技术涉及人工智能和语音处理,特别是涉及一种说话人转换点的检测方法、训练检测模型的方法及装置。

背景技术:

1、多人对话场景下对于说话人转换点的检测是语音识别技术中的一个热门问题,目标是确定一段多人对话音频中的说话人信息以及各时间段对应的说话人。目前在多人会议场景、客服电话场景、销售场景中被广泛应用。以多人会议场景为例,智能语音识别系统更能够快速识别出会议音频对应的文字信息并依据不同说话人进行分段,确定出说话人转换点的位置,这将极大地提高使用者的工作效率。

2、目前如何准确地进行说话人转换点的检测是目前各大智能语音识别服务商均致力解决的问题。

技术实现思路

1、有鉴于此,本技术提供了一种说话人转换点的检测方法、训练检测模型的方法及装置,以便于提高说话人转换点检测的准确性。

2、本技术提供了如下方案:

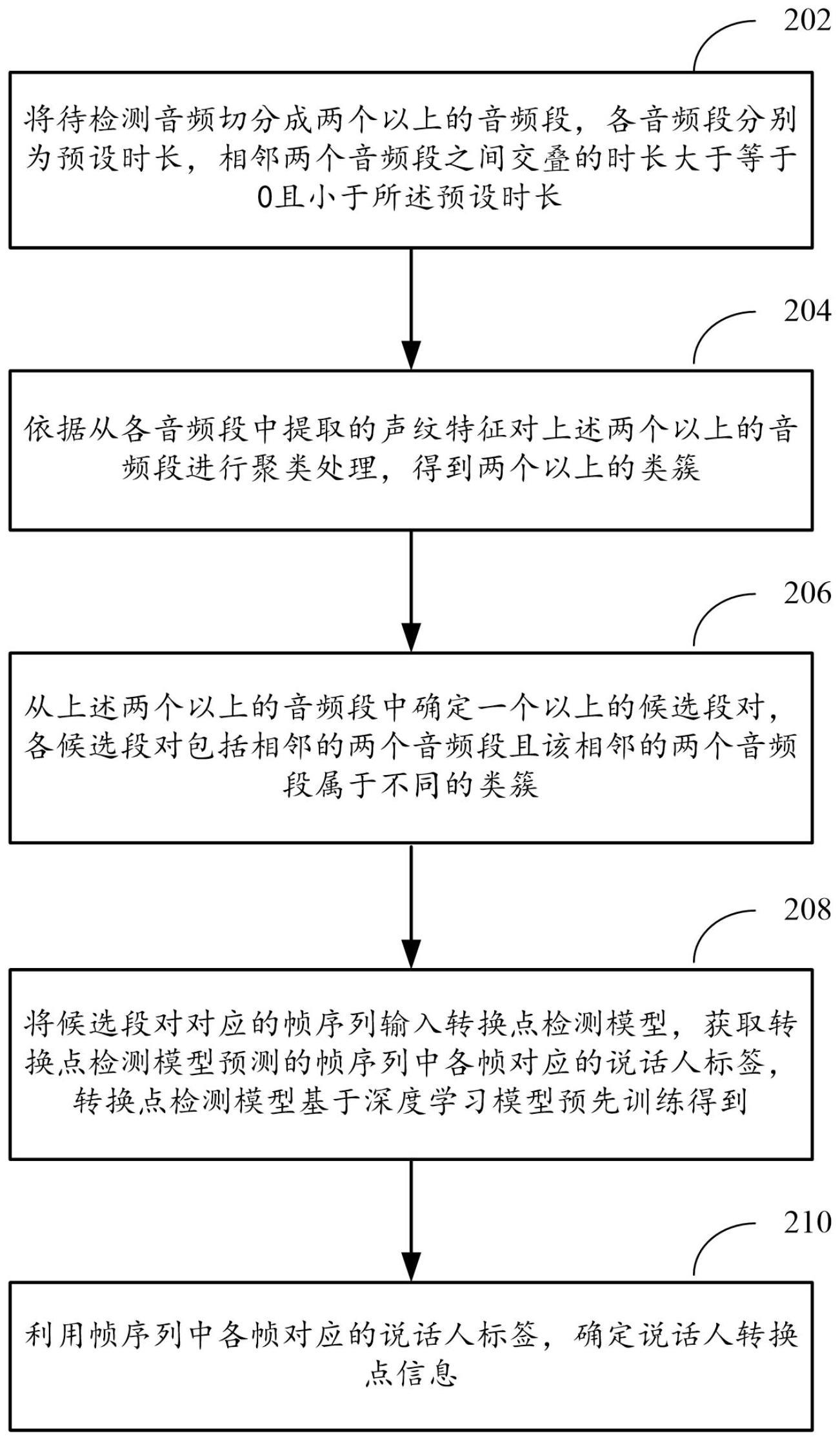

3、第一方面,提供了一种说话人转换点的检测方法,所述方法:

4、将待检测音频切分成两个以上的音频段,各音频段分别为预设时长,相邻两个音频段之间交叠的时长大于等于0且小于所述预设时长;

5、依据从各音频段中提取的声纹特征对所述两个以上的音频段进行聚类处理,得到两个以上的类簇;

6、从所述两个以上的音频段中确定一个以上的候选段对,各候选段对包括相邻的两个音频段且该相邻的两个音频段属于不同的类簇;

7、将候选段对对应的帧序列输入转换点检测模型,获取所述转换点检测模型预测的帧序列中各帧对应的说话人标签,所述转换点检测模型基于深度学习模型预先训练得到;

8、利用所述帧序列中各帧对应的说话人标签,确定说话人转换点信息。

9、根据本技术实施例中一可实现的方式,所述转换点检测模型包括编码网络和预测网络;

10、所述编码网络对输入的候选段对对应的帧序列进行特征编码,得到帧序列中各帧的特征表示;

11、所述预测网络利用所述帧序列中各帧的特征表示以及所述输入的候选段对中两个音频段的声纹特征,预测所述帧序列中各帧对应的说话人标签。

12、根据本技术实施例中一可实现的方式,所述方法还包括:确定所述输入的候选段对中两个音频段所属的类簇,分别利用确定出的各类簇中音频段的声纹特征,确定各类簇分别对应的全局特征表示;

13、所述转换点检测模型包括编码网络和预测网络;

14、所述编码网络对输入的候选段对对应的帧序列进行特征编码,得到帧序列中各帧的特征表示;

15、所述预测网络利用所述帧序列中各帧的特征表示以及所述输入的候选段对中两个音频段所属的类簇对应的全局特征表示,预测所述帧序列中各帧对应的说话人标签。

16、根据本技术实施例中一可实现的方式,所述编码网络采用时延神经网络tdnn,所述预测网络采用转换transformer网络。

17、根据本技术实施例中一可实现的方式,利用所述帧序列中各帧对应的说话人标签,确定说话人转换点信息包括:

18、将所述帧序列中对应不同说话人标签的相邻两个帧之间的时间点,确定为说话人转换点信息。

19、根据本技术实施例中一可实现的方式,所述方法还包括:

20、将所述说话人转换点信息提供给语音识别系统,以便于所述语音识别系统依据所述说话人转换点信息对所述待检测音频对应的识别结果进行分段或标注说话人信息。

21、第二方面,提供了一种训练转换点检测模型的方法,所述方法包括:

22、获取包括多个训练样本的训练数据,所述训练样本包括两个说话人的音频段构成的音频帧序列以及所述音频帧序列中各帧被标注的说话人标签;

23、利用所述训练数据训练基于深度学习模型的转换点检测模型,其中,将音频帧序列作为所述转换点检测模型的输入,由所述转换点检测模型预测所述音频帧序列中各帧对应的说话人标签,所述训练的目标包括:最小化所述转换点检测模型预测的结果与对应音频序列中各帧被标注的说话人标签之间的差异。

24、根据本技术实施例中一可实现的方式,所述获取包括多个训练样本的训练数据包括:

25、获取第一音频段和第二音频段,所述第一音频段和第二音频段对应不同说话人;

26、将所述第一音频段和第二音频段进行拼接得到音频帧序列,依据音频帧序列中各帧所属的音频段对各帧标注说话人标签。

27、根据本技术实施例中一可实现的方式,所述方法还包括:获取所述两个说话人的音频段分别对应的声纹特征;

28、所述转换点检测模型包括编码网络和预测网络;

29、所述编码网络对输入的音频帧序列进行特征编码,得到音频帧序列中各帧的特征表示;

30、所述预测网络利用所述音频帧序列中各帧的特征表示以及该音频帧序列所来源的音频段对应的声纹特征,预测所述音频帧序列中各帧对应的说话人标签。

31、第三方面,提供了一种说话人转换点的检测装置,所述装置包括:

32、段切分单元,被配置为将待检测音频切分成两个以上的音频段,各音频段分别为预设时长,相邻两个音频段之间交叠的时长大于等于0且小于所述预设时长;

33、音频聚类单元,被配置为依据从各音频段中提取的声纹特征对所述两个以上的音频段进行聚类处理,得到两个以上的类簇;

34、段对确定单元,被配置为从所述两个以上的音频段中确定一个以上的候选段对,各候选段对包括相邻的两个音频段且该相邻的两个音频段属于不同的类簇;

35、模型检测单元,被配置为将候选段对对应的帧序列输入转换点检测模型,获取所述转换点检测模型预测的帧序列中各帧对应的说话人标签,所述转换点检测模型基于深度学习模型预先训练得到;

36、转换点确定单元,被配置为利用所述帧序列中各帧对应的说话人标签,确定说话人转换点信息。

37、第四方面,提供了一种训练转换点检测模型的装置,所述装置包括:

38、样本获取单元,被配置为获取包括多个训练样本的训练数据,所述训练样本包括两个说话人的音频段构成的音频帧序列以及所述音频帧序列中各帧被标注的说话人标签;

39、模型训练单元,被配置为利用所述训练数据训练基于深度学习模型的转换点检测模型,其中,将音频帧序列作为所述转换点检测模型的输入,由所述转换点检测模型预测所述音频帧序列中各帧对应的说话人标签,所述训练的目标包括:最小化所述转换点检测模型预测的结果与对应音频序列中各帧被标注的说话人标签之间的差异。

40、第五方面,提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现上述第一方面和第二方面中任一项所述的方法的步骤。

41、第六方面,提供了一种电子设备,包括:

42、一个或多个处理器;以及

43、与所述一个或多个处理器关联的存储器,所述存储器用于存储程序指令,所述程序指令在被所述一个或多个处理器读取执行时,执行上述第一方面和第二方面中任一项所述的方法的步骤。

44、根据本技术提供的具体实施例,本技术公开了以下技术效果:

45、1)本技术通过将待检测音频切分成音频段后,基于声纹特征对音频段进行聚类以对音频段进行说话人的区分,然后利用转换点检测模型对属于不同类簇的相邻两个音频段进行各帧的说话人标签预测,将转换点信息的预测误差限制于帧级别,从而更加准确地确定说话人转换点信息,提高用户体验。

46、2)转换点检测模型在依据帧序列中各帧的特征表示进行预测处理时,进一步结合输入模型的候选段对中两个音频段的声纹信息,或者进一步结合输入的候选段对中两个音频段所属类簇声纹的全局特征表示,从而更进一步提高对转换点信息预测的准确性。

47、3)本技术所提供的端到端的转换点检测模型中,基于tdnn-transformer结构来实现,所带来的计算负载小,更方便落地到具体的产品。

48、当然,实施本技术的任一产品并不一定需要同时达到以上所述的所有优点。

- 还没有人留言评论。精彩留言会获得点赞!