一种多模态情感识别方法及系统

本技术涉及情感识别,并且更具体地,涉及一种基于跨模态卷积注意力和多声学特征融合模块的多模态情感识别方法与系统。

背景技术:

1、语音情感识别技术是一种自然语言处理技术,目的是通过语音信号识别人类的情感状态,它可以用于评估说话人的情绪、态度、情感倾向等,在现实生活中的应用很多,如:①自然语言理解:帮助计算机更好地理解和解释人类语音中的情感状态;②智能客服:语音情感识别技术可以帮助客服人员更好地了解客户的情感状态和需求,并提供更好的服务和支持;③情感诊断和治疗:语音情感识别技术可以用于情感诊断和治疗,帮助医生和治疗师更好地了解患者的情感状态和需求,并提供更有效的治疗方案;④社交媒体:语音情感识别技术可以应用于社交媒体,例如对语音留言、语音评论和视频直播等进行情感分析,从而更好地了解和回应用户的反馈和情感状态。

2、语音是一种信号,最早的语音情感特征提取是使用通用的信号特征提取方式,如:移动平均(ma),傅立叶变换(fft),小波变换(wt)等通用信号特征提取,同时基于语音信号的自身特性,也有专用的特征提取方法,如:短时能量(ste),过零率(zcr),线性预测编码系数(lpc),梅尔倒谱系数(mfcc)。这些人工特征提取方法的表现受限于信号采集的质量和数量,对夹杂的噪音信号难以过滤,计算繁琐,鲁棒性差。

3、随着深度学习技术的进步,现代语音情感识别技术已经取得了显著进展。深度学习中的技术被广泛应用在语音信号特征提取上,如:卷积神经网络(cnn)、长短时记忆网络(lstm)和自注意力模型(transformer)。深度学习在语音情感识别上有很多优势,如深度学习网络能够自动从原始语音信号中学习高层次的特征表示,不需要手工设计特征,从而能够更准确地表达语音信号中的情感信息;也具有较强的鲁棒性,能够处理一定程度的噪声和语音变形,从而能够更稳定地识别语音信号中的情感状态。

4、东南大学无线电工程系的赵力等人在2001年首先提出语音信号中的情感识别研究,并采用主元分析法进行语音情感识别的深入研究;清华大学计算机系的蔡永莲等人也进行了汉语普通话情感识别的研究,他们研究了韵律特征在汉语普通话中情感识别的作用,并采用高斯混合模型和概率神经网络模型作为分类器,使得情感识别率比较理想,另外,2003年中国科学院自动化所等相关单位在北京举行了第一届中国情感计算及智能交互学术会议,2005年该单位又举办了国际情感计算及智能交互学术会议,将国内甚至国际这个领域的知名研究者汇聚一堂,进行学术交流交流各自的研究进展,为情感计算和情感语音识别在中国的研究推广做了较大的贡献。但现有的语音-文本双模态情感识别技术,在语音模态中仅使用了语音波形这一声学特征,没有使用其余声学特征,特征单一,蕴含信息较少,特别在数据集较小的时候,只使用语音波形会导致语音模态信息不足,训练效果差。语音和文字模态之间具有很强的相关性,在相同的文本情况下,说话的声调高低,语速快慢,话语节奏等都与情感相关联。但在现有语音-文字情感识别技术下,语音模态和文本模态之间没有充分的信息交互的过程,只是对两种模态的特征向量直接拼接或对两种特征向量做内积,未能充分利用语音和文本的相关性捕捉关键信息,以及高维子空间的信息交互。

5、综上,现有技术存在以下缺陷:①在语音模态中仅使用了语音波形这一声学特征,没有使用其余声学特征,特征单一,蕴含信息较少,特别在数据集较小的时候,只使用语音波形会导致语音模态信息不足,训练效果差;②语音-文字情感识别技术下,语音模态和文本模态之间没有充分的信息交互的过程,只是对两种模态的特征向量直接拼接或对两种特征向量做内积,未能充分利用语音和文本的相关性捕捉关键信息,以及高维子空间的信息交互,造成情感识别准确率下降。

技术实现思路

1、本发明针对现有技术中利用的声学特征单一与情感识别准确率低的技术问题,提出了一种多模态情感识别方法与系统,增强语音模态中多种声学特征的信息交互和联系,通过捕捉语音模态和文字模态之间的交互信息并融合处理,能够更全面地捕捉两个模态之间的情感信息,从而取得更好的性能。

2、为了实现本发明的目的,本发明采用如下技术方案:

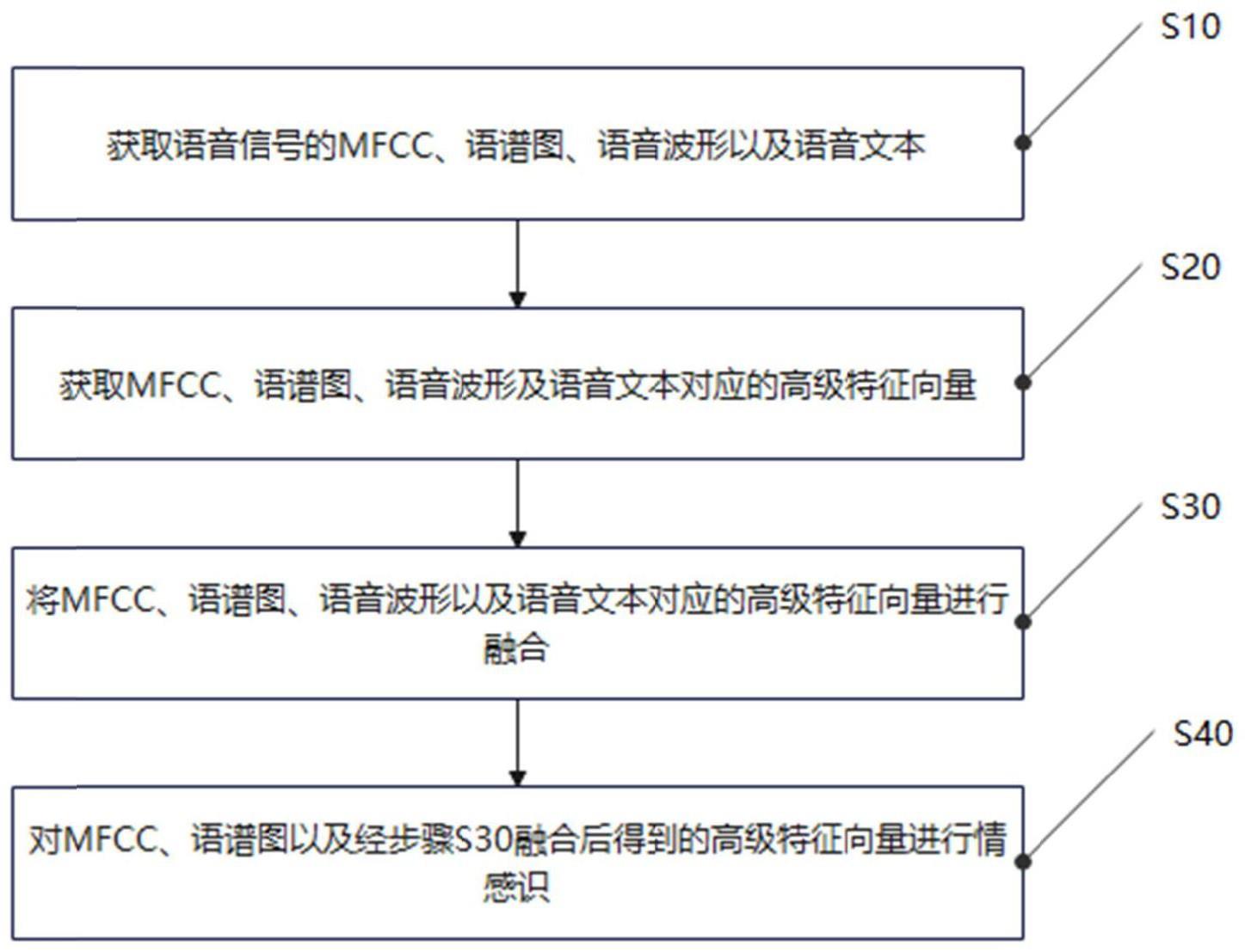

3、一种多模态情感识别方法,包括以下步骤:

4、s10:获取语音信号的mfcc、语谱图、语音波形以及语音文本;

5、s20:获取mfcc、语谱图、语音波形及语音文本对应的高级特征向量;

6、s30:将mfcc、语谱图、语音波形以及语音文本对应的高级特征向量进行融合;

7、s40:对mfcc、语谱图以及经步骤s30融合后得到的高级特征向量进行情感识别;

8、其中,mfcc表示梅尔倒谱系数。

9、根据上述技术方案,通过获取mfcc、语谱图、语音波形和语音文本及其对应的高级特征向量,并将mfcc、语谱图、语音波形以及语音文本对应的高级特征向量进行融合,从而增强语音模态中多种声学特征的信息交互和联系,并将语音模态和文字模态之间交互信息融合处理,能够更全面地获取两个模态之间的情感信息,从而取得更好的情感识别性能。

10、进一步地,所述步骤s10具体包括以下步骤:

11、s11:对语音信号进行预加重处理;

12、s12:对预加重处理后的语音信号进行分帧处理;

13、s13:将分帧处理后的语音信号进行加窗处理。

14、在步骤s11中,所述预加重处理需通过高通滤波器方程加入,预加重处理的过程满足:

15、y(t)=x(t)-αx(t-1);

16、公式中,t表示当前时刻,α表示滤波器系数,x(t)表示语音信号的输入值,y(t)表示语音信号的输出值。

17、在步骤s13中,所述加窗处理需通过hamming窗口函数加入,加窗处理的过程满足:

18、

19、公式中,n表示每帧语音信号的窗口长度,a表示每帧语音信号的汉明窗系数,n表示窗口函数对分帧后语音信号的采样点,w(n,a)表示汉明窗在时域上的取值。

20、s14:将加窗处理后的每帧语音信号进行频域上的能量分布变换,获取语音信号的能量谱,能量分布变换过程满足公式:

21、

22、公式中,si(k)表示频域上语音信号第k个频率分量的复数值,si(n)表示时域上第n个采样点的实数值,k表示频率分量的下标,n表示总采样点数。

23、根据上述技术方案,通过对语音信号进行预加重处理,可以更好地将语音信号进行放大高频,并将放大高频后的语音信号进行分帧处理,将整个平稳的语音信号分帧成短时平稳信号,随后再对所述短时平稳信号进行加窗处理,减少频谱泄露,从而可更好地将语音信号进行频域上的能量分布变换,进而获取mfcc和语谱图对应的能量谱。

24、进一步地,所述步骤s20具体包括以下步骤:

25、s21:提取语音信号中mfcc和语谱图对应的低级特征向量;

26、s22:提取mfcc、语谱图、语音波形以及语音文本对应的高级特征向量,包括:

27、将mfcc对应的低级特征向量输入至添加flatten层后的bilstm处理器中进行深度学习,获取到mfcc对应的高级特征向量:

28、xm=flatten(biltsm(xmfcc));

29、其中,

30、将语谱图应的低级特征向量输入至添加flatten层后的alexnet处理器中进行深度学习,获取语谱图对应的高级特征向量:

31、xs=flattern(alexnet(xspec));

32、其中,

33、将语音波形输入至wav2vec处理器中进行预处理,并将预处理后的语音波形通过wav2vec处理器进行深度学习,获取语音波形对应的高级特征向量:

34、xw=wav2vec(xwav);

35、其中,

36、将语音文本输入至bert处理器中进行预处理,并将预处理后的语音文本通过bert处理器进行深度学习,获取语音文本对应的高级特征向量:

37、xt=bert(xtext);

38、其中,

39、根据上述技术方案,通过将mfcc与语谱图对应的低级特征向量、语音波形以及语音文本传输至对应的处理器中,经过深度学习模型进行深度学习,进而可获取语音信号更高层次的声音特征和语音情感的高级特征向量。

40、进一步地,所述步骤s30具体包括以下步骤:

41、将mfcc、语谱图以及语音波形对应的高级特征向量通过激活函数的线性层进行向量融合:

42、

43、其中,fl(·)表示线性层函数,xm表示mfcc的高级特征向量,xs表示语谱图的高级特征向量,表示向量拼接,xms表示线性层输出的融合向量;

44、将融合向量xms通过激活函数的线性层进行向量融合:

45、

46、其中,表示矩阵乘法,x′w表示mfcc、语谱图以及语音波形对应的高级特征向量融合后得到的多声学融合特征向量;

47、将语音文本对应的高级特征向量进行解压映射到一个固定的维度n,获取对应的高维度向量:

48、xd=fde(xt);

49、其中,

50、将语音波形对应的高级特征向量进行压缩映射到一个固定的维度n,获取对应的维度度向量:

51、xe=fen(xw);

52、其中,

53、将语音文本和语音波形对应的n维特征向量通过跨卷积注意力机制进行强化特征提取,通过自适应权重分配,获取对应的跨模态单头注意力公式:

54、qw=wwxe+bw;

55、kt=wtxd+bt;

56、vb=wbxd+bb;

57、公式中,w表示每个层的权重矩阵,b表示偏差系数,qw通过语音模态获取,kt与vb通过文字模态获取;

58、根据跨模态单头注意力公式获取嵌入的表达式:

59、

60、其中,d表示嵌入的尺寸;

61、将嵌入表达式与xt相加,获取语音波形和语音文本的融合向量:

62、x′t=ln(attention(qw,kt,vb)+xt);

63、公式中,ln(·)是层标准化函数,

64、根据上述技术方案,通过将mfcc、语谱图以及语音波形对应的高级特征向量进行融合,能够将mfcc、语谱图以及语音波形对应的高级特征向量的优点进行整合,实现信息互补,并可利用它们之间的相关性加强语音波形路径的特征输出;通过将语音波形和语音文本的高级特征向量进行融合,可实现对语音和文本特征的精确建模与融合,能够提高多模态学习任务的性能,增强模型泛化能力和可解释性。

65、进一步地,所述步骤s40具体包括以下步骤:

66、将mfcc、语谱图以及融合后对应的高级特征向量进行形状规整,获取拼接向量:

67、xconcat=concat(fffn(xm),fffn(xs),fffn(x′w),fffn(x′t));

68、其中,fffn(·)表示前向传播模块函数,concat(·)表示向量拼接函数,表示向量拼接结果;

69、根据拼接向量xconcat进行情感识别,过程满足:

70、

71、其中,fcls(·)表示情感识别函数,表示情感识别结果。

72、根据上述技术方案,通过将mfcc、语谱图以及融合后对应的高级特征向量进行形状规整,可将不同维度的特征向量进行形状规整,进而消除因为向量维度不同对情感识别准确度造成的影响。

73、一种多模态情感识别系统,包括:

74、获取模块,用于获取语音信号的mfcc、语谱图、语音波形以及语音文本;

75、向量提取模块,用于提取mfcc、语谱图、语音波形以及语音文对应的高级特征向量;

76、向量融合模块,用于将mfcc、语谱图、语音波形以及语音文对应的高级特征向量进行融合;

77、情感识别模块,用于将mfcc、语谱图以及经向量融合模块融合后得到的高级特征向量进行情感识别。

78、进一步地,情感识别系统还包括预处理模块,所述预处理模块,用于对语音信号进行预加重、分帧以及加窗处理,所述预加重处理需通过高通滤波器方程加入,预加重处理的过程满足:

79、y(t)=x(t)-αx(t-1);

80、公式中,t表示当前时刻,α表示滤波器系数,x(t)表示语音信号的输入值,y(t)表示语音信号的输出值;

81、所述加窗处理需通过hamming窗口函数加入,加窗处理的过程满足:

82、

83、公式中,n表示每帧语音信号的窗口长度,a表示每帧语音信号的汉明窗系数,n表示窗口函数对分帧后语音信号的采样点,w(n,a)表示汉明窗在时域上的取值;

84、将加窗处理后的每帧语音信号进行频域上的能量分布变换,获取mfcc和语谱图对应的能量谱,能量分布变换过程满足公式:

85、

86、公式中,si(k)表示频域上语音信号第k个频率分量的复数值,si(n)表示时域上第n个采样点的实数值,k表示频率分量的下标,n表示总采样点数。

87、进一步地,所述向量提取模块,根据mfcc和语谱图对应的能量谱进行低级特征向量提;

88、将mfcc对应的低级特征向量输入至添加flatten层后的bilstm处理器中进行深度学习,提取到mfcc对应的高级特征向量:

89、xm=flatten(biltsm(xmfcc));

90、其中,

91、将语谱图应的低级特征向量输入至添加flatten层后的alexnet处理器中进行深度学习,提取语谱图对应的高级特征向量:

92、xs=flattern(alexnet(xspec));

93、其中,

94、将语音波形输入至wav2vec处理器中进行预处理,将预处理后的语音波形通过wav2vec处理器进行深度学习,提取语音波形对应的高级特征向量:

95、xw=wav2vec(xwav);

96、其中,

97、将语音文本输入至bert处理器中进行预处理,将预处理后的语音文本通过bert处理器进行深度学习,提取语音文本对应的高级特征向量:

98、xt=bert(xtext);

99、其中,

100、所述向量提取模块将语音文本对应的高级特征向量进行解压映射到一个固定的维度n,提取对应的高维度向量:

101、xd=fde(xt);

102、其中,

103、所述向量提取模块将语音波形对应的高级特征向量进行压缩映射到一个固定的维度n,提取对应的低维度向量:

104、xe=fen(xw);

105、其中,

106、所述向量提取模块将语音文本和语音波形对应的n维特征向量通过跨卷积注意力机制进行强化特征提取,通过自适应权重分配,提取对应的跨模态单头注意力公式:

107、qw=wwxe+bw;

108、kt=wtxd+bt;

109、vb=wbxd+bb;

110、公式中,w表示每个层的权重矩阵,b表示偏差系数,qw通过语音模态获取,kt与vb通过文字模态获取;

111、根据跨模态单头注意力公式提取嵌入的表达式:

112、

113、其中,d表示嵌入的尺寸;

114、所述向量提取模块将嵌入表达式与xt相加,提取语音波形和语音文本的融合向量:

115、x′t=ln(attention(qw,kt,vb)+xt);

116、公式中,ln(·)是层标准化函数,

117、进一步地,所述情感识别模块,将mfcc、语谱图以及融合后对应的高级特征向量进行形状规整,获取拼接向量:

118、xconcat=concat(fffn(xm),fffn(xs),fffn(x′w),fffn(x′t));

119、其中,fffn(·)表示前向传播模块函数,concat(·)表示向量拼接函数,表示向量拼接结果;

120、根据拼接向量xconcat进行情感识别,过程满足:

121、

122、其中,fcls(·)表示情感识别函数,表示情感识别结果。

123、相比现有技术,本发明的有益效果在于:

124、本发明提出一种多模态情感识别方法与系统,通过获取语音信号的mfcc、语谱图、语音波形和语音文本及其对应的高级特征向量,并将mfcc、语谱图、语音波形以及语音文本对应的高级特征向量进行融合,从而增强语音模态中多种声学特征的信息交互和联系,且可通过捕捉语音模态和文字模态之间的交互信息并融合处理,能够更全面地捕捉两个模态之间的情感信息,以及高维子空间的信息交互,从而取得更好的情感识别性能,使得情感识别准确率显著提高,进而增强训练效果;有效解决了语音模态声学信息单一和语音-文本模态信息交互不充分,使得信息不能充分被充分利用,造成情感识别准确率下降的问题。

- 还没有人留言评论。精彩留言会获得点赞!