基于雷视数据运动分析的车辆检测方法与流程

1.本发明涉及智能交通技术领域,基于视频传感器与毫米波雷达,提出了一种基于雷视数据运动分析的车辆检测方法。

背景技术:

2.随着科技的发展与社会的进步,我国车辆检测技术飞速发展,城市交通建设逐步智能化,并取得了优异的成果。现今多种多样的车辆检测设备应用于城市路段,例如地磁线圈、摄像头、毫米波雷达、激光雷达、红外传感器、超声波等设备,用于城市交通信号控制。

3.使用单传感器进行交通区域检测,存在各自的不稳定性;视频传感器受天气及场景影响较大,其雨雪雾天气及夜晚场景检测效果受限;地磁地感线圈传感器受气候影响小,但安装过程中会破坏路面;毫米波雷达传感器波长短,可精准获取目标的位置信息和速度信息,但其对静止目标及低速目标会漏检;激光雷达的位置信息检测效果好,但缺少速度的检测,并且维护成本较高。因此,使用多传感器融合进行车辆检测成为一个大的趋势。

4.车辆检测的结果包括了车流量、脉冲、排队长度、停止次数、时间占有率、空间占有率等统计量,因此该技术不仅依赖于目标检测,还依赖于目标跟踪方法;传统的单视频跟踪方法分为依赖于目标检测的方法和不依赖于目标检测的方法,其中前者精度较高,但在复杂场景和恶劣天气下,往往检测结果不如意,同时目标检测结果的实时性和精确性,很大程度依赖于神经网络模型对场景的鲁棒性以及设备的运算能力;传统的单雷达跟踪方法,强制依赖于雷达的特性,并且动静切换过程容易造成大量滞留。

技术实现要素:

5.本发明所要解决的技术问题是针对单传感器进行车辆检测器缺陷,提出了结合视频传感器与毫米波雷达传感器的优势的基于雷视数据运动分析的车辆检测方法。

6.本发明所要解决的技术问题是通过以下的技术方案来实现的,本发明是一种基于雷视数据运动分析的车辆检测方法,其特点是,包括如下步骤:

7.s1,视频与毫米波雷达数据的采集及标定;

8.s2,基于多帧毫米波雷达数据来生成车道热点图;

9.s3,基于目标运动状态分析的雷视融合策略;

10.s4,交通统计量的计算与传输;

11.s5,实时视频流的推送。

12.本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,s1步骤所述的视频与毫米波雷达数据的采集及标定,包括如下步骤:

13.s1.1,视频数据与毫米波雷达数据的采集;

14.s1.2,使用目标检测模型对原始视频帧进行解算,使用稀疏光流法对结果进行校正;

15.s1.3,视频数据与毫米波雷达数据的同步;

16.s1.4,视频数据、毫米波雷达数据、视频目标检测框,保存并推送到数据总线;

17.s1.5,基于目标速度优先的标定处理。

18.本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,实现s1.2步骤的方法是:捕获模型推理前后的实时视频帧i

t1

与i

t2

,以目标检测框的中心坐标作为角点cornerset,通过稀疏光流法,计算出前后两帧中各个角点的像素偏移δu与δv,依据中心点的u、v方向偏移量,对上述视频帧目标检测结果进行校正;

19.δu=opticalflowdiffu(i

t2

,i

t1

,cornerset)

20.δv=opticalflowdiffv(i

t2

,i

t1

,cornerset)

21.实现s1.5步骤所述的基于目标速度优先的标定处理方法是:筛选纵向距离小于一定阈值、横向速度小于一定阈值、纵向速度大于一定阈值的目标,将这些目标特殊标记出来,作为对应点选择的优先目标。

22.本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,s2步骤所述的基于多帧毫米波雷达数据来生成车道热点图,包括如下步骤:

23.s2.1,基于多帧毫米波雷达数据构建频数图;

24.s2.2,基于频数图极大值比例统计,对频数图进行特定变换,将计算结果关联颜色图,生成车道热点图;

25.s2.3,基于生成的热点图,勾勒虚拟车道。

26.本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,实现s2.1步骤的方法是:通过线性变换l,构建了多帧毫米波雷达观测的空间频数图i

freq

;具体地,将毫米波雷达数据横向坐标变换到(0,640)值域范围内,将其纵坐标变换到(0,480)值域范围;

27.i

freq(x,y)

=l

·

radar

(x,y)

28.实现s2.2步骤的方法是:如下式所示,如果频数极大值所占比例大于一定的比例δ

p

,则直接进行频数归一化处理,若频数极大值所占比例小于一定的比例δ

p

,则进行非线性平滑处理,得到结果i'

freq

,通过颜色图关联,得到目标热点图i

map

;

[0029][0030][0031]imap

=colormap(i'

freq

)。

[0032]

本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,s3步骤所述的基于目标运动状态分析的雷视融合策略,包括如下步骤:

[0033]

s3.1虚拟车道状态计算;

[0034]

s3.2毫米波雷达跟踪目标的运动状态分析;

[0035]

s3.3跟踪目标在不同运动状态下,使用相应的融合策略;

[0036]

s3.4密集车辆情况下,对毫米波雷达数据进行启停处理;

[0037]

s3.5低速、静止情况下,采用视屏目标检测框进行补点;

[0038]

本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,实现s3.1步骤的方法是:根据车道中第一个雷达目标的速度、加速度、未匹配的帧数以及距离停止线的距离情况,将车道集合laneset划分为红灯车道集合laneset

red

和绿灯车道集合laneset

green

;绿灯车道不保留长时未匹配的目标,红灯车道进行车辆目标的补点及排队长度的维护;

[0039]

laneset={lane

red

,lane

green

}

[0040]

实现s3.2步骤的方法是:使用匈牙利匹配方法关联毫米波雷达集合与视频观测集合,结合毫米波目标所在车道的状态、毫米波雷达目标的速度、毫米波雷达的位置等信息,当目标所在的车道为红灯车道,其距离前一辆停止车辆小于一定阈值,且匹配不到毫米波雷达观测,但能匹配到视频观测,则判定该车辆为停止;由此,将毫米波雷达目标集合objset划分为运动目标集合obj

move

和静止目标集合obj

static

;

[0041]

objset={obj

move

,obj

static

}

[0042]

实现s3.3步骤的方法是:针对红灯车道中的静止目标obj

redstatic

、红灯车道中的运动目标obj

redmove

、绿灯车道中的静止目标obj

greenstatic

、绿灯车道中的运动目标obj

greenmove

,分别采用不同的融合处理策略φ

redstatic

、φ

redmove

、φ

greenstatic

、φ

greenmove

,维护红灯车道中的排队长度,同时减少车道由红到绿后存在滞留目标;

[0043]

实现s3.4步骤的方法是:当车道状态由红灯切换到绿灯时,若目标未匹配上雷达观测与视频观测,则根据车道内的前车速度进行y方向前移/后移,直至同前车距离小于一定阈值。

[0044]

本发明所述的基于雷视数据运动分析的车辆检测方法,其进一步优选的技术方案是,红灯车道中静止目标的处理方法是:红灯车道中的静止目标记作obj

redstatic

,其处理逻辑记为φ

redstatic

,将跟踪目标映射到图像上,使用匈牙利匹配来关联视频目标检测数据,若跟踪目标在连续一定内没有匹配到视频检测框,将该目标从跟踪器中清除,处理结果记为obj

redstaticres

;

[0045]

红灯车道中运动目标的处理方法是:红灯车道中的运动目标记作obj

redmove

,其处理逻辑记为φ

redmove

,若跟踪目标在连续一段时间内没有匹配到视频检测框,则将该目标从跟踪器中清除,处理结果记为obj

redmoveres

;

[0046]

绿灯车道中静止目标的处理方法是:绿灯车道中的静止目标记作obj

greenstatic

,其处理逻辑记为φ

greenstatic

,若该目标长时未匹配到毫米波雷达观测,则将该目标从跟踪器中清除,处理结果记为obj

greenstaticres

;

[0047]

绿灯车道中运动目标的处理方法是:绿灯车道中的运动目标记作obj

greenmove

,其处理逻辑记为φ

greenmove

,若该目标未匹配上雷达观测,则使用与该目标关联的视频观测与卡尔曼滤波预测值进行关联,处理结果记为obj

greenmoveres

。

[0048]

本发明以毫米波雷达数据为主进行雷视数据同步,提出了一种基于目标速度优先的雷达与视频数据标定方法;本发明对毫米波雷达目标进行运动状态的分析,不同运动状态采用不同的雷视融合策略,并针对车辆密集场景和天气恶劣场景,分别使用了处理方法;本发明对多帧雷达观测频数图的统计与非线性变换,并使用颜色图(colormap)进行可视

化,生成车道热点图,来辅助工程人员;交通统计量的计算与传输,本发明结合虚拟车道与虚拟线圈,对融合目标进行统计,使用tcp的传输方式向信号机发送车流量、排队长度、停车次数、线圈存在性等统计量;实时视频流的推送,本发明通过nginx流媒体服务器的搭建,可以向用户推送rtsp、rtmp、flv等视频流。

[0049]

与现有技术相比,本发明提供的基于雷视数据运动分析的车辆检测方法至少具备以下有益效果:

[0050]

1、本发明使用了一种更加合理的处理方式,通过对毫米波雷达与视频数据的运动分析及自适应融合,提升了目标检测的精度与鲁棒性,适用于低算力的边缘计算设备,降低了设备成本。

[0051]

2、本发明全面均衡了车流量、排队长度、停车次数、线圈存在性等统计量。

[0052]

3、本发明在算法中引入各个车道的运行灯态,并对毫米波雷达观测数据运动状态进行分析,不同的运动状态采用相应的处理策略,有效解决了绿灯车道内车辆目标误检、红灯车道内车辆目标漏检的问题。

[0053]

4、本发明相比现有车辆检测技术,能更好地为信号控制系统提供精确、多样的交通数据。

[0054]

5、本发明结合视频传感器与毫米波雷达传感器的特性,考虑到视频目标检测的实时性,为适应低算力的边缘计算设备,以雷达观测为主,以视频观测为辅,基于运动状态分析进行决策层的融合。

附图说明

[0055]

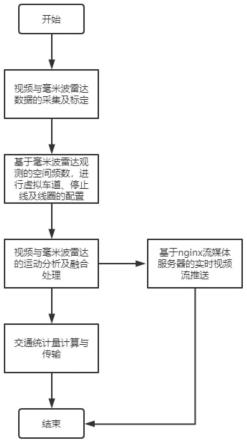

图1为本发明方法的一种流程示意图;

[0056]

图2为本发明方法的一种应用场景示意图;

[0057]

图3为本发明方法的一种整体架构示意图;

[0058]

图4为本发明方法的一种采集与标定技术流程示意图;

[0059]

图5为本发明方法的一种雷视标定操作示意图;

[0060]

图6为本发明方法的一种虚拟车道、停止线及线圈配置技术流程示意图;

[0061]

图7为本发明方法的一种虚拟车道、停止线及线圈配置操作示意图;

[0062]

图8为本发明方法的一种雷视融合技术流程示意图;

[0063]

图9为本发明方法的一种雷视融合效果示意图;

[0064]

图10为本发明方法的一种交通统计量计算技术流程示意图;

[0065]

图11为本发明方法的一种交通统计量相关展示示意图;

[0066]

图12为本发明方法的一种实时视频流推送技术流程示意图;

[0067]

图13为本发明方法的一种实时视频流推送效果示意图。

具体实施方式

[0068]

下面将结合附图和具体实施方式,对本发明的技术方案作详细说明,应理解这些实施方法仅用于说明本发明而不用于限制本发明的范围,在阅读本发明之后,本领域技术人员对发明的各种等价形式的修改均落入本发明所附权利要求所限定的范围内。

[0069]

除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的

技术人员通常理解的含义相同。本文中在本发明的说明书中所使用的术语只是为了描述具体的实施方式的目的,不是旨在于限制本发明。

[0070]

参考图1所示,为本公开实施例提供的一种基于雷视数据运动分析的车辆检测方法的流程图,可以看出,主要包括以下流程:视频与毫米波雷达数据的采集及标定;基于毫米波雷达观测的空间频数进行虚拟车道、停止线及线圈的配置;视频目标检测结果与毫米波雷达数据的运动分析及融合处理;交通统计量的计算与传输;基于nginx流媒体服务器的实时视频流推送。

[0071]

本实施例的应用场景示意图参照图2。

[0072]

参考图3所示,为本公开实施例提供的一种基于雷视数据运动分析的车辆检测方法的架构图,总计分为上述流程中所述的5个模块,建立mqtt及共享内存结合的数据总线,各模块通过该总线进行数据的发布与订阅。

[0073]

(1)所述视频与毫米波雷达数据的采集及标定,该环节根据数据时间戳对毫米波雷达数据与视频数据进行预同步,使用了一种基于目标速度优先的雷达视频标定方法,对横向速度与纵向速度满足一定条件的雷达观测做出特殊标记,以供工程人员优先选择包含这些特殊标记的点来找出雷视坐标系对应点。

[0074]

(2)所述基于毫米波雷达观测的空间频数进行虚拟车道、停止线及线圈的配置,该环节对多帧毫米波雷达观测值在空间上的频数图进行构建,统计频数图中的极大值比例,分别对频数图进行线性变换与非线性变换,使用颜色图对变换的结果进行可视化,对来向数据与去向数据分别进行可视化处理,以供工程人员进行虚拟车道、停止线及线圈等交通信息的配置。

[0075]

(3)所述视频目标检测结果与毫米波雷达数据的运动分析及融合处理,该环节以雷达数据为主,基于卡尔曼滤波(kf)与匈牙利匹配方法(hungarian algrithom)对毫米波雷达数据进行跟踪,引入车道的运行状态,结合车道状态对跟踪目标进行运动分析,跟踪目标依据不同的状态,同视频目标检测结果进行融合处理;针对低速、静止的场景,使用视频数据进行补偿;针对多目标密集遮挡的场景,提出一种鲁棒的启停处理策略。

[0076]

(4)所述交通统计量的计算与传输,该环节在已配置好的虚拟车道、停止线、虚拟线圈等交通配置信息的基础上,对融合目标进行统计,使用tcp的传输方式向信号机发送车流量、排队长度、停车次数、线圈存在性等统计量。

[0077]

(5)所述基于nginx流媒体服务器的实时视频流推送,该环节通过在边缘计算设备上搭建轻量级的流媒体服务器,使得边缘计算设备可以推送多种视频流,包括rtsp视频流、rtmp视频流以及flv视频流。

[0078]

本发明使用80ghz的毫米波雷达、200万像素的单目摄像头作为传感器,可以同时获取相对地面的道路目标位置坐标数据、目标的速度数据、目标及场景的像素信息;边缘计算处理器选型为4核arm cortex-a7,选用的gpu算力为0.5tflops。

[0079]

步骤1:视频与毫米波雷达数据的采集与标定

[0080]

本发明使用200万像素的单目摄像头进行视频数据的采集,帧率为30fps,采集到的图像分辨率为640x480;使用80ghz的毫米波雷达,雷达数据解析频率为10fps。步骤1的技术流程如图4所示,传感器数据的处理主要分为数据推送分支和雷视标定分支,数据推送分支将采集的视频数据进行预处理、目标检测模型推理、稀疏光流法补偿推理延迟,而后把视

频目标检测结果、实时采集的视频帧和毫米波雷达数据发布到数据总线;雷视标定分支将实时采集的视频数据、毫米波雷达数据进行同步、保存、雷视标定。

[0081]

数据推送分支中,将原始视频帧分辨率缩放至416x416,使用imagenet数据集的均值、标准差对图像数据进行标准化,使用交通场景数据训练好的yolov3作为目标检测模型,将其推理batchsize配置为1,经过非极大值抑制等后处理,得到视频帧的目标检测结果;如下式所示,捕获模型推理前后的实时视频帧i

t1

与i

t2

,以目标检测框的中心坐标作为角点cornerset,通过稀疏光流法,计算出前后两帧中各个角点的像素偏移δu与δv,依据中心点的u、v方向偏移量,对上述视频帧目标检测结果进行校正;最后,将视频帧目标检测结果、毫米波雷达实时采集的数据、视频实时采集的数据推送到mqtt数据总线。

[0082]

δu=opticalflowdiffu(i

t2

,i

t1

,cornerset)

[0083]

δv=opticalflowdiffv(i

t2

,i

t1

,cornerset)

[0084]

雷视标定分支中,首先对视频帧数据与毫米波雷达数据进行预同步,以毫米波雷达数据为主,根据二者的时间戳进行比对,通过阈值设定,保证一帧雷达对应一帧图像,以相应的方式进行保存;而后,使用基于目标速度优先的方式对多帧离线数据进行标签化,具体地,筛选纵向距离小于一定阈值、横向速度小于一定阈值、纵向速度大于一定阈值的目标,将这些目标特殊标记出来,以供工程人员选择;如图5所示,工程人员选择视频界面和雷达界面中的目标对应点,为防止雷达界面内鼠标点击造成的标定误差,步骤1在雷达坐标系内鼠标所点击的范围内搜索最近的雷达目标点,如下式所示,根据人工选择的雷视对应点对集合correspointset,可以求解出坐标系间的透视变换矩阵homomatrix,该矩阵表示雷达坐标系坐标到像素坐标的映射变换关系。

[0085]

homomatrix=findhomography(correspointset)

[0086]i(x,y)

=homomatrix

·

radar

(x,y)

[0087]

步骤2:虚拟车道、停止线、虚拟线圈等交通信息的配置

[0088]

现有基于视频传感器进行虚拟车道配置的方式,大都在视频画面中直接选取各个车道区域,但现实应用场景存在多种多样的路口,往往存在车道线模糊、道路反光、车道界限不确定等问题;因此本发明以毫米波雷达信号为主,进行交通信息的配置。如图6所示,虚拟车道、停止线、虚拟线圈等交通信息的配置包括:基于多帧毫米波雷达观测的热点图生成、人工根据目标热点图画虚拟车道、人工确定各个车道的停止线、人工在视频画面中配置虚拟线圈。

[0089]

步骤2中的交通信息配置依赖于步骤1求解出的透视变换矩阵,以便两个坐标系下的配置信息可以相互映射。

[0090]

步骤2中通过线性变换l,构建了多帧毫米波雷达观测的空间频数图i

freq

,该频数图大小设定为640x480,并统计频数图中的极大值max

freq

所占比例p

freq

;如下式所示,如果频数极大值所占比例大于一定的比例δ

p

,则直接进行频数归一化处理,若频数极大值所占比例小于一定的比例δ

p

,则进行非线性平滑处理,得到结果i'

freq

,通过颜色图关联,得到目标热点图i

map

。

[0091]ifreq(x,y)

=l

·

radar

(x,y)

[0092][0093][0094]imap

=colormap(i'

freq

)

[0095]

步骤2中根据目标热点图i

map

,通过人工的方式在热点图中对虚拟车道进行勾勒,如图7所示,工程人员仅需画车道边界线,便可自动生成雷达坐标系和视频坐标系下的虚拟车道。步骤2中人工配置各车道的停止线与各车道中的虚拟线圈,工程人员仅需要在视频画面中勾勒停止线与各个车道的虚拟线圈。

[0096]

步骤3:视频目标检测结果与毫米波雷达数据的运动分析及融合处理

[0097]

步骤3基于目标运动分析,实现了决策层的雷视数据自适应融合方法,整体技术流程如图8所示,以毫米波雷达数据处理为主线,使用卡尔曼滤波对当前跟踪目标进行预测,使用基于马氏距离的匈牙利匹配来关联毫米波雷达观测与预测值;对各个跟踪目标进行运动状态分析,同时引入车道绿灯/红灯状态;分别针对红灯车道中的静止目标、红灯车道中的运动目标、绿灯车道中的静止目标、绿灯车道中的运动目标,各采用不同的融合处理策略;针对毫米波雷达对低速目标/静止目标检测效果差的情况,提出并实现使用视频进行补点的策略;针对高峰期多目标密集遮挡的情况,提出并实现一种鲁棒的启停处理策略。

[0098]

步骤3中使用卡尔曼滤波对毫米波雷达目标进行预测,t-1时刻的跟踪目标为一个6维的向量[x

t-1

,y

t-1

,vx

t-1

,vy

t-1

,ax

t-1

,ay

t-1

],其中x

t-1

表示t-1时刻的横坐标,y

t-1

表示t-1时刻的纵坐标,vx

t-1

表示t-1时刻的横向速度,vy

t-1

表示t-1时刻的纵向速度,ax

t-1

表示t-1时刻的横向加速度,ay

t-1

表示t-1时刻的纵向加速度;预测如下式所示,依据t-1时刻的目标信息对t时刻的目标状态进行预测。

[0099][0100]

步骤3中使用匈牙利匹配方法来关联预测结果和毫米波雷达观测,如下式所示,统计跟踪目标历史数据的协方差,构建预测和所有观测值的马氏距离;通过匈牙利匹配方法找到预测和观测的最大匹配。

[0101][0102]

[0103]

步骤3引入了车道的绿灯状态/红灯状态,各车道默认为绿灯状态,判断车道中第一辆车的数据情况,来决定车道是否切换为红灯状态;当满足以下条件时,车道切换为红灯车道;若车道为来向车道、车道内第一辆车距离停止线在30米范围内、第一辆车的速度小于5m/s、车道内第一辆车连续5帧未匹配到毫米波雷达观测值、车道内第一辆车在2s内存在减速趋势、该车道距离上次为红灯状态已超过10s。

[0104]

laneset={lane

red

,lane

green

}

[0105]

步骤3对各个跟踪目标的运动状态进行分析,毫米波雷达对目标停车速度的处理存在一定的误差,存在车辆停车时的纵向测速过大的问题;结合配置好的交通信息,对跟踪目标进行运动和静止的状态判定。跟踪目标的状态初始为运动,当满足以下条件时,判定为静止状态:计算跟踪目标在车道中的纵向次序,如果目标为车道中的第一辆车,则判断车道是否为来向车道、目标距离停止线是否小于一定阈值、自身速度是否低于5m/s、2s内是否存在减速趋势、毫米波雷达观测是否连续失配、目标是否可以匹配到视频观测,若以上皆满足,则判定为静止状态;如果跟踪目标不是车道中的第一辆车,则判断车道是否为红灯车道、距离前面最近的停止目标是否小于50米、自身速度是否低于5m/s、2s内是否存在减速趋势、毫米波雷达观测是否连续失配、目标是否可以匹配到视频观测,若以上皆满足,则判定为静止状态;判定为静止目标的状态一定周期内不可以修改运动状态。

[0106]

objset={obj

move

,obj

static

}

[0107]

步骤3分别针对红灯车道中的静止目标、红灯车道中的运动目标、绿灯车道中的静止目标、绿灯车道中的运动目标,各采用不同的融合处理策略;红灯车道中的静止目标记作obj

redstatic

,其处理逻辑记为φ

redstatic

,具体地,将跟踪目标映射到图像上,使用匈牙利匹配来关联视频目标检测数据,若跟踪目标在连续3s内没有匹配到视频检测框,将该目标从跟踪器中清除,处理结果记为obj

redstaticres

,同时,计算该目标在车道前后目标的距离,若前方有静止目标,判别目标间是否存在视频检测框,使用视频检测框对二者之间进行补点;红灯车道中的运动目标记作obj

redmove

,其处理逻辑记为φ

redmove

,具体地,和第一种情况相仿,若跟踪目标在连续3s内没有匹配到视频检测框,则将该目标从跟踪器中清除,处理结果记为obj

redmoveres

;绿灯车道中的静止目标记作obj

greenstatic

,其处理逻辑记为φ

greenstatic

,具体地,若该目标长时未匹配到毫米波雷达观测,则将该目标从跟踪器中清除,处理结果记为obj

greenstaticres

;绿灯车道中的运动目标记作obj

greenmove

,其处理逻辑记为φ

greenmove

,具体地,若该目标未匹配上雷达观测,则使用与该目标关联的视频观测与卡尔曼滤波预测值进行关联,处理结果记为obj

greenmoveres

。

[0108]

objset={obj

redstatic

,obj

redmove

,obj

greenstatic

,obj

greenmove

}

[0109]

obj

redstaticres

=φ

redstatic

(obj

redstatic

)

[0110]

obj

redmoveres

=φ

redmove

(obj

redmove

)

[0111]

obj

greenstaticres

=φ

greenstatic

(obj

greenstatic

)

[0112]

obj

greenmoveres

=φ

greenmove

(obj

greenmove

)

[0113]

objset

res

={obj

redstaticres

,obj

redmoveres

,obj

greenstaticres

,obj

greenmoveres

}

[0114]

步骤3中针对毫米波雷达对低速目标/静止目标检测效果差的情况,提出并使用了视频目标检测框进行补点的策略;步骤3通过将视频检测框和毫米波雷达观测进行匹配,统计出失配的视频目标检测框集合,根据这些目标检测框来创建新的跟踪目标。

[0115]

步骤3针对高峰期多目标密集遮挡的情况,提出并实现一种鲁棒的启停处理策略;该策略根据车道的红灯状态和绿灯状态情况,找到红灯状态切换绿灯状态的时段,将尚处于静止状态的目标向前推,直至和前面车辆的距离小于一定阈值。

[0116]

步骤4:交通统计量的计算与传输

[0117]

步骤4基于虚拟车道和虚拟线圈进行相关统计,每次目标融合更新后,对其进行数据更新统计;统计效果如图11所示,所计算的交通统计量包括脉冲数据、传统数据等。

[0118]

脉冲数据指的是检测目标驶入线圈和驶离线圈的状态信息,其计算过程如图10所示,针对每个线圈,分别建立一个用于存储脉冲数据的向量,当目标进入线圈时,状态存储1,当目标驶离线圈时,状态存储0。

[0119]

传统数据包括排队长度、车流量(总流量或按照类型划分的车流量)、时间占有率、平均速度、车头时距等;其中排队长度分为静态排队长度和动态排队长度;动态排队长度,首先统计在车道内的目标点数,然后按照位置进行排序,记录第一辆车到最后一辆车之间的距离,为排队长度。当第一辆车过了车道线时,排队长度为车道线到末端车之间的距离,当第一辆车未过车道线时,排队长度为第一辆车的车头到最后一辆车的车尾距离;静态排队长度的计算,首先统计在车道内的目标点数,然后通过速度阈值进行筛选,接着进行排序,当排序后的相邻目标大于一定阈值时,记录前一个目标为a,记录第一个目标到a目标之间的距离为静态排队长度;时间占有率的计算依据于统计线圈,周期性统计的参数,从统计周期开始时,记录每一个点进入线圈进入线圈和离开的时刻,并做差值累积到线圈占有时间,周期结束的时候,计算周期内占有时间与统计周期的比值,即时间占有率;平均速度的计算依据于统计线圈,记录一下周期内经过线圈的目标的速度并累计,周期结束时与目标书做比值,进行相应传输;车头时距的计算需要记录周期内第一辆和最后一辆车进入线圈的时刻,并做差值计算,在与周期内经过的车辆数做比值,即为车头时距。

[0120]

步骤4基于tcp协议向信号机传输交通统计量,初始化边缘计算设备ip作为tcp服务器,信号机作为tcp客户端;边缘计算设备通过监听客户端连入通讯事件,与信号机建立通讯连接,边缘计算设备与信号机间定制了相应的通讯协议,主要包含车流量、脉冲传输、动态排队长度、故障信息、路况信息、停车次数、延误时间、排队超值报警、过车状态、区间动态当量车辆数、区间平均车头间距、实时速度上传、车道数据等。

[0121]

步骤5:实时视频流的推送

[0122]

步骤5基于ffmpeg库,使用h264格式进行编解码,将原始视频帧/叠加信息的视频帧推送rtsp视频流;通过在边缘计算设备搭建nginx流媒体服务器,将rtsp视频流转换为rtmp和flv,并可以在局域网内推送;整体框架如图12所示,nginx通过rtmp模块提供rtmp服务,ffmpeg推送一个rtmp流到nginx,而后通过访问nginx来收看实时rtmp视频流,同理,配置hls,客户端可以通过http协议来访问flv视频流;视频流推送效果如图13所示,视频流效果满足实时性。

[0123]

本实施例基于雷视数据运动分析的车辆检测方法的整体架构参考图3,视频与毫米波雷达数据的标定操作参考图5,虚拟车道、停止线及线圈的配置参考图7,毫米波雷达与视频数据的融合跟踪效果参考图9,交通统计量的相关展示参考图11,实时视频推送流参考图13。

[0124]

综上,本发明提出了一种基于雷视数据运动分析的车辆检测方法,通过对毫米波

雷达与视频数据的运动分析及自适应融合,提升了目标检测的精度与鲁棒性,适用于低算力的边缘计算设备,降低了设备成本;同时,全面均衡了车流量、排队长度、停车次数、线圈存在性等统计量,本发明在算法中引入各个车道的运行灯态,并对毫米波雷达观测数据运动状态进行分析,不同的运动状态采用相应的处理策略,有效解决了绿灯车道内车辆目标误检、红灯车道内车辆目标漏检的问题。本发明相比现有车辆检测技术,能更好地为信号控制系统提供精确、多样的交通数据。

[0125]

本说明书中的上述各个实施方式均采用递进的方式描述,各个实施方式之间相同相似部分互相参照即可,每个实施方式重点说的都是与其他实施方式不同之处。以上所述仅为本发明的几个实施方式,虽然本发明所揭露的实施方式如上,但所述内容只是为了便于理解本发明的技术方案而采用的实施方式,并非用于先定本发明。任何发明所属技术领域的技术人员,在不脱离本发明所揭露的精神和范围的前提下,可以在实施方式的形式上及细节上作任何的修改与变化,但本发明的专利保护范围,仍须以所附权利要求书所界定的范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1