一种基于目标感知ViT的无人机跟踪方法

本发明涉及目标跟踪领域,尤其涉及一种针对无人机的目标跟踪方法。

背景技术:

1、随着人工智能的发展,很多行业都受到影响,其中有些发生着巨大的变化。对于无人机来说,许多公司都致力于利用深度学习的技术让无人机更加智能,其中之一就是无人机跟踪技术。无人机跟踪在灾害救援、交通监视、环境监测和电力巡检等方面有着广泛的应用。无人机不同于无人车、无人船等,无人机由于其起飞重量的限制,所搭载的处理器以及电池都要尽可能的轻,因此无人机的处理器性能和电池电量都受到制约。

2、无人机跟踪器应该具备两个基本素质:1)要能够应对一些极端的挑战,如极端视角、运动模糊和严重遮挡等;2)满足有限电池容量和计算资源约束的情况下高效率低功耗的要求。

3、目前无人机中使用最广泛的跟踪器仍是基于判别式滤波器(dcf)的跟踪器,最近也有些使用滤波器剪枝的基于卷积神经网络(cnn)的轻量级跟踪器。基于dcf的跟踪器因其效率高而受到青睐,然而它们往往难以实现高跟踪精度。另一方面,基于cnn的跟踪器以其高精度而闻名,但它们对计算资源的要求很高,因此不太适合高效的需求。为解决此问题,权衡之下,研究人员为无人机跟踪引入基于cnn的轻量级跟踪器。这些跟踪器采用滤波器剪枝技术来减少网络中的参数数量,从而显著提高了精度和效率。

4、在通用视觉跟踪领域,新兴的基于vit(vision transformer)的跟踪器通过使用注意力机制而获得了巨大的成功,能够更有效地捕捉目标位置。而无人机跟踪领域尚未有人提出基于vit的跟踪器,可能是因为基于vit的通用视觉跟踪器具有庞大的模型参数数量和较低的运行速率,这些原因阻止了许多有益的探索。

技术实现思路

1、本发明的目的是提供一种基于目标感知vit的无人机跟踪方法以进行实时高效的无人机跟踪。

2、本发明的技术方案是设计并训练所提出的无人机跟踪模型,将该模型部署到无人机平台上进行目标跟踪以满足用户需求。

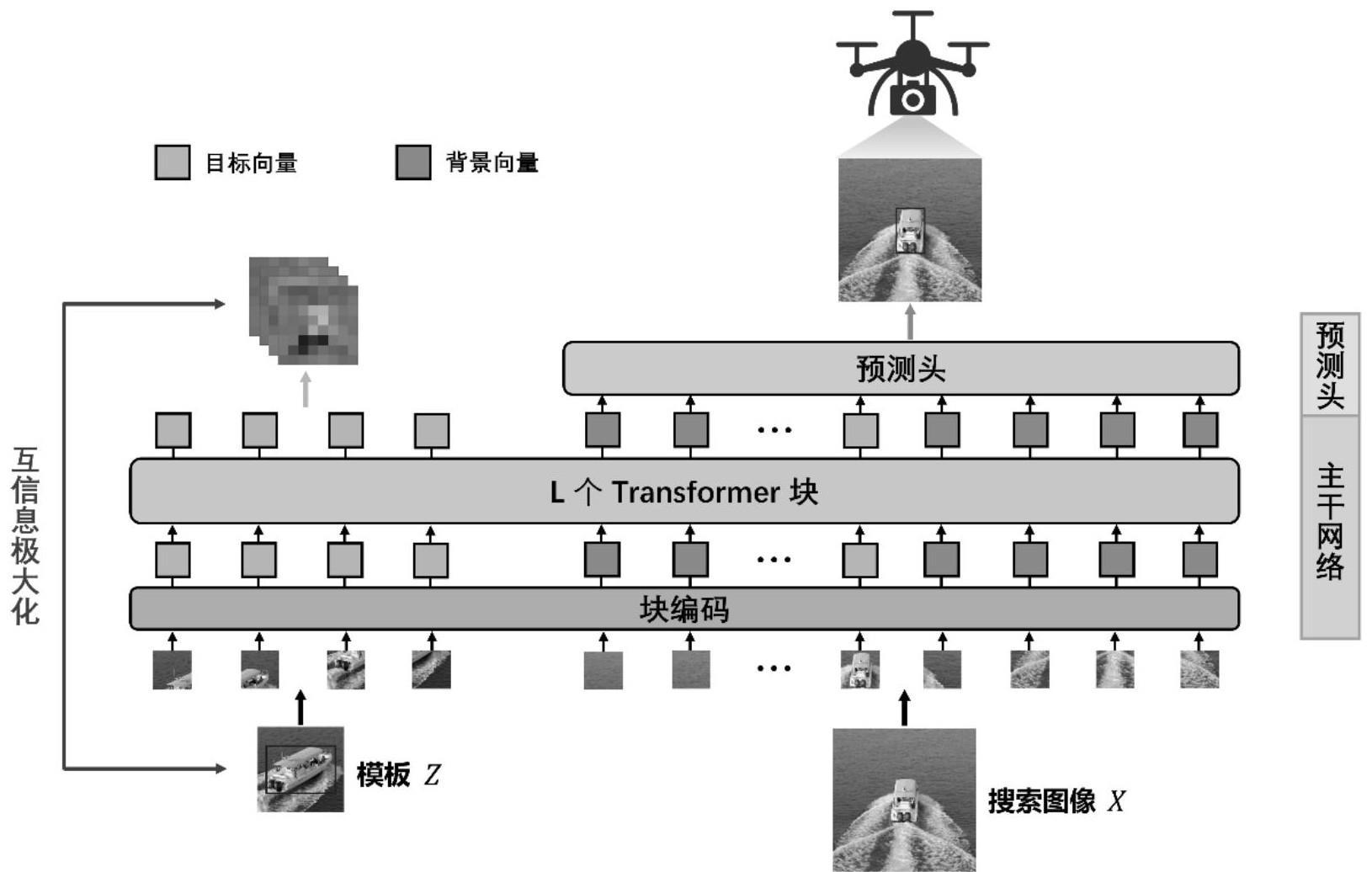

3、基于vit的无人机跟踪框架如图1所示。该框架由基于目标感知vit的主干网络以及预测头部组成。

4、(1)主干网络

5、主干网络承载着同时输出特征学习和模板-搜索图像耦合的任务,允许两个过程交互。该框架的输入包含目标模板z和搜索图像x,它们首先被按相同大小(16×16)切割并按顺序展平为一个序列,然后通过可训练的线性投影层标记化,并产生k个向量,其表示为:

6、(1)

7、其中d表示每个向量的嵌入维度,向量序列和分别表示模板和搜索图像,其中。用表示第层的transformer 块,向量从第层到第层通过来转换。整个转换过程可表示为:

8、(2)

9、其中表示组合操作,是的参数,共有层transformer 块。

10、本框架的核心思想是模板图像与其特征之间的互信息极大化。

11、设是两个随机变量,则之间的互信息可以表示为:

12、(3)

13、其中表示联合概率分布,表示边缘概率分布,表示kullback-leibler散度(通常简称为kl散度)。但在实际情况中,估计互信息非常困难,因为我们可以得到样本,但是无法得到总体分布。因此我们使用deep infomax(dim)学习用于无人机跟踪的目标感知vit,它基于jensen-shannon散度(jsd)而不是kl散度。其表示为:

14、(4)

15、其中是由参数化的神经网络,是softplus激活函数。在本框架中,我们的具体做法如下:

16、(5)

17、=表示从主干网络输出中截取的模板特征。互信息极大化损失函数定义如下:

18、(6)

19、(2)预测头和损失函数

20、使用基于全卷积网络的预测头,包含三个分支,每个分支包括4个堆叠在一起的卷积-批量归一化-relu层,用于估计目标的边界框。从主干网络输出的向量中截取搜索图像的部分并重新解释为2维空间特征图输入到预测头中。其结果为目标分类得分<mi>p</mi><mi>∈</mi><msup><mi>[0,1]</mi><mrow><msub><mi>h</mi><mi>x</mi></msub><mi>/p</mi><msub><mi>×w</mi><mi>x</mi></msub><mi>/p</mi></mrow></msup>,局部偏移量<mi>o</mi><mi>∈</mi><msup><mi>[0,1]</mi><mrow><msub><mi>2×h</mi><mi>x</mi></msub><mi>/p</mi><msub><mi>×w</mi><mi>x</mi></msub><mi>/p</mi></mrow></msup>,以及归一化边界框大小<mi>s</mi><mi>∈</mi><msup><mi>[0,1]</mi><mrow><msub><mi>2×h</mi><mi>x</mi></msub><mi>/p</mi><msub><mi>×w</mi><mi>x</mi></msub><mi>/p</mi></mrow></msup>(其中分别表示搜索图像的高和宽,表示将图像切成的小块的边长)。位置的初始估计由最大分类得分确定,表示为。然后基于这个粗略位置计算出预测的目标边界框为:

21、(7)

22、对于跟踪任务我们采用加权的focal loss进行分类、并将iou损失和l1损失的组合用于边界框回归。最后总的损失函数为:

23、(8)

24、其中常数、、。在加载用于图像分类的vit预训练权重之后,我们的框架使用整体损失函数进行端到端训练。

技术特征:

1.一种基于目标感知vit的无人机跟踪方法,其特征在于:

技术总结

本发明公开了基于目标感知的无人机跟踪方法,涉及无人机跟踪技术领域。采用的跟踪框架是一个单流的跟踪框架,包含主干网络和预测头两部分。主干网络使用DeiT‑Tiny,是基于ViT的,通过模板图像与其特征之间的互信息极大化操作实现目标感知。预测头部有三个分支,分别用于预测分类得分、预测采样量化误差以及预测归一化边界框大小,每个分支由四个堆叠在一起的卷积‑批量归一化‑ReLU组成。使用现有的目标跟踪数据集进行训练,获得无人机跟踪模型,然后将训练好的框架部署到无人机平台用于目标踀。本发明通过设计和训练基于目标感知的无人机跟踪模型,可以实现对强烈阳光下的目标、具有快速变换视角的目标以及远距离小目标的精确、高效、实时跟踪。

技术研发人员:李水旺,杨向阳,叶恒舟

受保护的技术使用者:桂林理工大学

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!