一种融合视觉里程计及IMU的室内定位方法与流程

一种融合视觉里程计及imu的室内定位方法

技术领域

[0001]

本发明涉及机器人定位技术领域,具体涉及一种融合视觉里程计及 imu的室内定位方法。

背景技术:

[0002]

随着传感器、人工智能等技术的快速发展,机器人的研究越来越受到重视。机器人通过传感器获取外部环境信息和自身状态信息,依据这些信息实现自主运动并完成一定的作业任务。

[0003]

但,自主定位是机器人智能导航和环境探索研究的基础,由于单一传感器难以获取系统所需的全部信息,多传感器的信息融合成为机器人实现自主定位的关键。

[0004]

目前,单一或两种传感器的定位精度和稳定性很难满足要求,采用视觉或者里程计的方法较为成熟,但在室内,运动和光照环境对其稳定性及精确度有较大影响。

[0005]

因此,利用惯性测量单元(imu)来获取机器人的瞬时位移增量来推算出机器人的轨迹,然后来辅助定位成为可能。

技术实现要素:

[0006]

本发明的目的是提供一种融合视觉里程计及imu的室内定位方法。此方法旨在解决传统机器人定位实时性和鲁棒性差的问题,利用双目相机结合场景结构化特征,基于室内场景结构化特征的立体匹配方法,提升立体匹配精度,与基于因子图的后端全局优化相结合,以提升机器人定位的实时性和鲁棒性。

[0007]

为达到上述目的,本发明提供了一种融合视觉里程计及惯性测量单元 (imu)的室内定位方法,包括以下步骤:

[0008]

步骤1:采用相机对室内场景进行目标分析,获取场景图像;

[0009]

步骤2:对场景图像进行关键帧提取,获得场景图像的关键帧;

[0010]

步骤3:基于随机抽样一致算法,对相机在不同位姿下的两幅连续场景图像中的关键帧,进行特征点匹配,获得场景图像的位姿约束信息;

[0011]

步骤4:基于因子图优化算法,根据连续两幅场景图像特征匹配获得的位姿约束信息,给因子图中定位姿节点之间边的初始值,并对场景图像进行位姿全局优化,获得优化位姿;

[0012]

步骤5:根据位姿约束信息以及优化位姿,对相机的位姿进行实时优化,获得室内场景的场景轨迹和全局地图,完成室内定位。

[0013]

最优选的,所述关键帧提取包括以下步骤:

[0014]

步骤2.1:基于线段特征与二进制线描述符相结合,对所述场景图像进行线条结构关系提取,获取场景图像的场景空间结构;

[0015]

步骤2.2:基于orb特征点提取算法,对所述场景图像进行特征点提取,获取场景图像的特征点矩阵;

[0016]

步骤2.3:结合所述场景图像的场景空间结构与所述特征点矩阵,获得场景图像的关键帧。

[0017]

最优选的,所述特征点提取包括以下步骤:

[0018]

步骤2.2.1:根据场景图像,构建多层的高斯金字塔;

[0019]

步骤2.2.2:基于fast算法,根据所述多层的高斯金字塔,计算出每层的高斯金字塔的特征点位置;

[0020]

步骤2.2.3:根据所述每层的高斯金字塔的特征点位置,将每层的高斯金字塔划分为若干个区域;

[0021]

步骤2.2.4:提取每层每个区域的高斯金字塔中响应值最大的兴趣点,并进行描述子计算,获得场景图像的特征点矩阵。

[0022]

最优选的,相机为双目相机。

[0023]

最优选的,室内场景为室内天顶纹理图像、地板纹理图像中的任意一种。

[0024]

运用此发明,解决了传统机器人定位实时性和鲁棒性差的问题,利用双目相机结合场景结构化特征,基于室内场景结构化特征的立体匹配方法,提升了立体匹配精度,与基于因子图的后端全局优化相结合,提升了机器人定位的实时性和鲁棒性。

[0025]

相对于现有技术,本发明具有以下有益效果:

[0026]

1、本发明提供的融合视觉里程计及imu的室内定位方法,利用双目相机结合场景结构化特征,基于室内场景结构化特征的立体匹配方法,提升立体匹配精度与建图效果,并与基于因子图的后端全局优化相结合,构建视觉slam系统,以提升机器人定位的实时性和鲁棒性。

[0027]

2、本发明提供的融合视觉里程计及imu的室内定位方法,通过对目标场景进行分析,基于室内场景固有特点,获取位姿估计的精确信息约束条件,并采用因子图算法进行位姿优化。

[0028]

3、本发明提供的融合视觉里程计及imu的室内定位方法,前端为视觉里程计,估算相邻图像间相机的运动,以及局部地图,后端通过因子图接收不同时刻视觉里程计测量的相机位姿,对他们进行优化,得到全局一致的轨迹和地图。

附图说明

[0029]

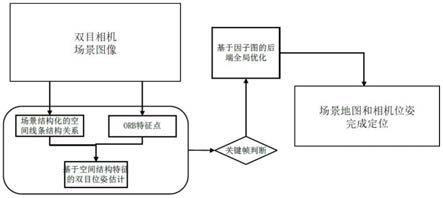

图1为本发明提供的室内定位方法流程图。

具体实施方式

[0030]

以下结合附图通过具体实施例对本发明作进一步的描述,这些实施例仅用于说明本发明,并不是对本发明保护范围的限制。

[0031]

本发明提供了一种融合视觉里程计及imu的室内定位方法,如图1所示,包括以下步骤:

[0032]

步骤1:采用双目相机对变电站的室内场景进行目标分析,获取变电站室内场景的场景图像。

[0033]

在本实施例中,双目相机的型号为mynt s1030-ir-120;变电站的室内场景为室内天顶纹理图像、地板纹理图像等。

[0034]

步骤2:对变电站室内场景的场景图像进行关键帧提取,获得变电站室内场景的场景图像的关键帧;

[0035]

其中,关键帧提取包括以下步骤:

[0036]

步骤2.1:基于线段特征与二进制线描述符相结合,对变电站室内场景的场景图像进行线条结构关系提取,获取变电站室内场景的场景图像的场景空间结构。

[0037]

步骤2.2:基于orb(oriented fast and rotated brief)特征点提取算法,对场景图像进行特征点提取,获取变电站室内场景的场景图像的特征点矩阵。

[0038]

其中,特征点提取包括以下步骤:

[0039]

步骤2.2.1:根据场景图像,构建场景图像的多层的高斯金字塔,以实现场景图像的尺度不变性变换、以及通过灰度质心对方向进行标定实现旋转不变性变换。

[0040]

在本实施例中,构建出场景图像的多层的高斯金字塔对应的c语言程序如下:

[0041]

输入:inputarray_图像,vector_特征点,outputarray_描述子

[0042]

对输入图像进行高斯模糊

[0043]

金字塔时的变化尺度scalefactor=1.2;金字塔的层数nlevels=8

[0044]

for(当前层数=0;层数<nlevels;++当前层数)

[0045]

按照层数,对图像进行下采样

[0046]

if(层数!=0)

[0047]

为图像添加边缘。

[0048]

步骤2.2.2:基于fast算法,根据场景图像的多层的高斯金字塔,计算出场景图像的每层的高斯金字塔的特征点位置。

[0049]

在本实施例中,计算特征点位置对应的c语言程序如下:

[0050]

fast特征点的默认阈值inithfast=20

[0051]

for(当前层数=0;l当前层数<nlevels;++当前层数)。

[0052]

步骤2.2.3:根据每层的高斯金字塔的特征点位置,将每层的高斯金字塔划分为若干个区域;

[0053]

步骤2.2.4:提取每层每个区域的高斯金字塔中响应值最大的兴趣点,并进行描述子计算,获得场景图像的特征点矩阵。

[0054]

在本实施例中,描述子计算对应的c语言程序如下:

[0055]

for(当前特征点id=0;id<n;++id)。

[0056]

步骤2.3:结合变电站室内场景的场景图像的场景空间结构与场景图像的特征点矩阵,获得场景图像的关键帧。

[0057]

步骤3:基于随机抽样一致算法(random sample consensus,ransac),对相机在不同位姿下的两幅连续场景图像中的关键帧,进行特征点匹配,从而将连续时间上的两幅场景图像在信息上关联,获得场景图像的位姿约束信息。

[0058]

其中,特征点的匹配效果直接影响特征点跟踪过程的精确性和实时性,进而极大影响运动估计结果的精确度与效率。

[0059]

步骤4:基于因子图优化算法,构建出只有轨迹的因子图优化,根据连续两幅场景图像的关键帧之间特征匹配获得的位姿约束信息来给定位姿节点之间边的初始值,对场景图像进行位姿全局优化,获得场景图像的优化位姿。

[0060]

其中,位姿全局优化是指:从相机位姿和地图特征中获得运动边(motionarcs)和测量边(measurement arcs),测量边连接位姿和该位姿上所测量到的特征点,每个边对应一个非线性位姿约束值,这些位姿约束信息表示测量和运动模型的负对数似然,而目标函数是这些位姿约束信息的集合;因子图优化后端将一系列的约束线性化,线性化得到信息矩阵和信息矢量,通过调整各变量的值,使其因子之乘积最大化,获取地图后验。

[0061]

步骤5:根据前端视觉里程计估算出的连续场景图像关键帧之间相机的运动与场景图像的位姿约束信息,以及后端通过因子图接收不同时刻视觉里程计测量的场景图像的优化位姿,对相机的位姿进行实时优化,获得全局一致的场景轨迹和全局地图,完成室内定位。

[0062]

本发明的工作原理:

[0063]

采用相机对室内场景进行目标分析,获取场景图像;对场景图像进行关键帧提取,获得场景图像的关键帧;基于随机抽样一致算法,对相机在不同位姿下的两幅连续场景图像中的关键帧,进行特征点匹配,获得场景图像的位姿约束信息;基于因子图优化算法,根据连续两幅场景图像特征匹配获得的位姿约束信息,给因子图中定位姿节点之间边的初始值,并对场景图像进行位姿全局优化,获得优化位姿;根据位姿约束信息以及优化位姿,对相机的位姿进行实时优化,获得室内场景的场景轨迹和全局地图,完成室内定位。

[0064]

综上所述,本发明一种融合视觉里程计及imu的室内定位方法,解决了传统机器人定位实时性和鲁棒性差的问题,利用双目相机结合场景结构化特征,基于室内场景结构化特征的立体匹配方法,提升了立体匹配精度,与基于因子图的后端全局优化相结合,提升了机器人定位的实时性和鲁棒性。

[0065]

尽管本发明的内容已经通过上述优选实施例作了详细介绍,但应当认识到上述的描述不应被认为是对本发明的限制。在本领域技术人员阅读了上述内容后,对于本发明的多种修改和替代都将是显而易见的。因此,本发明的保护范围应由所附的权利要求来限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1