一种基于神经网络的车牌对齐检测方法与流程

1.本发明涉及一种基于神经网络的车牌对齐检测方法,属于图像识别技术领域。

背景技术:

2.伴随着人们生活水平的提高私家车数量呈指数增长,在方便人们出行的同时,私家车也造成了一些不好的影响,并给现代交通带来了巨大的压力。日益严重的交通堵塞,车辆管理困难等问题日益困扰着人们,给生活到来了极大的不便。车牌作为车辆身份的标识,在车辆自动检测和识别过程中占据着重要的地位,已经被广泛的应用到智能交通和汽车智能管理中,车牌检测的好坏直接影响后续识别的精度。

3.对于自然场景下的车牌检测,基于人工设计的图像特征检测车牌速度快但是准确率较低;基于深度学习的检测算法有faster-rcnn、yolo和ssd等,faster-rcnn是二阶段检测网络,经过rpn(区域提名网络)后回归类别和坐标框,回归网络存在重复调用的情况,计算量大且实时性差,yolo系列和ssd为一阶段检测网络,任务中只回归了目标的类别和坐标框,检测速度也依然有待提高,因此基于深度学习的车牌检测准确率较高,但实时性较差。对于扭曲的车牌矫正对齐用专门的网络回归车牌的四个顶点,再进行透射变换矫正车牌区域,这个过程进一步增加了计算复杂度。对于现有的检测并回归车牌四个顶点的模型,可以借鉴mtcnn,但对于输入较大尺寸的图片,mtcnn的图像金字塔较多计算量成倍增加。

技术实现要素:

4.本发明的目的是提供一种基于神经网络的车牌对齐检测方法,以解决目前基于深度学习的车牌检测存在的效率低、实时性差的问题。

5.本发明为解决上述技术问题而提供一种基于神经网络的车牌对齐检测方法,该检测方法包括以下步骤:

6.1)获取需要进行车牌对齐检测的图像数据;

7.2)将获取的图像数据代入构建好的对齐检测模型中,所述的对齐检测模型采用mobilenet-yolov4网络架构,该网络架构用于实现车牌类别的回归、车牌边界框的回归和车牌四个顶点的回归,包括mobilenet网络模块和yolov4网络模块,所述的mobilenet网络模块包括有3个不同尺度的卷积层;yolov4网络模块包括3个预测层,分别与各尺度的卷积层对应,用于输出不同尺寸大小的特征图。

8.本发明利用mobilenet网络和yolov4网络的设计思想,构建了mobilenet-yolov4网络进行车牌检测,除了实现回归车牌的类别和边界框的任务外,另外增加一路任务回归车牌的四个顶点,将预测到的四个顶点透射变换对车牌进行矫正对齐,提高了网络层的复用并减少后续车牌矫正对齐的计算量,网络在减少部分网络层数和卷积核个数的前提下,模型的识别率依然很高,并且检测推理速度大大减小,使车牌检测满足实时高效的要求。

9.进一步地,所述特征图上每个点的维度为3

×

(5+1+8)=42,3代表每个点上有3个尺度框(锚点),5维分别代表目标中心点坐标,目标宽高和锚点有目标的概率,1维代表目标

的置信度,8维分别代表车牌的四个角的顶点坐标。

10.进一步地,所述的对齐检测模型进行训练时采用联合损失函数,所述的联合损失函数为:

11.loss=lbox+lcls+lobj+lpts

12.其中lbox为边界框的损失函数,lcls为类别损失函数,lobj为锚点处是否存在目标的损失函数,pts为四个顶点的损失函数。

13.进一步地,所述的边界框的损失函数为:

[0014][0015]

其中s2表示各预测层输出特征图的尺寸大小;b表示box的尺度框个数;λ

coord

是联合损失函数中边界框回归损失函数做占的比重,值为1;表示i,j处的box有目标时其值为1,否则为0,xi、yi、wi、hi分别表示目标框中心点坐标以及目标框宽和高的真实值,分别代表目标框中心点坐标的预测值以及目标框宽和高的预测值。

[0016]

进一步地,所述类别损失函数为:

[0017][0018]

其中s2表示各预测层输出特征图的尺寸大小;b表示box的尺度框个数;λ

class

是联合损失函数中类别概率损失函数所占的比重,值为1;表示i,j处的box有目标时其值为1,否则为0,参数c为预测维度上车牌的预测置信度。

[0019]

进一步地,所述锚点处是否存在目标的损失函数如下:

[0020][0021]

其中s2表示各预测层输出特征图的尺寸大小;b表示box的尺度框个数;λ

nobj

是联合损失函数中不存在目标的损失函数所占的比重,值为1;λ

obj

是联合损失函数中存在目标的损失函数所占的比重,值为1;表示i,j处的box有目标时其值为1,否则为0;表示i,j处的box没有目标时其值为1,否则为0,参数ci、为是否有目标的真实值和预测值。

[0022]

进一步地,所述的四个顶点的损失函数为:

[0023][0024][0025]

其中s2表示各预测层输出特征图的尺寸大小;b表示box的尺度框个数;λ

pts

是联合损失函数中车牌四个顶点坐标回归损失函数所占的比重,值为1;表示i,j处的box有目标时其值为1,否则为0;表示i,j处的box没有目标时其值为1,否则为0,lk和分别是车牌四个顶点的真实坐标和预测的坐标,x为真实值和预测值的差,也就是

附图说明

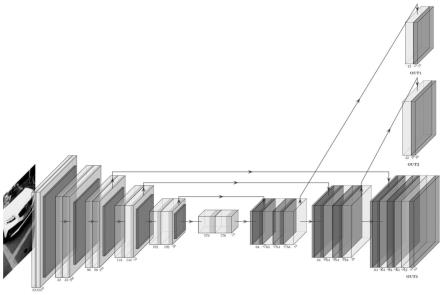

[0026]

图1是本发明所采用的mobilenet-yolov4网络结构简化图;

[0027]

图2是本发明预测层的结构示意图;

[0028]

图3是本发明验证例中的模型测试效果图;

[0029]

图4是本发明验证中对齐后得到车牌区域;

[0030]

图5本发明验证例中耗时情况示意图。

具体实施方式

[0031]

下面结合附图对本发明的具体实施方式作进一步地说明。

[0032]

本发明借鉴了mobilenet网络和yolov4网络的设计思想,构建了mobilenet-yolov4网络进行车牌检测,mobilenet-yolov4网络前半部分借鉴mobilenet网络去掉部分无用层和亢余的卷积核数,网络的后半部分借鉴yolov4的设计思想,并优化网络结构。除了回归车牌的类别和边界框,另外增加一路任务回归车牌的四个顶点,将预测到的四个顶点透射变换对车牌进行矫正对齐,将这三个任务整合到一个简单的网络里面,提高了网络层的复用并减少后续车牌矫正对齐的计算量。具体而言该方法的实现过程如下:

[0033]

1.构建mobilenet-yolov4网络作为对齐检测模型。

[0034]

如图1所示,本发明构建的mobilenet-yolov4网络包括mobilenet网络模块(主干网络)和yolov4网络模块(预测层网络),主干网络借鉴mobilenet,随着网络加深,特征图逐渐减小并在不同层之间连接,融合不同尺度的特征,使高维特征更容易捕捉到语义信息;预测层网络中上采样部分借鉴yolov4,在上采样过程中特征图不断增大,在三个不同尺度的特征图中进行预测,并将主干网络中相同大小的特征图进行变换融合到对应的三个预测特征图中,既保留了高维的语义特征又增加了低维的细粒度特征,提高了模型的准确率和鲁棒性。其中mobilenet网络模块采用多个卷积核,每个卷核的大小不同;yolov4网络模块包括三个预测层,预测层输出部分out1网络结构如图2所示,预测层网络中处理单元主要是卷积和激活函数的叠加组合,特征图的大小都为13

×

13,最终得到三个分支,这三个分支的特征图大小和卷积核数分别为13

×

13

×

32、13

×

13

×

16、13

×

13

×

16,经过route操作将这三个分支合并为13

×

13

×

64的特征图数,再经过卷积和线性回归得到13

×

13

×

42的预测层,输出层融合了3个特征通道的信息,out2和out3类似;当网络输入大小为416

×

416时,三个预测层out1、out2、out3的输出特征图尺寸大小分别为13

×

13、26

×

26、54

×

54。图2中out1的网络结构可以看出,最终预测层输出为13

×

13

×

42的张量,13

×

13为预测输出层尺寸大小,这个输出层上每个点上的维度为42,按任务进行拆分后42=3

×

(5+1+8),特征图上每个点的维度为3

×

(5+1+8)=42,3代表每个点上有3个尺度框(锚点),5维分别代表目标中心点坐标,目标宽高和锚点有目标的概率,前4维也就是边界框的回归任务,1维代表目标的置信度,车牌类别的回归任务,8维分别代表车牌的四个角的顶点坐标,车牌四个顶点的回归任务。

[0035]

2.对构建的mobilenet-yolov4网络进行训练,训练时采用联合损失函数。

[0036]

本发明在对mobilenet-yolov4网络进行训练时采用联合损失函数,该联合损失函数包括有边界框的损失函数、类别损失函数、锚点处是否存在目标的损失函数和四个顶点的损失函数,下面对各损失函数进行介绍。

[0037]

边界框的损失函数如下:

[0038][0039]

s2表示各预测层输出特征图的尺寸大小,预测层out1的尺寸为13

×

13、预测层out2的尺寸为26

×

26,预测层out3的尺寸为54

×

54,b表示box的尺度框个数,λ

coord

是联合损失函数中边界框回归损失函数做占的比重;表示i,j处的box有目标,其值为1,否则为0。表示i,j处的box没有目标,其值为1,否则为0,xi、yi、wi、hi分别表示目标框中心点坐标以及目标框宽和高的真实值,分别代表目标框中心点坐标的预测值以及目标框宽和高的预测值;λ

class

是联合损失函数中类别概率损失函数所占的比重,值为1,参数ci、为是否有目标的真实值和预测值,λ

nobj

是联合损失函数中不存在目标的损失函数所占的比重,值为1;λ

obj

是联合损失函数中存在目标的损失函数所占的比重,值为1;λ

pts

是联合损失函数中车牌四个顶点坐标回归损失函数所占的比重,值为1;lk和分别是车牌四个顶点的真实坐标和预测的坐标,x为真实值和预测值的差,也就是参数c为预测维度上车牌的预测置信度。

[0040]

类别损失函数如下:

[0041][0042]

锚点处是否存在目标的损失函数如下:

[0043][0044]

四个顶点的损失函数如下:

[0045][0046][0047]

联合损失函数为:loss=lbox+lcls+lobj+lpts(6)

[0048]

3.将待检测的带有车牌的图像数据输入到训练完的mobilenet-yolov4网络中,通过该网络可以实现对车牌图像的识别。

[0049]

为了说明本发明的可行性,将本发明对齐检测方法应用的具体的实例上,本发明在开源ccpd:chinese city parking dataset数据集上训练和测试,经过大量的实验,发现构建的轻量网络准确率能达到99.19%,单张图片测试效果如图3所示。根据检测到的4个点进行透射变换,将车牌对齐到预设框中,如图4所示。对齐后的车牌区域(图4)就可以用来识别,例如用训练好的crnn模型识别车牌中的具体字符。图片输入网络尺寸大小为416

×

416时,检测视频的帧率可以达到260fps,推理一张图片耗时约为3.848毫秒,结果如图5所示。

[0050]

本发明提出的检测网络在减少部分网络层数和卷积核个数的前提下,通过不断调优,模型的识别率依然很高,并且检测推理速度大大减小,使网络在车牌检测任务中实时高效。在原有任务上另加一路任务回归车牌的四个顶点,将对齐的前向步骤也移入网络,提高

了网络的复用性,使类别回归、边界框回归和顶点坐标回归达到了一个好的平衡,后续只需接入crnn识别模型,就可以将检测、对齐后的车牌进行识别,具有较高的商业应用价值。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1