基于多语义学习的知识图谱补全方法

1.本发明适用于知识领域知识图谱补全技术,尤其涉及一种基于多语义学习的知识图谱补全方法。

背景技术:

2.知识图作为人类知识的集合,已经成为人工智能(ai)和自然语言处理(nlp)应用的重要资源,如问题回答、网络搜索和语义分析等。知识表示,特别是知识嵌入,是知识利用的基础步骤。知识图谱的嵌入是为了学习一种连续的映射,将一个结构化的知识图谱的实体和关系嵌入到一个向量空间中。知识图谱嵌入有多种应用,如关系提取、问题回答、规范化、推荐系统、对话系统等。

3.知识图谱是事实的结构化的表示,其在知识图可以表示成三元组的集合(h,r,t),其中r表示头实体h和尾实体t之间的关系。大多数知识图谱,如freebase[1],wordnet[2],yago[3]等,已经包含数百万甚至数十亿的三元组,但仍远未完成,因为新兴出现的新知识。因此,该问题产生了知识库完成、实体识别和链接预测等任务。

[0004]

知识图谱补全(knowledge graph completion,kgc)任务旨在减少知识图谱中的知识缺失,提高知识图谱中知识的完备程度。因此,若能将知识图谱中的这些知识补全,对于提升搜索引擎的语义搜索精度、完善知识问答和智能推荐系统的服务质量具有重要的价值。近年来,各种不同的知识图谱补全方法被提出,这些方法大致分为以下三类,即基于距离的模型,基于语义匹配的模型和基于卷积神经网络的模型。

[0005]

(1)基于距离的模型

[0006]

这些方法的主要思想是先将实体和关系映射到同一空间,之后将关系视为从头实体到尾实体的转换。

[0007]

transh在2014年提出,该方法将实体映射到特定关系的超平面上,来满足不同关系下的实体表示,再进行转换操作。transr于2016年提出,该方法针对每个关系学习一个映射矩阵,然后把实体映射到特定关系空间中。

[0008]

(2)基于语义匹配的模型

[0009]

基于语义匹配的模型提出更复杂的操作,寻找实体和关系之间的语义联系。

[0010]

distmult在2014年提出,该方法使用使用加权元素点积来定义分数函数。打分函数定义为f

r

(h,t)=∑h

k

r

k

t

k

。complex在2016年提出,complex是distmult的一个改进版本,它利用复数嵌入和hermitian点积来解决反对称问题,而它在反对称关系上的性能比transe或distmult差。atth在2020年提出,该方法利用双曲线嵌入方法来捕获层次和逻辑模式。打分函数可以被定义为:其中q(h,r)是双曲注意力机制。

[0011]

(3)基于卷积神经网络的模型

[0012]

基于卷积的模型,该模型提出利用卷积来提升模型的表达能力,cnn的多层结构具有表达能力强、参数效率高的优点。

[0013]

基于卷积神经网络的模型主要包括conve(2018),hyper(2019),等。conve在2018年提出,该方法使用卷积神经网络(cnn)对实体和关系之间的交互进行建模,增强了实体和关系嵌入之间的交互,从而学习更好的表示。打分函数表示为:f

r

(h,t)=f(vec(f([h;r*w]))w)t。hyper在2019年提出,该方法把实体作为特征图,关系重构成卷积核的形式进行卷积操作。该模型的打分函数被定义为:f

r

(h,t)=f(vec(h*vec

‑1(w

r

h))w)t。interacte在2020年提出,该方法通过feature permutation,checkered feature reshaping,以及circular convolution来增强模型表达能力。该方法打分函数表示为:f

r

(h,t)=concat(g([h,r,t]*ω))w。

[0014]

现有的方法虽然已经取得了很大的进步,但仍存在一些具有挑战性的问题有待解决。首先是一词多义的问题。对于实体或者关系应该具有多种语义,而不同的语义应该具有不同的特征表示,以及特征交互不充分问题。针对这两个问题,提出的解决方案有:(1)通过多语义学习来进行知识图谱嵌入。(2)增强实体和关系特征之间的交互。

技术实现要素:

[0015]

同一个实体或者关系有多种语义,而不同语义应该具有不同的特征表示。比如,对于两个三元组(apple,taste,delicious)与(apple,software,ios),同一个实体apple,具有不同的语义,应该通过不同的特征表示来表达。所以本文通过学习多种语义表达来进行知识图谱嵌入。通过引入深度残差注意力模块,联合注意力,门控注意力网络,以及去噪模块来对实体和关系特征进行学习。

[0016]

本发明通过提出的模型能使实体和关系的特征表示更加准确,以及提升实体和关系的交互能力。

[0017]

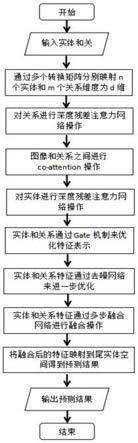

所提的模型的框架如附图1所示。对于实体和关系,首先通过不同的变换矩阵来捕获它们的多个隐藏语义信息。然后,通过深度残差注意力网络的结构以及实体和关系之间的联合注意来捕捉实体和关系间的交互影响,得到更有判别性的特征。最后通过了去噪网络和基于残差网络的多步融合结构来优化特征表示及融合实体和关系的特征。

[0018]

步骤一:实体和关系的多重嵌入;

[0019]

首先,将实体e1和r分别先通过多个转换矩阵学习到多个隐藏的语义表示。知识图嵌入的目的是将实体和关系嵌入到连续的低维空间中,同时保持知识图的关系和语义。当实体数为n

e

,关系数为n

r

,则实体和关系独热编码的维度分别为n

e

和n

r

,实体和关系的嵌入维数为d。即通过实体的嵌入矩阵,关系的嵌入矩阵来实现,其中i和j是实体和关系需要学习语义参数的个数i∈1,2,3

…

,n,j∈1,2,3

…

,m。在本发明中,头实体e1和关系r分别对应于高维的独热向量x

e

和x

r

,接着分别对头实体e1和关系r通过多个嵌入矩阵c

ei

和c

rj

嵌入到d维空间,分别得到e

1i

和r

j

的嵌入表示为:

[0020][0021]

步骤二:深度残差注意力网络;

[0022]

在前面的知识图嵌入捕捉实体和关系多个隐藏语义的步骤中,得到对同一实体或关系的多个特征嵌入。接着,本步骤利用深度残差注意力网络优化实体和关系的嵌入。深度残差注意力网络结构由1

×

1卷积层、relu层和softmax归一化层组成,预测每个输入特征的

注意力权重,然后是输入特征的加权求和层。深度残差注意力网络减少了对外部信息的依赖,更擅长捕获特征的内部相关性。

[0023]

在本发明中,首先对于关系的多个隐藏语义特征是r1,r2,...,r

m

,每一个特征r

j

表示一个通道。如图1所示,第一个1

×

1卷积层实现跨信道交互和信息整合,这一步捕获概念之间内在的相关性。relu激活函数增加了模型的非线性和表达能力。第二层1

×

1卷积层将通道数减小到1,然后通过softmax函数生成注意力权重图m

r

。softmax操作将注意力权重图的每个元素设置在0到1之间,这些元素和为1。最后通过输入特征的加权求和操作得到关系特征r,该过程表示为:

[0024][0025]

其中,表示对应元素的乘积。

[0026]

通过深度残差注意力网络生成关系嵌入向量然后将关系嵌入向量对实体的每个语义特征进行联合注意操作。与实体关系的联合注意力过程表示为:

[0027][0028]

其中,σ表示sigmoid非线性激活函数。表示关系对实体联合注意力操作之后的实体特征表示。

[0029]

在关系对实体进行联合注意力过程后,对实体嵌入向量上进行深度残差注意力网络,过程与关系一样。实体通过深度残差注意力网络,生成实体特征向量实体的权值求和过程表示为:

[0030][0031]

接下来,将gate结构引入到的模型中,以优化关系的特征表示。gate结构是lstm的核心机制,在许多应用中被发现非常成功。gate是一种选择性地让信息通过的方法。如图1中的模块所示,gate由具有sigmoid激活功能的层和hadamard product操作层组成。gate结构表示为:

[0032][0033]

b,w表示偏差和权重矩阵。[;]表示向量拼接操作。sigmoid操作将f的每个元素设置在0到1之间,描述应该允许通过多少信息。然后,一个gate使用hadamardproduct来过滤信息,如公式(6)所示:

[0034][0035]

步骤三:去噪网络

[0036]

本步骤将引入去噪网络优化实体嵌入和关系嵌入接下来先简述去噪网络的结构。假设m=(m1,m2,m3,...,m

l

)

t

是特征向量。对特征元素间进行差分操作之后投射到一个新的向量n=(n1,n2,n3,...,n

z

)

t

。n中的每个元素计算如下:

[0037]

[0038]

其中,i,j∈[1,l],k∈[1,z],是可学习的参数。公式(7)写成矩阵形式为:

[0039]

n

k

=m

t

w

(k)1‑

m

t

(w

(k)

)

t1ꢀꢀꢀ

(8)

[0040]

其中,w

(k)

∈r

l

×

l

是可学习的参数,1∈r

l

是全1向量。

[0041]

其中n

k

是向量n里的一个特征元素,因此在向量n中这个权值参数为w∈r

l

×

l

×

z

。而对于三阶张量会引入参数爆炸的问题的同时,加重训练负担,因此引入张量分解。

[0042][0043]

其中,u

s

∈r

l

×

z

和v

s

∈r

l

×

z

是权值参数;s是超参数;是hadamard乘积。

[0044]

最终,向量n∈r

z

表示为:

[0045][0046]

因此,把从m到n的映射过程表示为去噪过程,表示为:

[0047]

n=dn(m)

ꢀꢀꢀ

(11)

[0048]

最后,实体和关系通过去噪网络之后表示为:

[0049][0050][0051]

步骤四:多步融合

[0052]

本步骤引入多步融合的过程来充分融合实体和关系,多步融合过程表示为:

[0053][0054]

其中,τ是softmax函数。w1和w2是可学习的映射参数矩阵。conv(x,y)函数表示在2019年hyper模型引入的卷积方法,即把x当作特征图,y重构成卷积核的形式进行卷积的操作。

[0055]

步骤五:打分函数

[0056]

本发明的知识图谱嵌入的打分函数表示为:

[0057][0058]

其中,conv()是卷积操作,是深度残差注意力网络,vec

‑1是向量到矩阵的映射操作。

[0059]

对于训练过程,使用adam优化器来最小化交叉熵损失函数。

[0060]

与现有技术相比较,虽然现有的方法取得了很大的进展,但仍存在一些具有挑战性的问题。比如实体或关系的多重语义问题。事实上,大多数实体或关系在实践中有许多不同的语义。例如,实体apple在不同的三元组(apple,taste,delicious)和(apple,software,ios)中明显表达了不同的语义,那么不同的语义在嵌入空间里应该具有不同的特征表示。然而,在目前的方法中,由于一个实体在嵌入空间中通常只有一个表示形式,所以很难处理这种情况。而本发明能够学习多种特征向量来表达多种不同的语义。同时本发明提出来的深度残差注意力网络,能有效减少引入多个隐藏语义带来大量噪声的问题。同时去噪网络和多步融合网络能充分融合实体和关系,来得到最符合的预测结果。

附图说明

[0061]

图1:基于多语义学习的知识图谱补全研究主流程图。

[0062]

图2:基于多语义学习的知识图谱补全模型图。

具体实施方式

[0063]

以下结合附图和实施例对本发明进行详细说明。

[0064]

实验

[0065]

评估的模型在下列几个公共数据集上:

[0066]

表1.数据集列表.

[0067][0068]

wn18:是wordnet的子集,是一个包含单词之间的词汇关系的数据库。

[0069]

fb15k:是freebase的一个子集,是一个关于真实世界事实的大型数据库。

[0070]

wn18rr:是wn18的一个子集,由dettmers等人通过删除wn18的逆关系而创建。

[0071]

fb15k

‑

237:是由toutanova等人创建的,注意到fb15k和wn18的验证和测试集包含了训练集中存在许多的逆关系,对于简单的模型更有利。fb15k

‑

237是fb15k的一个子集,去掉了逆关系。

[0072]

1、评估指标

[0073]

本实验共采用4种评价标准对该知识图谱补全模型进行评估,分别为平均倒数秩(mrr),hit@10,hit@3,以及hit@1。平均倒数秩(mrr)取所有测试三元组中分配给真三元组的倒数秩的平均值。hit@k测量真实三元组出现在排名前k的三元组中的案例的百分比。总体而言,实验目标是实现高平均倒数秩(mrr)和hit@k。

[0074]

2、实验结果

[0075]

实验一:链路预测

[0076]

表2.在wn18rr和fb15k

‑

237数据集上的链路预测

[0077][0078]

表3.在wn18和fb15k数据集上的链路预测结果

[0079][0080]

实验二:不同关系下实验性能

[0081]

表4.wn18rr中不同关系的数量和性能

[0082]

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1