基于数据融合与特征选择的遥感影像多尺度目标检测方法与流程

1.本发明涉及遥感影像目标检测技术领域,具体涉及一种基于数据融合与特征选择的遥 感影像多尺度目标检测方法。

背景技术:

2.基于深度学习的遥感影像目标检测算法存在样本不均衡问题,同时,在多任务遥感影 像目标检测中,存在着各种尺度大小不一的检测对象,而模型对于地物尺度的泛化性是有 一定限度的,因此样本不均衡和遥感影像尺度的多样性给目标检测任务带来了极大的挑 战。

3.为了减轻由样本不均衡带来的负面影响,pang j等人提出了一个简单而有效的平衡学 习目标检测框架libra r

‑

cnn。它集成了三个新的组成部分:iou均衡采样、均衡特征金字 塔和均衡l1损失函数,分别用于减少样本、特征和目标层次上的不均衡。shrivastava a等 提出一种通过“在线难例挖掘”(ohem)的方法来选择一些难以预测的样本作为训练的样本 从而改善因为样本数目不平衡而导致检测效果差的问题。cao y等人提出了一种简单而有 效的抽样和学习策略(pisa),它将训练过程的重点指向由基本样本中选出的重要样本,训 练时聚焦于原始样本更有效。图像金字塔尺度归一化(snip)训练方案根据图像尺度的变 化有选择地反向传播不同大小目标实例的梯度。

4.光学遥感影像存在着大量不同尺度和小样本目标,多尺度特征融合可以有效提高小目 标和不同目标的检测效果。ssd算法通过将vgg16的多个不同尺寸特征图共同进行目标框 的回归进行不同尺度的预测,最终在小目标的预测效果上优于其他单阶段网络。fpn网络 在faster rcnn框架的基础上,提出了特征层融合的自上而下结构,该结构能有效提取图 片的不同尺度特征信息。由于遥感影像本身存在着各种尺度的目标,多尺度融合结构在遥 感目标检测取得了优秀的效果,同时该结构成为最为常用的多尺度特征提取网络。yolo v2、 yolo v3在后续的改进中也加入了多尺度提高检测精度。而retinanet模型则采用fpn作为 特征提取网络,提出focal loss损失函数来减轻正负样本对精度的影响,panet网络则在fpn 的基础上新增了一个自底向上的融合结构。

5.以上虽然在遥感影像目标检测中取得了很大的进步,但是依然存在以下缺点:

6.1、首先,以上针对于样本不均衡在网络结构上的改进的解决方法并不能普遍适用于 所有的目标检测框架。

7.2、其次,常用的多尺度方法在遥感影像上虽然能够顾及不同尺度的目标信息,但不 同尺度的特征层并不是对每一种尺度的目标信息都能够很好的反映,常用多尺度方法在各 个特征图上识别所有尺寸的目标,导致特征信息较弱的目标识别效果差。

8.综上所述,急需一种基于数据融合与特征选择的遥感影像多尺度目标检测方法以解决 现有技术中存在的问题。

技术实现要素:

9.本发明目的在于提供一种基于数据融合与特征选择的遥感影像多尺度目标检测方法, 旨在解决样本不均衡和遥感影像尺度的多样性给目标检测任务带来了极大的挑战的问题, 具体技术方案如下:

10.一种基于数据融合与特征选择的遥感影像多尺度目标检测方法,包括以下步骤:

11.步骤s1:获取训练集,对整个训练集中各类别存在的边界框数量进行统计;

12.步骤s2:通过数据融合增强补齐训练集中各类别的边界框数量差,使训练集中各类别 的边界框数量达到均衡,得到最终的用于模型训练的训练集;

13.步骤s3:将步骤s2处理后的训练集采用foveabox网络进行训练,将不同尺寸的目标 在不同的尺度特征图上进行目标识别。

14.以上技术方案中优选的,所述步骤s1中,对遥感影像目标检测数据集按比例划分为训 练集和测试集。

15.以上技术方案中优选的,所述步骤s2中数据融合增强具体为:

16.步骤s2.1:取一张需要增强类别的待增强影像,再取一张不包含任何目标的背景影像, 获取待增强影像和背景影像两者中的最大高h和最大宽w;

17.步骤s2.2:创建一个高为h、宽为w、通道数为3且像素值为0的融合影像;

18.步骤s2.3:将融合影像与待增强影像融合得到融合了待增强影像后的融合影像,将融 合了待增强影像的融合影像与背景影像进行融合得到最终的融合影像。

19.以上技术方案中优选的,步骤s2.3中,根据式(1)将融合影像与待增强影像融合得 到融合了待增强影像后的融合影像,根据式(2)将融合了待增强影像的融合影像与背景 影像进行融合得到最终的融合影像;

[0020][0021][0022]

其中,表示矩阵按对应坐标相加,

×

表示矩阵相乘;系数θ为人为设置的[0,1]的 常数;i表示待增强影像;v表示融合前的融合影像;m表示融合了待增强影像后的融合 影像;p

k

表示背景影像;v代表最终的融合影像。

[0023]

以上技术方案中优选的,所述步骤s3具体为:

[0024]

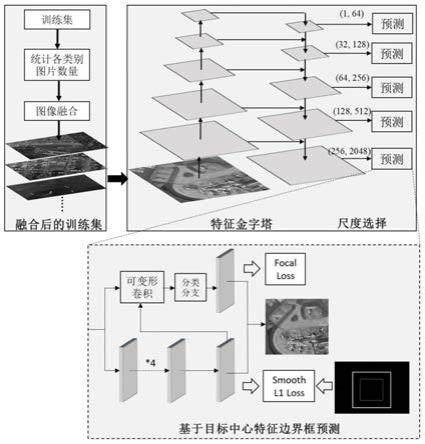

步骤s3.1:经过步骤s2后得到的训练集采用foveabox网络进行训练,训练集中的训 练图片经过fpn特征提取网络得到多个不同尺度大小的特征图;

[0025]

步骤s3.2:各个特征图分别选择多个不同边界框面积范围的目标进行预测,使得不同 尺度的特征图能够预测不同大小的目标,并且一个目标能够根据面积在多个特征图上预 测;

[0026]

步骤s3.3:特征图经过分类分支和边界框分支训练,分类分支使用focal loss损失函 数进行训练,边界框分支使用smooth l1 loss损失函数进行训练;训练完成后,模型的分 类分支和边界框分支分别预测特征图中目标的类别和边界框得到最终输出结果。

[0027]

以上技术方案中优选的,在边界框分支训练的过程中,采用小于真实边界框的区域进 行训练。

[0028]

以上技术方案中优选的,步骤s3.1中,训练集中的训练图片经过fpn特征提取网络得 到5个不同尺度大小的特征图。

[0029]

以上技术方案中优选的,步骤s3.2中,5个不同尺度的特征图分别选择((1,64), (32,128),(64,256),(128,512),(256,2048))边界框像素面积范围的目标进行预测。

[0030]

应用本发明的技术方案,具有以下有益效果:

[0031]

为了解决样本数目不均衡的问题,提出一种基于图像融合的数据增强策略,通过图像 融合增强(即数据融合增强)提高了样本库的多样性,能减轻类别不均衡的影响,模型训 练的结果泛化性更好;其次,在光学遥感影像上采用foveabox进行多尺度目标检测的特征 表达与选择,通过利用适合尺度的特征图来识别相应尺度的目标,同时允许同一尺度目标 在相邻的特征图上进行预测;多尺度特征表达与选择和数据融合增强两种方法结合可以应 对遥感影像中相对复杂背景的影像,减轻类别不均衡的影响,更加符合遥感影像使用的场 景,提升模型的性能,提高了在遥感影像中不同尺度目标识别的效果。

[0032]

本发明提出的图像融合增强是在数据层面进行样本不均衡处理,能适用于所有目标检 测框架,解决现有的方法不能普遍适用于所有的目标检测框架的问题。另外,本发明使用 的特征表达与选择的多尺度网络在不同尺度的特征图上预测不同大小的目标,充分利用不 同特征层包含的目标特征更好地进行目标识别,解决常用的多尺度方法在各个特征图上识 别所有尺寸的目标,导致特征信息较弱的目标识别效果差的问题。

[0033]

除了上面所描述的目的、特征和优点之外,本发明还有其它的目的、特征和优点。下 面将参照图,对本发明作进一步详细的说明。

附图说明

[0034]

构成本技术的一部分的附图用来提供对本发明的进一步理解,本发明的示意性实施例 及其说明用于解释本发明,并不构成对本发明的不当限定。在附图中:

[0035]

图1是本发明方法的处理流程示意图;

[0036]

图2a是图像融合前的原始图像;

[0037]

图2b是图像融合前的背景影像一;

[0038]

图2c是图像融合前的背景影像二;

[0039]

图2d是图像融合前的背景影像三;

[0040]

图3a是图2a未进行融合后效果图;

[0041]

图3b是图2a与图2b融合后的效果图;

[0042]

图3c是图2a与图2c融合后的效果图;

[0043]

图3d是图2a与图2d融合后的效果图;

[0044]

图4是基于目标中心区域的候选框预测的示意图;

[0045]

图5a是测试集测试结果可视化中场景一的真实标注;

[0046]

图5b是测试集测试结果可视化中场景二的真实标注;

[0047]

图5c是测试集测试结果可视化中场景三的真实标注;

[0048]

图5d是测试集测试结果可视化中场景四的真实标注;

[0049]

图6a是图5a采用fpn网络预测的结果;

[0050]

图6b是图5b采用fpn网络预测的结果;

[0051]

图6c是图5c采用fpn网络预测的结果;

[0052]

图6d是图5d采用fpn网络预测的结果;

[0053]

图7a是图5a采用retinanet预测的结果;

[0054]

图7b是图5b采用retinanet预测的结果;

[0055]

图7c是图5c采用retinanet预测的结果;

[0056]

图7d是图5d采用retinanet预测的结果;

[0057]

图8a是图5a采用foveabox预测的结果;

[0058]

图8b是图5b采用foveabox预测的结果;

[0059]

图8c是图5c采用foveabox预测的结果;

[0060]

图8d是图5d采用foveabox预测的结果;

[0061]

图9a是图5a采用foveabox和数据融合增强结合的预测结果;

[0062]

图9b是图5b采用foveabox和数据融合增强结合的预测结果;

[0063]

图9c是图5c采用foveabox和数据融合增强结合的预测结果;

[0064]

图9d是图5d采用foveabox和数据融合增强结合的预测结果。

具体实施方式

[0065]

为了便于理解本发明,下面将对本发明进行更全面的描述,并给出了本发明的较佳实 施例。但是,本发明可以以许多不同的形式来实现,并不限于本文所描述的实施例。相反 地,提供这些实施例的目的是使对本发明的公开内容的理解更加透彻全面。

[0066]

除非另有定义,本文所使用的所有的技术和科学术语与属于本发明的技术领域的技术 人员通常理解的含义相同。本文中在本发明的说明书中所使用的术语只是为了描述具体的 实施例的目的,不是旨在于限制本发明。

[0067]

实施例1:

[0068]

参见图1,一种基于数据融合与特征选择的遥感影像多尺度目标检测方法,包括以下 步骤:

[0069]

步骤s1:获取训练集,对整个训练集中各类别存在的边界框数量进行统计;

[0070]

优选的,所述步骤s1中,对遥感影像目标检测数据集按8:2的比例划分为训练集和测 试集,其中训练集用于步骤s1中的处理,测试集用于后续的精度测试。

[0071]

步骤s2:通过数据融合增强补齐训练集中各类别的边界框数量差,使训练集中各类别 的边界框数量达到均衡(即数量达到一致),得到最终的用于模型训练的训练集;

[0072]

参见图2a

‑

图3d,所述步骤s2中数据融合增强具体为:

[0073]

步骤s2.1:取一张需要增强类别的待增强影像i,再取一张不包含任何目标的背景影 像p

k

,获取待增强影像和背景影像两者中的最大高h和最大宽w;

[0074]

即:h=max(h

i

,h

k

),w=max(w

i

,w

k

),其中h

i

、w

i

分别表示待增强影像的高和宽,h

k

、 w

k

分别表示背景影像的高和宽;

[0075]

步骤s2.2:创建一个高为h、宽为w、通道数为3且像素值为0的融合影像v,即: v=zero(h,w,3);

[0076]

步骤s2.3:根据式(1)将融合影像与待增强影像融合得到融合了待增强影像后的融 合影像m,根据式(2)将融合了待增强影像的融合影像与背景影像进行融合得到最终的 融合影像v;

[0077]

[0078][0079]

其中,表示矩阵按对应坐标相加,

×

表示矩阵相乘;系数θ为人为设置的[0,1]的 常数;i表示待增强影像;v表示融合前的融合影像;m表示融合了待增强影像后的融合 影像;p

k

表示背景影像;v代表最终的融合影像。

[0080]

步骤s3:将步骤s2处理后的训练集采用foveabox网络进行训练,将不同尺寸的目标 在不同的尺度特征图上进行目标识别。

[0081]

优选的,所述步骤s3具体为:

[0082]

步骤s3.1:经过步骤s2后得到的训练集采用foveabox网络进行训练,训练集中的训 练图片经过fpn特征提取网络(即fpn特征金字塔网络)得到多个不同尺度大小的特征图;

[0083]

步骤s3.2:各个特征图分别选择多个不同边界框面积范围的目标进行预测,使得不同 尺度的特征图能够预测不同大小的目标,并且一个目标能够根据面积在多个特征图上预 测;

[0084]

步骤s3.3:特征图经过分类分支和边界框分支训练,分类分支使用focal loss损失函 数进行训练,边界框分支使用smooth l1 loss损失函数进行训练;训练完成后,模型的分 类分支和边界框分支分别预测特征图中目标的类别和边界框得到最终输出结果。

[0085]

优选的,在边界框分支训练的过程中,采用小于真实边界框的区域进行训练;如图4 所示,亮色框为训练时使用的监督训练边界框,暗色框为真实标注边界框,用小于真实边 界框的区域模型能学习更具代表性的特征,使得模型鲁棒性得到提升。

[0086]

本实施例中优选的,步骤s3.1中,训练集中的训练图片经过fpn特征提取网络得到5 个不同尺度大小的特征图。

[0087]

本实施例中优选的,步骤s3.2中,5个不同尺度的特征图分别选择((1,64),(32,128), (64,256),(128,512),(256,2048))边界框像素面积范围的目标进行预测。

[0088]

参见图5a

‑

图9d,本实施例还提供了本实施例中的方法与常用的fpn、retinanet、 foveabox等方法处理四个场景的案例对比。

[0089]

nwpuvhr10数据集划分出测试集后,采用本实施例的方法与fpn、retinanet、foveabox 等方法在测试集上进行测试精度的对比,具体对比结果如表1。

[0090]

表1.测试精度对比表

[0091]

[0092]

由图5a

‑

图9d以及表1可知,采用foveabox网络和数据融合增强结合的方式(即表1 中的foveabox&fusion项)相比于fpn、retinanet、foveabox(fpn、retinanet、foveabox 均为常用的多尺度网络的名称)平均精度分别提高了6.84%、7.17%、4.78%,采用影像融 合和特征选择与表达的网络后的船舶、棒球场、网球场、篮球场、港口、桥梁和车辆类别 精度都得到提升。

[0093]

从图5a

‑

图9d的可视化结果可以看出,加入图像融合增强(即数据融合增强)的多尺 度选择与表达的模型在飞机类别、船舶、海港、车辆类别上面相对于其他的多尺度网络有 更好的识别效果,特别是在网球场、车辆等类别上降低了误检测率,在岸边包含船舶的影 像,fpn、retinanet以及foveabox很难将河岸和船舶很好地区分开,而采用foveabox与 数据融合增强结合的方法对复杂背景下的目标的识别也相对更加准确。

[0094]

结果表明,图像融合增强(即数据融合增强)能够消除训练数据中类别不均衡的问题, 在不使用数据融合增强的foveabox方法与结合图像融合增强的foveabox方法的对比可以 看出图像融合增强的有效性,对模型的性能以及鲁棒性都有提升。

[0095]

综上所述,图像融合增强了样本场景的多样性,并且在遥感影像上采用多尺度特征选 择与表达的结果整体表明在光学遥感影像中不同尺度大小的目标都能够合理的预测出来。

[0096]

以上所述仅为本发明的优选实施例而已,并不用于限制本发明,对于本领域的技术人 员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、 等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1