一种基于多模态人脸训练的单模态人脸活体检测方法

1.本发明涉及计算机视觉领域,尤其涉及一种基于多模态人脸训练的单模态人脸活体检测方法。

背景技术:

2.人脸活体检测是人脸识别任务中非常重要的一部分,它可以确保人脸识别在某些关键的商业或安全场景中的可靠性,例如人脸扫描付款和人脸扫描解锁。由于对面部识别的攻击类型迅速增加,因此研究人员认为,单模态人脸活体检测抵抗攻击的能力较弱。幸运的是,多模态人脸图像可以提供附加和补充的信息,从而可以大大提高人脸活体检测的鲁棒性。具体而言,基于打印的2d攻击在深度模态中非常容易区分,但是在可见光模态中则很难区分。

3.但是,多模态人脸活体检测有以下局限性,使其无法在某些应用场景中广泛使用。1)难以获得多模态的人脸图像。每个模态都需要一个相应的传感器来捕获。近红外和深度信息传感器的高昂成本使其很难获得近红外和深度模态数据。2)多模态传感器难以集成,并且广泛部署在移动终端上。另外,基于单一模态的方法在训练阶段无法使用其他模态的数据,这导致模态之间互补信息的丢弃,进而导致性能较弱。

技术实现要素:

4.为了解决上述问题,本发明的目的是提供一种基于多模态人脸训练的单模态人脸活体检测方法,提高了传统单模态人脸活体检测模型性能的同时,还降低了实际场景下的硬件成本。

5.本发明所采用的技术方案是:一种基于区块链的个人征信信息管理方法,包括以下步骤:

6.s1、获取输入数据并基于输入数据训练预构建的生成对抗网络,得到训练完成的生成对抗网络,所述预构建的生成对抗网络包括生成器和判别器;

7.s3、基于训练完成的生成对抗网络合成数据集并训练类多模态人脸活体检测模型,得到训练完成的类多模态人脸活体检测模型;

8.s4、获取单模态待测图像;

9.s5、基于生成对抗网络将单模态待测图像扩展为多模态人脸图像,并输入至练完成的多模态人脸活体检测模型进行判别,得到检测结果。

10.进一步,所述获取输入数据并基于输入数据训练预构建的生成对抗网络,得到训练完成的生成对抗网络这一步骤,其具体包括:

11.获取输入数据并对输入数据中的原始人脸图片进行尺寸调整,所述输入数据中的原始人脸图片中可见光信息、近红外信息和深度信息的图片数量比设置为1:1:1;

12.基于输入数据对生成对抗网络中的生成器和判别器进行交替训练;

13.固定判别器,训练生成器,得到训练完成的生成器;

14.固定生成器,训练判别器,得到训练完成的判别器;

15.得到训练完成的生成对抗网络。

16.进一步,所述生成器包括第一特征粗提取单元、下采样特征提取单元、隐层特征学习单元、上采样特征提取单元和目标图像生成单元,所述固定判别器,训练生成器,得到训练完成的生成器这一步骤,其具体包括:

17.对于输入数据中的原始人脸图片及其原始模态标签,随机给定一个目标模态标签并以独热编码的形式编码;

18.将目标模态标签重复拓展为原始人脸图片的尺寸大小,并与原始人脸图片进行拼接,得到整合数据;

19.将整合数据经过特征粗提取单元处理,维持整合数据的大小尺寸不变,将通道数扩展为64维,得到第一特征图;

20.基于下采样特征提取单元对第一特征图进行处理,扩展通道数,得到第二特征图;

21.基于隐层特征学习单元对第二特征图进行处理,生成残差特征并相加,得到第三特征图;

22.基于上采样特征提取单元对第三特征图进行处理,压缩通道数,得到第四特征图;

23.基于目标图像生成单元对第四特征图进行处理,将通道数压缩为3维生成第五特征图并将第五特征图中的数值归一化,得到生成人脸;

24.将生成人脸和原始模态标签送入生成器,得到生成人脸在原始模态标签下的重构人脸;

25.采用l1正则化约束重构人脸和原始人脸图片的距离;

26.基于判别器对生成人脸进行判别,得到判别结果;

27.基于对抗损失函数优化生成器和判别器之间的损失误差,得到训练完成的生成器。

28.进一步,所述判别器包括第二特征粗提取单元、特征细提取单元、第一判别分支和第二判别分支,所述固定生成器,训练判别器,得到训练完成的判别器这一步骤,其具体包括:

29.将原始人脸图片经过生成器得到对应的其他模态下的生成图片;

30.将原始人脸图片和生成图片送入判别器,经过第二特征粗提取单元将通道数由3维拓展为64维,得到粗提取特征图;

31.基于特征细提取单元对粗提取特征图进行处理,缩减输入特征,得到细提取特征图;

32.基于第一判别分支对细提取特征图进行处理,映射得到真假判别输出并用于判别器和生成器的对抗学习;

33.基于第二判别分支对细提取特征图进行处理,映射得到模态判别输出并用于判别器的学习;

34.得到训练完成的判别器。

35.进一步,所述类多模态人脸活体检测模型由三个结构相同的特征提取分支构成,每个特征提取分支包括特征自适应第一单元、低阶特征学习单元、中阶特征学习单元、高阶特征学习单元和特征自适应第二单元组成。

36.进一步,所述基于训练完成的生成对抗网络合成数据集并训练类多模态人脸活体检测模型,得到训练完成的类多模态人脸活体检测模型这一步骤,其具体包括:

37.选择输入数据中单一模态人脸图像输入至训练完成的生成对抗网络,生成对应其他模态下的人脸图像,得到合成数据集;

38.基于特征自适应第一单元对合成数据集中的图像进行处理,扩展通道数,得到输入特征;

39.将输入特征依次送入低阶特征学习单元、中阶特征学习单元和高阶特征学习单元,减少特征尺寸,得到低阶特征、中阶特征和高阶特征;

40.将低阶特征、中阶特征和高阶特征按通道拼接,得到的融合特征图;

41.基于特征自适应第二单元对融合特征图进行处理,得到输出特征图;

42.将三个特征提取分支的输出特征图按通道数进行拼接和特征融合,得到最终特征图;

43.基于均方误差损失函数约束最终特征图与目标标签之间的距离,得到训练完成的类多模态人脸活体检测模型。

44.进一步,所述基于生成对抗网络将单模态待测图像扩展为多模态人脸图像,并输入至练完成的多模态人脸活体检测模型进行判别,得到检测结果这一步骤,其具体包括:

45.基于生成对抗网络对待测单模态人脸图像进行处理,得到对应的模态下生成模态人脸图像;

46.将待测单模态人脸图像和生成模态人脸图像送入类多模态人脸活体检测模型,得到活体类别概率;

47.判断到活体类别概率低于预设阈值,将该待测单模态人脸图像判定为假体人脸图像。

48.本发明方法的有益效果是:本发明首先利用多模态的人脸数据训练一个生成器和判别器实现多个模态人脸之间的相互转换和生成,其次,在我们只使用某一种模态的人脸和训练得到的生成器,合成其在其他模态下的图片,并送入类多模态活体检测网络中进行训练。在测试阶段,我们仅用训练收敛的生成器和类多模态活体检测器实现单模态活体检测任务,有效且降低了实际场景下的硬件成本。

附图说明

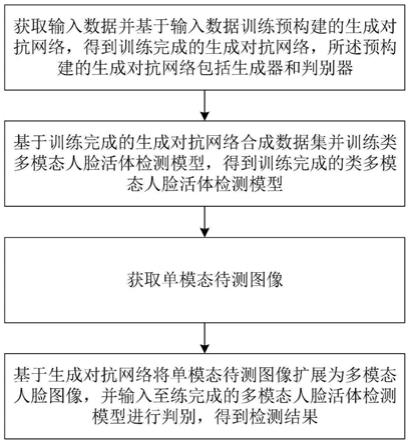

49.图1是本发明一种基于多模态人脸训练的单模态人脸活体检测方法的流程示意图;

50.图2是本发明具体实施测试过程的示意图。

具体实施方式

51.下面结合附图和具体实施例对本发明做进一步的详细说明。对于以下实施例中的步骤编号,其仅为了便于阐述说明而设置,对步骤之间的顺序不做任何限定,实施例中的各步骤的执行顺序均可根据本领域技术人员的理解来进行适应性调整。

52.参照图1和图2,本发明提供了一种基于多模态人脸训练的单模态人脸活体检测方法,包括以下步骤:

53.s1、获取输入数据并基于输入数据训练预构建的生成对抗网络,得到训练完成的生成对抗网络,所述预构建的生成对抗网络包括生成器和判别器;

54.s3、基于训练完成的生成对抗网络合成数据集并训练类多模态人脸活体检测模型,得到训练完成的类多模态人脸活体检测模型;

55.s4、获取单模态待测图像;

56.s5、基于生成对抗网络将单模态待测图像扩展为多模态人脸图像,并输入至练完成的多模态人脸活体检测模型进行判别,得到检测结果。

57.进一步作为本方法的优选实施例,所述获取输入数据并基于输入数据训练预构建的生成对抗网络,得到训练完成的生成对抗网络这一步骤,其具体包括:

58.获取输入数据并对输入数据中的原始人脸图片进行尺寸调整,所述输入数据中的原始人脸图片中可见光信息、近红外信息和深度信息的图片数量比设置为1∶1∶1;

59.具体地,每张图片的大小均为(c0=3,h0=256,w0=256),故输入数据的总体尺寸为(n,c0,h0,w0)。

60.基于输入数据对生成对抗网络中的生成器和判别器进行交替训练;

61.固定判别器,训练生成器,得到训练完成的生成器;

62.固定生成器,训练判别器,得到训练完成的判别器;

63.得到训练完成的生成对抗网络。

64.进一步作为本方法的优选实施例,所述生成器包括第一特征粗提取单元、下采样特征提取单元、隐层特征学习单元、上采样特征提取单元和目标图像生成单元,所述固定判别器,训练生成器,得到训练完成的生成器这一步骤,其具体包括:

65.对于输入数据中的原始人脸图片及其原始模态标签,随机给定一个目标模态标签并以独热编码的形式编码;

66.将目标模态标签重复拓展为原始人脸图片的尺寸大小,并与原始人脸图片进行拼接,得到整合数据;

67.具体地,尺寸大小(1,c

modal

=3,h0,w0),其中c

modal

代表了本任务中一共存在的人脸模态个数。

68.将整合数据经过特征粗提取单元处理,维持整合数据的大小尺寸不变,将通道数扩展为64维,得到第一特征图;

69.具体地,将输入数据经过一个由“卷积层

→

实例归一化层

→

relu激活层”组成的特征粗提取单元,其中卷积层的卷积核大小为7

×

7,padding大小为3,卷积滑动步长为1。该单元维持输入数据的大小尺寸不变,将通道数扩展为64维,即得到尺寸为(n,64,h0,w0)的特征图。

70.基于下采样特征提取单元对第一特征图进行处理,扩展通道数,得到第二特征图;

71.具体地,将上一步得到的特征图经过由两个串联的可学习下采样块组成的下采样特征提取单元,其中每个可学习下采样块均由“卷积层

→

实力归一化层

→

relu激活层”组成,其中卷积核的大小为4

×

4,padding大小为1,卷积滑动步长为2。每一个下采样块使得输入特征的大小尺寸减半,将通道数扩展为2倍,即经过下采样特征提取单元后得到尺寸为(n,256,h0/4,w0/4)的特征图。

72.基于隐层特征学习单元对第二特征图进行处理,生成残差特征并相加,得到第三

特征图;

73.具体地,将上一步得到的特征图经过由六个串联的残差块组成的隐层特征提取单元,其中每个残差块具有相同的结构,且在隐层特征学习的过程中,不会改变特征的大小和通道数。每个残差块均由“卷积层

→

实例归一化层

→

relu激活层

→

卷积层

→

实例归一化层”组成,在前向计算过程中,输入特征先通过上述模块得到残差特征,再将原始输入特征和残差特征逐元素相加输出特征,经过隐层特征学习单元后,特征图的尺寸大小为(n,256,h0/4,w0/4);

74.基于上采样特征提取单元对第三特征图进行处理,压缩通道数,得到第四特征图;

75.具体地,将上一步得到的特征图经过由两个串联的可学习上采样块组成的上采样特征提取单元,其中每个可学习上采样块的结构均为“反卷积层

→

实力归一化层

→

relu激活层”,每一个上采样块使得输入特征的大小尺寸翻倍,将通道数压缩为一半,即经过下采样特征提取单元后得到尺寸为(n,64,h0,w0)的特征图;

76.基于目标图像生成单元对第四特征图进行处理,将通道数压缩为3维生成第五特征图并将第五特征图中的数值归一化,得到生成人脸;

77.具体地,将上一步得到的特征图经过由“卷积层

→

tanh激活层”组成的图像生成单元,其中卷积层的卷积核大小为7

×

7,padding大小为3,卷积滑动步长为1。该单元维持输入数据的大小尺寸不变,将通道数压缩为3维,即得到尺寸为(n,3,h0,w0)的特征图,然后我们将该特征图经过tanh激活函数进行处理,将特征图中的数值归一化到[

‑

1,1]区间中。至此,本方法实现了“生成器g生成一张原始人脸在目标模态下的生成人脸”;

[0078]

将生成人脸和原始模态标签送入生成器,得到生成人脸在原始模态标签下的重构人脸;

[0079]

采用l1正则化约束重构人脸和原始人脸图片的距离;

[0080][0081]

上式中,n代表一个batch内的训练人脸图片个数,x代表原始的输入人脸图片,m

s

,m

t

代表原始模态标签和目标模态标签,g代表生成器。

[0082]

基于判别器对生成人脸进行判别,得到判别结果;

[0083]

具体地,判别器需要将生成人脸分类到正确的模态类别中:

[0084][0085]

其中,d代表判别器。

[0086]

基于对抗损失函数优化生成器和判别器之间的损失误差,得到训练完成的生成器。

[0087]

具体地,生成器和判别器之间用对抗损失函数进行优化:

[0088][0089]

训练生成器时,网络的总损失函数为:

[0090]

l

g

=l

a

+λ

gc

l

gc

+λ

r

l

r

[0091]

其中,λ

gc

,λ

r

表示控制损失函数贡献的超参数。

[0092]

进一步作为本方法优选实施例,所述判别器包括第二特征粗提取单元、特征细提取单元、第一判别分支和第二判别分支,所述固定生成器,训练判别器,得到训练完成的判别器这一步骤,其具体包括:

[0093]

将原始人脸图片经过生成器得到对应的其他模态下的生成图片;

[0094]

具体地,当训练判别器,固定生成器时,将原始图片经过生成器得到其在其他模态下的生成图片,即此时判别器接收的输入图片尺寸为(n,c0,h0,w0);

[0095]

将原始人脸图片和生成图片送入判别器,经过第二特征粗提取单元将通道数由3维拓展为64维,得到粗提取特征图;

[0096]

具体地,将输入图片经过一个由“卷积层

→

leakyrelu激活层”组成的特征粗提取单元,其中卷积层的卷积核大小为4

×

4,padding大小为1,卷积滑动步长为2,leakyrelu的超参数设置为0.01,该特征粗提取单元将输入图片的大小减半,并将通道数由3维拓展为64维,即得到尺寸为(n,64,h0/2,w0/2)的特征图;

[0097]

基于特征细提取单元对粗提取特征图进行处理,缩减输入特征,得到细提取特征图;

[0098]

具体地,将上一步得到的特征图经过由六个串联的特征提取块组成的特征细提取单元,每个特征块的结构均是“卷积层

→

leakyrelu激活层”,其中卷积层的卷积核大小为4

×

4,padding大小为1,卷积滑动步长为2,leakyrelu的超参数设置为0.01,每个特征提取块都将输入特征的大小缩减为一半,并将特征通道数增加一倍,因此在经过特征细提取单元后,获得尺寸为(n,4096,h0/128,w0/128)的特征图;

[0099]

基于第一判别分支对细提取特征图进行处理,映射得到真假判别输出并用于判别器和生成器的对抗学习;

[0100]

基于第二判别分支对细提取特征图进行处理,映射得到模态判别输出并用于判别器的学习;

[0101]

具体地,然后,将上一步得到的特征图经过由两个并联的判别分支,其中一个判别分支由一层卷积层和一层可选的池化层组成,该卷积层的核大小为为3

×

3,padding大小为1,卷积滑动步长为1,该卷积层将输入特征映射为尺寸为(n,1,1,1)的真假判别输出,若得到的特征图大小不为1

×

1,则执行均值池化操作将其固定为1

×

1;该输出用于判别器和生成器的对抗学习中:

[0102][0103]

另一个判别分支亦由一层卷积层组成,该卷积层的核大小为当前特征图的宽和高以此确保卷积得到的尺寸为1

×

1,该卷积层将输入特征映射为尺寸为(n,c

modal

,1,1)的模态判别输出,该输出用于判别器将输入特征分类到正确的模态中,在判别器学习的阶段中,判别器需要将原始图片分类到正确的模态类别中:

[0104][0105]

得到训练完成的判别器。

[0106]

具体地,当训练判别器中,网络的总损失函数为:

[0107]

l

d

=

‑

l

a

+λ

rc

l

rc

[0108]

其中,λ

rc

是控制损失函数贡献的超参数。

[0109]

进一步作为本方法优选实施例,所述类多模态人脸活体检测模型由三个结构相同的特征提取分支构成,每个特征提取分支包括特征自适应第一单元、低阶特征学习单元、中阶特征学习单元、高阶特征学习单元和特征自适应第二单元组成。

[0110]

每个特征提取分支中的卷积层均为深度拉普拉斯卷积层对于一个输入特征f

in

,其输出结果为:

[0111][0112]

其中,为标准拉普拉斯算子,w

kernel

代表当前中的深度卷积核,代表卷积操作,θ=0.7代表两部分卷积操作所占的比重

[0113]

进一步作为本方法优选实施例,所述基于训练完成的生成对抗网络合成数据集并训练类多模态人脸活体检测模型,得到训练完成的类多模态人脸活体检测模型这一步骤,其具体包括:

[0114]

选择输入数据中单一模态人脸图像输入至训练完成的生成对抗网络,生成对应其他模态下的人脸图像,得到合成数据集;

[0115]

具体地,对于某个单模态下的人脸图像将其归一化到256

×

256,再通过生成器得到该图像在其他所有模态下的人脸图像

[0116]

基于特征自适应第一单元对合成数据集中的图像进行处理,扩展通道数,得到输入特征;

[0117]

具体地,将输入图片经过特征自适应第一单元,该单元由一个深度拉普拉斯卷积层组成,该单元维持特征图的大小不变,将其通道数拓展为64维,得到(n,64,256,256)的特征图。

[0118]

将输入特征依次送入低阶特征学习单元、中阶特征学习单元和高阶特征学习单元,减少特征尺寸,得到低阶特征、中阶特征和高阶特征;

[0119]

具体地,将输入特征以此送入低阶、中阶和高阶特征学习单元,每个特征学习单元均由三个深度拉普拉斯卷积层组成,其中低阶单元将特征尺寸减半,通道数加倍,故其特征输出为(n,128,128,128),中阶和高阶单元维持特征的通道数不变,将特征的尺寸一次减半,故特征输出分别为(n,128,64,64)和(n,128,32,32);

[0120]

将低阶特征、中阶特征和高阶特征按通道拼接,得到的融合特征图;

[0121]

具体地,将低阶特征和中阶特征进行池化操作使其特征图大小固定为(n,128,32,32),加下来我们将低阶、中阶和高阶的特征按通道拼接得到(n,384,32,32)的融合特征图;

[0122]

基于特征自适应第二单元对融合特征图进行处理,得到输出特征图;

[0123]

具体地,将融合特征图经过特征自适应第二单元,该单元由一个深度拉普拉斯卷积层组成,该单元维持特征图的大小不变,将其通道数压缩为128维,得到(n,128,32,32)的特征图。

[0124]

将三个特征提取分支的输出特征图按通道数进行拼接和特征融合,得到最终特征图;

[0125]

具体地,分别对三条模态提取支路进行相同的上述操作,得到三种模态下的特征图后,将三种特征按通道数进行拼接,整合为一个尺寸为(n,384,32,32)特征,对整合特征进行深度拉普拉斯卷积层操作实现特征融合,最后输出(n,1,32,32)大小的特征图

[0126]

基于均方误差损失函数约束最终特征图与目标标签之间的距离,得到训练完成的类多模态人脸活体检测模型。

[0127]

具体地,目标标签即数据集中自带的标签,在有监督任务中用于损失函数中的,为预先在数据集中设置好的。

[0128]

利用均方误差损失函数约束特征图与目标标签之间的距离足够接近:

[0129][0130]

其中,n代表输出特征中像素点的总个数,f

out

代表最后输出的特征图,gt代表特征图所对应的真实二值标签图。

[0131]

使用对比深度损失cdl来约束特征图与目标标签的细节信息足够相似,多模态人脸活体检测模型的整体损失函数为:

[0132]

l

fas

=l

m

+l

cdl

[0133]

进一步作为本方法优选实施例,所述基于生成对抗网络将单模态待测图像扩展为多模态人脸图像,并输入至练完成的多模态人脸活体检测模型进行判别,得到检测结果这一步骤,其具体包括:

[0134]

基于生成对抗网络对待测单模态人脸图像进行处理,得到对应的模态下生成模态人脸图像;

[0135]

将待测单模态人脸图像和生成模态人脸图像送入类多模态人脸活体检测模型,得到活体类别概率;

[0136]

判断到活体类别概率低于预设阈值,将该待测单模态人脸图像判定为假体人脸图像。

[0137]

一种基于多模态人脸训练的单模态人脸活体检测装置:

[0138]

至少一个处理器;

[0139]

至少一个存储器,用于存储至少一个程序;

[0140]

当所述至少一个程序被所述至少一个处理器执行,使得所述至少一个处理器实现如上所述一种基于多模态人脸训练的单模态人脸活体检测方法。

[0141]

上述方法实施例中的内容均适用于本装置实施例中,本装置实施例所具体实现的功能与上述方法实施例相同,并且达到的有益效果与上述方法实施例所达到的有益效果也相同。

[0142]

以上是对本发明的较佳实施进行了具体说明,但本发明创造并不限于所述实施例,熟悉本领域的技术人员在不违背本发明精神的前提下还可做作出种种的等同变形或替换,这些等同的变形或替换均包含在本技术权利要求所限定的范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1