基于情感匹配的电子音乐相册的生成方法

1.本公开涉及计算机技术领域,尤其涉及一种电子相册智能生成方法,具体涉及一种基于情感匹配的电子音乐相册的生成方法。

背景技术:

2.伴随着多媒体与互联网技术的飞速发展,由手工制作电子音乐相册的形式正逐渐被自动化的智能处理方式代替,相关技术中根据提示的情境选择配上滤镜或音乐,简化了用户的操作流程。

3.在实现本公开构思的过程中,发明人发现相关技术中至少存在如下问题:电子音乐相册的生成过多依赖服务器端提供的给定模板与模式,可选择的曲目数量较少且类型单一,在音视频的匹配上主要取决于用户对图像和音乐的手动筛选等。

技术实现要素:

4.有鉴于此,本公开要解决的技术问题在于提供一种基于情感匹配的电子音乐相册的生成方法,解决了相关技术中电子音乐相册的生成过多依赖服务器端提供的给定模板与模式的问题。

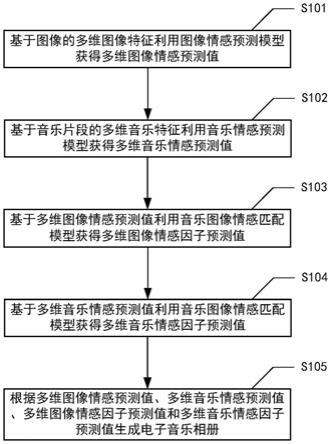

5.为了解决上述技术问题,本公开的具体实施方式提供一种基于情感匹配的电子音乐相册的生成方法,包括:基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值;基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值;基于多维图像情感预测值利用音乐图像情感匹配模型获得多维图像情感因子预测值;基于多维音乐情感预测值利用音乐图像情感匹配模型获得多维音乐情感因子预测值;根据多维图像情感预测值、多维音乐情感预测值、多维图像情感因子预测值和多维音乐情感因子预测值生成电子音乐相册。

6.本公开实施例的另一方面提供了一种电子设备,包括一个或多个处理器以及存储装置,其中,上述存储装置用于存储可执行指令,上述可执行指令在被上述处理器执行时,实现本公开实施例的方法。

7.本公开实施例的另一方面提供了一种计算机可读存储介质,存储有计算机可执行指令,上述指令在被处理器执行时用于实现本公开实施例的方法。

8.本公开的另一方面提供了一种计算机程序,上述计算机程序包括计算机可执行指令,上述指令在被执行时用于实现本公开实施例的方法。

9.根据本公开的实施例,建立多个情感因子与多维情感形容词之间的映射关系,然后基于图像和音乐的特征,构建情感特征子集,再采用机器学习算法基于情感特征子集与情感因子的关系构建情感预测模型,然后利用构建的情感预测模型和上述映射关系完成音视频匹配。可以至少部分地解决相关技术中电子音乐相册的生成过多依赖服务器端提供的给定模板与模式的问题,并因此可以实现提升音乐情感与图像情感匹配精准度的技术效果。

10.应了解的是,上述一般描述及以下具体实施方式仅为示例性及阐释性的,其并不能限制本公开所欲主张的范围。

附图说明

11.下面的所附附图是本公开的说明书的一部分,其绘示了本公开的示例实施例,所附附图与说明书的描述一起用来说明本公开的原理。

12.图1为本公开实施例提供的一种基于情感匹配的电子音乐相册的生成方法的整体示意流程图。

13.图2为本公开实施例提供的一种训练图像情感预测模型和音乐情感预测模型的示意流程图。

14.图3为本公开实施例提供的一种基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值的示意流程图。

15.图4为本公开实施例提供的一种基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值的示意流程图。

16.图5为本公开实施例提供的一种训练音乐图像情感匹配模型的示意流程图。

17.图6为本公开实施例提供的一种生成电子音乐相册的示意流程图。

18.图7为本公开实施例提供的一种将音乐分成多个音乐片段的示意流程图。

具体实施方式

19.为使本公开实施例的目的、技术方案和优点更加清楚明白,下面将以附图及详细叙述清楚说明本公开所揭示内容的精神,任何所属技术领域技术人员在了解本公开内容的实施例后,当可由本公开内容所教示的技术,加以改变及修饰,其并不脱离本公开内容的精神与范围。

20.本公开的示意性实施例及其说明用于解释本公开,但并不作为对本公开的限定。另外,在附图及实施方式中所使用相同或类似标号的元件/构件是用来代表相同或类似部分。

21.关于本文中所使用的“第一”、“第二”、

…

等,并非特别指称次序或顺位的意思,也非用以限定本公开,其仅为了区别以相同技术用语描述的元件或操作。

22.关于本文中所使用的方向用语,例如:上、下、左、右、前或后等,仅是参考附图的方向。因此,使用的方向用语是用来说明并非用来限制本创作。

23.关于本文中所使用的“包含”、“包括”、“具有”、“含有”等等,均为开放性的用语,即意指包含但不限于。

24.关于本文中所使用的“及/或”,包括所述事物的任一或全部组合。

25.关于本文中的“多个”包括“两个”及“两个以上”;关于本文中的“多组”包括“两组”及“两组以上”。

26.关于本文中所使用的用语“大致”、“约”等,用以修饰任何可以微变化的数量或误差,但这些微变化或误差并不会改变其本质。一般而言,此类用语所修饰的微变化或误差的范围在部分实施例中可为20%,在部分实施例中可为10%,在部分实施例中可为5%或是其他数值。本领域技术人员应当了解,前述提及的数值可依实际需求而调整,并不以此为限。

27.图1为本公开实施例提供的一种基于情感匹配的电子音乐相册的生成方法的整体示意流程图。

28.如图1所示,基于情感匹配的电子音乐相册的生成方法可以包括以下操作s101~s105:

29.在操作s101,基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值。

30.在本公开的实施例中,多维图像特征包括底层特征、高层特征以及关键区域特征等。底层特征主要包括主色调、颜色矩、颜色对比度、灰度共生矩阵、tamura特征等;高层特征包括美学特征和构图特征,美学特征和构图特征作为高层特征引入到图像特征提取算法中,其中美学特征包括图像的纹理复杂度、色彩复杂度、能量特征等;构图特征包括图像的三分法则、景深、动态特征等;关键区域特征算法主要经过图像显著性计算、显著区域提取、显著区域特征这3个步骤进行提取。图像情感预测模型为事先训练的模型。例如,图像情感值的维度可以为18,18维图像情感值可以对应18维图像情感形容词,18维图像情感形容词可以如下述表1所示。

31.表1

32.序号情感形容词序号情感形容词序号情感形容词1舒服7忧虑13温暖2大气8压抑14浪漫3孤独9梦幻15希望4消沉10恐惧16清新5快乐11伤感17温馨6轻松12阳光18失落

33.然后,在操作s102,基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值。

34.在本公开的实施例中,多维音乐特征可以包括节奏、频谱质心、谱对比度、mfcc(mel频率倒谱系数,mel frequency cepstrum coefficient,mfcc)、半音cqt(常数q变换,constant q transformas)谱、半音谱质心、短时平均过零率、频谱衰减等。音乐情感预测模型也为事先训练的模型。例如,音乐情感值的维度可以为18,18维音乐情感值可以对应18维音乐情感形容词,18维音乐情感形容词也可以为上述表1所示的情感形容词。本公开可以通过节拍位置将音乐划分为多个音乐片段。

35.接下来,在操作s103,基于多维图像情感预测值利用音乐图像情感匹配模型获得多维图像情感因子预测值。

36.在本公开的实施例中,音乐图像情感匹配模型是根据主观实验评价及因子分析确定的。多维图像情感因子预测值的维度可以为4。

37.其次,在操作s104,基于多维音乐情感预测值利用音乐图像情感匹配模型获得多维音乐情感因子预测值。

38.在本公开的实施例中,多维音乐情感因子预测值的维度与多维图像情感因子预测值的维度相同。如果多维图像情感因子预测值的维度为4,那么多维音乐情感因子预测值的维度也为4。

39.接下来,在操作s105,根据多维图像情感预测值、多维音乐情感预测值、多维图像情感因子预测值和多维音乐情感因子预测值生成电子音乐相册。

40.在本公开的实施例中,计算图像与音乐片段之间的欧式距离(即欧几里得距离),具体来说,计算图像对应的多维图像情感预测值,与音乐片段对应的多维音乐情感预测值之间的绝对值,计算图像对应的多维图像情感因子预测值,与音乐片段对应的多维音乐情感因子预测值之间的绝对值,然后给两个绝对值设置权重。如果每个绝对值与对应权重相乘后求和,得到的数值越小,说明该图像与该音乐片段之间的情感空间越接近。

41.在本公开的实施例中,提取图像的底层特征、高层特征以及关键区域特征等,提取与音乐属性有关的特征,如能量、旋律、音色、节奏、节拍、和声等。并基于欧氏距离最小原则将图像与音乐片段进行匹配,即将图像插入相应的音乐片段,实现更符合人类情感认知体系的电子音乐相册自动生成功能,提升音乐相册制作过程中的情感匹配准确性,增强用户体验。

42.图2为本公开实施例提供的一种训练图像情感预测模型和音乐情感预测模型的示意流程图。

43.如图2所示,在操作s102基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值之前,基于情感匹配的电子音乐相册的生成方法还可以包括以下操作s201:

44.在操作s201,基于图像特征训练集和图像特征测试集训练图像情感预测模型。

45.在本公开的实施例中,图像特征训练集用于调试图像情感预测模型的参数,图像特征测试集用于验证图像情感预测模型。

46.在操作s102基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值之前,基于情感匹配的电子音乐相册的生成方法还可以包括以下操作s202:

47.在操作s202,基于音乐特征训练集和音乐特征测试集训练音乐情感预测模型。

48.在本公开的实施例中,音乐特征训练集用于调试音乐情感预测模型的参数,音乐特征测试集用于测试音乐情感预测模型。

49.在本公开的实施例中,预先训练图像情感预测模型和音乐情感预测模型,可以提升音乐相册制作过程中的情感匹配准确性。

50.在本公开的实施例中,操作s201基于图像特征训练集和图像特征测试集训练图像情感预测模型可以包括以下操作:

51.将多个标准图像特征子集按照预定比例随机分为图像特征训练集和图像特征测试集;以及

52.根据图像特征训练集、图像特征测试集和多个图像因子值分别训练每个图像因子值对应的图像情感预测模型。

53.在本公开的实施例中,可以广泛搜集能够体现电子音乐相册情感的情感形容词,然后设计4组音乐mv(music video)/mad(movie、anime、drama+music video)视频作为素材,内容可以包括2007年后出品的电影电视剧情节剪辑和流行音乐原版mv,音乐语言可以包括中文、英语、日文和韩文等。可以选择多名(不少于15名,例如18名等)被试对该音视频内容激发的情感进行勾选,经过高频词筛选和主基底分析,最终可以保留多个(例如18个)情感形容词,最终保留的情感形容词可用于多维情感识别和匹配,可以参考上文的表1。可

以对如上文表1所示的18个图像情感形容词开展主观评价实验,获得18维图像情感值。例如,每个图像情感值用心理学量表中的1

‑

5级表示,1代表没有该情感,5代表非常强烈,经过归一化以后,这个数值将规范至0

‑

1之间,即可得到相应的图像情感值。采用因子分析法从情感描述的角度建立图像因子值与多维图像情感值之间的映射关系,由多维图像情感值可以得到多维图像因子值,例如,由18维图像情感值可以得到5维图像因子值;由多维图像因子值可以得到多维图像情感值,例如,可以由5维图像因子值得到18维图像情感值。

54.本公开可以参照iaps(国际情绪图片系统)和caps(中国情绪图片系统)的建立标准和原则,从色彩、人物、动物、建筑、自然风景等多方面进行均衡,建立多张(例如700张到1000张)且覆盖原始所有情感的图像数据库。从图像数据库中每个标准图像均体现每个图像情感形容词对应的图像情感值,将图像数据库中所有标准图像的特征分成多个标准图像特征子集,标准图像特征子集与图像因子值对应。其中,标准图像特征子集中的图像特征为降维后的图像特征。由于图像因子值与多维图像情感值之间具有映射关系,因此,可以获得标准图像特征子集与图像因子值之间的映射关系。

55.在本公开的实施例中,可以按照8:2的比例将多个标准图像特征子集随机分为图像特征训练集和图像特征测试集。

56.在本公开的实施例中,操作s202基于音乐特征训练集和音乐特征测试集训练音乐情感预测模型,可以包括以下操作:

57.将多个标准音乐特征子集按照预定比例随机分为音乐特征训练集和音乐特征测试集;以及

58.根据音乐特征训练集、音乐特征测试集和多个音乐因子值分别训练每个音乐因子值对应的音乐情感预测模型。

59.在本公开的实施例中,可以广泛搜集能够体现电子音乐相册情感的情感形容词,然后设计4组音乐mv(music video)/mad(movie、anime、drama+music video)视频作为素材,内容可以包括2007年后出品的电影电视剧情节剪辑和流行音乐原版mv,音乐语言可以包括中文、英语、日文和韩文等。可以选择多名(不少于15名,例如18名)被试对该音视频内容激发的情感进行勾选,经过高频词筛选和主基底分析,最终可以保留多个(例如18个)情感形容词,最终保留的情感形容词可用于多维情感识别和匹配,可以参考上文的表1。可以对如上文表1所示的18个音乐情感形容词开展主观评价实验,获得18维音乐情感值。例如,每个音乐情感值用心理学量表中的1

‑

5级表示,1代表没有该情感,5代表非常强烈,经过归一化以后,这个数值将规范至0

‑

1之间,即可得到相应的音乐情感值。采用因子分析法从情感描述的角度建立音乐因子值与多维音乐情感值之间的映射关系,由多维音乐情感值可以得到多维音乐因子值,例如,由18维音乐情感值可以得到4维音乐因子值;由多维音乐因子值可以得到多维音乐情感值,例如,可以由4维音乐因子值得到18维音乐情感值。

60.本公开可以广泛搜集类型多样且覆盖原始所有情感的音乐素材,建立至少包含多首(例如700首到1000首)音乐的音乐数据库。从音乐数据库中每首标准音乐片段均体现每个音乐情感形容词对应的音乐情感值,将音乐数据库中所有标准音乐片段的特征分成多个标准音乐特征子集,每个标准音乐特征子集与音乐因子值对应。由于音乐因子值与多维音乐情感值之间具有映射关系,因此,可以获得标准音乐特征子集与音乐因子值之间的映射关系。

61.在本公开的实施例中,可以按照8:2的比例将多个标准音乐特征子集随机分为音乐特征训练集和音乐特征测试集。

62.在本公开的实施例中,分别训练每个图像因子值对应的图像情感预测模型,分别训练每个音乐因子值对应的音乐情感预测模型,可以提升音乐相册制作过程中的情感匹配准确性,增强用户体验度。

63.图3为本公开实施例提供的一种基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值的示意流程图。

64.如图3所示,操作s101基于图像的多维图像特征利用图像情感预测模型获得多维图像情感预测值可以包括以下操作s1011~s1014:

65.在操作s1011,从图像的不同层次提取与情感描述有关的多维图像特征。

66.在本公开的实施例中,从图像的底层、高层和关键区域等提取与情感描述有关的多维图像特征。多维图像特征例如可以包括底层特征、高层特征以及关键区域特征等。其中,底层特征主要包括主色调、颜色矩、颜色对比度、灰度共生矩阵、tamura特征等;美学特征和构图特征可以作为高层特征引入到图像特征提取算法中,其中,美学特征可以包括图像的纹理复杂度、色彩复杂度、能量特征等,构图特征可以包括图像的三分法则、景深、动态特征等;关键区域特征主要通过图像显著性计算、显著区域提取、显著区域特征这3个步骤进行提取。

67.其次,在操作s1012,针对每个图像因子值对多维图像特征进行降维获得该图像因子值对应的图像情感特征子集。

68.在本公开的实施例中,在lasso(least absolute shrinkage and selection operator)回归与rf(随机森林)特征重要性的基础上对多维图像特征进行筛选、降维,获得该图像因子值对应的图像情感特征子集。对多维图像特征进行降维可以提高模型的泛化能力、降低学习的难度。

69.然后,在操作s1013,基于每个图像因子值对应的图像情感特征子集利用该图像因子值对应的图像情感预测模型获得该图像因子预测值。

70.在本公开的实施例中,每个图像因子值均对应一个图像情感特征子集,每个图像因子值均对应一个图像情感预测模型,将每个图像因子值对应的图像情感特征子集输入到该图像因子值对应的图像情感预测模型获得该图像因子预测值。可以利用mse(均方误差)和mae(平均绝对误差)作为图像情感预测模型的损失函数。

71.在本公开的实施例中,图像因子预测值可以用表示。例如,共有5个图像因子预测值,那么m为5。图像因子预测值可以解释多个(例如18个)图像情感形容词90%以上的信息量。

72.接下来,在操作s1014,基于所有图像因子预测值利用反变换公式获得多维图像情感预测值。

73.在本公开的实施例中,在获得图像因子预测值后,可以利用下面的反变换公式获得图像情感预测值。

[0074][0075]

上述公式中,上述公式中,为图像情感预测值。图像情感预测值代表图像情感预测模型所预测的图像在18个情感形容词上的激发程度,数值越大表示对应该情感形容词的情感越强烈。

[0076]

在本公开的实施例中,可以提高模型的泛化能力、降低学习的难度。还可以提升音乐相册制作过程中的情感匹配准确性,增强用户体验度。

[0077]

图4为本公开实施例提供的一种基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值的示意流程图。

[0078]

如图4所示,操作s102基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值可以包括以下操作s1021~s1024:

[0079]

在操作s1021,从多个角度提取与情感表达有关的音乐片段的多维音乐特征。

[0080]

在本公开的实施例中,多维音乐特征可以包括节奏、频谱质心、谱对比度、mfcc(mel频率倒谱系数,mel frequency cepstrum coefficient,mfcc)、半音cqt(常数q变换,constant q transformas)谱、半音谱质心、短时平均过零率和频谱衰减等。

[0081]

其次,在操作s1022,针对每个音乐因子值对多维音乐特征进行降维获得该音乐因子值对应的音乐情感特征子集。

[0082]

在本公开的实施例中,在本公开的实施例中,在lasso(least absolute shrinkage and selection operator)回归与rf(随机森林)特征重要性的基础上对多维音乐特征进行筛选、降维,获得该音乐因子值对应的音乐情感特征子集。对多维音乐特征进行

降维可以提高模型的泛化能力、降低学习的难度。

[0083]

接下来,在操作s1023,基于每个音乐因子值对应的音乐情感特征子集利用该音乐因子值对应的音乐情感预测模型获得该音乐因子预测值。

[0084]

在本公开的实施例中,在本公开的实施例中,每个音乐因子值均对应一个音乐情感特征子集,每个音乐因子值均对应一个音乐情感预测模型,将每个音乐因子值对应的音乐情感特征子集输入到该音乐因子值对应的音乐情感预测模型获得该音乐因子预测值。可以利用mse(均方误差)和mae(平均绝对误差)作为音乐情感预测模型的损失函数。

[0085]

在本公开的实施例中,音乐因子预测值可以用表示。例如,共有4个音乐因子预测值,那么n为4。音乐因子预测值可以解释多个(例如18个)音乐情感形容词90%以上的信息量。

[0086]

然后,在操作s1024,基于所有音乐因子预测值利用反变换公式获得多维音乐情感预测值。

[0087]

在本公开的实施例中,在获得音乐因子预测值后,可以利用下面的反变换公式获得音乐情感预测值。

[0088][0089]

其中,上述公式中,代表音乐情感预测值,从音乐情感预测模型获得的音乐情感预测值代表音乐在18个情感形容词上的激发程度,数值越大表示对应该情

感形容词的情感越强烈。

[0090]

在本公开的实施例中,可以提高模型的泛化能力、降低学习的难度。还可以提升音乐相册制作过程中的情感匹配准确性,增强用户体验度。

[0091]

图5为本公开实施例提供的一种训练音乐图像情感匹配模型的示意流程图。

[0092]

如图5所示,在操作s103基于多维图像情感预测值利用音乐图像情感匹配模型获得多维图像情感因子预测值之前,基于情感匹配的电子音乐相册的生成方法还可以包括以下操作s501:

[0093]

在操作s501,采用因子分析法构建音乐图像情感匹配模型,其中,音乐图像情感匹配模型用于描述情感预测值和情感因子预测值之间的映射关系。

[0094]

在本公开的实施例中,采用因子分析法构建音乐图像情感匹配模型,可以提升音乐相册制作过程中的情感匹配准确性。

[0095]

在本公开的实施例中,因子分析法可以评价多维(例如18维)情感形容词的激活程度与音乐图像在情感上的匹配程度。激活程度可以用基于心理学量表的1

‑

5分表示,1分表示没有感受到该情感,5分表示该情感非常强烈。匹配程度也用基于心理学量表的1

‑

5分表示,1分表示不匹配,5分表示非常匹配。保留匹配程度在3分及以上的数据,并对这些数据中所有被试的评价结果取平均值,经过归一化后,获得用户对“图像+音乐”数据集的情感评价结果,即与多维情感形容词对应的音乐图像情感因子预测值如果多维情感形容词为18个,那么j的值为18,此时,音乐图像情感匹配模型f

lmtch

,l=1,2,3,...,s可以表示如下:

[0096][0097]

其中,上述公式中,存在4个音乐图像因子预测值,即l为4。当为图像的图像情感预测值(即)时,则可计算得到多维图像情感因子预测值f

lmtch_im

,l=1,2,3,4,此时f

lmtch

=f

lmtch_im

,l=1,2,3,4。同理,当为音乐的音乐情感预测值(即)时,则可计算得到多维音乐情感因子预测值f

lmtch_m

,l=1,2,3,4,此时f

lmtch

=f

lmtch_m

,l=1,2,3,4。

[0098]

在本公开的实施例中,与单独针对图像和音乐分别构建模型相比,可以得到相同

维度的图像情感因子预测值和音乐情感因子预测值,还可以提升音乐相册制作过程中的情感匹配准确性,增强用户体验度。

[0099]

图6为本公开实施例提供的一种生成电子音乐相册的示意流程图。

[0100]

如图6所示,操作s105根据多维图像情感预测值、多维音乐情感预测值、多维图像情感因子预测值和多维音乐情感因子预测值生成电子音乐相册可以包括以下操作s1051~s1053:

[0101]

在操作s1051,根据多维图像情感预测值和多维音乐情感预测值利用欧式距离计算公式获得第一欧式距离。

[0102]

在本公开的实施例中,假设k维空间上有两个点x和y,它们在任一维度上的坐标用x

i

和y

i

表示,i=1,2,...k,则这两个点x和y之间的欧式距离dist(x,y)的计算方法为:

[0103][0104]

在本公开的实施例中,假如有18维图像情感预测值和18维音乐情感预测值,第一欧式距离dist1的计算公式可以如下:

[0105][0106]

其中,上述公式中,表示音乐情感预测值;表示图像情感预测值;j表示图像情感预测值及音乐情感预测值的维度序号。

[0107]

其次,在操作s1052,根据多维图像情感因子预测值和多维音乐情感因子预测值利用欧式距离计算公式获得第二欧式距离。

[0108]

在本公开的实施例中,假如有4维图像情感因子预测值和4维音乐情感因子预测值,第二欧式距离dist2的计算公式可以如下:

[0109][0110]

其中,上述公式中,f

lmtch_m

表示音乐情感因子预测值;f

lmtch_im

表示图像情感因子预测值;l表示图像情感因子预测值和音乐情感因子预测值的维度序号。

[0111]

接下来,在操作s1053,根据第一欧式距离、第二欧式距离和预定权重获得每张图像和每个音乐片段之间的音乐图像情感匹配值。

[0112]

在本公开的实施例中,音乐图像情感匹配值dist的计算公式可以利用下面的公式表示:

[0113]

dist=αdist1+(1

‑

α)dist2

[0114]

其中,上述公式中,α表示权重,0≤α≤1。

[0115]

然后,在操作s1054,根据音乐图像情感匹配值确定与每个音乐片段最匹配的图像。

[0116]

在本公开的实施例中,音乐图像情感匹配值越小,说明图像与音乐片段越匹配,从而可以查找到与每个音乐片段最匹配的图像。

[0117]

接下来,在操作s1055,将每张图像插入到对应最匹配的音乐片段处。

[0118]

在本公开的实施例中,将查找到最匹配的图像插入到对应的音乐片段处,例如,在每个音乐片段的节拍位置处插入最匹配的图像。在操作s1055将每张图像插入到对应最匹配的音乐片段处之后,操作s105还可以包括以下操作:设置被插入图像的转场特效。转场特效包括划像、叠变、淡入淡出、飞入飞出、卷页等。

[0119]

在本公开的实施例中,调整第一欧式距离和第二欧式距离的权重可以兼顾基于情感形容词和基于因子值的相似度进行匹配的优点,使匹配到的图像和音乐片段不仅在单一情感形容词的距离上最近,从情感的表达类型上也最相似,从而提升情感匹配准确度,提高用户体验度。

[0120]

图7为本公开实施例提供的一种将音乐分成多个音乐片段的示意流程图。

[0121]

如图7所示,在操作s102基于音乐片段的多维音乐特征利用音乐情感预测模型获得多维音乐情感预测值之前,基于情感匹配的电子音乐相册的生成方法还可以包括以下操作s701:

[0122]

在操作s701,利用节拍检测算法将音乐分成多个音乐片段。

[0123]

在本公开的实施例中,节拍检测算法包括确定性算法和学习算法。将音乐分成多个音乐片段,以便图像与音乐片段精准匹配,将图像插入到最匹配的音乐片段中。

[0124]

在本公开的实施例中,操作s701利用节拍检测算法将音乐分成多个音乐片段可以包括以下操作:

[0125]

利用统一的采集率对音乐进行分帧得到多个音频帧。其中,根据音乐播放顺序,音频帧具有固定的序号。

[0126]

利用常数q变换(cqt)获得每个音频帧对应的常数q变换值(cqt值)。其中,cqt值类似频谱值。

[0127]

根据所有音频帧对应的常数q变换值筛选音频帧。其中,仅保留cqt值大于预定值的音频帧。

[0128]

根据筛选后的音频帧获取音乐的多个音符起点序列。其中,筛选出来的音频帧对应音乐的音符起点序列。

[0129]

对获取的多个音符起点序列进行高斯滤波平滑处理后,提取多个音符起点序列的峰值。

[0130]

根据峰值获得音乐的拍速。其中,从第一个峰值到最后一个峰值的时间除以峰值的数量,可以得到音乐的拍速。

[0131]

根据拍速从音乐的最后一个峰值从后向前,重新划分出每一拍的时间区间。其中,拍速是指每一拍的时间区间。

[0132]

根据每一拍的时间区间和节奏型因子将音乐分成多个音乐片段。其中,时间区间和节奏型因子的乘积为音乐片段的时长。例如,三拍子的音乐的节奏型因子为3,四拍子的音乐的节奏型因子为4。

[0133]

在本公开的实施例中,根据峰值获得音乐的拍速,可以包括以下操作:

[0134]

对音符起点序列进行幅度采样,确定节拍点的幅度阈值;

[0135]

根据确定的幅度阈值筛除小于幅度阈值的峰值,获得有效峰值;

[0136]

将相邻有效峰值的第一时间间隔放置在数组中;

[0137]

从数组中去除不符合歌曲速度的第二时间间隔,此时数组中剩余第三时间间隔;

其中,歌曲的速度一般在60拍/分钟到220拍/分钟之间,即拍速大约在0.27到1秒之间。如果第一时间间隔不在0.27秒到1秒之间,则视为第二时间间隔去除;

[0138]

保留第三时间间隔的一位小数,获得第四时间间隔;

[0139]

获取第四时间间隔的众数;

[0140]

根据众数保留第三时间间隔;其中,可以将位于区间[众数

‑

0.05,众数+0.05]第三时间间隔保留下来;

[0141]

根据第三时间间隔重新确定峰值,以便根据峰值获得音乐的拍速。

[0142]

在本公开的实施例中,通过上述算法得到的音乐片段更加贴合音乐信号的分布规律,更加贴近人类听觉系统,为后续图像与音乐片段的精准匹配打下良好基础,进而提升音乐相册制作过程中的情感匹配准确性,增强用户体验度。

[0143]

在本公开的实施例中,基于情感匹配的电子音乐相册的生成方法还可以包括以下操作:

[0144]

根据预定设置播放生成的电子音乐相册。

[0145]

在本公开的实施例中,预定设置可以包括图像显示设置、播放界面设置等。具体地可以利用matlab gui工具完成电子音乐相册界面的搭建、设置等。

[0146]

以上仅为本公开示意性的具体实施方式,在不脱离本公开的构思和原则的前提下,任何本领域的技术人员所做出的等同变化与修改,均应属于本公开保护的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1