一种基于横向联邦学习的文本预测方法及装置与流程

1.本公开涉及自然语言处理技术领域,尤其涉及一种基于横向联邦学习的文本预测方法及装置。

背景技术:

2.联邦学习起源于虚拟键盘的语言模型分布式训练的方案,采用逻辑回归进行下一词的排序和语言模型进行下一词的预测。在一些场景中,由于文本较长,要想达到较好的效果,需要较大的模型,较多的样本,然而各参与方并不总是有共享彼此数据的意愿。联邦学习可以让各参与方数据不出本地,只传参数的方法联合建模。

3.现有技术中,基于联邦蒸馏的方法feded或基于联邦迁移学习的方法fedner表明各方联合建模相比单方建模具有显著的效果优势。但是现有的横向联邦学习网络只存在一个中心服务器,中心服务器先解密再汇总梯度的过程中会存在数据损失而且影响数据传输的安全性。

技术实现要素:

4.本公开提供一种基于横向联邦学习的文本预测方法及装置,用以解决现有技术中联邦学习的安全性问题。

5.本公开提供一种基于横向联邦学习的文本预测方法,应用于参与方,所述预测方法包括:

6.获取待预测文本;

7.将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;

8.其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;

9.所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;

10.所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

11.根据本公开提供的一种基于横向联邦学习的文本预测方法,所述横向联邦学习网络包括多个参与方;

12.对每个参与方的本地联邦模型的训练过程,具体包括:

13.基于本地私有化文本训练数据及文本训练数据标签进行本地联邦模型训练,得到共享参数梯度;

14.接收公私钥服务器生成的公钥;

15.根据所述公钥将所述共享参数梯度进行同态加密后发送至汇总服务器;

16.接收所述公私钥服务器发送的更新共享参数;其中,所述更新共享参数是通过所述汇总服务器接收的各参与方发送的所述共享参数梯度,并进行梯度均值处理,将处理后均值数据发送至所述公私钥服务器;所述公私钥服务器将接收的所述均值数据通过私钥解

密得到的;

17.将所述更新共享参数更新至所述本地联邦模型中,完成一轮迭代;

18.循环进行至少一轮迭代,直至所述本地联邦模型的损失函数收敛。

19.根据本公开提供的一种基于横向联邦学习的文本预测方法,所述本地联邦模型包括嵌入层、至少一个编码层;所述将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,具体包括:

20.将待预测文本输入所述嵌入层,经过对文本做初始映射得到嵌入层输出的降维特征向量;

21.将所述降维特征向量依次输入至少一个所述编码层,经过进行高阶特征提取得到编码层输出的联邦预测数据。

22.根据本公开提供的一种基于横向联邦学习的文本预测方法,所述下游任务的任务类型包括:文本分类、序列标注、文本生成及句对分类,所述私有模型根据下游任务的任务类型处理得到相应的预测结果。

23.本公开还提供一种基于横向联邦学习的文本预测装置,包括:

24.获取单元,用于获取待预测文本;

25.文本预测单元,用于将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;

26.其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;

27.所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

28.根据本公开提供的一种基于横向联邦学习的文本预测装置,所述文本预测单元包括模型训练单元,所述模型训练单元用于对本地联邦模型进行模型训练。

29.根据本公开提供的一种基于横向联邦学习的文本预测装置,所述横向联邦学习网络包括多个参与方;对每个参与方的所述模型训练单元包括:

30.共享参数梯度获取子单元,用于基于本地私有化文本训练数据及文本训练数据标签进行本地联邦模型训练,得到共享参数梯度;

31.公钥接收子单元,用于接收公私钥服务器生成的公钥;

32.梯度加密发送子单元,用于根据所述公钥将所述共享参数梯度进行同态加密后发送至汇总服务器;

33.更新共享参数接收子单元,用于接收所述公私钥服务器发送的更新共享参数;其中,所述更新共享参数是通过所述汇总服务器接收的各参与方发送的所述共享参数梯度,并进行梯度均值处理,将处理后均值数据发送至所述公私钥服务器;所述公私钥服务器将接收的所述均值数据通过私钥解密得到的;

34.模型更新子单元,用于将所述更新共享参数更新至所述本地联邦模型中,完成一轮迭代;

35.循环迭代子单元,用于循环进行至少一轮迭代,直至所述本地联邦模型的损失函数收敛。

36.根据本公开提供的一种基于横向联邦学习的文本预测装置,所述本地联邦模型包括嵌入层、至少一个编码层;所述文本预测单元包括映射子单元及特征提取子单元;

37.所述映射子单元,用于将待预测文本输入所述嵌入层,经过对文本做初始映射得到嵌入层输出的降维特征向量;

38.所述特征提取子单元,用于将所述降维特征向量依次输入至少一个所述编码层,经过进行高阶特征提取得到编码层输出的联邦预测数据。

39.本公开还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如上述任一种所述基于横向联邦学习的文本预测方法的步骤。

40.本公开还提供一种非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如上述任一种所述基于横向联邦学习的文本预测方法的步骤。

41.本公开提供的基于横向联邦学习的文本预测方法及装置,各参与方通过与公私钥服务器及汇总服务器形成横向联邦学习网络,将联邦学习的本地联邦学习模型用于文本预测的下游任务,在有效保护本地私有数据的同时提高了数据网络传输的安全性。

附图说明

42.为了更清楚地说明本公开或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作一简单地介绍,显而易见地,下面描述中的附图是本公开的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

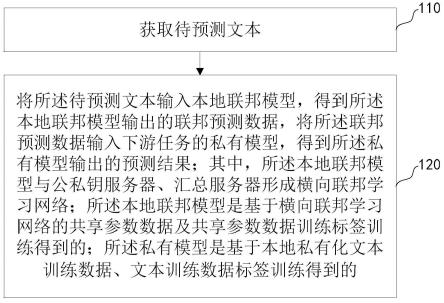

43.图1是本公开提供的基于横向联邦学习的文本预测方法的流程示意图;

44.图2是本公开提供的基于横向联邦学习的文本预测方法的各参与方本地联邦模型训练流程示意图;

45.图3是本公开提供的基于横向联邦学习的文本预测方法的各参与方本地联邦模型训练结构示意图;

46.图4是本公开提供的基于横向联邦学习的文本预测方法的本地联邦模型与私有模型连接的结构示意图;

47.图5是本公开提供的基于横向联邦学习的文本预测装置的结构示意图;

48.图6是本公开提供的电子设备的结构示意图;

具体实施方式

49.为使本公开实施例的目的、技术方案和优点更加清楚,下面将结合本公开实施例中的附图,对本公开实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本公开实施例一部分实施例,而不是全部的实施例。基于本公开实施例中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本公开实施例保护的范围。

50.在对本公开实施例进行说明之前,先对现有技术中的联邦学习技术进行简要说明。

51.联邦学习本质上是一种分布式机器学习技术,或机器学习框架。联邦学习的目标

是在保证数据隐私安全及合法合规的基础上,实现共同建模,提升ai模型的效果。横向联邦学习(horizontal federated learning)又称同构联邦学习(homogenous federated learning)指的是各参与方拥有同样特征空间,而在样本空间上互不相同的联邦学习。现有技术中联邦蒸馏的方法feded本地联邦模型为bert模型,由于参数量巨大,基于联邦蒸馏的方法,需要中心服务器具有私有数据,且各参与方需要对齐标注标准。

52.联邦迁移的方法fedner局限应用于下游任务中的ner(命名实体识别)任务,且本地联邦模型是基于word2vec和elmo的语言模型,存在无法较好地利用上下文,需要各方对齐词表,因此存在梯度隐私泄露的风险,梯度信息一旦泄露,容易暴露原始的文本信息。

53.现有的中心化的方案将加密后的梯度汇聚和解密操作均置于同一台服务器中进行,会存在安全隐患,且对梯度加噪声又会影响建模效果。

54.下面结合图1描述本公开实施例的基于联邦学习的文本预测方法,包括:

55.步骤110:获取待预测文本;

56.本步骤中的待预测文本依据下游任务而决定。

57.步骤120:将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;

58.其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;

59.所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;;

60.所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

61.本公开实施例中本地联邦模型包括嵌入(embedding)层、至少一个编码(transformer)层。

62.本公开实施例中,横向联邦学习网络包括多个参与方。

63.本公开实施例提供一种去中心化的横向联邦建模的方法,既可以防止网络传输过程中梯度的泄露,又可以防止中心服务器先解密后汇总梯度,实现数据理论上无损。

64.步骤120具体包括:

65.将待预测文本输入所述嵌入层,经过对文本做初始映射得到嵌入层输出的降维特征向量;

66.将所述降维特征向量依次输入至少一个所述编码层,经过进行高阶特征提取得到编码层输出的联邦预测数据。

67.由于各参与方文本数据不共享,标注标签并不完全相同,数据需要隐私保护,因此需要联合建模。然而现有技术中联邦蒸馏方法中常用的bert等预训练模型参数规模过大,网络通信开销过大。而联邦迁移中常用的基于word2vec和elmo的共享模型对于上下文捕捉能力有限,因此本公开实施例中,优选地,应用albert模型作为本地联邦模型,在其上进行迁移学习任务。

68.为了达到较好的建模效果,在其他优选实施例中,还可采用其他的预训练模型例如distilbert模型作为本地联邦模型,但可能参数量更大,但可以减少参数传递过程。

69.本公开实施例中所述下游任务主要是针对(自然语言处理)nlp任务进行的,下游任务类型主要包括:文本分类、序列标注、文本生成及句对分类,所述私有模型根据下游任

务的任务类型处理得到相应的预测结果。

70.本公开实施例中下游任务可以使用各种网络,例如当下游任务为文本分类时,可只应用[cls]向量或者[cls]向量另接一个线性(linear)层和/或外接多项逻辑回归(softmax)层做下游任务。本公开实施例中为了保证预测效果,各参与方下游任务要相同且目标要尽可能接近,但不强求训练数据标签完全一致。

[0071]

本公开实施例中底层的本地联邦模型为共享模型,各参与方共享参数,上层的私有模型的参数为私有。

[0072]

本公开实施例中,步骤120中对每个参与方的本地联邦模型的训练过程,如图2及图3所示,具体包括:

[0073]

步骤210:基于本地私有化文本训练数据及文本训练数据标签进行本地联邦模型训练,得到共享参数梯度;

[0074]

本步骤中,各参与方的本地私有化文本训练数据的数据类型相同。

[0075]

各参与方训练应用相同的模型作为本地联邦模型,在本地联邦模型训练时的第一轮本地联邦模型参数是由公私钥服务器下载的模型参数,开始进行迭代训练。

[0076]

步骤220:接收公私钥服务器生成的公钥;

[0077]

本公开实施例中,在横向联邦学习网络中在各参与方的服务器中随机选出其中的两台服务器分别作为公私钥服务器及汇总服务器。如图3中,平台k为公私钥服务器,平台j为汇总服务器。本公开实施例中,随机选取的目的是在任务进行前不知道公私钥服务器和汇总服务器分别是哪个参与方,被选中的两台服务器所属的参与方本身也不知道自己被选中,这样可以避免选取的这两参与方联合作弊。

[0078]

本步骤中,所述公私钥服务器生成公钥及私钥,并将公钥发送至各所述参与方;

[0079]

步骤230:根据所述公钥将所述共享参数梯度进行同态加密后发送至汇总服务器;

[0080]

现有的nlp联邦学习方法存在梯度泄露的风险,尤其是嵌入(embedding)层梯度的泄露会导致原始文本的字词(token)泄露,因此本公开实施例中,通过采用同态加密技术对梯度进行保护,从而防止梯度泄露,保证网络传输安全性。本地联邦模型的梯度通过paillier算法进行加密并发送到汇总服务器。

[0081]

本步骤中,优选地,将albert模型作为本地联邦模型,这种基于预训练模型的方法相比于fedner联邦迁移方法中的word2vec和elmo的共享模型,可以更充分地利用大规模预训练语料的上下文信息。同时albert模型采用参数低秩分解和跨层共享参数的方法,参数量仅为原始bert参数量的1/12,因此较好地解决了现有技术中,联邦学习联合建模的参数量巨大,网络传输消耗较大的问题。如图4所示,albert模型中包含1个嵌入(embedding)层,12个编码(transformer encoder)层。

[0082]

利用albert模型作为本地联邦模型进行横向联邦迁移学习,可大大减少参数量,从而降低通讯开销,相比非预训练模型在效果上有一定的优势。

[0083]

步骤240:接收所述公私钥服务器发送的更新共享参数;其中,所述更新共享参数是通过所述汇总服务器接收的各参与方发送的所述共享参数梯度,并进行梯度均值处理,将处理后均值数据发送至所述公私钥服务器;所述公私钥服务器将接收的所述均值数据通过私钥解密得到的;

[0084]

本步骤中,汇总服务器进行的是密文运算,避免了其得到各参与方的具体的梯度

值,然后将计算结果传给公私钥服务器。

[0085]

本步骤中,梯度数据是先在汇总服务器经过计算再在公私钥服务器上进行解密,从而防止梯度泄露,而且实现梯度数据处理时是无损的。

[0086]

本步骤中,由于更新共享参数是计算后的结果,不存在梯度泄露的问题,因此更新共享参数明文传输即可。

[0087]

本步骤中,将汇总服务器中计算得到的梯度均值进行解密后,将均值梯度更新到本地联邦模型的模型参数中,即得到更新共享参数。本公开实施例中,由于是横向联邦学习网络因此各参与方各自的本地联邦模型的模型参数是相同的,因此可将处理的均值梯度直接更新到模型参数中,从而使得公私钥服务器最终将相同的更新共享参数发送给各个参与方。

[0088]

步骤250:将所述更新共享参数更新至所述本地联邦模型中,完成一轮迭代;

[0089]

本公开实施例中,各参与方底层的本地联邦模型为共享模型,各参与方共享参数,上层的私有模型的参数为私有。在反向传播的过程中,私有参数直接基于梯度进行更新。

[0090]

步骤260:循环进行至少一轮迭代,直至所述本地联邦模型的损失函数收敛。

[0091]

本公开实施例中,重复进行步骤210-250,直至各参与方各自的本地联邦模型的损失函数收敛。优选地,每轮迭代在步骤210-250过程中,每次传输发送接收的内容均上链,从而增加数据安全与隐私保护。

[0092]

步骤260后各方参与均增强了各自的本地联邦模型可直接用于各自下游任务的预测。训练后每个参与方训练自己的下游任务都充分利用了其他参与方的数据。

[0093]

现有的横向联邦学习同态加密技术大多将解密和梯度汇总放在了同一台中心服务器中进行,或者依赖第三方来进行解密,前者不能保证中心服务器先梯度汇总后解密,只能先解密后汇总,不能保证数据安全,后者难以找到可靠的第三方。因此本公开实施例提出了一种去中心化的将解密和梯度汇总分开放在两个服务器中的方法,保证先计算后解密从而实现梯度数据的保护。

[0094]

以下结合具体的应用场景实例对本公开实施例的基于横向联邦学习的文本预测方法进行举例说明:

[0095]

应用场景:多家医院相同或者相近科室,根据病例文本进行联邦学习,进行文本生成的下游任务:达到医疗对话、自动问诊、基于多个医院的聊天对话的平行预料,训练一个自动辅助问诊的聊天机器人。

[0096]

由于医院患者的数据往往是隐私的,多方联合建模可以更好地提高模型的效果,而且达到患者隐私保护的的目的。

[0097]

本实例中包括两种下游任务:标注实体以及实体推理。

[0098]

应用过程如下:

[0099]

根据患者病例文本内容对其经过本地联邦模型以及私有模型后得到标注实体,例如:

[0100]

第一条对话内容为患者的病例文本,内容为“胃部胀气有时候会反酸经常性会发出鸣响”,根据病例文本,经过训练好的本地联邦模型进行提取疾病症状特征后,再经过ner(命名实体识别)下游任务来自动形成疾病症状的结构化文本“胃胀,反酸”;

[0101]

第二条对话内容为医生的问诊文本,内容为患者的病例文本内容为“这段时间有

没有腹痛、打嗝的情况?消化怎么样”,根据问诊文本,经过训练好的本地联邦模型进行提取疾病症状特征后,再经过ner(命名实体识别)下游任务来自动形成疾病症状的结构化文本“腹痛,打嗝”;

[0102]

第三条对话内容为患者的病例文本,内容为“有时候腹痛,但就几次打嗝,有时候觉得不消化”,根据病例文本,经过训练好的本地联邦模型进行提取疾病症状特征后,再经过ner(命名实体识别)下游任务来自动形成疾病症状的结构化文本“腹痛,打嗝,消化不良”;

[0103]

根据三条下游任务提取的疾病症状的结构化文本,经过文本生成的下游任务,得到该患者的疾病症状为“消化不良”,对应的药物治疗方案为“奥美、吗丁啉”,进而再经过文本生成的下游任务将该患者的疾病症状为“消化不良”,对应的药物治疗方案为“奥美、吗丁啉”自动形成结构化语音,并输出“嗯,这种情况属于消化不良造成的,建议口服奥美拉唑加吗丁啉治疗”,从而形成了自动辅助问诊的聊天机器人。

[0104]

相应地,本地联邦模型的训练过程与上述应用过程为对应的过程,根据各条病例文本及问诊文本对应得到实体标注标签及文本生成标签,分别用于本地联邦模型的训练数据及标签对其进行训练,将训练好的本地联邦模型用于实际辅助问诊系统中。

[0105]

如图5所示,本公开还提供一种基于横向联邦学习的文本预测装置,包括:

[0106]

获取单元510,用于获取待预测文本;

[0107]

文本预测单元520,用于将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;

[0108]

其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;

[0109]

所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;;

[0110]

所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

[0111]

本公开实施例中,横向联邦学习网络包括多个参与方。本公开实施例中本地联邦模型包括嵌入(embedding)层、至少一个编码(transformer encoder)层。由于各参与方文本数据不共享,标注标签并不完全相同,数据需要隐私保护,因此需要联合建模。然而现有技术中联邦蒸馏方法中常用的bert等预训练模型参数规模过大,网络通信开销过大。而联邦迁移中常用的基于word2vec和elmo的共享模型对于上下文捕捉能力有限,因此本公开实施例中,优选地,应用albert模型作为本地联邦模型,在其上进行迁移学习任务。为了达到较好的建模效果,在其他优选实施例中,还可采用其他的预训练模型例如distilbert模型作为本地联邦模型,但可能参数量更大,但可以减少参数传递过程。将albert模型作为本地联邦模型,这种基于预训练模型的方法相比于fedner联邦迁移方法中的word2vec和elmo的共享模型,可以更充分地利用大规模预训练语料的上下文信息。同时albert模型采用参数低秩分解和跨层共享参数的方法,参数量仅为原始bert参数量的1/12,因此较好地解决了现有技术中,联邦学习联合建模的参数量巨大,网络传输消耗较大的问题。

[0112]

本公开实施例中所述下游任务主要是针对(自然语言处理)nlp任务进行的,下游任务类型主要包括:文本分类、序列标注、文本生成及句对分类,所述私有模型根据下游任务的任务类型处理得到相应的预测结果。

[0113]

本公开实施例中下游任务可以使用各种网络,例如当下游任务为文本分类时,可只应用[cls]向量或者[cls]向量另接一个线性(linear)层和/或外接多项逻辑回归(softmax)层做下游任务。本公开实施例中为了保证预测效果,各参与方下游任务要相同且目标要尽可能接近,但不强求训练数据标签完全一致。

[0114]

本公开实施例提供一种去中心化的横向联邦建模的方法,既可以防止网络传输过程中梯度的泄露,又可以防止中心服务器先解密后汇总梯度,实现数据理论上无损。

[0115]

本公开实施例中,所述本地联邦模型包括嵌入层、至少一个编码层;文本预测单元520具体地包括:

[0116]

映射子单元:用于将待预测文本输入所述嵌入层,经过对文本做初始映射得到嵌入层输出的降维特征向量;

[0117]

特征提取子单元,用于将所述降维特征向量依次输入至少一个所述编码层,经过进行高阶特征提取得到编码层输出的联邦预测数据。

[0118]

本公开实施例中,所述横向联邦学习网络包括多个参与方;对每个参与方的所述模型训练单元包括:

[0119]

共享参数梯度获取子单元,用于基于本地私有化文本训练数据及文本训练数据标签进行本地联邦模型训练,得到共享参数梯度;

[0120]

本公开实施例中,利用albert模型作为本地联邦模型进行横向联邦迁移学习,可大大减少参数量,从而降低通讯开销,相比非预训练模型在效果上有一定的优势。

[0121]

各参与方的本地私有化文本训练数据的数据特征类型相同。各参与方训练应用相同的模型作为本地联邦模型,在本地联邦模型训练时的第一轮本地联邦模型参数是由公私钥服务器下载的模型参数,开始进行迭代训练。

[0122]

公钥接收子单元,用于接收公私钥服务器生成的公钥;

[0123]

本公开实施例中,公私钥服务器及汇总服务器是在各参与方中的各自的服务器中随机选举出来的两台。随机选取的目的是在任务进行前不知道公私钥服务器和汇总服务器分别是哪个参与方,被选中的两台服务器所属的参与方本身也不知道自己被选中,这样可以避免选取的这两参与方联合作弊。

[0124]

梯度加密发送子单元,用于根据所述公钥将所述共享参数梯度进行同态加密后发送至汇总服务器;

[0125]

更新共享参数接收子单元,用于接收所述公私钥服务器发送的更新共享参数;其中,所述更新共享参数是通过所述汇总服务器接收的各参与方发送的所述共享参数梯度,并进行梯度均值处理,将处理后均值数据发送至所述公私钥服务器;所述公私钥服务器将接收的所述均值数据通过私钥解密得到的;

[0126]

模型更新子单元,用于将所述更新共享参数更新至所述本地联邦模型中,完成一轮迭代;

[0127]

循环迭代子单元,用于循环进行至少一轮迭代,直至所述本地联邦模型的损失函数收敛。

[0128]

图6示例了一种电子设备的实体结构示意图,如图6所示,该电子设备可以包括:处理器(processor)610、通信接口(communications interface)620、存储器(memory)630和通信总线640,其中,处理器610,通信接口620,存储器630通过通信总线640完成相互间的通

信。处理器610可以调用存储器630中的逻辑指令,以执行基于横向联邦学习的文本预测方法,该方法包括:获取待预测文本;将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

[0129]

此外,上述的存储器630中的逻辑指令可以通过软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。基于这样的理解,本公开实施例的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本公开各个实施例所述方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、磁碟或者光盘等各种可以存储程序代码的介质。

[0130]

另一方面,本公开还提供一种计算机程序产品,所述计算机程序产品包括存储在非暂态计算机可读存储介质上的计算机程序,所述计算机程序包括程序指令,当所述程序指令被计算机执行时,计算机能够执行上述各方法所提供的基于横向联邦学习的文本预测方法,该方法包括:获取待预测文本;将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

[0131]

又一方面,本公开还提供一种非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现以执行上述各提供的基于横向联邦学习的文本预测方法,该方法包括:获取待预测文本;将所述待预测文本输入本地联邦模型,得到所述本地联邦模型输出的联邦预测数据,将所述联邦预测数据输入下游任务的私有模型,得到所述私有模型输出的预测结果;其中,所述本地联邦模型与公私钥服务器、汇总服务器形成横向联邦学习网络;所述本地联邦模型是基于横向联邦学习网络的共享参数数据及共享参数数据训练标签训练得到的;所述私有模型是基于本地私有化文本训练数据、文本训练数据标签训练得到的。

[0132]

以上所描述的装置实施例仅仅是示意性的,其中所述作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本实施例方案的目的。本领域普通技术人员在不付出创造性的劳动的情况下,即可以理解并实施。

[0133]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到各实施方式可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件。基于这样的理解,上

述技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品可以存储在计算机可读存储介质中,如rom/ram、磁碟、光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行各个实施例或者实施例的某些部分所述的方法。

[0134]

最后应说明的是:以上实施例仅用以说明本公开的技术方案,而非对其限制;尽管参照前述实施例对本公开进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本公开各实施例技术方案的精神和范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1