一种增强纹理细节的非配对图像翻译方法

1.本发明涉及计算机图像处理技术,具体涉及一种增强纹理细节的非配对图像翻译方法。

背景技术:

2.图像翻译广泛应用于超分辨率、图像修复、图像风格迁移等领域,其旨在学习源域输入图像与目标域输出图像之间的映射关系,从而将一个物体的图像表征转换为该物体的另一种图像表征。传统方法要求手工设计图像的特征,例如形状、纹理和边缘。当数据量较大时,手工设计图像特征的工作强度非常大,导致效率低下。此外,采用传统方法建立的数学模型基本上只能用于某一特定场景,这给实际应用带来了很大的局限性。

3.由于深度学习的发展,采用生成对抗网络来实现图像翻译成为一个热门的研究方向。通过训练,生成对抗网络可以自动学习训练图像的数据分布特征,并生成具有相似特征的目标域图像。然而,在许多图像翻译任务中,需要处理的图像不是成对的。例如,如果想把马转换成斑马,在现实生活中很难获得配对的真实照片。

4.研究人员提出了许多非配对的图像翻译方法,例如通过加入循环一致损失解决图像翻译任务中的解空间过大的问题,强制要求源域图像与目标域图像能够互相转换,从而不需要二者一一对应。但由于配对关系的缺失,主要关注图像的整体翻译导致了图像的真实性降低。

技术实现要素:

5.本发明所要解决的技术问题是,提出一种通过改善图像翻译过程中所得目标域图像的真实性来提高非配对图像翻译质量的方法。

6.本发明采用的技术方案为:

7.一种增强纹理细节的非配对图像翻译方法,包括下列步骤:

8.步骤1:构建图像翻译的生成对抗网络模型,并对所述生成对抗网络模型进行网络参数训练;

9.所述生成对抗网络模型包括两个生成器和两个鉴别器,构成循环一致性生成对抗网络cyclegan,其中,生成器包括依次连接的编码器、转换器和解码器;

10.所述编码器用于图像的下采样处理,依次包括:若干层标准卷积层构成的卷积堆叠结构和若干层空洞卷积层构成的空洞卷积堆叠结构;

11.所述转换器为若干个残差块构成的堆叠结构;

12.所述解码器用于图像的上采样处理,依次包括若干反卷积层和一层全连接层,其中,反卷积层的层数与编码器的标准卷积层的层数相对应,所述全连接层采用双曲正切激活函数;

13.步骤2:从训练后的两个生成器中选择与翻译目标对应的生成器作为图像翻译生成器,对待翻译图像进行图像预处理以使得待翻译图像与所述图像翻译生成器的输入相匹

配,再将图像预处理后的待翻译图像输入图像翻译生成器,基于其输出得到图像翻译结果。

14.进一步的,所述空洞卷积堆叠结构为锯齿形空洞卷积堆叠结构。

15.进一步的,步骤1中,对所述生成对抗网络模型进行网络参数训练时,采用的损失函数为:

[0016][0017]

其中,表示生成对抗网络模型的总损失,表示循环一致损失,表示身份映射损失,表示对抗性损失,λ

m

表示循环一致损失的系数,λ

i

表示身份映射损失的系数,x表示源域,y表示目标域,g、f分别表示第一生成器和第二生成器的映射,d

x

,d

y

分别表示关于x、y的鉴别器。

[0018]

且有:

[0019][0020][0021][0022][0023]

其中,x表示源域x的个体,y表示目标域y的个体,g()、f()分别表示第一生成器的输出,即生成器输出的生成图像,表示ms

‑

ssim损失,表示高斯分布参数,α表示比例系数,表示l1损失(即将目标值与估计值的绝对差值的总和最小化);表示数学期望,p

data

()表示括号中对象的分布,||||1表示l1范数;d

x

()、d

y

()分别表示第一鉴别器和第二鉴别器的输出,其中,鉴别器的输入为生成器输出的生成图像,以及该生成图像所对应的真实图像。

[0024]

本发明提供的技术方案至少带来如下有益效果:相比于主要关注图像整体翻译的方案,本发明可以在完成图像翻译任务的基础上有效改善生成目标域图像的纹理细节,实现更加逼真的非配对图像翻译。

附图说明

[0025]

为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其它的附图。

[0026]

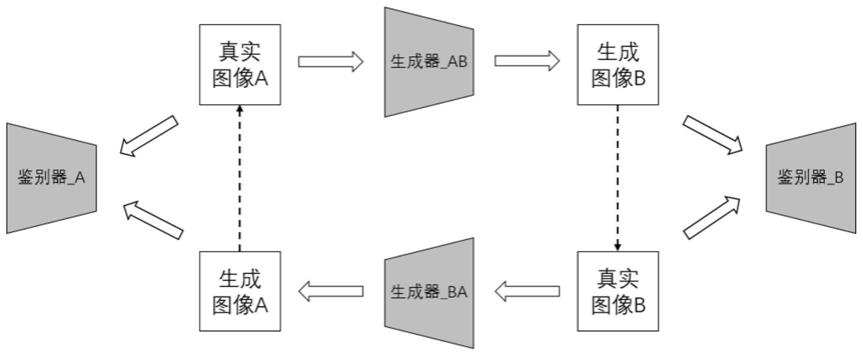

图1为本发明实施例提供的增强纹理细节的非配对图像翻译方法的网络整体框架示意图。

[0027]

图2为本发明实施例提供的增强纹理细节的非配对图像翻译方法的生成器结构图。

[0028]

图3为本发明实施例提供的增强纹理细节的非配对图像翻译方法的空洞卷积示意图。

[0029]

图4为现有非配对图像翻译模型与本发明方法在monet

→

photo(油画

→

照片)数据

集上的效果对比图(从上至下依次为输入图像,cyclegan(循环一致性生成对抗网络),munit(多模态无监督),drit(多模态解纠缠),gcgan(几何一致性生成对抗网络)以及本发明的生成图像)。

[0030]

图5为现有非配对图像翻译模型与本发明方法在cat

→

dog(猫

→

狗)数据集上的效果对比图。

[0031]

图6为现有非配对图像翻译模型与本发明方法在label

→

facade(标签

→

建筑物正面)数据集上的效果对比图。

具体实施方式

[0032]

为使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明实施方式作进一步地详细描述。

[0033]

本发明实施例提供了一种增强纹理细节的非配对图像翻译方法,是一种将非配对的源域图像通过生成对抗网络模型转换为具有丰富纹理细节的目标域图像的图像处理技术。本发明实施例提供的增强纹理细节的非配对图像翻译方法,基于所构建的生成对抗网络模型实现非配对图像翻译方法,该生成对抗网络模型包括两个生成器与两个鉴别器,构成循环一致性生成对抗网络,如图1所示,其中,将源域到目标域的生成器定义为生成器_ab,将目标域到源域的的生成器定义为生成器_ba,两个生成器的结构相同;两个鉴别器的结构相同,并将对源域的鉴别器定义为鉴别器a,对目标域的鉴别器定义为鉴别器b。其中,生成器包括编码器(encoder)、转换器(converter)与解码器(decoder)三部分,且所述编码器包括若干标准卷积层(convolution)以及空洞卷积层(dilated convolution),使输出特征图的大小保持不变,并且采用改进的循环一致损失作为损失函数,从而防止空间分辨率下降,更好地保留图像的纹理细节。图1中,图像a和b分别表示源域和目标域的图像。

[0034]

参见图1,所构建的生成对抗网络模型的主体网络仍采用cyclegan(循环一致性生成对抗网络),但本发明实施例中,对传统生成器进行了改造,改进的生成器结构如图2所示,并提出了一种改进的循环一致损失函数用于训练。

[0035]

其中,改进的生成器包括三个模块:编码器、转换器和解码器,经过下采样、转换然后上采样的过程实现对输入图像的整体翻译。其中,编码器包含若干标准卷积层以及空洞卷积层,每层卷积之后均采用批归一化处理并连接relu(分段线性)激活函数。编码器前部为若干标准卷积层,用于输入图像的下采样。其目标是使生成器在训练过程中保留更多的图像纹理细节,因此需要在不降低分辨率的情况下扩大感受野,故在标准卷积层下采样之后添加一系列(若干个)空洞卷积层,即多个空洞卷积层的堆叠结构构成空洞卷积块(dilated convolution block)。与普通卷积相比,空洞卷积层的卷积核增加了一个扩张率参数,使得相同大小的卷积核具有更大的感受野。同时,空洞卷积可以保持输出特征图的大小不变,从而防止空间分辨率下降,更好地保留图像的纹理细节。示例性的,可将空洞卷积层的层数设置为4层,如图2所示。

[0036]

空洞卷积层的示意图如图3所示。同时,为了避免空洞卷积带来的网格效应问题,在一种可能的实现方式中,可采用锯齿形空洞卷积结构,例如,若采用三层空洞卷积层构型可将空洞率设置为1、2和5,若采用四层空洞卷积层构型则可将空洞率分别设置为1、2、5和9。

[0037]

需要注意的是,空洞卷积层数并非越多越好,当采用过多的空洞卷积层时效果反而下降,生成图像丢失大量纹理细节。原因在于,较大的感受野适合检测和识别大型物体,但是,当图像中含有丰富的纹理时,必须保持分辨率并避免丢失细节,过大的感受野反而会降低模型的性能,并增加过拟合的风险。

[0038]

转换器由一系列残差块组成,即若干个残差块的堆叠结构,用于将图像在源域中的特征向量转换为目标域中的特征向量。残差块数目由实际输入图像尺寸确定,当输入图像分辨率为128

×

128时优选采用6个残差块,当输入图像分辨率为256

×

256或更高时优选采用9个残差块。

[0039]

解码器包含若干反卷积层及一层全连接层,用于从特征向量中还原出低级特征。反卷积层数与编码器中标准卷积层数相对应,每层反卷积之后同样采用批归一化处理并连接relu激活函数。最后跟随一层全连接层并采用tanh(双曲正切)激活函数,从而输出生成图像。

[0040]

对所构建的生成对抗网络模型进行训练网络参数训练,当满足预设的训练结束条件时,保存训练后的两个生成器。

[0041]

从训练后的两个生成器中选择与翻译目标对应的生成器作为图像翻译生成器,对待翻译图像进行图像预处理(例如尺寸归一化处理),以使得待翻译图像与所述图像翻译生成器的输入相匹配,再将图像预处理后的待翻译图像输入图像翻译生成器,基于其输出得到图像翻译结果。例如,当前需求时需要获得从对象a

→

b的翻译,则将训练后的生成器_ab作为图像翻译生成器,例如,训练时,生成器_ab是用于将猫转换为狗,则当需要获取“cat

→

dog”的翻译结果时,将生成器_ab作为图像翻译生成器。而当需要获取“dog

→

cat”的翻译结果时,则将生成器_ba作为图像翻译生成器。

[0042]

为了进一步增强生成图像的纹理细节,在本发明实施例公开的增强纹理细节的非配对图像翻译方法中,提出了一种改进的循环一致损失,通过引入ms

‑

ssim(多尺度结构相似性指数),综合比较生成图像与输入图像之间的亮度、对比度和结构差异,使生成图像更好地满足人类视觉感知。

[0043]

其中,循环一致损失的表达式为:

[0044][0045]

其中,g:x

→

y和f:y

→

x为源域(x)与目标域(y)之间的相互映射,x表示源域的个体,y表示目标域的个体,g()表示生成器_ab的输出,f()表示生成器_ba的输出,表示数学期望,p

data

()表示括号中对象的分布,||||1表示l1范数;

[0046]

而改进的循环一致损失表达式为:

[0047][0048]

其中,g:x

→

y和f:y

→

x为源域(x)与目标域(y)之间的相互映射,x表示源域的个体,为高斯分布参数,α为比例系数,为ms

‑

ssim损失,为l_1损失(即将目标值与估计值的绝对差值的总和最小化)。优选的,将α设为0.84时性能最佳。

[0049]

除改进的循环一致损失外,总损失函数还包括对抗性损失与身份映射损失其表达式分别为:

[0050][0051][0052]

即在训练时,将目标域的个体y(图像)输入到生成器_ab中,得到g(y),以及将源域的个体x输入到生成器_ba中,

[0053]

因而,总损失函数可表示为:

[0054][0055]

其中,λ

m

和λ

i

为比例系数。由于本发明实施例的目标是在实现非配对图像翻译的同时保持更多的图像纹理细节,故而最重要,可采用与cyclegan相同的比例设置,将λ

m

设为10,λ

i

设为5。

[0056]

为了进一步验证本发明实施例提供的增强纹理细节的非配对图像翻译方法的图像处理性能,通过测试对比进行说明。

[0057]

如图4、图5和图6所示,将现有非配对图像翻译模型与本发明实施例提供的增强纹理细节的非配对图像翻译方法的翻译结果进行定性对比,图中虚线上方为输入图像,虚线下方从上至下依次为不同模型(最下方为本发明实施例的图像翻译方法)的测试结果及相应的放大的纹理细节图。

[0058]

将现有非配对图像翻译模型与本发明网络翻译结果进行定量对比,评价指标采用fid(fr

é

chet inception distance),所得结果为:

[0059]

方法monet

→

photocat

→

doglabel

→

facadecyclegan139.3895.70166.20munit163.70113.14135.08drit172.39134.47155.09gcgan147.1694.77125.04本发明134.1382.52134.66

[0060]

结果表明,通过使用本发明实施例提供的增强纹理细节的非配对图像翻译方法的网络进行非配对图像的训练,训练出的识别模型可以有效改善生成图像的纹理细节,实现更加逼真的非配对图像翻译。

[0061]

最后应说明的是:以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

[0062]

以上所述的仅是本发明的一些实施方式。对于本领域的普通技术人员来说,在不脱离本发明创造构思的前提下,还可以做出若干变形和改进,这些都属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1