一种方面级情感分类方法

1.本公开涉及人工智能技术领域,尤其涉及一种方面级情感分类方法。

背景技术:

2.随着社交媒体的兴起,情感分析日益成为人工智能领域中自然语言处理方向的研究热点,其研究对象是人们对服务、事件、产品、话题及其属性的观点、情绪和态度,针对这些主观性言论进行分析往往可以快速把握民众对热点话题、政策、商品等方面的态度或看法,具有显著的研究价值。

3.相关技术中,早期的情感分析方法主要是依赖统计方法建立情感词典,将情感词典作为情感分析的基础。然而,无论人工构建还是自动构建情感词典,往往仅能针对某一领域,对于跨领域情感分析的效果并不理想。目前,方面级情感分类研究逐渐沿着深度学习技术而展开,但现有方法往往忽略了方面词与上下文的交互信息,因而导致情感分析效果欠佳。

4.因此,有必要提供一种新的技术方案改善上述方案中存在的一个或者多个问题。

5.需要说明的是,在上述背景技术部分公开的信息仅用于加强对本公开的背景的理解,因此可以包括不构成对本领域普通技术人员已知的现有技术的信息。

技术实现要素:

6.本公开的目的在于提供一种方面级情感分类方法,进而至少在一定程度上克服由于相关技术的限制和缺陷而导致的一个或者多个问题。

7.根据本公开实施例提供的一种方面级情感分类方法,该方法包括:

8.采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示;

9.针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与所述方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示;

10.基于所述上下文信息特征表示,利用注意力机制学习所述方面词与所述上下文的交互信息,同时提取所述上下文中为方面词情感分类做出重要贡献的情感特征信息,并预测情感极性。

11.本公开的实施例中,所述采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示的步骤包括:

12.采用预训练词典对所述方面词和所述上下文进行词嵌入处理,分别得到所述方面词的词嵌入向量和所述上下文的词嵌入向量。

13.本公开的实施例中,所述采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表

示的步骤包括:

14.通过双向长短期记忆网络模型对所述词嵌入向量和所述文本嵌入向量进行转换处理,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示。

15.本公开的实施例中,所述针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示的步骤包括:

16.本公开的实施例中,根据上下文文本搭建句法依存树,并采用图结构保存所述句法依存树,构建邻接矩阵。所述针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示的步骤包括:

17.将所述上下文隐层表示和所述邻接矩阵输入图卷积网络,利用所述图卷积网络对所述句法依存树中的节点进行图卷积,并通过所述邻接矩阵将句法依存信息融入到所述节点,获得融合语法依存信息的上下文信息特征表示。

18.本公开的实施例中,所述将所述上下文隐层表示和所述邻接矩阵输入图卷积网络,利用所述图卷积网络对所述句法依存树中的节点进行图卷积,并通过所述邻接矩阵将句法依存信息融入到所述节点,获得融合语法依存信息的上下文信息特征表示的步骤之后还包括:

19.对所述方面词的所述隐层表示进行平均操作获得所述方面词的平均表征。

20.本公开的实施例中,所述基于所述上下文信息特征表示,利用注意力机制学习所述方面词与所述上下文的交互信息,同时提取所述上下文中为方面词情感分类做出重要贡献的情感特征信息,并预测情感极性的步骤包括:

21.将所述上下文信息特征表示和所述方面词的所述平均表征输入所述注意力机制,利用所述注意力机制去学习所述方面词和所述上下文间的交互信息,并对情感判别起作用的单词进行分配不同的权重。

22.本公开的实施例中,所述基于所述上下文信息特征表示,利用所述注意力机制学习所述方面词与所述上下文的交互信息,同时提取所述上下文中为方面词情感分类做出重要贡献的情感特征信息,并预测情感极性的步骤包括:

23.根据分配的不同权重计算最终上下文表示。

24.本公开的实施例中,利用线性层将所述最终上下文表示映射到一个与预设情感极性空间维度相同的空间中,得到相同维度的上下文表示向量。

25.本公开的实施例中,采用softmax函数对所述上下文表示向量计算情感极性值,取情感极性值的最大值作为情感分析的结果。

26.本公开的实施例提供的技术方案可以包括以下有益效果:

27.本公开的一种实施例中,通过上述方面级情感分类方法,充分利用了图卷积网络的优点,根据句法依存树将句中的语法信息融合到上下文的语义信息中,并采用注意力机制学习上下文与方面词间的交互信息,显著提升了情感判别效果,相比传统的经典文本情感分析方法以及目前的主流方法而言,本公开实施例的方法具有更为理想的文本情感分析准确度。

28.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不

能限制本公开。

附图说明

29.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。显而易见地,下面描述中的附图仅仅是本公开的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

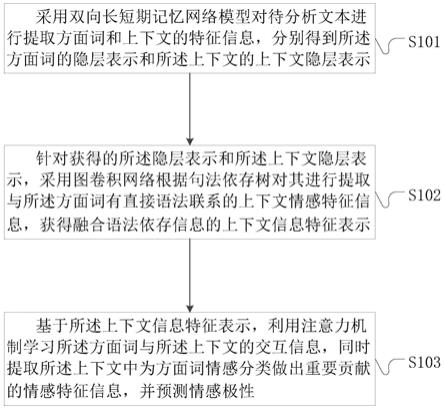

30.图1示意性示出本公开示例性实施例方面级情感分类方法的流程图;

31.图2示意性示出本公开示例性实施例方面级情感分类方法的总体架构图。

具体实施方式

32.现在将参考附图更全面地描述示例实施方式。然而,示例实施方式能够以多种形式实施,且不应被理解为限于在此阐述的范例;相反,提供这些实施方式使得本公开将更加全面和完整,并将示例实施方式的构思全面地传达给本领域的技术人员。所描述的特征、结构或特性可以以任何合适的方式结合在一个或更多实施方式中。

33.此外,附图仅为本公开的示意性图解,并非一定是按比例绘制。图中相同的附图标记表示相同或类似的部分,因而将省略对它们的重复描述。附图中所示的一些方框图是功能实体,不一定必须与物理或逻辑上独立的实体相对应。可以采用软件形式来实现这些功能实体,或在一个或多个硬件模块或集成电路中实现这些功能实体,或在不同网络和/或处理器装置和/或微控制器装置中实现这些功能实体。

34.本示例实施方式中首先提供了一种方面级情感分类方法,参考图1中所示,该方法可以包括:

35.步骤s101:采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示;

36.步骤s102:针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与所述方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示;

37.步骤s103:基于所述上下文信息特征表示,利用注意力机制学习所述方面词与所述上下文的交互信息,同时提取所述上下文中为方面词情感分类做出重要贡献的情感特征信息,并预测情感极性。

38.通过上述方面级情感分类方法,充分利用了图卷积网络的优点,根据句法依存树将句中的语法信息融合到上下文的语义信息中,并采用注意力机制学习上下文与方面词间的交互信息,显著提升了情感判别效果,相比传统的经典文本情感分析方法以及目前的主流方法而言,本公开实施例的方法具有更为理想的文本情感分析准确度。

39.下面,将参考图1至图2对本示例实施方式中的上述方法的各个步骤进行更详细的说明。

40.在一个实施例中,所述采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示的步骤包括:

41.采用预训练词典对所述方面词和所述上下文进行词嵌入处理,分别得到所述方面词的词嵌入向量和所述上下文的词嵌入向量。

42.具体的,采用预训练词典glove将方面词和上下文中的每个单词映射到低维向量空间;

43.给定长度为m的方面词以及长度为n的上下文其中,方面词可以为短语或者一个单词。

44.文本嵌入的嵌入矩阵为其中v为预训练词典中单词的数量,dw为词嵌入维度。t和s中的单词以及均有对应的词向量以及故方面词的词嵌入向量为上下文的词嵌入向量为

45.在一个实施例中,所述采用双向长短期记忆网络模型对待分析文本进行提取方面词和上下文的特征信息,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示的步骤包括:

46.通过双向长短期记忆网络模型对所述词嵌入向量和所述文本嵌入向量进行转换处理,分别得到所述方面词的隐层表示和所述上下文的上下文隐层表示。

47.具体的,双向长短期记忆网络模型即bi

‑

directional long short

‑

term memory,简写bi

‑

lstm;方面词的隐层表示可表示为ht和上下文隐层表示可表示为hc;设t时刻的输入词嵌入向量为v

t

,则长短记忆网络模型lstm的计算公式为:

[0048][0049]

其中,f

t

,i

t

和o

t

分别表示bi

‑

lstm门控机制中的遗忘门、输入门和输出门,σ是sigmoid激活函数,tanh是双曲正切函数,w

*

为权重矩阵,b

*

为偏置项,c

t

‑1和c

t

是记忆细胞在t

‑

1和t时刻的状态,h

t

‑1和h

t

是bi

‑

lstm在t

‑

1和t时刻的输出。

[0050]

由于bi

‑

lstm由一个正向lstm和反向lstm构成,故bi

‑

lstm的计算公式如下:

[0051][0052][0053][0054]

其中,为正向lstm在t时刻的输出,为反向lstm在t时刻的输出,将与进行拼接得到bi

‑

lstm的最终输出h

t

。

[0055]

将方面词和上下文的词嵌入向量分别通过bi

‑

lstm,从而获得方面词的隐层表示h

t

和上下文隐层表示h

c

:

[0056][0057]

[0058]

其中d

h

为bi

‑

lstm的隐层状态维度。

[0059]

在一个实施例中,所述针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示的步骤包括:

[0060]

根据上下文文本搭建句法依存树,并采用图结构保存所述句法依存树,构建邻接矩阵。

[0061]

具体的,根据上下文文本搭建句法依存树,并采用图结构g=(v,e)保存句法依存树,其中v是句中所有节点的集合,即句中所有词的集合;e是句中所有边的集合,即句中所有词与词依存关系的集合;邻接矩阵记为a。

[0062]

若两节点之间存在依存关系,则赋值为1:

[0063]

a

ij

=a

ji

=1

ꢀꢀꢀ

(7)

[0064]

若两节点之间不存在依存关系,则赋值为0:

[0065]

a

ij

=a

ji

=0

ꢀꢀꢀ

(8)

[0066]

设定每个词均与自身邻接,故有:

[0067]

a

ii

=1

ꢀꢀꢀ

(9)

[0068]

在一个实施例中,所述针对获得的所述隐层表示和所述上下文隐层表示,采用图卷积网络根据句法依存树对其进行提取与方面词有直接语法联系的上下文情感特征信息,获得融合语法依存信息的上下文信息特征表示的步骤包括:

[0069]

将所述上下文隐层表示和所述邻接矩阵输入图卷积网络,利用所述图卷积网络对所述句法依存树中的节点进行图卷积,并通过所述邻接矩阵将句法依存信息融入到所述节点,获得融合语法依存信息的上下文信息特征表示。

[0070]

具体的,将bi

‑

lstm输出的上下文隐层表示h

c

与其对应的邻接矩阵a输入l层图卷积网络,利用图卷积网络对句法依存树中的节点进行图卷积,并通过邻接矩阵将句法依存信息融入到节点,获得融合了语法依存信息的上下文信息特征表示h

c_l

;

[0071]

图卷积网络中第l层第i个节点的临时表示和最终表示如下:

[0072][0073][0074]

其中,表示图卷积网络中第l

‑

1层第j个节点,d

i

表示句法依存树中第i个节点的度,即第i个节点在树中所拥有的边数之和,而w

l

和b

l

是图卷积网络中第l层训练的权重矩阵和偏差项。

[0075]

经过l层图卷积网络后,可以获得融合了语法依存信息的上下文信息特征表示h

c_l

,

[0076][0077]

在一个实施例中,所述将所述上下文隐层表示和所述邻接矩阵输入图卷积网络,利用所述图卷积网络对所述句法依存树中的节点进行图卷积,并通过所述邻接矩阵将句法依存信息融入到所述节点,获得融合语法依存信息的上下文信息特征表示的步骤之后还包

括:

[0078]

对所述方面词的所述隐层表示进行平均操作获得所述方面词的平均表征。

[0079]

具体的,平均表征记为得h

t_avg

,平均表征的公式如下:

[0080][0081]

在一个实施例中,将所述上下文信息特征表示和所述方面词的所述平均表征输入所述注意力机制,利用所述注意力机制去学习所述方面词和所述上下文间的交互信息,并对情感判别起作用的单词进行分配不同的权重。

[0082]

具体的,图卷积网络中第l层第i个节点的最终表示对h

c_l

与h

t_avg

之间交互信息的评价得分为:

[0083][0084]

其中,γ为得分函数,是h

t_avg

的转置。

[0085]

待分配权重公式如下:

[0086][0087]

其中,α

i

为待分配权重,w

a

和b

a

分别为权重矩阵和偏差项。

[0088]

在一个实施例中,所述基于所述上下文信息特征表示,利用所述注意力机制学习所述方面词与所述上下文的交互信息,同时提取所述上下文中为方面词情感分类做出重要贡献的情感特征信息,并预测情感极性的步骤包括:

[0089]

根据分配的不同权重计算最终上下文表示。

[0090]

具体的,根据待分配权重α

i

获得最终上下文表示η,η的计算公式如下:

[0091][0092]

在一个实施例中,利用线性层将所述最终上下文表示映射到一个与预设情感极性空间维度相同的空间中,得到相同维度的上下文表示向量。

[0093]

具体的,得到的上下文表示向量的公式如下:

[0094]

x=w

x

·

η+b

x

ꢀꢀꢀ

(17)

[0095]

其中,w

x

和b

x

分别表示权重矩阵和偏差项。

[0096]

在一个实施例中,采用softmax函数对所述上下文表示向量计算情感极性值,取情感极性值的最大值作为情感分析的结果。

[0097]

具体的,采用softmax函数对上下文表示向量进行预测情感极性,得到的预测情感极性公式如下:

[0098][0099]

其中,y

i

∈r

c

,c为情感种类数量,x

i

)为上下文表示向量x中的每一个元素。

[0100]

通过上述方面级情感分类方法,充分利用了图卷积网络的优点,根据句法依存树将句中的语法信息融合到上下文的语义信息中,并采用注意力机制学习上下文与方面词间

的交互信息,显著提升了情感判别效果,相比传统的经典文本情感分析方法以及目前的主流方法而言,本公开实施例的方法具有更为理想的文本情感分析准确度。

[0101]

仿真对比实验:

[0102]

本公开实施例方法的仿真实验环境为:windows 10操作系统,intel(r)core(tm)i5

‑

6400 cpu,8gb内存,编程语言为python 3.8,深度学习框架为pytorch 1.6.0,并采用cuda 10.1进行加速运算。为了更好地对本公开实施例的技术方案加以理解,本实施例选用了三组情感分类公开数据集,即twitter数据集、semeval2014任务4中的lap14数据集和rest14数据集,情感极性分为积极、中立和消极三类,各数据集的情感极性分布如表1所示。

[0103]

表1数据集统计信息

[0104][0105]

为了验证本公开实施例方法的有效性,以下通过若干组仿真实验来验证相比传统的经典文本情感分析方法以及目前的主流方法而言,本公开实施例方法具有更为理想的文本情感分析效果:

[0106]

遵循本公开实施例方法的技术方案,本实验选取了11种代表性方法进行对比,具体包括:

[0107]

(1)lstm:标准lstm网络,将上下文编码输入到lstm中,将隐层输出作为最终情感判别特征;

[0108]

(2)at

‑

lstm:对上下文编码,输入到lstm中提取语义信息,用注意力机制进一步突出对情感判别有帮助的特征,再进行情感判别,忽略了方面词对于情感预测的影响;

[0109]

(3)atae

‑

lstm:以at

‑

lstm模型为基础,在上下文编码时,将方面词编码嵌入到上下文编码中,输入到lstm中,使用注意力机制分配权重,得到最终的情感特征进行判别;

[0110]

(4)ian:该模型分别对上下文和方面词进行编码,两者使用注意力机制进行交互,融合上下文对方面词和方面词对上下文的影响,最终做连接作为最终的情感特征;

[0111]

(5)ascnn:采用经典卷积神经网络来抽取语义信息;

[0112]

(6)asgcn:使用图卷积网络根据句法依存树以及掩码机制得到方面词的表征,再根据注意力机制对权重重新分配,使用softmax进行情感分类;

[0113]

(7)trancaps:在胶囊网络上使用迁移学习将文档级的语义信息融合到方面级中,从而增强方面级的情感分类;

[0114]

(8)cdt:采用图卷积网络和依赖树来拉近句子方面词与观点词之间的距离,模型的输入为字嵌入的依赖树,通过双向lstm学习上下文的信息,再通过图卷积网络进一步增强嵌入,通过一层池化层得到情感特征;

[0115]

(9)repwalk:在依存树中引入随机游走的方法,激活方面词在树中的边,给予方面词更大的权重,建立双层语义胶囊网络通过路由机制来进行情感分类;

[0116]

(10)bigcn:使用双层图卷积神经网络融合层次句法图和层次词汇图,充分利用单词之间的句法信息,之后再结合单词共现信息对情感进行分类;

[0117]

(11)depgcn:采用自注意力方法,以句子编码层的输出作为输入,得到潜在图结构,通过图卷积网络和门控机制来进一步完善原始句法信息。

[0118]

经过对比实验,包括本公开实施例方法在内的12种方法的实验结果分别如表2所示,其中实验结果单位均为%,n/a表示未取得实验结果。

[0119]

表2 12种方法对应的实验结果

[0120][0121]

由表2的实验数据可知,at

‑

lstm相较lstm在三个公开数据集上的准确率acc分别提升了1.91%、2.47%、2.23%,macro_f1分别提升了1.87%、2.30%、1.09%,可见注意力机制进一步提取重要情感特征对于情感判别的帮助;atae

‑

lstm在at

‑

lstm的基础上将方面词编码信息与上下文编码连接,初步将方面词编码信息与上下文联系起来,在twitter和rest14数据集上分别提升了0.24%、0.69%,简单的连接未能有效利用方面词对于情感预测的作用;而ian模型进一步的考虑到了方面词与目标的交互,相较于atae

‑

lstm在三个公开数据集上的准确率acc分别提升了3.85%、3.35%、2.06%,macro_f1分别提升了4.28%、3.45%、3.07%,可见将上下文与方面词的交互信息融合到模型之中,效果提升是相当高的,进一步体现了方面词与上下文之间的交互信息的重要性,但ian忽略了句法依存信息的利用;对比ascnn与asgcn,可见在三个数据集上asgcn的平均表现较ascnn好,gcn在语义抽取方面较cnn好,asgcn使用gcn将句法依存关系融合到上下文信息中,相较于atae

‑

lstm准确率acc分别提升了2.88%、5.44%、3.66%,macro_f1值分别提升了3.15%、5.31%、5.17%,可见将句法信息融入到上下文信息之中,对于情感预测的提升是非常有用的;本公开实施例方法相较于ataea

‑

lstm在三个公开数据集上的准确率acc分别提升4.33%、6.22%、4.42%,macro_f1值分别提升了4.87%、6.53%、6.49%,原因在于本公开实施例方法同时考虑到了方面词与上下文之间的交互信息,并且充分的利用了句法信息;相较于ian模型,准确率acc分别提升了0.48%、2.87%、2.36%,macro_f1值分别提升了0.59%、3.08%、3.42%,因为ian模型考虑到了方面词与上下文之间的相互影响,但忽略了句子中的语法信息;对比trancaps模型,在lap14和rest14数据集上,准确率acc分别提升了1.05%、2.07%,macro_f1值分别提升了0.36%、2.10%,说明将文档级信息融入方面级中,

其效果不如去融合句法信息和学习方面词交互信息;相较于cdt模型,准确率acc分别提升了0.24%、0.54%、1.14%,macro_f1值在twitter和rest14数据集上分别提升了0.87%、1.47%,在lap14数据集上低于cdt模型0.52%,两模型均使用了图卷积网络来融入句法信息,但本公开实施例方法在准确率方面略有提升,说明方面词与上下文之间的交互信息在情感判别方面仍然发挥了一定的作用,而cdt模型融合了句法、位置、词性等多方面信息,在lap14数据集上macro_f1值比本公开实施例方法略显稳定。repwalk采用随机游走的方式为方面词增加权重,相当于从另一方面来增强方面词与上下文之间联系,但没有考虑到句子中的语法信息,其在三个公开数据集上比本公开实施例方法有所落后,在准确率acc分别落后0.85%、0.82%、0.70%,macro_f1值分别落后0.40%、0.45%、2.20%,在rest14数据集上该模型性能较差,因为rest14数据集中样本长度差距较大,产生的依存树结构差距大,对于在依存树上的随机游走方法有一定的限制;bigcn与depgcn模型在三个公开数据集上的性能相差不大,两者均充分利用了句法信息,用不同的方式对原始的句法信息进行弥补,但两者均没有考虑到方面词与上下文的交互信息,本公开实施例方法在考虑相互信息的情况下,在前两个数据集上准确率acc比bigcn提升了0.92%、0.60%,macro_f1值两者相当,在rest14数据集上两模型性能相当;本公开实施例方法相比于depgcn在三个公开数据集上准确率acc分别提升0.87%、0.13%、0.95%,macro_f1值在前两个数据集相差较小,rest14数据集提升1.62%,awi

‑

gcn在rest14数据集上比depgcn更为稳定。综上,本公开实施例方法在方面级情感分析任务中是有效的,其语法信息的融入和方面词与上下文交互信息的学习,都对情感判别效果的提升起到了一定的作用。

[0122]

为了验证图卷积网络融合句法信息的有效性,特构建若干种方法用于比较。首先,对方面词和上下文建模,采用bi

‑

lstm上下文隐层输出与方面词进行交互,建立awi方法;其次,为验证上下文与方面词之间交互信息对于实验结果的影响,不再进行上下文与方面词在注意力机制上的交互,而是让上下文与方面词分别建模,提取方面词内容(aspect word content,awc),再通过池化进一步抽取特征,上下文通过图卷积网络(graph convolutional network,gcn)融合句法信息后通过注意力机制,将得到的结果拼接进行情感分析,构建awc

‑

gcn方法。则包括本公开实施例方法在内的三种方法在三个公开数据集上的实验结果如表3所示,其中实验结果单位均为%。

[0123]

表3 3种方法对应的实验结果

[0124][0125]

通过对比表3中三种方法在不同数据集上的准确率acc和macro_f1值可以得出:awi的效果在三种方法中最差,原因在于其未融合句法依存信息;awc

‑

gcn方法融合了句法依存信息,并初步考虑了方面词对情感判别的影响,其在twitter数据集上的准确率与本公开实施例方法相当接近,然而awc

‑

gcn忽略了方面词与上下文之间的交互信息,故效果逊于本公开实施例方法;本公开实施例方法同时融合了句法依存信息,并考虑到了方面词与上下文之间的交互信息,故在三种方法中本公开实施例方法表现最好。

[0126]

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不必须针对的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任何的一个或多个实施例或示例中以合适的方式结合。此外,本领域的技术人员可以将本说明书中描述的不同实施例或示例进行接合和组合。

[0127]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其它实施方案。本技术旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由所附的权利要求指出。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1